爆!2024‘Meta 推出CTR集成框架 CETNet,多 CTR 模型集成大幅提升预测精度

1. Kimi k1.5: Scaling Reinforcement Learning with LLMs

语言模型预训练时,通过预测下一个词来提升计算量的方法效果不错,可训练数据量却限制了它的进一步发展。强化学习(RL)的拓展则为人工智能持续进步提供了新途径,让大语言模型(LLMs)有机会通过学习探索扩充训练数据。不过,之前相关研究成果都不太理想,没有特别突出的。

基于这样的情况,我们来分享 Kimi k1.5 的训练过程。这是我们新研发的多模态 LLM,使用 RL 训练。我们会讲讲 RL 训练技术、多模态数据处理方法,还有基础设施优化这些内容。长上下文扩展和改良后的策略优化是我们训练方法的关键,搭建出简单好用的 RL 框架,不用像蒙特卡洛树搜索、价值函数、过程奖励模型这些复杂技巧。

特别要提的是,我们的系统在不少基准测试和不同模态里,推理性能都很突出。AIME 测试得 77.5 分,MATH 500 测试得 96.2 分,Codeforces 测试处于 94 百分位,MathVista 测试得 74.9 分,和 OpenAI 的 o1 水平差不多。 另外,我们还找到了好办法,用长思维链(CoT)技术增强短思维链模型。在 AIME 中得分 60.8,MATH500 里得 94.6 分,LiveCodeBench 里得 47.3 分,比 GPT-4o、Claude Sonnet 3.5 这些短思维链模型强很多,最高领先幅度能达到 550%。

论文: https://arxiv.org/pdf/2501.12599

2. FilmAgent: A Multi-Agent Framework for End-to-End Film Automation in Virtual 3D Spaces

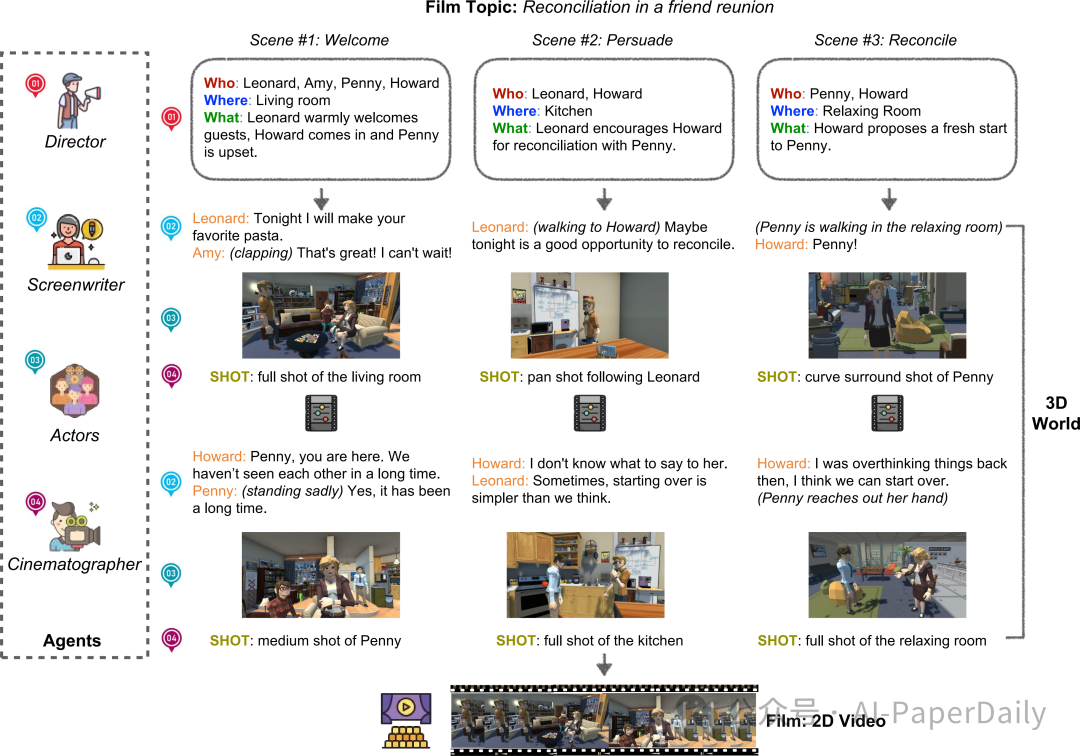

制作虚拟电影,做决策可太复杂了。既要创作剧本,又要进行虚拟摄影,还得精准设计演员的定位和动作。最近,自动决策领域在基于语言 Agent 社会这一块有了新进展,我们从中受到启发,提出了 FilmAgent。这是一种基于大语言模型的多 Agent 协作框架,目的是在我们搭建的 3D 虚拟空间里,从头到尾实现电影制作的自动化。

FilmAgent 能模仿好多剧组里的角色,像导演、编剧、演员、摄像师等等,涵盖了电影制作的关键阶段。首先是创意开发,把大家头脑风暴出来的想法,整理成有条理的故事情节;接着是剧本创作,仔细描述每个场景里角色的对话和动作;然后是摄影环节,确定每个镜头的摄像机该怎么摆放。Agent 团队通过反复地反馈和修改来合作,这样就能验证中间生成的剧本,减少那些不合理、不真实内容的出现。

我们针对 15 个创意和 4 个关键方面生成的视频做了评估。经过人工评估,FilmAgent 在各个方面都比其他对比对象表现好,平均得分 3.98 分,这就充分说明多 Agent 协作在电影制作中是可行的。进一步分析发现,就算用的是相对没那么先进的 GPT - 4o 模型,FilmAgent 的表现还是超过了单 Agento1,这就突出了协调得好的多 Agent 系统的优势。

论文: https://arxiv.org/pdf/2501.12909

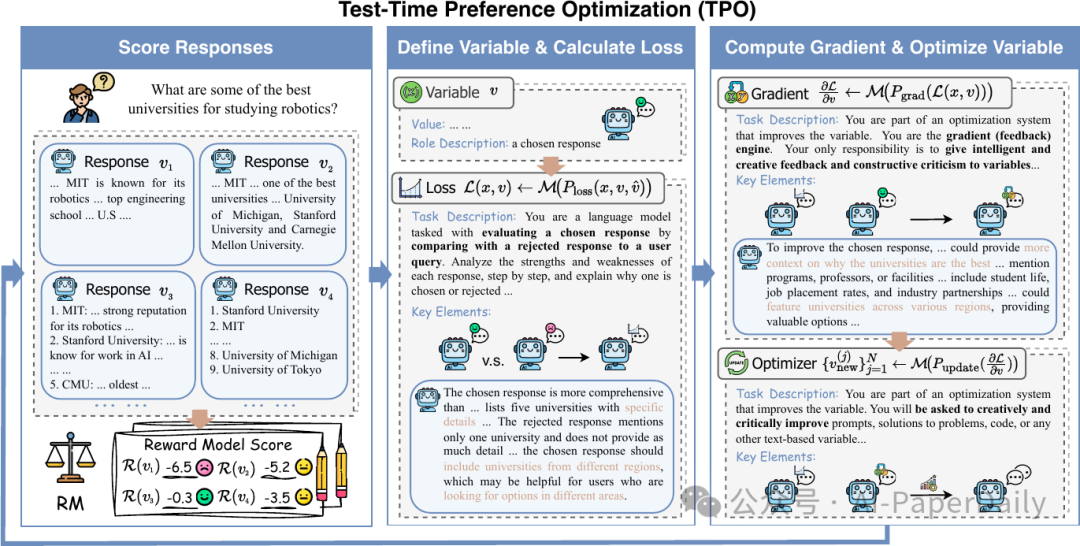

3. Test-Time Preference Optimization: On-the-Fly Alignment via Iterative Textual Feedback

大语言模型(LLMs)展现出的性能令人赞叹,不过在快速契合人类偏好方面存在短板,除非重新训练。在这篇文章里,我们提出了测试时偏好优化(TPO)框架,这个框架能在推理过程中,让 LLM 的输出结果与人类偏好保持一致,也就无需更新模型参数。

和单纯依赖数值奖励不同,TPO 会把奖励信号转变为文本批评,然后将其当作文本奖励,一步步优化自身的响应。在包含指令跟随、偏好对齐、安全性以及数学等方面的基准测试中,评估结果显示 TPO 能逐步提升与人类偏好的契合度。值得一提的是,仅经过几步 TPO 处理,一开始未对齐的 Llama-3.1-70B-SFT 模型,就能超越已对齐的对应模型 Llama-3.1-70B-Instruct。而且,TPO 在推理时,随着搜索宽度和深度的增加,能高效扩展。

通过案例研究,我们阐述了 TPO 是如何利用 LLM 自身能力来解读和执行奖励信号的。我们的研究成果表明,TPO 是一种实用、轻量级的测试时偏好优化替代方案,能实现实时对齐。我们的代码已在https://github.com/yafuly/TPO 上公开。

论文: https://arxiv.org/pdf/2501.12895

4. VideoLLaMA 3: Frontier Multimodal Foundation Models for Image and Video Understanding

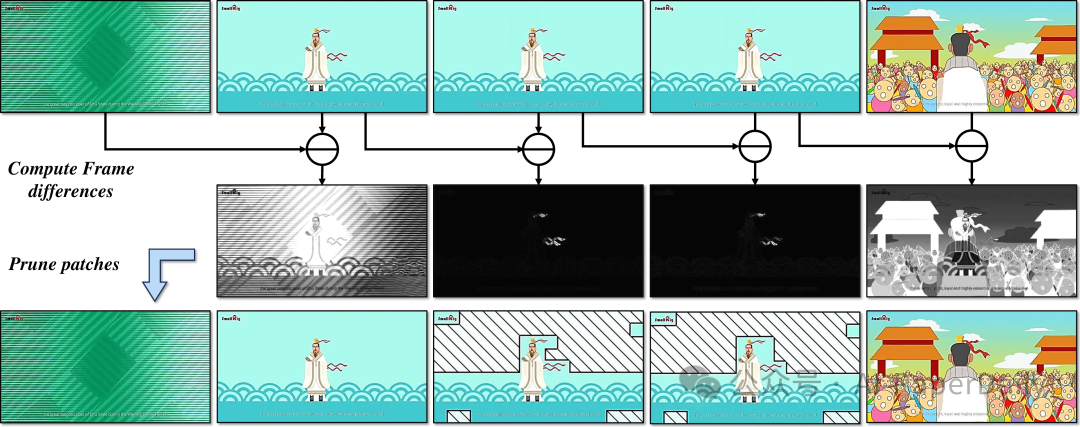

在这篇文章里,我们带来了VideoLLaMA3,这是一个更厉害的多模态基础模型,主要用来理解图像和视频。VideoLLaMA3的核心设计思路就是以视觉为中心,这里面有两层含义:一个是视觉为中心的训练方式,另一个是视觉为中心的框架设计。

为什么采用视觉为中心的训练方式呢?是因为我们发现高质量的图像-文本数据,对理解图像和视频特别重要。所以,我们没去搞大规模的视频-文本数据集,而是把心思花在构建大规模、高质量的图像-文本数据集上。VideoLLaMA3的训练分成四个阶段:

- 视觉为中心的对齐阶段:这个阶段主要是让视觉编码器和投影器先热热身;

- 视觉-语言预训练阶段:一起优化视觉编码器、投影器和大模型(LLM),用的是大规模的图像-文本数据,像场景图像、文档、图表这些都有,还有纯文本数据;

- 多任务微调阶段:把图像-文本SFT数据和视频-文本数据用到下游任务里,给视频理解打下基础;

- 视频为中心的微调阶段:让模型理解视频的能力再上一个台阶。

在框架设计方面,为了能把图像里的小细节都抓住,我们调整了预训练的视觉编码器,让它能根据图像大小,编码出对应的视觉标记数量,而不是固定的数量。对于视频输入,我们会根据它们的相似程度,减少视觉标记数量,这样视频的表示就更准确、更简洁了。

多亏了这种以视觉为中心的设计,VideoLLaMA3在图像和视频理解的基准测试中,取得了非常不错的成绩。

论文: https://arxiv.org/pdf/2501.13106

本文转载自 AI-PaperDaily,作者: AI-PaperDaily