基于CogVideoX-2B,视觉一致和语义对齐超越最新SOTA!南洋理工等发布RepVideo

文章链接:https://arxiv.org/pdf/2501.08994

项目链接:https://vchitect.github.io/RepVid-Webpage

亮点直击

- 研究了视频扩散模型中的transformer表示,揭示了各层注意力图的显著变化导致了空间语义的碎片化和时间一致性的降低,这对视频质量产生了负面影响。

- 提出了RepVideo,一个利用特征缓存模块和门控机制来聚合和稳定中间表示的框架,增强了空间细节和时间一致性。

- 大量实验表明,RepVideo在时间一致性和空间质量方面都取得了竞争力的表现,验证了其在视频生成中的有效性。

总结速览

解决的问题

视频生成中,生成具有时空一致性和高质量空间细节的视频非常复杂且具有挑战性。现有的研究主要集中在模型训练的扩展上,缺乏对表示直接影响视频生成过程的深入研究。特别是在生成的视频中,随着模型层数的增加,注意力图在不同层之间差异显著,导致特征表示不稳定,影响了时序一致性,最终降低了相邻帧之间的相似性,影响了视频生成的质量。

提出的方案

本文提出了一个增强的视频表示框架——RepVideo,用于文本到视频的扩散模型。该方法通过累积相邻层的特征来形成增强的表示,从而捕捉到更稳定的语义信息。这些增强的表示被用作注意力机制的输入,从而提高语义表达能力,同时确保相邻帧之间的特征一致性。

应用的技术

- 特征缓存模块:该模块聚合来自多个相邻 transformer 层的特征,通过对所有收集的特征进行均值聚合,获得稳定的语义表示。

- 门控机制:将聚合后的表示与原始 transformer 输入结合,以生成每个 transformer 层的增强特征输入。

- 扩展 transformer 注意力机制:利用不同层之间的特征差异来丰富视频的语义一致性和空间细节。

达到的效果

- 时序一致性:通过稳定的语义表示,RepVideo 能够保持相邻帧之间的特征一致性,缓解相邻帧之间的不一致性,从而提升视频的时序一致性。

- 空间细节:增强的特征输入提高了模型生成细节的能力,使得生成的视频在空间上更加细致,能够准确捕捉复杂的空间关系。

- 视频质量提升:实验结果表明,RepVideo 在定性和定量指标上均显著提升了时序一致性和空间细节生成,生成的视频更加一致和高质量。

方法

重新思考视频扩散模型的表示

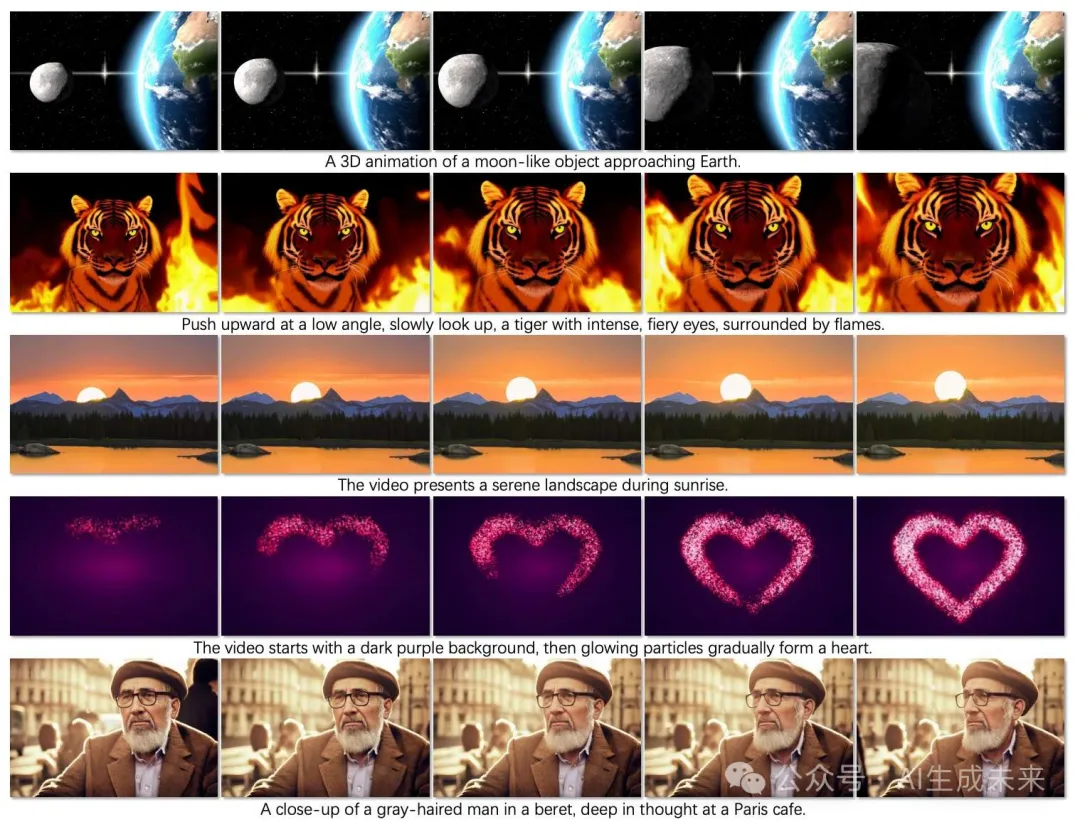

最近,扩散Transformer在文本到视频生成中取得了显著成功,如 CogVideoX 和 MovieGen。这些方法通常由三个核心组件组成:一个 3D VAE、文本编码器和Transformer网络,如下图 2 所示。3D VAE 用于沿空间和时间维度压缩视频数据,生成紧凑的潜在表示,从而能够高效处理更高的视频分辨率和更多的帧数,同时显著减少 GPU 内存使用。文本编码器处理输入文本提示,将其转换为一组嵌入,捕捉语义信息并指导整个视频生成过程。

然后,视频的隐空间表示被展平成一个标记序列,与文本嵌入标记一起输入到Transformer网络中。通过利用Transformer强大的注意力机制,它可以学习视频序列中的复杂空间和时间关系,确保生成的帧既连贯、一致,又与文本提示提供的语义信息对齐。通过整合这些组件,基于扩散Transformer的模型在生成高分辨率、长时长的视频方面显示出显著的改进,这些视频不仅在时间上一致,而且在语义上与输入提示对齐。尽管取得了这些进展,大多数研究主要集中在扩展模型训练上,如增加模型大小、训练数据集规模和计算资源,同时对中间表示如何直接影响视频生成过程提供的见解较少。这种对扩展的侧重忽视了理解和优化内部特征表示的潜在好处,而这些优化可能导致更高效且连贯的视频生成,而不仅仅依赖于增加模型容量。

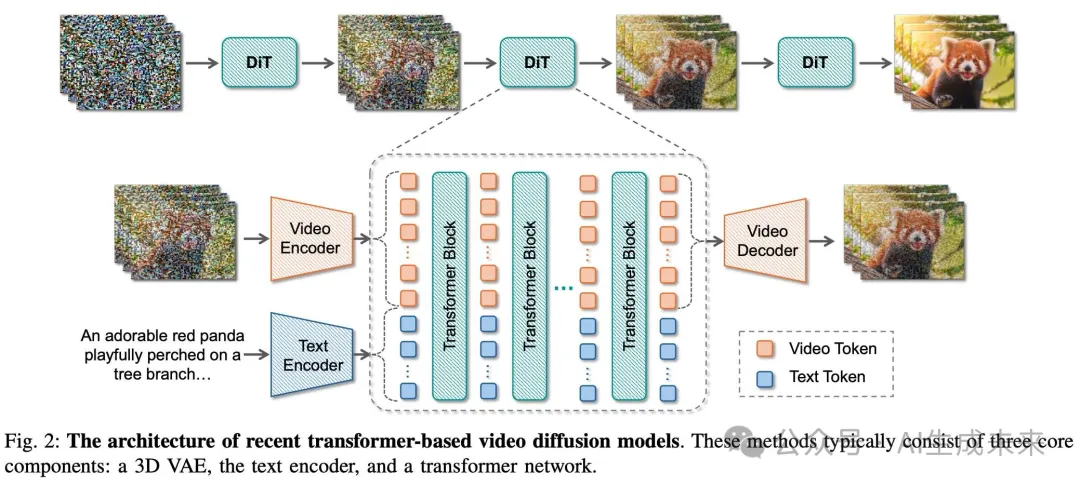

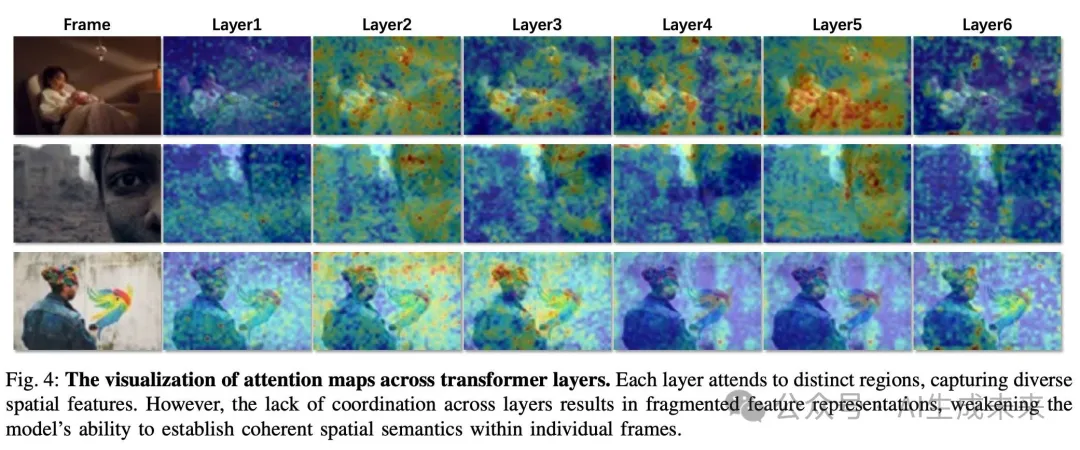

为了全面理解中间表示在视频生成中的作用,深入分析了视频扩散模型中Transformer表示,特别关注它们对空间表现力和时间一致性的影响。我们首先分析了跨Transformer层的注意力图的空间表现力。如上图 2 所示,最近的模型将视频潜在标记和文本嵌入标记整合成一个统一的标记序列,然后通过Transformer使用全注意力机制处理这些标记之间的关系。为了理解注意力图中的哪些区域对语义信息有贡献,可视化了每一帧标记在整个标记序列中的注意力分布,如下图 3 所示。结果显示,不同层之间的注意力分布存在显著差异,每一层关注的区域不同,学习到的特征方面也有所不同。此外,发现随着层深的增加,与每一帧的标记相对应的注意力越来越集中于同一帧的标记,而对其他帧标记的注意力较弱。

这一观察表明,仅分析每一帧标记的注意力图能够有效地表示序列的整体注意力特征。因此,可以专注于单个帧标记的自注意力图,以捕捉关键的全局注意力特征,从而简化分析,同时仍然提供有意义的洞察,揭示注意力如何在视频中的不同空间和时间区域之间分布。如下图 4 所示,我们可视化了不同层级下单帧标记的注意力图。可视化结果表明,不同层的注意力图显示出显著的差异,每一层关注不同的区域并捕捉不同的特征信息。随着网络深度的增加,这些注意力机制也导致了特征的逐步区分。虽然这使得模型能够捕捉多样的空间特征,但由于层与层之间缺乏协调,导致特征表示的碎片化,削弱了模型在单一帧内形成连贯空间语义的能力。

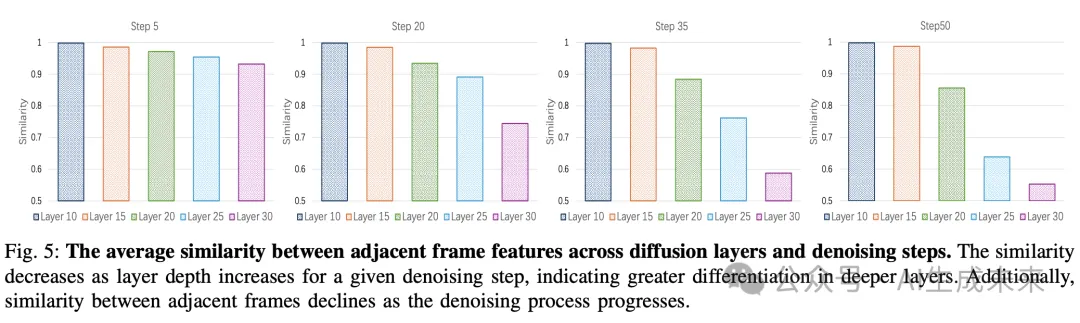

基于此,扩展了调查,分析了这些注意力机制如何影响时间一致性。分析了Transformer层之间相邻帧特征的相似度演变,因为这种相似度是时间一致性的关键指标。下图 5 可视化了不同扩散层中相邻帧特征在不同去噪步骤下的平均相似度。分析揭示了两个关键观察结果。首先,对于给定的去噪步骤,随着层深的增加,相邻帧特征的相似度减小。这表明,深层引入了越来越多的多样化特征,导致帧特征之间的差异化。其次,在比较不同去噪步骤时,相邻帧之间的相似度随着去噪过程的推进而减小。例如,在较早的步骤(例如步骤 5)中,平均相似度较高,但在较晚的步骤(例如步骤 5)中逐渐减小。这一趋势表明,尽管去噪过程为视频特征增添了更多多样的语义内容,但它也增加了相邻帧之间的变异性,从而降低了时间一致性,并可能在生成的视频中引入运动伪影。

增强的视频扩散模型表示

本文提出了 RepVideo,一个简单而有效的框架,利用丰富的中间表示来增强文本到视频扩散模型中的视频生成。本文的方法灵感来自最近在扩散模型中结合多个文本编码器的进展,如 FLUX 和 MovieGen。这些方法通过使用多个编码器来捕捉不同层次的信息(如语义层级和字符层级的理解),增强了模型对文本提示的解读能力,从而改善了生成内容与文本描述之间的对齐。RepVideo 基于这一思想,旨在创建更丰富的视频表示,从而最终提高生成视频的时间一致性和语义对齐。

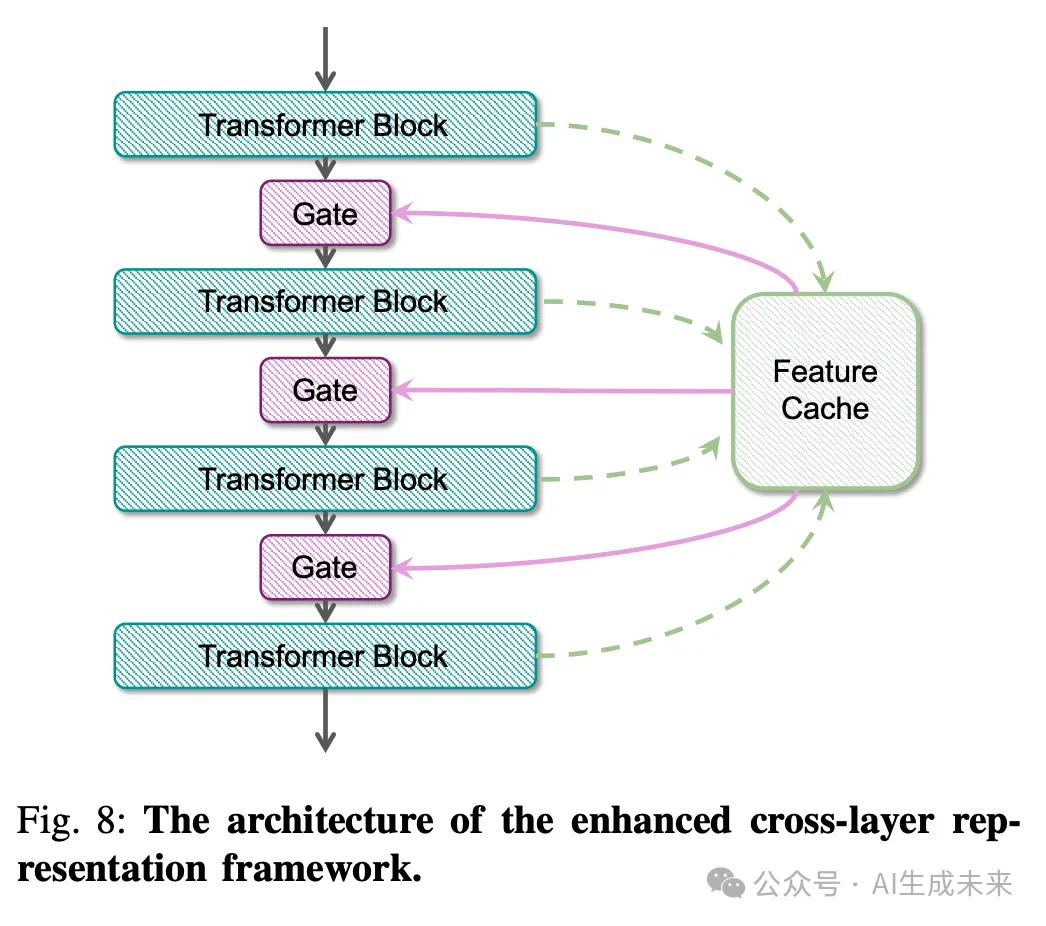

为了实现这一目标,探索利用扩散Transformer中固有的丰富特征来增强生成视频的语义一致性和质量。这种方法消除了引入额外网络的需要,如同在文本编码器中所做的那样,从而保持了模型的简洁性和计算效率。首先,我们在Transformer中引入了一个特征缓存模块,如下图 8 所示。该模块允许每个Transformer层将其输出的标记序列存储在缓存中,使得特征缓存模块能够聚合来自多个相邻Transformer层的特征。

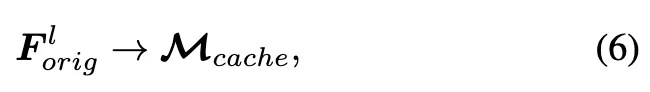

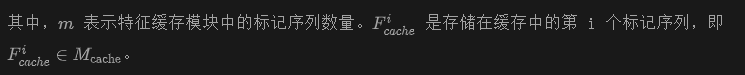

按如下方式存储第 l 层Transformer的输出标记序列:

通过合并这些特征,可以实现更加语义丰富的表示。在下图 6 中,展示了标准Transformer层生成的原始特征图与在特征缓存模块中进行特征聚合后获得的特征图之间的比较。可以观察到,聚合后的特征捕捉了更多的语义信息,并展示了更清晰的结构信息。

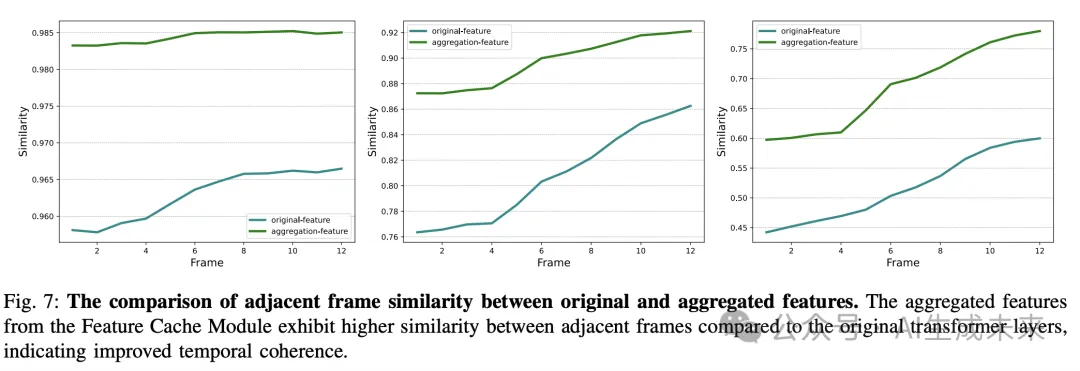

此外,下图 7 显示了两组表示的相邻帧特征之间的相似性。分析结果揭示,来自特征缓存模块的聚合特征在相邻帧之间表现出比原始Transformer层更高的相似性。这表明,集成多层特征不仅丰富了语义信息,而且在整个帧之间保持了更强的时间一致性,这在减少的变异性和改进的相邻帧对齐中得到了体现。

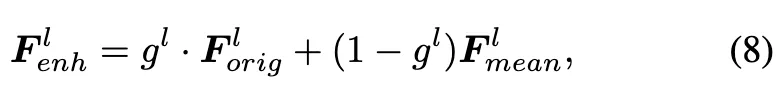

为了利用这种增强的表示来提升原始Transformer特征,通过门控机制将聚合后的特征与原始输入结合:

通过使用这种增强的输入,RepVideo 提升了扩散模型在文本输入与生成视频之间保持一致性的能力,从而实现了更平滑的过渡、更大的语义一致性,并整体提高了视频质量。

训练

为了评估 RepVideo 引入的增强表示的有效性,基于 CogVideoX-2B实现了本文的模型。之所以选择这个基准模型,是因为它拥有强大的架构,并在文本到视频生成任务中表现出色,为比较提供了坚实的基础。训练过程经过精心设计,以确保基准和我们提出的方法之间的公平性和一致性。

数据准备

由于 CogVideoX-2B 已经在大规模视频语料库上进行了预训练,构建了一个定制的内部数据集来进行微调。该数据集来自高质量平台,并经过严格的预处理管道,以确保多样性和质量。首先,将长视频分割成较短的可管理片段,以强调重点事件或动作。然后,将相关片段链接在一起,形成一致的事件序列,确保跨帧的叙事一致性。为了进一步精炼数据集,应用了静态视频过滤,以排除缺乏显著运动的片段,确保突出动态内容。

此外,进行美学评分,根据预定义标准评估视觉质量,优先考虑高质量和语义丰富的视频输入。动态估计被用于分析运动模式和整体片段动态,增强数据集对以运动为中心的视频生成的相关性。还应用了水印分类器,检测并标注含有可见水印的视频,保持训练数据的完整性和可用性。这个全面的数据准备过程最终生成了一个高质量的数据集,包含了100万条带有详细字幕的标注视频,覆盖了多种类目。

训练设置

增强表示实现

RepVideo 的核心创新在于其通过聚合中间Transformer输出生成稳定和语义丰富的表示,从而提高了空间忠实度和时间一致性。这是通过引入特征缓存模块实现的,该模块跨每m个Transformer层聚合特征。通过聚合相邻层的特征,模块有效地捕获了语义细节,同时减少了帧间的不一致性。实证评估表明,设置m=6提供了计算效率和性能改进之间的最佳平衡。除非另有说明,实验中默认使用m=6 。

为了将这些增强的表示集成到Transformer层中,引入了门控机制。该机制动态地将聚合的特征与原始Transformer输出结合,使用一个可学习的参数来控制它们的相对影响。

所提出的聚合和门控机制是轻量级的,增加的参数和计算开销极小。在训练过程中,这些机制显著提高了空间一致性、时间一致性和语义对齐,最终生成了更平滑、视觉效果更好的视频输出。

实验

为了全面评估本文提出的框架的有效性,进行了涵盖定量和定性分析的综合实验。这些实验旨在评估 RepVideo 在多个指标上的表现,包括空间忠实度、时间一致性和与文本提示的语义对齐。特别地,我们通过在自动化指标和人工偏好评估中将本文的模型与最先进的方法进行基准比较,提供了对其优势的全面视角。实验分为三个部分:1) 自动评估:使用 VBench 中提供的定量指标,客观地比较 RepVideo 的性能与现有模型。2) 人工评估:人工评估者根据与提示的对齐、时间平滑度和逐帧质量评估生成的视频,提供互补视角。3) 消融研究:详细分析 RepVideo 设计的贡献,分析空间和时间一致性的改进。以下部分深入探讨了这些评估,突出了我们方法的优势和潜在改进领域。

自动评估

定量评估

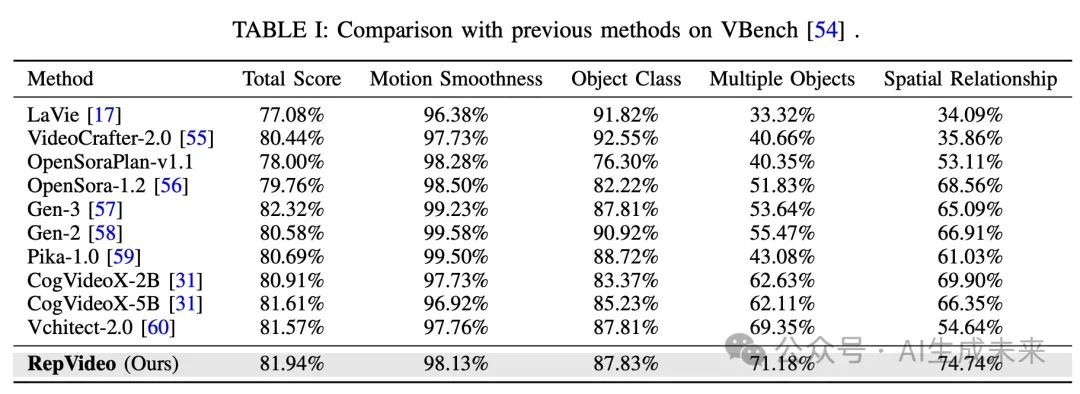

为了评估本文模型的性能,采用了 VBench 提供的所有指标。如下表 I 所示,报告了总分以及几个代表性的指标。具体来说,运动平滑度评估生成视频的时间稳定性,而物体类别和多物体则衡量生成多样化且定义良好的视觉元素的能力。此外,空间关系评估物体定位和交互的一致性。

与基准模型 CogVideoX-2B 相比,本文的模型 RepVideo-2B 在总分上取得了更优的结果。值得注意的是,本文的模型在运动平滑度上提高了 0.4%,在物体类别上提高了 4.46%,突出了其在保持时间一致性和生成细致物体细节方面的能力。此外,RepVideo 在空间关系 (+4.84%) 和多物体 (+8.55%) 上也取得了显著的提升,展示了增强的空间一致性和强大的处理复杂物体交互的能力。

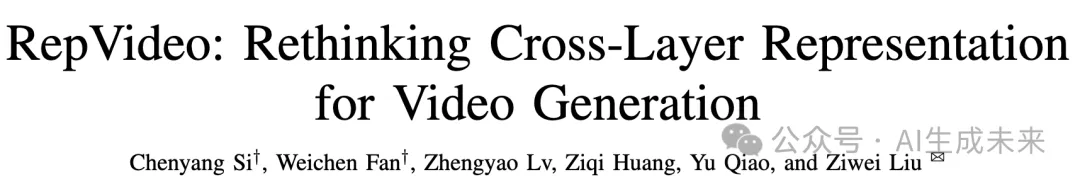

定性评估

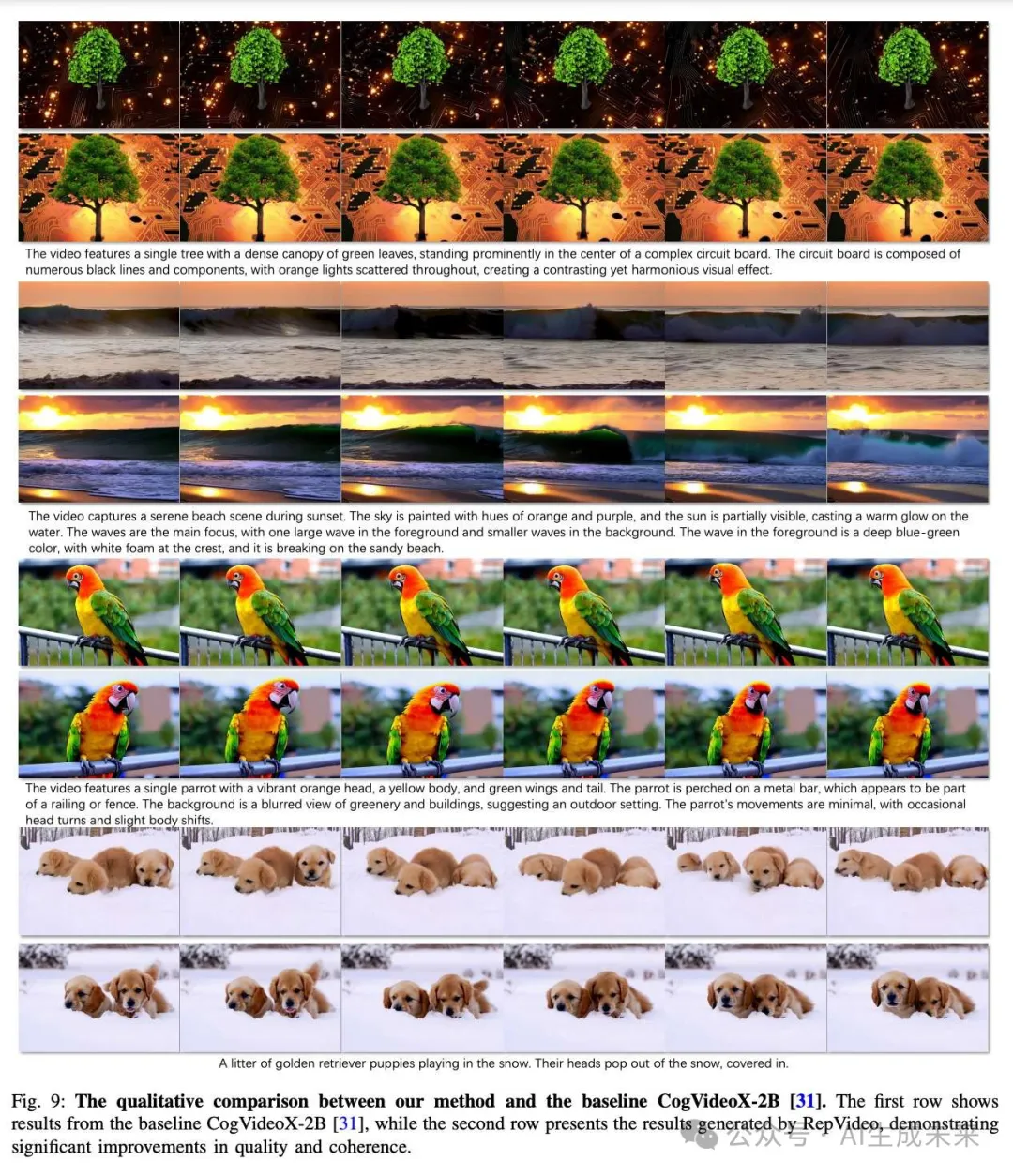

下图 9 提供了本文方法与基准模型 CogVideoX-2B 的定性比较,展示了本文模型取得的显著改进。本文方法生成的结果呈现在第二列,基准模型的输出则显示在第一列。显而易见,本文的方法生成了更加视觉一致且语义准确的视频,捕捉到了提供提示中的空间和时间关系。例如,在提示“几只金毛寻回犬幼犬在雪地里玩耍,它们的头从雪地里冒出来,覆盖着……”下,本文的模型保持了时间一致性,确保了幼犬在不同帧之间外观和动作的一致性。相比之下,基准模型的表现不稳定,导致了伪影和不一致性。

在提示“日落时分的宁静海滩场景”中,本文的方法有效地捕捉了日落的平滑运动和空间精度,而基准模型无法理解日落。同样,对于提示“一个树木茂盛、绿色叶片密集的单棵树,显著地站立在复杂电路板的中央”,本文的方法保持了精细的细节和空间对齐,而基准模型则显示出明显的抖动和空间不一致性。最后,在提示“一个拥有鲜艳橙色头部、黄色身体、绿色翅膀和尾巴的鹦鹉”下,本文的模型确保了鲜艳的色彩和平滑的过渡,保持了时间稳定性。基准模型则未能生成连贯的运动,导致了视觉失真。这些定性结果突显了我们提出的 RepVideo 框架在生成具有增强时间一致性和空间忠实度的高质量视频方面的优势。

人工评估

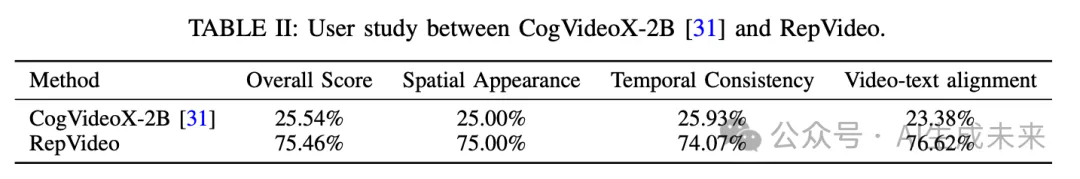

除了自动评估外,本文还进行了全面的人工评估,以评估本文的模型相较于最先进方法的表现。人工评估者展示了不同模型生成的视频对,且每对视频都基于相同的文本提示进行条件化。评估者根据三个关键标准,独立评估并选择他们偏好的视频:视频与文本的对齐、时间一致性和空间外观。这些标准来源于 VBench 中的维度设计,确保了标准化和严格的评估过程。

评估包括了两个模型:本文提出的 RepVideo 和 CogVideoX-2B。对于每个标准,评估者在本文模型和竞争方法生成的视频之间进行了 50 次配对比较。

如下表 II 所总结,本文的模型在所有三个指标上都取得了超过 50% 的平均胜率,证明了其在生成具有更高语义对齐、更平滑时间过渡和更高视觉质量的视频方面的优势。这些结果强调了本文框架中引入的增强表示的有效性,正如人工评估者明显表现出的偏好所证明的那样。

消融实验

为了验证本文提出的方法的有效性,进行了两项实验,突出展示了RepVideo如何改善空间外观和时间一致性。这些评估结合了定性可视化和定量指标,展示了我们方法的优势。

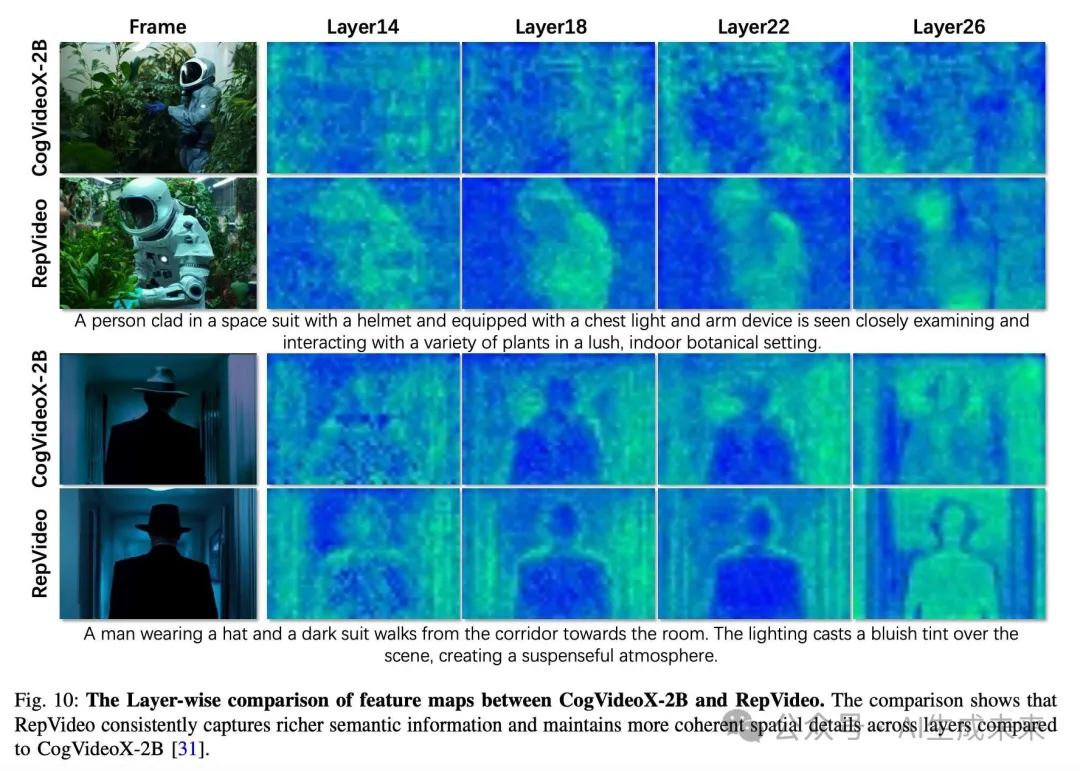

RepVideo如何改善空间外观下图10提供了CogVideoX-2B和RepVideo之间的特征图逐层比较。结果表明,本文的模型在特征图的深层处理中,始终能够捕捉到更丰富的语义信息,并保持更一致的空间细节。例如,在“一个穿着帽子和深色西装的男人从走廊走向房间”的例子中,RepVideo生成的特征图清晰地保持了男人的结构和轮廓,确保生成的视频保留了清晰且定义明确的空间属性。相比之下,CogVideoX-2B的深层特征图显示模糊且缺乏焦点,未能捕捉到场景的关键语义元素。

类似地,在“一个穿着太空服的人在室内郁郁葱葱的植物环境中与多种植物互动”的例子中,RepVideo的特征图展示了优越的能力,能够捕捉到细致的细节,例如宇航员和植物的明显轮廓。随着层深度的增加,本文的模型保持了语义一致性和空间完整性,而CogVideoX-2B在空间一致性方面存在困难,常常导致生成视频中的视觉伪影。这些结果强调了RepVideo丰富的表示的重要性,通过跨层聚合信息来稳定空间细节并增强语义对齐。

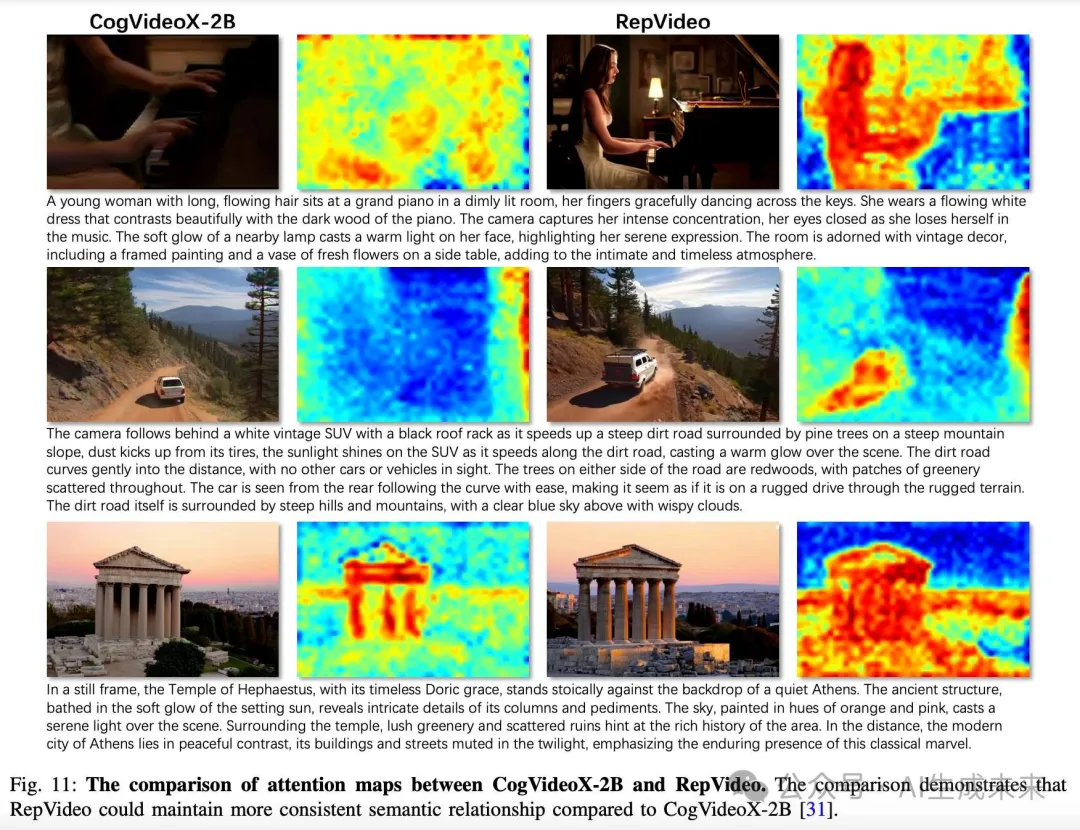

空间外观的改善可以归因于特征聚合机制,它利用连续层的中间表示。正如下图11所示,注意力图的可视化展示了不同提示下帧中对象的激活情况。与CogVideoX相比,RepVideo的注意力图清楚地显示了在不同提示下不同主体的边界,表明我们的聚合特征有助于加强相应的空间区域。通过结合这些特征,RepVideo减少了层间的变异性,并确保在整个视频生成过程中保留关键的空间信息。这一机制增强了模型生成视觉一致、与输入提示对齐的场景的能力。

RepVideo如何改善时间一致性除了改善空间细节外,RepVideo显著增强了时间一致性,这是生成连贯视频的关键因素。为了量化这一改进,我们计算了连续帧之间的余弦相似度,如图12所示。x轴表示层深度,y轴表示第n帧与第(n+1)帧之间的余弦相似度。更高的相似度值表明时间稳定性更好,连续帧之间的变化较小。

结果表明,RepVideo在所有层中都实现了比CogVideoX-2B更高的余弦相似度得分。例如,在像Layer 25和Layer 30这样的较深层中,RepVideo保持了强烈的帧间相似性,确保生成的视频没有时间伪影,如闪烁或抖动。相比之下,CogVideoX-2B在层深度增加时相似度急剧下降,表明其时间一致性较弱,且更容易出现运动不连续。

RepVideo所实现的增强时间一致性得益于其创新的特征缓存模块。通过聚合多个相邻层的特征,该模块稳定了中间表示并最小化了时间变异性。这一方法确保每一帧不仅在语义上与输入提示对齐,而且与前后帧保持一致。因此,RepVideo能够生成平滑过渡和连贯运动的视频,即使在涉及动态对象或环境的复杂场景中。

讨论

尽管RepVideo在现有方法上取得了显著进展,但仍有一些方面可以进一步改进。一个主要的限制是我们依赖于预训练模型,例如CogVideoX-2B。这些模型虽然强大,但由于其原始训练数据集的偏差和限制,可能会限制生成视频的多样性和适应性,尤其是在训练数据分布之外的场景中。

另一个改进的方向是与特征聚合机制相关的计算成本。尽管与添加新参数相比,这一方法相对轻量,但在实时应用或资源有限的环境中部署时,仍可能会面临挑战。因此,如何在不妥协其效果的前提下优化这一机制,是未来研究的重要方向。

此外,该方法在生成以人为中心的内容和理解复杂空间关系方面可能还需改进。如我们在实验中所示,RepVideo在需要精确建模人体动作或复杂物体布局的视频生成中,偶尔会出现一致性问题。

未来的研究可以集中在开发实时的特征聚合机制。此外,将本文的方法与不同的文本到视频预训练模型结合,可能对整个社区带来益处。解决这些限制可以进一步扩展RepVideo的潜力,使其能够在文本到视频生成任务中设立新的基准。

结论

RepVideo

通过广泛的实验,验证了本文框架的有效性。RepVideo在自动化基准和人工评估中优于现有的最先进模型,展示了其在动态场景中保持时间一致性并生成详细、准确空间表示的能力。这些贡献代表了文本到视频生成领域的重要进展,为未来的创新和应用提供了坚实的平台。

本文转自AI生成未来 ,作者:AI生成未来