多智能体微调:用多样化推理链实现语言模型的自我提升

图片

图片

1. 问题:单一模型自我提升的瓶颈

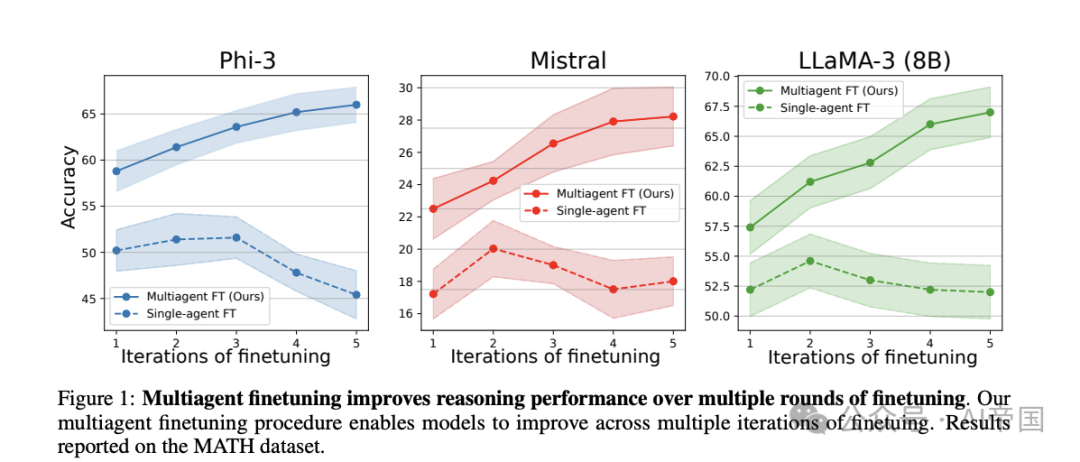

近年来,大语言模型(LLMs)如GPT-4取得了显著进展,但这些模型的性能仍然受限于已有的训练数据。尽管通过生成合成数据进行自我微调成为提升模型的主流方法,但随着微调轮次的增加,性能提升会迅速进入“收益递减”状态,模型的多样性和推理能力难以进一步提高。这种瓶颈限制了语言模型在复杂推理任务中的表现。

图片

图片

2. 方法:多智能体协作微调(Multiagent Finetuning)

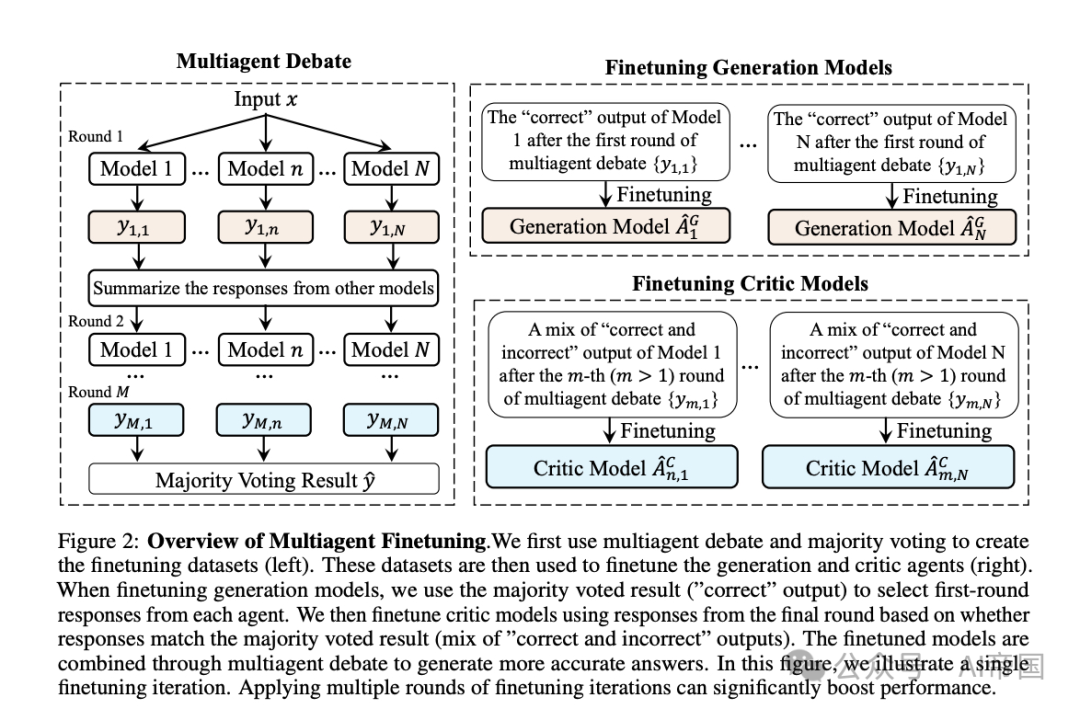

论文提出了一种全新框架——多智能体微调(Multiagent Finetuning),通过组建由多个语言模型组成的“智能体社会”,实现协作与自我提升:

智能体角色分工:将模型分为“生成智能体”和“评论智能体”。生成智能体负责提供初步答案,评论智能体对其进行批判性评估和改进,形成高质量反馈闭环。

数据独立性与多样性:每个智能体基于独立的数据子集进行微调,从而在推理链中实现角色的专业化与结果的多样化。

多智能体辩论机制:智能体间进行“辩论”以协同优化最终答案,确保整体推理链的逻辑性和准确性。

通过这一分级协作的方法,模型能够持续改进,克服单一模型方法中的多样性丧失问题。

图片

图片

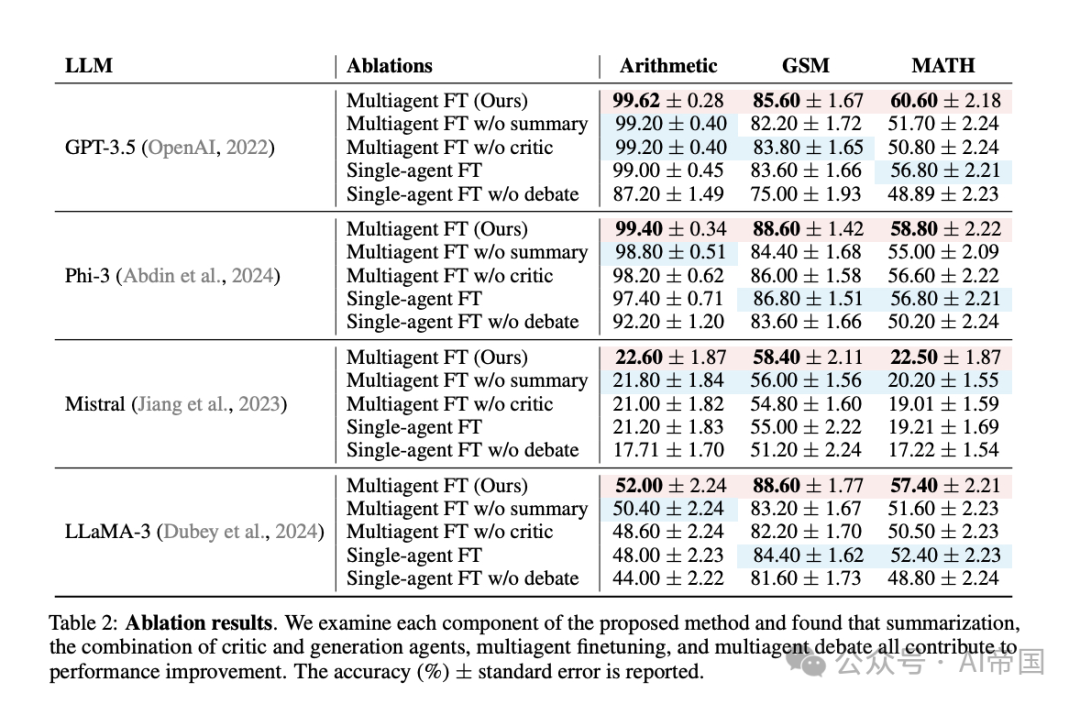

3. 结果:性能显著提升

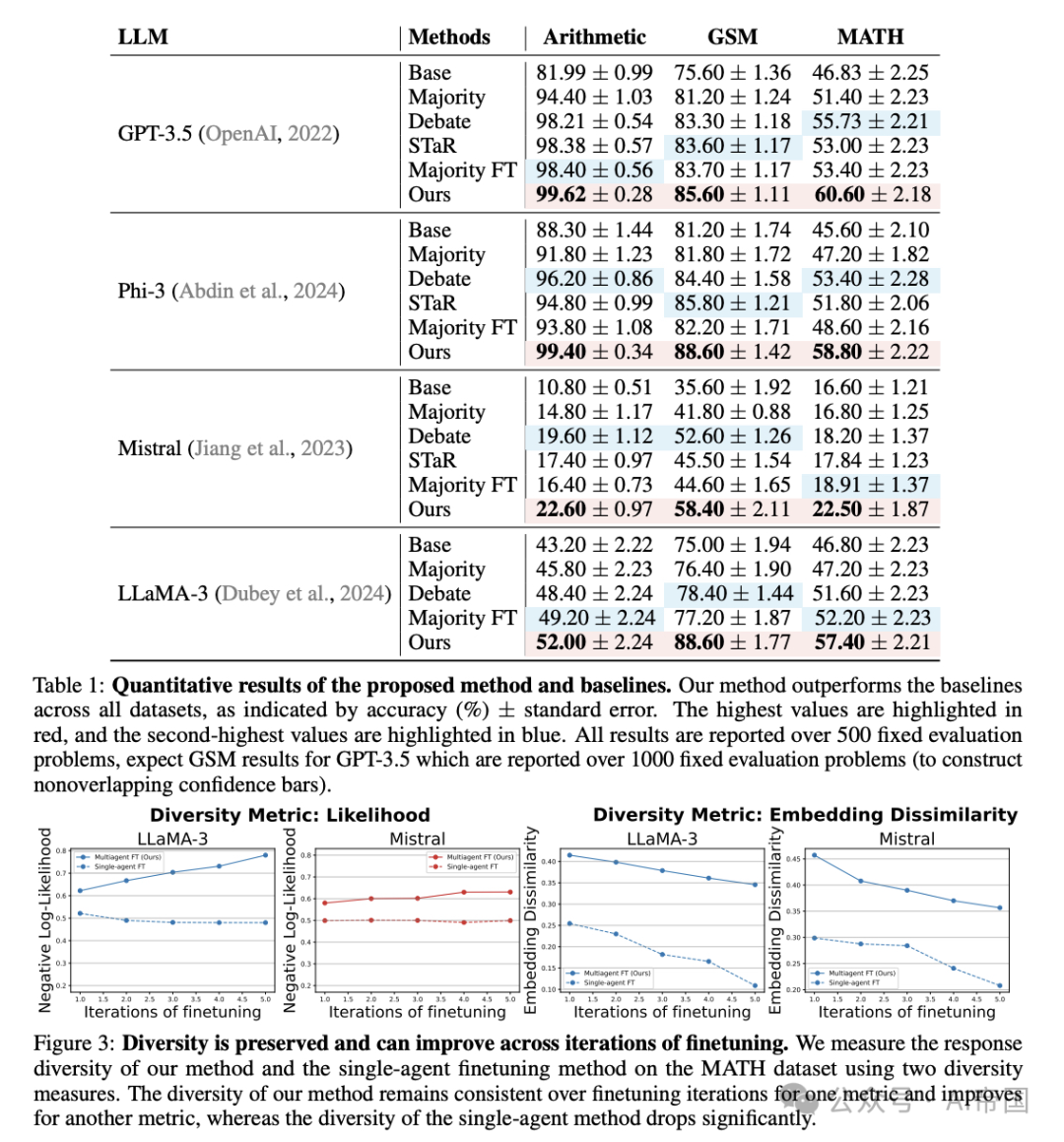

实验表明,多智能体微调在多种推理任务上显著超越现有基线方法,包括单一模型微调、基于投票的多智能体方法和其他辩论机制:

在开源模型(Phi-3、Mistral、LLaMA-3)和专有模型(GPT-3.5)上均实现了大幅性能提升。

在复杂任务如数学推理(MATH)和通用问题求解(GSM)中,多智能体微调方法不仅增强了准确性,还保留了丰富的推理链条和内容多样性。

即便在仅使用500个微调样本的情况下,效果仍超越了多轮单一模型微调方法。

图片

图片

4. 意义:为语言模型的未来开辟新路径

多智能体微调为语言模型的自我提升提供了全新的思路,不仅解决了单一模型在微调过程中性能瓶颈的问题,还展示了多智能体协作在复杂推理任务中的强大潜力。未来,这一方法可与人类反馈强化学习(RLHF)等技术结合,用于进一步优化语言模型的泛化能力和实用性。

图片

图片

总结:从“单兵作战”到“团队协作”,多智能体微调让语言模型自我提升的边界更加广阔,为复杂推理任务带来了新可能。

论文标题:Multiagent Finetuning: Self Improvement with Diverse Reasoning Chains

论文链接:https://arxiv.org/abs/2501.05707

本文转载自 AI帝国,作者: 无影寺