面向统一的单、多主体个性化文生图框架!阿里通义发布AnyStory!

论文链接:https://arxiv.org/pdf/2501.09503

项目链接:https://aigcdesigngroup.github.io/AnyStory/

亮点直击

- 提出了一种统一的单主体和多主体个性化框架,称为AnyStory。该框架在个性化单主体和多主体时实现了一致性,同时遵循文本提示;

- 引入了一种增强的主体表示编码器,由简化的轻量级 ReferenceNet 和 CLIP 视觉编码器组成,能够对一般主体进行高保真细节编码;

- 提出了一种解耦的实例感知router模块,能够准确感知和预测主体的隐空间条件区域,从而实现对单个或多个主体的灵活和可控的个性化生成;

- 实验结果表明,本方法在保持主体细节的真实性、对齐文本描述以及个性化多个主体方面表现出色。

总结速览

解决的问题:

- 生成具有特定主体的高保真个性化图像面临挑战,尤其是在涉及多个主体的情况下。

- 在不牺牲主体保真度的情况下,处理多个主体的个性化生成。

提出的方案:

- 提出 AnyStory,一种统一的单主体和多主体个性化框架。

- 采用“编码-route”的方式来建模主体个性化问题。

- 在编码步骤中,利用 ReferenceNet 和 CLIP 视觉编码器实现高保真编码。

- 在route步骤中,使用解耦的实例感知主体router,准确感知和预测隐空间中主体的位置。

应用的技术:

- ReferenceNet:一种简化的轻量级图像编码器,用于高保真细节编码。

- CLIP 视觉编码器:用于增强主体表示的编码。

- 解耦的实例感知route模块:用于准确感知和预测主体的隐条件区域,实现灵活和可控的个性化生成。

达到的效果:

- 在保留主体细节、对齐文本描述和个性化多个主体方面表现优异。

- 实现了单主体和多主体个性化的一致性,同时遵循文本提示。

方法

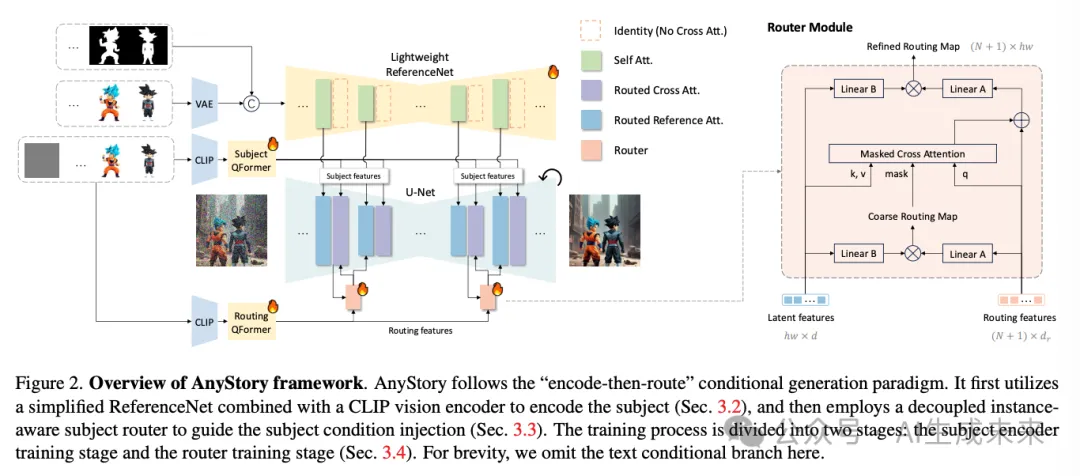

AnyStory,这是一种在文本到图像生成中实现单主体和多主体个性化的开创性方法。首先回顾扩散模型的背景,然后详细介绍两个提出的关键组件,即增强的主体编码器和解耦的实例感知主体router。最后,介绍本文的训练方案。方法的框架如下图 2 所示。

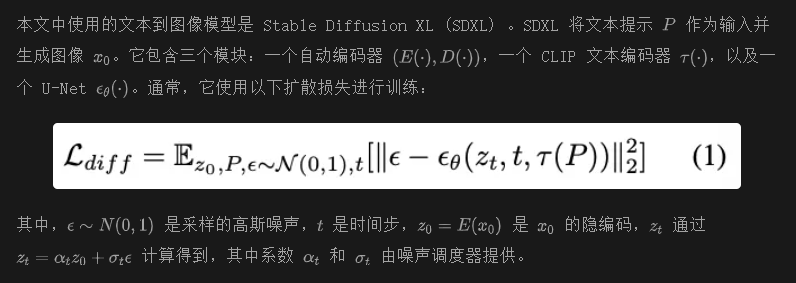

预备知识

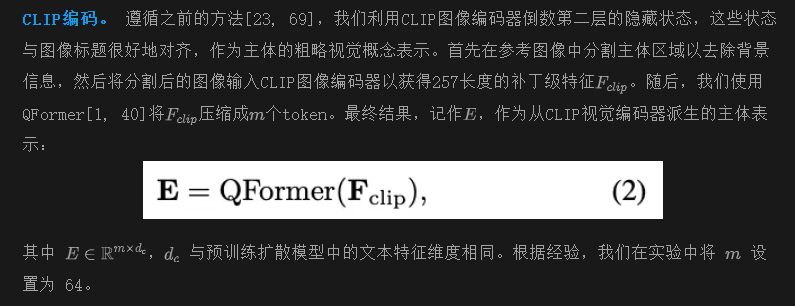

增强的主体表示编码

在开放领域中个性化主体图像,同时确保对主体细节和文本描述的忠实度,仍然是一个未解决的问题。一个关键的挑战在于主体信息的编码,这需要在最大限度地保留主体特征的同时,保持一定的编辑能力。当前主流方法[16, 39, 44, 46, 56, 66, 69, 70]主要依赖CLIP视觉编码器来编码主体。然而,由于对比图像-文本训练范式的原因,CLIP的特征主要是语义性的,并且分辨率较低(通常为224 × 224),因此在提供主体详细信息方面存在局限性。替代方法[19, 41, 48, 64]结合了特定领域的专家模型,如面部编码器[12, 29],以增强主体身份表示。尽管这些方法取得了一定的成功,但它们在其领域内是有限的,不能扩展到一般主体。

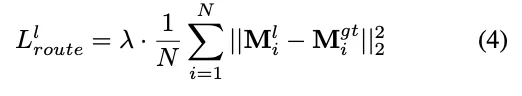

为了解决这些问题,引入了ReferenceNet,一种强大而多功能的图像编码器,与CLIP视觉编码器一起编码主体。ReferenceNet利用变分自编码器(VAE)来编码参考图像,然后通过与U-Net相同架构的网络提取其特征。它具有三个显著优势:(1)支持更高分辨率的输入,从而能够保留更多的主体细节;(2)其特征空间与去噪U-Net对齐,便于U-Net在不同深度和尺度上直接提取主体特征;(3)使用预训练的U-Net权重进行初始化,这些权重具有丰富的视觉先验,并在学习一般主体概念方面表现出良好的泛化能力。

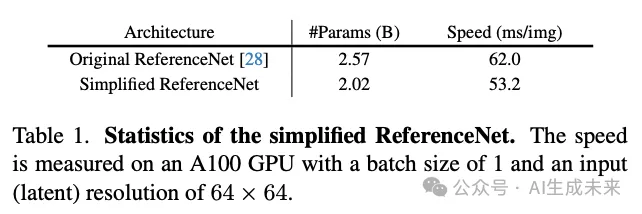

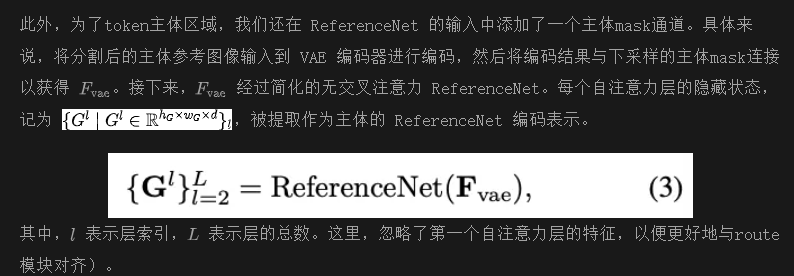

ReferenceNet 编码。 在原始实现中ReferenceNet 采用与 U-Net 相同的架构,包括带有文本条件注入的交叉注意力块。然而,由于在我们的任务中 ReferenceNet 仅用作视觉特征提取器,并不需要文本条件注入,我们跳过了所有交叉注意力块,从而减少了参数数量和计算复杂度(见下表 1)。

解耦的实例感知主体route

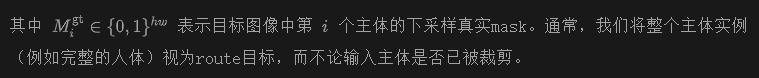

注入主体条件时需要仔细考虑注入位置,以避免影响不相关的目标。以前的方法 [37, 39, 56, 66, 69, 70] 通常通过简单的注意力模块将条件特征注入隐空间。然而,由于软加权机制,这些方法容易出现语义泄漏 [10, 67],导致主体特征的混合,特别是在生成外观相似的实例时。一些方法 [18, 34, 38, 44, 46, 65, 71] 引入了预定义的布局mask来解决这个问题,但这限制了它们的实际应用。UniPortrait [23] 提出了一种router,可以自适应地感知并限制主体条件的影响区域;然而,其route特征完全与主体特征耦合,这限制了route模块的能力;此外,它没有考虑主体条件对背景的影响。在本研究中,我们提出了一种解耦的实例感知主体route模块,可以准确有效地将主体特征route到相应区域,同时减少对不相关区域的影响。

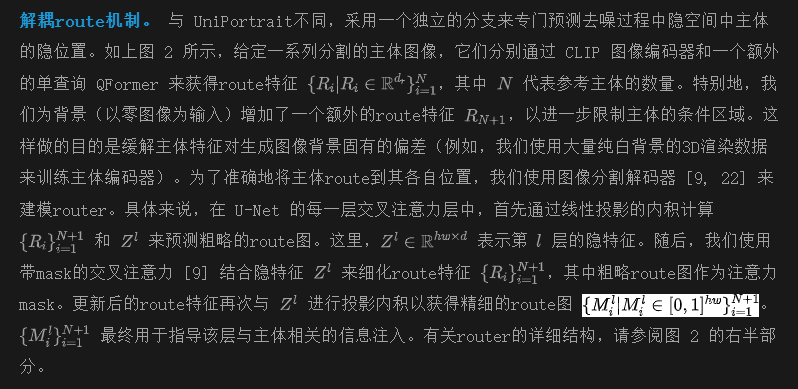

实例感知route正则化损失。 为了促进router学习并区分不同实例的主体,我们引入了一种实例感知route正则化损失。损失函数定义为:

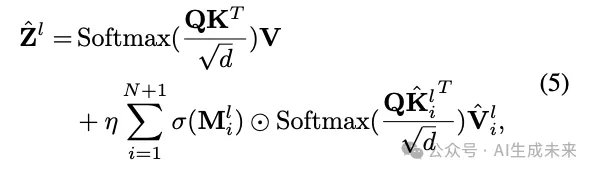

route引导的主体信息注入。 对于CLIP编码的主体表示,我们使用解耦的交叉注意力 [69] 将其整合到U-Net中,但增加了route引导的定位约束:

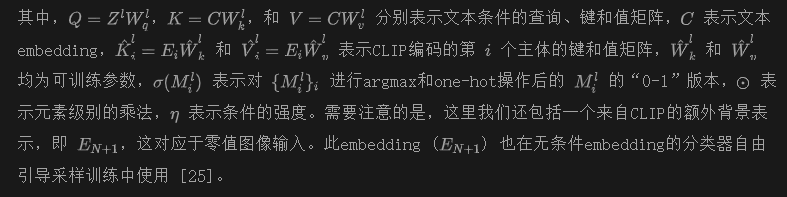

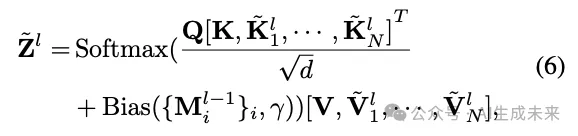

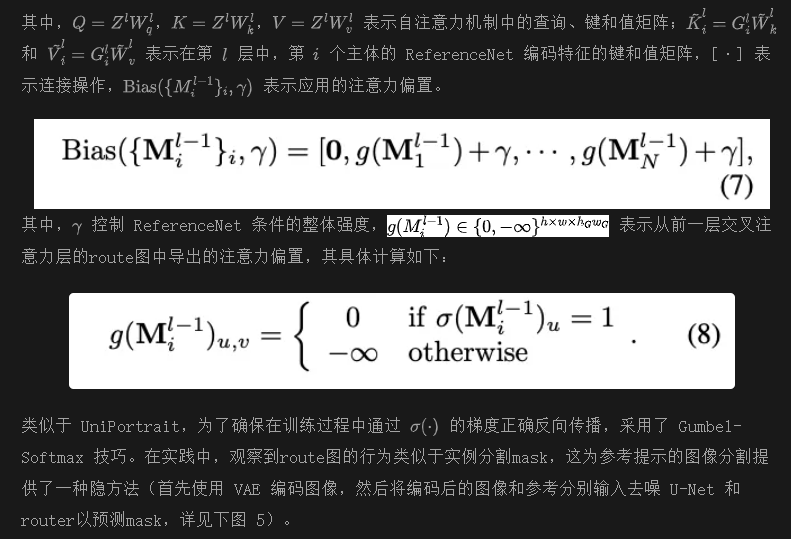

关于ReferenceNet编码的主体特征的注入,采用原始参考注意力,但增加了由route图引导的额外注意力mask。稍微滥用一下符号,这个过程可以表示为:

训练

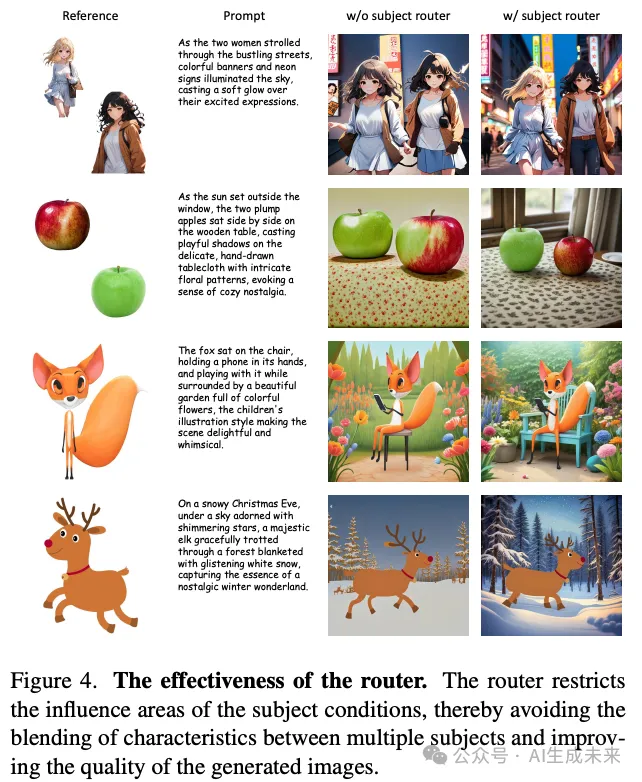

根据 UniPortrait,AnyStory 的训练过程分为两个阶段:主体编码器训练阶段和router训练阶段。

主体编码器训练:训练主体 QFormer、ReferenceNet 及注意力块中的对应键和值矩阵。ReferenceNet 使用预训练的 UNet 权重进行初始化。为了避免主体特征的细粒度编码导致的复制粘贴效应,收集了大量配对数据,这些数据在保持主体身份一致的同时展示了背景、姿势和视角的变化。这些数据来自于图像、视频和 3D 渲染数据库,并由 Qwen2-VL 进行标注。具体来说,图像(约 41 万)和视频(约 52 万)数据主要来自以人为中心的数据集,如 DeepFashion2 和人类舞蹈视频,而 3D 数据(约 560 万)则来自 Objaverse ,其中从七个不同角度渲染的物体图像作为配对数据。在训练过程中,这些配对中的一张图像用作参考输入,而另一张图像则在不同的背景下展示相同的主体身份,作为预测目标。此外,还对参考图像应用了包括随机旋转、裁剪和零填充在内的数据增强技术,以进一步防止主体过拟合。该阶段的训练损失与原始扩散损失相同,如公式(1)所示。

实验

设置

使用 stable diffusion XL 作为基础模型。所使用的 CLIP 图像编码器是 OpenAI 的 clip-vit-huge-patch14。主体 QFormer 和route QFormer 都由 4 层组成。ReferenceNet 的输入图像分辨率为 512×512。所有训练在 8 个 A100 GPU 上进行,批大小为 64,使用 AdamW优化器,学习率为 1e-4。为了促进无分类器引导的采样 [25],在训练时对 10% 的图像去掉 CLIP 主体条件。在推理过程中,使用 25 步 EDM采样和 7.5 的无分类器引导比例,并使用来自 huggingface 的 RealVisXL V4.0 模型以实现更逼真的图像生成。

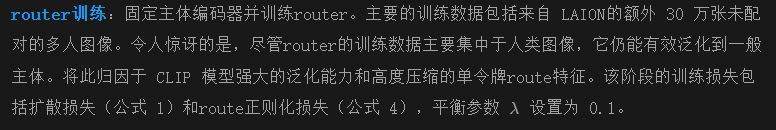

ReferenceNet 编码器的效果

下图 3 展示了 ReferenceNet 编码器的有效性,相较于仅使用 CLIP 视觉编码器,它增强了主体细节的保留。然而,显然仅使用 ReferenceNet 并不能产生令人满意的结果。事实上,在大量测试中发现,ReferenceNet 编码器只能实现主体细节的对齐,而不能引导主体生成。仍然需要依赖与文本embedding良好对齐的 CLIP 编码特征来触发主体生成。

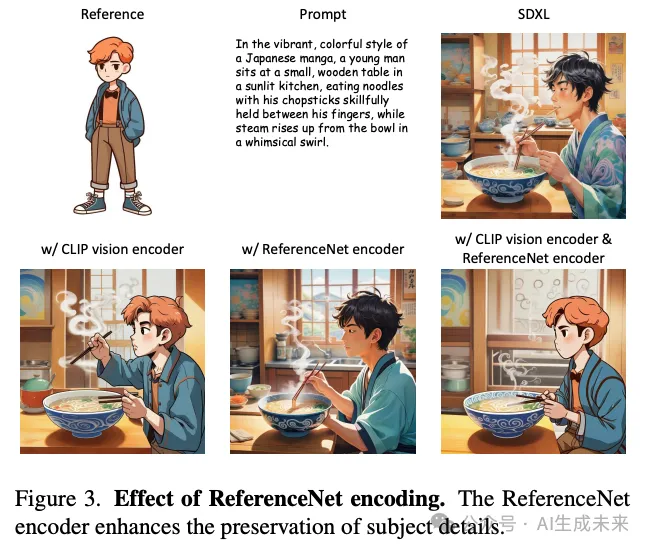

解耦实例感知router的效果

下图 4 展示了所提出router的有效性,它可以有效避免多主体生成中主体之间的特征混合。此外,观察到在单主体设置中使用router也提高了生成图像的质量,特别是在图像背景中。这是因为router限制了主体条件的影响区域,从而减少了主体特征固有的隐偏差(例如,从大量 3D 渲染数据中学习到的简单白色背景偏好)对生成图像质量的影响。

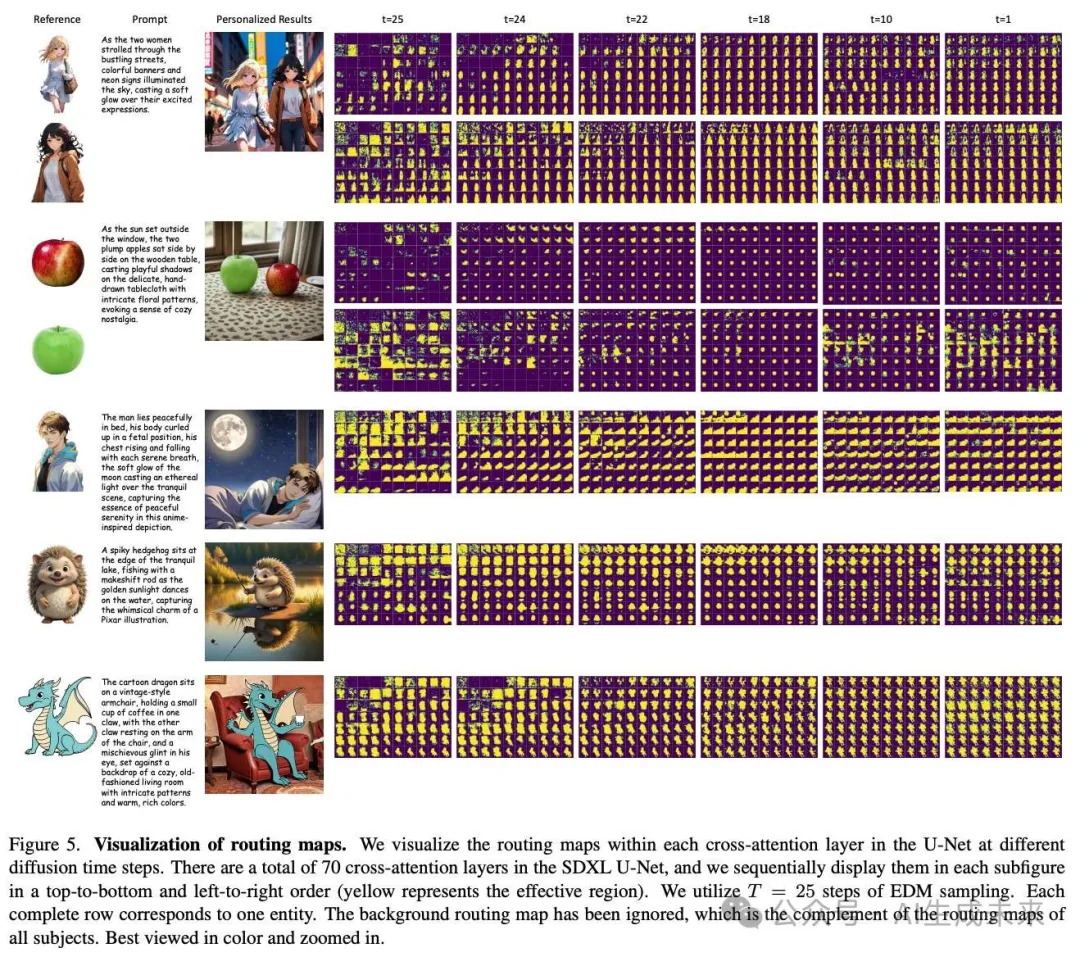

上图 5 可视化了扩散模型在去噪过程中不同时间步的route图。这些结果表明,所提出的router可以在去噪过程中准确感知并定位每个主体条件的影响区域。显示的route图类似于图像分割mask,表明通过去噪 U-Net 和训练好的router可以实现基于参考图像的引导图像分割的潜力。此外,如前文所述,尽管router主要在以人为中心的数据集上训练,但它对一般主体(如上图 5 中的卡通恐龙)具有良好的泛化能力。我们将此归因于 CLIP 模型强大的泛化能力和高度压缩的单token route特征。

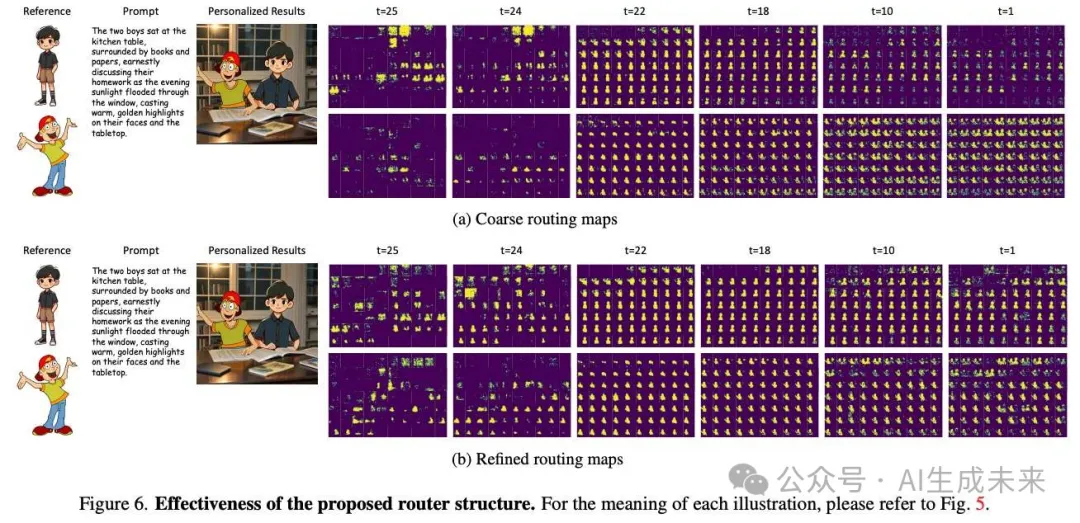

下图 6 展示了将router建模为微型图像分割解码器的有效性。与通过简单点积获得的粗略route图相比,通过轻量级mask交叉注意模块细化后的route图可以更准确地预测每个主体的隐位置。

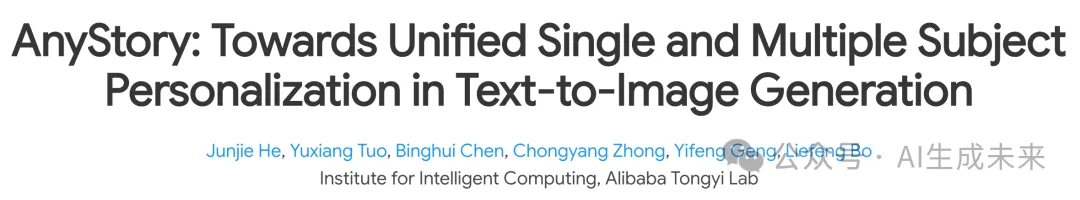

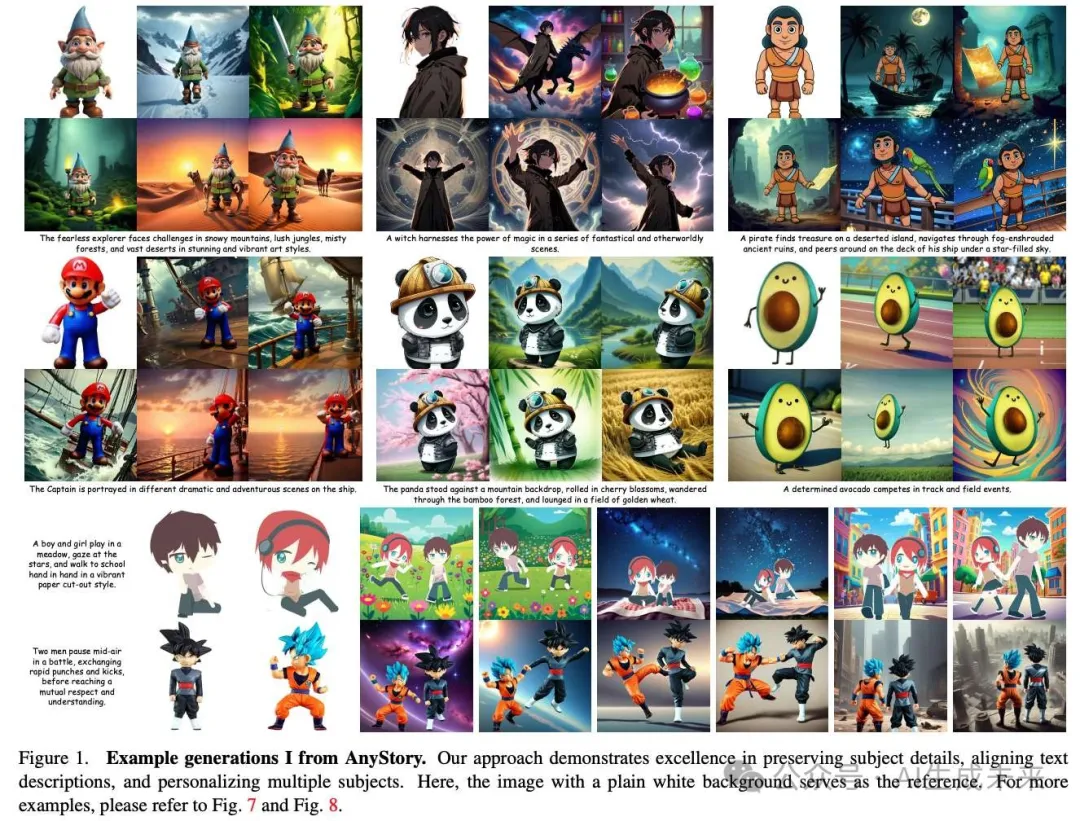

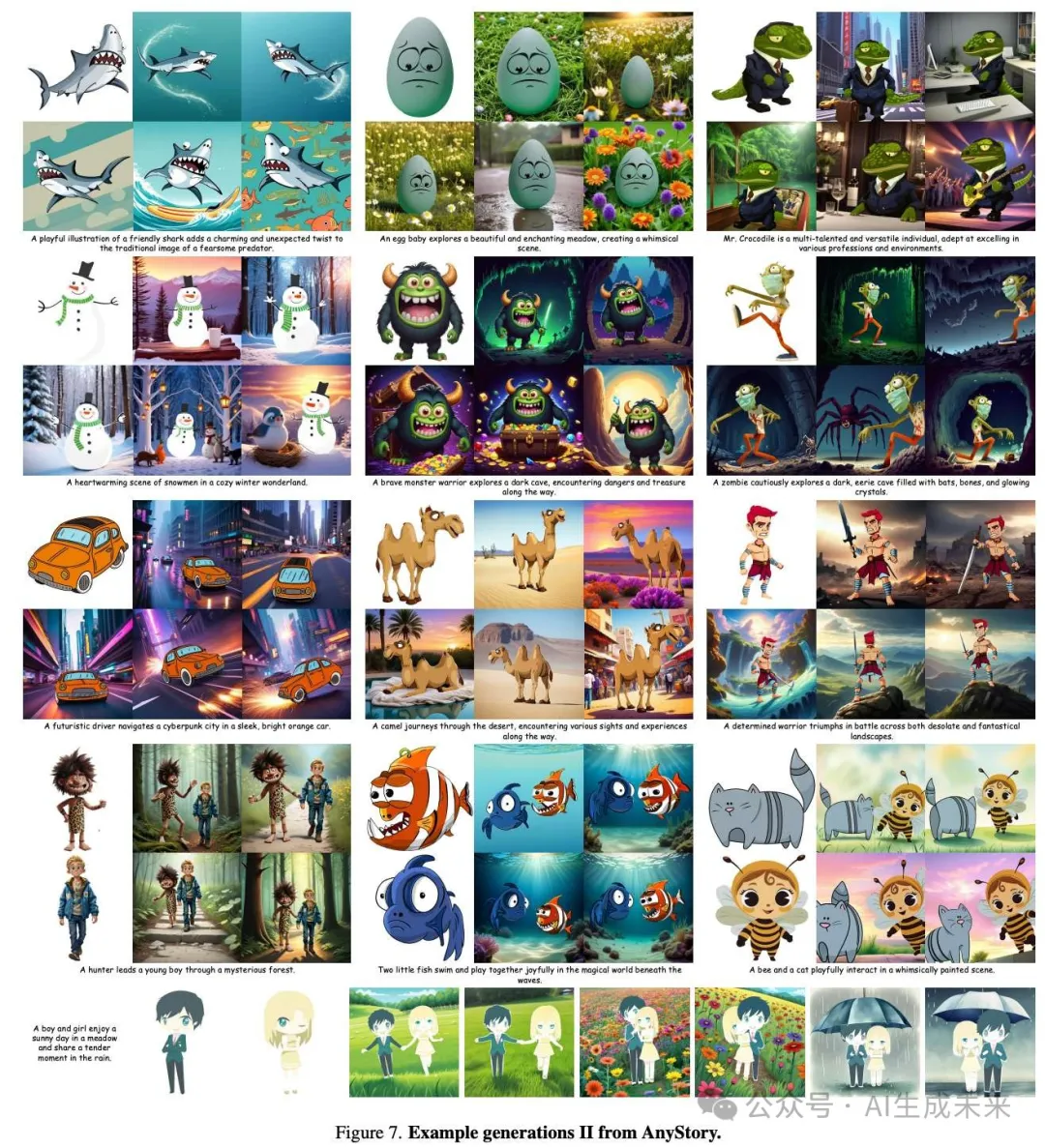

示例生成

在上图 1、上图 7 和上图 8 中,展示了本方法的更多结果,显示了其在保持主体细节、对齐文本提示以及实现多主体个性化方面的卓越性能。

结论

AnyStory是一种针对单主体和多主体个性化生成的统一方法。AnyStory 利用通用且强大的 ReferenceNet 以及 CLIP 视觉编码器来实现高保真度的主体编码,并采用解耦的、实例感知的route模块,以灵活和准确地注入单/多主体条件。实验结果表明,本方法在保留主体细节、与文本描述对齐以及多主体个性化方面表现出色。

局限性和未来工作。 目前,AnyStory 无法为图像生成个性化背景。然而,在序列图像生成中保持图像背景的一致性同样重要。未来,将扩展 AnyStory 的控制能力,从主体域扩展到背景域。此外,AnyStory 生成的主体中仍然存在复制粘贴效应,我们计划通过数据增强和使用更强大的文本到图像生成模型来进一步缓解这一问题。

本文转自AI生成未来 ,作者:AI生成未来