华为诺亚方舟实验室突破具身AI瓶颈, SpatialCoT通过坐标对齐和思路链推进空间推理

具身人工智能的目标是使机器人或虚拟代理能够像人类一样理解和操作其所在的物理环境,而空间推理被视为实现具身任务规划的关键能力。导航和操作任务是具身AI中常见的挑战,依赖于模型对空间关系的理解和高效执行复杂任务的能力,但现有方法在处理复杂空间推理任务时仍面临诸多局限,难以满足实际应用的需求。

现有方法大多通过补充空间数据和模型微调来提升空间推理能力,可是这些方法主要依赖于语言生成的粗粒度结果,难以在复杂环境中管理更精细的任务。一些方法引入了基于点的动作空间来缓解这一问题,但在处理复杂任务时仍存在明显不足,原因在于未充分利用视觉语言模型固有的思维和推理能力。另外,现有模型主要在配有文本的2D图像数据上训练,缺乏理解空间关系所需的信息。

为了解决上述问题,华为诺亚方舟实验室提出了一种新方法SpatialCoT,目标是增强视觉语言模型(VLMs)的空间推理能力。SpatialCoT由两个主要阶段组成:空间坐标双向对齐和链式思维空间定位。通过这些阶段,模型能够更好地理解和生成坐标基于的响应,并利用语言模型的推理能力进行高级空间推理。实验结果表明,SpatialCoT在导航和操作任务中显著优于之前的最先进方法。研究团队的相关论文《SpatialCoT: Advancing Spatial Reasoning through Coordinate Alignment and Chain-of-Thought for Embodied Task Planning》近日发表于 arXiv,引起业内广泛关注。

研究团队是由来自华为诺亚方舟实验室的一组杰出研究人员组成,包括Yuecheng Liu, Dafeng Chi, Shiguang Wu, Zhanguang Zhang, Yaochen Hu, Lingfeng Zhang, Yingxue Zhang, Shuang Wu, Tongtong Cao, Guowei Huang, Guangjian Tian, Xingyue Quan, Jianye Hao和 Yuzheng Zhuang。华为诺亚方舟实验室是华为旗下专注于人工智能和机器学习研究的机构,致力于推动前沿技术的发展,特别是在视觉语言模型和具身人工智能等领域的创新与应用。团队成员在各自领域拥有丰富的研究经验和专业知识,共同推动了SpatialCoT的开发和应用。

这些研究人员在视觉语言模型、具身AI和空间推理领域积累了丰富的经验和深厚的知识基础。他们的合作与研究不仅推动了理论的发展,也对实际应用产生了重要影响。通过他们的不懈努力,SpatialCoT为具身任务规划提供了一个创新的解决方案,展示了其在复杂环境中处理导航和操作任务的巨大潜力。

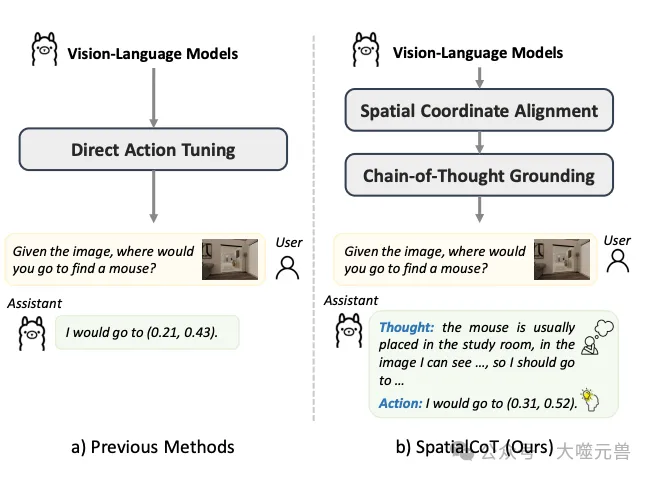

图1:SpatialoT与以前方法的比较。a) 以前的方法通常直接根据语言指令输出动作。b) SpatialoT通过有效利用VLM的推理能力来提高动作生成质量。这是通过两个阶段的微调过程实现的,涉及空间坐标对齐和思维链空间基础。

这篇论文的贡献不仅在于提出了一种新的空间推理方法,更在于其对未来研究方向的引领和启发。随着技术的不断进步,SpatialCoT方法有望在更多实际应用中发挥重要作用,为机器人和智能代理的自主性和智能化提供坚实的技术支持。

方法介绍

空间坐标双向对齐

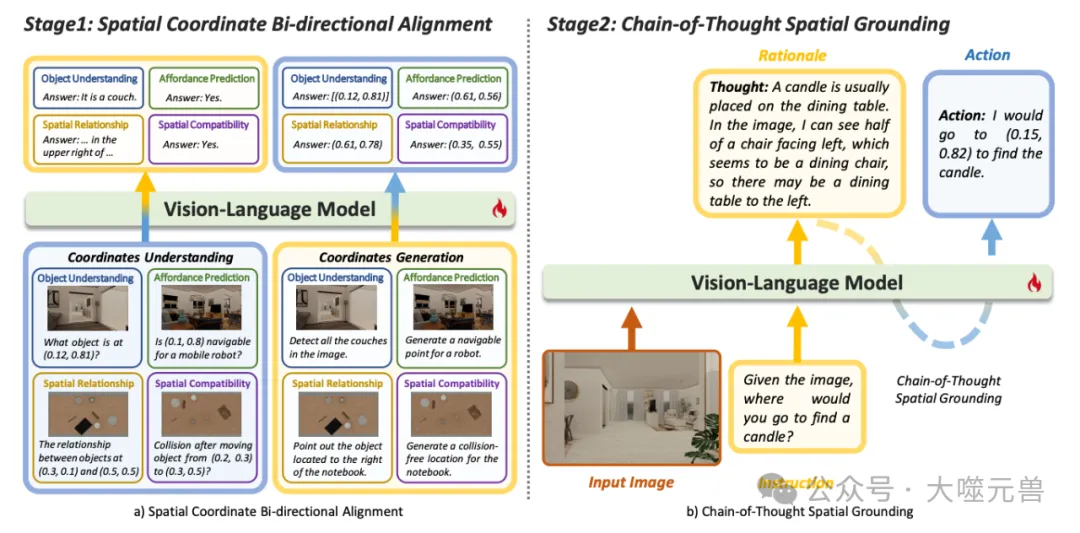

图2:SpatialIoT概述,包括两个核心阶段。a) 空间坐标双向对齐,包括将坐标转换为语言(由左侧的蓝色到黄色箭头表示)和语言转换为坐标(由右侧的黄色到蓝色箭头表示)。b) 思维链空间接地:该模型首先通过生成基于语言的基本原理进行综合思维,然后将其接地为基于坐标的动作(黄色到蓝色虚线),显著提高了模型在复杂空间推理任务中的性能。

空间坐标双向对齐是SpatialCoT方法的第一个核心阶段。其主要目的是通过明确对齐视觉-语言输入与空间坐标,从而增强模型的空间理解和响应生成能力。具体而言,这一阶段涉及将图像和文本描述与具体坐标进行双向映射,使模型能够更精准地理解和生成基于坐标的反馈。

空间坐标双向对齐通过两种形式的数据对齐实现。第一种形式是将图像与包含坐标的文本指令进行配对,模型需输出指令中描述坐标的相关信息。第二种形式是将图像与不含坐标的语言指令进行配对,模型需生成一个或多个坐标来指示指令中描述的位置或区域。

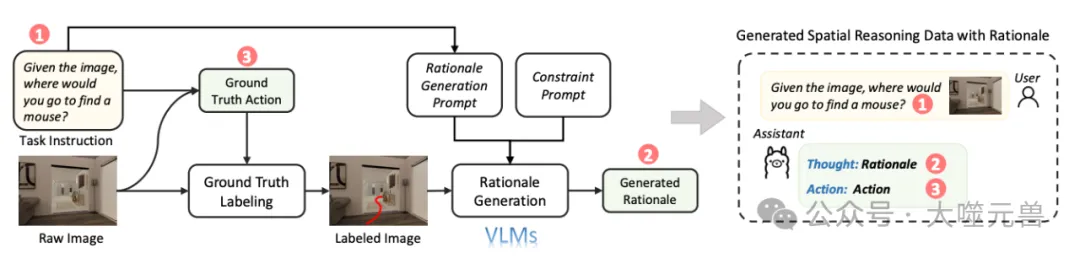

图3:思维链空间接地的数据采集管道。

在图像与坐标的双向对齐机制中,首先将视觉-语言数据与坐标进行显式对齐,这一过程通过设计不同类型的数据(如对象理解、可用性预测、空间关系和空间兼容性)来实现。通过双向对齐,使得模型不仅能根据坐标理解文本描述,还能根据文本描述生成准确的坐标。

在具体数据处理过程中,模型需要处理两种主要的数据形式。一种是图像与包含具体坐标的文本描述配对,另一种是图像与不包含坐标的文本描述配对。具体示例如“图像中物体位于(0.81, 0.90)的位置”以及“请指出图像中所有椅子的位置”,前者要求模型理解并生成关于坐标的反馈,而后者则要求模型生成对应的坐标。

链式思维空间定位

链式思维空间定位是SpatialCoT的第二个核心阶段,旨在通过语言模型的推理能力进行高级空间推理。不同于直接生成基于坐标的动作,这一阶段通过语言推理过程将复杂的空间推理问题逐步分解,生成细粒度的动作计划。

链式思维空间定位通过生成包含推理过程和具体动作的数据来实现。首先,模型需生成基于任务的推理过程,利用语言空间中的推理能力进行任务指导。然后,模型基于推理过程生成对应的基于坐标的动作。这一过程通过在前一阶段对齐的语言和坐标数据中实现,无需大量的微调数据。

在这一阶段,模型通过内在推理能力进行复杂的空间定位。模型首先生成任务的推理过程,利用语言模型中的空间和常识推理能力,指导任务的完成。然后,基于推理过程生成相应的坐标动作,实现高级空间推理任务的解决。

为了高效地生成高质量的推理-动作数据对,我们设计了一条自动化数据生成流水线。初始阶段,基于图像和任务指令从模拟器中获取真实动作,并在图像上进行标注。接着,利用强大的视觉语言模型生成基于动作标注图像和任务指令的推理过程,并通过加入额外的约束来确保推理过程的有效性。最终,通过微调模型,使其能够高效处理复杂的空间推理任务。

实验设计

SpatialCoT的方法通过一系列精心设计的实验验证了其在具身任务中的有效性。

图4:现实世界的重排实验,SpatialoT将各种对象组合排列成合理的布局,遵守物理约束并避免碰撞。

研究团队采用闭环具身任务规划的方法,通过在模拟器中进行任务设置和评估,全面考察SpatialCoT在导航和操作任务中的表现。任务设置包括状态、目标、动作和转换的具体设置,以确保任务的复杂性和真实性。

状态、目标、动作、转换的具体设置

在状态方面,研究团队主要考虑了视觉遮挡、物体堆叠和封装遮挡等因素。此外,还涉及物体属性如几何形状和可移动性。目标设置包括物体数量、空间约束和目标描述的抽象程度。动作设置则考虑了动作空间的格式和所需技能的数量。转换方面,研究团队处理了环境的动态不确定性,通过不同复杂度的层次进行任务分解。

导航任务和操作任务的详细描述

导航任务采用了更具挑战性的目标物体导航评估任务。与传统的区域定位任务不同,目标物体导航要求模型生成最佳的次目标点,以尽快找到不在视野内的目标物体。例如,模型需要根据图像生成最佳路径点,以找到目标物体的位置。

操作任务采用了餐桌功能重排评估任务,这是对RoboPoint任务的进一步扩展。给定一个目标布局描述,模型需要逐步生成每个物体的起始和结束位置,直到达到期望的布局。例如,模型需要根据语言指令逐步将餐桌上的物品摆放到指定位置。

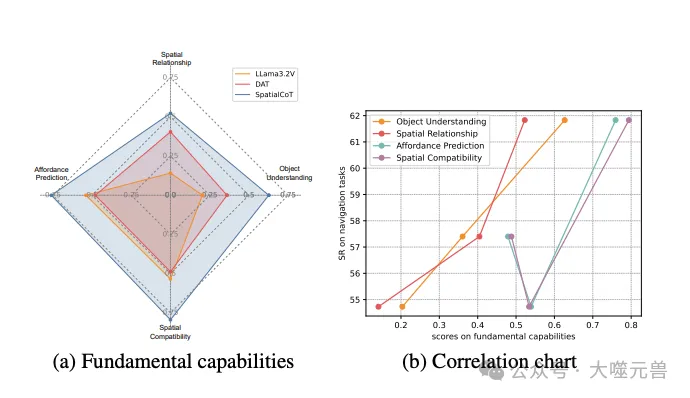

基本能力评估

除了具身任务规划,研究团队还评估了视觉语言模型的基本能力,以理解这些能力与任务规划性能之间的关系。这些基本能力包括对象理解、可用性预测、空间关系和空间兼容性。

- 对象理解:匹配自然语言描述与图像中的具体视觉内容。

- 可用性预测:识别和预测环境中可执行的动作,如确定可导航区域或如何操作物体。

- 空间关系:理解物体之间的空间关系。

- 空间兼容性:预测和理解物体之间的兼容性。

实验设置

数据收集方面,研究团队使用了两个主要场景数据集。导航任务的数据收集依赖于Habitat合成场景数据集(HSSD),并使用Habitat作为模拟器进行闭环模型评估。操作任务的数据收集则使用Sapien作为模拟器,生成多样的桌面重排任务和数据。为了提高视觉真实度并减少模拟与现实的差距,研究团队使用Blender渲染器获取高质量图像进行数据收集。

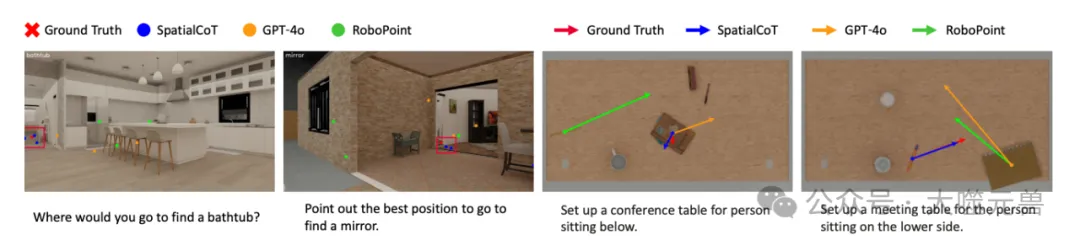

图5:导航和操纵任务中空间推理结果的可视化

数据生成和处理

数据生成过程中,研究团队通过大语言模型的强大生成能力,半自动化地构建桌面功能重排任务的数据。此外,通过引入高质量数据进行模型微调,使得SpatialCoT在复杂环境中的表现更加稳定和出色。

模型训练

在模型训练过程中,研究团队选择了Llama3.2-Vision 11B作为视觉语言模型的骨干。训练方法包括使用LoRA进行微调,整个训练过程分为两个阶段,每个阶段进行了2个epoch的训练。所有实验在配备8块NVIDIA L40 GPU的单台机器上进行,确保了训练的高效和稳定。

对比基线

为了验证SpatialCoT的有效性,研究团队将其与多个基线模型进行对比。这些基线模型包括专门的空间推理模型RoboPoint、开源视觉语言模型LLaMA3.2V以及闭源模型GPT-4o。通过对比这些基线模型,研究团队全面评估了SpatialCoT在不同任务和环境中的性能表现。

实验结果

通过一系列实验,SpatialCoT展示了其在导航和操作任务中的显著优势。

导航任务结果

在导航任务中,研究团队引入了两个关键指标:距离增益(DG)和成功率(SR)。距离增益衡量生成动作的质量,成功率则评估模型在模拟器内的整体表现。

在比较不同基线模型时,GPT-4o ICL和Llama3.2V 11B零样本的距离增益分别为-0.27和-2.47,表明这些模型生成的动作质量低于平均水平。而RoboPoint模型的距离增益为0.21,尽管有所提升,但仍不足以应对需要高推理能力的复杂任务。采用直接在动作生成数据上微调模型的方法,距离增益达到了2.28。通过加入空间坐标双向对齐,这一数值进一步提高到3.23,而链式思维空间定位则将其提升至2.83。当结合这两个阶段时,距离增益达到了3.33,相比直接动作微调提升了46%。

在成功率方面,SpatialCoT达到了61.83%,相比直接动作微调提高了4.43%,并且在所有评估的开源和闭源模型中表现最佳。

操作任务结果

在操作任务中,研究团队引入了碰撞率(CR)和成功率(SR)作为评估指标。碰撞率衡量生成动作的有效性,成功率则评估任务在指令描述和无碰撞条件下的完成情况。

零样本评估中,先前模型的成功率为零,主要由于碰撞率较高。而直接动作微调将碰撞率降至21.3%,成功率提高至75.8%。SpatialCoT进一步改进了这些指标,碰撞率降至15.6%,成功率提高到82.6%,表明在端到端任务成功率上有显著提升。

问题分析

图6:分析VLM的基本能力和具体任务规划之间的相关性,DAT表示直接动作调整。

通过对具体任务规划的分析,研究团队发现SpatialCoT在高复杂度任务中表现尤为出色。操作任务中,主要的失败来源于非独特物体和大量物体的处理,这些场景容易导致碰撞。而在导航任务中,SpatialCoT在需要稀疏奖励信号的任务中表现尤为突出,特别是在目标较少且距离较大的复杂任务中表现显著提高。

对基本能力与下游任务性能的相关性分析显示,SpatialCoT在所有评估类别中均优于其他模型。特别是对象理解和空间关系这两个类别显示出明显的正相关关系,表明这些基本能力对模型在具体任务中的表现具有重要影响。

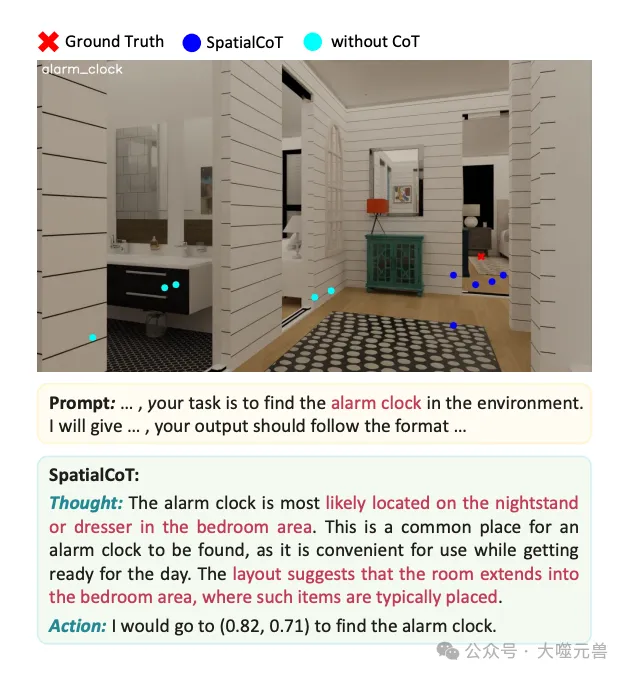

图7:思维链空间基础案例研究。

链式思维对空间推理能力的贡献也在实验中得到验证。通过链式思维过程,模型能够更好地利用空间和上下文信息,如房间布局和常识知识,以得出正确答案。例如,在寻找闹钟的任务中,SpatialCoT首先考虑闹钟的典型位置,然后根据布局推断卧室位置,最终生成准确结果。而基线模型在没有链式思维的情况下,生成的结果则较为无序。

方法的局限性

虽然SpatialCoT在许多方面展示了其强大的空间推理能力,但仍有一些局限性需要注意。

处理复杂动作(如旋转)的局限

首先,SpatialCoT的方法主要基于坐标的动作生成,这使得其在处理某些复杂动作时显得力不从心,特别是涉及物体旋转的任务。具体来说,当前的方法未能有效处理需要精确控制物体旋转角度的任务,这在实际应用中可能导致一些局限。例如,在需要机器人旋转物体以便更好地定位或操作时,SpatialCoT的模型可能无法生成足够精确的动作指令。这一局限性限制了模型在某些复杂场景中的应用,因此未来的研究需要进一步探索和解决这一问题。

对3D输入的依赖和未来研究方向

另一个需要注意的局限性是SpatialCoT目前依赖于2D图像作为视觉输入。虽然2D图像在许多场景中已经能够提供足够的信息,但在更大、更复杂的空间中,3D输入的需求变得尤为重要。3D输入可以提供更丰富的空间信息,使模型能够更准确地理解和导航复杂环境。然而,引入3D输入也带来了新的挑战,包括更高的数据处理复杂度和计算资源需求。因此,未来的研究应当探索如何有效地利用3D输入来提升模型的空间推理能力。

结论

SpatialCoT方法的创新点在于它结合了空间坐标双向对齐和链式思维空间定位两大核心技术,以增强视觉语言模型的空间推理能力。这种方法通过明确对齐视觉-语言输入与空间坐标,使模型能够更精准地理解和生成基于坐标的响应。同时,通过引入链式思维,使模型能够利用语言推理能力进行高级空间推理,从而更好地解决复杂的具身任务。

研究结果表明,SpatialCoT在导航和操作等复杂具身任务中的表现显著优于现有的最先进方法。在导航任务中,SpatialCoT在距离增益和成功率两个关键指标上均取得了优异的成绩,展示了其在生成高质量动作方面的能力。在操作任务中,SpatialCoT在碰撞率和成功率上均表现出色,进一步证明了其在复杂场景中执行精细操作的能力。

尽管SpatialCoT已经展示了其强大的空间推理能力,但仍存在一些需要进一步研究的领域。未来的研究可以探索如何更好地处理复杂动作(如物体旋转),以增强模型在实际应用中的适用性。此外,虽然当前的方法主要依赖于2D图像作为视觉输入,但随着技术的发展,探索3D输入的潜力也将成为未来研究的一个重要方向。3D输入可以提供更丰富的空间信息,使模型能够更准确地理解和操作复杂环境,但同时也带来了更高的数据处理复杂度和计算资源需求。(END)

参考资料:https://arxiv.org/abs/2501.10074

本文转载自大噬元兽,作者: FlerkenS