Kimi深夜炸场:满血版多模态o1级推理模型!OpenAI外全球首次!Jim Fan:同天两款国产o1绝对不是巧合! 原创

编辑 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

昨晚十点,Kimi弹了条推送。

大晚上的,他们就这么波澜不惊地发了一个SOTA 模型出来!

就是这个k1.5 多模态思考模型,性能实现有多逆天呢:

在 short-CoT 模式下, Kimi k1.5 的多项能力,大幅超越了全球范围内短思考 SOTA 模型 GPT-4o 和 Claude 3.5 Sonnet 的水平,领先达到 550%;在 long-CoT 模式下,Kimi k1.5 的数学、代码、多模态推理能力,也达到长思考 SOTA 模型 OpenAI o1 满血版的水平!

而且,这是Kimi首次发布训练报告《Kimi k1.5:借助大语言模型实现强化学习的 Scaling》,足足25页。

图片

图片

k 1.5针对强化训练做了不少工作,尤其是让k 1.5实现逆天短推理能力的Long2short技术,让很多技术者眼前一亮。这个报告真的可以说有“压箱底”的干货,高效思维链也是被很多人认为马上要引领新风潮了。

(github 链接:https://github.com/MoonshotAI/Kimi-k1.5)。

Kimi作为专注产品侧的闭源模型,能主动去做很多技术分享,真的很可贵。(点的就是越来越封闭的CloseAI)

再叠加上开源顶流DeepSeek家也推出了推理模型——DeepSeek-R1,这下硅谷AI圈又得死磕着研究咱们的技术报告了。

图片

图片

说回k 1.5,Kimi这次也是按惯例,一发测试报告就在C端产品上陆续上线,选这个模型切换就能使用k 1.5模型。

图片

图片

比较遗憾的是,目前被灰度到的小伙伴还很少,小编也没能找到网友们的实测例子。

只能说怀着期待再等一等!

图片

图片

1.k1.5到底有多强

作为SOTA 模型,Kimi k1.5 性能上相当能打。

图片

图片

首先是短链思维链,也是k 1.5最大的看点。

短链思维链的核心,就是简单高效,让模型生成一个概括性的中间推理步骤来帮助回答问题。

k1.5 的数学、代码、视觉多模态和通用能力,大幅超越了全球范围内短思考 SOTA 模型 GPT-4o 和 Claude 3.5 Sonnet 的水平,领先达到 550%,直接看图:

图片

图片

除了视觉能力(Vision)上弱一点,其他真的是很超前。

k 1.5的长板够长,其他做得也不弱。在长链思维链模式下,Kimi k1.5 的数学、代码、多模态推理能力,依然比肩了长思考 SOTA 模型 OpenAI o1 正式版的水平。

长链思维链专注的是复杂问题,数学证明、复杂因果关系、推理等等……这些任务需要模型多想几步,生成更丰富的逻辑推理链条。

看报告真的和OpenAI打得有来有回的。

图片

图片

而更有含金量的是:

这应该是全球范围内,OpenAI 之外的公司首次实现 o1 正式版的多模态推理性能。

月之暗面 Kimi

二、SOTA之路:Kimi模型是如何训练出来的

我感觉,Kimi在强化学习方面找到手感了!真的能说一句越战越勇。

去年 11 月他们发了 k0-math 数学模型,紧接着下个月又发了 k1 视觉思考模型。

再看年前他们发的k1.5 多模态思考模型,总觉得Kimi下了一盘很大的棋。

我们先说说,Kimi官方给出的k 1.5的几个关键词,然后再详细聊聊这次最大的创新技术Long2short。

1.1.5的关键词

k 1.5的三个关键词:长上下文扩展、改进的策略优化、多模态能力。

图片

图片

- 长上下文扩展。Kimi 将 RL 的上下文窗口扩展到 128k,并观察到随着上下文长度的增加,性能持续提升。这背后的一个关键思想是,使用部分展开(partial rollouts)来提高训练效率——即通过重用大量先前的轨迹来采样新的轨迹,避免了从头开始重新生成新轨迹的成本。我们的观察表明,上下文长度是通过 LLMs 持续扩展RL的一个关键维度。

这项突破也意味着强化学习,使得大模型向更复杂和长时记忆任务又迈进了一步。

- 改进的策略优化。Kimi推导出了long-CoT的 RL 公式,并采用在线镜像下降的变体进行稳健的策略优化。该算法通过我们的有效采样策略、长度惩罚和数据配方的优化进一步得到改进。

- 多模态能力。我们的模型在文本和视觉数据上联合训练,具有联合推理两种模态的能力。该模型数学能力出众,但由于主要支持LaTeX等格式的文本输入,依赖图形理解能力的部分几何图形题则难以应对。

2.long2short方法

k 1.5找到的long2short方法,绝对值得技术者学习。

这证明:Long-CoT模型的推理先验知识可以顺利转移到 Short-CoT 模型中。

这样Short-CoT 模型不仅效果飞升,还不会像Long-CoT那样燃烧如此多的token。

Kimi这个创新真的可以:利用 Long-CoT 技术来改进 Short-CoT 模型后,在短链思维推理方面取得了SOTA成绩——例如,在AIME上达到60.8分,MATH500上达到94.6分,LiveCodeBench上达到47.3分——大幅超越了现有的短链思维模型,如GPT-4和Claude Sonnet 3.5(提升幅度高达550%)。

图片

图片

报告中还进一步披露了Long-CoT改进Short-CoT的实现方法。

引用《ChatGPT原理与实战》作者对报告的分析,Kimi团队尝试了模型合并、最短拒绝采样、DPO、long2short强化学习多个方法。

这才炼成了如此优秀的SOTA。

图片

图片

三、同天之内两家国产o1绝不是巧合

前脚,DeepSeek-R1 刚发,作为高性能的 AI 推理模型,对标的也是 OpenAI 的 o1 的正式版。

作为开源模型,R1已经开源,模型权重可在 Hugging Face 上获取。加上之前V3的惊艳,声量非常大。

开源地址:https://huggingface.co/deepseek-ai/DeepSeek-R1

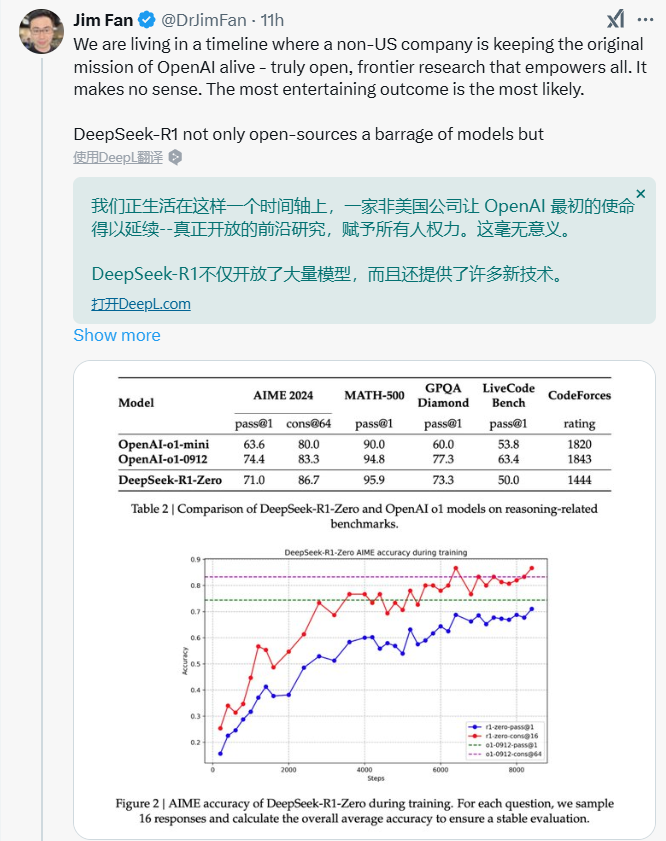

英伟达大佬Jim Fan感叹说,R1不止是开放了模型,技术的共享也非常重要。

图片

图片

就这么你追我赶着,k 1.5也横空出世了。

看来,如Jim Fan此前预言的,2025强化学习要王者归来了。

图片

图片

最后,Jim Fan还总结了一波两个模型的不同之处,让我们一起看看:

- DeepSeek 采用 AlphaZero 方法--纯粹通过 RL 引导,无需人工输入,即 "冷启动"。

- DeepSeek的权重是MIT许可的(思想领导力!);Kimi还没有发布模型。

- Kimi在MathVista等基准测试中显示出强大的多模态性能(!),这些基准测试要求对几何、智商测试等有直观的理解。

- Kimi 的论文中有大量关于系统设计的细节:RL 基础设施、混合集群、代码沙箱、并行策略;以及学习细节:长上下文、CoT 压缩、课程、抽样策略、测试用例生成等!

发布k 1.5之后,Kimi发布了K系列的未来计划。从k0-math 数学模型,到k1 视觉思考模型,再到k 1.5的多模态推理,感觉Kimi真的是在一路升级打怪。

期待2025年,更多的模型厂跟我们一些惊艳的新东西。

图片

图片

本文转载自51CTO技术栈,作者:伊风