开源版o1!中国大模型让国外陷入疯狂,成本猛降90% 精华

前不久,国产大模型平台DeepSeek开源的v3模型,受到了Andrej Karpathy等业内大神的盛赞,在算法、数据等方面非常棒。

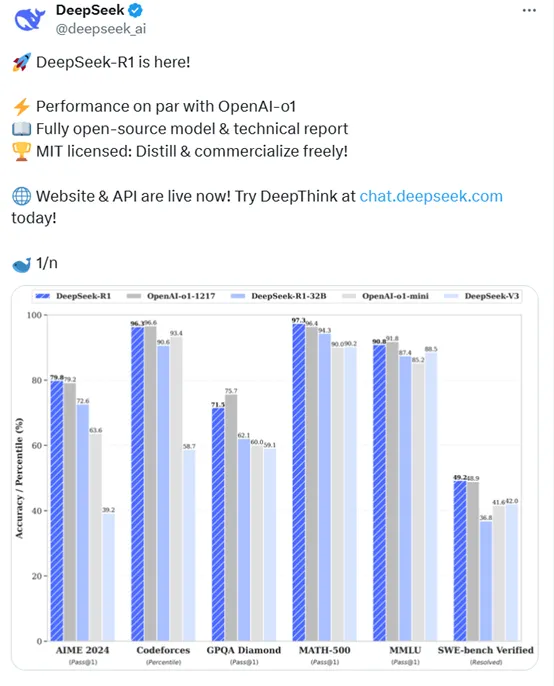

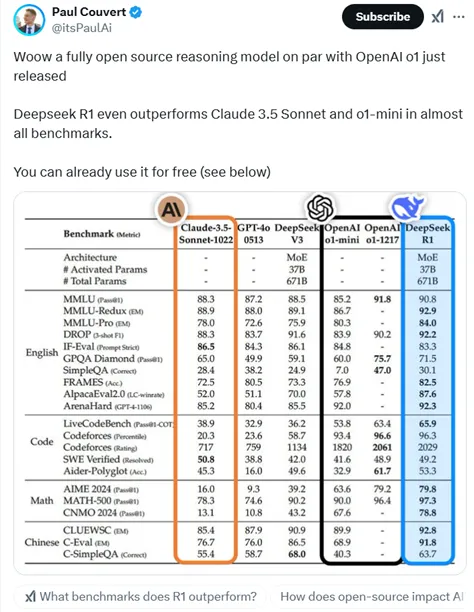

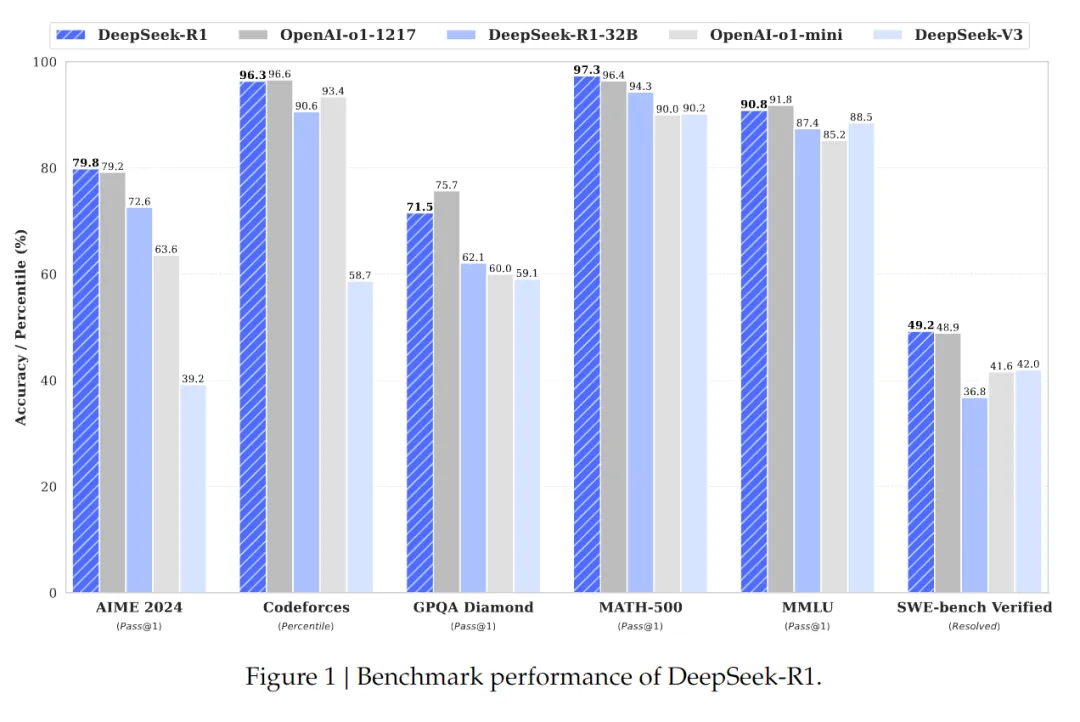

现在,DeepSeek又重磅开源了R1模型。根据其公布测试数据显示,在美国AIME 2024测试中R1拿下79.8分,超过了OpenAI的o1模型的79.2分;在MATH-500,R1为97.3分,同样超过了o1的96.4分;

在SWE-bench Verified,R1为49.2分再次超过了o1的48.9分。而在代码测试Codeforces中,R1仅比o1模型低0.3分;MMLU低1分;GPQA低4.2分,整体性能与o1模型相当。

但价格方面o1模型每100万tokens的输入是15美元,R1是0.14美元,比GPT-4o-mini价格还要低(这个是目前OpenAI最便宜的主打模型之一)成本猛降90%。

输出价格更是低的离谱,o1每100万tokens输出是60美元,R1只有2.19美元,降低了27倍左右。

开源地址:https://huggingface.co/deepseek-ai/R1

API:https://api-docs.deepseek.com/guides/reasoning_model

在DeepSeek宣布开源R1后,国外网友彻底疯狂了,R1如此强的性能却这么便宜,对中国开源大模型飞速发展感到不可思议,已经超过了Meta、Mistral等老牌开源平台。

绝对疯狂。与o1模型性能相当且开源。还可以用来蒸馏创建你自己的模型。

讲真,有了这个超强模型之后,OpenAI每月的200美元订阅就没啥优势了。

伙计们干的不错,这真的很令人印象深刻,价格也很便宜。

恭喜,各方面都很出色,尤其是价格。

感谢你们把这一切开源!作为一个新学习者,这激励我在这个领域探索更多。DeepSeek模型都非常令人印象深刻。祝贺你们!

开源界的英雄!

这个看起来很棒。你们为开源项目做出了杰出的工作。

开源、遵循 MIT 许可协议,且可与 OpenAI 相媲美?这正是我们喜闻乐见的创新。

我正在用它来编写代码,最佳大模型之一,持续改进 :)

R1就是o1,但是免费的。感谢deepseek团队的研究人员。

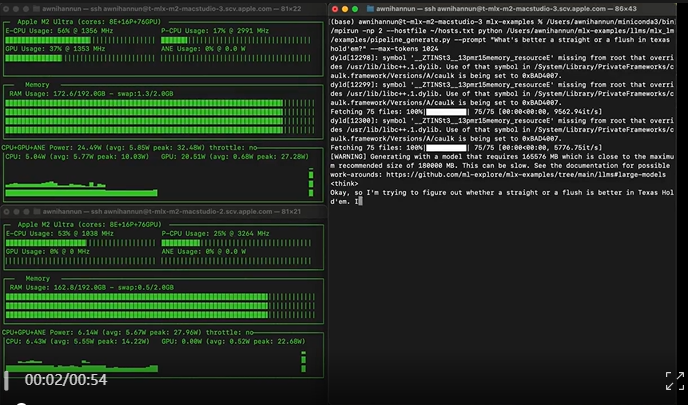

苹果的机器学习研究员Awni Hannun已经测试了R1模型,仅在苹果M2 Ultra上就能运行,推理效率还相当的快。

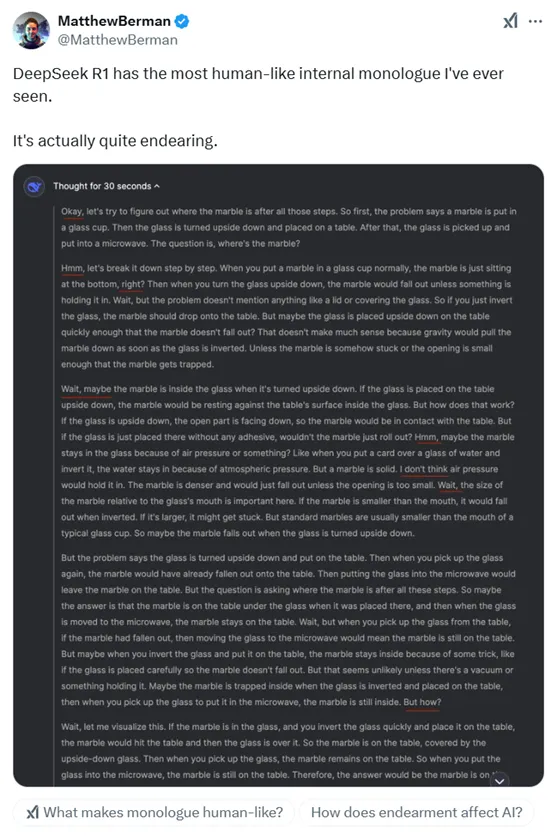

也有人体验了DeepSeek R1后表示,这是最像人类内心独白的模型,实际上相当不错。

FileDash.ai创始人Paul Couvert也转发了R1开源的消息,并认为比Claude 3.5 Sonnet 和 o1-mini 表现更出色,性能与o1几乎差不多。

也有网友用R1,简单、直观的来解释勾股定理。不到30秒,一次就完美解决,相当满意。

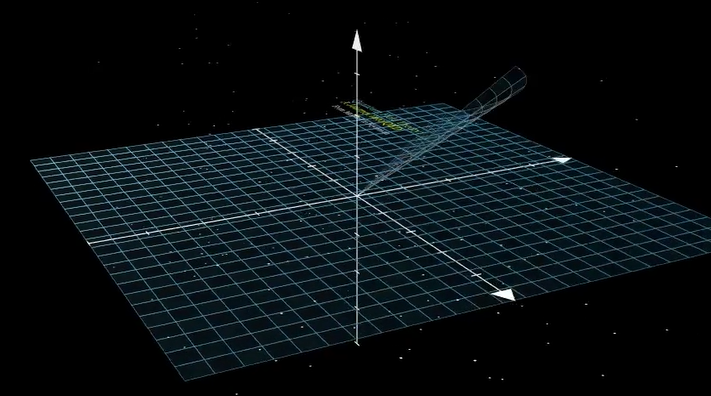

接着这位老哥又给R1加大了强度,要求其解释量子电动力学的工作原理,以及如何将其可视化呈现。

只用了9分钟,依然完美解决了这个问题。

最后这位老哥彻底服气了,感慨道,我看不到任何错误。它一次就修正了旋转。思考大约用了3分钟,渲染花了45分钟。所以,中国开源的大模型,可以胜过我见过的任何博士。

R1简单介绍

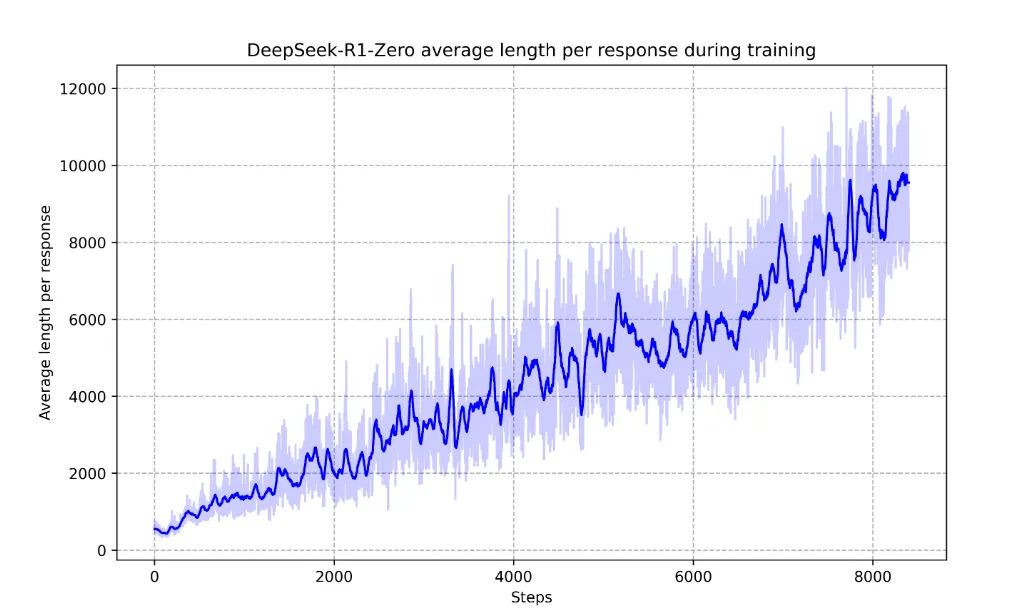

其实DeepSeek最开始开发的是R1-Zero模型,通过纯强化学习训练,不依赖于任何监督学习数据。该模型以DeepSeek-V3-Base为基础,采用了GRPO算法进行训练,通过采样一组输出并计算其相对优势,从而优化模型的策略,避免了传统强化学习中需要与策略模型同规模的评估模型,大大降低了训练成本。

在训练过程中,R1-Zero展现出了一系列强大的推理行为,例如,自我验证、反思和生成长推理链等。这些行为并非人为植入,而是模型在强化学习过程中自然涌现的结果。

例如,在AIME 2024数学竞赛中,R1-Zero的Pass@1得分从初始的15.6%提升至71.0%,通过多数投票进一步提升至86.7%,与OpenAI-o1-0912模型相当。这一结果证明了纯强化学习在提升模型推理能力方面的巨大潜力。

但是R1-Zero也存在一些问题,如可读性差和语言混用等。所以,DeepSeek又开发出了R1模型。

R1在R1-Zero的基础上进行了改进,引入了冷启动数据和多阶段训练流程,以提升模型的推理能力和可读性。

冷启动与多阶段训练

冷启动阶段是R1训练流程的起点,也是整个训练策略中最重要的一环。与R1-Zero直接从基础模型开始强化学习不同,R1引入了少量高质量的长CoT数据作为冷启动数据,为模型提供一个更加稳定和优化的起点,从而在后续的强化学习过程中更好地发展推理能力。

冷启动数据的一个关键特点是其对可读性的优化。与R1-Zero生成的推理过程相比,冷启动数据更加注重语言的清晰性和逻辑性。例如,团队设计了一种特定的输出格式,即在每个回答的末尾添加一个总结,并用特殊标记将推理过程和总结区分开来。

这种格式不仅使模型的输出更加易于理解,也为后续的强化学习提供了一个明确的结构框架。

在冷启动阶段之后, R1进入了一个包含多个阶段的复杂训练流程。这一流程的设计目标是通过逐步优化和调整,使模型在推理能力上达到更高的水平,同时在其他任务上也表现出色。

第一阶段:推理导向的强化学习

在冷启动数据的基础上,R1进入了一个以推理为导向的强化学习阶段。这一阶段的核心目标是通过大规模的强化学习,进一步提升模型在数学、编程、科学和逻辑推理等任务上的表现。这一阶段的训练与R1-Zero的强化学习过程类似,但有一个重要的区别:R1在训练过程中引入了语言一致性奖励。

语言一致性奖励的引入是为了解决模型在生成推理链时可能出现的语言混用问题。在多语言的推理任务中,模型可能会在推理过程中混用不同语言,这不仅影响了输出的可读性,还可能干扰模型的推理逻辑。

为了克服这一问题,研究团队设计了一个奖励机制,通过计算推理链中目标语言的比例来优化模型的输出。虽然这种奖励机制在一定程度上略微降低了模型的推理性能,但它显著提升了输出的可读性和一致性。

第二阶段:拒绝采样与监督微调

当推理导向的强化学习接近收敛时,R1进入了一个关键的阶段:拒绝采样与监督微调。这一阶段的目标是通过生成新的监督学习数据,进一步优化模型在推理和其他任务上的表现。

拒绝采样是一种从模型生成的数据中筛选出高质量样本的方法。在这一阶段,研究团队利用当前模型的检查点,通过拒绝采样生成了大量的推理相关数据。这些数据不仅包括了推理任务的样本,还涵盖了写作、事实问答、自我认知等其他领域的数据。通过这种方式,模型不仅在推理任务上得到了优化,还在其他任务上展现了更强的能力。

第三阶段:全场景强化学习

在经过拒绝采样和监督微调之后,R1进入了一个更为复杂的阶段:全场景强化学习。这一阶段的目标是通过结合推理任务的规则奖励和一般任务的偏好奖励,进一步优化模型的性能。

在这一阶段,模型不仅需要在推理任务上表现出色,还需要在其他任务上展现出更高的有用性和安全性。研究团队通过引入多样化的奖励信号和任务分布,确保模型在推理能力、有用性和安全性之间达到平衡。

例如,在推理任务中,模型继续使用规则奖励来优化其推理链的准确性和效率。而在一般任务中,模型则依赖于偏好奖励来优化其输出的有用性和安全性。通过这种方式,R1能够在多个任务上展现出卓越的性能,同时保持推理能力的核心优势。

有兴趣的小伙伴可以试试这个R1模型,在国外已经爆火成为开源大模型界的顶流了。

本文转自 AIGC开放社区 ,作者:AIGC开放社区