LLM合集:MiniMax-01 开源,性能比肩 GPT-4o,上下文窗口领先 20-32 倍

1.MiniMax-01: Scaling Foundation Models with Lightning Attention

我们推出了 MiniMax-01 系列,包括 MiniMax-Text-01 和 MiniMax-VL-01。这两款产品不仅性能可与顶尖模型相媲美,而且在处理更长文本上下文方面具备卓越能力。其核心技术是Lightning Attention及其高效的扩展方法。为充分发挥计算能力,我们将其与混合专家(MoE)技术相结合,打造出拥有 32 个专家模块、共计 4560 亿参数的模型,每个Token激活 459 亿参数。针对 MoE 和闪电注意力机制,我们开发了优化的并行策略以及高效的计算 - 通信重叠技术。通过这种方式,我们能够在包含数百亿参数的模型上,对数百万Token长度的上下文进行高效的训练与推理。MiniMax-Text-01 在训练时上下文窗口可达 100 万个Token,推理时以较低成本外推至 400 万个Token。我们的视觉 - 语言模型 MiniMax-VL-01 则通过使用 5120 亿视觉 - 语言Token持续训练构建而成。在标准和内部基准测试中,我们的模型性能与 GPT-4o、Claude-3.5-Sonnet 等最先进模型相当,但上下文窗口长度却是它们的 20 - 32 倍。我们已在https://github.com/MiniMax-AI上公开发布 MiniMax-01 。

论文: https://arxiv.org/pdf/2501.08313

2. Diffusion Adversarial Post-Training for One-Step Video Generation

扩散模型在图像和视频生成领域应用广泛,但其迭代生成过程缓慢且成本高昂。尽管现有的蒸馏方法已在图像领域展现出一步生成的潜力,但生成质量仍显著下降。在本文中,我们提出在扩散预训练之后,针对真实数据采用对抗后训练(APT)方法,实现一步视频生成。

为提升训练稳定性和生成质量,我们对模型架构和训练流程进行了多项改进,并引入了近似的 R1 正则化目标。实验表明,经对抗后训练的模型 Seaweed - APT,能够在单步前向评估中实时生成 2 秒时长、分辨率为 1280×720、帧率 24fps 的视频。此外,该模型还能一步生成 1024 像素的图像,生成质量与当前最先进的方法相当。

论文: https://arxiv.org/pdf/2501.08316

3.MangaNinja: Line Art Colorization with Precise Reference Following

MangaNinjia 源于扩散模型,专门用于参考引导的线稿上色任务。为确保精准转录角色细节,我们融入了两项精心设计:一是补丁混洗模块,助力参考彩色图像与目标线稿之间的对应关系学习;二是点驱动控制方案,实现精细的色彩匹配。在自行收集的基准数据集上进行的实验表明,我们的模型在精准上色方面优于当前的其他解决方案。我们还展示了所提出的交互式点控制在处理复杂情况、跨角色上色、多参考图像协调等方面的潜力,这些都是现有算法难以企及的。

论文: https://arxiv.org/pdf/2501.08332

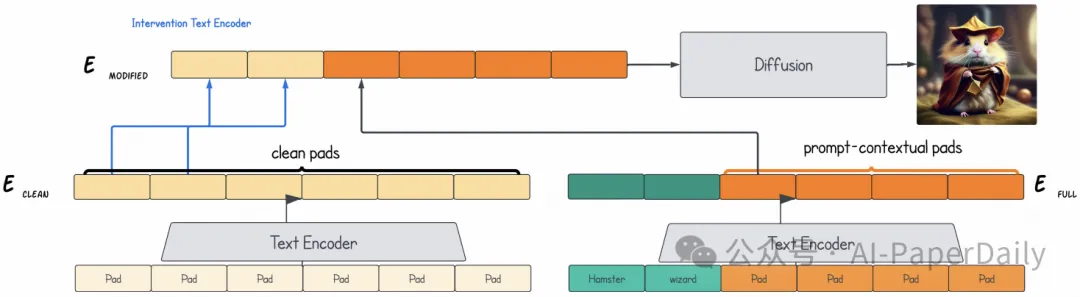

4.Padding Tone: A Mechanistic Analysis of Padding Tokens in T2I Models

文本转图像(T2I)扩散模型依靠编码后的提示词来引导图像生成过程。通常,在对文本进行编码之前,这些提示词会通过添加填充标记扩展到固定长度。尽管这是一种默认做法,但填充标记对图像生成过程的影响却从未有人研究过。在这项研究中,我们首次深入分析了填充标记在 T2I 模型中所起的作用。

我们开发了两种因果分析技术,用于剖析在 T2I 流程的不同组件中,信息是如何编码到标记表示中的。借助这些技术,我们探究了填充标记何时以及如何影响图像生成过程。我们的研究结果揭示了三种不同的情况:填充标记可能在文本编码阶段、扩散过程中影响模型输出,或者被模型有效忽略。此外,我们还明确了这些情况与模型架构(交叉注意力或自注意力)及其训练过程(文本编码器冻结或训练)之间的关键联系。 这些见解有助于我们更深入地理解填充标记的作用机制,有望为未来 T2I 系统的模型设计和训练方法提供参考。

论文: https://arxiv.org/pdf/2501.06751

本文转载自AI-PaperDaily,作者: AI-PaperDaily