3D头像资产生产又出SOTA! 加州默塞德&Adobe发布FaceLift:身份保持极佳!

文章链接:https://arxiv.org/pdf/2412.17812

项目链接:https://www.wlyu.me/FaceLift/

亮点直击

- 本文提出了FaceLift,这是一种两阶段框架,通过视图生成和大规模重建模型从单张图像重建高保真3D头像。

- 结合了用于视图一致性训练的合成头部数据和大型图像生成基础模型的丰富先验,从而实现了强大的泛化能力。

- 通过全面的定量和定性评估,证明了本文的方法在重建精度和身份保持方面达到了SOTA。

总结速览

解决的问题

当前的3D头像重建方法存在以下挑战:

- 细节缺失:传统的基于参数化网格的模型难以生成高细节和高真实感的面部几何和纹理。

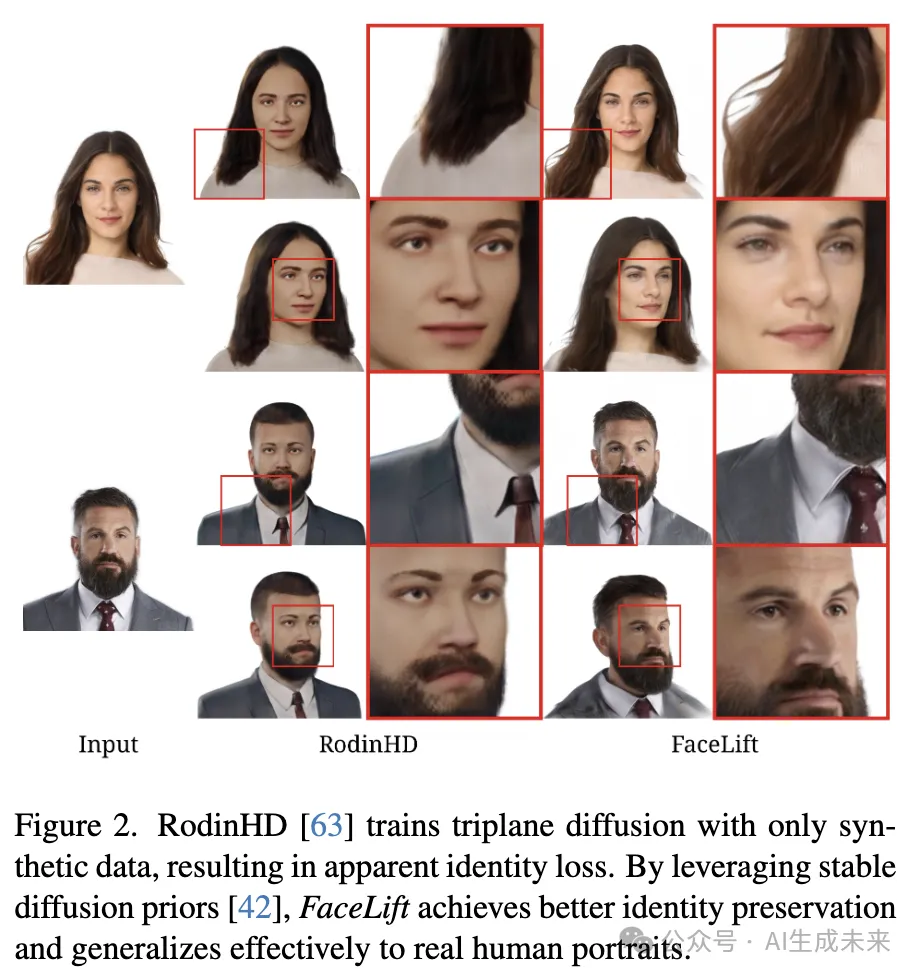

- 身份保持差:仅用合成数据训练的模型在生成结果中会导致显著的身份感知损失。

- 视角一致性不足:现有方法难以保证不同视角生成的图像在几何和纹理上的一致性。

提出的方案

FaceLift采用两阶段管线实现高质量的3D头像重建:

- 第一阶段:多视角生成

基于扩散模型的多视角生成方法。

通过图像条件扩散模型生成头部的侧面和背面视图。

利用多视角一致的合成数据进行模型微调,增强视角一致性和泛化能力。

- 第二阶段:3D重建

- 使用最先进的GS-LRM模型,将生成的稀疏多视角图像融合为完整的3D高斯表示。

- 在Objaverse数据集上初步训练,并对合成头像数据进行微调以提高重建精度。

应用的技术

- 扩散模型:以扩散模型为核心,通过大规模基础模型微调实现多视角生成。

- GS-LRM:利用大规模重建模型,将稀疏视图转换为高细节的3D高斯表示。

- 训练数据:

- 构建了合成多视角头像数据集。

- 利用Objaverse和合成头像数据对模型进行分阶段训练。

达到的效果

- 高细节和真实感:生成结果在几何和纹理上表现出精细的细节。

- 身份保持:有效保留输入面部的身份特征。

- 视角一致性:多视角生成和重建结果高度一致。

- 广泛适用性:尽管仅用合成数据训练,FaceLift在真实人脸图像上表现出显著的泛化能力。

- 扩展功能:支持视频输入实现4D新视角合成,并能与2D再动画技术结合,生成3D面部动画。

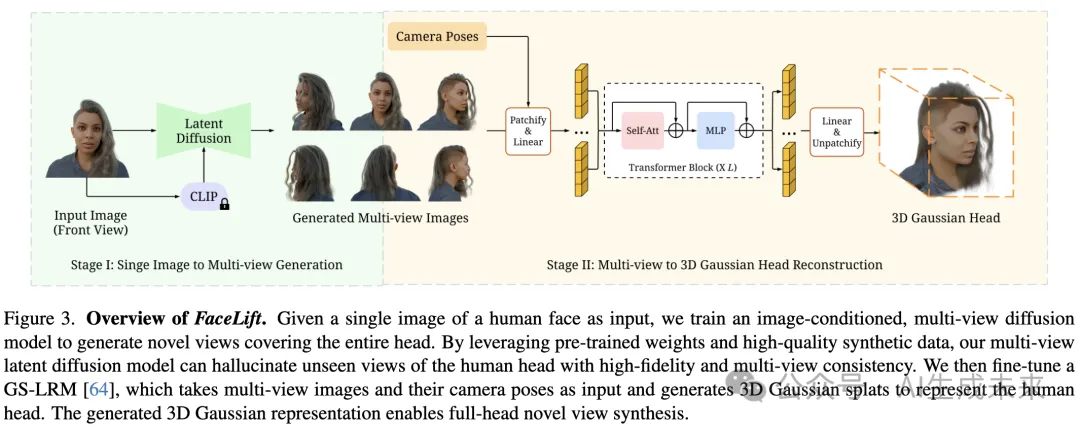

提出的方法

给定一张人脸的正面图片,本文的目标是以3D高斯点云的形式重建完整的3D头像模型。生成输入视角不可见的合理细节(例如头部后侧),同时确保从任意角度都具有一致的视觉效果。本文提出的FaceLift方法遵循两阶段pipeline,如下图3所示。在第一阶段,利用合成头像多视角图像,我们训练了一个基于图像条件的扩散模型,生成六个视角的头像图像,同时保持多视角一致性并保留身份特征。在第二阶段,这些生成的视图及其相应的相机位姿被输入到一个经过微调的GS-LRM模型中,以重建一组3D高斯点云。

合成头像数据集

本文实现了一个基于[59]启发的3D头像资产生成pipeline。该过程始于一组由艺术家创作的高质量3D头像网格模型,通过加入详细的面部组件(如眼睛、牙齿、牙龈、面部和头皮头发)对其进行增强。通过绑定实现姿态变化,并通过混合变形实现多样化的面部表情来增强这些基础模型。这些最终的头像模型通过一组PBR纹理贴图(包括反照率、法线、粗糙度、高光和次表面散射贴图)进一步丰富。最后为头像模型搭配了一组服装资产。整个pipeline在Blender中实现,图像使用Cycles渲染器进行渲染。

为了训练,本文以512×512分辨率渲染了200个唯一身份,每个身份具有50种不同外观(包括发型、肤色、表情、服装、姿态等)。训练数据集在两种光照条件下渲染:(1) 环境光;(2) 随机HDR环境光。每个主体渲染六个视图以训练多视角扩散模型。为了微调GS-LRM,使用随机相机位姿渲染了32个视图。

阶段一:从单张图像到多视角生成

近期的3D生成和重建框架通过利用扩散模型生成多视角一致的图像,展示了令人鼓舞的成果。基于这一方法,本文采用了开源的Stable Diffusion文本到图像生成器作为视图生成网络的基础。使用了Stable Diffusion V2-1-unCLIP模型,该模型通过在Stable Diffusion V2-1上微调,结合了CLIP图像 embeddings 作为额外的条件输入。在pipeline中,CLIP图像编码器处理输入的正面人脸图像,生成embeddings用作扩散模型的条件信号。

为了确保生成的新视角图像的一致性,采用了类似于[26, 32]的多视角注意力机制,以促进信息传播并隐式编码多视角依赖性。扩散模型通过在注意力层中共享跨视角的信息学习多视角相关性,从而能够从多个视角生成一致的RGB图像。

给定的单张近正面人脸图像,其方位角为 ,多视角扩散模型将生成六个视角图像,其方位角分别为 ,覆盖头像的360度范围。所有输入图像和生成的输出图像均保持零仰角,以确保水平视角的一致性。生成的视角包括重建的正面图像(与输入图像一致)、捕捉头部两侧的左侧和右侧侧面图像,以及基于正面输入和学习先验综合生成的后视图(包括头发结构和颜色)。此外,还生成左前和右前三分视图,以增强后续重建阶段的人脸细节。

第二阶段:从多视角到3D高斯头像重建

第二阶段利用第一阶段生成的六个视角进行稀疏视角重建。本文使用了GS-LRM,这是一种在从有限视角生成详细3D模型方面表现卓越的最先进重建模型。GS-LRM采用3D高斯作为其底层表示方式,对于捕捉头像的复杂细节(如发丝)尤其有效。此外,其前馈架构支持快速重建,使其非常适合实际应用。

GS-LRM使用一种Transformer架构,从一组带有位姿的图像中回归出像素对齐的3D高斯。每个多视角图像与其相应的Plücker射线坐标(由相机的内参和外参计算得出)拼接在一起,用于位姿条件化。图像被划分为不重叠的补丁,每个2D补丁被展平为一个1D向量。然后,一个线性层将这些向量映射为图像补丁token。所有多视角图像的token被拼接后,通过一系列Transformer块进行处理。接着,Transformer的输出token通过一个线性层解码为高斯参数,随后将高斯参数从补丁形式转化为3D高斯。每个2D像素对应一个3D高斯,高斯的参数化包括以下内容:三通道RGB、三通道尺度、四通道旋转四元数、单通道不透明度以及单通道射线距离,类似于[23]。

GS-LRM模型的最终输出是所有输入视角中3D高斯的合并结果。

在GS-LRM训练期间,随机从可用的相机位姿中选择四个视角来重建总计八个视角(四个输入视角加上四个新视角)。根据[64],使用均方误差(MSE)和感知损失的组合来优化模型。在推理阶段,GS-LRM处理我们多视角扩散模型的输出。尽管GS-LRM可以接受任意数量的输入视角,使用扩散模型生成的全部六个视角以实现最佳的视觉质量。

实验

为评估单张图像头像重建方法,利用公开的多视角头像数据集,通过已知的相机参数评估新视角合成性能。我们展示了基于这些数据集的定性比较和定量误差指标。

实验设置

评估数据集

使用两个多视角数据集评估本文的方法:

- Cafca 数据集:

这是一个合成数据集,专注于人脸场景,但与本文的训练数据集有显著差异。本文的训练数据集是独立开发的。用于评估时,选择了40个主体,每个主体包含30个测试相机视角。由于相机位置是随机分布的,手动选择最接近正视图的图像作为输入。 - Ava-256 数据集:

这是一个以真实人类主体为对象的专业拍摄数据集。随机选取了10个主体,每个主体有10个测试相机视角。为了证明系统的泛化能力,还使用收集到的“野外”人脸图像集进行定性评估。

对比方法

将结果与以下三种最新方法进行了比较:

- PanoHead: 基于3D GAN的最新3D全头重建方法。通过GAN反演(GAN-inversion)从单张输入图像中获得重建结果。需要注意的是,该方法只能在特定相机姿态范围内渲染图像,且缺乏真实的3D表示,无法实现新视角合成。

- Era3D: 最近提出的一种通用物体重建方法。它采用多视角扩散模型生成六个视角,并使用 NeuS 的 Instant-NSR-PL 实现进行网格提取。

- LGM: 类似于 GS-LRM,该方法在视角生成阶段后使用高斯点云作为3D表示。

评估指标

使用以下四个标准指标评估重建质量:

- PSNR(峰值信噪比)

- SSIM(结构相似性)

- LPIPS

- DreamSim

为评估身份保持能力,使用 ArcFace 通过 DeepFace 实现进行人脸验证。

实现细节

数据集处理

Cafca 和 Ava-256 数据集提供了多视角的 RGB 图像及其相应的相机位姿。然而,这些数据集的相机系统与 FaceLift 和基线方法所用的相机系统存在差异。因此,为每种方法重新计算测试相机的外参。

为了更精确的比较,使用 Mediapipe 面部关键点检测算法,在目标图像和渲染输出中识别面部关键点,并根据关键点分布进行对齐。需要注意的是,基于面部关键点检测的对齐方法仅适用于捕捉前脸特征的图像。

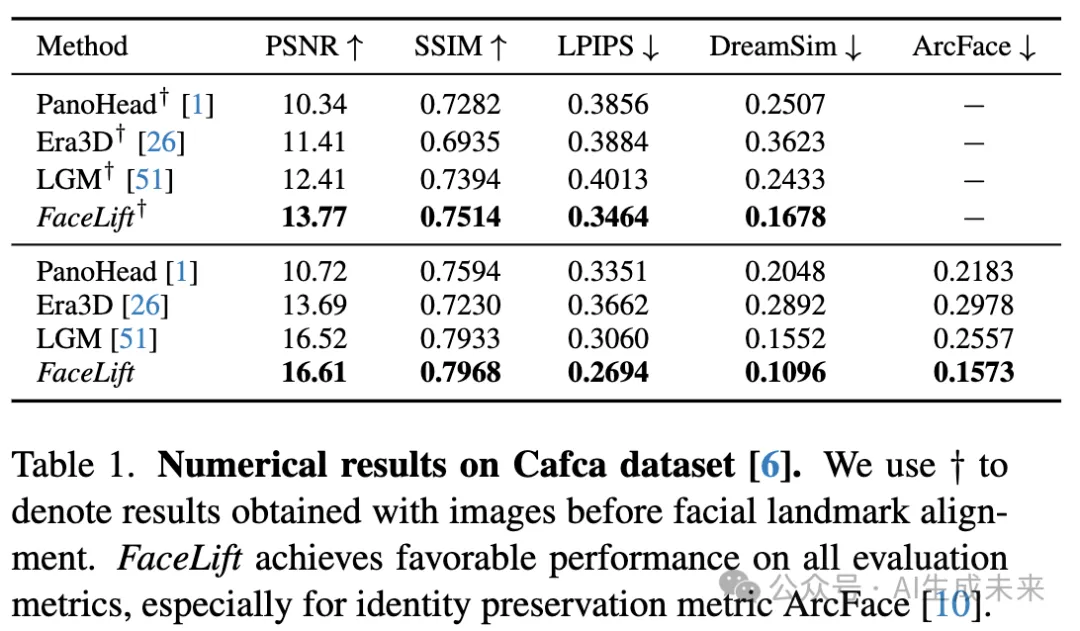

Cafca 数据集的实验结果

定量结果

在下表 1 中报告了面部关键点对齐前后的数值比较结果:

- 在对齐前,Cafca 数据集中的全部 30 个相机视角被用作测试视角,但部分视角未覆盖面部区域。因此,身份保持指标(ArcFace)仅在对齐后的比较中报告。

- 对齐后,每个主体的测试视角数量为 7 至 19 个。

在两种比较中,FaceLift 相较于基线方法表现更优,特别是在 DreamSim 指标上,它更符合人类对相似性的判断。此外,FaceLift 在身份保持方面也表现出色,ArcFace 的面部嵌入距离较低。

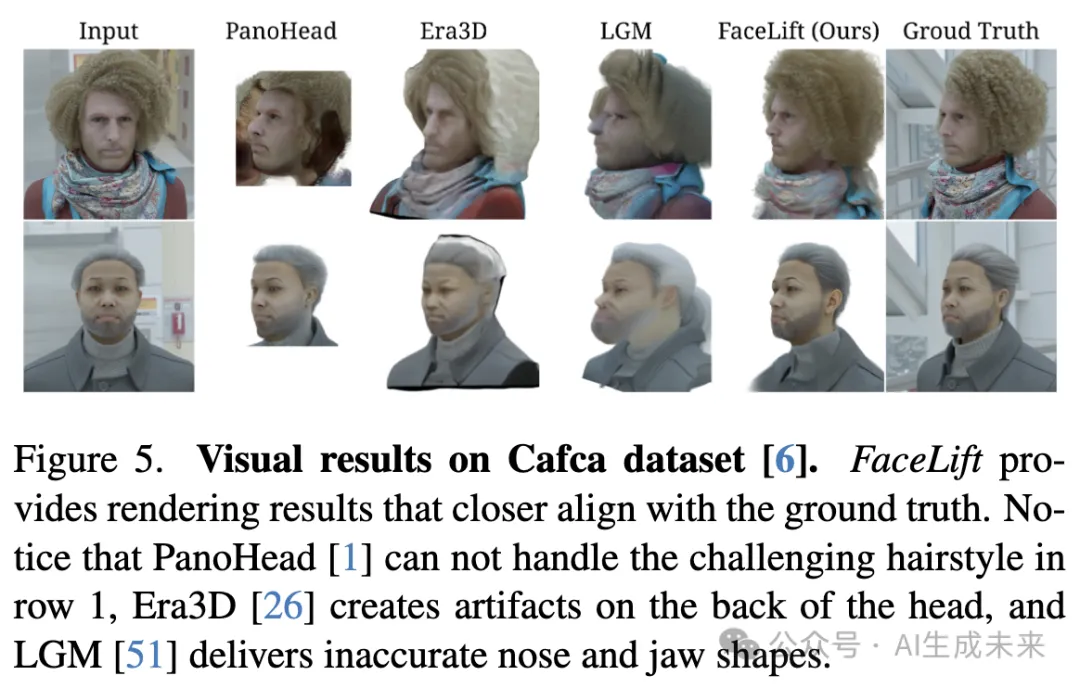

视觉结果

如下图 5 所示,FaceLift 能够渲染出更接近真实的新视角图像,而其他方法在颜色或几何结构的 3D 头部重建上经常失败。

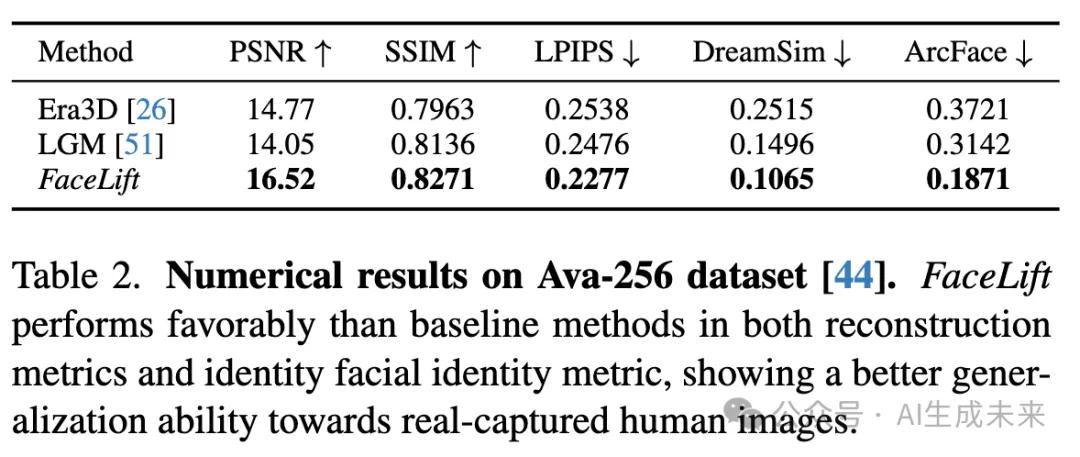

Ava-256 数据集的实验结果

定量结果

在真实人类拍摄的 Ava-256 数据集上进一步评估了 FaceLift 的性能,与其他基线方法进行比较。由于 PanoHead 在该数据集的测试相机视角下无法生成合理结果,排除了该基线。

下表 2 显示,FaceLift 在所有评估指标上均优于其他基线方法,展现了卓越的重建质量和身份保持能力。这也证明了 FaceLift 在真实人脸上的强泛化能力。

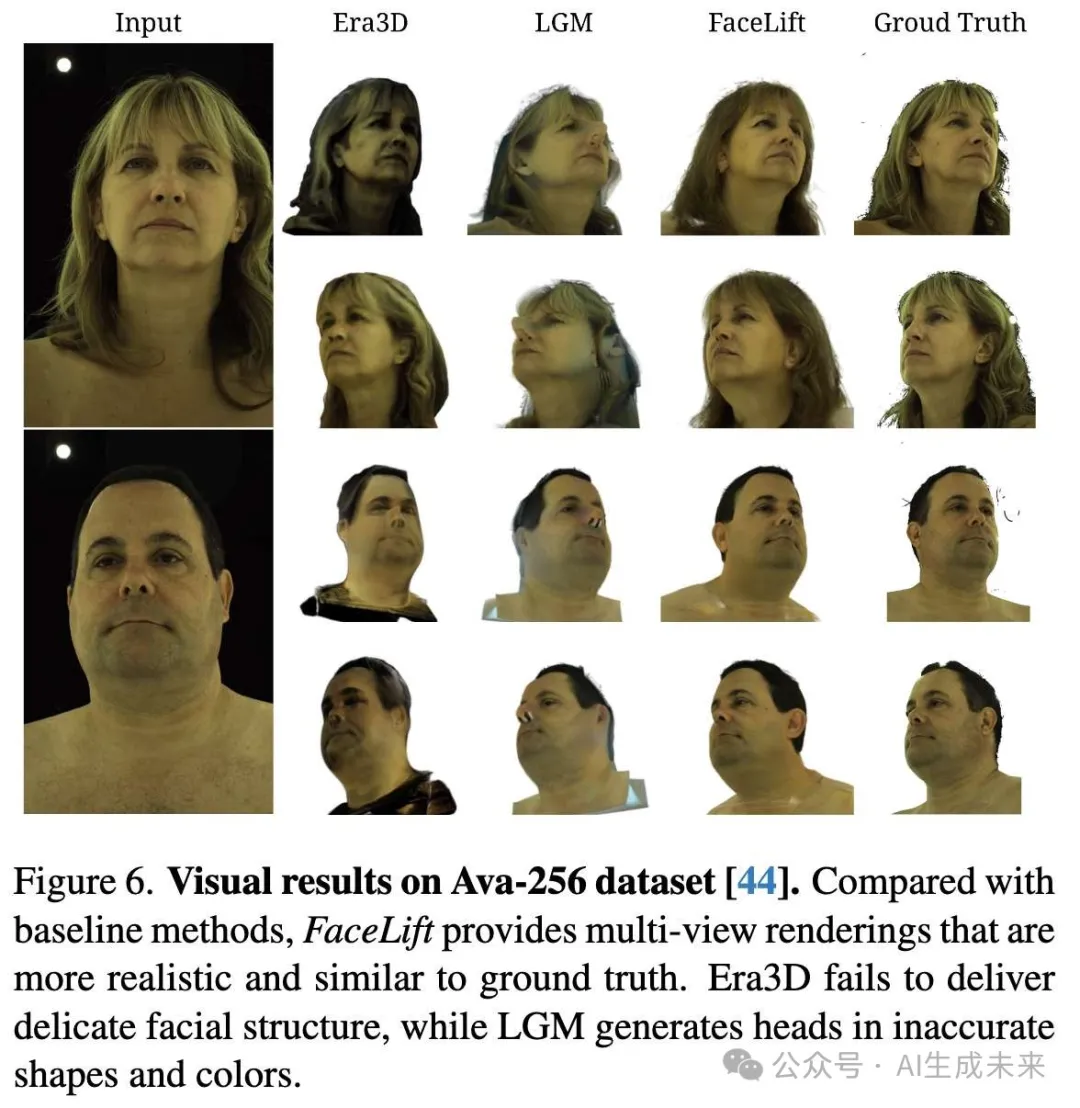

视觉结果

如图 6 所示,FaceLift 能够生成更逼真的头部合成图像,而 Era3D 在皮肤和头发纹理以及面部细节上存在缺陷。此外,LGM 在鼻子形状的重建上表现不准确。

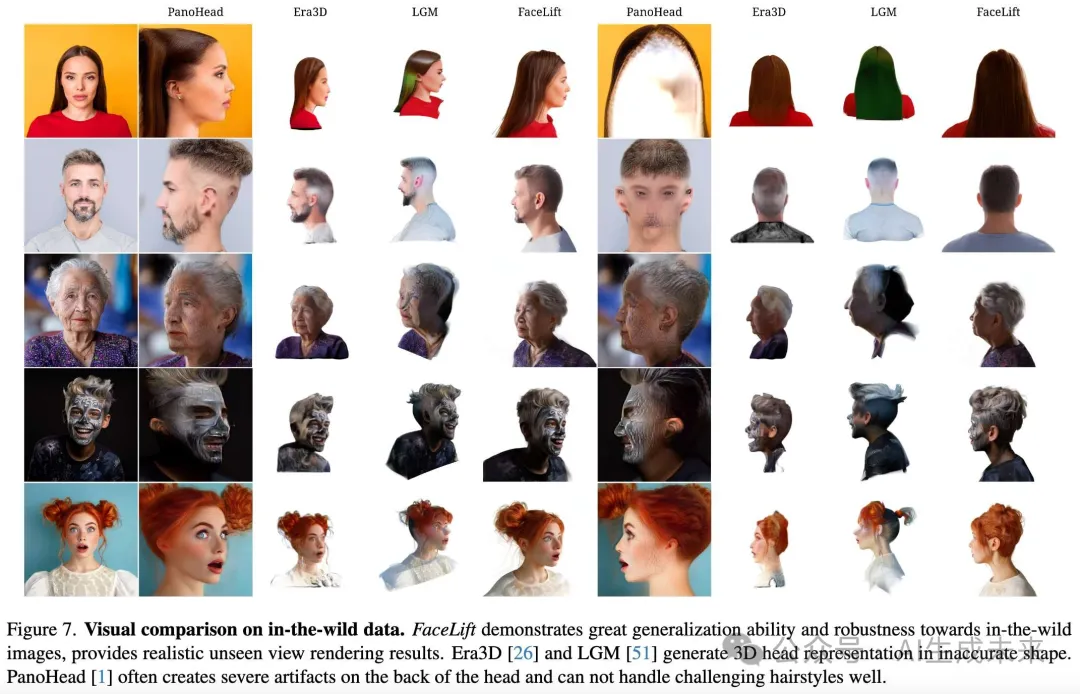

在自然场景图像上的结果

方法泛化能力

为了进一步展示 FaceLift 的泛化能力并强调其在真实应用中的潜力,我们收集了自然场景中的人脸图像,与其他基线方法进行定性比较,结果如下图 7 所示。

- 基线方法问题

- PanoHead经常无法渲染头部后方,有时甚至会在后脑生成额外的眼睛。此外,它在头发、阴影、皱纹以及面部涂料的合成上也表现不佳。PanoHead 的输出缺乏多视角一致性。例如,在最后一行中,尽管相机视角发生了变化,但女孩在新视角 1 中依然面向镜头。

- Era3D在生成头部形状时常有误差,尤其是在左侧和右侧视图中。此外,相较于 FaceLift,它生成的几何细节更少。

- LGM所生成的高斯分布颜色和透明度不准确,缺乏对面部几何的正确理解,导致面部特征扭曲。

- FaceLift 的优势

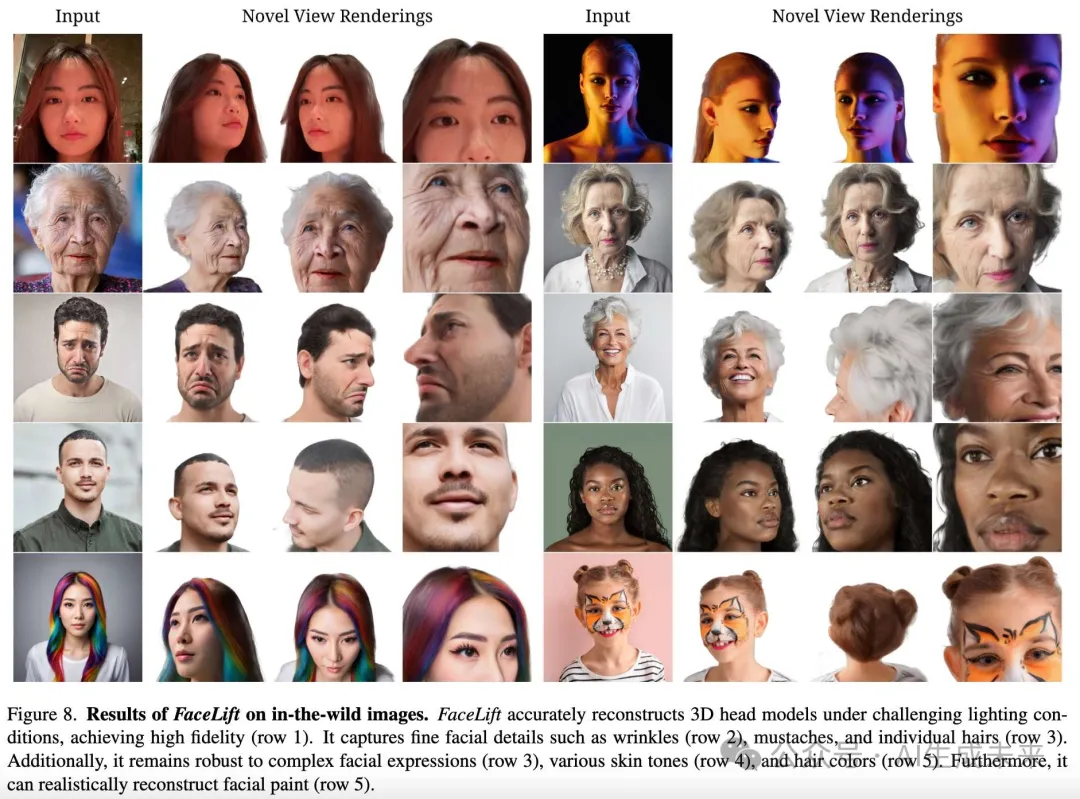

更多渲染结果

下图 8 中展示了 FaceLift 的新视角渲染结果:

- 不同光照条件

FaceLift 能够在各种光照条件下处理人脸。例如,在光线较暗的条件下(第 1 行第 1 列,由 iPhone 拍摄的照片),它仍然能渲染出逼真的新视角图像,突显了其鲁棒性和真实应用潜力。 - 极端表情和细节重建

FaceLift 能够高保真地重建面部细节,尤其是极端表情导致的面部皱纹和褶皱(第 2 行和第 3 行)。 - 复杂纹理的处理

FaceLift 在重建挑战性纹理(如胡须和头发)方面表现优异。此外,即使我们的合成人脸数据集中不包含面部涂料数据,FaceLift 仍能忠实地重建面部涂料,展现了其强大的泛化能力。

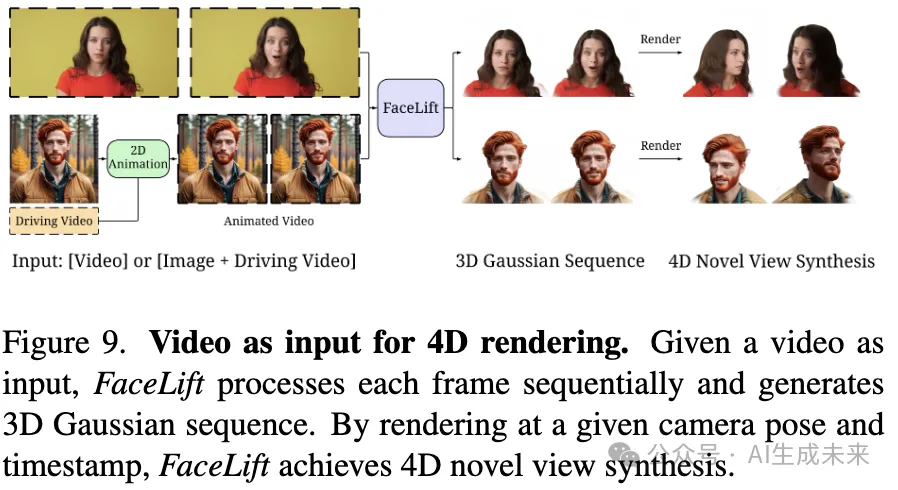

应用:视频作为输入进行4D新视角渲染

如下图 9 所示,得益于 FaceLift 的高保真重建能力,该方法能够从视频输入生成一致的 3D 高斯序列,实现 4D 渲染。具体过程如下:

- 帧序列处理:逐帧处理视频输入,为每一帧生成一个 3D 高斯表示,形成高斯序列。

- 时间戳渲染:在任意时间戳选择对应的 3D 高斯表示,可从任何给定视角进行渲染。

尽管未添加约束以保持不同时间戳间的一致性,FaceLift 仍能以极少伪影渲染新视角下的视频序列。

结合2D人脸动画方法

通过结合诸如 LivePortrait 等 2D 人脸动画方法,FaceLift 实现了 3D 人脸动画。

- 极端表情处理

FaceLift 的鲁棒性和强泛化能力允许其将带有极端表情的人脸提升为 3D 表现,而不会牺牲细节保真度。

消融研究

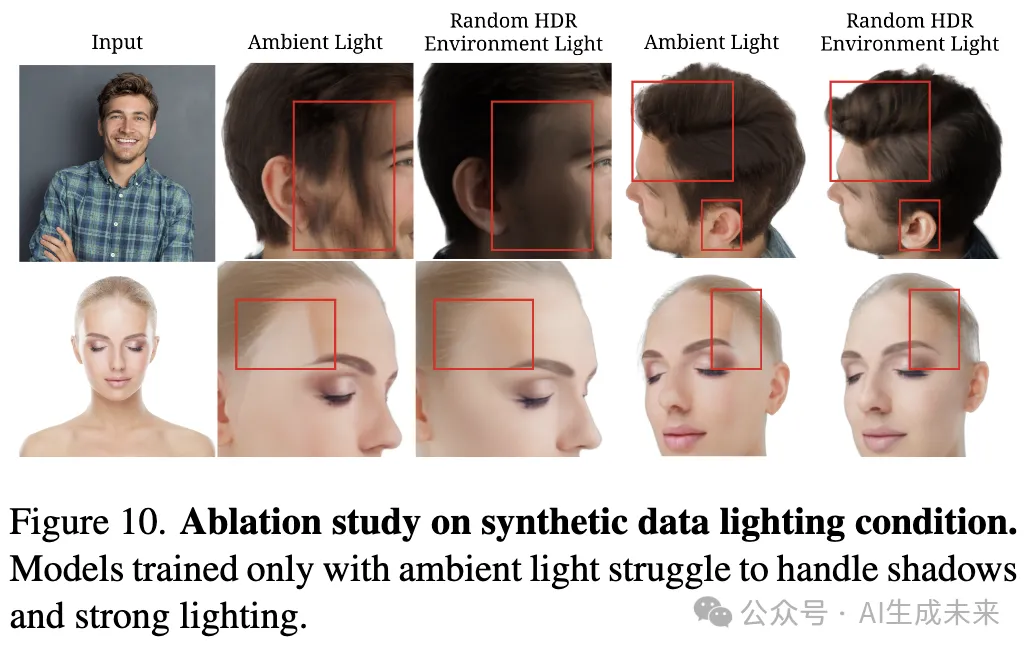

多样化光照数据的重要性

FaceLift 使用合成数据进行训练,这带来了控制光照条件的优势,使得头像图像可以在多种光照场景下渲染。相比之下,真实世界的人脸数据通常在类似环境光的工作室中捕获,如下图 2 中的输入所示。

- 仅环境光渲染的数据

- 随机 HDR 环境光渲染的数据

结果比较

结果如下图 10 所示:

- 仅环境光数据训练的模型

- 难以正确理解阴影,常在面部生成类似头发的纹理。

- 面对强光照时,面部会出现白色区域。

- 随机 HDR 环境光数据训练的模型

- 在不同光照区域之间生成平滑过渡,表现出更强的光照适应能力。

此研究表明,丰富的光照数据是训练高性能 3D 人脸重建模型的重要因素。

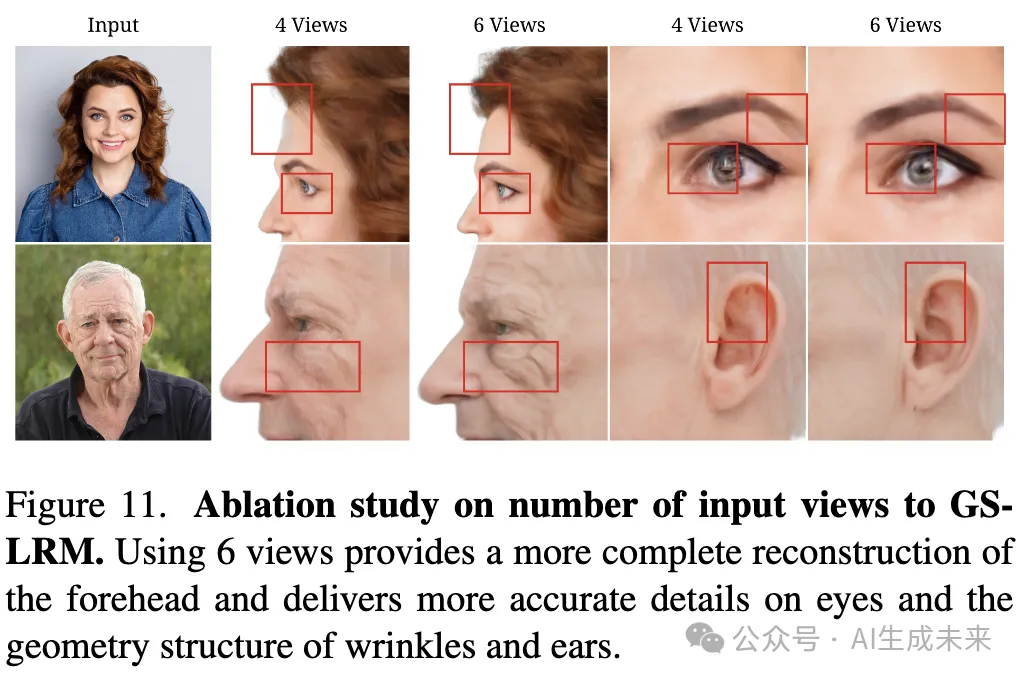

多视角用于 GS-LRM 重建原始 GS-LRM 使用四个视角进行推理。在此基础上增加了两个视角(左前方和右前方),以进一步改善面部细节结构的重建能力。

如下图 11 所示,不同输入图像数量对 GS-LRM 重建的影响如下:

- 仅使用四个视角:

- 无法完整重建前额。

- 使用六个视角:

- 更平滑地重建眼睛和眉毛。

- 更真实地呈现诸如面部皱纹和耳部褶皱等复杂纹理。

GS-LRM 微调的有效性

在 FaceLift 中使用的 GS-LRM 是通过在 Objaverse 上使用合成头像数据进行预训练的 GS-LRM 检查点进行微调的。

为了验证合成头像数据训练的重要性,将以下两种模型的渲染结果进行了对比:

- 仅在 Objaverse 上训练的 GS-LRM

- 微调后的 GS-LRM

结果显示:

- 未微调的 GS-LRM

- 难以准确估计面部深度,导致眼部区域出现伪影,并且由于缺乏从头顶上方投影的高斯点,头顶呈现扁平状态。

- 微调后的 GS-LRM

- 学习到了头部结构的先验知识,能够生成更平滑和更真实的渲染结果。

结论与未来工作

FaceLift,这是一种单张人脸图像到高精度 3D 重建的前馈方法,能够保留身份特征。FaceLift 通过多视角扩散生成不可见视角,并利用 GS-LRM 重建 3D 高斯点,支持高质量的新视角合成。为了应对捕获真实世界多视角头像图像的困难,本文采用高质量合成数据进行训练。尽管仅在合成数据上训练,FaceLift 仍能从真实图像中高保真地重建 3D 头像。

相比baseline方法,FaceLift 表现出以下优势:

- 更精细的几何与纹理细节

- 更好的身份特征保留能力

此外,还展示了 FaceLift 在视频输入场景下支持 4D 新视角合成的能力,验证了其高保真与鲁棒性。尽管如此,仍观察到跨时间戳的一些不一致性,尤其是在头发区域。

未来工作方向

为了增强时间一致性,计划引入 4D 高斯表示,从而更好地约束 3D 高斯点在帧间的位置、形状、大小及旋转等属性。

本文转自AI生成未来 ,作者:AI生成未来