几秒生成逼真3D场景,泛化媲美Stable Diffusion | 浙大&蚂蚁等提出Prometheus

论文链接:https://arxiv.org/pdf/2412.21117

git链接:https://freemty.github.io/project-prometheus/

亮点直击

- Prometheus,这是一种面向文本到3D生成的3D感知隐空间扩散模型,适用于对象和场景级别。

- 按照标准的隐空间扩散范式,将训练分为两个不同的阶段。在第一阶段,训练一个3D高斯变分自编码器(GS-VAE),它以多视角或单视角RGB-D图像为输入,预测每个像素对齐的3D高斯。在第二阶段,训练一个多视角LDM,联合预测多视角RGB-D隐空间code,并以相机姿态和文本提示为条件。

- 此外,本文的完整模型在9个多视角和单视角数据集的组合上进行训练,旨在实现与Stable Diffusion相当的泛化能力。

- 展示了该方法在前馈3D高斯重建和文本到3D生成中的有效性,表明本模型能够在几秒钟内生成3D场景,同时很好地泛化到各种3D对象和场景。

总结速览

解决的问题

- 实现从文本到3D场景的高效生成,适用于对象级别和场景级别。

- 提升生成3D内容的保真度和几何质量,同时确保模型具备良好的泛化能力。

- 改善现有方法在3D生成中的效率问题,实现快速且高质量的3D生成。

提出的方案

- 多视图、前馈、像素对齐的3D高斯生成:将3D场景生成表述为在隐空间变量扩散框架中的这一过程。

- 两阶段训练框架:

- 第一阶段:训练3D高斯变分自编码器(GS-VAE),以多视角或单视角的RGB-D图像为输入,预测每个像素对齐的3D高斯。

- 第二阶段:训练多视角隐空间变量扩散模型(LDM),联合预测多视角RGB-D隐空间代码,并以相机姿态和文本提示为条件进行生成。

- RGB-D隐空间变量空间的引入:通过解耦外观和几何信息,优化3D高斯生成的效率和质量。

- 基于预训练模型的微调:以预训练的文本到图像生成模型为基础,进行最小调整后,利用来自单视图和多视图数据集的大量图像进行训练。

应用的技术

- 隐空间变量扩散模型(LDM):作为生成框架,结合3D高斯生成和多视角条件。

- 3D高斯变分自编码器(GS-VAE):用于从RGB-D图像中提取隐空间变量并生成像素对齐的3D高斯。

- RGB-D隐变量空间:解耦外观(RGB)和几何信息(D),提升生成的保真度和几何质量。

- 多视角训练数据:结合9个多视角和单视角数据集,增强模型的泛化能力。

- 前馈生成策略:相比传统方法,显著加速生成过程。

达到的效果

- 高效生成:在几秒内实现对象级别和场景级别的3D生成。

- 高质量输出:生成的3D内容在保真度和几何质量上表现优异。

- 良好的泛化能力:在不同类型的3D对象和场景中均表现出色,与Stable Diffusion相当的泛化能力。

- 实验验证:大量实验结果证明了Prometheus在前馈3D高斯重建和文本到3D生成中的有效性。

方法

如下图2所示,Prometheus遵循常见的隐空间变量扩散框架,该框架包括两个训练阶段。在第一个阶段,3D自动编码器GS-VAE从多视图图像中学习压缩和抽象的隐空间变量空间。随后,它将该隐空间变量空间解码为像素对齐的3D高斯(3DGS)表示,作为场景级别的表示。在第二个阶段,一个隐空间变量多视图扩散模型(MVLDM)在第一阶段自动编码器生成的隐空间变量表示上进行训练,从而形成一个完全生成的模型。最后,详细说明了采样策略,该策略能够在几秒钟内采样出3D场景,同时保持一致性和视觉保真度。

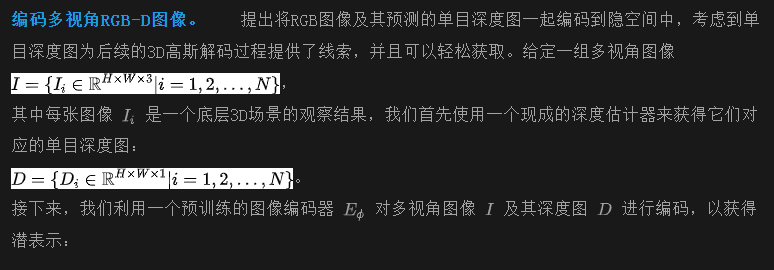

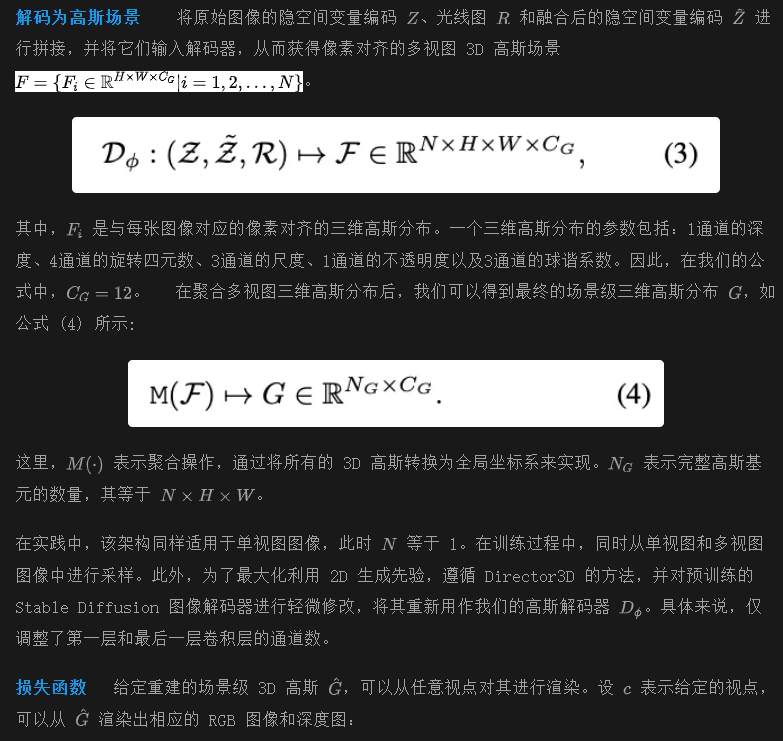

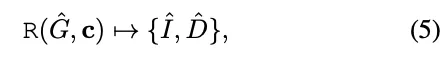

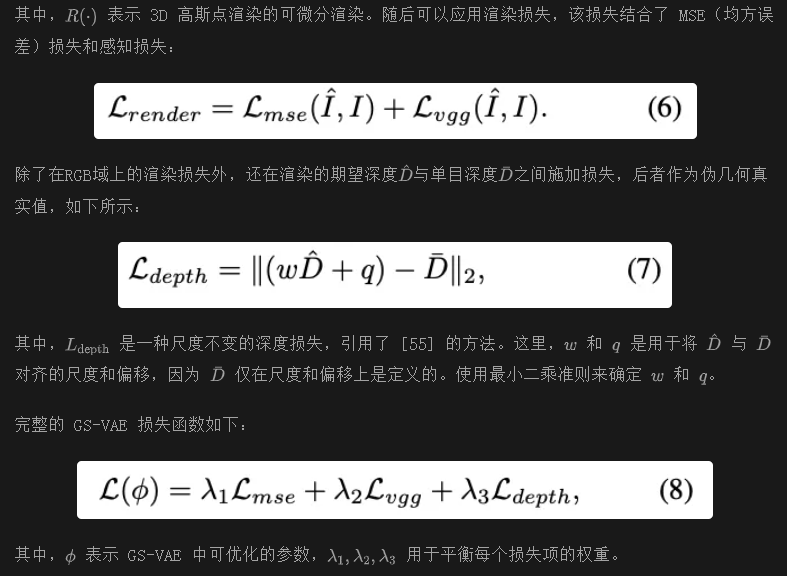

第一阶段: GS-VAE

在阶段 1 中,目标是训练一个能够将数据压缩到隐空间并随后将其重建为3D表示的3D自动编码器。给定具有相机位姿的多视角输入图像,GS-VAE输出多视角像素对齐的3D高斯表示(3DGS)。这些输出随后被合并为场景级别的3D表示。

其中h x w是下采样后的分辨率。在实际操作中,使用预训练的 Stable Diffusion (SD) 图像编码器,并在训练过程中冻结它。最近的方法(如 Marigold)表明,SD 编码器在处理深度图时表现出强大的泛化能力。因此,我们选择使用相同的 SD 编码器分别对图像和深度进行编码,而无需进行微调。随后,我们将这些编码表示进行拼接,以获得完整的多视图隐空间变量Z,该隐空间变量可用于 3D 重建。此外,我们的扩散模型在联合的 RGB-D 隐空间变量空间中进行训练。

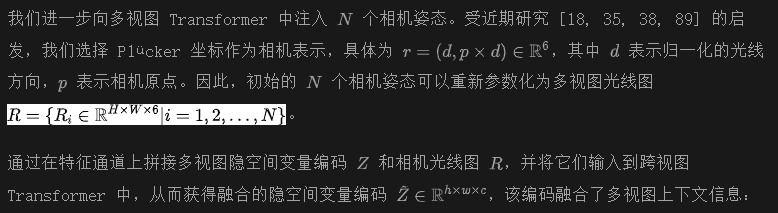

融合多视图隐空间变量图像 最近的研究进展 [26, 35, 77, 101, 102] 强调了基于 Transformer 的模型在整合多视图信息方面的显著潜力。由于每个视图的隐空间变量编码Z是独立生成的,我们采用多视图 Transformer 来促进跨视图信息的交换。

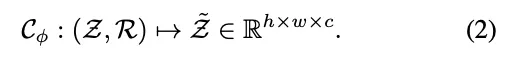

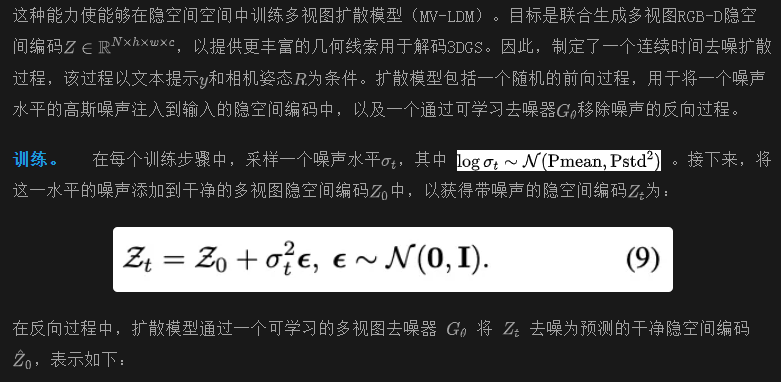

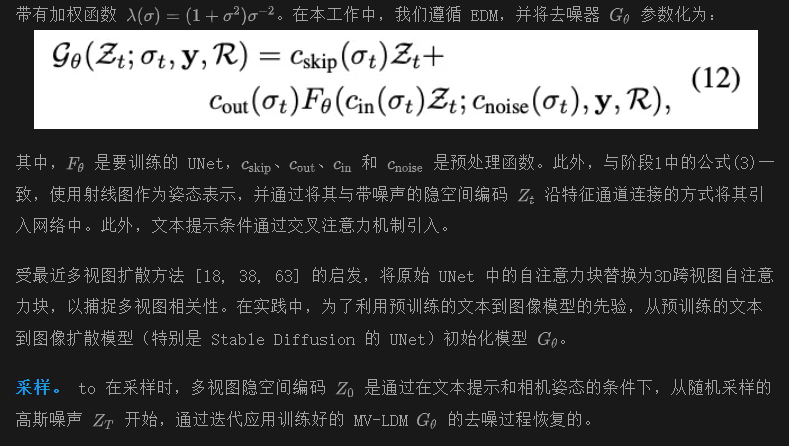

第二阶段: 几何感知多视图降噪器

在第一阶段的训练之后,获得了一个GS-VAE,其具备以下能力:

- 能够高效地将图像压缩到一个紧凑的隐空间空间中;

- 通过3D高斯解码器在2D和3D之间架起桥梁.

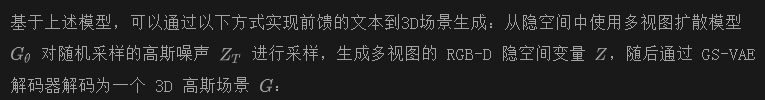

其中,y和R分别是文本和相机姿态的条件。MV-LDM 是通过在隐空间中使用去噪得分匹配 (DSM)进行训练的。

几秒钟内生成文本到 3D 场景

为了以高质量进行采样并与条件对齐,使用无分类器引导(CFG)来引导多视图生成朝向条件信号 。

实验

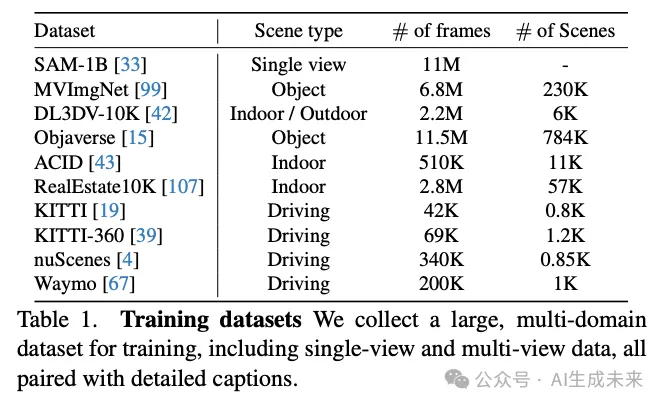

训练数据

本文方法在大规模单视图和多视图数据集上进行训练,详见下表1。关于单视图数据集,使用了高质量的 SAM-1B 数据集,该数据集包含详细的描述,并出现在 PixArt-α 中。本文模型在9个多视图数据集的组合上进行训练,这些数据集包括以物体为中心、室内、室外和驾驶场景。每个场景的文本提示由多模态大语言模型 生成。

实施细节

在GS-VAE的训练阶段(阶段1),为每个多视图场景设置输入视图和新视图的数量为N=4。为了提高模型的泛化能力,还在多视图图像旁采样2个单视图图像,并仅对单视图图像的输入视图应用损失。GS-VAE在8个A800 GPU上以32的批量大小进行训练。最终模型经过200,000次迭代,大约需要4天。使用gsplat作为我们的3D高斯渲染器。从预训练的RayDiff模型初始化跨视图Transformer的权重。

对于MV-LDM(阶段2),采用Stable Diffusion 2.1作为基础模型。在训练过程中,为每个多视图场景设置N=8。与阶段1类似,在多视图图像旁采样M=4个单视图图像。每次迭代时,在每个GPU上采样批大小为8的图像。最终的MV-LDM模型在32个A800 GPU上训练,总批量大小为3072张图像。模型经过350,000次迭代,大约需要7天。使用DepthAnything-V2-S模型动态估计深度图。为了在采样过程中实现无分类器引导,在训练过程中,以10%的概率随机丢弃文本条件t和姿态条件p。

评估协议

3D生成(阶段2)。 为了评估本文模型的文本到3D生成能力,使用来自T3Bench 的两个文本提示集——单对象和单对象带环境。这些集合共同评估模型在对象级别和场景级别生成任务中的熟练程度。此外,收集了80个涵盖室内和室外场景的多样化场景级别文本提示。定量结果使用CLIPScore、NIQE 和BRISQUE 指标进行评估。CLIPScore评估生成图像与文本提示之间的一致性,而NIQE和BRISQUE则表示图像质量。

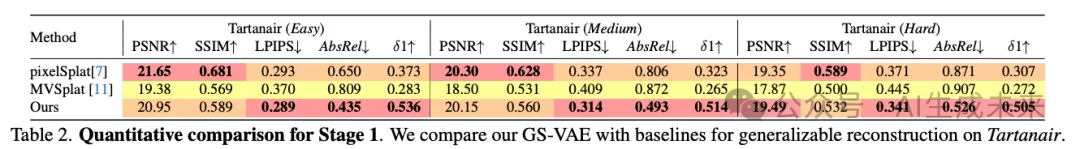

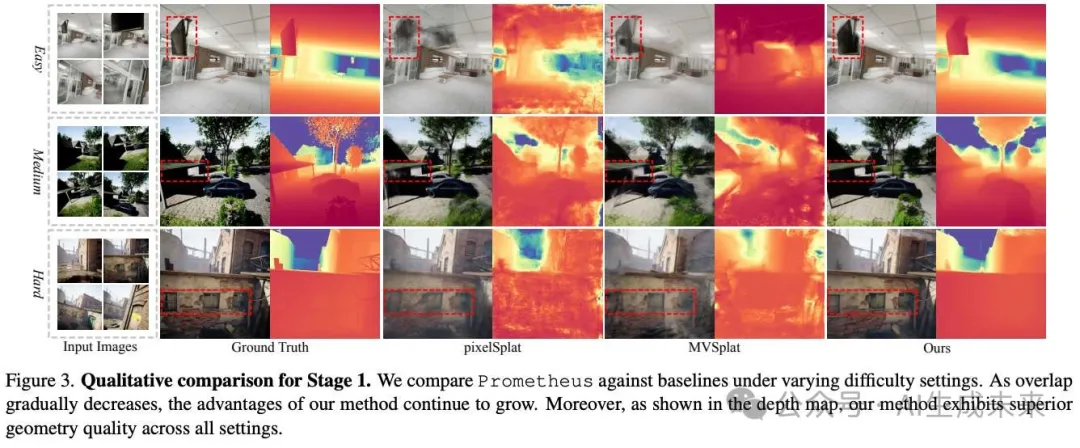

与基线比较

3D生成。 将Prometheus与三种文本到3D的基线方法进行比较,涵盖了基于优化的方法和前馈方法。GaussianDreamer 是一种最先进的基于SDS的3DGS方法。还实现了一个基线,它将多视图到3D的方法LGM 应用于由MVDream 生成的图像。我们还与一种前馈方法Director3D(不带精炼器)进行比较。下图4和下图5显示,本文方法能够生成对象和场景级别的内容,包含背景和丰富的细节,优于基于优化和前馈的基线。下表3显示,整体指标在对象级别上不如Director3D,但在其他情况下领先。这归因于对象中心设置中的失败案例。请注意,我们方法仅需8秒即可生成,优于所有基线。

GS-VAE 消融 (Stage 1)

在下表4中,对Tartanair的困难模式进行了消融研究,分析了GS-VAE的以下因素。

深度先验对GS-VAE的有效性: 研究了在第一阶段训练中RGB-D隐空间空间的影响。上表4中的结果显示,仅使用RGB隐空间空间而不使用RGB-D隐空间空间进行训练,会导致几何结果比完整模型更差。此外,这种较差的几何将导致重建图像的质量不佳,详见图6中的定性结果。

大规模数据集在可泛化重建中的重要性: 接下来,对大规模数据集的有效性进行了消融研究,在上表4中标记为“w/o single-view”。排除单视图数据集会导致重建图像和几何性能的下降。这强调了大规模数据集在实现稳健的可泛化重建中的重要作用。也在下图6中展示了定性结果。

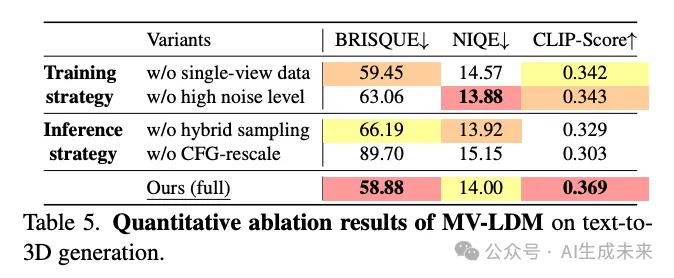

MV-LDM 消融(Stage 2)

在下表 5 中,对 T3Bench 的 SingleObject-with-Surroundings 子集进行了消融研究,分析了 MV-LDM 的训练和推理策略。

单视图数据集 (Single-View Dataset)

评估了单视图数据的影响。当仅使用多视图数据进行训练(即不包含单视图数据,w/o single-view data)时,模型性能出现了下降。这种性能下降可归因于缺乏单视图数据,导致模型的泛化能力降低,这与 MVDream 中的观察结果一致。

混合采样和 CFG 重标定 (Hybrid Sampling and CFG-Rescale)

最后,评估了前文中推理策略的设计,具体包括混合 CFG 采样和 CFG 重标定。在实验中,仅对文本提示应用 CFG(即不使用混合采样,w/o hybrid sampling),并将 CFG 重标定因子设置为 0(w/o CFG-rescale)。上表 5 显示,缺乏混合采样和 CFG 重标定会导致指标在不同程度上下降。

结论

Prometheus,这是一种3D感知的隐空间扩散模型,专为在对象级别和场景级别上实现文本到3D生成而设计,并且能够在数秒内完成。通过大量实验,展示了该方法在前馈重建和3D生成任务中的有效性。相信,本工作为文本到3D场景生成提供了重要贡献,提升了通用性、保真度和效率。

本文转自AI生成未来 ,作者:AI生成未来