视觉文本语音强强联合!南大&腾讯优图发布GPT-4o级别的实时视觉语音交互——VITA1.5

文章链接:https://arxiv.org/pdf/2501.01957

git 链接:https://github.com/VITA-MLLM/VITA

亮点直击

- VITA-1.5,一种多模态大语言模型(LLM),通过精心设计的三阶段训练方法整合了视觉、语言和语音。该训练策略逐步引入视觉和语音数据,缓解了模态冲突,同时保持了强大的多模态性能。

- 对图像、视频和语音理解相关的各类基准进行了广泛评估,并将结果与开源和专有模型进行了比较。VITA-1.5展现了与领先的基于图像/视频的多模态大语言模型(MLLMs)相当的感知和推理能力,并在语音能力上表现出显著提升。

总结速览

解决的问题

当前多模态大语言模型(MLLMs)主要聚焦于视觉和文本模态的整合,而对语音在增强交互中的作用关注较少。视觉和语音模态的融合存在根本性差异,导致在视觉和语音任务中实现高性能仍是一个显著挑战。此外,传统方法依赖独立的自动语音识别(ASR)和语音合成(TTS)模块,增加了系统复杂性和延迟。

提出的方案

提出了一种名为 VITA-1.5 的多模态大语言模型,通过精心设计的三阶段训练方法,逐步整合视觉、语言和语音模态,具体包括:

- 第一阶段:训练视觉适配器,基于视觉-语言数据(如描述性字幕和视觉问答数据)微调模型,建立视觉理解能力。

- 第二阶段:引入音频处理模块,基于语音与转录配对数据训练音频编码器,并通过语音问答数据微调模型,使其具备语音理解能力。

- 第三阶段:训练音频解码器,实现端到端语音输出,避免使用独立的TTS模块,从而提升语音交互的流畅性和效率。

应用的技术

- 多模态融合:通过多阶段训练策略,逐步引入视觉和语音数据,缓解模态冲突问题。

- 视觉适配器:提升模型对图像和视频的感知与推理能力。

- 音频编码器与解码器:实现语音输入的高效理解及端到端语音输出,避免依赖外部ASR和TTS模块。

- 端到端优化:减少模块化设计带来的延迟,实现实时多模态交互。

达到的效果

- 在图像、视频和语音任务的基准测试中,VITA-1.5展现了与领先的基于图像/视频的多模态大语言模型相当的视觉感知和推理能力。

- 在语音任务上表现出显著提升,支持近乎实时的视觉和语音交互。

- 实现了无需独立ASR和TTS模块的高效语音到语音对话功能,大幅加速了多模态响应速度,并提升了交互自然性和用户体验。

VITA-1.5

模型架构

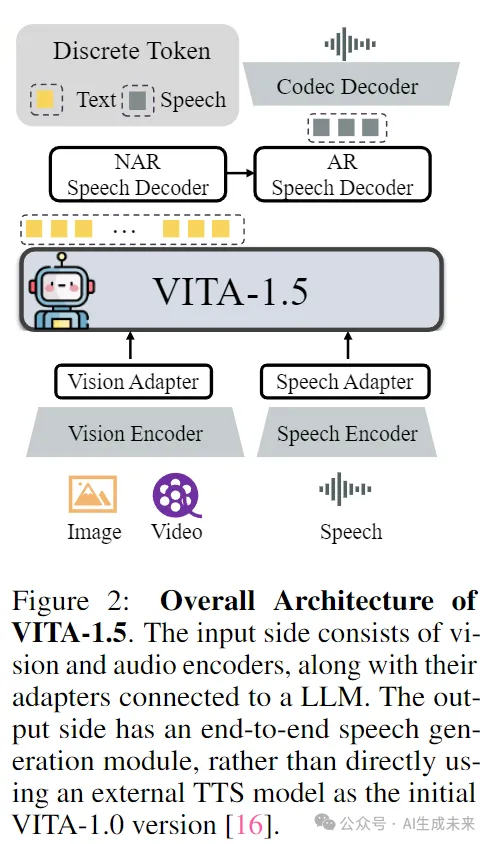

VITA-1.5 的整体架构如图 2 所示。

输入端与 VITA-1.0 版本相同,即采用“多模态编码器-适配器-LLM”的配置。它结合了视觉/音频 Transformer 和多层连接器,与 LLM 一起进行联合训练,旨在增强对视觉、语言和音频的统一理解。

在输出端,VITA-1.5 拥有自己的端到端语音模块,而不是像原始 VITA-1.0 版本那样使用外部 TTS 模型。

视觉模态

视觉编码器

VITA-1.5 采用 InternViT-300M 作为视觉编码器,输入图像大小为448X448像素,每张图像生成 256 个视觉标记(visual tokens)。对于高分辨率图像,VITA-1.5 使用动态分块(dynamic patching)策略来捕捉局部细节,从而提升图像理解的准确性。

视频处理

视频被视为一种特殊的多图像输入。如果视频长度小于 4 秒,则均匀采样 4 帧;对于 4 到 16 秒的视频,每秒采样 1 帧;对于长度超过 16 秒的视频,均匀采样 16 帧。为了避免生成过多视觉标记而影响处理效率,视频帧不适用动态分块。

视觉适配器

使用两层 MLP(多层感知机)将视觉特征映射为适合后续 LLM 理解的视觉标记。

音频模态

语音编码器(Speech Encoder)

类似于[56],本文的音频编码模块由多个下采样卷积层(4倍下采样)和24个Transformer块(隐藏层大小为1024)组成。下采样层有助于降低音频特征的帧率,从而提高LLM的处理速度。音频编码器包含约3.5亿参数,输出帧率为12.5Hz。音频编码器的输入为梅尔滤波器组特征(Mel-filter bank features),其窗口大小为25ms,帧移为10ms。

语音适配器(Speech Adapter)

语音适配器由多个带有2倍下采样的卷积层组成。

语音解码器(Speech Decoder)

使用TiCodec 作为编解码模型,定制了一个大小为1024的单码本(single codebook)。这种单码本设计简化了推理阶段的解码过程。编解码模型负责将连续的语音信号编码为频率为40Hz的离散语音标记(speech tokens),并同时具备将其解码回采样率为24,000Hz的语音信号的能力。

当前的LLM只能输出文本标记(text tokens),而语音生成能力要求LLM能够输出语音标记。为此,在文本标记之后添加了两个语音解码器(参考[56]):

- 非自回归(Non-Autoregressive, NAR)语音解码器:全局处理文本token并建模语义特征,旨在生成语音token的初始分布。

- 自回归(Autoregressive, AR)语音解码器:基于NAR解码器生成的语音信息,逐步生成更高质量的语音标记。

最终的语音标记序列通过Codec模型的语音解码器被解码为连续的语音信号流(波形)。为NAR和AR语音解码器分别采用了4层LLaMA解码器,其隐藏层大小为896,参数规模约为1.2亿。

训练数据

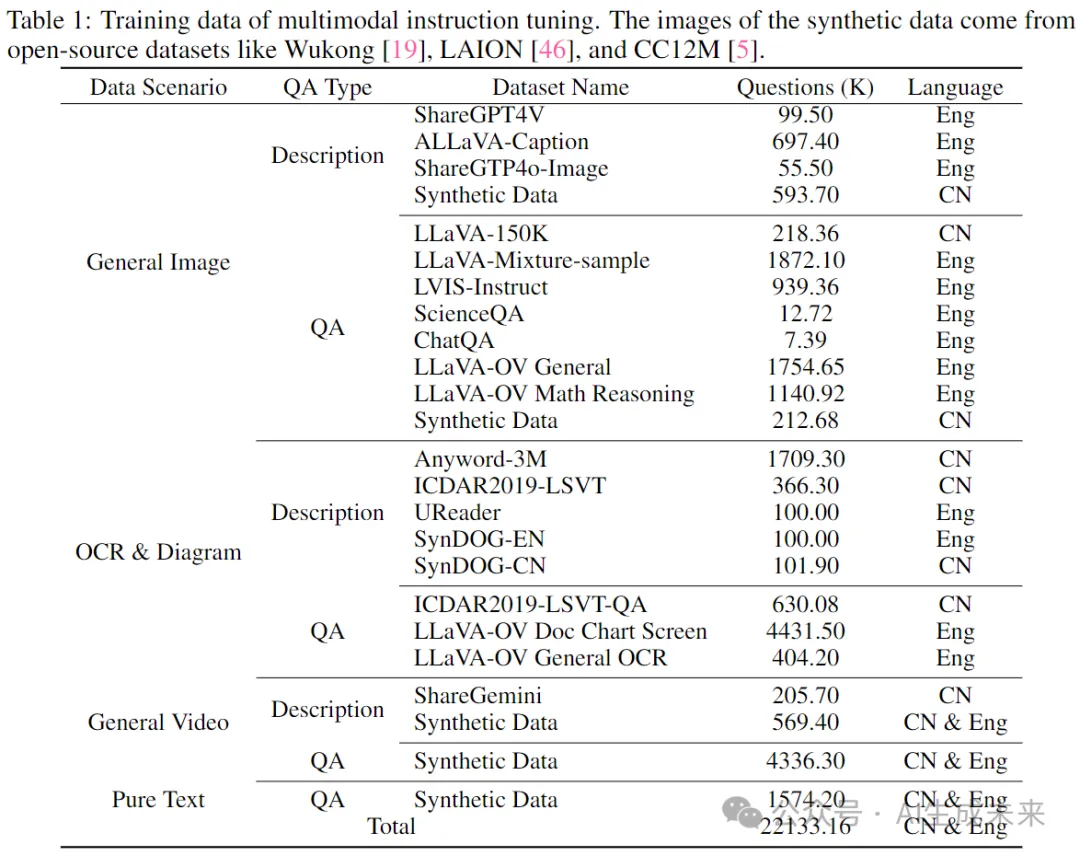

如表1所示,多模态指令微调的训练数据涵盖了广泛的类别,例如图像描述数据和问答(QA)数据,涉及中文和英文。在不同的训练阶段,会有选择性地从整个数据集中抽取子集以实现不同的训练目标。

具体来说,这些数据集被分类如下:

- 图像描述数据:使用的数据集包括 ShareGPT4V、ALLaVA-Caption、SharedGPT4o-Image,以及合成数据,用于训练模型生成图像的描述性语言。

- 图像问答数据:使用的数据集包括 LLaVA-150K、LLaVA-Mixture-sample、LVISInstruct、ScienceQA、ChatQA ,以及从 LLaVA-OV 中抽取的子集(如通用图像问答和数学推理数据集),用于训练模型回答基于图像的问题并执行视觉推理任务。

- OCR和图表数据:此类别支持模型理解OCR和图表内容,使用的数据集包括 Anyword-3M 、ICDAR2019-LSVT 、UReader、SynDOG、ICDAR2019-LSVT-QA,以及从 LLaVA-OV 中抽取的相关数据。

- 视频数据:使用的数据集包括 ShareGemini和合成数据,用于训练模型处理视频输入并执行视频描述和基于视频的问答任务。

- 纯文本数据:此类别增强了模型理解和生成语言的能力,以支持基于文本的问答任务。

除了表1中列出的图像和视频数据外,还包含了11万小时的内部语音转录配对的ASR数据(涵盖中文和英文),用于训练音频编码器并将其与大语言模型(LLM)对齐。此外,还使用了3000小时由TTS系统生成的文本-语音配对数据,用于训练语音解码器。

三阶段训练策略

为了确保 VITA-1.5 在视觉、语言和音频相关任务中表现良好,必须面对一个关键挑战,即不同模态之间的训练冲突。例如,加入语音数据可能会对视觉数据的理解产生负面影响,因为语音的特征与视觉的特征存在显著差异,这会在学习过程中引发干扰。为了解决这一挑战,设计了一个如图 3 所示的三阶段训练策略。核心思想是逐步将不同的模态引入模型,使其在增强新模态能力的同时,保持现有模态的能力。

Stage 1: 视觉-语言训练

阶段 1.1:视觉对齐(Vision Alignment)

阶段 1.2:视觉理解(Vision Understanding)

阶段 1.3:视觉微调(Vision SFT)

Stage 2: 音频输入微调

阶段 2.1 音频对齐 在完成阶段 1 的训练后,模型已在图像和视频理解方面建立了坚实的基础。在此阶段,目标是基于阶段 1 的成果,减少音频和语言之间的差异,从而使大语言模型(LLM)能够理解音频输入。训练数据包含 11,000 小时的语音-转录对。我们采用两步方法:

(a) 语音编码器训练

采用常见语音识别系统中使用的训练框架,利用连接时序分类(Connectionist Temporal Classification, CTC)损失函数来训练语音编码器。目标是让编码器从语音输入中预测出转录文本。此步骤确保语音编码器能够提取语音特征并将其映射到文本表示空间。

(b) 语音适配器训练

在完成语音编码器的训练后,将其与 LLM 集成,使用音频适配器将音频特征引入 LLM 的输入层。在此阶段的训练目标是使 LLM 能够输出语音数据的转录文本。此外,在步骤 (b) 中,引入了特殊的可训练输入标记(tokens)来引导语音理解过程。这些token提供额外的上下文信息,用于指导 LLM 在问答(QA)任务中执行自动语音识别(ASR)任务。

在本阶段,视觉编码器与适配器、音频编码器与适配器,以及 LLM 均可训练,旨在提升模型对多模态输入的适应能力。此外,在 LLM 的输出端添加了一个分类头(classification head),用于区分输入是来自语音还是文本。通过这一改进,模型能够更准确地解释语音输入,并高效、灵活地处理不同模态的数据。

Stage 3: 音频输出微调

在训练的前两个阶段,VITA-1.5模型已经有效地发展了其多模态理解能力。然而,一个关键能力,即语音输出,仍然缺失,而这对于其作为交互助手的角色至关重要。为了在不影响模型基本能力的情况下引入语音输出功能,借鉴了策略[56],使用了3,000小时的文本-语音数据,并采用了两步训练方法(见图3)。

阶段3.1 编解码器训练。 此步骤的目标是使用语音数据训练一个具有单个码本的编解码器模型。编解码器模型的编码器能够将语音映射为离散的标记,而解码器可以将离散的标记映射回语音流。在VITA-1.5的推理阶段,仅使用解码器。

阶段3.2 非自回归(NAR)+自回归(AR)解码器训练。 本阶段的训练使用文本-语音配对数据,其中文本被输入到分词器和LLM的嵌入层以获得其嵌入向量,而语音被输入到编解码器模型的编码器以获得其语音标记。文本嵌入向量被发送到NAR语音解码器以获取全局语义特征,然后这些特征被发送到AR语音解码器,后者预测相应的语音标记。注意,在此阶段LLM是冻结的,因此多模态性能不会受到影响。

评估

视觉-语言评估

基准模型 比较了一系列开源的多模态大语言模型(MLLM),包括VILA-1.5、LLaVA-Next、CogVLM2、InternLM-XComposer2.5、Cambrian-1、MiniCPM-V-2.6、Ovis1.5、InternVL-Chat-1.5、InternVL-2、LLaVA-OV、Video-LLaVA、SliME和LongVA,以及5个闭源的MLLM,包括GPT-4V7、GPT-4o8、GPT-4o-mini、Gemini 1.5 Pro和Claude 3.5 Sonnet9。

评估基准 为了评估VITA-1.5的图像感知和理解能力,使用了多个评估基准,包括MME、MMBench、MMStar、MMMU、MathVista、HallusionBench、AI2D、OCRBench和MMVet。这些基准涵盖了广泛的方面,包括一般的多模态能力(例如,MME、MMBench和MMMU)、数学推理(MathVista)、幻觉检测(HallusionBench)、图表(AI2D)和OCR(OCRBench)理解,提供了全面的评估结果。对于视频理解,使用了具有代表性的评估基准,包括Video-MME、MVBench和TempCompass。

视觉-语言能力 表2展示了VITA-1.5在图像理解性能方面的比较。经过三个阶段的训练后,VITA-1.5的表现与最先进的开源模型相当,甚至超过了一些闭源模型,如GPT-4V和GPT-4o-mini。这个结果突显了VITA-1.5在图像-语言任务中的强大能力。如表3所示,VITA-1.5在视频理解的评估中表现出与顶级开源模型相当的性能。与专有模型相比的显著差距表明,VITA-1.5在视频理解方面仍有显著的改进空间和进一步增强的潜力。请注意,在阶段2(音频输入调优)和阶段3(音频输出调优)训练后,VITA-1.5几乎保留了其在阶段1(视觉-语言训练)中的原始视觉-语言能力。

语音评估

基线模型。使用以下三个基线模型进行比较:Wav2vec2-base、Mini-Omini2、Freeze-Omini和 VITA-1.0。

评估基准。 普通话评估集包括三个数据集:aishell-1、test net和 test meeting。这些数据集用于评估模型在普通话语音上的表现。评估指标是字符错误率(CER)。英语评估集包括四个数据集:dev-clean、dev-other、test-clean 和 test-other,用于评估模型在英语语音上的表现。评估指标是单词错误率(WER)。

语音识别性能。 表 4 中的评估结果表明,VITA-1.5 在普通话和英语语音识别任务中均实现了领先的准确性。这表明 VITA-1.5 成功整合了先进的语音能力,以支持多模态交互。

结论

VITA-1.5,这是一种多模态大语言模型(LLM),通过精心设计的三阶段训练策略来整合视觉和语音。通过缓解模态间的固有冲突,VITA-1.5在视觉和语音理解方面实现了强大的能力,使得语音到语音的高效交互成为可能,而无需依赖单独的自动语音识别(ASR)或文本到语音(TTS)模块。广泛的评估表明,VITA-1.5在多模态基准测试中表现出色。希望VITA-1.5能够接过VITA-1.0的旗帜,继续推动开源模型在实时多模态交互领域的进步。

本文转自AI生成未来 ,作者:AI生成未来