中科大揭秘微调大模型的秘诀:如何精准选择数据提升AI性能 精华

引言:数据选择对于微调大型语言模型的重要性

在当今的人工智能领域,大型语言模型(LLMs)的发展已经达到了令人瞩目的高度,它们不仅能够生成接近真实人类语言的文本,还能够完成许多经典的自然语言处理(NLP)任务。这些模型如GPT和BERT等,通过在大规模数据集上进行预训练,已经展示出了强大的语言理解和生成能力。然而,要使这些模型在特定的下游任务中达到最佳表现,仅仅依靠预训练是不够的,这就需要通过微调(fine-tuning)来进一步优化模型。

微调是一个涉及模型调整的过程,目的是使预训练的语言模型更好地适应特定的应用场景。这一过程的关键在于选择合适的数据进行训练。数据选择的好坏直接影响到微调后模型的性能,因为不同的数据会对模型的学习路径和最终表现产生重大影响。选择高质量的数据子集不仅可以提高模型的表现,还可以加速训练过程,节省计算资源。

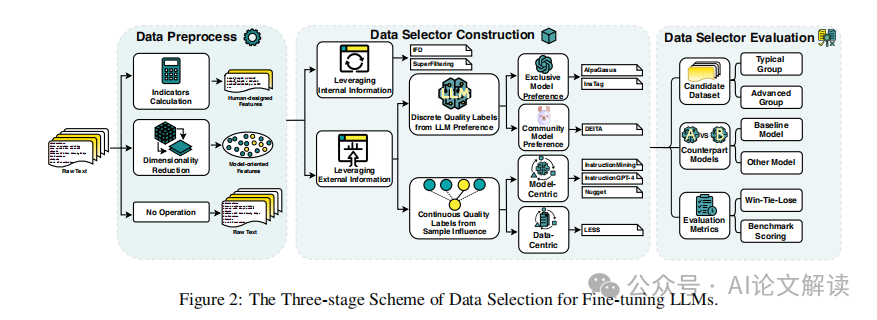

为了有效地选择数据,研究人员提出了多种数据选择方法,这些方法旨在从候选数据集中筛选出最能提高模型性能的数据样本。这一过程通常涉及三个阶段:数据预处理、数据选择器构建和数据选择器评估。在数据预处理阶段,原始数据会被转换成模型可以直接利用的格式,例如,将文本转换为特征向量。接下来,在数据选择器构建阶段,会根据预设的标准来评估每个数据样本的质量,并构建一个选择器来自动化选择过程。最后,在数据选择器评估阶段,通过比较选择器选出的数据训练的模型与在完整数据集上训练的模型的表现,来验证选择器的有效性。

通过这样的方法,研究人员能够更精确地控制数据对模型的影响,从而在保证模型表现的同时,优化训练效率。因此,数据选择作为微调大型语言模型的一个重要环节,它的研究和应用对于推动语言模型的实际应用具有重要意义。

论文标题: Take the essence and discard the dross: A Rethinking on Data Selection for Fine-Tuning Large Language Models

论文链接: https://arxiv.org/pdf/2406.14115.pdf

数据选择的三阶段方案

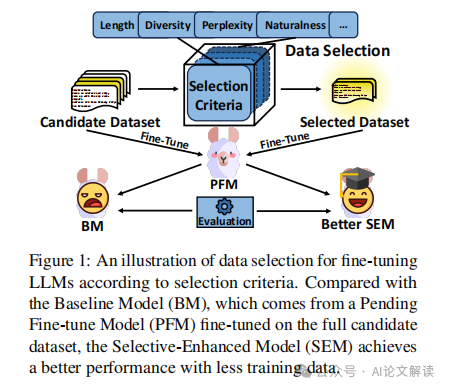

在大型语言模型(LLM)的微调过程中,数据选择是一个关键步骤,它旨在从给定的候选数据集中选择一个高质量的子集,以训练待微调模型(PFM),从而得到选择增强模型(SEM)。这一过程可以提高模型的性能并加速训练过程。以下是数据选择的三个阶段:

1. 数据预处理

数据预处理是数据选择流程的第一步,主要目的是将原始数据转换为更适合后续处理的格式。在这一阶段,一些研究保留了文本的原始特征,而其他研究则将文本转换为人为设计的特征或模型导向的特征。例如,Cao等人(2023年)使用了基于语言的指标来转换样本,这些指标包括连贯性、自然性和可理解性等,而Xia等人(2024年)则从LLM中提取低维梯度特征,用于更直接和针对性的选择。

2. 数据选择器的构建

数据选择器的构建关注于选择标准的设计,这些标准应当能够真实反映每个样本的质量。根据质量标签的信息来源,选择方法可以分为内部信息和外部信息两大类。内部信息指的是仅与候选数据集本身相关的信息,如Li等人(2024b)提出的指令遵循难度(IFD)标签;而外部信息则考虑了候选数据集之外的信息,例如Chen等人(2024年)使用的来自外部LLM的离散质量标签。

3. 数据选择器的评估

数据选择器的评估是验证选择器有效性的关键步骤,主要通过比较选择增强模型(SEM)和基线模型(BM)的性能来进行。这一评估通常涉及将通过选择器选出的数据子集用于微调模型,并将该模型的性能与全数据微调的基线模型进行比较。例如,Lu等人(2023年)使用MT-Bench等流行基准进行评分,直接量化SEM的性能表现。

通过这三个阶段的详细分析,我们可以更深入地理解数据选择对大型语言模型微调的影响,以及如何通过精确的数据选择提高模型效率和效果。

数据选择的关键因素:内部信息与外部信息的利用

1. 利用内部信息

在数据选择过程中,利用内部信息是指直接从候选数据集中提取数据质量标签。这种方法的优势在于能够直接反映数据本身的质量,而不受外部因素的干扰。例如,Li等人(2024b)提出了一种基于指令遵循难度(Instruction Following Difficulty, IFD)的质量标签,该标签通过评估在给定指令的帮助下生成特定答案的可能性变化来确定。他们首先使用部分候选数据集训练一个预体验模型(PFM),然后基于这个模型来评估IFD分数。

此外,SuperFiltering(Li等人,2024a)采用了一个较小的模型(GPT-2)作为预体验模型,通过比较小模型与大模型之间的IFD和困惑度的一致性,来选择数据。这种从弱到强的数据过滤方式,可以有效地筛选出高质量的数据。

2. 利用外部信息

利用外部信息进行数据选择涉及到从数据集之外获取样本质量的信息。这可以进一步细分为离散质量标签和连续质量标签。

2.1 离散质量标签

一些研究利用专有的大型语言模型(如ChatGPT)或社区模型(如LLaMA)来自动注释样本质量,随后通过设计的选择算法进行数据选择。例如,AlpaGasus(Chen等人,2024)通过向ChatGPT提供特定的提示来直接获取每个样本的评分,并根据这些评分进行样本选择。这种方法的优点是减少了高成本和耗时的人工注释。

DEITA(Liu等人,2024)使用Evol-Instruct方法来构建不同复杂度和质量的样本,训练社区模型作为更强的复杂度和质量评分器,然后设计了一个以分数为先的、考虑多样性的数据选择算法。

2.2 连续质量标签

其他研究采用更直接和模型特定的方法,通过利用样本对模型最终性能的影响来选择数据,这通常是连续且隐式的。例如,Instruction-Mining(Cao等人,2023)使用最小二乘法构建样本的4维指标表示与PFM模型的推理损失之间的映射,然后利用BLEND-SEARCH结合全局和局部优化进行有效的数据选择。

LESS(Xia等人,2024)则使用候选样本的梯度与特定任务数据集中的数据梯度的相似性来获取样本影响力,设计了一个数据选择算法,使用每个任务在验证集上的平均梯度作为锚点,与候选样本特征进行相似性计算,选择对所有任务都有改进的前5%的数据点。

通过这些方法,可以有效地从大量数据中筛选出对模型训练最有益的高质量数据,从而提高模型的性能并加速训练过程。

数据选择方法的比较

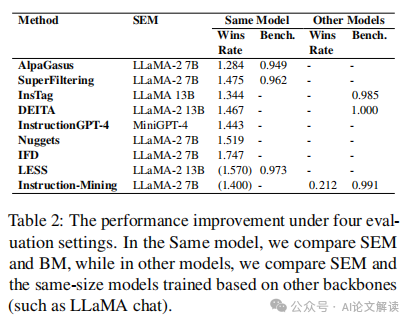

在大型语言模型(LLM)的微调过程中,选择合适的数据子集对于提高模型性能和加速训练过程至关重要。本章节将对现有的数据选择方法进行比较,特别关注选择器的效率和可行性两个方面。

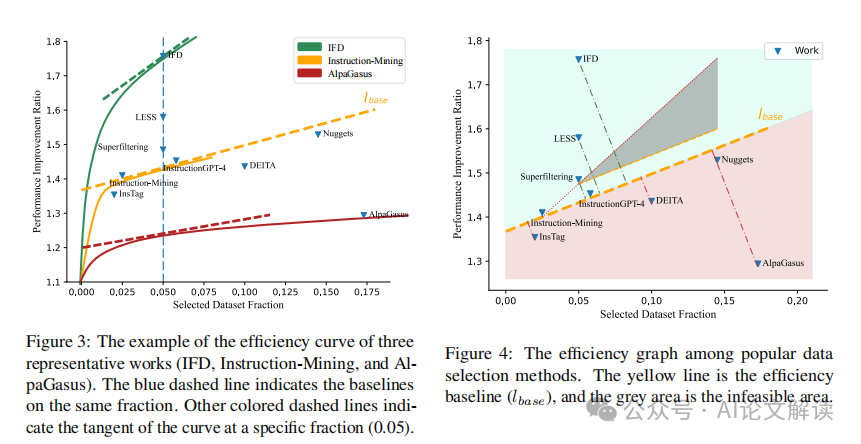

1. 选择器的效率

选择器的效率主要通过选择器能够准确选出高质量数据的能力来衡量。在众多研究中,我们发现目标更明确的数据选择方法通常具有更高的效率。例如,使用数据特定和模型特定的质量标签的方法往往能更准确地识别出对模型性能提升最大的数据。然而,这种方法的复杂性也相对较高,可能会降低其可行性。

为了量化比较不同方法的效率,我们设计了基于比率的效率指标(Performance Improvement Ratio, PIR)和选择数据集比例(Selected Dataset Fraction, SDF)。PIR 表示选择后的模型(SEM)与基线模型(BM)性能的比率,而 SDF 表示被选数据占原始候选数据集的比例。通过这两个指标,我们可以在散点图上直观地比较不同方法的效率。

此外,我们还引入了效率曲线假设,通过假设效率曲线呈对数形态,可以在相同的数据选择比例下比较不同方法的效率。这种方法允许我们在统一的框架下评估并直接比较不同的数据选择方法。

2. 选择器的可行性

选择器的可行性涉及到选择方法的实用性,包括其简单性和灵活性。简单性主要考虑选择过程的复杂性和方法的可重现性。例如,一些方法可能需要训练多个LLM模型或进行复杂的算法步骤,这可能会限制其在实际应用中的可行性。

灵活性则涉及到选择方法是否可以轻松地应用于不同的场景。这包括方法是否依赖于特定的PFM模型或数据集,以及是否容易扩展到使用不同的商业模型(如ChatGPT或GPT-4)。我们通过排名基于可行性的指标来评估现有方法的灵活性,这些指标包括模型自由度、数据集自由度和扩展性。

在综合考虑效率和可行性后,我们发现虽然一些方法在效率上表现出色,但可能因复杂性而在实际应用中受限。相反,一些简单但灵活的方法虽然效率不是最优的,但可能因其易于部署和适应性强而更受欢迎。

通过这种综合评估,我们可以更全面地理解不同数据选择方法的优势和局限,为未来的研究和应用提供指导。

面临的挑战与未来研究方向

1. 短期挑战

短期内,数据选择面临的主要挑战是如何为特定领域和多轮对话提供精确的数据选择解决方案。特定领域的数据选择需要能够针对模型在特定领域的短板进行优化,而不影响其他领域的性能。例如,现有的数据选择方法虽然在写作和角色扮演等领域表现出色,但在数学和逻辑推理等领域的改进却较为有限。此外,大多数现有的数据选择方法都集中在单轮对话上,因为这类数据的质量更容易衡量。然而,多轮对话数据的特点,如全局目标和对话的连贯性,还没有得到足够的关注。

2. 长期研究问题

从长远来看,数据选择研究需要解决的关键问题包括如何平衡性能和灵活性,以及如何找到统一而有效的数据质量衡量标准。目前的研究往往通过采用更精细的目标导向方法来提高选择效率,而不是寻找真正更有效的选择范式。这种方法虽然在效率上有所提高,但往往牺牲了灵活性,并可能引入外部信息噪声,影响选择的有效性。此外,现有的研究多从模型对数据的观察或数据选择对模型性能的影响出发,来衡量数据质量,而没有从数据集本身的质量分布出发。因此,探索一个能够统一衡量数据质量的有效指标,将是数据选择研究领域的一个基础问题。

总结:数据选择在微调大型语言模型中的作用及其发展趋势

1. 数据选择的重要性

数据选择是指从大规模候选数据集中筛选出最有利于模型学习的数据子集。这一过程对于构建高效的语言模型至关重要。通过有效的数据选择,可以确保模型训练集中于最具代表性和挑战性的样本,从而在实际应用中展现出更强的性能和更好的泛化能力。

2. 数据选择的方法发展

早期的数据选择方法多依赖于简单的随机抽样或者基于规则的筛选。然而,这些方法往往忽视了数据的内在质量和与模型性能的相关性。随着技术的进步,更多研究开始利用机器学习技术,通过模型预测的方式来评估数据质量,实现更为精准的数据选择。例如,一些研究通过分析数据对模型训练误差的贡献度来进行筛选,优先选择那些能够显著减少误差的数据。

3. 面临的挑战与发展趋势

尽管数据选择技术已取得了显著进展,但仍面临一些挑战。首先,如何定量评估数据质量仍然是一个难题。目前的方法大多依赖于模型的间接反馈,缺乏直接评估数据质量的客观标准。其次,数据选择算法的复杂性和计算成本也限制了其在大规模数据集上的应用。

展望未来,数据选择技术将朝着更加智能化和自动化的方向发展。一方面,借助深度学习等先进技术,可以进一步提高数据选择的准确性和效率。另一方面,结合多任务学习和迁移学习的方法,数据选择模型能够更好地适应不同的应用场景和需求,从而推动大型语言模型在更多领域的广泛应用。

本文转载自柏企科技圈,作者:柏企科技圈