谷歌调优MusicLM的秘密:用户偏好数据 原创

何谓MusicLM?

MusicLM是谷歌公司开发的文本到音乐人工智能中的旗舰产品,最初发布于2023年初。即使是在其基础版本阶段,它也代表着一个重大突破,并让音乐行业大吃一惊。然而,几周前,MusicLM进行了一次重要的更新。以下给出的是针对两个挑选的提示句子的并排比较情况:

Prompt: “Dance music with a melodic synth line and arpeggiation”:

中文意思:“带有旋律合成并伴有琶音的舞曲”:

- 老版本MusicLM:https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musiclm-7.wav

- 新版本MusicLM:https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musicrlhf-ru-7.wav

Prompt: “a nostalgic tune played by accordion band”中文意思:“手风琴乐队演奏的怀旧曲调”

- 老版本MusicLM:https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musiclm-27.wav

- 新版本MusicLM:https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musicrlhf-ru-27.wav

上述音乐质量的提高主要归因于谷歌研究公司的一篇新论文,题为《MusicRL: Aligning Music Generation to Human Preferenc\es》。显然,这次升级被认为意义重大;因此,他们决定重新命名该模型。然而,从底层实现来看,MusicRL在其关键架构上与MusicLM完全相同。唯一的区别在于:微调方式不同。

何谓微调?

当人们从头开始构建人工智能模型时,都是从零知识开始的,本质上是进行随机猜测。然后,该模型通过对数据进行训练来提取有用的模式,并随着训练的进行开始显示越来越智能的行为。这种方法的一个缺点是,从头开始训练需要大量数据。相比来说,微调则是使用现有模型并使其适应新任务,或者使其适应以不同的方式处理同一任务。因为模型已经学习了最重要的模式,所以所需的数据相对传统方案要少得多。

例如,原则上,任何人都可以从头开始训练像Mistral7B这样强大的开源LLM。即使产生非常有用的输出,也需要大量的数据。相反,如果公司使用现有的Mistral7B模型,并向其提供少量专有数据,就可以使其解决新的任务,无论是编写SQL查询这样的任务还是对于像电子邮件进行分类的任务。

关键是微调不会改变模型的基本结构。它只是稍微调整其内部逻辑,以便在特定任务上执行得更好。现在,让我们利用这些知识来了解谷歌是如何在用户数据基础上微调MusicLM的。

谷歌如何收集用户数据

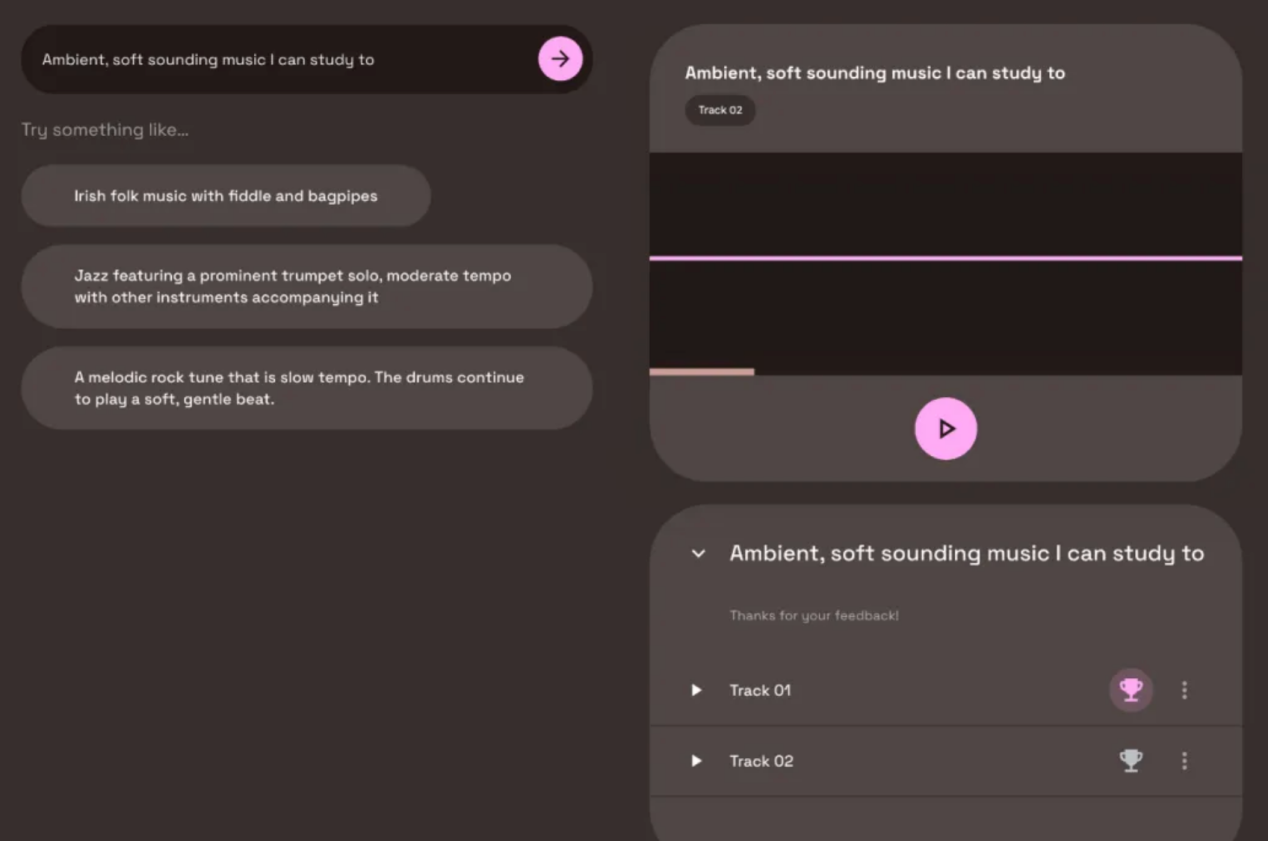

MusicLM论文发表几个月后,作为谷歌人工智能Test Kitchen项目的一部分,发布了一个公开演示版本。此版本中,用户可以免费试用文本到音乐的模型。然而,你可能知道这样一句话:如果产品是免费的,你就成为产品本身。不出所料,谷歌也不例外。在使用MusicLM的公开演示版本时,您偶尔会遇到两个生成的输出结果,并被要求说明您喜欢哪一个。通过这种方法,谷歌能够在几个月内收集到300000个用户偏好。

MusicLM公共游乐场中捕获的用户偏好评级示例(图片取自MusicRL论文:https://arxiv.org/pdf/2402.04229.pdf)

正如你从屏幕截图中看到的,用户没有被明确告知他们的偏好将用于机器学习。虽然这可能感觉不公平,但重要的是要注意,我们在互联网上的许多行为都被用于ML训练,无论是我们的谷歌搜索历史、我们的Instagram点赞,还是我们的私人Spotify播放列表。与这些相当私密和敏感的情况相比,MusicLM游乐场上的音乐偏好收集似乎微不足道。

Linkedin协作文章上的用户数据收集示例

值得注意的是,机器学习的用户数据收集一直在进行,通常不需要明确的同意。如果你在Linkedin上,你可能会被邀请为所谓的“合作文章”投稿。从本质上讲,用户被邀请就其专业领域的问题提供提示。下图给出的是一篇关于如何写一首成功的民歌(我不知道我需要什么)的合作文章(https://www.linkedin.com/advice/3/how-can-you-write-successful-folk-songs-skills-music-industry-w4i5e?trk=cah1)的例子。

一篇关于歌曲创作的合作文章的标题(右边是我被要求捐款以获得“顶级声音”徽章)

激励用户投稿,为他们赢得平台上的“顶级声音”徽章。然而,我的印象是,没有人真正读过这些文章。这让我相信,微软(Linkedin的所有者)正在使用这数千个问答对来训练这些数据的专家人工智能系统。如果我的怀疑是准确的,那么我会发现这个例子比谷歌向用户询问他们最喜欢的曲目更有问题。

废话少讲,还是回到我们讨论的MusicLM!

谷歌如何利用这些用户数据

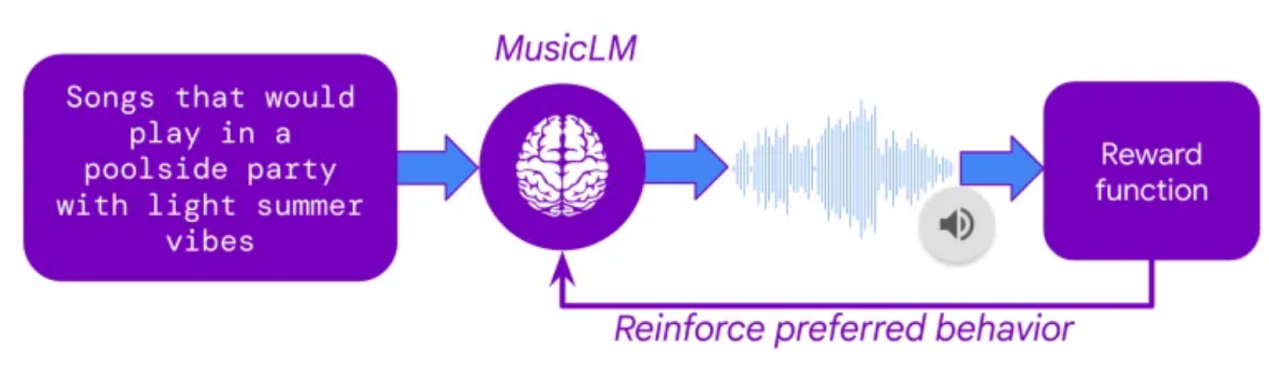

接下来的一个问题是,谷歌是如何利用这一庞大的用户偏好集合来微调MusicLM的。其实,秘密在于一种名为“从人类反馈中强化学习(RLHF)”的技术,这是ChatGPT在2022年的关键突破技术之一。在RLHF中,人类偏好被用来训练一个人工智能模型,该模型学习模仿人类偏好决策,从而产生一个人工评分器。一旦这个所谓的奖励模型被训练出来,它就可以接受任何两个曲目,并预测哪一个曲目最有可能被人类评分者所偏好。

通过建立奖励模型,人们可以对MusicLM进行微调,以最大限度地提高其输出的预测用户偏好。这意味着,文本到音乐模型可以生成数千首曲目,而每首曲目都能够从奖励模型中获得评级。通过对模型权重的迭代自适应,MusicLM可学会生成相当于人工评分者“喜欢”的音乐。

从人类反馈中强化学习(RLHF)作出的解释(图片取自MusicRL论文:https://arxiv.org/abs/2402.04229)

除了对用户偏好进行微调外,MusicLM还对另外两个标准进行了微调:

1.提示遵从

使用谷歌专有的文本到音频嵌入模型MuLan(https://research.google/pubs/mulan-a-joint-embedding-of-music-audio-and-natural-language/)可以计算用户提示和生成的音频之间的相似性。在微调过程中,这种遵从性得分被最大化。

2.音频质量

谷歌在用户数据上训练了另一个奖励模型,以评估其生成输出的主观音频的质量。这些用户数据似乎是在单独的调查中收集的,而不是在MusicLM公开展示的版本中。

新的MusicLM有多好?

新出现的经过微调的模型大概率优于旧的MusicLM,有兴趣的读者可以听一下其展示页面(https://google-research.github.io/seanet/musiclm/rlhf/)上提供的示例声音。当然,一个挑选出的公开展示作品可能是骗人的,因为创作者会被加以激励以便展示他们的新模型看起来尽可能好。真心希望我们大家能很快在公共场所测试使用MusicRL。

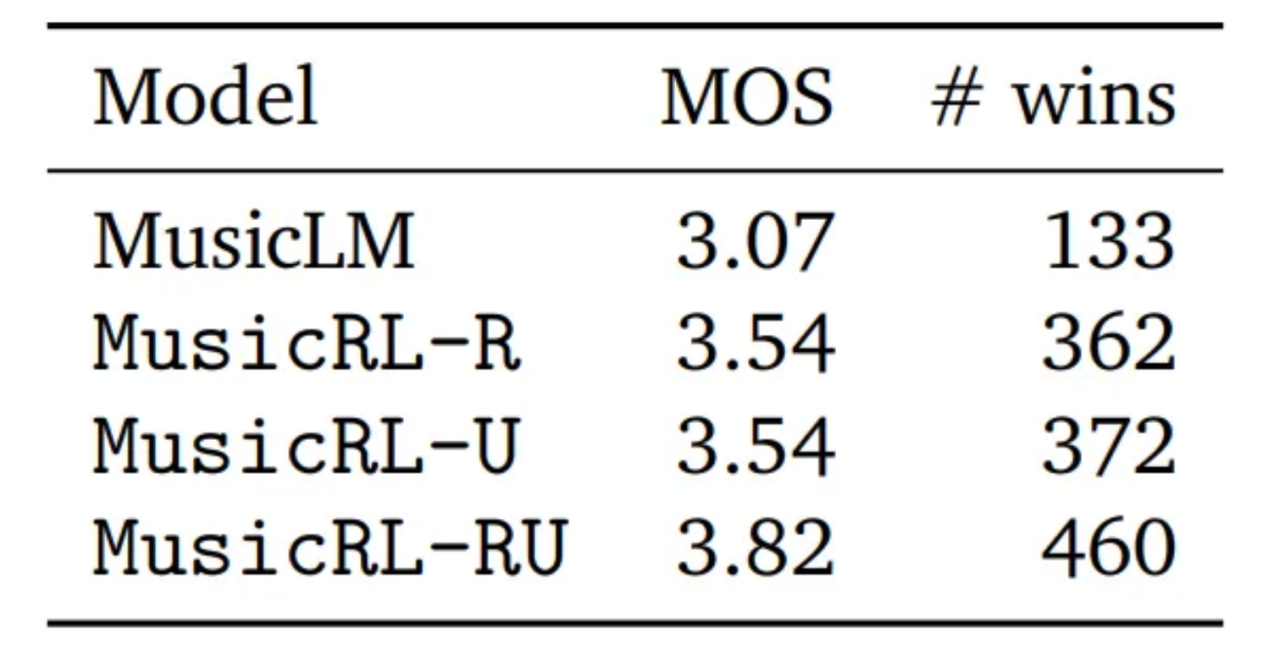

然而,论文中也提供了对于主观质量的定量评估。为此,谷歌进行了一项研究,要求用户为同一提示生成的两首曲目加以比较,每条曲目的得分范围是从1到5。将这个指标与平均意见得分(MOS)结合使用,我们不仅可以比较每个模型的直接比较获胜次数,还可以计算平均意见得分(MOS)。

定量基准指标比较结果(图片同样取自上述MusicRL论文)

上述图片中,MusicLM表示原始的MusicLM模型。MusicRL-R仅针对音频质量和提示遵从方面进行了微调。MusicRL-U仅根据人类反馈(奖励模型)进行微调。最后,MusicRL RU在所有三个目标上都进行了微调。毫不奇怪,MusicRL RU在直接比较和平均收视率方面击败了所有其他模型。

该论文还报道称,完全微调的MusicRL-RU模型在87%的直接比较中击败了MusicLM模型。通过分析MusicRL-R和MusicRL-RU之间的直接比较,可以看出RLHF的重要性。在这里,后者的胜率为66%,比较有把握地超过了竞争对手。

这意味着什么?

尽管输出质量的差异在质量和数量上都很明显,但在大多数情况下,新的MusicLM与人类水平的输出仍然相距甚远。即使在公共演示页面上,许多生成的输出曲目听起来也很奇怪,有节奏,无法捕捉到从提示中输入的关键元素,或者声音不自然。

在我看来,上面这篇论文仍然意义重大,因为它是第一次尝试将RLHF用于音乐生成。RLHF在文本生成中已经被广泛使用了一年多。但为什么花了这么长时间?我怀疑收集用户反馈和微调模型的成本相当高。谷歌可能发布公开的MusicLM演示的主要目的是收集用户反馈。显然,这是一个明智的举动,这会使他们比Meta公司有优势,因为Meta公司有同样强大的模型,但没有提供开放的平台来收集用户数据。

总的来说,谷歌利用了从ChatGPT借鉴来的经过验证的微调方法,使自己在竞争中领先。虽然借助于RLHF技术其改进版本的新的MusicLM仍然没有达到人类水平的质量,但谷歌现在可以维护和更新其奖励模型,通过相同的微调程序改进未来几代的文本到音乐模型。

看看Meta或Stability AI等其他竞争对手是否以及何时会迎头赶上,这将是一件有趣的事情。对于我们这些用户来说,这一切都是个好消息!我们会拥有免费的公开演示版本和更强大的模型。

对于音乐家来说,AI目前的发展步伐可能会对他们有点威胁——这是有充分理由的。我希望在未来的1-3年里看到人类水平的文本到音乐的一代模型。我指的是文本到音乐人工智能方面的模型,它在制作音乐方面的能力至少与ChatGPT发布时编写文本的能力一样。音乐家必须了解人工智能,以及它如何在日常工作中为他们提供支持。随着音乐行业再次被颠覆,好奇心和灵活性将是成功的首要关键。

对音乐AI感兴趣?

如果你喜欢这篇文章,你可能想看看我撰写的其他文章:

- “3 Music AI Breakthroughs to Expect in 2024”,我的Medium博客(https://medium.com/towards-data-science/3-music-ai-breakthroughs-to-expect-in-2024-2d945ae6b5fd)。

- “Where is Generative AI Music Now?”。YouTube采访我的SyncMusic(https://www.youtube.com/watch?v=OLJi1b-B0i0)。

- “MusicLM — Has Google Solved AI Music Generation?”,我的Medium博客(https://medium.com/towards-data-science/musiclm-has-google-solved-ai-music-generation-c6859e76bc3c)。

您也可以在Linkedin上关注我(https://www.linkedin.com/in/max-hilsdorf/),随时了解音乐人工智能的最新论文和趋势。

参考文献

- Agostinelli et al., 2023. MusicLM: Generating Music From Text. https://arxiv.org/abs/2301.11325。

- Cideron et al., 2024. MusicRL: Aligning Music Generation to Human Preferences. https://arxiv.org/abs/2402.04229。

译者介绍

朱先忠,51CTO社区编辑,51CTO专家博客、讲师,潍坊一所高校计算机教师,自由编程界老兵一枚。

原文标题:How Google Used Your Data to Improve their Music AI,作者:Max Hilsdorf

链接:https://towardsdatascience.com/how-google-used-your-data-to-improve-their-music-ai-8948a1e85491。