医学领域大模型与多模态大模型的综合调查

摘要

自ChatGPT和GPT-4发布以来,大型语言模型(LLMs)和多模态大型语言模型(MLLMs)因其在理解、推理和生成方面的卓越能力而受到广泛关注,为将人工智能整合到医学中引入了变革性范式。本调查全面概述了LLMs和MLLMs在医学中的发展、原理、应用场景、挑战和未来方向。具体而言,它首先考察了范式转变,追溯了从传统模型到LLMs和MLLMs的转变,并强调了这些LLMs和MLLMs在医学应用中的独特优势。接下来,调查回顾了现有的医学LLMs和MLLMs,以清晰系统的方式提供了关于其构建和评估的详细指导。随后,为了强调LLMs和MLLMs在医疗保健中的重大价值,调查探讨了该领域的五个有前景的应用。最终,该调查探讨了医学大型语言模型(LLMs)和多模态大语言模型(MLLMs)所面临的挑战,并提出了将其整合进医学领域的实用策略和未来方向。总之,本调查全面分析了医学LLMs和MLLMs的技术方法和实际临床应用,旨在弥合这些先进技术与临床实践之间的差距,从而促进下一代智能医疗系统的演变。

核心速览

研究背景

- 研究问题:这篇文章要解决的问题是如何利用大型语言模型(LLMs)和多模态大型语言模型(MLLMs)在医学领域的应用和发展。LLMs和MLLMs在理解、推理和生成方面表现出色,能够显著影响医学领域并加速人工智能与医学的融合。

- 研究难点:该问题的研究难点包括:获取高质量的医学数据、计算资源需求高、模型的多维度评估(如指令遵循能力、安全性和伦理问题)、以及模型的潜在应用场景不明确等。

- 相关工作:该问题的研究相关工作包括传统的自然语言处理模型、基于Transformer的预训练模型(如GPT系列和BERT系列)、以及多模态模型(如Flamingo)。这些模型在医学领域的应用已经取得了一定的进展,但仍面临诸多挑战。

研究方法

这篇论文提出了通过详细的系统综述来探讨LLMs和MLLMs在医学领域的应用和发展。具体来说,

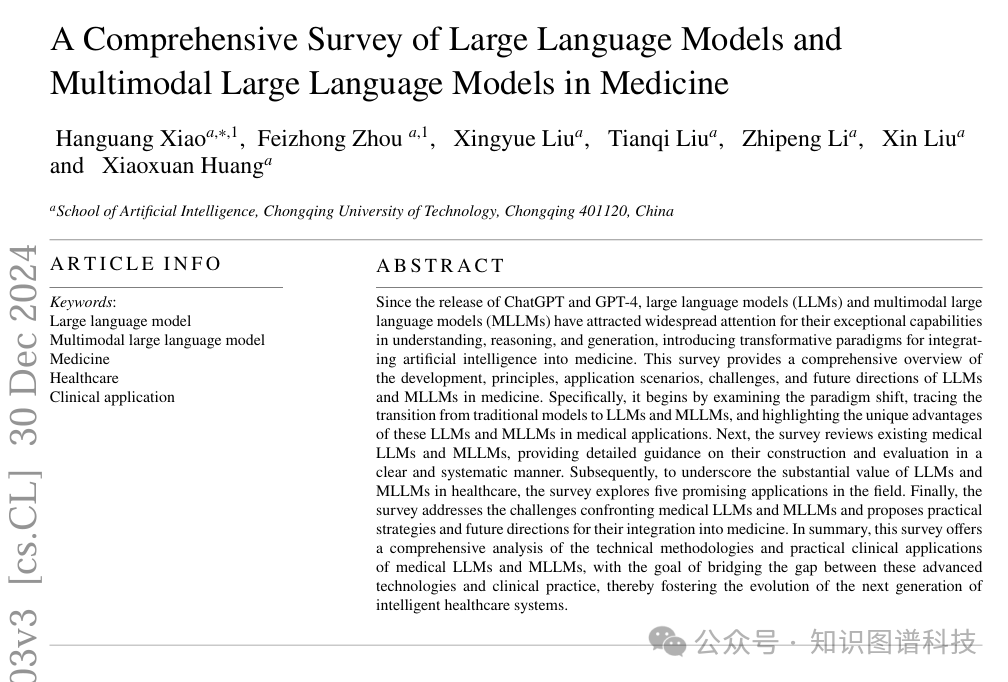

- 范式转变:首先,论文回顾了LLMs和MLLMs的发展范式转变,从监督学习到无监督预训练和微调,再到无监督预训练和提示,最后到文本到多模态的转变。

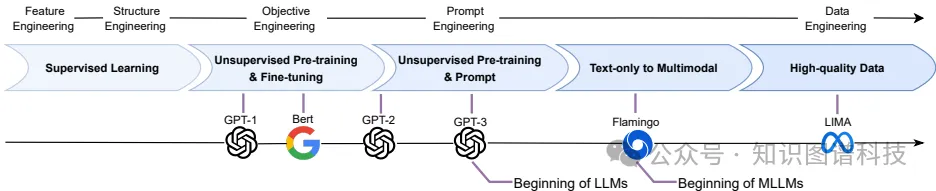

- 现有医学LLMs和MLLMs的综述:论文详细梳理了现有的医学LLMs和MLLMs,总结了它们的结构特征。

- 数据集和方法:论文收集了适合训练医学LLMs和MLLMs的数据集,并详细阐述了训练和评估这些模型的方法。

- 应用场景分析:论文总结了LLMs和MLLMs在临床实践中的应用,并分析了当前的局限性和潜在解决方案。

- 未来发展方向:论文探讨了医学LLMs和MLLLMs的未来发展方向,提供了前瞻性的分析。

结果与分析

- 发展轨迹:论文总结了LLMs和MLLMs的发展轨迹,强调了从特征工程到结构工程、目标工程和提示工程的逐步转变。

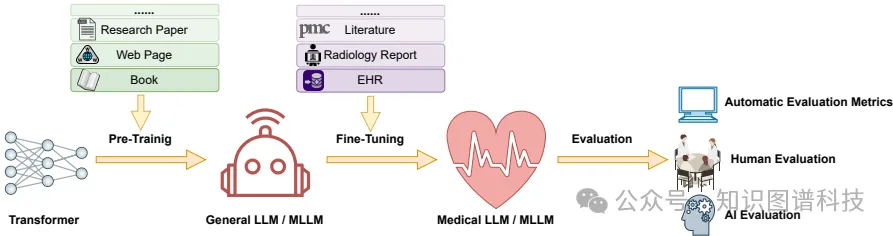

- 模型结构:论文详细介绍了现有的医学LLMs和MLLMs的结构,包括编码器-解码器模型、视觉编码器和模态对齐模块。

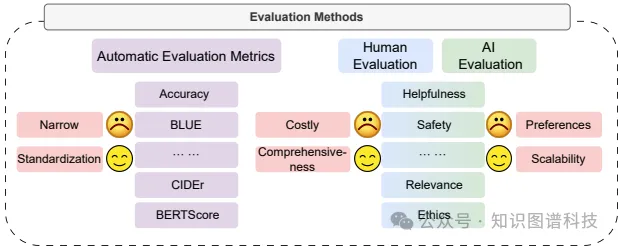

- 训练和评估方法:论文总结了六种微调方法(如持续预训练、指令微调和监督微调)和三种评估方法(自动评估指标、人类评估和AI评估),并分析了各自的优缺点。

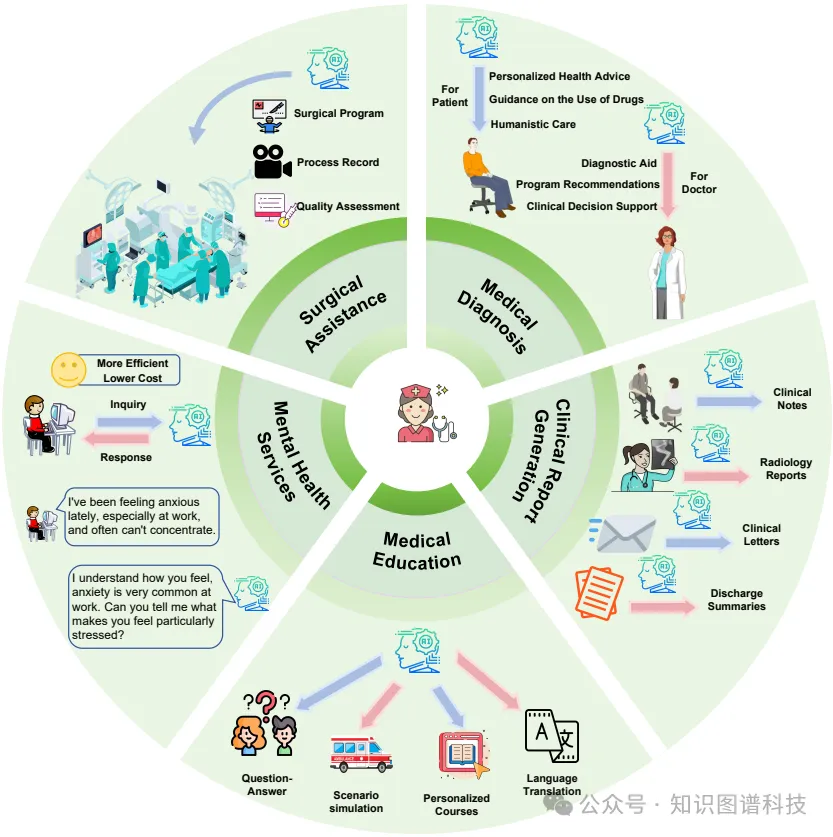

- 应用场景:论文总结了LLMs和MLLMs在医学诊断、临床报告生成、医学教育、心理健康服务和手术辅助等方面的应用,展示了它们在医疗领域的广泛应用潜力。

总体结论

这篇论文全面分析了医学LLMs和MLLMs的背景、原理、应用、挑战和未来发展方向。通过系统的综述,论文旨在为研究人员提供有价值的参考,推动医学LLMs和MLLMs在临床实践中的应用和发展。论文的贡献包括:

- 提供了医学LLMs和MLLMs的全面概述,从发展背景到架构框架,再到现有模型的详细分析和比较。

- 系统地阐述了医学LLMs和MLLMs的完整过程,从训练到评估,涵盖了微调方法、评估策略和相关医学数据集。

- 总结了医学LLMs和MLLLMs在临床实践中的应用、挑战和潜在解决方案,并提供了前瞻性的分析。

论文评价

优点与创新

- 全面性:论文提供了对医学领域大型语言模型(LLMs)和多模态大型语言模型(MLLMs)的全面概述,从发展背景、架构框架到训练和评估方法,再到临床应用和挑战。

- 系统性:论文系统地介绍了医学LLMs和MLLMs的构建和评估过程,涵盖了从数据选择、微调方法到评估策略的各个方面。

- 创新性:论文总结了医学LLMs和MLLMs在临床实践中的应用,并分析了当前的限制和潜在解决方案,提供了前瞻性的分析。

- 详细性:论文详细介绍了现有的医学LLMs和MLLMs,包括它们的结构特征、训练方法和评估指标,为研究人员提供了详细的指导。

- 多模态集成:论文强调了多模态MLLMs在医学领域的重要性,探讨了如何通过集成多种模态信息来增强临床决策支持、疾病诊断和治疗规划。

不足与反思

- 数据隐私和安全:医学LLMs和MLLMs的训练需要大量的医疗数据,这些数据的获取和标注涉及隐私和安全问题,论文提出了数据去标识化和差分隐私等方法来解决这些问题,但仍需进一步研究和实践。

- 模型泛化能力:尽管LLMs和MLLMs在多个任务上表现出色,但在面对新的医疗知识和概念时,模型的泛化能力仍需提升,以防止出现误导性输出。

- 模型的可解释性和透明度:医学LLMs和MLLLMs的决策过程往往缺乏透明度和可解释性,这对于医疗应用尤为重要。论文建议使用专家模型和提示增强技术来提高模型的可解释性,但这一领域仍有待深入研究。

- 伦理和偏见问题:医学LLMs和MLLLMs可能会从训练数据中学到偏见和有毒内容,论文提出了筛选高质量数据和使用反偏见技术来缓解这些问题,但实际操作中仍面临挑战。

- 未来方向:论文提出了边缘部署、医疗代理和通用医疗助手等未来发展方向,但具体实现过程中仍需解决计算资源限制、模型复杂性和实时交互等问题。

关键问题及回答

问题1:论文中提到的医学LLMs和MLLMs的主要结构有哪些?它们各自的特点是什么?

- 编码器-解码器模型:这类模型结合了编码器和解码器的优点,适用于需要同时处理输入和输出任务的场景。例如,T5和GLM模型。

- 视觉编码器:这类模型通过视觉编码器将视觉信息转换为文本可以理解的格式。常见的视觉编码器包括ResNet、ViT和CLIP-ViT。

- LLM骨干:作为MLLMs的认知引擎,LLM骨干包含了大量的参数,负责文本交互、上下文感知和推理。常用的LLM骨干包括LLaMA系列和GPT系列。

- 模态对齐模块:这类模块用于桥接视觉和文本模态之间的信息差异,使MLLMs能够理解和解释视觉信息。常见的模态对齐方法包括GATED XATTN-DENSE Layers、Query-Based方法、Projection-Based方法和Prompt Augmentation。

这些结构共同构成了MLLMs的核心框架,使其能够在多模态任务中表现出色。

问题2:论文中提到的六种微调方法各自的特点和应用场景是什么?

- 持续预训练(CPT):在大规模医学数据上进行预训练,注入医学知识。适用于需要广泛医学知识的场景。

- 指令微调(IFT):使用指令数据集进行微调,提高模型的指令遵循能力和零样本性能。适用于需要理解和执行人类指令的场景。

- 监督微调(SFT):在特定任务的标注数据上进行微调,提高模型在该任务上的性能。适用于需要针对特定任务进行优化的场景。

- 人类反馈强化学习(RLHF):通过收集人类反馈并使用强化学习进行模型优化,适用于需要高度符合人类偏好的场景。

- AI反馈强化学习(RLAIF):通过AI反馈进行模型优化,无需人工标注,适用于成本敏感且需要快速迭代的场景。

- 直接偏好优化(DPO):通过直接优化模型以符合人类偏好,避免复杂的奖励模型,适用于需要高效且稳定的模型对齐的场景。

这些微调方法各有优劣,研究人员和开发者可以根据具体需求和资源选择合适的方法。

问题3:论文中提到的医学LLMs和MLLLMs在医学诊断、临床报告生成、医学教育和心理健康服务等方面的应用潜力如何?

- 医学诊断:LLMs和MLLLMs能够处理和分析医学文本和图像,生成诊断结果和建议。例如,Med-PaLM 2在美国医学执照考试(USMLE)中得分超过86%,达到了专家水平。

- 临床报告生成:这些模型能够自动生成详细的医疗报告和总结,减轻医生的工作负担。例如,miniGPT-Med在生成医疗报告方面表现出色,准确率超过了现有模型19%。

- 医学教育:LLMs和MLLLMs可以模拟医疗场景,提供个性化学习计划和评估,帮助学生更好地掌握医学知识和技能。例如,Khanmigo和Duolingo平台已经集成了GPT-4,用于增强在线教学。

- 心理健康服务:基于LLM的聊天机器人可以提供24/7的心理咨询服务,降低成本并扩大服务范围。例如,ChatCounselor是一个用于心理健康支持的大型语言模型。

总体而言,LLMs和MLLLMs在医学领域的应用潜力巨大,能够显著提高医疗服务的效率和质量,但也面临一些挑战,如数据隐私、模型偏见和安全性等问题。

本文转载自 知识图谱科技,作者: KGGPT