贾佳亚团队新作MagicMirror:生成身份一致且高质量个性化视频,效果惊艳!

文章链接:https://arxiv.org/pdf/2501.03931

项目链接:https://julianjuaner.github.io/projects/MagicMirror/

亮点直击

- 提出了Magic Mirror,这是一种无需微调的新型框架,用于生成身份一致性的视频;

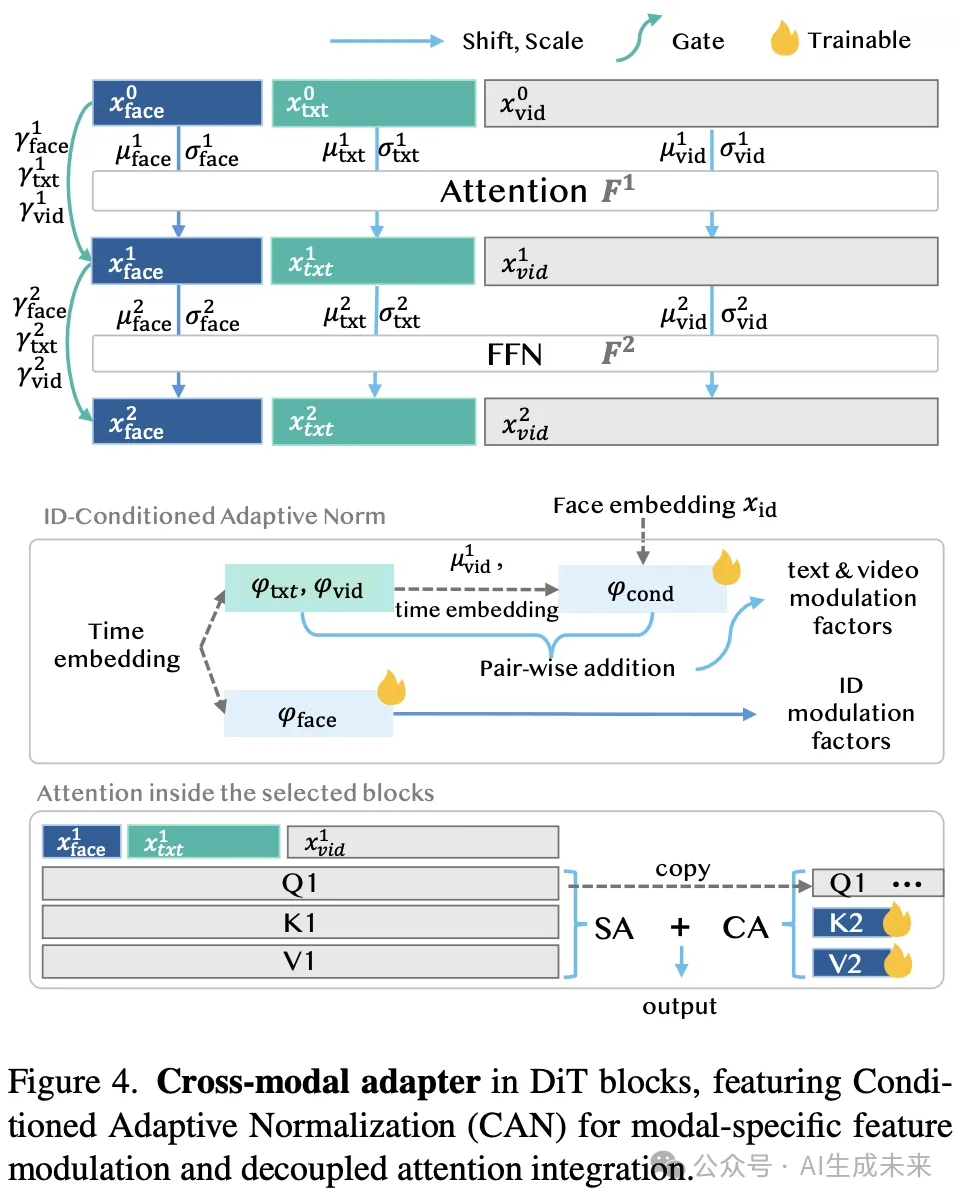

- 设计了一种轻量级适配器,结合条件自适应归一化,实现面部嵌入在全注意力扩散Transformer架构中的有效融合;

- 开发了一种数据集构建方法,通过合成数据生成和渐进式训练策略相结合,解决个性化视频生成中的数据稀缺问题。

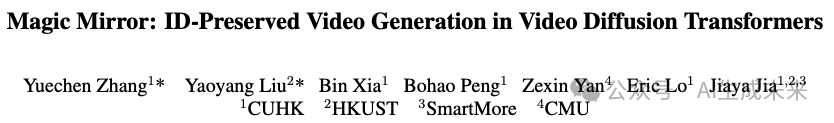

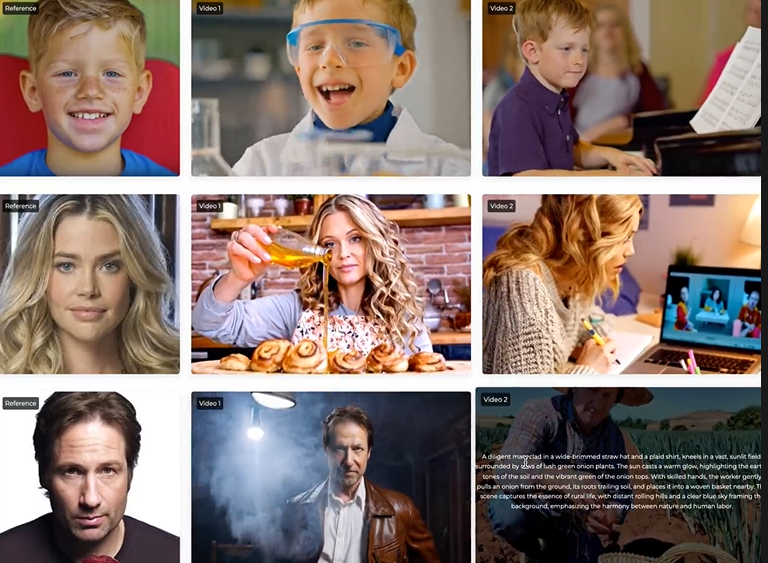

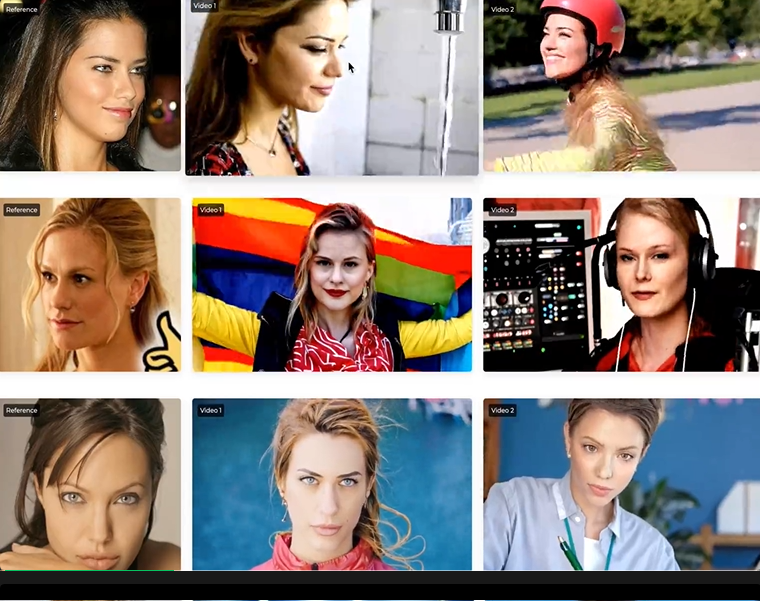

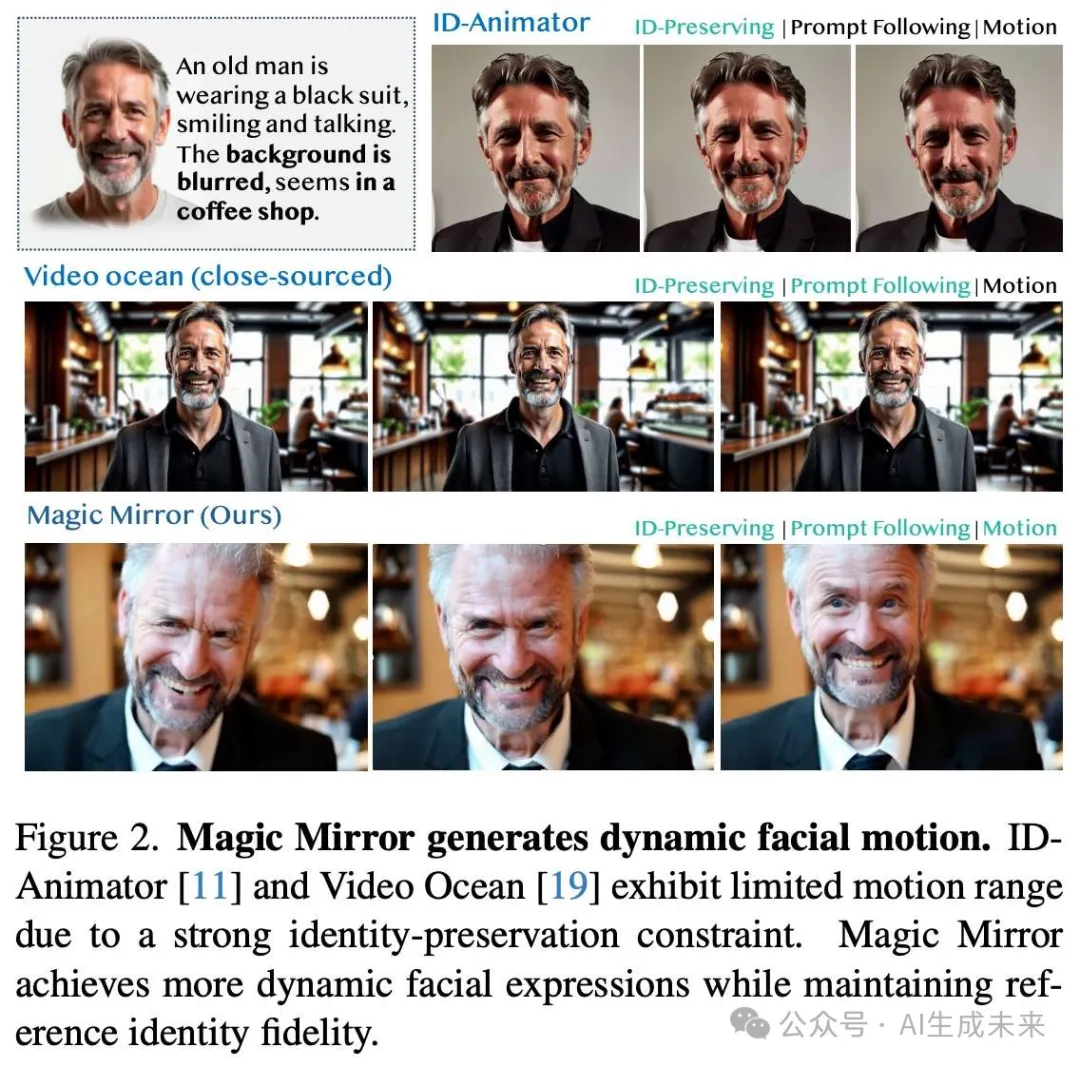

效果速览

总结速览

解决的问题

- 当前视频生成方法在身份(ID)一致性和自然动态性之间难以平衡:

- 现有方法需要针对特定人物进行微调,或在生成动态内容时无法保持身份一致性。

- 多数方法生成的视频动态性不足,仅实现静态的“复制粘贴”。

- 两阶段方法(图像个性化+图像到视频生成)在长序列生成中缺乏稳定性。

- 现有视频生成模型(如全注意力的Video DiT)在文本-视频对齐优化中牺牲了空间保真度,导致细粒度身份特征难以保留。

- 高质量、身份一致的图像-视频训练数据稀缺。

提出的方案

- 提出Magic Mirror单阶段框架,用于生成高质量、身份一致且动态自然的视频。

- 引入三个关键组件:

- 利用身份一致的合成数据进行初步训练。

- 在视频数据上进行细化训练,确保时序一致性。

- 集成到CogVideoX框架中。

- 采用条件自适应归一化(CAN),高效融合身份信息。

- 双分支面部特征提取器:同时捕捉高层次身份特征和参考特定的结构信息。

- 轻量级跨模态适配器:

- 两阶段训练策略:

应用的技术

- 构建于Video Diffusion Transformer(Video DiT)之上,优化动态视频生成。

- 条件自适应归一化(CAN)模块:

- 融合身份条件,提供注意力引导和特征分布引导。

- 数据合成策略:

- 利用身份保留模型生成高质量图像-视频对。

- 通过渐进式学习方法,先进行图像预训练,再进行视频微调。

- 构建人类中心的视频生成测试集,用于评价生成质量和一致性。

达到的效果

- 在身份一致性和自然动态性之间取得良好平衡:

- 动态视频生成效果优于现有方法。

- 在多项指标上表现优越,包括VBench等基准测试。

- 通过无需人物特定微调的方法,实现个性化视频生成:

- 保持面部一致性的同时,生成丰富的动态内容。

- 低参数开销的同时实现高质量生成:

- 为数字化创作提供更多个性化、动态化的表达方式。

Magic Mirror

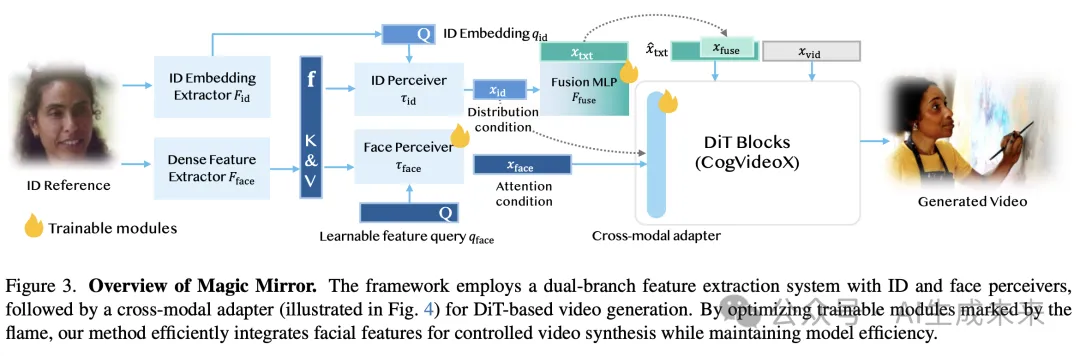

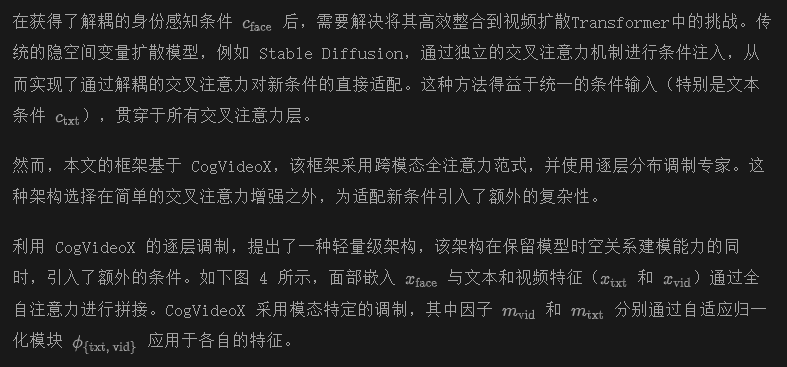

Magic Mirror 的概览如下图 3 所示。该双分支框架从一个或多个参考图像r 中提取面部身份特征。这些嵌入随后通过增强了轻量级跨模态适配器的 DiT 主干进行处理,并结合条件自适应归一化。该架构使 Magic Mirror 能够生成身份一致的文本到视频输出。

面部特征解耦提取

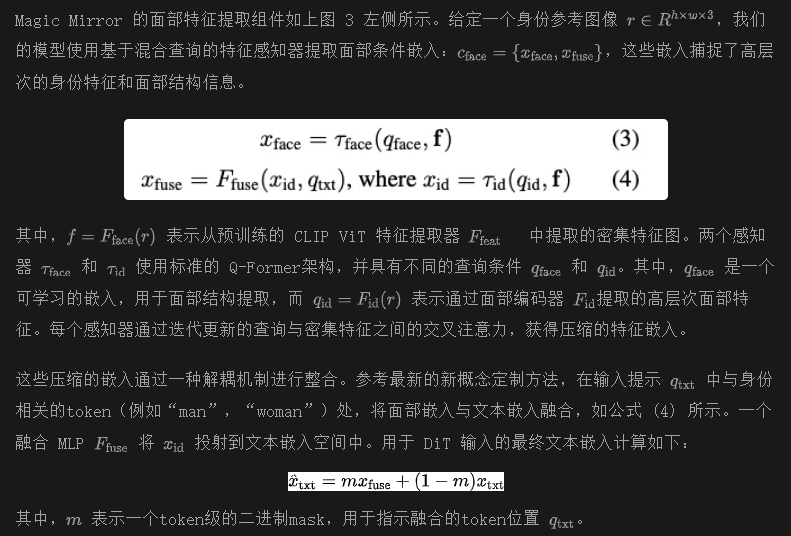

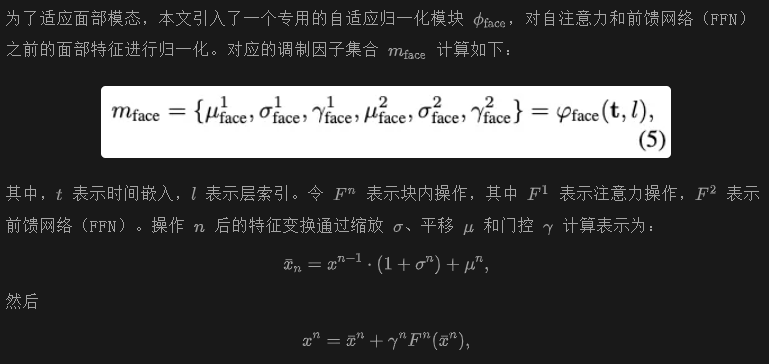

条件自适应归一化

其中,为简洁起见,省略了模态特定的下标。

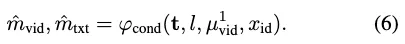

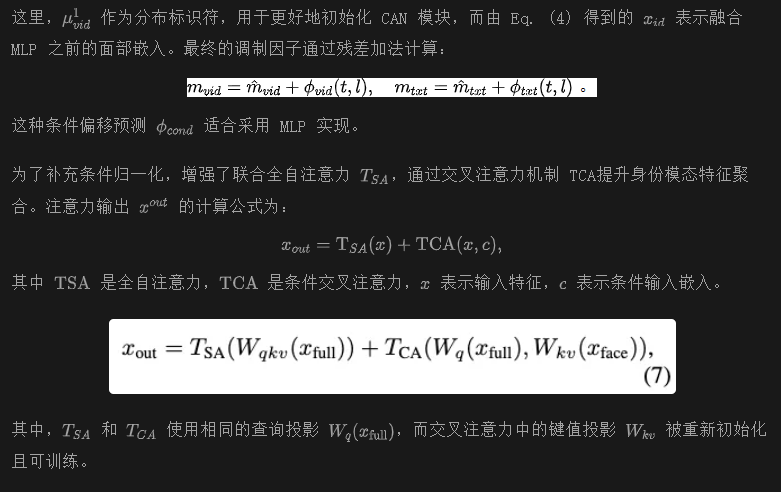

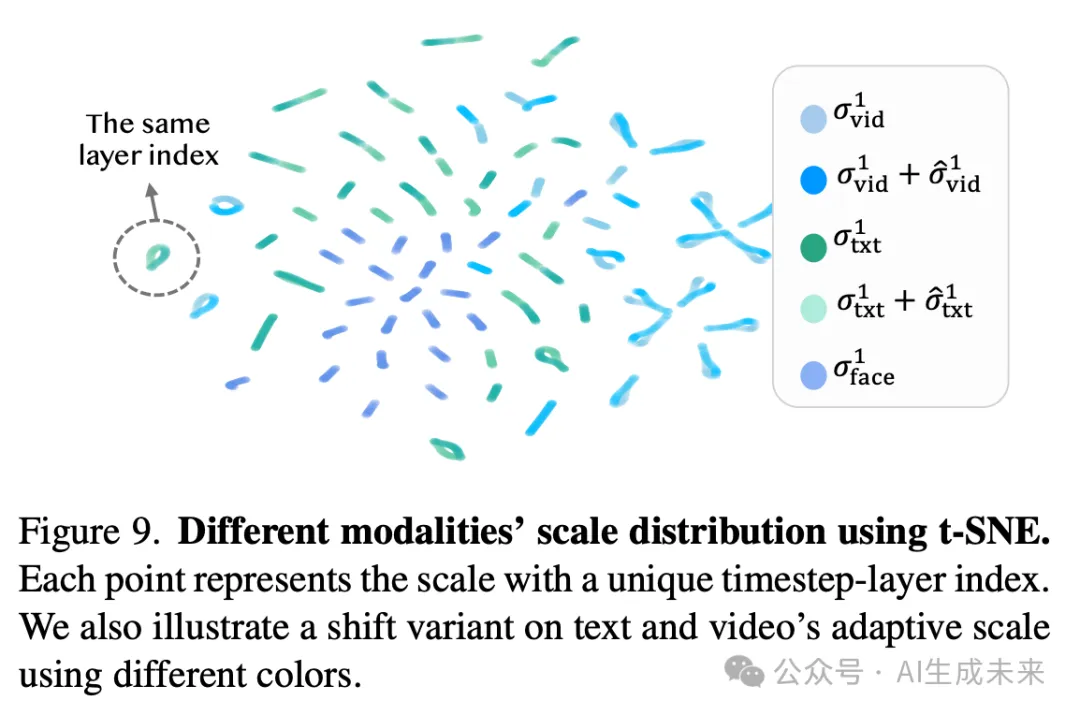

此外,为了增强特定参考身份(ID)的文本和视频隐空间变量的分布学习能力,引入了条件自适应归一化(CAN),其灵感来自类条件的 DiT 和 StyleGAN 的条件控制方法。CAN 为视频和文本模态预测分布偏移。

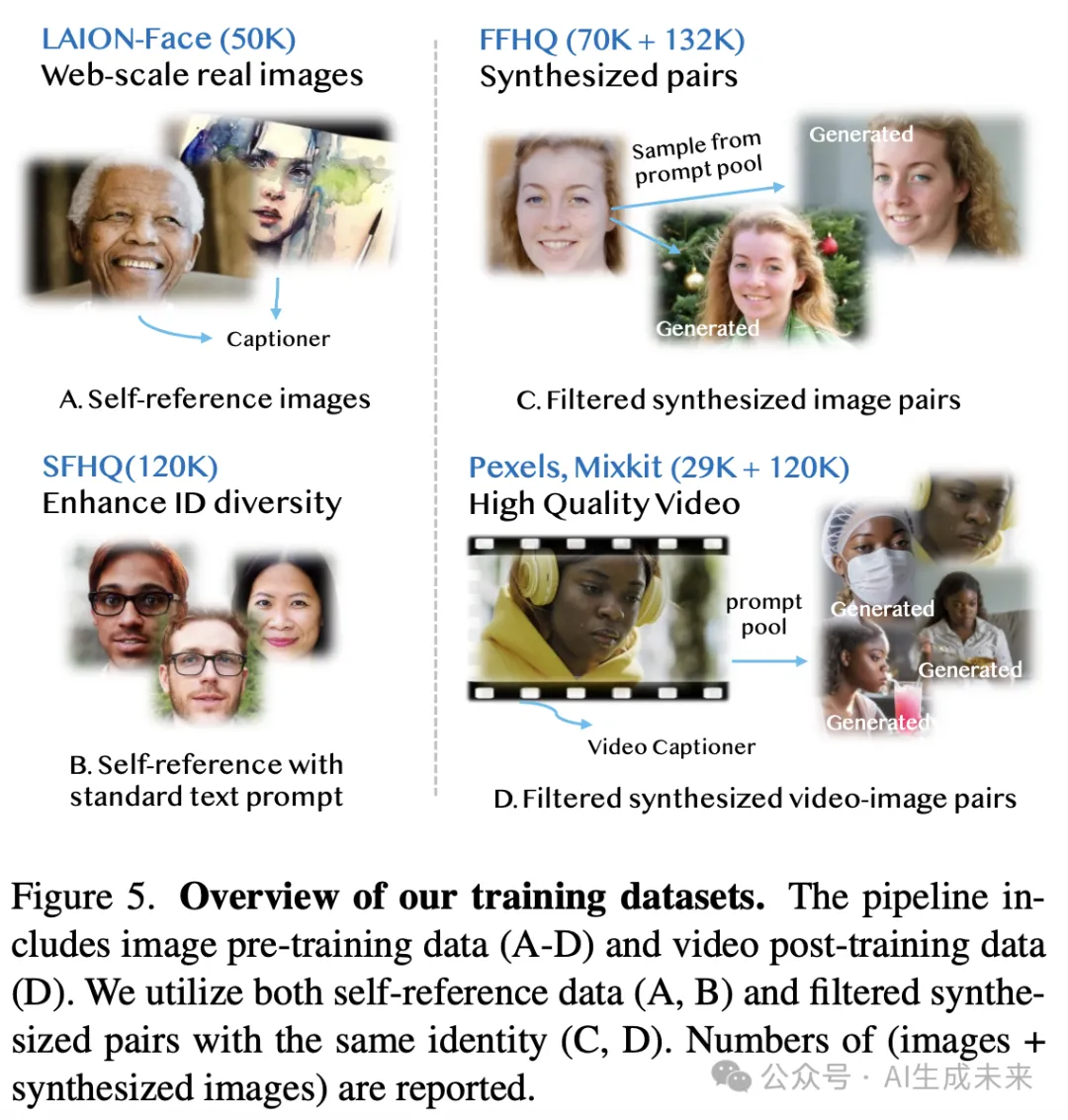

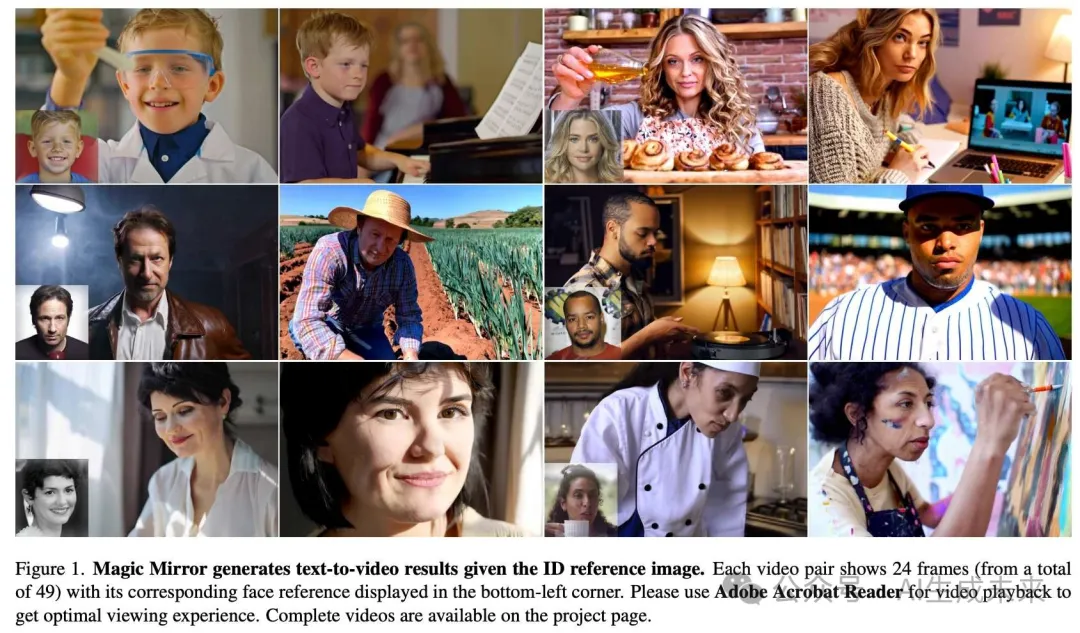

数据与训练

与诸如 Magic-Me 之类的微调方法相比,训练一个零样本定制适配器面临着独特的数据挑战。我们模型的全注意力架构不可分割地结合了空间和时间组件,因此需要采用两阶段训练策略。如下图 5 所示,首先在多样性和高质量数据集上训练,以培养稳健的身份保持能力。

渐进式训练pipeline利用多样化的数据集来增强模型性能,特别是在身份保持方面。对于图像预训练,首先使用 LAION-Face 数据集,该数据集包含大规模的网络真实图像,为生成自参考图像提供了丰富的资源。为了进一步增加身份的多样性,使用了 SFHQ 数据集,该数据集应用了标准文本提示的自参考技术。为了防止过拟合并促进生成多样化的脸部-头部运动,以 FFHQ 数据集为基础。从一个人像描述提示池中随机抽取文本提示,并使用 PhotoMaker-V2 生成身份条件的图像对,通过精心的筛选确保身份的相似性和多样性。

对于视频后训练,利用了高质量的 Pexels 和 Mixkit 数据集,以及从网络自采的小规模视频集合。同样地,与每个关键帧的面部参考对应的合成图像数据被生成为参考。组合数据集为模型在图像和视频上的训练提供了丰富的视觉内容。

目标函数结合了身份感知和通用去噪损失:

实验

实现细节

评估与比较将本文提出的方法与最先进的身份一致视频生成模型 ID-Animator 以及领先的图像到视频 (I2V) 框架(包括 DynamiCrafter、CogVideoX和 EasyAnimate)进行了对比评估。评估中使用了标准化的视频生成评测工具 VBench,以衡量运动质量和文本-运动对齐性能。对于身份保持,采用面部识别嵌入相似度 和面部运动指标进行评估。

评估数据集包括来自 VBench 的 40 个单角色提示(确保人口统计学的多样性)以及 40 个特定动作提示用于运动评估。身份参考从 PubFig 数据集中的 50 个面部身份中抽取,每个身份生成 4 个基于不同提示的个性化视频。

定量评估

定量结果总结在下表1中。使用VBench和EvalCrafter的通用指标评估生成的视频,包括:

- 动态度:衡量生成视频中动作的程度。

- 文本提示一致性:评估与给定文本描述的一致性。

- Inception Score (IS):评估生成视频内容的质量和多样性。

身份保持

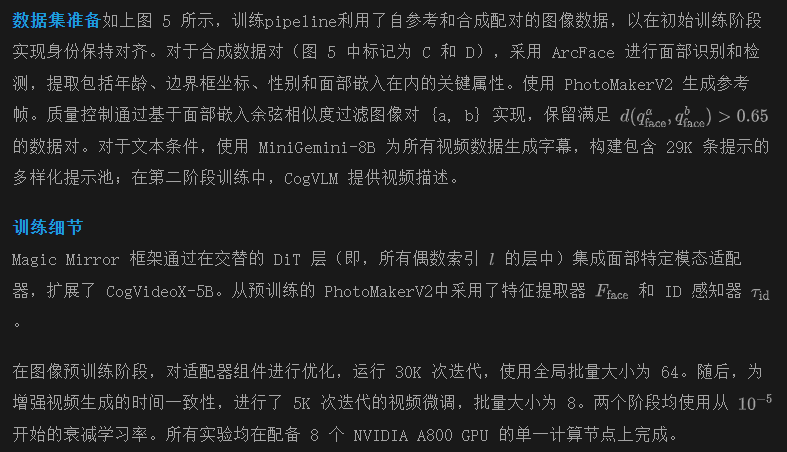

对于身份保持,引入了平均相似度,它评估生成的面部与每个身份参考图像的平均相似度之间的距离。此方法避免了通过简单的复制粘贴策略获得人为的高分,如下图2所示。

面部运动指标面部运动使用两个指标进行评估:

- FMref:衡量生成面部与参考面部之间的相对距离。

- FMinter:评估连续帧之间的距离。

定性评估

除了下图1中展示的示例外,下图6中展示了比较结果。与传统的CogVideoX推理方法相比,本文的方法保持了较高的文本一致性、运动动态和视频质量。与现有的图像到视频方法相比,Magic Mirror展示了在各帧之间更好的身份一致性,同时保持了自然的运动。本文的方法还在动态范围和文本对齐方面优于ID-Animator,后者在运动变化和提示遵循方面存在一定的局限性。

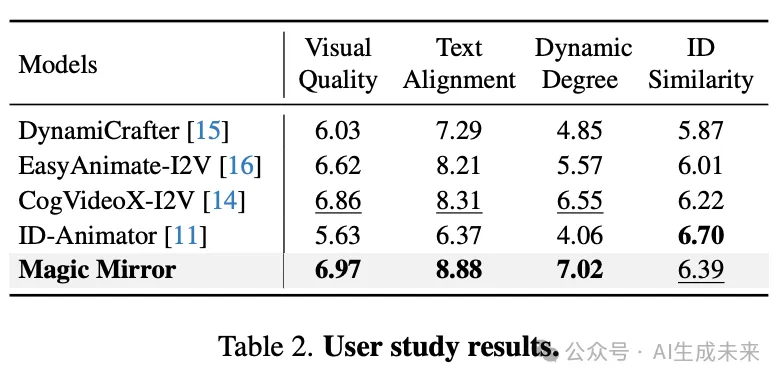

为了补充定量指标,进行了全面的用户研究,评估生成结果的感知质量。该研究共涉及173名参与者,参与者评估了以下四个关键方面:运动动态、文本-运动对齐、视频质量和身份一致性。参与者按1-10分的尺度对每个方面进行评分,结果总结在下表2中。如表1所示的总体偏好评分,Magic Mirror在所有评估维度上始终优于基准方法,展示了其在人类评估中的卓越感知质量。

消融研究

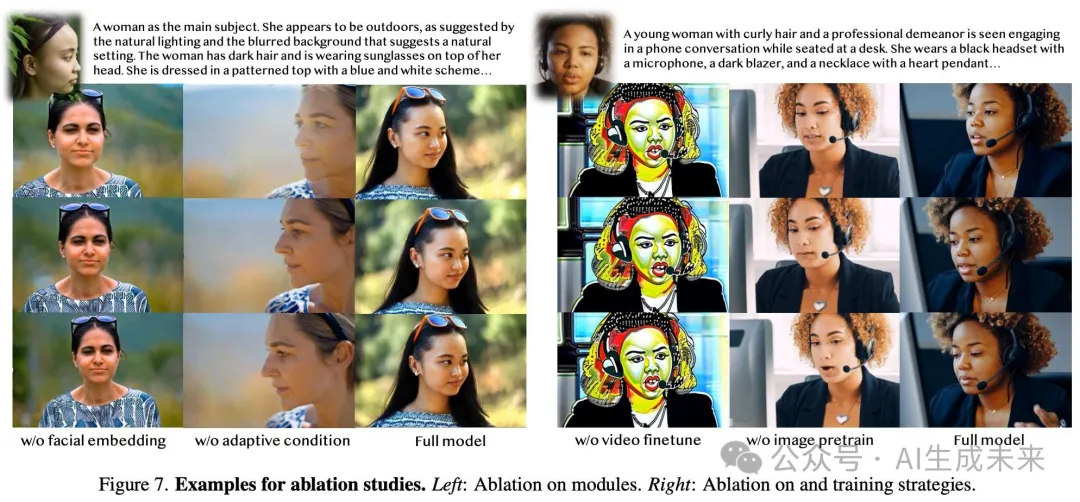

与条件相关的模块

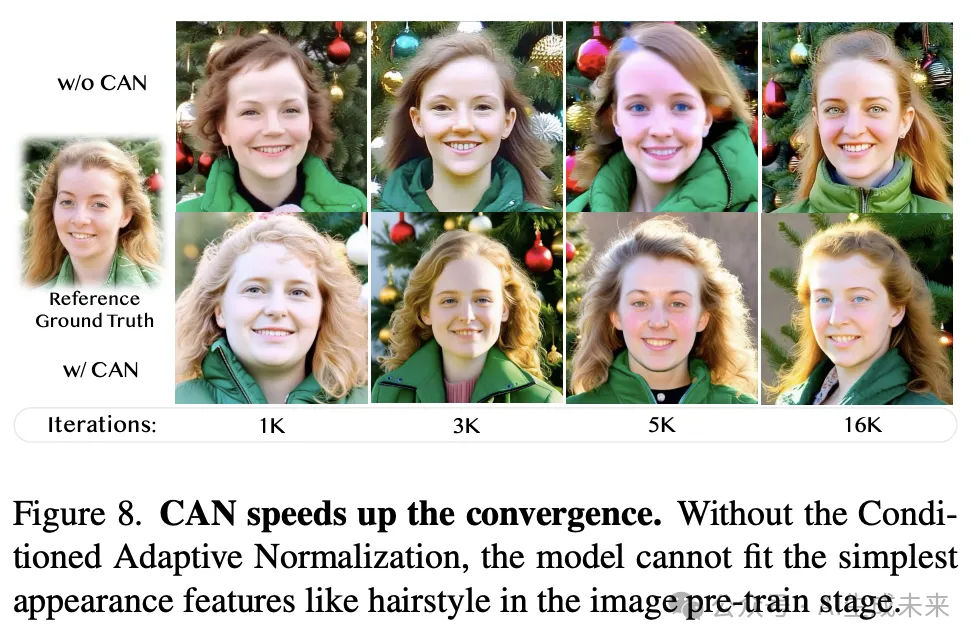

通过消融研究评估了关键架构组件,结果展示在下图7的左侧。没有参考特征嵌入分支时,模型失去了关键的高层次注意力引导,导致身份忠实度显著下降。条件自适应归一化(CAN)对于分布对齐至关重要,增强了跨帧的身份保持。下图8进一步展示了CAN在面部条件注入中的有效性,表明在图像预训练阶段,身份信息捕获的训练收敛性得到了改善。

训练策略上图7的右侧展示了不同训练策略的影响。图像预训练对于稳健的身份保持至关重要,而视频后训练确保了时间一致性。然而,仅在图像数据上训练会导致视频推理过程中出现颜色偏移伪影。这个伪影是由不同训练阶段中调制因子不一致造成的。我们的两阶段训练方法通过利用两个阶段的优势,生成具有高身份忠实度和动态面部运动的视频,达到了最佳结果。

讨论

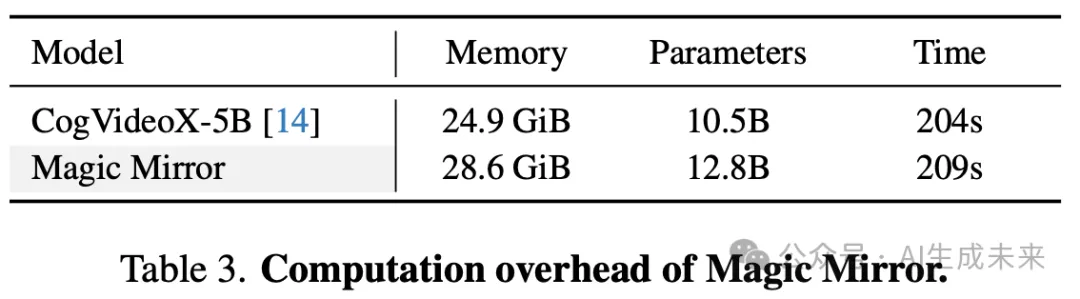

计算开销与基准模型相比,本文分析了生成一段49帧480P视频时的GPU内存利用、参数数量和推理延迟等计算要求。大多数附加参数集中在嵌入提取阶段,这只需要一次前向传递。因此,如下表3所示,Magic Mirror在GPU内存消耗和推理时间方面相较于基准模型引入了最小的计算开销。

限制与未来工作

尽管Magic Mirror在身份一致的视频生成方面表现强劲,但仍然面临一些挑战。首先,当前框架不支持多身份定制化生成。其次,本文的方法主要聚焦于面部特征,对于服饰和配件等细粒度属性的保持仍有改进空间。将身份一致性扩展到这些更广泛的视觉元素,代表了一个有前景的方向,适用于实际的多镜头定制视频生成。

结论

Magic Mirror,一种zero-shot身份保持视频生成框架。Magic Mirror将双重面部嵌入和条件自适应归一化(CAN)集成到基于DiT的架构中。本文的方法能够实现稳健的身份保持和稳定的训练收敛。大量实验表明,Magic Mirror能够生成高质量的个性化视频,同时保持单一参考图像的身份一致性,在多个基准和人工评估中优于现有方法。

本文转自AI生成未来 ,作者:AI生成未来