回复

OmniTokenizer-视觉tokenizer生成

本文介绍一种视觉tokenizer的生成。

AIGC生成模型在人工智能领域发展迅速,视觉生成主要有基于语言模型和扩散模型两种范式,而tokenizer是其核心组件。现有tokenizer分别针对图像或视频输入设计,存在应用灵活性和数据可扩展性的局限。因此需要一种联合图像 - 视频标记器,以实现从两种数据中联合学习,缓解单模态数据稀缺问题,并提高模型的通用性和可扩展性。

今天介绍一种OmniTokenizer方法,感兴趣的小伙伴可以看看原文:https://arxiv.org/abs/2406.09399

模型架构

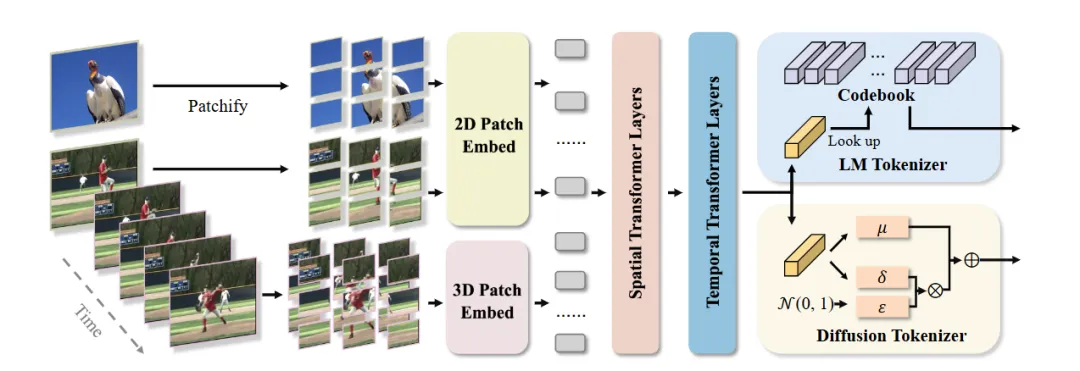

上图为OmniTokenize架构图,从中可以看出:

- OmniTokenizer 由 patch 嵌入层和独立的时空注意力块组成。采用时空解耦架构,在空间维度使用窗口注意力机制,因其具有局部聚合能力和效率;在时间维度使用因果注意力机制,以捕捉视频中的运动并确保时间连贯性。

- 输入数据首先进行 Patchify 操作,将图像和视频帧分别分割为不重叠的块并投影得到嵌入,然后通过时空分离的编码器获取潜在代码,解码器与编码器对称,最后通过线性投影层将时空标记映射回像素空间。

训练过程

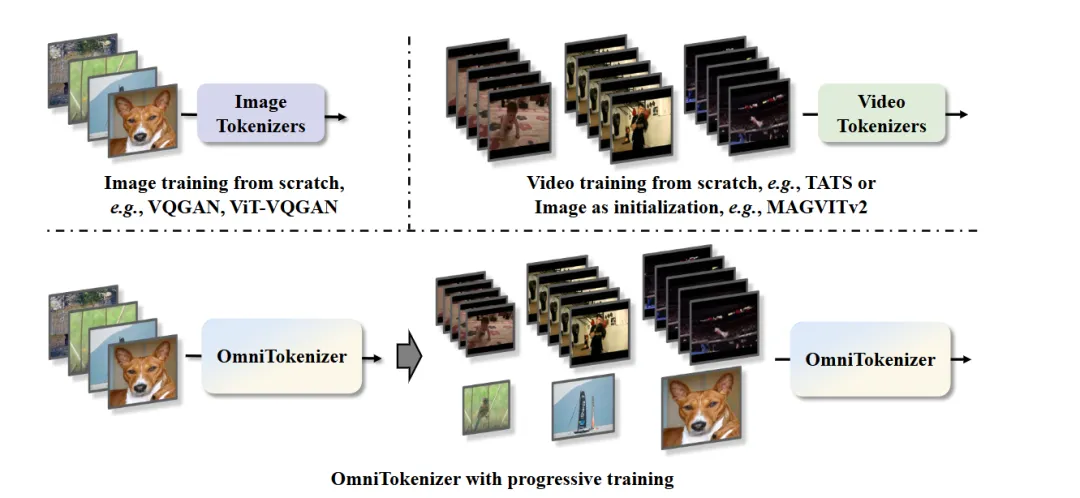

渐进式训练策略,包括两个连续阶段:

- 首先在固定分辨率的图像数据上进行训练,以建立对静态视觉信息的理解,即基础的空间编码能力

- 然后引入视频数据,在多分辨率上进行联合训练,学习时间动态信息,从而使模型能够准确捕捉单帧的空间细节和视频序列的时间关系。训练过程中使用向量量化目标函数,并在后期通过 KL 散度进行微调

实验结果

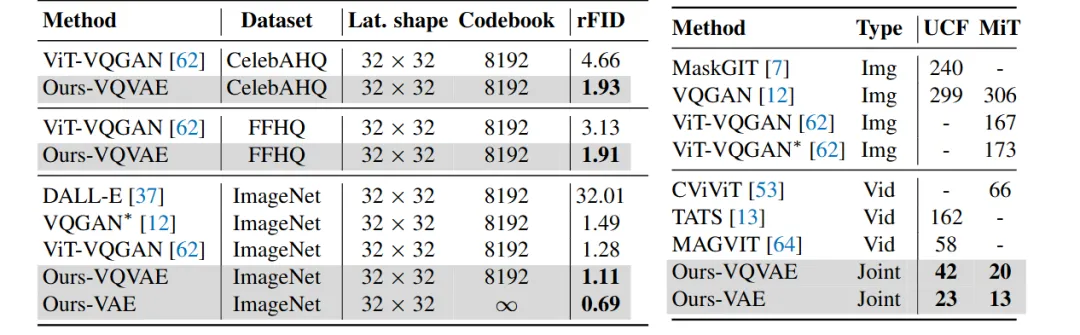

在 ImageNet、CelebA - HQ 和 FFHQ 等图像数据集以及 UCF - 101 和 Moments - in - Time 等视频数据集上评估。在相同压缩率和码本大小下,OmniTokenizer - VQVAE 在图像数据集上的重建 FID 指标优于现有方法,在 ImageNet 上达到 1.11,比之前的 SOTA 方法 ViT - VQGAN 提高了 13%;OmniTokenizer - VAE 进一步将 FID 降低到 0.69。在视频数据集上也取得了最佳的重建结果。

文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷

赞

收藏

回复

相关推荐