LLM合集:Meta推出PGraphRAG框架,异构图关系助力个性化RAG突破界限

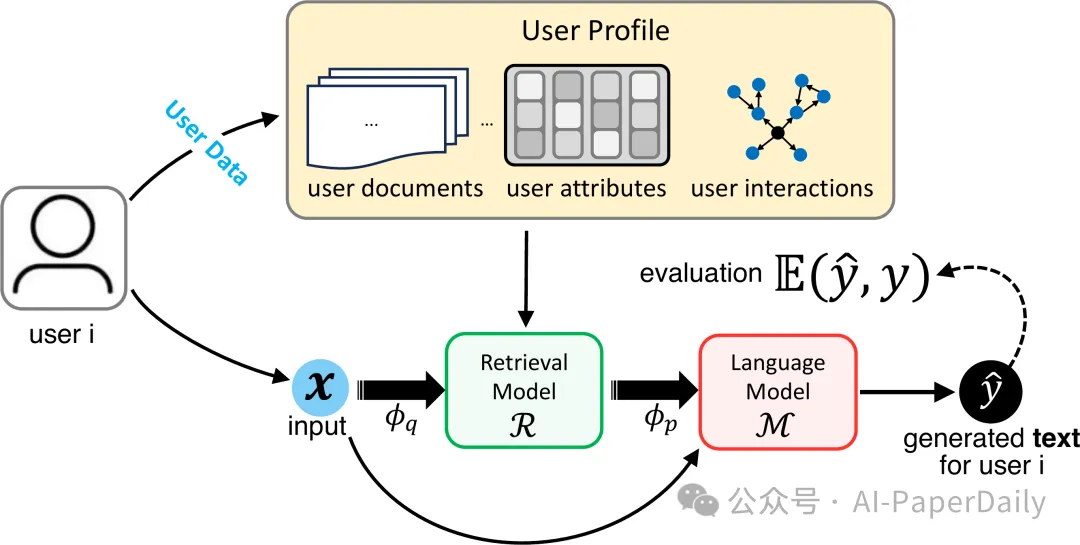

1. Personalized Graph-Based Retrieval for Large Language Models

随着大语言模型(LLMs)的演进,它们提供个性化和上下文相关响应的能力具有改变用户体验的潜力。然而,现有的个性化方法通常仅依赖用户历史来增强提示,这在冷启动场景或数据稀疏的情况下限制了其有效性。为了克服这些限制,我们提出了一种基于图的个性化检索增强生成(PGraphRAG)框架,该框架利用用户中心的知识图来丰富个性化。通过直接将结构化的用户知识融入检索过程,并用相关用户上下文增强提示,PGraphRAG增强了上下文理解和输出质量。我们还提出了基于图的个性化文本生成基准,旨在评估在用户历史稀疏或不可用的现实场景中的个性化文本生成任务。实验结果表明,PGraphRAG在多种任务中显著优于当前最先进的个性化方法,展示了基于图的检索在个性化方面的独特优势。

论文: https://arxiv.org/pdf/2501.02157

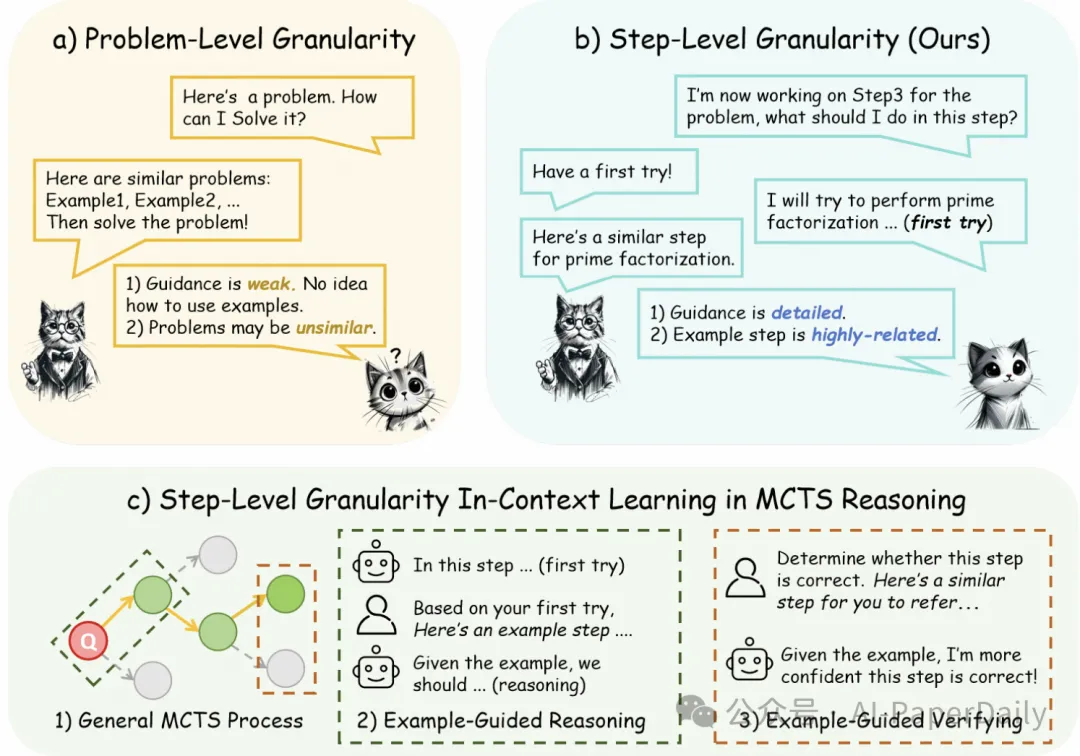

2. BoostStep: Boosting mathematical capability of Large Language Models via improved single-step reasoning

大语言模型(LLMs)通过分而治之的pipeline,并借助上下文学习(ICL)示例,在解决复杂数学问题方面表现出有前景的性能。然而,它们的改进潜力受到ICL示例中两个关键问题的限制:粒度不匹配和随之而来的负面效果噪声问题。具体而言,大语言模型能够进行分割过程,但在几个征服步骤中大多由于推理不准确而失败,而问题粒度的ICL示例有时缺乏针对特定挑战性推理步骤的相关步骤。进一步,这种断开可能由于不相关性而阻碍正确的推理。为此,我们专注于提高每一步的推理质量,并提出了BoostStep。BoostStep在每一步的检索和推理之间对齐粒度,并为每一步提供高度相关的ICL示例,采用一种新的“首次尝试”策略。BoostStep提供的相关示例多于粗略的问题粒度策略,逐步提高模型在每一步的推理质量。BoostStep是一种通用且稳健的推理增强方法,不仅提高了独立推理性能,还能无缝集成到蒙特卡洛树搜索方法(MCTS)中,以细化候选生成和决策。定量上,BoostStep分别将GPT-4o和Qwen2.5-Math-72B在各种数学基准上的性能提高了3.6%和2.0%,并与MCTS结合使用时,性能提高了7.5%。

论文: https://arxiv.org/pdf/2501.03226

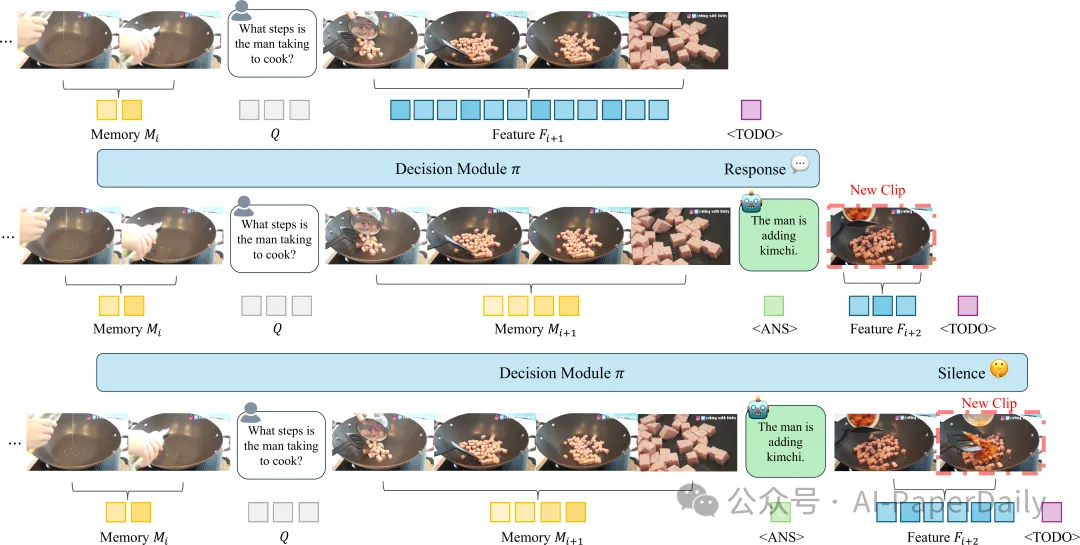

3. Dispider: Enabling Video LLMs with Active Real-Time Interaction via Disentangled Perception, Decision, and Reaction

与视频LLMs的主动实时交互带来了新的人机交互范式,其中模型不仅能够理解用户意图,还能在实时处理流式视频内容的同时做出响应。与先分析整个视频的离线视频LLMs不同,主动实时交互需要三种能力:1)感知:实时监控视频并捕获交互。2)决策:在适当情况下主动发起交互。3)反应:持续与用户交互。然而,这些期望的能力之间存在固有的冲突。决策和反应需要相反的感知规模和粒度,而自回归解码在反应期间阻断了实时感知和决策。为了在一个和谐的系统中统一这些冲突的能力,我们提出了Dispider系统,该系统解耦了感知、决策和反应。Dispider配备了一个轻量级的主动流式视频处理模块,用于跟踪视频流并识别最佳交互时刻。一旦触发交互,异步交互模块将提供详细的响应,同时处理模块继续监控视频。我们的解耦和异步设计确保了及时、上下文相关且计算效率高的响应,使Dispider非常适合长时视频流的主动实时交互。实验表明,Dispider不仅在常规视频问答任务中保持了强大的性能,还在流式场景响应中显著超越了先前的在线模型,从而验证了我们架构的有效性。代码和模型已发布在https://github.com/Mark12Ding/Dispider。

论文: https://arxiv.org/pdf/2501.03218

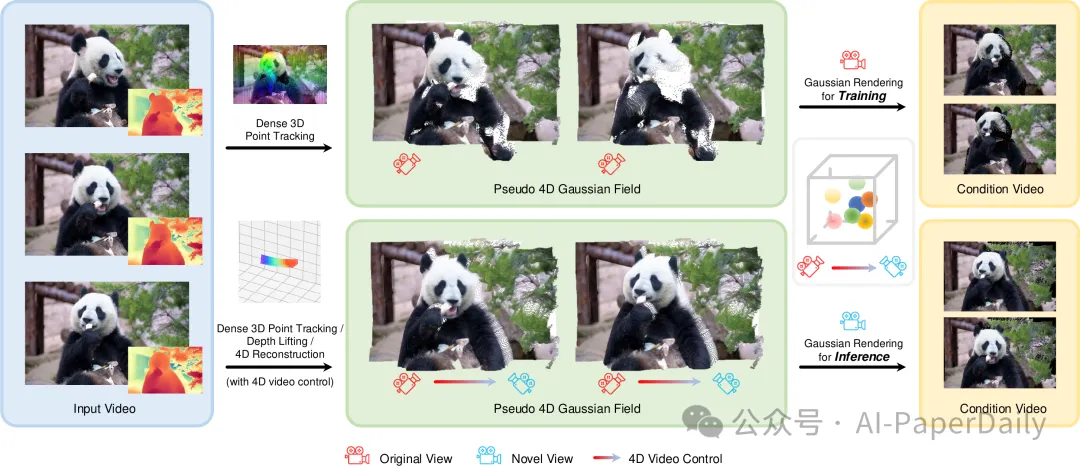

4. GS-DiT: Advancing Video Generation with Pseudo 4D Gaussian Fields through Efficient Dense 3D Point Tracking

4D视频控制对于视频生成是必不可少的,因为它使使用复杂的镜头技巧(如多机位拍摄和变焦)成为可能,而这些技巧目前现有的方法尚无法支持。直接训练一个视频扩散transformer(DiT)来控制4D内容需要昂贵的多视角视频。受到单目动态新颖视图合成(MDVS)的启发,该方法优化4D表示并根据不同的4D元素(如相机姿态和物体运动编辑)渲染视频,我们提出了伪4D高斯场到视频生成中。具体地,我们提出了一种新的框架,该框架使用密集的3D点跟踪技术构建伪4D高斯场,并为所有视频帧渲染高斯场。然后,我们微调预训练的DiT以生成遵循渲染视频指导的视频,称为GS-DiT。为了提高GS-DiT的训练效率,我们还提出了一种高效的伪4D高斯场构建方法——密集3D点跟踪(D3D-PT)。我们的D3D-PT在准确性和推理速度上均优于当前最先进的稀疏3D点跟踪方法SpatialTracker,加速推理速度两个数量级。在推理阶段,GS-DiT可以在遵循不同相机参数的同时生成具有相同动态内容的视频,解决了当前视频生成模型的一个重要局限性。

论文: https://arxiv.org/pdf/2501.02690

本文转载自AI-PaperDaily,作者: AI-PaperDaily