阿里巴巴Qwen研究员推出ProcessBench:衡量数学推理过程错误识别能力的新AI基准 原创

01、概述

在人工智能快速发展的浪潮中,语言模型已经展现出非凡的推理能力,尤其是在数学和编程等复杂领域。然而,尽管这些模型取得了显著的进步,它们在处理高难度问题时仍面临诸多挑战。随着**可扩展监督(scalable oversight)**领域的兴起,研究人员试图探索更加高效的监督方法,以帮助AI系统达到甚至超越人类的推理水平。

在这一背景下,阿里巴巴和Qwen团队推出了一个具有里程碑意义的数学推理评估基准——PROCESSBENCH,为语言模型在数学推理中的错误检测能力提供了系统化的评估框架。本文将从背景、创新点到实验成果全面解析PROCESSBENCH,为您揭开这个全新基准的神秘面纱。

02、现状:语言模型推理能力的挑战与评估缺口

语言模型近年来在复杂推理任务中取得了巨大突破,例如解决数学问题、编写程序和进行逻辑推导。然而,研究表明,语言模型在解决这些问题时依然存在以下几个主要瓶颈:

- 自我监督能力不足:尽管模型能够生成复杂的推理路径,但往往难以自动发现自身推理中的错误。

- 评估框架的局限性:现有的评估基准存在两大问题:

a.随着模型能力提升,部分问题集变得过于简单,无法体现模型在高难度场景下的表现。

b.许多评估方式仅关注答案的正确性,而缺乏对中间推理步骤的详细标注。

这种评估缺口导致难以全面理解和改进语言模型的推理机制。为解决这一问题,多个新的基准数据集应运而生:

a.CriticBench:评估模型对解决方案的批判与纠错能力。

b.MathCheck:通过引入含有故意错误的解决方案,要求模型识别推理中的错误步骤。

c.PRM800K:以详细标注的数学问题为基础,专注于评估推理步骤的正确性与逻辑性。

尽管这些基准已为研究带来重要进展,但它们在问题难度、解决方案多样性和评估全面性上仍有进一步提升的空间。这正是PROCESSBENCH诞生的初衷。

03、PROCESSBENCH的核心创新

PROCESSBENCH是由阿里巴巴和Qwen团队提出的一个专注于数学推理错误检测的评估基准,其设计基于以下三大原则:

1) 高难度问题设计

PROCESSBENCH专注于数学竞赛和奥林匹克级别的问题,问题的复杂性远超普通的数据集,例如 GSM8K 和 MATH。

2) 多样化的解决方案

PROCESSBENCH利用多个开源语言模型(如Qwen和LLaMA系列)生成解决方案,提供多种推理路径。通过引入12种不同的解决方案生成器,保证了数据集中解决方案的多样性,从而更好地考察模型的泛化能力。

3) 全面的评估框架

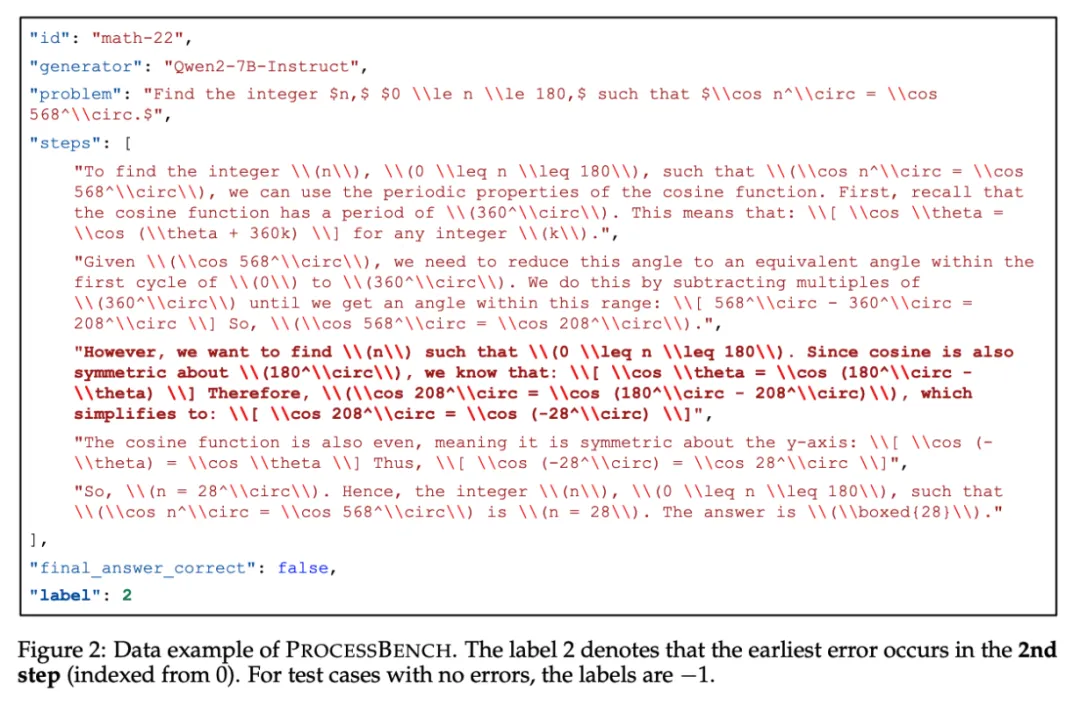

PROCESSBENCH采用直观但严谨的评估方法,要求模型定位解决方案中的最早错误步骤。这种方式不仅简化了评估流程,还使其能够适配不同类型的模型,包括过程奖励模型(Process Reward Models, PRMs)和批判模型(Critic Models)。

04、数据构建的严谨流程

为了构建一个高质量的评估基准,PROCESSBENCH团队经历了以下几个关键步骤:

1) 问题选择与整合

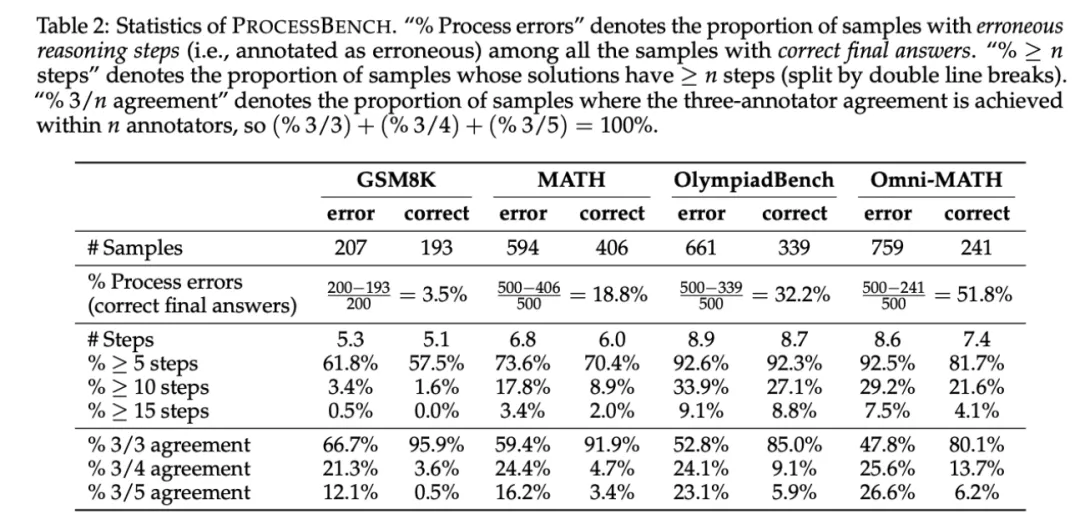

研究人员从四个知名数据集(GSM8K、MATH、OlympiadBench和Omni-MATH)中精心筛选问题,确保涵盖从小学水平到数学竞赛的难度范围。

2) 解决方案生成

通过使用Qwen和LLaMA系列的开源模型生成大量解决方案,每个问题对应多种解法,展现多样化的推理路径。

3) 解决方案格式标准化

团队引入Qwen2.5-72B-Instruct模型,对解决方案的推理步骤进行统一格式化处理,确保每一步推理都具有逻辑完整性和进展性。这种标准化使得人类专家后续标注更加高效且一致。

4) 专家标注

每个解决方案都由多位人类专家进行标注,明确指出最早的错误步骤,确保数据的准确性与可信性。

05、实验分析:PROCESSBENCH的研究发现

通过PROCESSBENCH的实验评估,研究人员揭示了语言模型在数学推理中的诸多关键问题与潜力:

1) 难度提升带来的性能下降

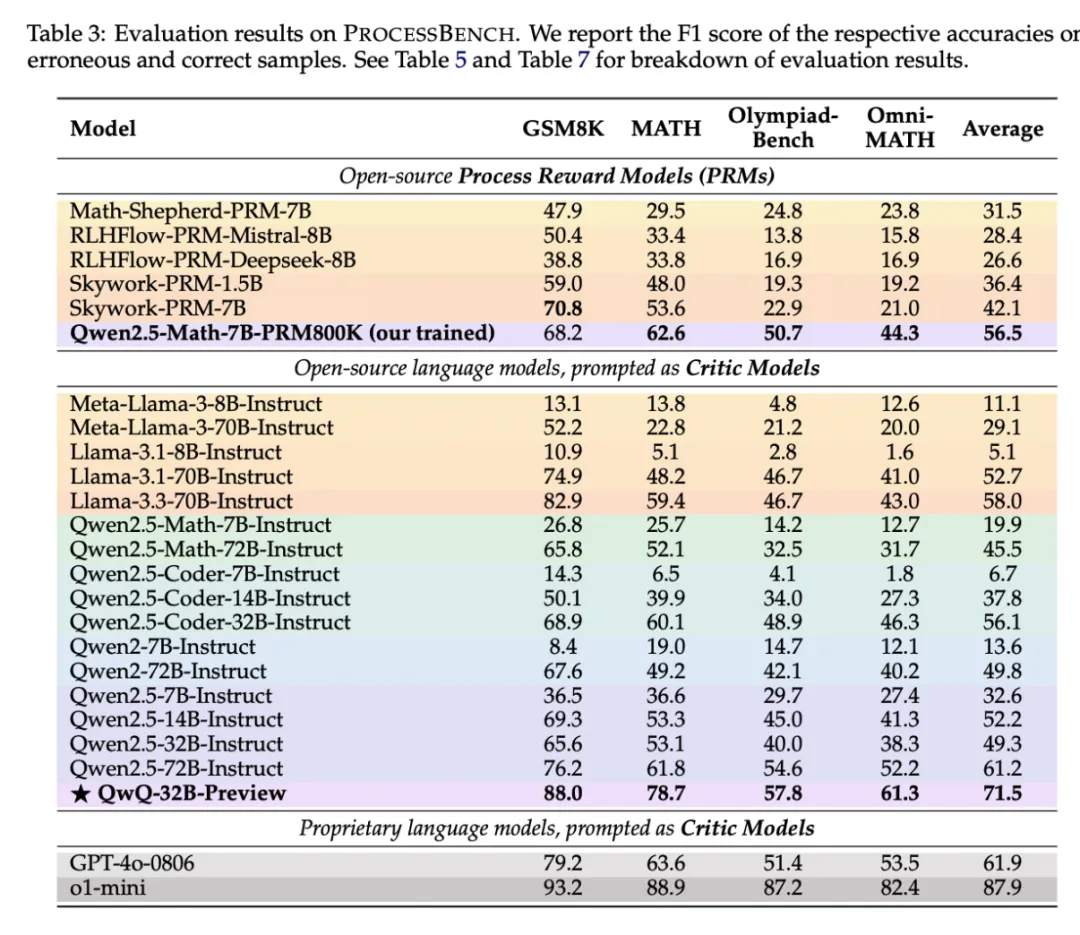

实验表明,无论是过程奖励模型(PRMs)还是批判模型(Critic Models),在问题难度逐步上升时(从GSM8K到Omni-MATH),所有模型的性能均显著下降。这暴露了当前模型在复杂推理中的泛化难题。

2) PRMs的表现短板

PRMs 在更简单的数据集(如 GSM8K 和 MATH)上表现优异,但在复杂问题上明显落后于批判模型。这种差距源于PRMs往往基于最终答案的概率估计推断推理步骤的正确性,而忽视了中间推理路径的细腻性。这使得即便模型通过错误步骤得出了正确答案,PRMs 仍难以有效捕捉错误。

3) 批判模型的优势

批判模型通过引入明确的纠错机制,在检测和定位推理错误上表现更为可靠。这为未来改进PRMs提供了重要参考方向。

06、研究意义:引领AI数学推理的新方向

PROCESSBENCH 的推出,不仅为语言模型的数学推理能力提供了一个全面的评估框架,还对AI推理过程的优化提出了全新思路:

- 提升错误检测能力:通过对高难度问题和多样化解决方案的考察,PROCESSBENCH帮助研究人员更深入地理解模型的推理弱点,为设计更强大的错误检测算法奠定了基础。

- 推动开源模型发展:实验结果显示,部分开源模型(如Qwen系列)在关键推理任务中的表现逐渐接近甚至超越了一些封闭的专有模型,这为开源领域的发展注入了信心与动力。

- 改进监督与奖励机制:研究强调了现有PRMs在复杂推理场景中的不足,未来可以通过改进奖励机制、引入更细致的推理路径监督来提升模型性能。

07、结语

作为一项前沿研究,PROCESSBENCH 为评估和提升语言模型的数学推理能力提供了宝贵工具。它不仅揭示了当前模型在高难度任务中的短板,也为研究人员开发更强大、更智能的推理模型指明了方向。

在未来,随着评估框架的不断完善和AI技术的快速进步,我们有理由相信,语言模型将更接近于人类推理水平,为数学教育、科学研究和更多实际应用场景带来深远影响。

参考:

- https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

- https://huggingface.co/datasets/Qwen/ProcessBench

- https://huggingface.co/papers/2412.06559

本文转载自公众号Halo咯咯 作者:基咯咯