EarthMarker:首个视觉提示遥感多模态大模型 原创

摘要:近年来,提示学习技术的发展使用户能够通过多轮对话与人工智能(AI)工具互动,从而实现对图像的交互式理解。然而,仅靠普通语言指令难以有效传递复杂遥感(RS)场景中的信息,这限制了对图像潜在内容的深入理解。此外,由于自然场景和遥感数据在领域上的显著差异,现有的提示策略难以直接应用于遥感数据解读。为解决这些问题,本文提出了首个基于视觉提示的多模态大语言模型(MLLM),名为EarthMarker,用于遥感领域。EarthMarker通过利用视觉提示(如框和点)实现图像、区域和点级别的遥感图像解读。模型开发了一种共享视觉编码方法,建立输入图像的多尺度表示和各种视觉提示之间的空间模式解释关系。随后,将混合视觉-空间表示与语言指令结合,构建联合提示,从而解释遥感图像中的复杂内容。为弥合自然数据与遥感数据之间的领域差距,并有效地将自然场景的领域级知识迁移到遥感领域,EarthMarker引入了一种跨领域学习策略。此外,为应对遥感视觉提示数据的不足,本文构建了名为RSVP的数据集,包含多模态、多粒度的视觉提示指令。通过广泛的实验表明,EarthMarker在多粒度遥感图像解读方面表现出竞争力,标志着视觉提示学习框架在遥感图像多粒度解读中的重大进展。

EarthMarker:数据集全部开源中!含365万条视觉-语言联合提示指令数据!

- 论文:https://ieeexplore.ieee.org/document/10817639

- 开源链接:https://github.com/wivizhang/EarthMarker

同系列模型:

EarthGPT:国内首个遥感大模型,100万多模态指令数据集已全部开源!

- 论文链接:https://ieeexplore.ieee.org/document/10547418

- 开源链接:https://github.com/wivizhang/EarthGPT

引言

视觉提示(Visual prompting)是当前自然领域中的研究热点,旨在通过视觉标记(如框、点和涂鸦)来解释图像中的感兴趣区域 [1], [2]。特别是,将视觉提示注入多模态大语言模型(MLLM)可以建立联合提示机制,使模型能够同时利用视觉和文本指令。这种联合提示方式类似于人类表达,能够以更灵活和高效的交互方式理解图像。

将视觉提示应用于遥感(RS)领域必须考虑其图像的独特特性,包括尺度变化、跨类别多样性以及复杂的上下文语义信息 [3], [4]。其中的主要挑战在于有效指导模型识别和解释复杂遥感图像中的关键潜在信息。然而,仅使用普通语言难以有效描述复杂遥感图像中的特定区域 [5], [6]。此外,现有MLLMs主要实现了图像级别的视觉-语言对齐,这限制了其进行详细图像理解的能力 [7]。因此,迫切需要开发更简洁且高效的提示机制,以增强遥感领域的细粒度视觉推理能力。

提示工程(Prompt engineering)已在自然语言处理(NLP)领域得到广泛研究 [8], [9],并逐渐扩展至计算机视觉领域。典型案例包括Segment Anything(SAM)[11]模型,该模型利用多种视觉提示实现零样本分割,从而适配多种新图像分布。此外,GPT4RoI [12]和RegionBlip [13]通过对区域-文本对的训练,使MLLMs能够完成区域级别的视觉理解任务。而Osprey [14]在像素级别视觉理解方面表现出色,但依赖预附加的分割模型,限制了其应用范围。此外,Ferret [15]和SPHINX-V [16]支持自由形状的视觉提示标记以实现像素级图像理解。然而,这些模型均在自然场景数据上进行训练,在处理遥感图像时性能不佳。

在遥感领域,致力于区域级细粒度图像理解或视觉提示的工作非常有限。例如,RSVG [17]采用语言提示来查询并定位特定对象。而EarthGPT [18]和GeoChat [6]等其他代表性遥感MLLMs超越了图像级别的理解,通过在视觉定位数据上训练实现了区域级视觉感知。此外,SAM在遥感图像上的表现有限,因为其ViT骨干网络是在大规模近距离遥感数据集上预训练的 [19], [20]。受SAM启发,RSPrompter [21]引入了一种自动化提示生成方法,用于开发针对遥感数据的交互式分割。然而,这些遥感MLLMs主要实现了图像-文本对齐,仅依赖语言指令,难以发现复杂遥感场景中隐藏的有价值信息,并且缺乏交互的灵活性。

为了填补这一空白,本文提出了一个基于视觉提示的MLLM,命名为EarthMarker,用于首次扩展MLLMs在遥感领域的区域级和点级理解能力。如图1所示,EarthMarker在多粒度遥感图像解释方面表现出色。具体而言,EarthMarker可以在从粗粒度的整体场景级别到细粒度的区域/对象级别,甚至点级别的区分之间切换。此外,EarthMarker能够完成广泛的粗粒度和细粒度遥感视觉任务,包括场景分类、目标分类、图像/区域/点级别标注以及关系分析等。值得注意的是,视觉提示用于隔离特定区域,并指导模型解释整个遥感图像的局部内容。

实际上,稀疏视觉提示、密集遥感图像特征以及语义层级的文本特征之间存在显著的差异,这使得对齐和整合这些模态变得具有挑战性。为了解决这一问题,本文开发了一种共享视觉编码方法。具体而言,将视觉提示处理为类似RGB图像,并与输入图像共享相同的视觉编码器。这种策略有助于一致的特征提取,并理解视觉提示区域与整体图像之间的关系,从而提升模型在视觉提示学习下的性能。

由于遥感数据的有限性,难以实现区域和文本的交互、空间关系的理解以及目标定位。为了缓解这一限制,本文采用通用领域数据进行混合训练。更重要的是,为了增强视觉提示-图像-文本的对齐,本文提出了跨领域学习策略。具体而言,在多领域图像-文本对齐的第一阶段,EarthMarker通过自然场景和遥感图像标注数据进行训练,以获得对图像的整体理解并提升概念多样性的建模能力。随后,模型进一步在自然场景的指代数据上训练,以获得图像的空间感知能力,从而为遥感领域中的指代理解能力的发展奠定基础。最后,在遥感视觉提示调优阶段,本文利用包含多种空间分辨率的遥感区域-文本和点-文本指令数据进行领域自适应训练。

EarthMarker配备了整体和点/区域级遥感图像解释能力。通过多领域联合训练,不仅提升了对细粒度遥感图像的深入解读能力,还增强了开放词汇推理能力。此外,模型的可更新参数是独立的,避免了不同粒度图像理解之间的干扰。

另一个挑战是现有视觉提示数据集 [14], [15] 限于自然场景,缺乏遥感语义特征。此外,目前公开的遥感标注数据往往过于简单且重复,缺乏遥感图像的独特特性。因此,本文构建了一个名为RSVP的视觉提示数据集,包含多模态大规模视觉-语言联合指令跟随任务。特别地,本文将各种公开可用的遥感数据转换并重新标注为统一的对话格式。此外,部分高质量的标注数据由GPT4V [22]生成,旨在展现每个遥感图像的独特特性,从而增强数据的丰富性和多样性。

通过在多类型遥感数据集上的广泛实验,证明EarthMarker在多粒度遥感视觉任务中的性能优于最先进(SOTA)专家模型、MLLMs以及视觉提示模型。具体来说,在零样本场景分类任务中,EarthMarker显著优于其他现有MLLMs。特别是在指代对象分类任务中,EarthMarker在DIOR-RSVG数据集 [23] 上使用边界框作为视觉提示获得了98.37%的语义相似性(SS)得分,并在使用点提示时获得了95.96%。此外,在图像和区域标注任务中,EarthMarker也远超其他MLLMs和视觉提示模型。

综上,实验结果表明,EarthMarker在各种多粒度遥感图像理解任务中表现出卓越性能,并具备出色的零样本推理能力。

我们的贡献可以总结如下:

首个遥感视觉提示多模态大语言模型(MLLM),EarthMarker:本文首次在遥感领域提出了一个基于视觉提示的MLLM,名为EarthMarker。EarthMarker能够通过视觉和文本联合提示理解遥感图像,并灵活切换解释层级,包括图像级、区域级和点级。更重要的是,EarthMarker填补了遥感领域视觉提示MLLM的空白,显著满足了实际应用中对遥感图像细粒度解释的需求。

首个遥感视觉提示学习框架:本文开发了一种通用的区域级和点级视觉提示数据标注方法,并提出了一种共享视觉编码机制,以增强视觉提示、整体图像和文本指令之间的交互。此外,设计了一种跨领域学习策略,通过利用多领域数据轻量化优化非关联参数,使EarthMarker具备空间感知能力和联合指令跟随能力。

首个遥感视觉提示数据集RSVP:本文构建了一个名为RSVP的大规模遥感区域指令数据集,包含约365万对图像-点-文本和图像-区域-文本配对数据。这一数据集的构建促进了遥感图像的细粒度解释,为遥感领域中视觉提示的开发奠定了基础。

在多粒度遥感视觉任务中的卓越表现:通过广泛的实验验证,EarthMarker在多粒度遥感视觉任务中展现了竞争力,其性能优于最先进的专家模型、MLLMs和视觉提示模型。所评估的任务包括场景分类、目标分类、区域标注、关系分析等。因此,EarthMarker成功探索了视觉提示学习在遥感领域的适应性,不仅提升了MLLM的性能,还标志着在细粒度遥感图像解释方面迈出了重要一步。

方法简介

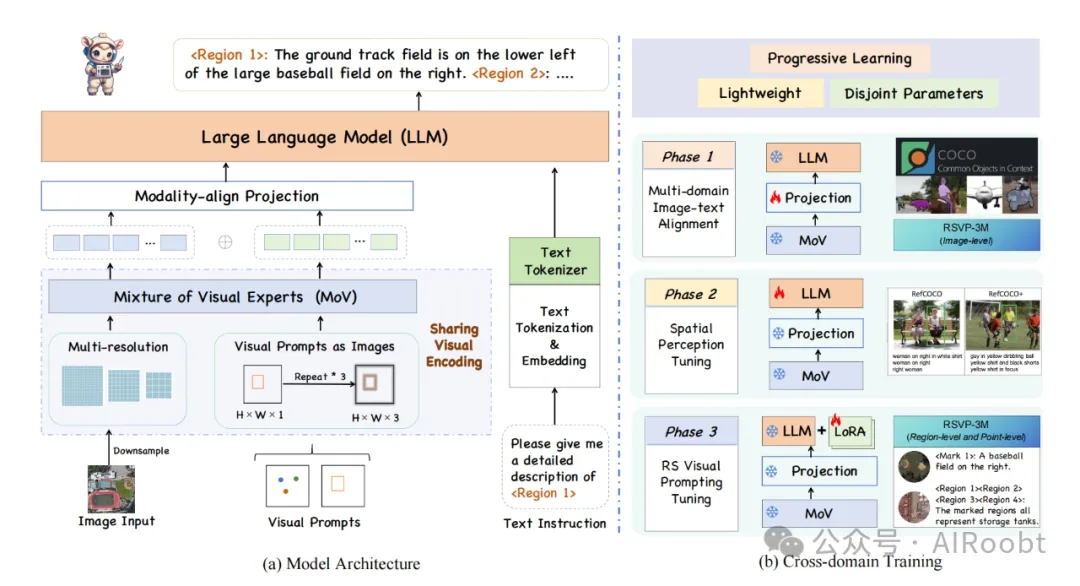

EarthMarker的总体架构如图1所示,提出了一种共享视觉编码机制,以增强视觉提示、整体图像和文本指令之间的交互理解。此外,设计了跨域三阶段学习策略,使得EarthMarker具备了空间感知和联合指令跟随能力。该研究贡献了一个视觉和语言联合提示多模态理解框架,并构建大规模的遥感多模态联合指令数据集,展示出了极大的实际应用的潜力。

图1 EarthMarker总体架构

可视化效果

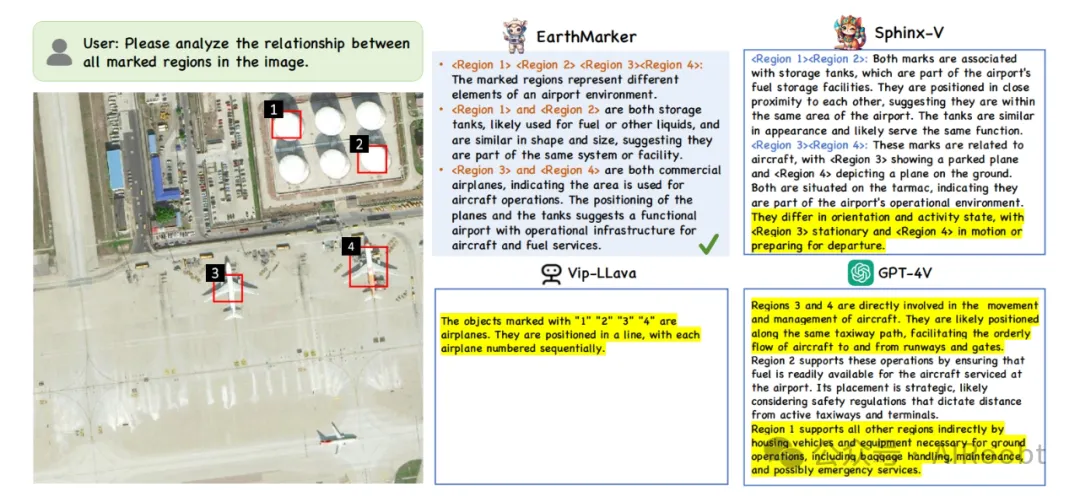

EarthMarker可完成复杂的视觉推理任务,尤其在目标关系分析任务中性能超越GPT-4V。如图2所示,EarthMarker展示出惊人的分析能力:首先总结了视觉提示所标识区域分别为机场环境中的不同要素, 接着对相同类别的区域进行了聚类分析,并推断出这些标注区域在机场环境中的不同功能。

图2 复杂推理任务:关键目标关系分析(黄色高亮部分表示错误)

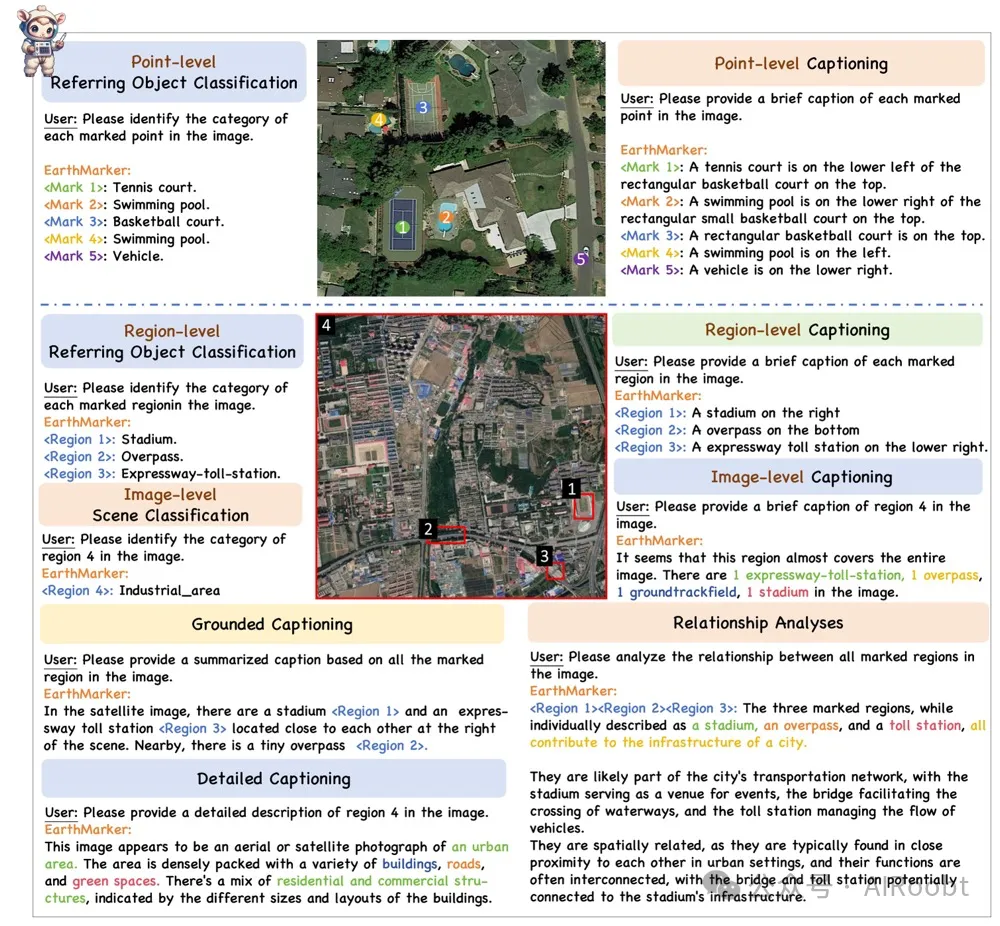

综合来讲,EarthMarker具备多才多艺的能力,如图3所示,EarthMarker可实现多粒度(如图像级、区域级和点级)遥感图像解译,擅长于各种视觉任务,包括场景分类、指定对象分类、图像描述、关系分析等。

图3 EarthMarker具备多粒度遥感图像解译能力,可实现多任务推理

相关工作

A. 多模态大语言模型(MLLMs)

近年来,大语言模型(LLMs)的进步极大地推动了自然语言处理(NLP)领域的变革与创新。代表性工作包括闭源的GPT系列 [12], [24] 和开源的LLaMA系列 [25], [26],它们展现了强大的通用语言处理与推理能力。受到LLM的启发,通过进一步引入视觉信号,多模态大语言模型(MLLMs)得以发展,用于实现视觉-语言的相互理解以及多种视觉任务。例如,VisualGPT [27]、BLIP [28] 和 Flamingo [29] 在将LLMs与视觉模态对齐后,表现出强大的多模态推理潜力。值得注意的是,LLAMA-Adapter V2 [30] 和 SPHINX [31] 采用零样本注意力机制和线性投影层调优,将LLM与视觉信号相结合。此外,VisionLLM [32] 将面向视觉任务的定义与LLM方法论对齐,从而以开放式的方式解决视觉中心任务。这些自然场景的MLLMs为扩展到遥感(RS)领域奠定了基础。

一些开创性的遥感MLLMs已经出现,例如EarthGPT [18]、GeoChat [6]、SkyEyeGPT [33] 和 LHRS-Bot [34],这些模型使MLLMs能够解释遥感图像。其中,GeoChat是第一个针对光学遥感图像解决多任务问题的MLLM。EarthGPT提出了一个通用MLLM,可以处理多源遥感图像并执行广泛的遥感视觉任务。LHRS-Bot则构建了LHRS-Bench,用于促进遥感社区对遥感特定MLLMs进行多维度评估。这些模型无疑促进了遥感特定领域MLLMs的发展。然而,这些模型仅通过语言交互完成视觉解释,而无法通过视觉提示生成响应来处理指代视觉理解任务。显然,现有的遥感MLLMs主要聚焦于图像级别和视觉定位,但无法进行更细粒度的区域、点和像素级别的解释。因此,本文旨在增强MLLMs在遥感图像多粒度理解上的多功能性。

B. 提示工程(Prompt Engineering)

提示工程是NLP中的新兴研究方向 [24]。代表性工作包括AutoPrompt [8] 和 CoOp [9],它们旨在为语言模型和视觉-语言模型自动生成提示模板,而非手动设计。此外,语言提示已被应用于开发开放词汇检测模型,如DetPro [35] 和 Promptdet [36]。与语言提示技术的广泛发展相比,视觉提示仍需进一步探索。

一个重要的发展是SAM [11] 模型,它支持多种分割提示以增强零样本性能。由于SAM中缺乏语义标签,Semantic-SAM [37] 被提出以实现多层次语义分析与预测。值得注意的是,GPT4RoI [12] 利用空间框并结合语言和感兴趣区域(RoI)作为输入,从而实现区域识别。Colorful Prompting Tuning (CPT) [38] 通过基于颜色的标记来提高预训练视觉-语言模型的性能。此外,Osprey [14] 将遮罩区域融入语言指令,从而实现像素级视觉理解。其他视觉提示相关工作包括RegionBlip [13]、Kosmos-2 [39]、Shikra [40] 和 Ferret [15],这些研究通过利用视觉提示技术,在区域级图像理解中显示出前景。研究“通过图像修复实现视觉提示” [41] 表明,通过提供所需任务示例,可以很好地完成各种视觉任务。此外,RegionPLC [42] 提出了一个轻量级且可扩展的区域点-语言对比学习框架,用于开放世界3D场景理解。

然而,上述模型均基于自然数据集进行训练,自然图像与遥感图像之间的显著差异表明,它们直接应用于遥感任务的能力有限。

在遥感领域,除传统视觉模型 [43], [44] 外,最近在语言或视觉指令学习上的研究有限。例如,RSVG [17] 可基于自然语言表达提供参考对象的位置。EarthVQA [45] 数据集和语义对象感知框架(SOBA)被开发,EarthVQA包含图像、对应的语义视觉提示以及问答对,用于训练SOBA以实现基于对象的推理。受提示学习启发,RSPrompter [21] 设计了一种自动化方法,用于生成适用于SAM输入的提示,从而促进遥感图像的分割。然而,RSVG采用语言提示而非视觉提示;EarthVQA仅涉及城市规划图像上的像素级推理;而RSPrompter仅适用于基于提示的分割任务。此外,一些专家模型已开发出基于点监督的检测和语义分割,如PSOD [46]–[49]。然而,这些模型仅为单一任务设计,缺乏多功能性。

显然,目前尚无统一的视觉提示框架专为遥感领域设计,以进一步提高MLLMs的多粒度解释能力。这些局限性阻碍了更复杂和更细粒度遥感图像理解的进一步发展,因此本文聚焦于填补这一空白。

本文转载自公众号AIRoobt ,作者:AIRoobt