微软人工智能研究院推出 OLA-VLM:一种以视觉为中心的优化多模态大型语言模型的方法 原创 精华

01、概述

随着人工智能(AI)领域的飞速发展,多模态大语言模型(MLLMs)正在快速崛起,推动着机器在理解和推理文本与视觉数据方面的能力。传统的AI系统通常在语言和视觉之间有着明显的界限,但随着技术的进步,我们正迎来一个可以同时处理视觉和语言信息的新时代。多模态大语言模型通过弥合视觉与语言之间的鸿沟,正在为图像分析、视觉问答、以及多模态推理等领域带来革命性变革。这些技术的出现,标志着人工智能在理解和与世界互动方面迈出了重要的一步。

然而,尽管前景广阔,这些系统仍然面临不少挑战。其中,最根本的问题之一便是对自然语言的依赖,这往往导致视觉表示质量的不足。尽管数据集规模和计算复杂度的提升带来了某些进展,但为了在视觉任务上取得更理想的表现,当前的多模态大语言模型仍需进行更加有针对性的优化。如今,现有的方法大多面临着计算效率和性能提升之间的平衡问题。

02、现有多模态大语言模型的困境

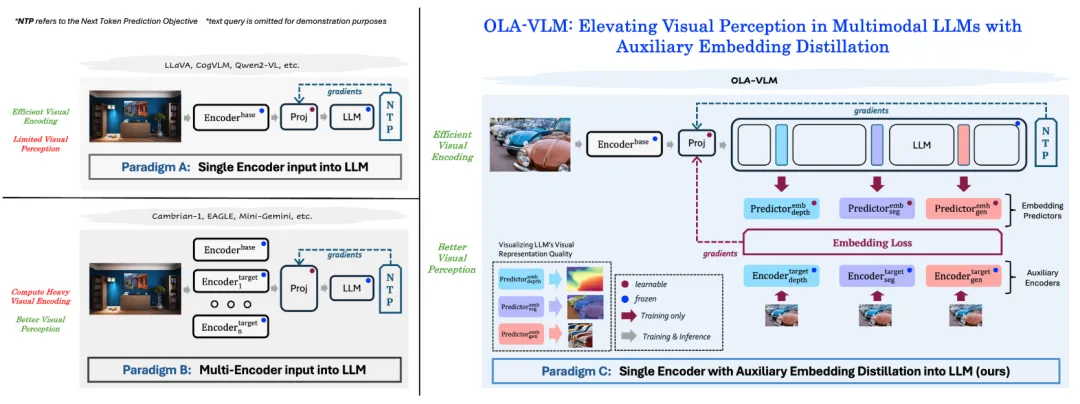

在多模态大语言模型的训练过程中,研究者通常采用视觉编码器提取图像特征,再将这些特征与自然语言数据一起输入语言模型。这些方法中有的采用了多个视觉编码器,或者使用交叉注意力机制来提升对视觉信息的理解。然而,这些技术虽然能够提升模型的性能,但也带来了数据量和计算需求的大幅增加,这在一定程度上限制了它们的可扩展性和实际应用。如何在提升视觉理解能力的同时,避免过度增加计算开销,成为了当前AI领域的一个难题。

03、OLA-VLM:全新优化方法的出现

为了解决这些挑战,乔治亚理工学院的SHI实验室与微软研究院的研究人员联合提出了一种创新的方案——OLA-VLM(Optimization of Language Model via Auxiliary Visual Embeddings)。这一方法的核心思想是,通过在预训练过程中将辅助的视觉信息“蒸馏”到大语言模型的隐藏层中,从而在不增加视觉编码器复杂度的情况下,提升模型在视觉推理方面的能力。通过这种方式,OLA-VLM能够在推理过程中不增加额外的计算开销的前提下,优化视觉与语言信息的对齐,进一步提升视觉推理的效果。

04、OLA-VLM的技术突破

OLA-VLM的核心技术涉及将嵌入损失函数应用于由专门的视觉编码器提取的特征,这些编码器主要用于图像分割、深度估计和图像生成任务。通过这种方法,研究者能够将蒸馏得到的视觉特征映射到语言模型的特定层,并采用预测嵌入优化技术进行调整。更重要的是,模型还引入了任务特定的标记,在输入序列中融入辅助的视觉信息。这一设计确保了视觉特征能够有效地整合进大语言模型的表示中,而不会干扰模型的主要训练目标——下一个标记的预测。

通过这种优化,OLA-VLM不仅提升了模型在视觉任务中的表现,而且避免了传统方法中所面临的计算瓶颈和效率问题。与传统方法不同,OLA-VLM能够在推理阶段仅使用一个视觉编码器,从而显著降低了计算成本,并提升了系统的效率。

05、OLA-VLM的实际效果:打破性能瓶颈

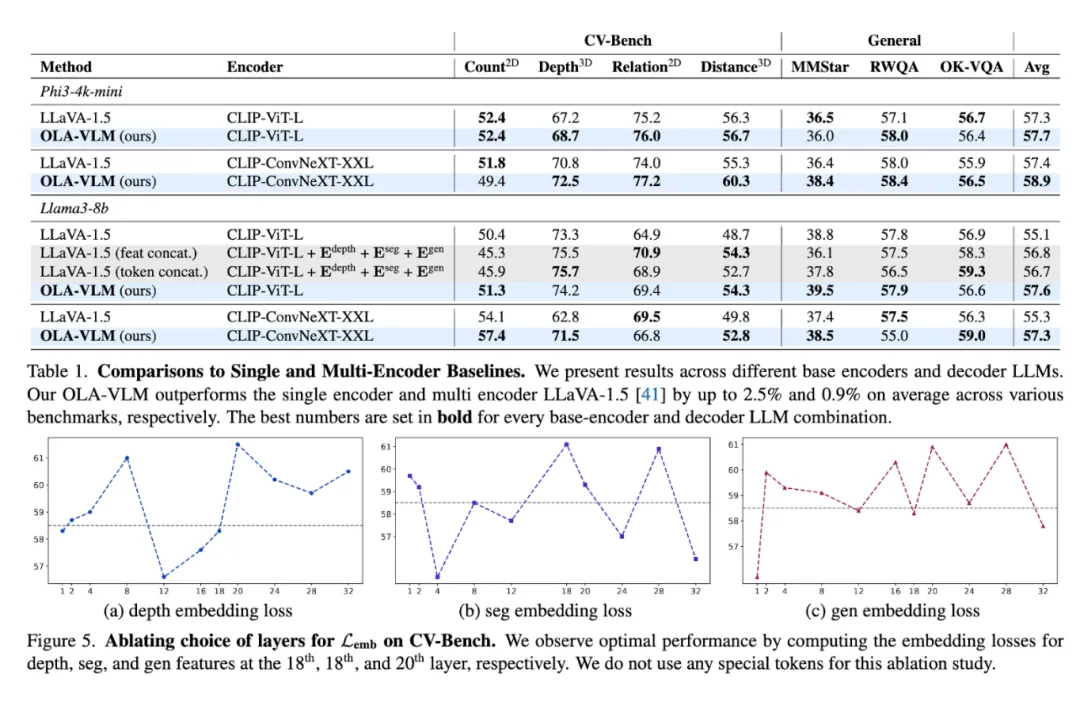

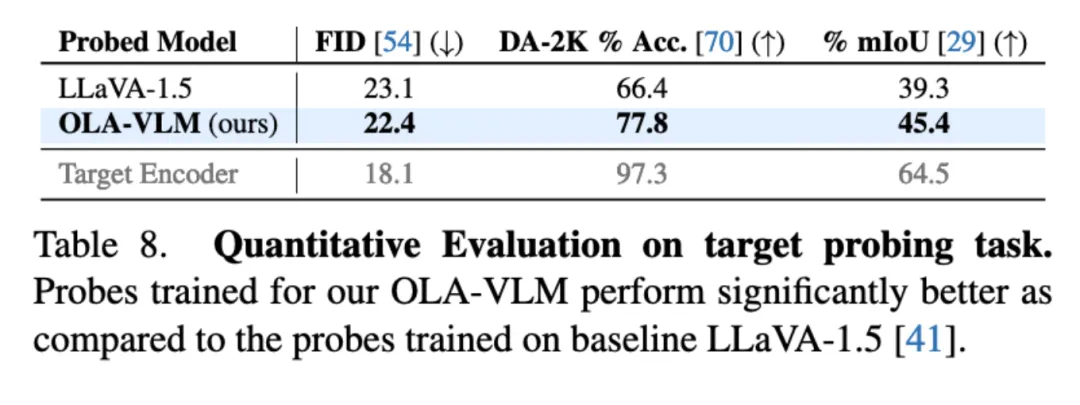

OLA-VLM在多个基准测试中展示了出色的表现,尤其在视觉任务方面超越了许多现有的模型。具体来说,在CV-Bench这一视觉任务基准套件中,OLA-VLM在深度估计任务上超越了LLaVA-1.5基线模型8.7%,达到了77.8%的准确率;在图像分割任务中,OLA-VLM的平均交并比(mIoU)达到了45.4%,显著高于基线模型的39.3%。此外,OLA-VLM还在二维和三维视觉任务上表现出持续的改进,尤其在距离推理和关系推理等任务中,平均提升了2.5%。这一切成果都仅使用了单一的视觉编码器,而不像许多现有模型那样依赖多个编码器,显示了其在效率上的显著优势。

为了进一步验证其有效性,研究人员还对OLA-VLM学习到的表示进行了分析。通过探究实验,研究人员发现该模型在中间层中实现了更优的视觉特征对齐,这一特性大大提升了模型在下游任务中的表现。特别是,研究人员指出,任务特定标记的引入在训练过程中显著优化了模型对深度估计、图像分割和图像生成任务的特征理解,从而进一步证明了预测嵌入优化方法的有效性。

06、OLA-VLM的未来展望

OLA-VLM为多模态大语言模型的视觉信息整合设立了一个新的标杆。它通过在预训练阶段聚焦嵌入优化,为当前的训练方法填补了一个关键的空白,将视觉与语言的对齐提升到了一个新的层次。这一创新方法不仅在视觉语言任务的表现上取得了突破,而且与传统方法相比,显著降低了计算资源的需求,为大规模的多模态系统提供了更具可扩展性和实用性的解决方案。

从更长远的角度来看,OLA-VLM的研究展示了如何通过针对性的优化策略,在不增加计算负担的情况下,显著提升多模态模型的表现。这一突破有望为未来更多的多模态系统打下基础,使得AI能够更加全面地理解世界并与之互动。随着这一技术的不断发展,我们可以预见,未来的多模态人工智能将更加智能化、更加高效,推动各个行业的深刻变革。

07、结语

总而言之,SHI实验室和微软研究院的研究成果展示了一项在多模态AI领域具有里程碑意义的技术突破——OLA-VLM。这一方法通过在预训练阶段对视觉表示进行优化,克服了传统方法中存在的视觉与语言对齐问题,并显著提升了模型在视觉任务上的表现。它不仅展示了在计算效率和视觉理解之间找到平衡的可能性,更为未来的多模态大语言模型的发展开辟了新的方向。

通过优化视觉特征的学习方式,OLA-VLM为AI的多模态理解带来了前所未有的进展,这一技术的成熟有望推动人工智能在各个领域的广泛应用。未来,我们将看到更多基于这种优化方法的模型在实际应用中的出现,它们将更好地理解和响应人类语言与视觉信息的复杂交互,进一步推动智能化时代的到来。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯