大模型之嵌入与向量化的区别是什么? 原创

“ 嵌入是更高层次的向量化,是智能化的;而向量化是一种数值转化的过程,是机械式的 ”

在前面写了几篇关于嵌入和向量化的文章,然而在今天才发现之前理解的有偏差,嵌入和向量并不是一个东西,其效果虽然相似但却并不完全一样。

嵌入与向量化

先来思考一下向量化和嵌入是同一个东西吗?如果不是,那他们的区别是什么?

我们都知道向量是大模型的底层数据结构,可以说没有向量就没有大模型;因此,在神经网络中唯一能够处理的数据格式就只有一种——向量。

但从实际的情况来看,向量只是最终的导向结果;普通数据在转化为向量之前,存在着不同的情况,虽然最终的目标都是向量,但原因和过程却不太一样。

在大模型技术体系中,向量化主要存在以下两种情况:

- Embedding——嵌入

- 数据向量化

虽然两种方式都是为了向量化,但其原因是有本质区别的。

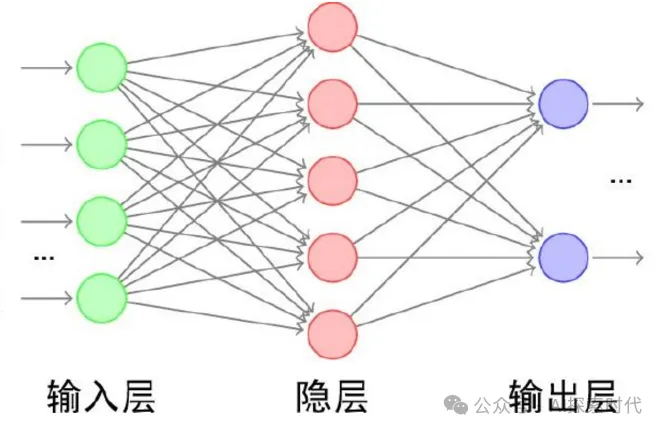

我们知道大模型是由一个输入层,一个输出层,以及一个隐藏层(包括多个神经网络层);而其中比较特殊的两个层就是输入层和输出层。

输入层的数据并不是由神经网络通过学习或训练获得,而是由外部人为输入的数据;因此,在输入层有一个很重要的操作就是把这些人为输入的数据转换成向量格式,然后隐藏层才能进行处理。

而这个过程就是向量化的过程,但不知道大家有没有发现这个向量化的过程有没有特殊的地方?

首先,在神经网络输入层的向量化过程,它只是单纯的把输入数据转换为向量表示;而其中并没有去维持输入数据原本的语义关系。

因为在无监督学习模式下,神经网络训练过程需要做的并不是去重建数据之间的语义关系;而是去学习这些数据之间的语义关系。

然后经过训练之后的模型,才能去理解用户输入数据的语义关系,然后再生成新的语义关系。

但是嵌入的过程是一个什么样的过程?

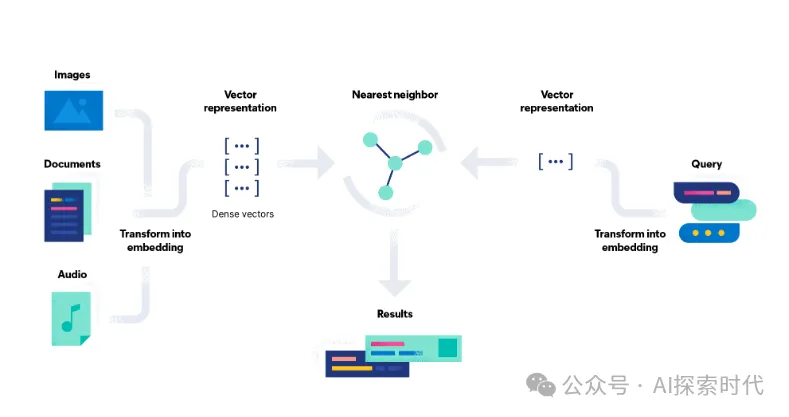

嵌入的本质也是数据向量化的过程,但这里有一个区别就是嵌入需要维护数据之间的语义关系;也就是说经过嵌入之后的数据是具有语义关系的;而不是毫无关系的离散向量。

这也是为什么嵌入的过程需要使用一些经过专门训练过的嵌入模型,或者其它机器学习模型;而不仅仅只是一个向量化的工具。原因就在于嵌入需要维护其语义关系。

所以,向量化和嵌入都是为了把数据转换为向量格式;但嵌入的目的是捕获数据的底层结构或属性,通常通过训练算法或模型习得。

“嵌入”强调以有意义和结构化的方式表示数据的概念,而“向量”指的是数值表示形式本身。

https://www.elastic.co/cn/what-is/vector-embedding#are-embeddings-and-vectors-the-same-thing

嵌入(Embedding)和向量化(Vectorization)是机器学习和自然语言处理中的两个重要概念,虽然它们都与将数据表示为向量有关,但在概念、应用和实现上有显著的区别。

嵌入(Embedding)

定义:

嵌入是一种将高维、稀疏或非结构化数据(如单词、句子、图像)转换为低维、密集向量的方法,同时保留数据的语义或结构信息。

特点:

- 低维稠密表示:嵌入通常将数据从高维稀疏表示(如词袋模型)映射到低维稠密空间。

- 语义相关性:嵌入向量在低维空间中保留了数据的语义相似性(如词语间的关系)。

- 通过学习生成:嵌入通常由神经网络通过优化学习得到,如词嵌入(word2vec、GloVe)或句嵌入(BERT)。

- 应用领域:

- 自然语言处理(如单词或句子的语义表示)

- 推荐系统(如用户或物品的特征表示)

- 图数据分析(如节点嵌入)

例子:

- 使用word2vec将单词 "king" 和 "queen" 嵌入为向量,这些向量可以捕捉性别和王室关系。

- 使用BERT将句子嵌入为向量,用于捕捉句子级别的语义信息。

向量化(Vectorization)

定义:

向量化是一种将数据转换为向量形式的过程,通常用于将非数值数据转化为数值形式,便于机器学习模型处理。

特点:

- 数值化的操作:向量化主要是将原始数据表示为可以直接输入模型的数值向量。

- 不一定学习:向量化可以是简单的规则转换,而不需要通过训练得到。

- 可能是高维稀疏向量:向量化的结果不一定是稠密向量,常见的高维稀疏向量化方法包括词袋模型和TF-IDF。

- 应用领域:

- 特征工程(如将文本、图像、或其他数据转化为数值特征)

- 数据预处理(如编码分类变量)

例子:

- 词袋模型将句子 "I like apples" 表示为一个词频向量:

[1, 1, 1, 0, 0, 0](假设词汇表是[I, like, apples, oranges, bananas, grapes])。 - 使用TF-IDF表示文档特征。

核心区别

维度 | 嵌入(Embedding) | 向量化(Vectorization) |

目的 | 学习低维稠密语义表示 | 将数据转换为数值向量,可能稀疏,也可能稠密 |

是否需要学习 | 需要(通常通过神经网络或优化算法学习) | 不需要(可以基于规则或统计方法生成) |

语义表示能力 | 保留语义关系和相似性 | 可能不保留语义,仅是特征的机械化表示 |

典型方法 | word2vec、GloVe、BERT、node2vec | 词袋模型(BoW)、TF-IDF、独热编码(One-hot Encoding) |

结果向量维度 | 通常低维且稠密 | 通常是高维且稀疏 |

总结

- 嵌入更注重语义特征,能够通过学习捕捉数据之间的深层关系,是一种“智能化”的表示方法。

- 向量化更注重数据表示的直接性,通常是基于规则或统计的“机械化”过程。

两者可以结合使用。例如,向量化生成初始特征表示,而嵌入通过深度学习进一步优化表示质量。

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/eisOBrLQb1UL5dLC25HTrA