大模型之神经网络特征提取综述 原创

“ 特征提取是神经网络的核心能力之一,但其复杂程度远没有想象中的那么简单 ”

在之前的文章编码器和解码器中介绍了编码器和解码器的核心功能之——特征提取和特征重建;编码器的核心任务是特征提取,而解码器的核心任务是特征重建。

但除开模型设计者也就是神经网络设计者之外,对大模型的使用者来说,大模型就是一个黑盒模型;用户只需要给定输入,大模型就可以根据训练结果给出相对应的数据输出。

因此对使用者来说,大模型内的一切都是不可见的;而且由于大模型的训练和微调都是由神经网络自身完成的,因此包括神经网络设计者在内;没人知道大模型的内部到底是怎么运作的;这也是为什么大模型缺乏可解释性的原因之一。

大模型的特征提取

要想了解大模型的特征提取,首先要明白一个概念就是——什么是特征?

事实上我们每时每刻都在接触不同的特征,比如说我们每天睁眼看到的东西,我们使用的物品,我们认识的人。

先来回答一个问题,我们是怎么区分不同的人和物的?

答案就是通过特征,比如苹果和香蕉的特征不一样;男人和女人的特征也不一样,你的朋友和其他人的特征也不一样。

所以,我们的大脑就是通过我们的五感输入的信息,然后通过提取特征来区分不同的人和物。

再回到人工智能领域,大模型是怎么提取特征的?

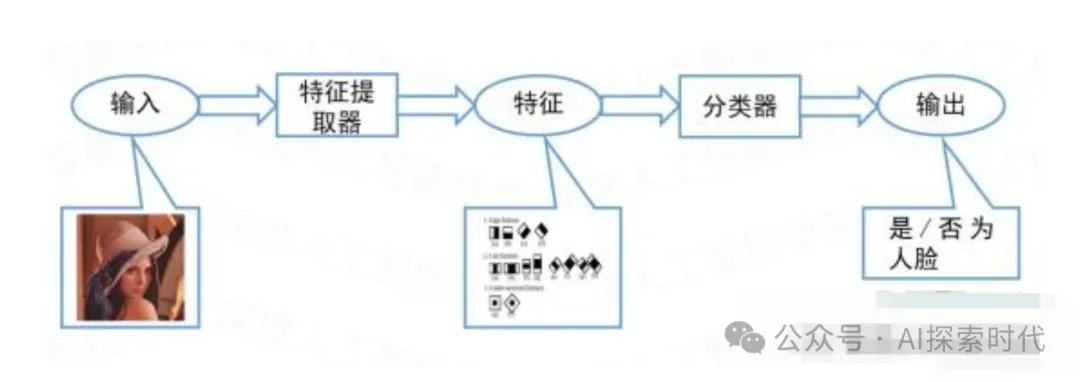

在深度学习爆火之前,特征提取并不是由神经网络自身来完成的;在那时的机器学习领域,特征提取是由业内的专家人士,通过自己的一套方法论来进行特征提取。

这种方式的好处是特征提取的可解释性,因为特征提取的全部流程都是由人类的完成的;因此这些专家可以给你解释为什么要提取这个特征,以及怎么提取这个特征。

但在神经网络模型爆火之后,所有的特征提取都是由模型自身来完成;虽然神经网络是由人类自己设计的,但人类也并不完全了解里面到底发生了什么;这也是为什么部分人担心大模型安全问题的原因之一。因为它是完全不可控的。

但从另一方面来说,由于神经网络中的特征是模型在学习中逐渐生成的;所以这些特征没有人为的干预,特征的分布更加客观,更有利于模型进行分类和回归;这一点是人工特征提取所无法比拟的。

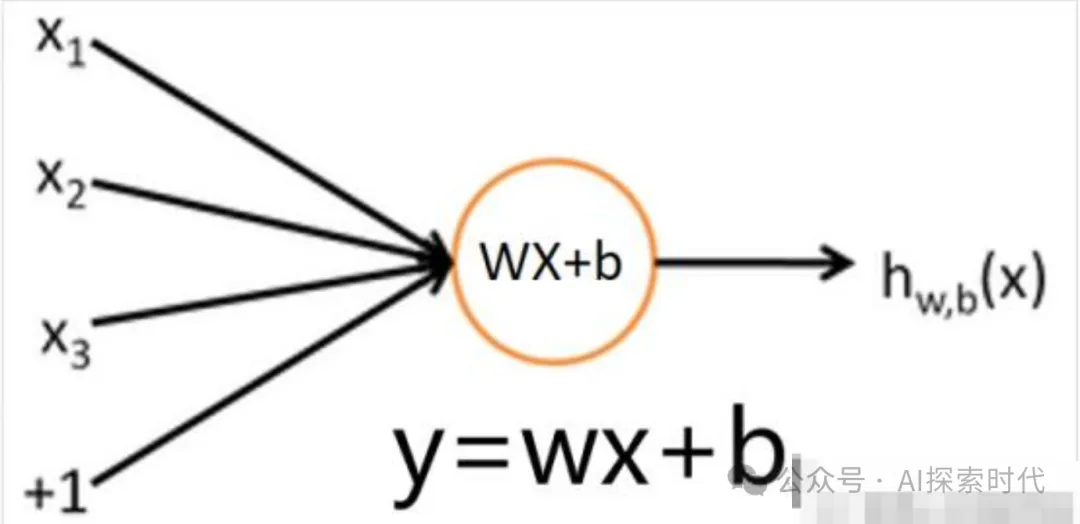

传统的特征提取方法是通过人工提取而来,人工神经网络中的特征是通过网络层计算得来的,最简单的特征提取方法就是在确定好数据标签y’后,通过反向传播算法和线性层来提取特征,比如y=wx+b,其中y是输出值,x是固定输入,w是权重,b是偏差,w和b都会随着模型的反向传播不断更新。一般通过损失函数E=1/2(y-y’)求得损失,然后通过反向传播算法降低损失E,由于损失函数中的y’是固定的,只有改变输出y,让y和y’越来越接近,才能够达到我们的目的,而改变y的值回到了前向输出公式y=wx+b上,在这个公式中,能够改变的值就只有w和b,所以最终我们通过改变w和b的值让输出的y发生变化,让其和标签y’更加接近。可见,在输入x不变的前提下,w和b的改变会让输出y有越来越接近标签y’。

从理论上来说,在网络层较浅时,提取到的特征不会有很强的标准性,这里的标志性指的是特征对原始数据的代表性。而到了神经网络层数越深的时候,模型提取到的特征会更具代表性;简单来说就是网络层数越深,模型能够解决的任务越复杂,这也是为什么说网络模型越深,能力越强。

神经网络的快速发展是最近这几年才大规模开始的,关于神经网络特征的理解,也是仁者见仁,智者见智,但是总体的目标是不变的,那就是朝着越来越高效的特征提取方向发展。不管是以前的CNN模型,还是这两年的transformers模型,以及提出的各种注意力的方法,都是在设计怎么去除掉对于当前任务无关的冗余信息,增加对于当前任务有用的信息权重,从而实现特征的高效提取,以达到快速高效的完成任务。

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/Tdhs_5wAF09-PESBi3tAzQ