回复

如何估算不同大小的大模型需要多大的GPU? 精华

在几乎所有的 LLM 访谈中,都有一个问题不断出现:“为大型语言模型提供服务需要多少 GPU 内存(LLM)?

这不仅仅是一个随机的问题,它是一个关键指标,表明您对这些强大模型在生产中的部署和可扩展性的理解程度。

在使用 GPT、LLaMA 或任何其他 LLMs,了解如何估算所需的 GPU 内存至关重要。无论您是处理 7B 参数模型还是更大的模型,正确调整硬件大小以服务于这些模型都至关重要。让我们深入研究数学运算,这将帮助您估算有效部署这些模型所需的 GPU 内存。

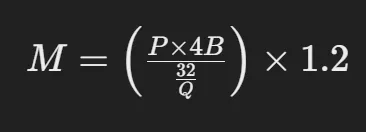

估算 GPU 内存的公式 要估计为大型语言模型提供服务所需的 GPU 内存,您可以使用以下公式:

估算 GPU 内存的公式分解公式

参数数量 (P):

- 这表示模型的大小。例如,如果您正在使用具有 700 亿个参数 (70B) 的 LLaMA 模型,则此值将为 700 亿。

每个参数的字节数 (4B):

- 每个参数通常需要 4 字节的内存。这是因为浮点精度通常占用 4 个字节(32 位)。但是,如果您使用的是半精度 (16 位),则计算将相应地调整。

每个参数的位数 (Q):

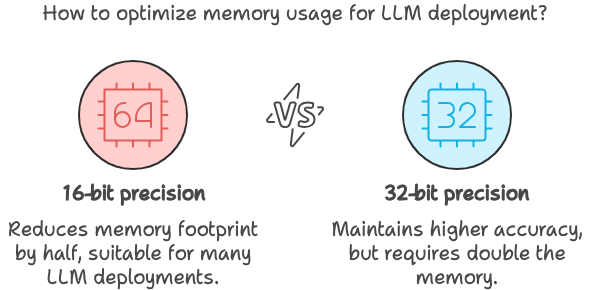

- 根据您是以 16 位还是 32 位精度加载模型,此值将发生变化。16 位精度在许多 LLM,因为它在保持足够精度的同时减少了内存使用量。

开销 (1.2):

- 1.2 乘数增加了 20% 的开销,以考虑推理期间使用的额外内存。这不仅仅是一个安全缓冲;这对于在模型执行期间覆盖激活和其他中间结果所需的内存至关重要。

如何优化 LLM?

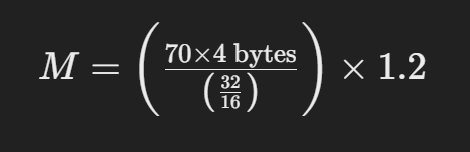

示例计算

假设您要估计为具有 700 亿个参数(以 16 位精度加载)的 LLaMA 模型提供服务所需的内存:

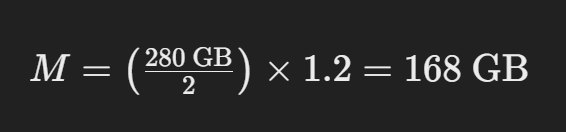

这简化了为:

此计算告诉您,您需要大约168 GB 的 GPU 内存才能为 16 位模式下具有 700 亿个参数的 LLaMA 模型提供服务。

实际意义

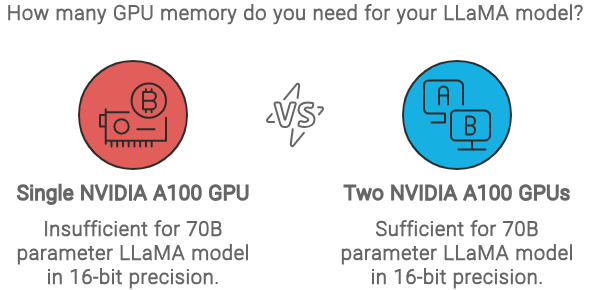

理解和应用这个公式不仅仅是理论上的;它具有现实世界的含义。例如,具有 80 GB 内存的单个 NVIDIA A100 GPU 不足以为该模型提供服务。您至少需要两个 A100 GPU,每个 GPU 为 80 GB,才能有效地处理内存负载。

您需要多少个 GPU 来为 LLaMA 模型服务器

通过掌握此计算,您将有能力在面试中回答这个基本问题,更重要的是,避免部署中代价高昂的硬件瓶颈。下次评估部署时,您将确切地知道如何估计有效为 LLMs。

本文转载自 AI大模型世界,作者: rocLv

赞

收藏

回复

相关推荐