即插即用,无痛增强模型生成美感!字节跳动提出VMix:细粒度美学控制,光影、色彩全搞定

文章链接:https://arxiv.org/pdf/2412.20800

代码地址:https://github.com/fenfenfenfan/VMix

项目地址:https://vmix-diffusion.github.io/VMix/

亮点直击

- 分析并探索现有模型在光影、色彩等细粒度美学维度上生成图像的差异,提出在文本提示中解耦这些属性,并构建一个细粒度的美学标签体系,提供清晰的模型优化方向;

- 提出VMix条件注入方法,它将输入文本提示解耦为内容描述和美学描述,通过值混合交叉注意力的条件控制方法,从不同维度提升模型生成的美感;

- 提出的方法对于现有的扩散模型具有普适效果,作者基于此训练了一个即插即用的美学适配器,与社区模块高度兼容。

- 实验表明,提出的方法能显著提升现有模型生成美感,优于FreeU、DPO、Textual Inversion等方法。

总结速览

解决的问题:

- 扩散模型在文本到图像生成方面表现出色,现有方法在提升图像质量以满足人类偏好方面做出了努力,但未能充分满足人类对视觉生成内容的细粒度审美偏好,如自然光线、丰富色彩和合理构图等;

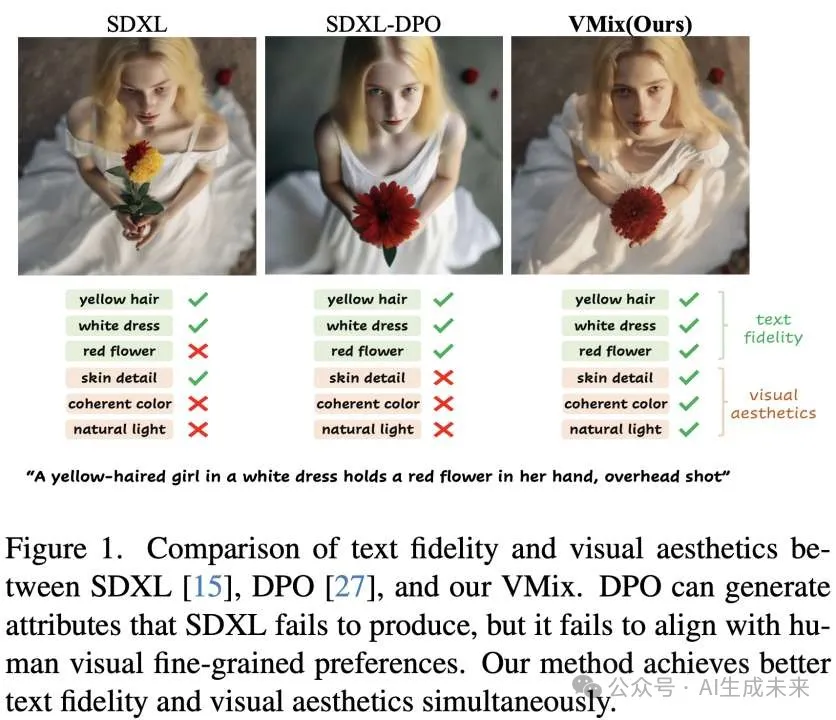

- 现有方法在提升图像质量以满足人类偏好方面做出了努力,如FreeU、DPO等,尽管整体生成结果可能在文本对齐方面表现更好,但可能在视觉构图等方面表现较差,现有方法未能准确对齐生成图像与人类偏好。

提出的方案:

- 通过对齐人类设计师偏好,构建包括光影、色彩、构图等不同美学标签,将文本条件解耦成内容描述和美学描述;

- 提出新的条件注入方法VMix,通过审美嵌入初始化模块和跨注意力混合控制模块,在保持原有模型图文匹配能力同时,提升美学表现;

- VMix设计灵活,能够与社区模块(如LoRA、ControlNet和IPAdapter)兼容,为图像生成提供更大的创造能力。

应用的技术:

- 扩散模型架构:Stable Diffusion、SDXL被作为基础图像生成模型进行实验,通过冻结基模仅训练额外小参数网络提升模型美感;

- 美学向量初始化:通过初始化美学向量,将输入文本提示分离为内容描述和多维度美学描述,并通过映射网络将审美标签作为额外条件整合到去噪模型中;

- 值混合交叉注意力:引入交叉注意力混合控制网络,在不直接改变注意力图的同时,最小化对图像-文本对齐的不利影响,从而更好的注入美学条件。

达到的效果:

- VMix能够在不损害模型原有图文匹配能力的同时,提升模型在光影、色彩、构图等不同美学维度的表现;在与其他方法,如FreeU、DPO、Textual Inversion的比较中表现更出色,证明了其在提升图像美感方面的有效性。

- 在MJHQ-30K和LAION-HQ10K基准测试中,VMix在Aes分数上取得了最高分,表明其在提升美感的重要性。用户研究也表明,应用VMix后,预训练和开源模型更受用户青睐。

方法

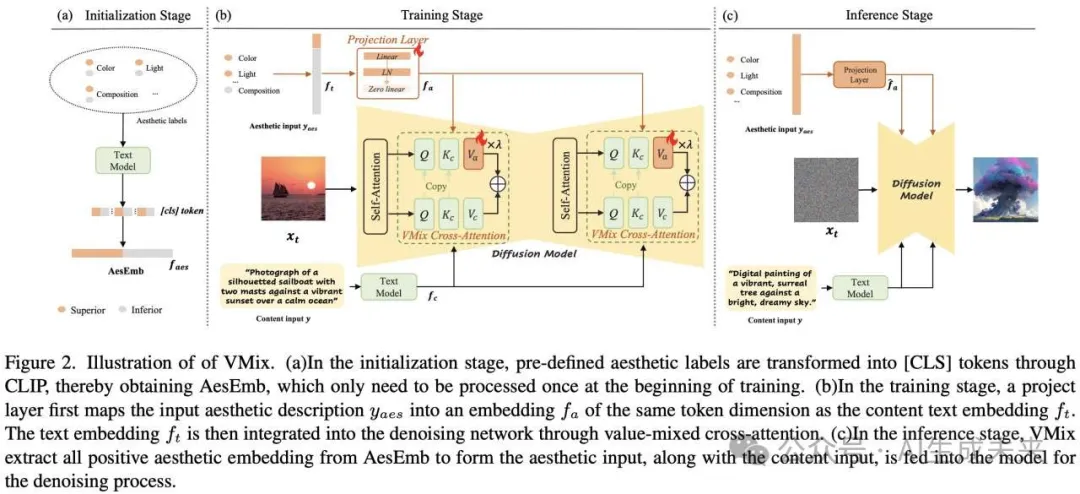

VMix框架的pipeline和实现细节,如下图所示,分为三个阶段:

(1)美学向量初始化阶段;(2)训练阶段;(3)推理阶段

美学向量初始化

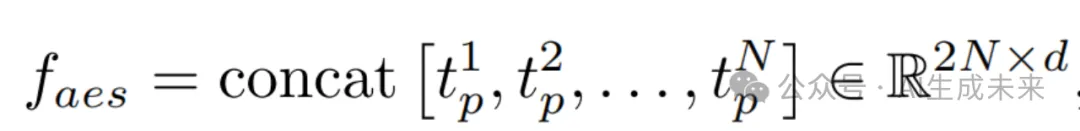

其中d是维度,N表示美学标签对的数量。

交叉注意力混合控制

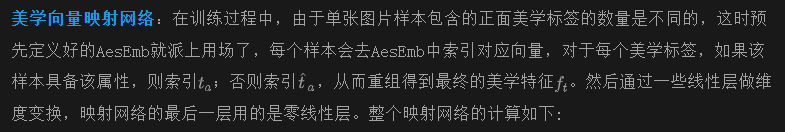

fa是从美学向量映射网络出的最终文本特征。在训练开始时,作为连接层的零初始化线性层的权重和偏置被设置为零。这种初始化确保了微调模型不会引入有害噪声,从而保留了原始预训练模型的能力。

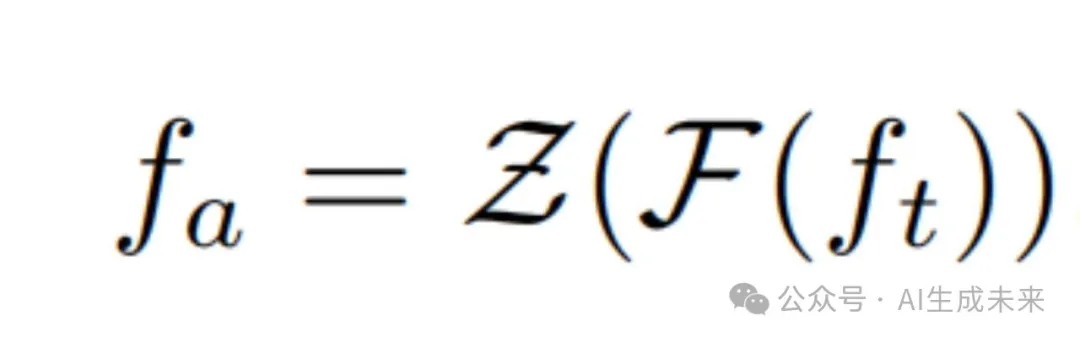

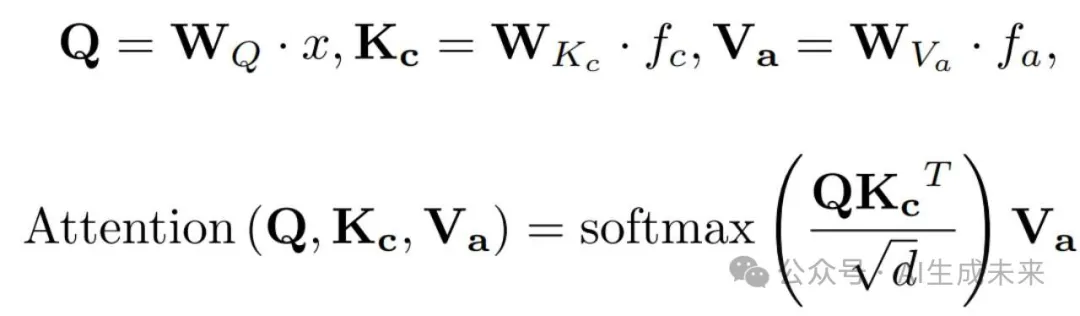

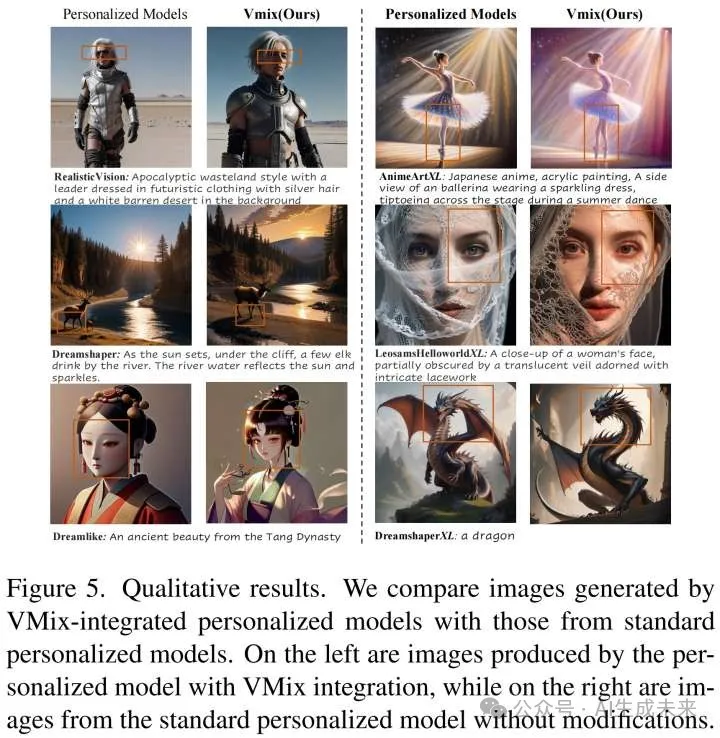

值混合交叉注意力:交叉注意力层中的注意力图决定了文本标记在每个图像块的概率分布,为了尽可能保留预训练模型中固有的图文匹配能力,通过内容分支和美学分支双分支的方式在扩散模型中引入值混合交叉注意力网络,这两个分支共享注意力图,对于美学分支,仅让网络学习一个新的value,从而减少注入过程中对原始注意力图的影响,这个过程可以表示为:

训练及推理细节

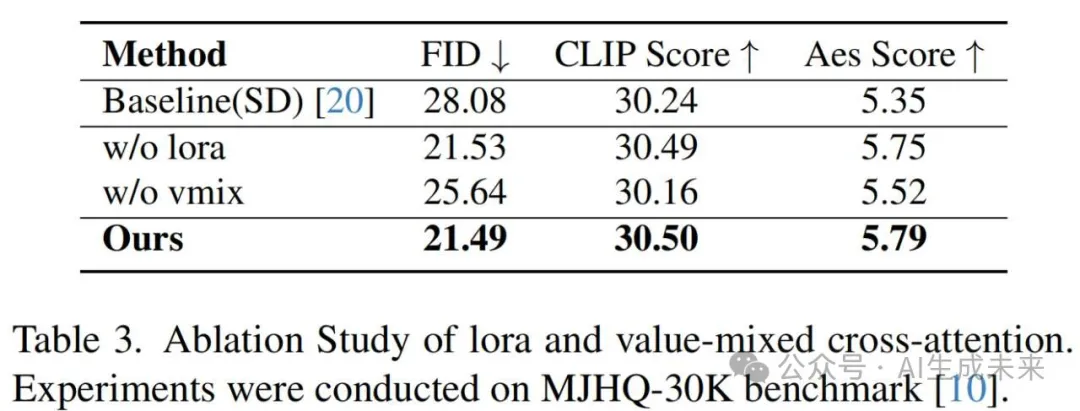

模型全参数训练虽然会有更高的上限,但会产生高昂的成本,并且高度定制化;训练过程中,基模参数被冻结,只训练新增的映射网络和值混合交叉注意力网络,基模通过挂载一个小参数的LoRA,从而使模型训练过程更加稳定,并增强了其适用性。训练完成后,形成一个即插即用的模块。在推理阶段,默认使用所有正面的审美标签,如上图(c)所示,从而提升模型在所有审美维度上的生成质量。尽管在训练阶段使用了LoRA,在推理阶段这不是必需的,后面有相关的消融实验

实验结果

实验设置

训练数据:从LAION等大型公开英文数据集中提取了20万张图片,采用自动和人工过滤组合方式进行清洗。这批图除了内容描述文本外,还会标注不同美学维度(如色彩、光影、构图、重心等)的分类标签,用来作为训练过程中的额外条件。

训练设置:SD1.5和SDXL的学习率分别设置为1e−4和1e−5。Batch size设置为256,实验中的总训练步数为50,000。在推理阶段,使用DDIM采样器进行采样25步,CFG为7.5,不使用反向提示词。

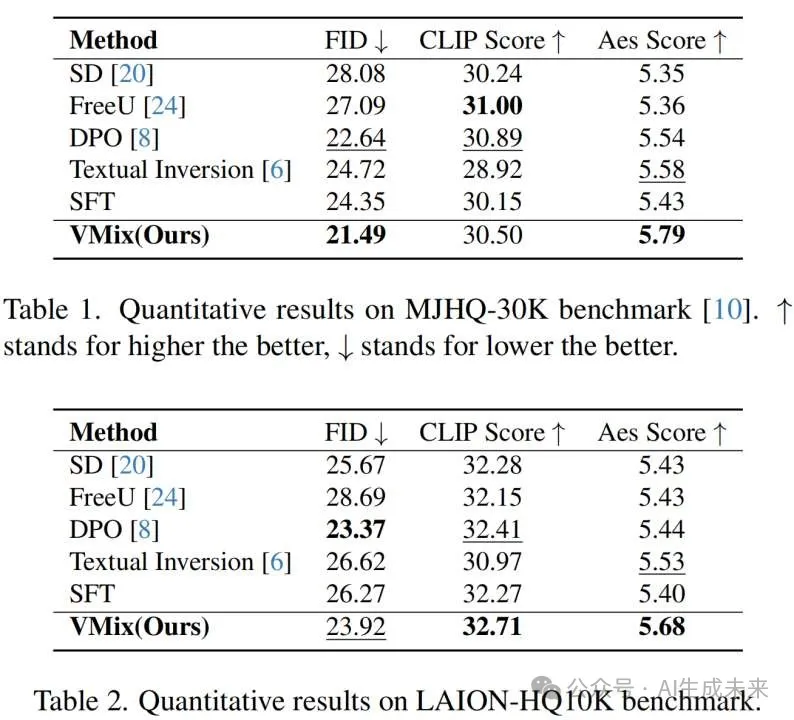

评估细节:除了使用MJHQ-30K数据集进行评估外,额外构建一个只包含高美学和高分辨率图片的LAION-HQ10K数据集,使用FID、CLIP Score和Aes Score衡量生成图像的整体质量。

结果

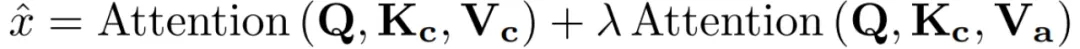

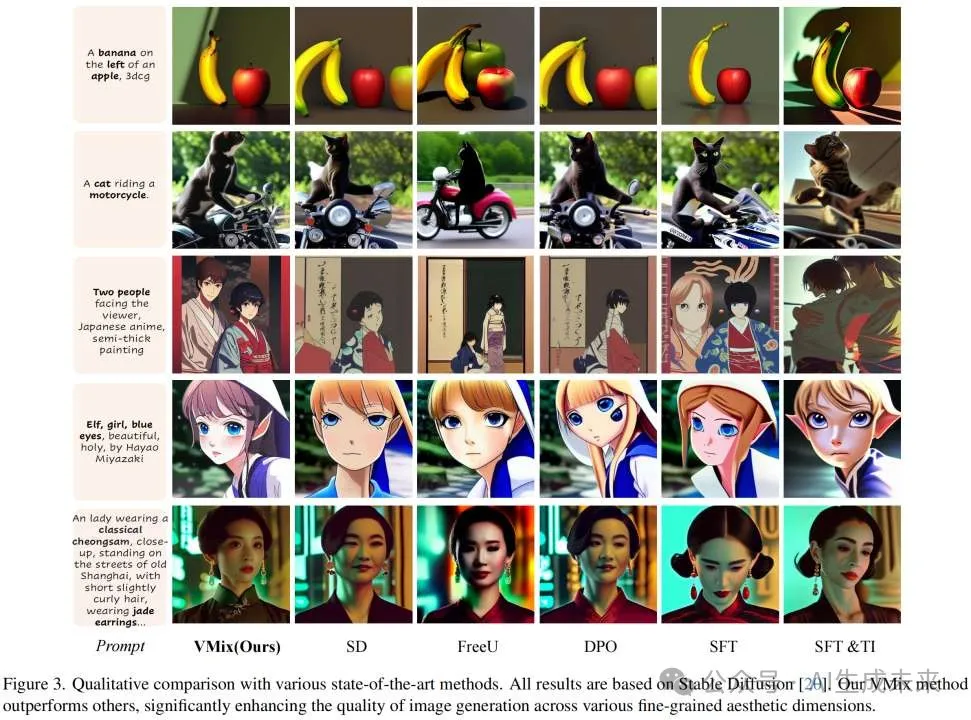

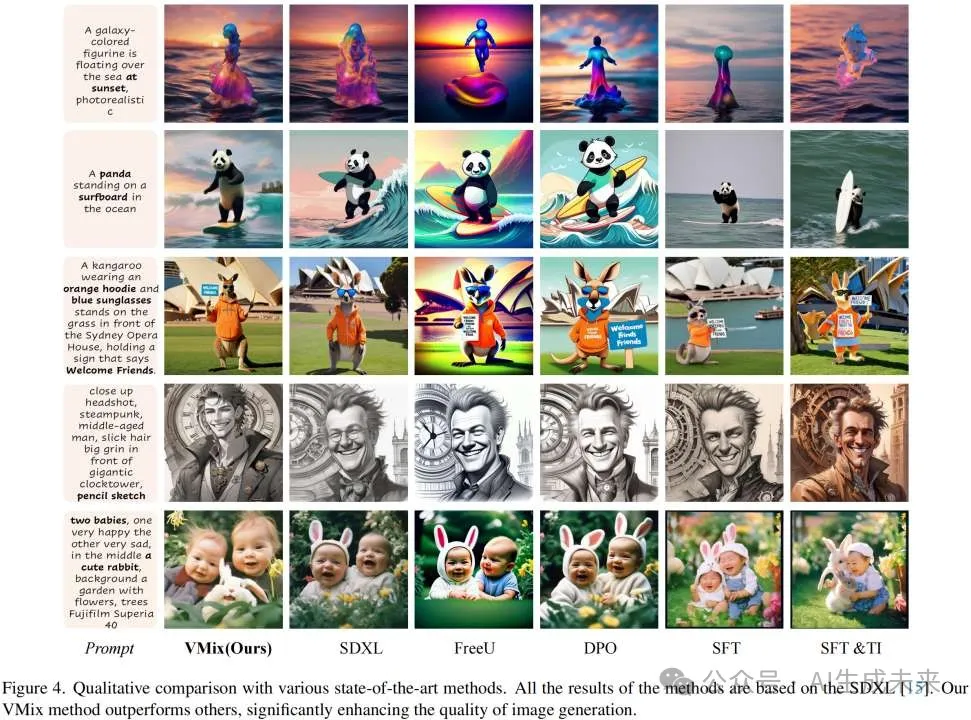

定性比较:在视觉效果上,VMix显著优于其它方法,并且与使用同样训练集的SFT方法比,VMix的效果更好,从而验证了条件注入的有效性,同时对高质量数据进行消融。此外,VMix作为插件可以直接应用于开源模型,提升它们的美学表现。

SD1.5上不同方法的比较

SDXL上不同方法的比较

应用于开源模型的效果

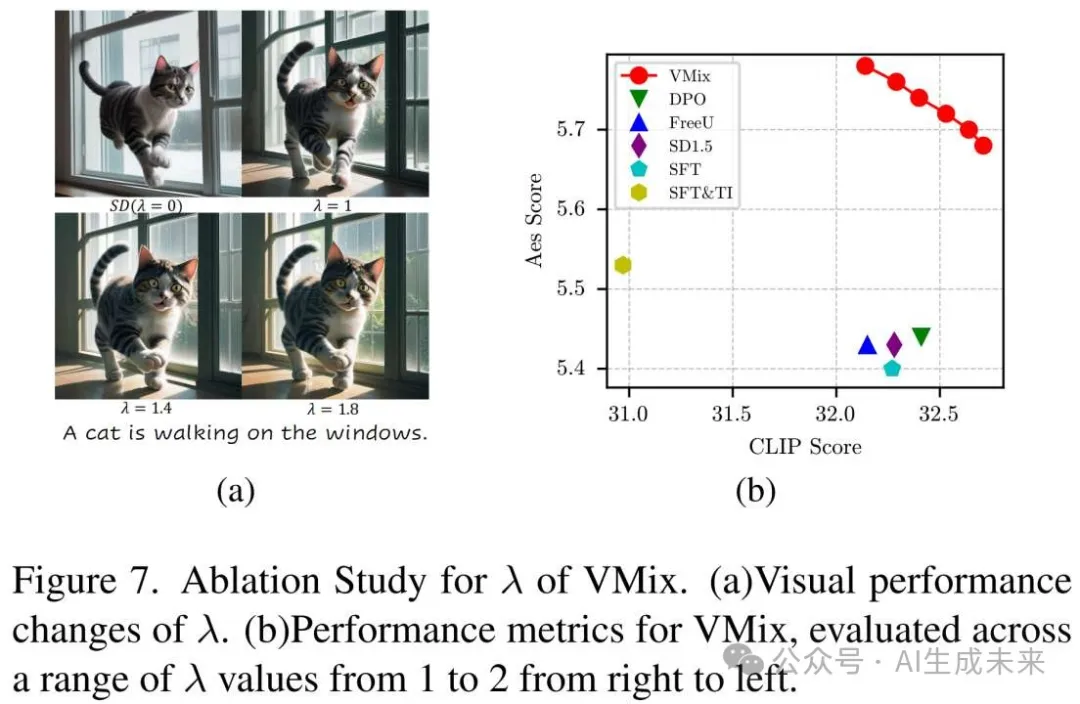

定量指标:VMix模型有着最高的Aes Score,并且可以看到基模的图文匹配能力并没有受到影响,甚至条件解耦后模型相较普通SFT方式更容易在高质量数据集上收敛。推理阶段随着增大,图片美感也会随之提升。

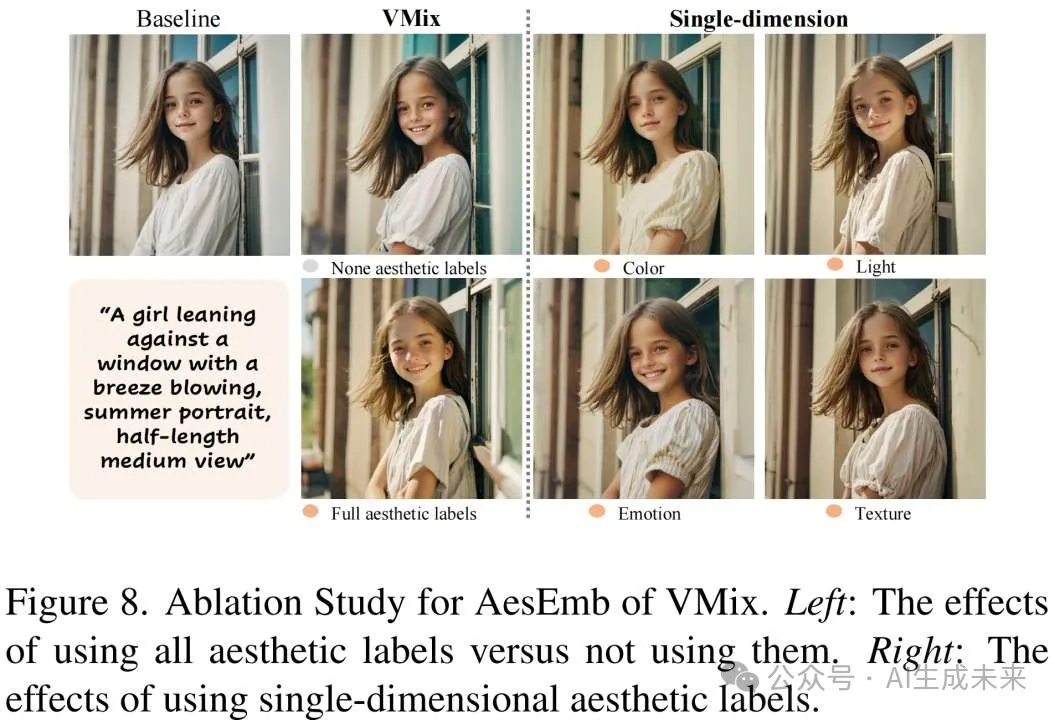

消融实验:文中进一步分析了AesEmb不同维度对生成结果的影响,可以看到不同美学维度都能明显改善图片质量,当一起使用时效果最好;文中还对对LoRA的使用进行了消融,从而验证模型性能的提升主要来自VMix本身。

结论

这项研究提出了VMix,它通过引入美学标签(光影、色彩、构图等)作为额外的条件,并采用交叉注意力混合控制方法来增强模型在各种美学维度上的表现。论文发现,让模型对齐人类期望的最关键因素之一是使用适当的条件控制方法,在解耦的细粒度美学标签下进行训练。受此启发,论文提出了一种有效的条件控制方法,显著提高了模型的生成质量。广泛的实验验证了VMix在文本忠实度和视觉美学方面超越了其他最先进的方法。作为一个即插即用的插件,VMix可以与开源模型无缝集成,提升审美表现,从而进一步推动社区的发展。

本文转自AI生成未来 ,作者:AI生成未来