ACL2024 | 利用GPT4构建的多Agent系统自动发现科学假设

今天分享一篇来自南阳理工的一篇文章《Large Language Models for Automated Open-domain Scientific Hypotheses Discovery》。本研究的目标是探索如何使用大型语言模型,尤其是GPT-4,来自动发现科学假设。目前假设性归纳研究的局限性在于使用的数据不是原始网络语料库,而是手动选择后的句子,导致了来源较为封闭;同时,现有的假设标注大多是常识性知识,任务挑战性不足。本文提出了首个针对社会科学学术假设发现的自然语言处理(NLP)数据集,该数据集包含了50篇最新发布于顶级社会科学期刊的论文,以及发展这些论文中假设所必需的原始网络语料库。同时提出了一个MooSE框架,验证了利用GPT4构建的多Agent系统直接从web raw corpus自动发现科学假设的可行性。

图片

图片

• Title: Large Language Models for Automated Open-domain Scientific Hypotheses Discovery

• URL: https://arxiv.org/abs/2309.02726

• Code: https://github.com/zongliny/moose

1 Motivation

• 假设归纳被认为是科学家对世界进行观察并尝试提出假设来解释这些观察结果时的主要推理类型。现有的假设归纳研究有两个局限

a.受限于人工选定的句子,而非原始网络语料,导致其来源较为封闭;

b.现有研究中的ground truth假设多为常识性知识,使得任务挑战性降低。

• 如何基于最原始网络语料,自动观察并提出对人类而言都是全新的科学假设非常有意义。

2 Methods

这篇论文首次提出了一个用于社会科学学术假设发现的自然语言处理(NLP)数据集,并尝试实现一个MOOSE框架去解决该问题。

数据集特点:

• 该数据集由50篇最近发表在顶级社会科学期刊上的论文组成。

• 收集了提出这些论文中假设所需的原始网络语料库。

最终目标:是创建一个系统,只给予一堆原始网络语料库,便能自动生成有效、新颖且对人类研究者有帮助的假设。

2.1 数据集步骤

1. 选择论文:从顶级社会科学期刊选择50篇在2023年1月之后发表的论文。涵盖社会科学如心理学、人力资源管理、信息系统等领域。

2. 专家标注:对于每一篇选定的论文,社会科学研究领域的专家会收集其主要假设,并识别其背景和灵感来源(background + inspirations -> hypothesis) => reasoning process。然后,专家们会在网络语料库中找到与这些背景和灵感相似的内容,并收集每个匹配内容的完整段落,这些段落作为原始网络语料库的一部分。

3. 避免数据污染:没有直接复制论文的背景和灵感,尝试在raw web courpus中找到语义上相似的文本内容作为替代。以实现本文提到的从raw web corpus提出research hypotheses的目标。

4. 收集相关材料:还收集了所有50篇论文的链接,以及相关的14篇survey文章(这些survey论文可能有助于检查假设的新颖性)。

5. 数据集构建:最终,这个数据集完全由一位社会科学研究领域的博士生构建完成。文档中提到,由于数据集涉及许多手动选择过程,因此这些手动选择的内容更多地被用作基准人类性能的比较。

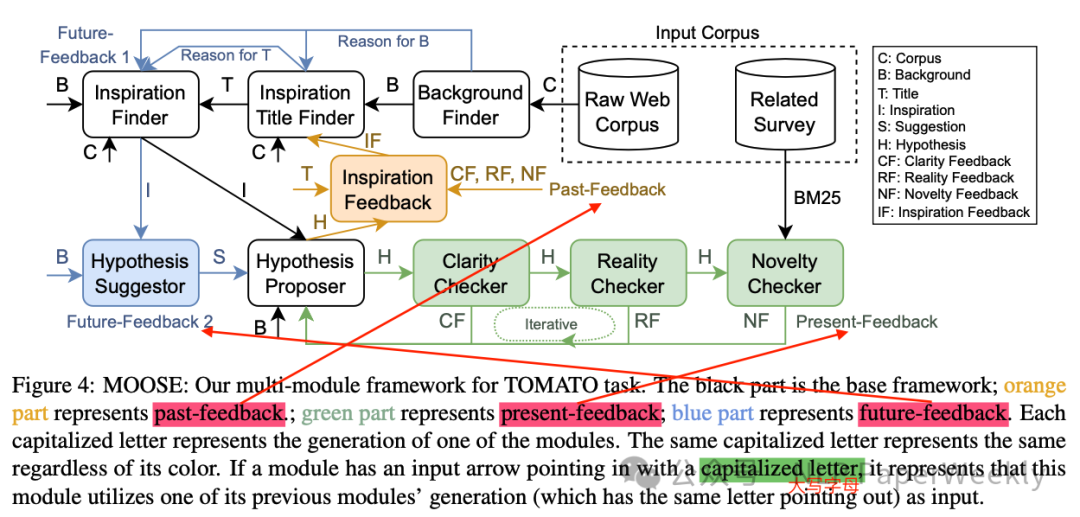

2.2 MOOSE框架介绍

MOOSE(MultimOdule framewOrk with paSt present future feEdback)的多模块框架,用于自动化开放领域科学假设的发现(TOMATO任务)。其特点是结合了大型语言模型的生成能力和复杂的反馈机制,以自动化地从大量文本数据中发现和提炼出可能对科学研究有价值的新假设。

整体框架:

1. 基础框架(MOOSE-base):MOOSE框架的核心是一个基础多模块框架,它模拟了社会科学研究者提出初始研究假设的过程。这个过程包括以下几个步骤:

• 背景发现器(Background Finder):模块通过阅读原始网络语料库来寻找合适的研究背景。

• 灵感标题发现器(Inspiration Title Finder):在找到背景后,模块搜索与背景相关的标题,以帮助找到可能的灵感来源。

• 灵感发现器(Inspiration Finder):根据选定的标题,模块在相关文档中找到能够启发假设形成的句子或段落。

• 假设提议器(Hypothesis Proposer):利用背景和灵感来提出研究假设。

2. 反馈机制:为了提高生成假设的质量,MOOSE框架引入了三种反馈机制:

• 即时反馈(Present-Feedback):当某个模块的输出可以被直接评估时,通过其他大型语言模型(LLMs)提供反馈,模块可以根据反馈和之前的生成结果进行再生成,以改进输出。

• 过去反馈(Past-Feedback):在无法直接评估某个模块的输出时,框架继续运行直到生成可以评估的输出,然后利用这些信息为之前的模块提供反馈(例如生成Inspiration Title时,可能没法直接评价好坏,可以等依赖Inspiration Title生成具体Hypothesis后,通过评估Hypothesis质量反推当时生成Title的效果)。

a.说明:在文中提出的MOOSE框架中,Past-feedback被应用于Inspiration Title Finder模块。Inspiration Title Finder的任务是从大量文本标题中找出可能对形成科学假设有启发性的标题。然而,直接评估这些标题的质量和相关性可能比较困难,因为它们是否能够激发出有意义的假设还未知。因此,系统会先继续运行,直到生成一个假设(hypothesis),这个假设受到之前选择的标题的影响,并且可以被直接评估。然后,系统会使用这个假设和它的评估结果作为反馈,来改进之前选择的标题。如果一个假设经过评估被认为是新颖且合理的,那么可以推断出启发这个假设的标题是合适的,反之亦然。通过这种方式,系统可以在未来的迭代中选择更好的标题,以提高最终假设的质量。Past-feedback的关键在于,它允许系统从未来的评估中学习,并利用这些知识来改进过去的决策,这在某些复杂的生成任务中是非常有用的。

b.未来反馈(Future-Feedback):为后续模块提供额外信息,帮助它们生成更高质量的输出。包括提供输出的理由(FF1)和在关键模块前插入一个辅助模块来分担推理负担(FF2)。

1. Future-feedback-1 (FF1): 这种类型的反馈机制涉及到为后续模块提供当前输出的解释或理由。不仅仅是提供生成的假设本身(oi),还提供生成这些假设的理由或解释,这样后续模块(Mj,j>i)就可以更好地利用这些信息。例如,在MOOSE框架中,Background Finder和Inspiration Title Finder模块被修改为不仅生成背景或标题,还提供选择它们的理由。这样做的目的是帮助后续模块更全面地理解所提供的信息,并在此基础上生成更深入、更有针对性的假设。

2. Future-feedback-2 (FF2): 这种类型的反馈机制涉及到在关键模块之前插入一个额外的模块,以分担一些推理负担。例如,在MOOSE框架中,Hypothesis Proposer模块负责提出假设,这是一个复杂且重要的任务。为了提高这个模块的输出质量,框架在Hypothesis Proposer之前引入了一个Hypothesis Suggestor模块(作为Mj−0.5),它的任务是提供初步的建议,如何利用背景和灵感来构建假设。然后,Hypothesis Proposer模块可以根据这些建议进一步发展出更新颖、更复杂的假设。(看着有点像COT的思考过程)

• Future-feedback是文中提出的另一种反馈机制,旨在为未来的模块生成提供额外有用的信息,以提高生成质量。具体来说,Future-feedback关注于如何帮助后续模块更有效地利用当前模块的输出来生成更高质量的结果。在MOOSE框架中,Future-feedback分为两种类型:Future-feedback-1 (FF1) 和 Future-feedback-2 (FF2)。总结:Future-feedback的目的是增强模块间的协作,通过提供额外的解释、理由或初步建议,帮助后续模块更有效地利用前一个模块的输出,从而提高整个系统生成假设的质量和新颖性。

特点:

• 模块化设计:MOOSE框架采用模块化设计,每个模块负责一个特定的任务,并且可以独立优化和改进。

• 迭代反馈:通过引入反馈机制,MOOSE框架能够不断迭代和改进生成的假设,提高了假设的质量和新颖性。

• 自动化和开放领域:MOOSE框架旨在自动化地从开放领域的原始网络语料库中生成科学假设,无需人工干预。

• 多方面评估:MOOSE框架不仅关注假设的新颖性,还包括有效性、一致性和清晰度等多个评估方面,以确保生成的假设对科学研究具有实际帮助。

3 Conclusion

• 构建了一个领先的NLP数据集,适用于开放域的科学假设发现。

• 提出了多模块框架MOOS以及三种反馈机制,有助于提高假设生成的效果,验证了从网络raw corpus生成科学假设的有效性。

二、详细内容

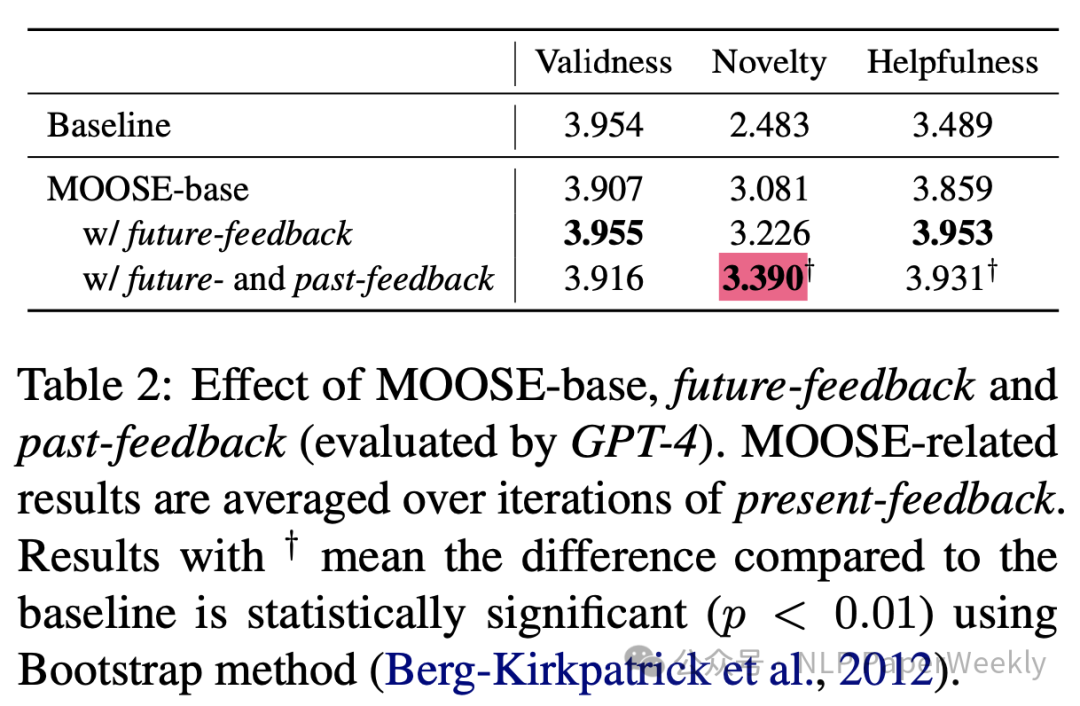

1.FeedBack模块对最终生成结果的影响

GPT4评估结果

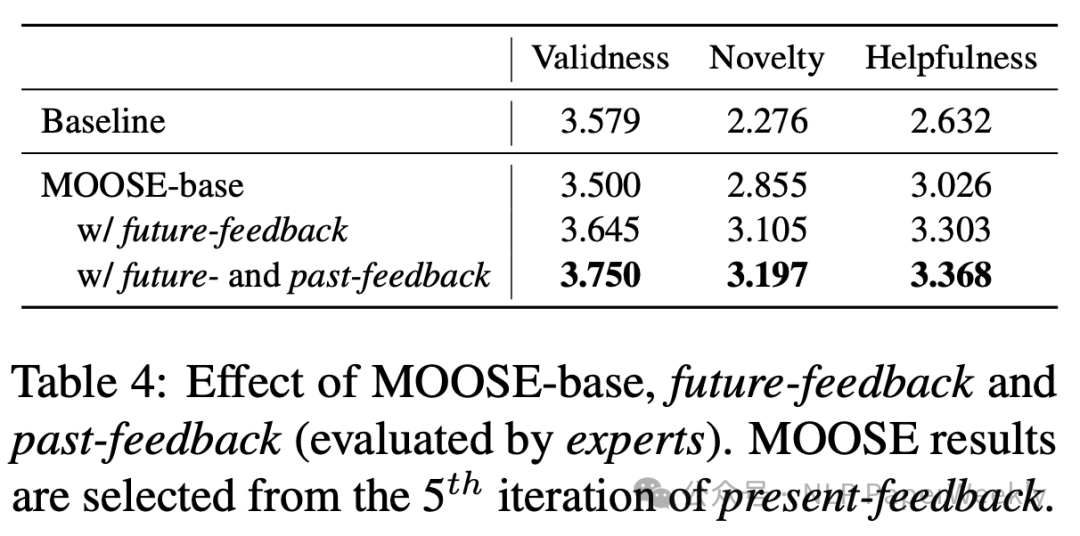

人类专家评估结果:

结论1:MOOSE-base 在新颖性和有帮助性方面表现优于基线模型,但在有效性方面略低。

结论2:加入未来反馈的MOOSE能提升整体表现。 所有指标都有所提升。

结论3::同时加入未来反馈和过去反馈的MOOSE在新颖性方面有显著提升。可能意味着过去反馈更侧重于提升假设的新颖性,但可能以牺牲一定程度的有效性和有帮助性为代价。

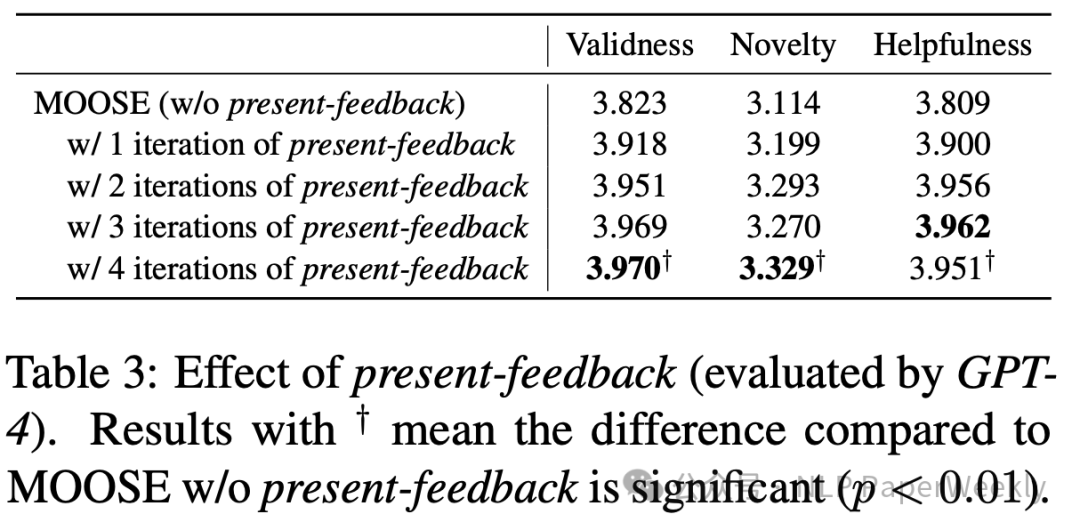

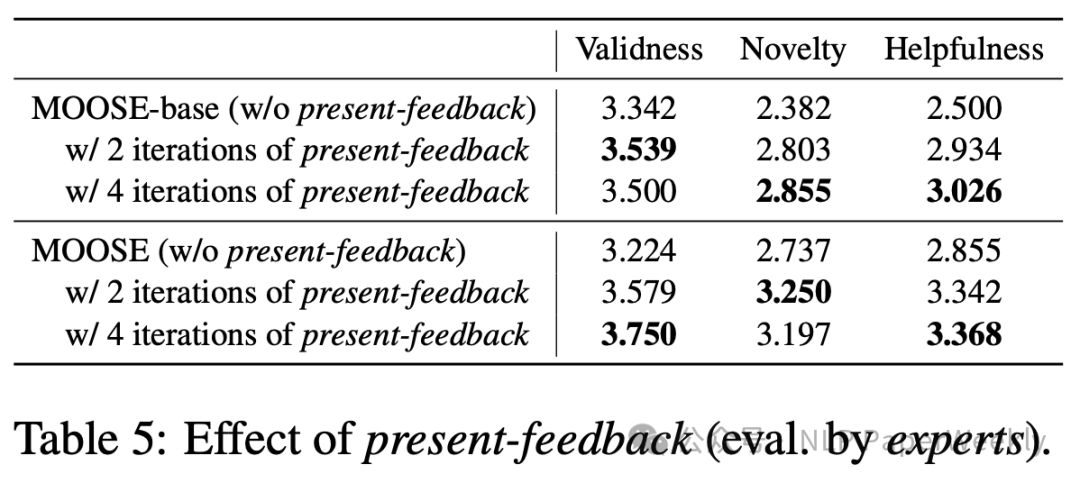

2.Present-feedback迭代次数对性能的影响(GPT4)

GPT4评估结果

人类专家评估结果:

结论1:present-feedback对于提高假设生成系统的性能是有效的,可以显著提高生成假设的有效性、新颖性和对研究人员的帮助程度。

结论2:随着反馈迭代次数的增加,性能提升效果持续,但可能存在一个最佳的迭代次数,超过这个次数后性能提升的边际效益可能减少。

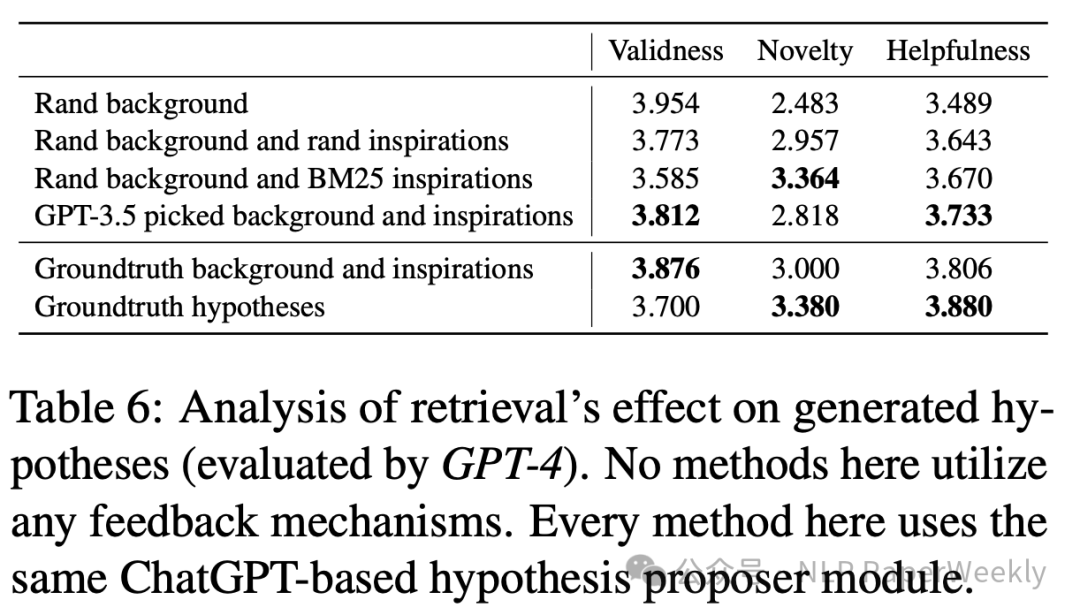

3 background选择方法和Inspirations选择方法对实验结果的影响

实验设置:

1. 目的:分析不同的背景(background)和灵感(inspirations)检索方法对于最终生成的科学假设的质量有何影响。

2. 检索方法:

• 随机选择背景和随机选择灵感(Random background and rand inspirations)。

• 随机选择背景和使用 BM25 算法选择灵感(Rand background and BM25 inspirations)。

• 使用 GPT-3.5 选择背景和灵感(GPT-3.5 picked background and inspirations)。

实验结论:

结论1: 选择背景和灵感的方法对生成假设的有效性、新颖性和有帮助性有显著影响,随机选择背景和灵感能够产生相对新颖的假设,但有效性和有帮助性较低。

结论2: BM25 在新颖性方面表现较好,而真实背景和灵感在有效性和有帮助性方面表现最佳。

结论3: GPT-3.5挑选的背景和灵感在有帮助性方面表现最佳,且在新颖性方面也表现不错。

结论4: 利用Groundtruth background and inspirations生成的Hypotheses与真实的Hypotheses相比,新颖性方面得分并不高但是Validness比较高,可能是因为它们基于已有的研究成果。说明可能需要在Novelty和Validness之间找到平衡。

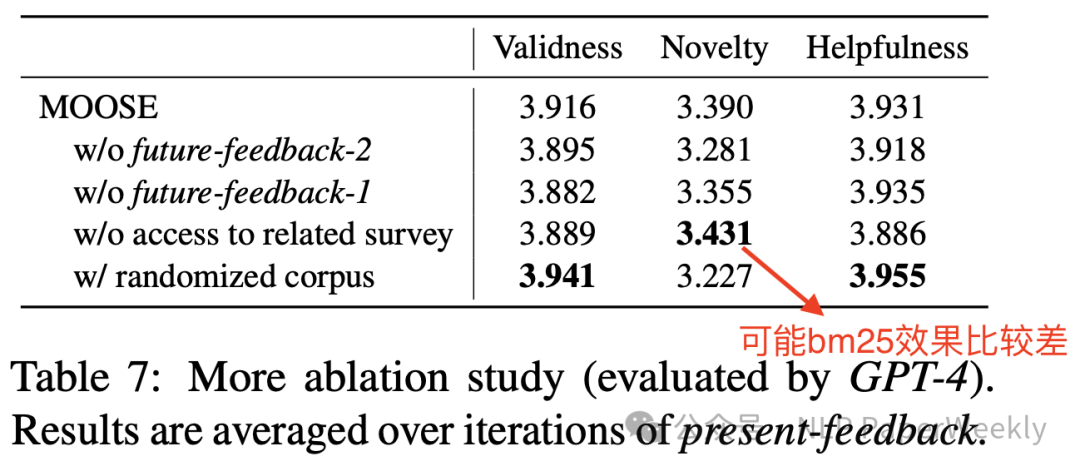

4.其他消融实验

结论1: Future Feedback(特别是 FF2),对假设生成的质量有显著影响,能够提高新颖性和有效性。

结论2: 引入related survey对新颖性评估有重要影响,切断与相关调查的访问会提高新颖性。 因为BM25检索到的相关调查内容较少,导致新颖性检测器倾向于认为假设是新颖的。

结论3: 语料库的选择和使用方式也会影响生成假设的新颖性和有效性。使用randomized corpus策略选择数据,有效性得分略有提高,而新颖性得分下降。这可能是因为在这种设置下,MOOSE 倾向于选择与背景相同灵感语料库的灵感,导致结果不够新颖。

• 先前的实验:background passages -> backgrounds and inspirations passages -> inspirations

• w/ randomized corpus : inspiration corpus -> background, inspiration and background corpus -> inspiration extraction

三、总结

这篇论文提出了首个用于社会科学学术假设发现的NLP数据集,并开发了一个多模块框架MOOSE以及三种不同的反馈机制,用以自动地生成科学假设。该方法不仅提高了生成假设的质量和新颖性,也验证了大型语言模型在科学研究中自动化发现新假设的潜力。

结论1: 该研究首次发布了开放域科学假设发现的NLP数据集,填补了现有领域中的空白。

结论2: 论文提出的多模块框架和三种反馈机制(Present、Future、Past)显著提升了假设生成的性能,在多项评估中表现优异。

结论3:在生成科学假设时通常会遇到的一个权衡问题,即有效性(validness)与新颖性(novelty)之间的权衡。通常如果一个方法或系统在生成假设时达到了高新颖性,那么它很难同时达到高有效性。

本文转载自 NLP PaperWeekly,作者: NLP PaperWeekly