什么是序列到序列(Seq2Seq)模型?以及为什么图像理解领域主要使用的是CNN网络而不是Transformer网络? 原创

“ 大模型的核心点就在于特征的提取和重建,大模型技术的所有一切都是为了这个核心点服务 ”

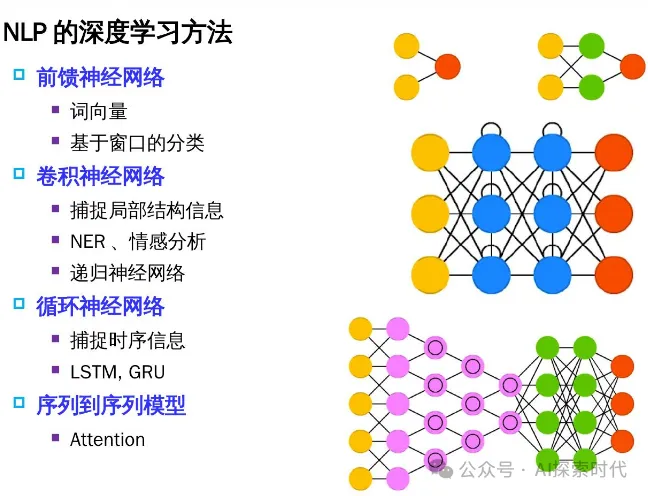

对大模型有过了解的人应该都知道Transformer架构,而且也知道这个架构在NLP(自然语言处理)领域大放异彩;但是为什么Transformer架构能在NLP领域大放异彩,以及为什么图像理解领域使用的是CNN网络,而不是Transformer网络?

当然,这句话有点片面,目前基于Transformer架构在图像处理领域也逐渐变得越来越重要。

序列到序列——Seq2Seq

先来回答一个问题,什么是序列到序列——Seq2Seq? 什么又是序列到序列模型?

就拿自然语言处理来说吧,什么是自然语言?自然语言就是随着文化自然演化的语言,比如我们汉语,现代的汉语与古代的汉语就不完全一样;现代汉语虽然脱胎于古汉语,但又在进化的过程中,融入了新的元素;古英语也是类似情况。

语言的主要特点是什么?

语言主要特点就是其表达方式,比如说英语是表音型语言,而汉语是表意型语言;其语言结构和特点是不一样的。

但从语言的本质上来说,不论是表音语言或者表意语言;语言的目的是为了表达人类的思想和行为。因此,表音语言也好,表意语言也罢,最重要的是表达语义,也就是我们说话的意思、含义。

当然,这时你可能会有疑问,这个和序列到序列有什么关系?

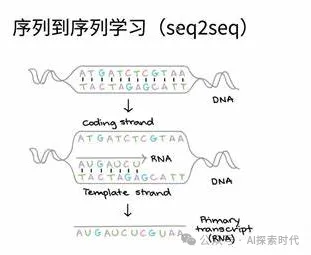

语言就是一个序列性的内容,因为它是连续的,在不同的上下文中,同一句话具有不同的含义;而在自然语言处理领域,大模型即需要去理解语言,也需要去生成新的语言(这就是之前文章中讲的编码器和解码器的作用,编码器通过模态提取来理解语言,通过解码器来生成语言)。

而类似于这种具有关联关系的内容领域,就属于序列到序列处理;因为它需要理解一个序列,又需要生成一个新的序列。而序列到序列这个名词的来源是因为在英文中这个叫做Sequence to Sequence,而直译过来就成了序列到序列。

因此,序列到序列的本质是描述一种具有连续性关系的生成模型;除了自然语言处理之外,还广泛应用于机器翻译,语音识别,视频处理等领域;简单来说,凡是具有连续关系的领域,都可以使用Seq2Seq的处理方式。

说到这里,可能很多人已经想明白了为什么在图像处理领域使用的是CNN(卷积神经网络),原因就在于图像是一个不连续的过程;因为每张图片都是一个独立的个体,它和别的图片没有直接连续关系。如果图片有了连续的关系,那么它就不再是图片,而是变成了视频。

当然,自然语言出来远没有想象中的那么简单,即使编码器和解码器也是有复杂的神经网络层构成。而且,随着技术的发展Transformer架构也在不断地进化,其在处理图像这种非序列化数据时,能力也得到了巨大的增强。

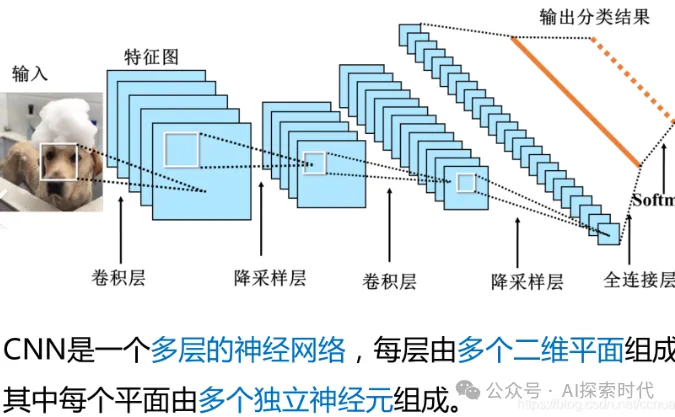

为什么CNN擅长处理图像数据?

在大模型技术中,不论什么模型最重要的两个功能点就是特征提取和特征重建;简单来说就是先理解(学习),再生成。

而图像的本质就是一堆像素点,其特征提取本质上来说就是获取这些像素点之间的关系;因此,卷积就成了图像理解的最佳实践方案之一,原因就在于卷积能够很好的描述像素之间的关系;通过卷积能够对图像进行多重变换,以此来获取到足够的特征数据。

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/kxrRIgDRekjzGMrBB9EZeQ