回复

微软:GPT-4o-mini只有8B,o1-mini仅100B

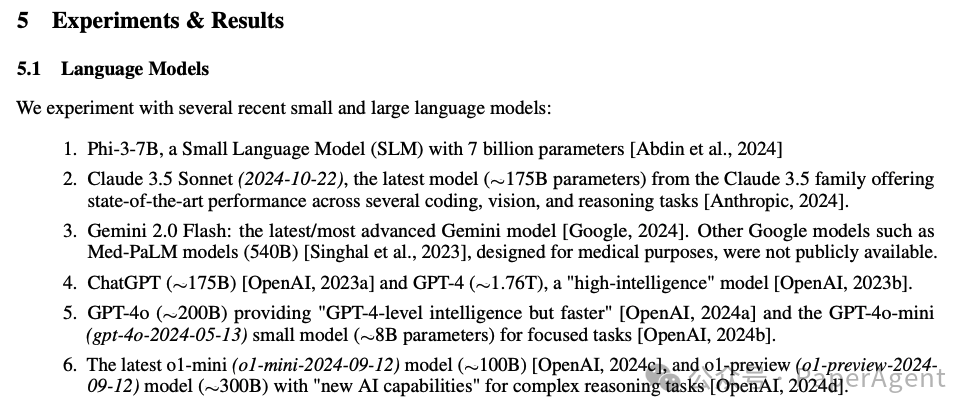

关于主流闭源LLM的参数规模一直讨论不断,在2024年最后2天来自微软的一篇关于检测和纠正临床笔记中医疗错误的测试基准MEDEC的研究一不小心直接漏了它们的参数规模:o1-preview, GPT-4,GPT-4o和Claude 3.5 Sonnet。

- Claude 3.5 Sonnet(2024-10-22),~175B

- ChatGPT,~175B

- GPT-4,约1.76T

- GPT-4o,~200B

- GPT-4o-mini(gpt-4o-2024-05-13)只有8B

- 最新的o1-mini(o1-mini-2024-09-12)仅100B

- o1-preview(o1-preview-2024-09-12)~300B

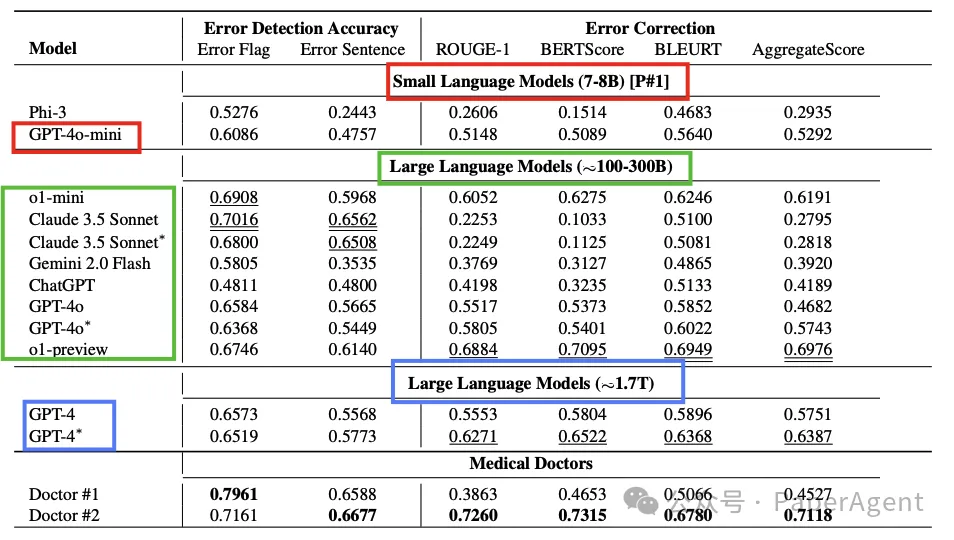

实验部分也是将大模型参数规模分为3挡:7-8B,~100-300B,~1.7T,而GPT-4o-mini被分在第一档,只有8B着实让人有点不可思议~

PromptWizard 概述

https://arxiv.org/pdf/2412.19260v1

MEDEC: A BENCHMARK FOR MEDICAL ERROR DETECTION AND CORRECTION IN CLINICAL NOTES本文转载自PaperAgent

已于2025-1-2 15:42:52修改

赞

收藏

回复

相关推荐