阿里巴巴语音实验室发布新成果,多模态方法显著提升视频主题分割性能

随着数字视频内容的爆炸式增长,如何有效地进行视频主题分割成为了一个亟待解决的问题。视频主题分割的目标是将视频内容按主题进行划分,以便更好地理解和管理视频信息。这不仅在视频检索和推荐系统中起到关键作用,还能提升视频编辑和生成摘要的效率。在教育和娱乐领域,视频主题分割同样能够极大地促进内容分类和个性化推荐。

在视频内容分析领域,多模态数据的融合和一致性建模是当前的研究热点。多模态数据包括视频中的视觉、音频和文本信息,通过融合这些信息,可以更全面地理解视频内容。然而如何有效地融合多模态数据,并在此基础上进行一致性建模,仍然是一个具有挑战性的研究课题。现有方法主要依赖于单一模态的数据,无法充分利用视频中的多模态信息。此外现有方法在处理长视频和复杂视频内容时,往往表现出较大的局限性,难以保证分割的准确性和一致性。

视频主题分割在许多应用场景中具有重要意义。例如,在视频检索和推荐系统中,精确的主题分割可以提高检索和推荐的准确性;在视频编辑和摘要生成中,主题分割可以帮助自动生成视频摘要,提高编辑效率。此外在教育和娱乐领域,视频主题分割也可以用于内容分类和个性化推荐,为用户提供更好的观看体验。

目前,视频主题分割的方法主要包括基于视觉特征的方法、基于音频特征的方法和基于文本特征的方法。然而这些方法通常只利用单一模态的数据,无法充分利用视频中的多模态信息。此外,现有的方法在处理长视频和复杂视频内容时,往往表现出较大的局限性,难以保证分割的准确性和一致性。近日,来自阿里巴巴语音实验室的研究团队提出了一种改进的多模态融合和一致性建模方法,用于视频话题分割(VTS)任务,并引入了一个大规模的中文讲座视频数据集 CLVTS,以促进 VTS 领域的研究。12 月 30 日,他们更新了论文《Multimodal Fusion and Coherence Modeling for Video Topic Segmentation》V2版并发表于arXiv。

该研究由一支在多模态数据处理和视频内容分析领域具有丰富经验的团队完成。团队成员具有深厚的学术背景和丰富的研究经验。他们在多模态数据融合、一致性建模和视频内容分析等方面取得了多项重要成果,为研究工作的顺利开展提供了坚实的基础。

研究目标

这个领域充满挑战性,如何有效地进行视频主题分割成为了一个重要的问题。现有的方法往往难以在处理复杂和长视频内容时保持高效性和准确性。针对这一问题,研究团队提出了一种新颖的多模态融合和一致性建模方法,旨在通过更好地整合视频中的多模态信息,提高视频主题分割的准确性和鲁棒性。

提出多模态融合和一致性建模的新方法

多模态数据的融合和一致性建模是提高视频主题分割效果的关键。在这项研究中,研究团队引入了多种新的方法和技术,旨在优化多模态信息的整合和处理。

首先研究团队提出了一种新的多模态融合方法,利用了视觉、听觉和文本三种模态的信息。这种融合方法不仅能够捕捉视频中的视觉特征,还能结合音频和文本数据,实现对视频内容的全面理解。研究团队通过引入交叉注意力(Cross-Attention)和专家混合(Mixture of Experts)等技术,进一步提升了多模态信息融合的效果。

为了增强多模态的一致性建模,研究团队设计了一种新的预训练任务和微调任务。这些任务通过多模态对比学习(Multimodal Contrastive Learning)来强化不同模态之间的对齐和融合,从而提高模型在处理复杂视频内容时的表现。

提高视频主题分割的准确性和鲁棒性

通过这些创新的方法和技术,研究团队在多个方面提升了视频主题分割的效果。在多模态融合方面,通过探索不同的架构和模型预训练方法,研究团队显著提高了不同模态信息的对齐和整合效果。通过引入新的预训练和微调任务,研究团队不仅增强了多模态数据的融合,还提升了模型在捕捉视频中主题转换细节方面的能力。

此外,研究团队还通过在教育视频数据集上的大量实验,验证了所提出方法的有效性。实验结果表明,新的多模态融合和一致性建模方法在准确性和鲁棒性方面均优于现有的无监督和监督方法,展示了其在实际应用中的巨大潜力。

方法概述

多模态融合策略

在视频主题分割中,多模态信息的有效融合是实现准确分割的关键。研究团队提出了一种创新的多模态融合策略,结合视觉、听觉和文本三种信息,从不同层次上整合这些信息,以捕捉视频内容的复杂语义。

视觉信息在视频内容理解中占据重要地位。通过使用预训练的视觉编码器,研究团队提取视频中的关键帧特征。为了降低计算成本,视觉编码器的参数在训练过程中保持冻结状态,仅调整其他模块的参数。这种方法能够有效捕捉视频中的图像信息,为多模态融合提供基础。

听觉信息,如背景音乐、对话音频等,同样在视频理解中起到重要作用。研究团队通过自动语音识别(ASR)系统,将视频中的语音转换为文本,并将其作为听觉信息的代表。这种方法不仅能够捕捉到音频中的语言信息,还能够结合语音的语调和节奏,为多模态融合提供更多维度的数据支持。

文本信息主要包括视频中的字幕、屏幕文字等。研究团队使用预训练的文本编码器对这些文本信息进行处理,将其转换为特征向量。通过将文本信息与视觉和听觉信息结合,研究团队能够更全面地理解视频内容,实现更加准确的主题分割。

分层融合策略

在多模态融合过程中,研究团队采用了分层融合策略,将多模态信息在不同层次上进行整合。具体来说,研究团队探索了交叉注意力(Cross-Attention)和专家混合(Mixture of Experts)等多种架构。这些架构在不同层次上对多模态信息进行处理,通过交叉注意力机制,增强了各模态之间的信息交互和融合。专家混合机制则通过选择不同的专家模块,提高了模型的表达能力和鲁棒性。

一致性建模

为了进一步提升视频主题分割的效果,研究团队还引入了一致性建模方法。在预训练阶段,通过多模态对比学习任务,强化了不同模态之间的对齐和融合。在微调阶段,研究团队设计了新的对比语义相似性学习任务,通过选择正负样本对,增强了多模态表示学习的效果。此外,研究团队还提出了伪主题边界学习任务,利用无标签数据进行预训练,从而提高了模型在处理复杂视频内容时的表现。

相关工作

在探讨多模态融合和一致性建模方法在视频主题分割中的应用之前,有必要回顾一下现有的相关工作,包括文本主题分割、视频主题分割以及多模态融合和一致性建模方法的最新进展。

文本主题分割旨在将文本自动划分为一致且不重叠的段落,通过自动挖掘主题转换的线索来实现这一目标。早期的方法主要依赖于无监督学习,通过基于相似度的聚类算法来检测主题边界。近年来,随着大规模标注数据的积累和深度学习技术的发展,监督学习方法在文本主题分割中取得了显著的进展。这些方法通过建模长序列文本和增强一致性建模,能够捕捉到更长的上下文细节,从而实现更好的主题分割性能。

与文本主题分割类似,视频主题分割的目标是将视频内容划分为连贯的、不重叠的主题段落。然而由于视频内容的多模态性质,这一任务更加复杂。早期的方法主要依赖于浅层特征或无监督方法,如视觉特征的聚类等。然而这些方法在捕捉视频内容的语义转换方面表现较弱。随着深度学习技术的进步,监督学习方法逐渐成为主流,通过利用大规模预训练模型和多模态数据,这些方法在视频动作分割、场景分割和主题分割等任务中取得了优异的成绩。

在视频主题分割中,多模态融合方法至关重要。多模态数据包括视觉信息、听觉信息和文本信息,通过融合这些模态,可以更全面地理解视频内容。现有的多模态融合方法主要分为早期融合、中期融合和后期融合。早期融合在感知处理的早期阶段整合多模态信息,而中期融合则在特征级别进行整合,后期融合则在独立预测之后进行整合。研究表明,早期和中期融合由于更好地对齐人类感知过程,通常表现优于后期融合。在中期融合中,通过交叉注意力和专家混合等机制,可以进一步提升多模态信息的融合效果。

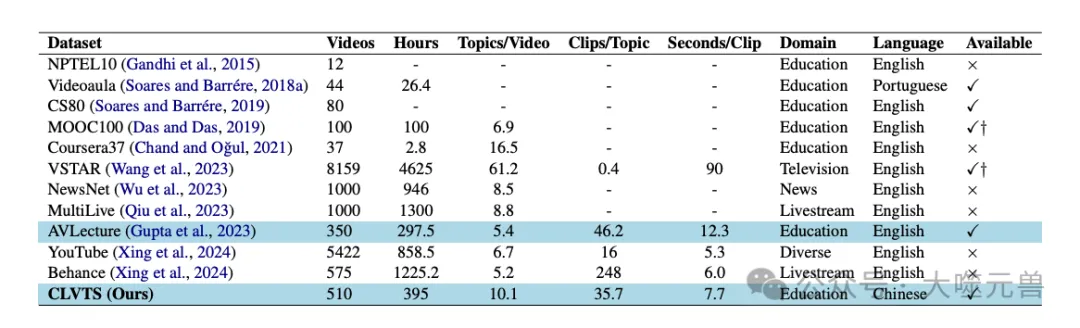

表1:研究团队的CLVTS数据集和现有视频数据集在视频主题分割任务中的比较。†表示数据并非完全开源。在研究团队工作之前,AVLecture是唯一一个支持监督VTS方法的公开可用的大规模视频数据集。

一致性建模是提高视频主题分割效果的关键。在文本主题分割中,增强一致性建模已被证明可以显著提高分割性能。类似地,在视频主题分割中,通过增强多模态数据之间的对齐和融合,可以提高模型在处理复杂视频内容时的表现。多模态对比学习是一种有效的方法,通过最大化相同片段的视觉和文本特征的余弦相似度,同时最小化不同片段的模态特征相似度,从而增强模态对齐。此外,通过引入对比语义相似性学习任务,可以进一步增强多模态表示的学习效果。

方法详细描述

多模态融合层架构

在视频主题分割任务中,多模态融合层架构是至关重要的一部分。研究团队提出了多种创新的融合架构,包括合并注意力、协同注意力和专家混合模块。这些架构在不同的层次上实现了多模态信息的高效整合和处理。

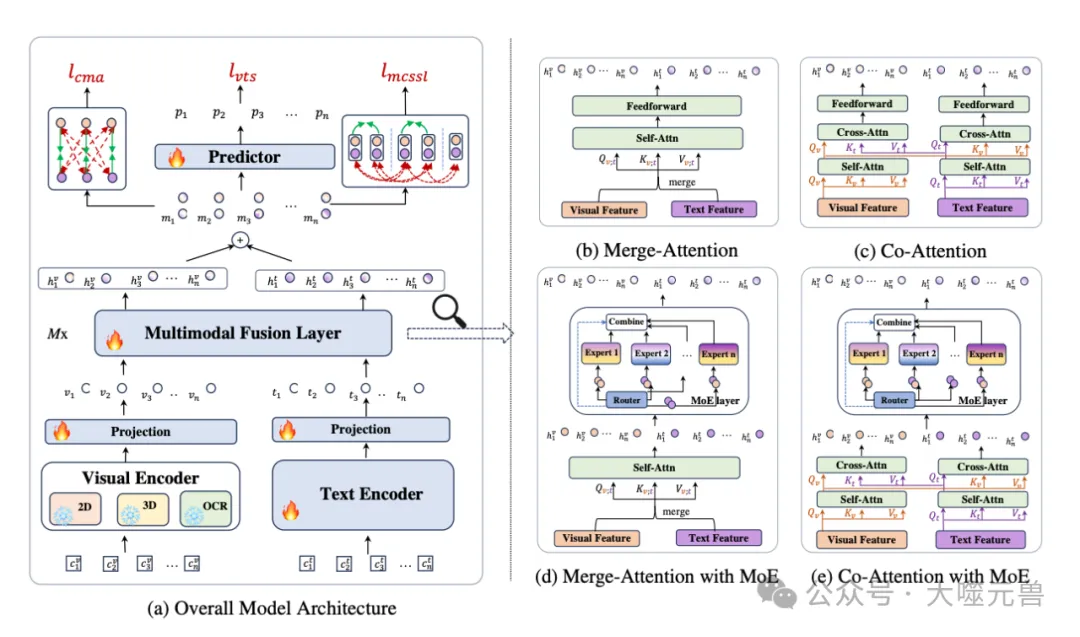

图1:MMVTS模型的总体架构和(a)中多模融合层的四种不同架构。在整体架构中,雪花符号表示某个模块的参数被冻结;而火焰符号表示可训练的模块。lmcssl模块中的蓝色虚线表示主题边界。lcma模块中的绿色实线表示特征被拉近,而红色虚线表示特征被推开。

合并注意力机制通过将来自不同模态的特征进行连接,然后输入到标准的Transformer编码器层中。该编码器层共享跨模态的注意力参数,从而实现特征的交互和融合。接着,通过添加前馈层生成最终的输出表示。这种方法能够有效地捕捉多模态信息之间的相互关系,并在高维空间中进行融合。

协同注意力机制首先对每个单模态编码器的特征进行自注意力处理,使用模态特定的注意力参数。然后,通过对称的交叉注意力机制,将所有其他模态的信息整合到当前模态的表示中,增强该模态的特征表示。最后,通过前馈层生成最终的融合表示。这种方法不仅考虑了单模态特征的内在关系,还增强了多模态特征之间的相互作用。

专家混合模块通过引入多个专家模块,进一步提升了模型的表达能力。具体来说,专家模块由多个多层感知器(MLP)组成,根据输入数据动态选择激活的专家。通过噪声Top-K门机制,从所有候选专家中选择K个专家,并线性组合激活专家的输出。这种方法不仅能够更深入地整合多模态信息,还在不显著增加计算复杂度的情况下,提高了模型的容量和鲁棒性。

预训练任务

在预训练阶段,研究团队设计了两种主要任务:跨模态对齐和伪主题边界学习。这些任务旨在通过无标签数据对模型进行初步训练,增强不同模态之间的对齐和融合。

跨模态对齐任务利用对比学习损失,最大化相同片段的视觉和文本特征的余弦相似度,同时最小化不同片段的模态特征相似度。通过这种方法,模型能够学习到多模态特征在相同主题下的一致性,增强模态之间的对齐和融合效果。

伪主题边界学习任务通过利用无标签数据,学习伪主题边界。具体来说,通过核密度估计(KDE)模型估计训练集中的主题持续时间分布,并基于此进行视频分段。在每个段落中,随机插入、替换或保留段落,以生成伪主题边界。这种方法能够让模型在预训练阶段学习到主题转换的特征,从而在后续的训练中表现更好。

微调任务

在微调阶段,研究团队设计了对比语义相似性学习和多模态一致性建模任务。这些任务进一步增强了模型对多模态数据的融合和一致性建模能力。

对比语义相似性学习任务利用主题相关的一致性特征,通过选择正负样本对,增强多模态表示学习效果。具体来说,选择相同主题内的相似片段和不同主题间的不同片段,计算其多模态表示之间的相似性。这种方法能够提高模型在不同主题下的区分能力,增强对视频内容的理解和分割效果。

多模态一致性建模任务通过进一步对齐和融合多模态特征,确保主题分割的一致性和连贯性。通过提升主题内多模态特征的相似性和主题间多模态特征的差异性,模型能够更好地捕捉视频内容的逻辑结构和语义变化。

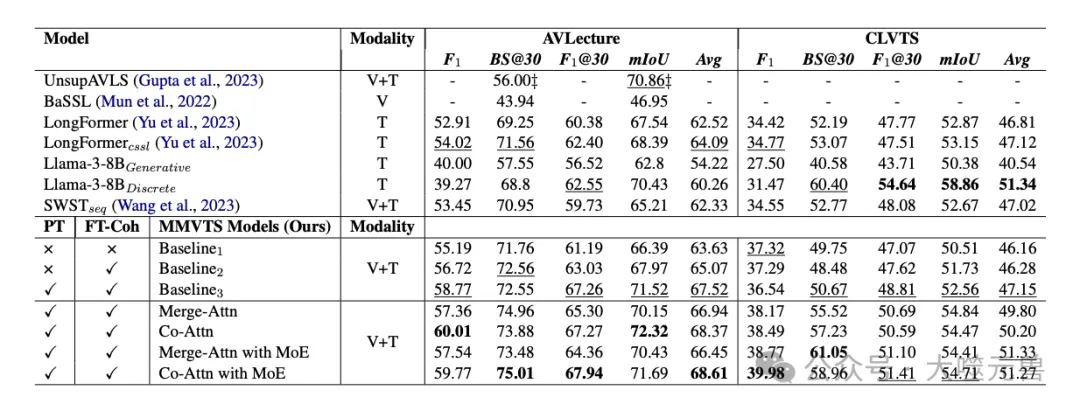

表2:AVLecture和CLVTS测试集上基线和研究团队的MMVTS模型的性能。‡表示地面真相主题号的泄漏。情态下的V和T分别表示视觉和文本情态。MMVTS基线1,2,3表示研究团队的MMVTS模型,不带多模态融合层。Attn表示注意。PT表示在微调之前,在未标记的数据(第3.2节方程式13)上对模型进行预训练。FT-Coh表示在微调期间添加两个辅助多峰相干建模任务(第3.3节方程15);w/o FT Coh指的是使用标准lvts进行微调(方程式5)。对于每个指标,所有模型中的最佳结果都以粗体显示,而每组中的最佳效果则以下划线显示。

实验设计

在研究工作中,为了验证多模态融合和一致性建模方法在视频主题分割任务中的有效性,研究团队进行了精心设计的实验。实验设计包括数据集的选择、实验设置以及评价指标的定义和使用。这些部分构成了实验的核心,确保实验结果的可靠性和可重复性。

数据集选择

研究团队选择了多个数据集,以全面评估所提出方法的性能和鲁棒性。主要数据集包括AVLecture和CLVTS。这两个数据集具有代表性,涵盖了不同语言和领域的视频内容。

AVLecture数据集主要包含英文讲座视频,这些视频内容丰富,涵盖了多种学科和主题。该数据集被广泛用于视频内容分析的研究,提供了详尽的标注信息,有助于评估视频主题分割模型的性能。

CLVTS数据集是研究团队新引入的一个大规模中文讲座视频数据集。与AVLecture数据集相比,CLVTS数据集具有更长的视频时长和更多的主题数。研究团队在数据收集和标注过程中,严格遵循伦理规范,确保数据的质量和可信度。通过引入CLVTS数据集,研究团队不仅丰富了现有的研究数据资源,还促进了中文视频内容分析的研究。

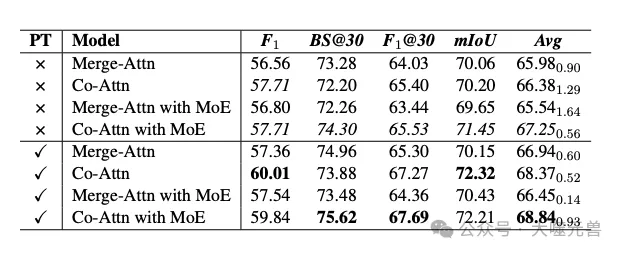

表3:AVLecture测试集训练前任务的消融研究。在微调中添加了两个辅助相干建模任务(方程式15)。对于平均值,研究团队报告了使用不同随机种子的三次运行的平均值和标准偏差。

实验设置

在实验设置方面,研究团队采用了多种技术和策略,以确保实验结果的准确性和公平性。首先,研究团队在模型训练过程中,使用了预训练和微调两种主要策略。预训练阶段,模型在无标签视频数据上进行训练,学习跨模态对齐和伪主题边界。微调阶段,模型在有标签数据上进行训练,进一步优化多模态一致性建模。

在具体实现方面,研究团队使用了多种多模态融合层架构,包括合并注意力、协同注意力和专家混合模块。这些架构在不同层次上对多模态信息进行处理,增强了各模态之间的交互和融合。此外,研究团队还设计了对比语义相似性学习任务,通过选择正负样本对,进一步提升多模态表示学习的效果。

为了评估模型的性能,研究团队在每个实验中使用了相同的超参数设置和训练策略,以确保实验的可重复性和公正性。具体的超参数设置和训练细节在附录中有详细描述。

评价指标

为了全面评估所提出方法的性能,研究团队采用了多种评价指标。这些指标包括F1得分、BS@30、mIoU和F1@30。

F1得分是一个综合评价模型精度和召回率的指标,通过计算模型预测的正确主题边界与实际边界的匹配情况来评估模型的整体性能。

BS@30(Boundaries at 30 seconds)是一个用于评价模型在特定时间窗口内检测主题边界准确性的指标,通过计算模型在30秒窗口内预测的边界与实际边界的匹配情况来评估模型的精度。

mIoU(mean Intersection over Union)是一个常用于语义分割任务的评价指标,通过计算预测分割结果与实际分割结果的重叠区域和总区域的比值来评估模型的分割精度。

F1@30是一个结合F1得分和时间窗口的评价指标,通过计算模型在30秒窗口内的F1得分来评估模型的时间敏感性和准确性。

通过使用这些评价指标,研究团队能够全面评估所提出方法在不同维度上的性能,验证其在实际应用中的有效性和鲁棒性。

实验结果与分析

在研究工作中,研究团队针对所提出的多模态融合和一致性建模方法,进行了系统而详尽的实验评估。实验结果展示了该方法在视频主题分割任务中的卓越性能,并通过与现有方法的对比,进一步验证了其有效性和优势。

基准数据集上的实验结果

在基准数据集AVLecture和CLVTS上的实验结果显示,所提出的多模态融合和一致性建模方法在多个评价指标上均表现出色。在AVLecture数据集上,使用协同注意力和专家混合(Co-Attention with MoE)架构的MMVTS模型取得了最佳的平均得分(Avg),在F1得分、BS@30、mIoU和F1@30等指标上均创下新的记录。

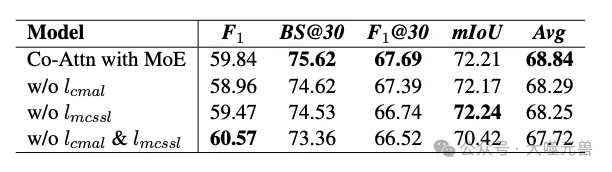

表4:AVLecture测试集上两个辅助相干建模微调任务的消融研究。模型从预训练开始初始化(方程式13)。

在CLVTS数据集上,尽管该数据集的挑战性更大,MMVTS模型仍然表现出色。在F1得分上,MMVTS模型相比之前的最佳模型有显著提升,显示了其在处理长视频和复杂视频内容时的强大能力。总体而言,实验结果表明,所提出的方法在中英文讲座视频数据集上均具有优越的性能。

与现有方法的对比

与现有的无监督和监督方法相比,所提出的多模态融合和一致性建模方法在各项指标上均表现出色。无监督方法如UnsupAVLS在精度上有所不足,而传统的视觉和文本模型如BaSSL和Longformer在多模态融合和主题分割精度上也不及MMVTS模型。

具体而言,MMVTS模型在F1、BS@30、mIoU和F1@30等指标上的表现均优于现有的最先进方法,特别是在结合预训练和微调任务后,MMVTS模型的性能有了显著提升。这表明,多模态信息的有效整合和一致性建模能够显著提升视频主题分割的效果。

方法的有效性分析

通过深入分析实验结果,可以得出以下几点关于方法有效性的结论。多模态融合层架构(如合并注意力和协同注意力)能够在不同层次上实现多模态信息的有效整合,提高模型的表达能力。通过引入专家混合模块,进一步提升了模型的容量和鲁棒性。

此外,预训练任务(如跨模态对齐和伪主题边界学习)能够在无标签数据上初步训练模型,增强不同模态之间的对齐和融合,为后续的微调提供了良好的基础。微调任务(如对比语义相似性学习和多模态一致性建模)则进一步优化了多模态数据的融合和一致性建模,提高了模型在处理复杂视频内容时的表现。

总体而言,通过结合多模态融合层架构、预训练任务和微调任务,所提出的方法在视频主题分割任务中的表现显著优于现有方法,展示了其在实际应用中的巨大潜力。

消融研究

为了验证不同组件对模型性能的贡献,研究团队进行了消融研究。通过移除不同的预训练和微调任务,分析其对模型性能的影响。结果显示,无论是跨模态对齐任务还是对比语义相似性学习任务,均对模型的最终性能有显著贡献。

具体来说,移除跨模态对齐任务后,模型的Avg得分明显下降,这表明该任务在增强不同模态之间的对齐和融合方面起到了关键作用。移除对比语义相似性学习任务后,模型在F1和BS@30等指标上的表现有所下降,表明该任务在提升多模态数据的一致性建模方面具有重要作用。

此外,研究团队还分析了不同多模态融合层架构对模型性能的影响。结果显示,协同注意力和专家混合模块在不同数据集上的表现均优于其他架构,特别是在结合预训练和微调任务后,表现尤为突出。

综上所述,消融研究验证了所提出方法中各个组件的重要性,进一步证明了多模态融合和一致性建模在视频主题分割任务中的有效性和优势。这为未来进一步优化和扩展该方法提供了宝贵的参考和指导。

结论与未来工作

这项研究提出了一种新颖的多模态融合和一致性建模方法,以应对视频主题分割的挑战。通过整合视觉、听觉和文本信息,研究团队设计了多种创新的架构和任务,包括合并注意力、协同注意力和专家混合模块,以及跨模态对齐和伪主题边界学习等预训练任务。实验结果表明,这些方法在多个基准数据集上均表现出色,显著提高了视频主题分割的准确性和鲁棒性。通过全面的实验评估和消融研究,验证了多模态融合和一致性建模的有效性,展示了其在实际应用中的巨大潜力。

这项研究方法的主要优势在于其多模态融合和一致性建模的创新设计。通过引入不同模态的信息并在多个层次上进行融合,研究团队能够捕捉视频内容的复杂语义,实现更精确的主题分割。此外,预训练和微调任务的设计进一步增强了模型在无标签和有标签数据上的学习能力,提高了模型的泛化能力和鲁棒性。

然而,方法也存在一些不足之处。由于计算复杂性的考虑,视觉编码器在训练过程中保持冻结状态,这可能限制了多模态信息的充分利用。其次,尽管在实验中取得了显著的提升,但在更复杂和多样化的视频内容上,方法的适应性和扩展性仍需进一步验证和优化。未来研究需要在这些方面进行改进,进一步提升模型的性能和应用范围。

未来的研究可以从以下几个方面展开。

优化视觉编码器的使用:在当前方法中,视觉编码器保持冻结状态。未来可以探索在保持计算效率的同时,部分解冻视觉编码器,以充分利用其潜在信息,提高多模态融合的效果。

引入更多音频特征:当前的音频信息主要通过自动语音识别系统获取文本信息。未来研究可以探索直接使用音频特征,如音调、节奏和背景声音等,进一步提升多模态融合的效果。

结合大规模预训练模型:随着大规模预训练模型的发展,未来可以尝试将这些模型与当前方法结合,利用其强大的表示能力和丰富的知识库,提高视频主题分割的性能。

扩展应用场景:未来研究可以探索将当前方法应用于更多类型的视频内容,如娱乐视频、新闻视频和社交媒体视频等,验证其在不同场景下的适应性和鲁棒性。

多模态融合层架构的优化:尽管当前的合并注意力和协同注意力架构表现出色,但未来仍需探索更多的融合架构和策略,如动态融合机制和自适应融合方法,以进一步提升多模态信息的整合效果。

通过这些研究方向的探索和改进,未来的方法有望在视频内容的高效处理和智能分析中发挥更大的作用,为视频主题分割领域带来更多的创新和进步。总之,研究团队所提出的多模态融合和一致性建模方法在视频主题分割任务中展示了巨大潜力,未来研究将继续优化和扩展这些方法,推动视频内容分析的进一步发展。(END)

参考资料:https://arxiv.org/abs/2408.00365

本文转载自大噬元兽,作者: FlerkenS