“大模型+知识图谱”双轮驱动的见解、技术和评估 - 英伟达的GraphRAG

数据是现代企业的命脉,为从创新到战略决策的方方面面提供动力。然而,随着组织积累的信息量不断增长(从技术文档到内部通信),他们面临着一项艰巨的挑战:如何从海量的非结构化数据中提取有意义的见解和可操作的结构。

检索增强生成 (RAG) 已成为一种流行的解决方案,它通过集成相关的企业数据来增强 AI 生成的响应。虽然传统的 RAG 方法对简单的查询有效,但在解决需要推理和交叉引用的复杂、多层次问题时,往往无法满足要求。

问题在于:简单的向量搜索可以检索数据,但通常无法提供复杂推理所需的细微上下文。即使是多查询 RAG、查询增强和混合检索等高级技术,也难以解决需要中间推理步骤或跨数据类型复杂连接的任务。

本文探讨了如何将大型语言模型 (LLM) 的强大功能与知识图谱相结合来应对这些挑战,使企业能够将非结构化数据集转换为结构化、互连的实体。这种集成增强了推理能力,提高了准确性,并减少了幻觉:这是传统 RAG 系统无法解决的问题。

本文涵盖以下方面:

- LLM 生成的知识图谱如何改进 RAG 技术。

- 构建这些图形的技术流程,包括使用 cuGraph 进行 GPU 加速。

- 对高级 RAG 方法的比较评估,以突出优势和实际应用:

VectorRAG

GraphRAG

HybridRAG (vectorRAG和graphRAG集成)

借助 LLM 驱动的知识图谱,企业可以获得更深入的见解、简化运营并获得竞争优势。

了解知识图谱

知识图谱是信息的结构化表示形式,由实体(节点)、属性以及它们之间的关系组成。通过在大量数据集之间创建连接,知识图谱可以更直观、更强大地探索数据。

大规模知识图谱的突出示例包括 DBpedia – Wikipedia、LinkedIn 和 Facebook 等平台使用的社交网络图谱,或 Google 搜索创建的知识面板。

Google 率先使用知识图谱来更好地了解现实世界的实体及其相互联系。这项创新通过多跳查询等技术显著提高了搜索准确性和高级内容探索。

Microsoft 通过 GraphRAG 扩展了这一概念,展示了 LLM 生成的知识图谱如何通过减少幻觉和实现对整个数据集的推理来增强 RAG。这种方法使 AI 系统能够通过图形机器学习来发现数据中的关键主题和关系。重磅 - 微软官宣正式在GitHub开源GraphRAG

知识图谱对于解决复杂问题和解锁各个行业和用例的见解已成为不可或缺的工具:

- 医疗保健 :通过绘制医学知识、患者记录和治疗途径,实现高级研究和明智的决策。

- 推荐系统 :通过将用户偏好与相关产品、服务或内容联系起来,提供个性化体验,从而丰富用户体验。

- 搜索引擎 :提高搜索结果的准确性和相关性,正如 2012 年 Google 对知识图谱的集成所证明的那样,它彻底改变了信息的传递方式。

- 社交网络 :支持社交图谱分析,以建议有意义的联系、发现趋势并提高 LinkedIn 和 Facebook 等平台上的用户参与度。

- 财务 :通过分析交易图表和识别财务数据中的隐藏关系,检测欺诈活动并发现见解。

- 学术研究 :通过连接科学出版物和研究数据集中的数据点,促进复杂的查询并发现新的见解。

通过构建和链接不同领域的数据,知识图谱为 AI 系统提供了高级推理功能,从而为复杂的行业挑战提供更精确、上下文感知的解决方案。

构建 LLM 生成的知识图谱的高级技术和最佳实践

在现代 LLM 兴起之前(可以称为前 ChatGPT 时代),知识图谱是使用传统的自然语言处理 (NLP) 技术构建的。此过程通常包括三个主要步骤:

- 命名实体识别 (NER)

- 实体链接

- 关系提取 (RE)

这些方法在很大程度上依赖于词性 (PoS) 标记、广泛的文本预处理和启发式规则来准确捕获语义和关系。虽然有效,但这些方法是劳动密集型的,并且通常需要大量的人工干预。

今天,指令微调的 LLM 彻底改变了这一过程。通过将文本拆分为块并使用 LLM 根据用户定义的提示提取实体和关系,企业现在可以更轻松、更高效地自动创建知识图谱。

但是,构建强大而准确的基于 LLM 的知识图谱仍然需要仔细注意某些关键方面:

- 架构或本体定义 :数据之间的关系通常必须受特定用例或域的约束。这是通过架构或本体实现的,它为构建图形提供了正式的语义规则。定义完善的架构为每个实体指定类、类别、关系和属性,从而确保一致性和相关性。

- 实体一致性 :保持一致的实体表示形式对于避免重复或不一致至关重要。例如,America、USA、US 和 United States 应映射到同一节点。形式语义和消歧技术可以显著减少这些问题,但可能仍需要额外的验证。

- 强制结构化输出:确保 LLM 输出符合预定义的结构对于可用性至关重要。有两种主要方法可以实现此目的:

- 后处理 :如果 LLM 未以所需格式输出数据,则必须手动处理响应以满足所需的结构。

- 使用 JSON 模式或函数调用 :某些 LLM 提供将其输出限制为特定格式(如 JSON)的功能。当本机支持不可用时,微调可以通过持续的基于指令的训练来训练模型以生成 JSON 输出。

通过解决这些注意事项并适当地微调模型,企业可以使用 LLM 生成的知识图谱来构建强大、准确且可扩展的数据表示形式。这些图表为高级 AI 应用程序解锁了新的可能性,从而获得更深入的见解并增强决策能力。

LLM 生成的知识图谱的实验设置

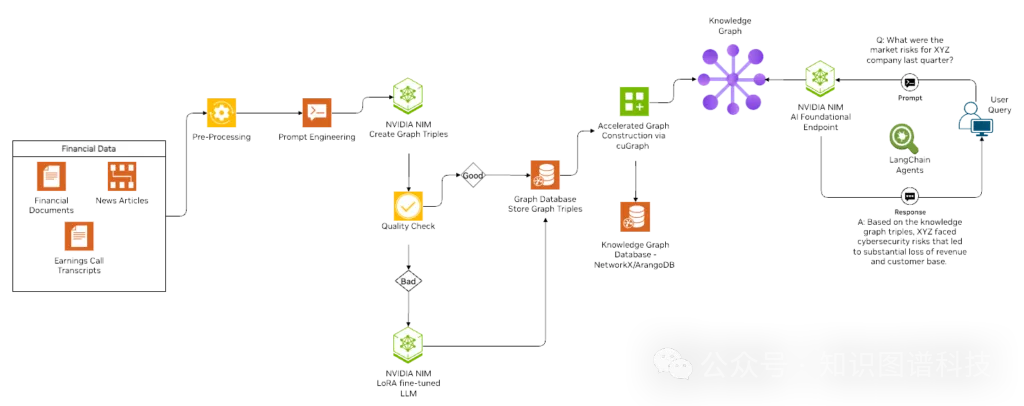

为了演示使用 LLM 创建知识图谱,我们开发了一个结合 NVIDIA NeMo、LoRA 和 NVIDIA NIM 微服务的优化实验工作流程(图 1 )。此设置可以有效地生成 LLM 驱动的知识图谱,并为企业用例提供可扩展的解决方案。

图 1.NIM 微服务加速的 GraphRAG 工作流

数据采集

在这个实验中,我们使用了来自 arXiv 的学术研究数据集,其中包含丰富的元数据,例如文章来源、作者详细信息、出版日期和随附的图像。为了促进复制,我们在 GitHub 上提供了开源代码,包括用于下载特定领域样本研究论文的脚本。

知识图谱创建

该过程使用了 Llama-3 70B NIM 模型,并带有从文本块中提取实体关系三元组的详细提示。虽然初始模型的性能相当不错,但某些输出不准确。

为了解决这个问题,我们使用 NVIDIA NeMo 框架和低秩自适应 (LoRA) 微调了一个较小的模型 Llama3-8B ,从而进一步优化了。Mixtral-8x7B 生成了用于微调的三元组数据,与较大的模型相比,这提高了准确性、减少了延迟并降低了推理成本。

该过程将生成的三元组解析为 Python 列表或字典,并将它们索引到图形数据库中。通过以下优化解决了格式不正确的三元组(例如,缺少标点符号或括号)等难题:

- 增强的解析功能 :使用具有改进文本处理的最新 LLM 模型。

- Fine-tuning for triplet extraction :添加说明以规范标点符号并确保实体格式的一致性。

- Re-prompting :通过提示 LLM 进行精细响应来纠正格式错误的输出,从而显著提高准确性。

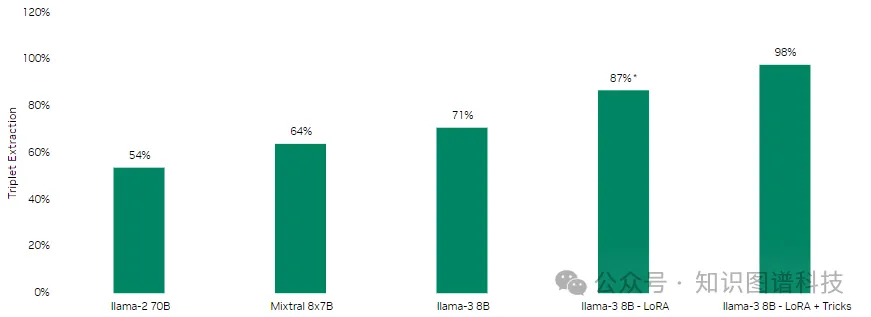

精度比较

为了评估不同模型和方法对三元体提取的有效性,我们在 100 个新闻文档的测试集上比较了它们的准确性。结果突出了通过微调和优化实现的性能改进。

请考虑以下示例段落:

|

在对 Llama-3-8B 模型进行微调之前,提取的三元组不完整,导致后处理函数解析时出现错误。

('Royal Dutch Shell', 'ORG', 'Announce', 'Cut Spending', 'EVENT'), ('Royal Dutch Shell', 'ORG', 'Operate_In', 'Oil and Gas Exploration', 'FIELD')]' |

微调后,该模型在完成率和准确性方面表现出显着提高。精炼后的三元组更精确,更符合文本的上下文:

['Total', 'COMP', 'Cut', 'Spending on oil and gas exploration', 'ACTIVITY'], ['World’s top oil companies', 'ORG', 'Hesitate', 'Accelerate the search for new resources', 'ACTIVITY']] |

图 2.从 100 个新闻文档中预测三元组的不同模型和方法的准确性比较

用于三元组提取的代码和架构

下面是一个 /NVIDIA/GenerativeAIExamples 代码示例,展示了用于三元组提取的架构和方法:

- ORG: Organizations other than government or regulatory bodies - ORG/GOV: Government bodies (e.g., "United States Government") - ORG/REG: Regulatory bodies (e.g., "Food and Drug Administration") - PERSON: Individuals (e.g., "Marie Curie") - GPE: Geopolitical entities such as countries, cities, etc. (e.g., "Germany") - INSTITUTION: Academic or research institutions (e.g., "Harvard University") - PRODUCT: Products or services (e.g., "CRISPR technology") - EVENT: Specific and Material Events (e.g., "Nobel Prize", "COVID-19 pandemic") - FIELD: Academic fields or disciplines (e.g., "Quantum Physics") - METRIC: Research metrics or indicators (e.g., "Impact Factor"), numerical values like "10%" is not a METRIC; - TOOL: Research tools or methods (e.g., "Gene Sequencing", "Surveys") - CONCEPT: Abstract ideas or notions or themes (e.g., "Quantum Entanglement", "Climate Change") |

这种结构化方法确保了更清晰、更准确的三联体提取。

优化推理

为了扩展数千个文档块的工作流程,我们执行了以下优化:

- Converted model weights :将 NeMo 训练的模型权重转换为 TensorRT-LLM 检查点。

- 优化的推理引擎 :使用 GPU 加速推理以获得更快的性能。

- 部署的可扩展系统:使用优化的模型检查点实现高吞吐量推理,显著提高了大型数据集的性能。

通过集成先进的 LLM 优化技术和微调工作流程,我们实现了高效且可扩展的知识图谱生成,为企业 AI 应用程序提供了强大的基础。

使用 NVIDIA cuGraph 加速知识图谱,实现可扩展的 AI 工作流

NVIDIA 多年来一直致力于推进 GPU 上的 AI 工作流,尤其是在图形神经网络 (GNN) 和复杂数据表示等领域。基于这些专业知识,NVIDIA RAPIDS 数据科学团队开发了 cuGraph,这是一个用于图形分析的 GPU 加速框架。cuGraph 通过实现可扩展的高速图形操作,显著提高了 RAG 系统的效率。

在知识图谱检索增强生成 (KRAG) 中,将查询知识图谱以检索相关信息,从而在文本生成期间增强语言模型的上下文。cuGraph 最短路径、PageRank 和社区检测等高性能算法可快速识别和排序大规模知识图谱中的相关节点和边缘。通过这样做, cuGraph 确保更快、更准确地检索上下文相关信息,从而提高 AI 生成的输出的质量。

cuGraph 特别强大的原因是它与 NetworkX、RAPIDS cuDF 和 cuML 等广泛使用的开源工具无缝集成。这种集成使您能够以最少的代码更改来加速图形工作流,从而实现快速采用和即时性能提升。

在我们的开源实施中,我们使用 cuGraph 通过 NetworkX 加载和管理图形表示,从而在多 GPU 系统上实现数十亿个节点和边缘的可扩展性。cuGraph 还支持高效的图形查询和多跳搜索,使其成为处理大型复杂知识图谱不可或缺的工具。

深入了解 VectorRAG、GraphRAG 和 HybridRAG

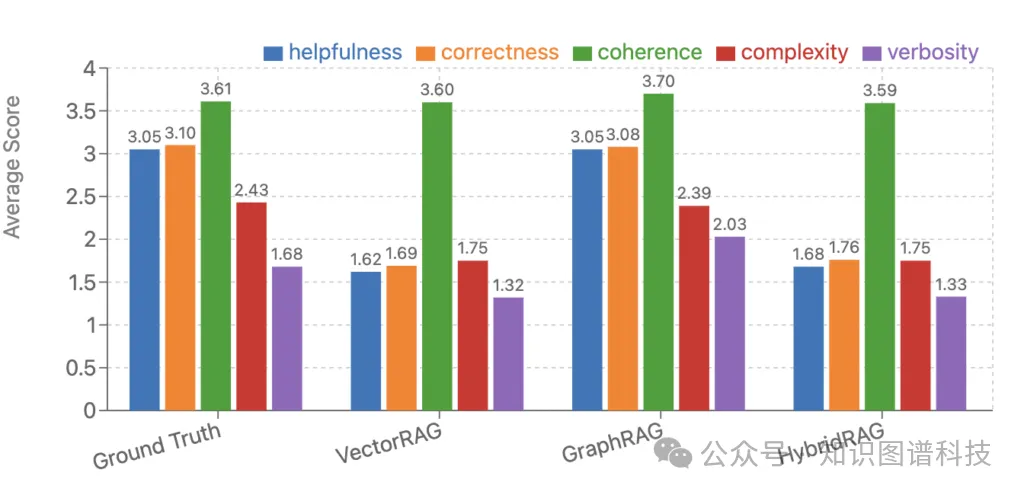

我们对三种 RAG 技术进行了全面的比较分析:VectorRAG、GraphRAG 和 HybridRAG。我们使用 nemotron-340b 奖励模型来评估他们的输出质量。

评估指标

评估侧重于以下关键指标,评分范围为 0 到 4(越高越好):

- Helpfulness:衡量响应对提示的处理效果。

- 正确性:评估是否包含所有相关事实,无不准确之处。

- Coherence:评估响应中表达的一致性和清晰度。

- 复杂性:确定生成响应所需的知识深度(例如,它是否需要深厚的领域专业知识,还是可以通过基本的语言能力生成)。

- Verbosity:分析相对于提示要求提供的详细程度。

有关更多信息,请参阅模型卡。

数据集和实验设置

本研究使用的数据集包含从 arXiv 收集的研究论文。真实 (GT) 问答对是使用 nemotron-340b 合成数据生成模型合成生成的。

包含关键见解的结果摘要

图 3.地面实况 - 长上下文合成对的比较分析

注意:在这种情况下,与纯 GraphRAG 相比,HybridRAG 的性能不佳,因为该数据集是为多跳推理而综合设计的,以突出 GraphRAG 的优势。对于真实世界的数据,HybridRAG 可能会在大多数情况下提供最佳结果。

分析揭示了不同技术之间的显著性能差异:

- 正确性 :GraphRAG 在正确性方面表现出色,提供了高度准确且忠实于源数据的响应。

- 整体表现 :GraphRAG 在所有指标上都表现出卓越的表现,提供准确、连贯且与上下文一致的响应。它的优势在于使用关系上下文进行更丰富的信息检索,这使得它对于需要高准确性的数据集特别有效。

- HybridRAG 的潜力 :根据数据集和上下文注入,HybridRAG 几乎在所有指标上都显示出优于传统 VectorRAG 的潜力。其基于图形的检索功能可以改进对复杂数据关系的处理,尽管这可能会导致一致性略有妥协。

- HybridRAG 作为一种平衡的方法:HybridRAG 作为一种平衡且有效的技术出现,它将语义 VectorRAG 的灵活性与高级多跳推理和全局上下文摘要无缝结合。这使得它特别适合金融和医疗保健等受监管的领域,在这些领域中,强大的响应基础至关重要。其方法可实现准确高效的信息提取,满足这些行业的严格要求。

图形检索技术的集成有可能重新定义 RAG 方法处理复杂、大规模数据集的方式,使其成为需要跨关系进行多跳推理、高准确性和深入上下文理解的应用程序的理想选择。

探索 LLM 驱动的知识图谱的未来

在本文中,我们研究了将 LLM 与知识图谱集成如何增强 AI 驱动的信息检索,在多跳推理和高级查询响应等领域表现出色。VectorRAG、GraphRAG 和 HybridRAG 等技术显示出巨大的潜力,但在我们突破这项技术的界限时,仍然存在一些挑战。

以下是一些关键挑战:

- 动态信息更新:将实时数据合并到知识图谱中,添加新节点和关系,并确保大规模更新期间的相关性。

- 可扩展性:管理增长到数十亿个节点和边缘的知识图谱,同时保持效率和性能。

- 三元组提取优化:提高实体关系提取的精度以减少错误和不一致。

- 系统评估:开发强大的特定领域指标和基准,用于评估基于图形的检索系统,以确保一致性、准确性和相关性。

一些未来的方向可能包括以下任何一项:

- 动态知识图谱:改进技术以无缝扩展动态更新,使图谱能够随着最新数据而发展。

- 专家代理集成 :探索知识图谱检索如何充当专家系统,为特定领域的应用程序提供专业见解。

- 图谱嵌入:为整个知识图谱开发嵌入的语义表示,以解锁图形分析和信息检索方面的新功能。

使用 NVIDIA 工具构建和优化知识图谱

要深入了解这些创新,请探索 NVIDIA NeMo 框架、 NVIDIA NIM 微服务和 cuGraph ,以创建和管理 GPU 加速的知识图谱。

要复制帖子和其他开源示例中讨论的工作流程,请参阅 /NVIDIA/GenerativeAIExamples GitHub repo 。这些工具使您能够有效地扩展系统,无论您是构建动态知识图谱、微调 LLM 还是优化推理管道。

参考文献

- Stardog Voicebox智能体: 知识图谱&LLM双轮驱动、释放自动化的创造力

- 大模型能自动创建高质量知识图谱吗?可行性及人机协同机制 - WhyHow.AI

- GraphRAG和轻量级LightRAG技术及应用案例深度解析

- 微软GraphRAG框架演进之路及带来的一些思考

- LazyGraphRAG:微软重磅推出高性价比下一代GraphRAG

- 提升大型语言模型结果:何时使用GraphRAG

- 微软GraphRAG最新动态:通过动态社区选择改善全球搜索

- GraphRAG产业化应用落地挑战和探索:知易行难 - 企业大模型独角兽Glean实践之四

- GraphRAG从研发到上线的挑战-硅谷企业级大模型知识库独角兽Glean系列之三

- 企业级知识库为什么要用GraphRAG - 硅谷企业级ChatGPT独角兽Glean系列之二

- 企业智能知识库企业Glean利用GraphRAG融资2.6亿美元

- 重磅 - 微软官宣正式在GitHub开源GraphRAG

- 开源GraphRAG解读:微软的人工智能驱动知识发现方法

- GraphRAG工程落地成本详细解读和实例分析

- GraphRAG类型、限制、案例、使用场景详细解析

- 引入GraphRAG的场景条件分析

- 不适用生成式人工智能的场景

- 知识图谱增强大模型GraphRAG全面综述解读 - 蚂蚁集团、北大、浙大、人大等

- 5个知识图谱KG和RAG系统的误解 — 构建和使用RAG原生图谱

- OpenKG-SIG | SIGData兴趣组:利用大模型构建LLM需要的知识图谱

- 关于大模型和知识图谱、本体的一场讨论

- 什么时候(不)用GraphRAG

- GraphRAG工程落地成本详细解读和实例分析

- Structured-GraphRAG知识增强框架——足球游戏数据案例研究

- StructRAG: 下一代GraphRAG - 中科院&阿里

- KG RAG vs. Vector RAG:基准测试、优化杠杆和财务分析示例 - WhyHow.AI实践

- WhyHow AI

- 知识图谱增强RAG流水线Use Case-WhyHow.AI

- “大模型+知识图谱”双轮驱动的医药数智化转型新范式-OpenKG TOC专家谈

- 知识图谱(KG)和大模型(LLMs)双轮驱动的企业级AI平台构建之道

本文转载自 知识图谱科技,作者:KGGPT