参数减少99.5%,媲美全精度FLUX!字节跳动等发布首个1.58-bit FLUX量化模型

文章链接:https://arxiv.org/pdf/2412.18653

项目链接:https://chenglin-yang.github.io/1.58bit.flux.github.io/

git主页:https://github.com/Chenglin-Yang

亮点分析

- 1.58-bit FLUX,第一个将 FLUX 视觉 Transformer 的参数(共 119 亿)减少 99.5% 至 1.58-bit 的量化模型,无需依赖图像数据,大幅降低存储需求。

- 开发了一个高效的线性内核,针对 1.58-bit 计算进行了优化,实现了显著的内存减少和推理加速。

- 证明了1.58-bit FLUX在具有挑战性的 T2I 基准测试中,性能与全精度 FLUX 模型相当。

总结速览

解决的问题

- 当前文本生成图像(T2I)模型,如 DALLE 3、Stable Diffusion 3 等,参数量巨大,推理时内存需求高,难以在资源有限的设备(如移动设备)上部署。

- 本文重点研究极低比特量化(1.58-bit)在 T2I 模型中的可行性,以减少存储和内存需求,同时提升推理效率。

提出的方案

- 选用 FLUX.1-dev 模型作为量化目标,通过后训练量化方法将其权重压缩为 1.58-bit(值限制为 {-1, 0, +1}),无需访问图像数据。

- 开发专用的低比特操作优化内核,进一步提升推理效率。

应用的技术

- 1.58-bit 权重量化:使用类似 BitNet b1.58 的方法,将模型的线性层权重压缩至 1.58-bit,并通过 2-bit 有符号整数存储权重,从而实现极低比特化。

- 无监督量化方法:完全依赖 FLUX.1-dev 模型本身的自监督机制,无需依赖混合精度方案或额外的训练数据。

- 定制化内核:针对低比特操作优化的推理内核,降低内存使用并缩短推理延迟。

达到的效果

- 存储效率:模型存储需求减少 7.7×,从 16-bit 压缩到 2-bit。

- 推理效率:推理时的内存使用减少 5.1×,推理延迟显著改善。

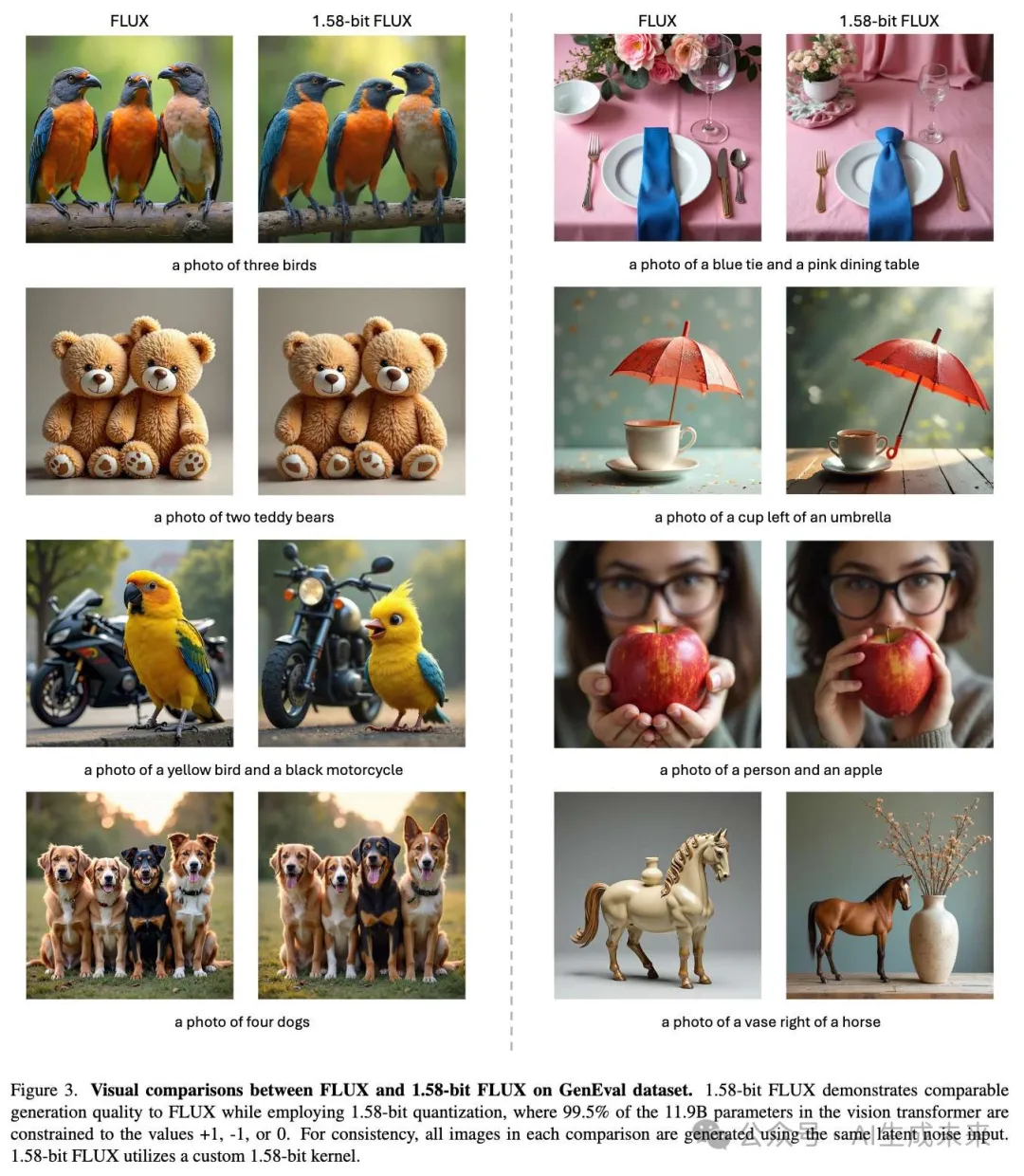

- 生成质量:在 GenEval 和 T2I Compbench 基准测试上,生成质量与全精度 FLUX 基本持平,验证了方案的有效性和实用性。

实验结果

设置

量化:使用一个校准数据集进行量化,数据集由 Parti-1k 数据集和 T2I CompBench 训练集的提示语组成,共计 7,232 条提示语。整个过程完全不依赖图像数据,不需要额外的数据集。量化将 FLUX 中 FluxTransformerBlock 和 FluxSingleTransformerBlock 的所有线性层权重压缩至 1.58-bit,占模型总参数的 99.5%。

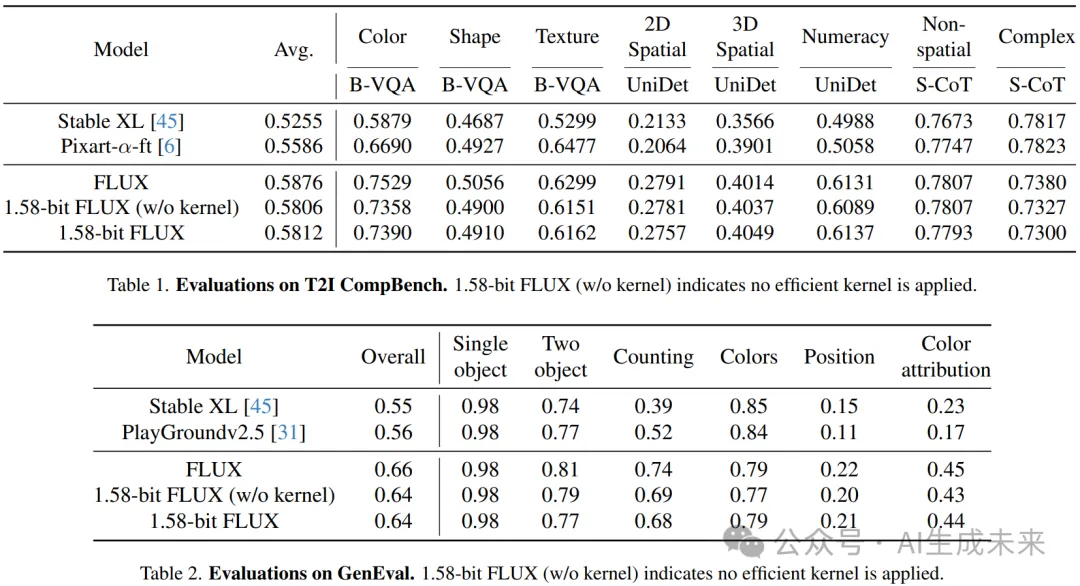

评估:在 GenEval 数据集 和 T2I CompBench 验证集上评估 FLUX 和 1.58-bit FLUX,遵循官方的图像生成流程。

- GenEval 数据集:包含 553 条提示语,每条提示语生成 4 张图像。

- T2I CompBench 验证集:包含 8 个类别,每个类别有 300 条提示语,每条提示语生成 10 张图像,总计生成 24,000 张图像进行评估。

- 所有图像均以 1024 × 1024 的分辨率生成,适用于 FLUX 和 1.58-bit FLUX。

结果

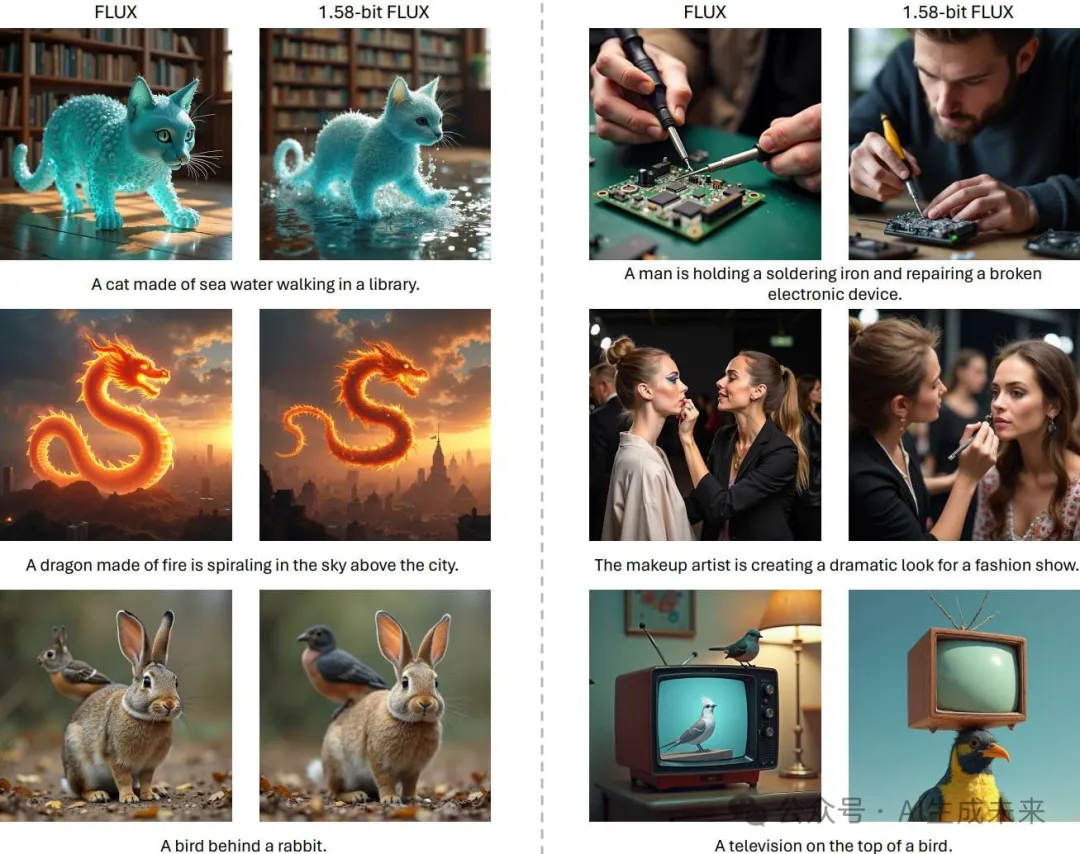

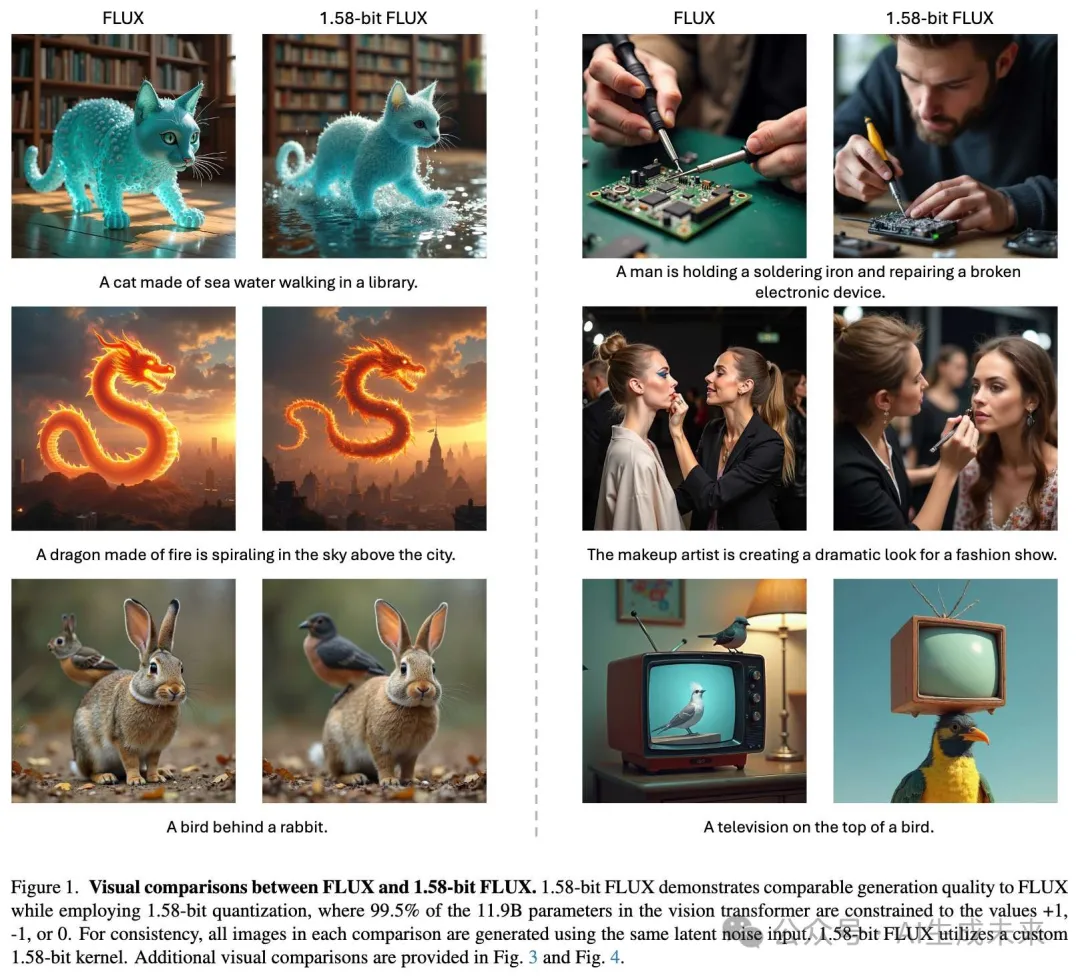

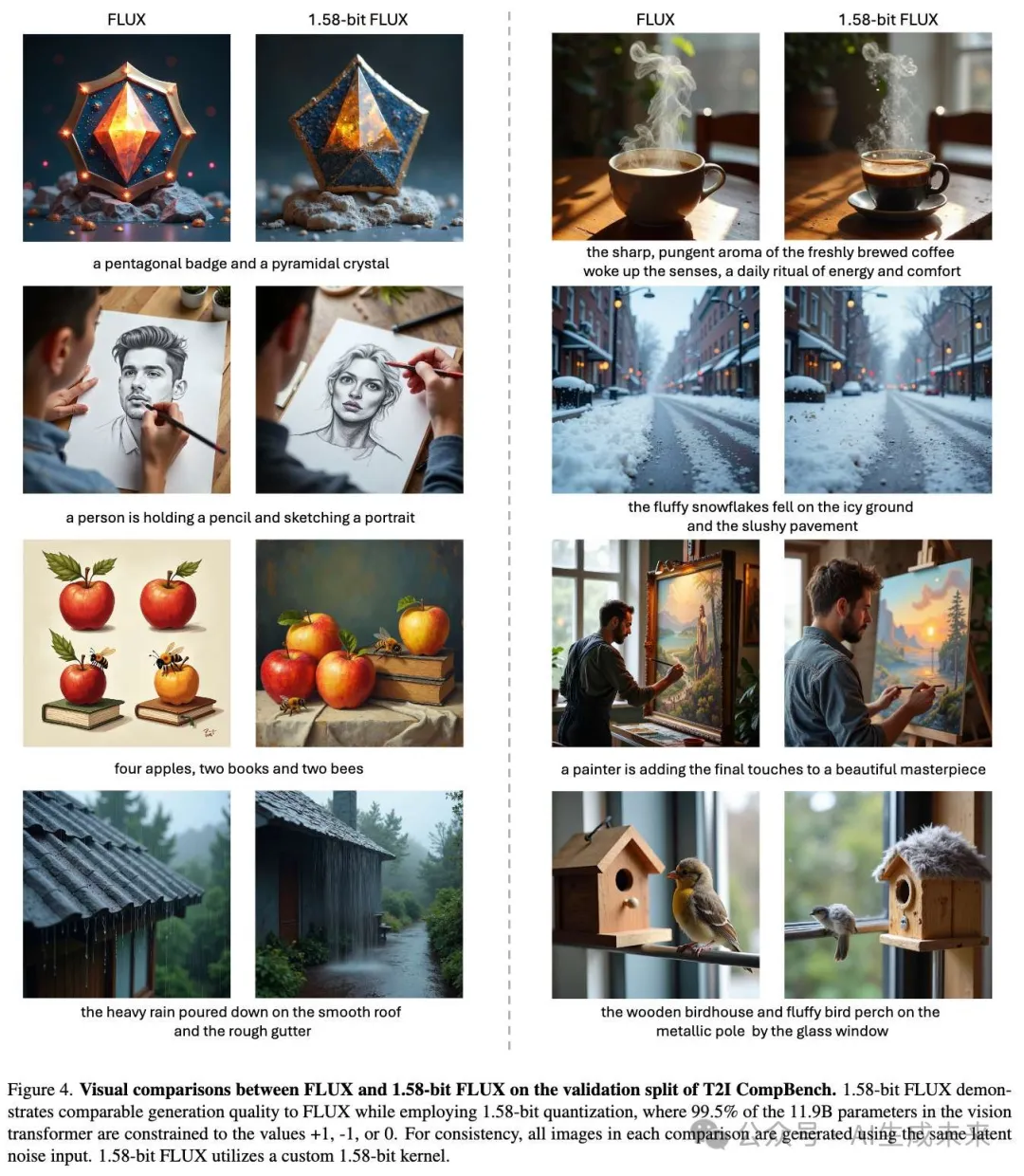

性能:在 T2I Compbench 和 GenEval 基准测试中,1.58-bit FLUX 与全精度 FLUX 的性能表现相当,具体结果见表 1 和表 2。在应用自定义线性内核前后,性能变化微乎其微,进一步验证了实现的准确性。

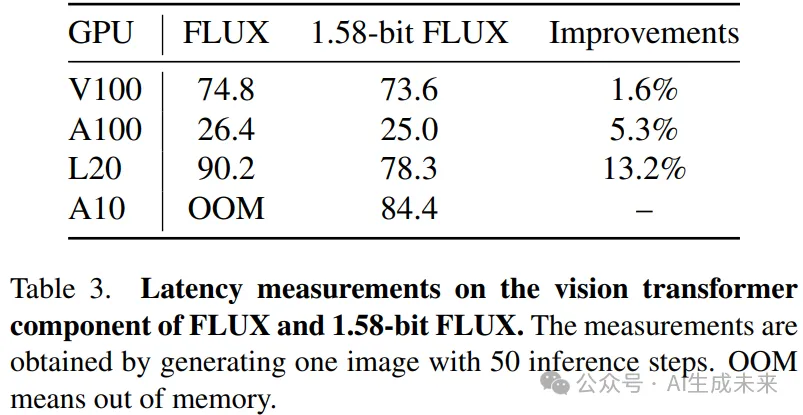

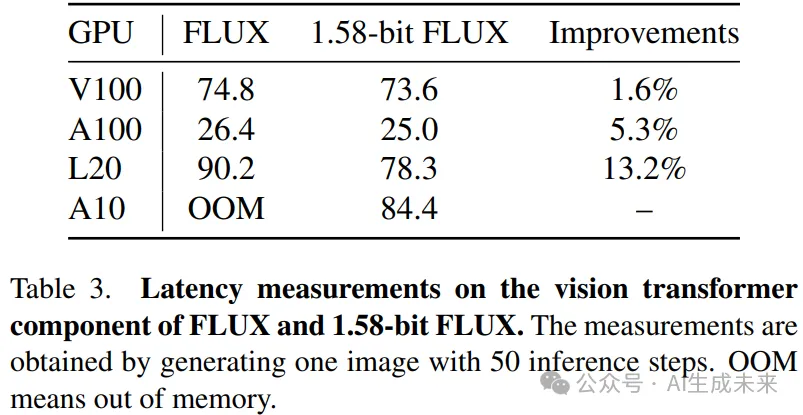

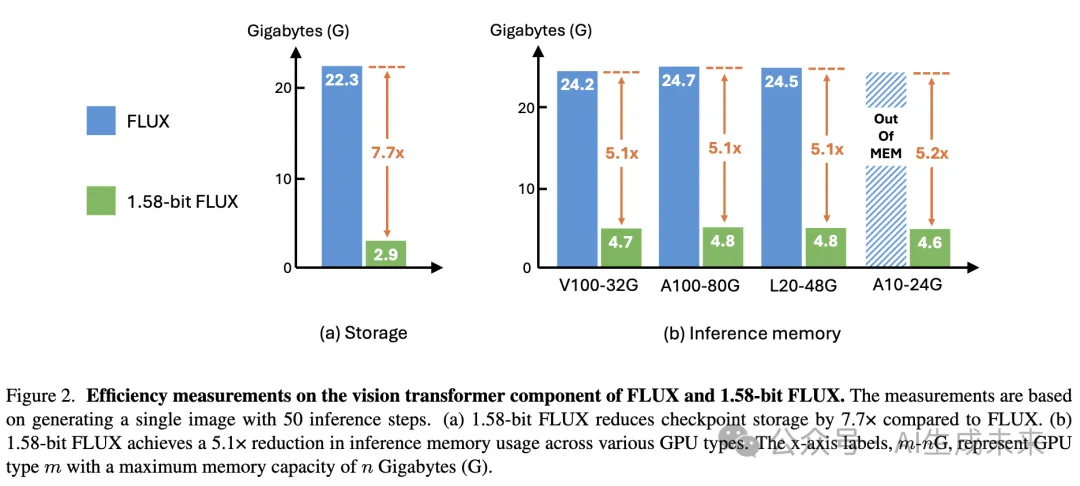

效率:如下图 2 所示,1.58-bit FLUX 在模型存储和推理内存上取得了显著提升。在推理延迟方面,如下表 3 所示,特别是在低性能但易于部署的 GPU(如 L20 和 A10)上,改进更为显著。

结论与讨论

本文提出了 1.58-bit FLUX,将 99.5% 的 Transformer 参数量化至 1.58-bit,并通过自定义计算内核实现了以下改进:

- 存储需求减少:模型存储需求降低 7.7 倍。

- 推理内存减少:推理内存使用减少超过 5.1 倍。

尽管实现了这些压缩效果,1.58-bit FLUX 在 T2I 基准测试中表现出与全精度模型相当的性能,同时保持了较高的视觉质量。希望 1.58-bit FLUX 能够激励社区开发更适合移动设备的模型。

当前局限性

关于速度改进的局限性

- 尽管 1.58-bit FLUX 降低了模型大小和内存消耗,但由于缺乏激活值量化和更高级的内核优化,其延迟改进有限。

- 鉴于目前取得的成果,希望激励社区开发适用于 1.58-bit 模型的自定义内核实现。

关于视觉质量的局限性

- 如下图 1、图 3 和图 4 所示,1.58-bit FLUX 能生成与文本提示高度一致的生动逼真的图像,但在渲染超高分辨率细节时仍落后于原始 FLUX 模型。

- 计划在未来研究中缩小这一差距。

本文转自AI生成未来 ,作者:AI生成未来

原文链接:https://mp.weixin.qq.com/s/ZFJ1f7YZZEKoEs5Ie1YAbA