为啥强化学习开始成为了大语言模型(LLM)的新宠?

一、强化学习基础概述

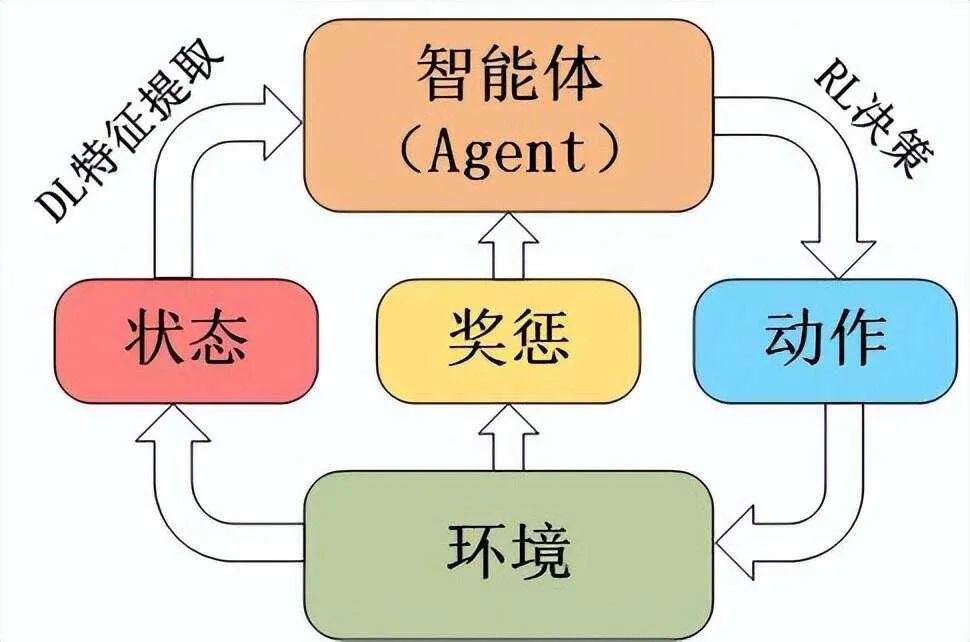

强化学习是机器学习的一个分支,核心在于智能体(agent)与环境(environment)的交互。智能体执行动作(action),环境随之反馈奖励(reward)和新的状态(state)。智能体的目标便是通过不断试错,学习到能最大化长期累积奖励的策略(policy) 。

大语言模型的预训练依赖海量无监督文本数据,构建起庞大的参数空间来捕捉语言规律。然而,这一过程存在诸多短板:

- 缺乏任务针对性:预训练后的模型像是个“知识杂烩”,面对具体任务,如撰写专业法律文书、创意故事写作时,难以迅速精准输出,容易给出宽泛、缺乏重点的回答。

- 与人类偏好偏差:预训练没考量人类主观的审美、价值观与交流习惯,生成内容可能冰冷机械,不符合日常沟通期待,甚至偶尔输出不当、冒犯性言论。

- 数据分布适应性弱:现实世界数据分布瞬息万变,新流行语、新事件带来全新语义分布,单纯依靠预训练时的固定数据难以灵活应变。

强化学习此时闪亮登场,它能基于即时反馈,动态调整模型行为,宛如给懵懂的“语言天才”配备一位实时指导的导师,精准雕琢模型输出。

二、强化学习受宠于LLM的原因

(一)弥补预训练局限

大语言模型的预训练依赖海量文本数据,它贪婪地摄取知识,构建起庞大的语言表征体系。然而,预训练无法充分考量真实场景下用户多样化、动态化的需求。就好比学生在图书馆通读各类书籍打基础,但缺乏应对实际复杂考试场景的针对性练习。强化学习介入后,能够依据即时反馈校准模型输出,促使其贴合人类期望的回应模式,把宽泛的知识储备精准应用于具体任务。

(二)提升模型适应性

现实世界的数据分布处于持续变动中,新话题、新表述、新语境层出不穷。传统的监督学习依赖固定数据集微调,面对分布外的数据时效果大打折扣。强化学习构建起模型与环境交互的闭环,通过不断试错与奖励反馈,让LLM可以迅速适应全新的数据分布。例如,当网络流行语更迭时,经强化学习优化的LLM能更快捕捉语义变化,给出契合当下语境的回答。

(三)对齐人类偏好

人工智能产品最终服务于人类用户,模型输出需契合人类的价值观、审美与交流习惯。强化学习中的奖励信号能够融入人类反馈,构建起人类偏好模型,引导LLM生成的文本更人性化、更有同理心。未经优化的生成内容可能冗长、晦涩,而基于人类反馈的强化学习能让回复变得亲切自然,像贴心老友给出靠谱建议。

(四)优化效率与成本

持续扩大模型规模来提升性能,面临算力瓶颈与高昂成本。强化学习聚焦于策略优化而非单纯的数据堆砌,利用少量高质量反馈数据,就能对模型行为做出显著改进。相比海量数据的二次预训练,强化学习像是四两拨千斤的巧劲,用精打细算的方式让LLM“更上一层楼”。

三、近端策略优化(PPO)在LLM中的应用

(一)PPO算法原理

近端策略优化属于策略梯度算法家族,旨在更高效、稳定地更新策略网络。它限制新策略与旧策略的偏离程度,防止策略更新步子迈得太大,掉进局部最优陷阱。通过优化目标函数,利用重要性采样,权衡新旧策略下动作的概率与奖励反馈,实现策略的渐进式优化。

(二)在LLM里的实践

OpenAI将PPO广泛应用于GPT系列。模型生成文本片段时,PPO会依据奖励函数评估。奖励考量多维度因素:

- 连贯性:文本读起来是否通顺流畅,有无逻辑跳跃,例如在讲述历史事件脉络时,连贯的叙述才能让读者跟上节奏。

- 准确性:针对科普、资讯类内容,输出的事实、数据必须精准无误,不然会误导受众。

- 安全性:禁止生成包含歧视、暴力、虚假信息等不良内容,一旦触及红线,给予严厉负向奖励。

借助PPO,GPT不断微调策略网络,让生成质量稳步攀升,输出从混乱无序走向条理清晰、合规有用。

四、基于人类反馈的强化学习(RLHF)

(一)RLHF流程拆解

- 数据收集:首先要汇聚海量人类反馈数据。比如向志愿者展示模型对同一问题的不同回答,让他们标记出更喜欢的回复;或是收集专业编辑对模型生成文章的修改意见,标记优劣差异。

- 奖励模型构建:把收集的人类偏好数据“翻译”成量化的奖励信号,训练出一个小型的奖励模型,用于预测给定文本能获得的人类偏好分数。

- 强化学习循环:主模型生成文本,奖励模型打分,依据分数用强化学习算法更新主模型,促使它下次生成更契合人类喜好的内容。

(二)RLHF的变革性影响

以ChatGPT为例,RLHF是它风靡全球的关键“魔法”。在日常闲聊场景,未经RLHF的模型可能回复生硬简短;经RLHF打磨后,ChatGPT能感知用户情绪,俏皮打趣、暖心安慰,瞬间拉近与用户距离。在答疑领域,回答也从干巴巴的条文罗列,变成通俗易懂、举例生动的贴心讲解,深度匹配用户期望。

五、OpenAI O1开启的强化学习持续优化范式

(一)动态“后训练”理念

OpenAI O1打破传统训练的阶段性局限,倡导全生命周期的持续后训练。模型上线不是终点,而是新征程开端。每日海量用户交互反馈,都化作强化学习的燃料,当晚就能微调模型参数,优化第二天输出。遇上突发新闻热点、新网络用语诞生,快速响应更新知识与表达风格。

(二)复合反馈融合

不再单纯依赖用户点赞、差评,O1整合文本语法检查、语义完整性评估、伦理合规审查、任务完成效能考量等多源反馈。一篇财经评论,既要语法正确、语义连贯,不能违规荐股,还得精准预测市场走向,综合反馈塑造更优质模型。

(三)拓展能力边界

传统框架下,LLM被初始设定束缚,O1利用强化学习试探未知策略空间。鼓励模型挖掘冷门知识、新兴学术理论,催生新颖创意内容,不断拓展智能边界,给用户带来新奇体验。

六、强化学习应用于LLM的挑战与应对

(一)奖励设计复杂性

设计普适公平的奖励函数困难重重。过于侧重准确性奖励,会扼杀创意;过度鼓励新奇,又易产出不靠谱内容。需结合对抗训练、分层奖励架构,不同任务定制差异化奖励细则,平衡激励方向。

(二)数据偏差与噪声

人类反馈数据夹杂主观偏见、文化局限,采集渠道局限也会引入噪声。要扩大数据收集范围,跨地域、跨文化采集,用数据清洗、异常值剔除、多源数据交叉验证等手段净化数据。

(三)算力与时长难题

强化学习频繁更新模型,算力消耗巨大,训练耗时漫长。借助云算力租赁、自研高效计算芯片、算法并行化改造,削减计算成本,提速训练进程。

七、未来展望

强化学习与LLM的融合正处于蓬勃发展的蜜月期。随着算法创新持续迭代,奖励机制愈发精妙,反馈数据越发纯净海量,算力基建蓬勃发展,我们有望见证LLM蜕变成为真正的“智能伴侣”。

从无缝融入创意产业,激发人类无限灵感,到深度嵌入专业领域,成为可靠的决策辅助,强化学习驱动的LLM将跨越当下局限,勾勒出一个人机深度协同、知识共创共享的崭新未来。

本文转载自 智驻未来,作者: 小智