MIT:LLM的思考方式竟然和大脑相似 精华

一、背景

1. 人工智能与神经科学的融合

在当今科技飞速发展的时代,人工智能与神经科学的交叉领域正成为科研的热点方向。大语言模型(LLMs)作为人工智能领域的重要成果,其与人类大脑语言处理机制的关系备受关注。从本质上讲,这一研究方向旨在探寻机器如何像人类大脑一样理解和处理语言,这不仅有助于提升人工智能技术的性能,更有助于揭示人类认知的奥秘。过往研究已发现LLMs与大脑在某些方面存在相似之处,如特征提取和表征等,但这些研究尚未触及到LLMs具备类脑处理能力的核心计算原理。

2. 研究目的与价值

本研究聚焦于揭示LLM性能、神经可预测性、解剖结构对齐以及上下文编码之间的内在联系。通过深入研究,期望能够明确促使LLMs在语言处理上既高效又类脑的关键因素,进而挖掘人工与生物系统在语言理解方面更精细的相似之处。这一研究成果将为LLMs的优化提供全新的理论依据,推动自然语言处理技术向更高水平发展,同时也为神经科学研究提供独特的视角,助力人类对自身语言处理机制的深入理解。

3.研究方法

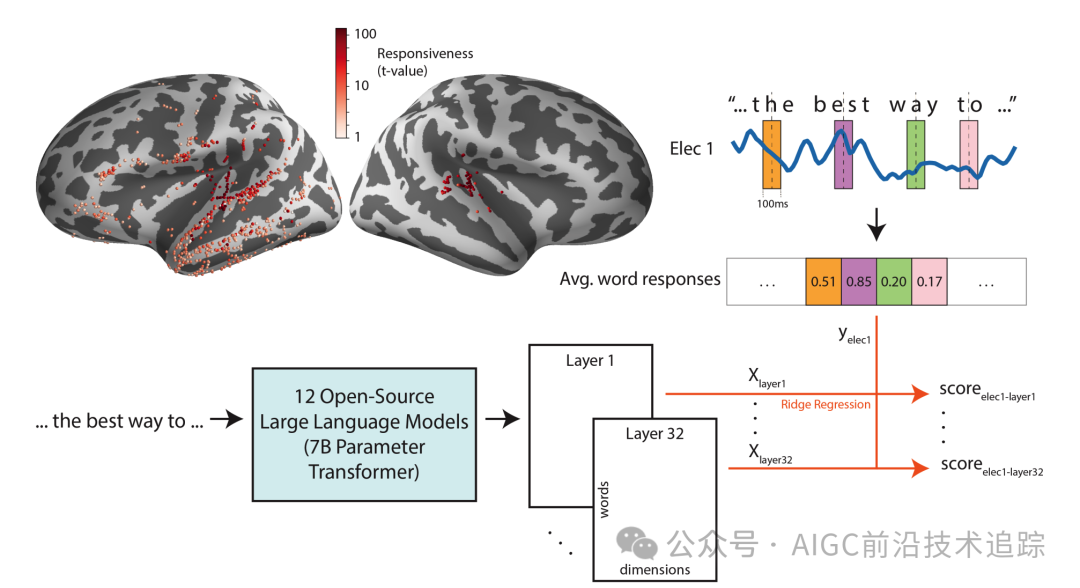

研究选取了12个开源、预训练且参数规模相近但语言能力有别的LLMs,涵盖了当下流行的多种模型。在实验过程中,借助颅内脑电图(iEEG)技术,记录神经外科患者聆听语音时的神经活动。然后将这些神经反应与LLMs处理相同语言输入时各层提取的嵌入表示进行对比分析。这种方法能够精准定位LLMs中与大脑活动关联紧密的层和特征,为后续研究奠定坚实基础。

图片

图片

二、与大脑相似性

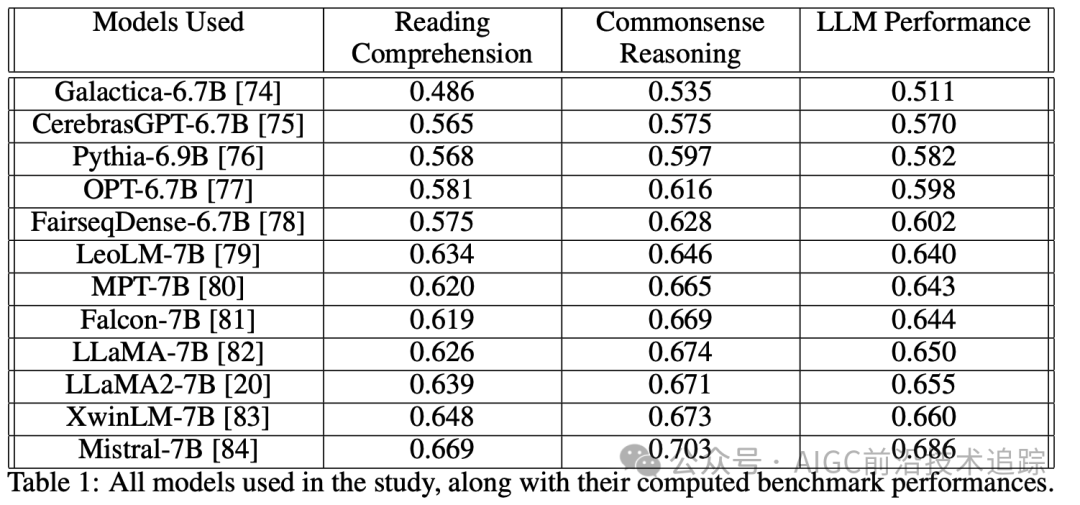

1. 模型选择与性能评估体系

研究精心挑选了12个近期热门且开源的LLMs,其参数规模均约为70亿。为全面评估模型的语言处理能力,研究构建了一套细致的评估体系,将任务划分为阅读理解和常识推理等与英语语言理解密切相关的类别。在计算总体LLM性能时,取阅读理解和常识推理得分的平均值作为综合指标。这一体系的建立旨在模拟人类语言理解的多维度需求,确保评估结果能真实反映模型的语言处理水平。

图片

图片

2. 神经反应采集与数据预处理

实验对象为八名耐药性癫痫患者,电极通过颅内植入(iEEG)方式置于其听觉皮层和语音处理区域,位置依据临床需求确定。患者聆听20 - 30分钟的语音素材,包括故事和对话。将语音对应的文本输入LLMs,提取各层每个单词的因果嵌入表示,并使用PCA降至500个组件,以统一数据维度。针对每个对语音有反应的电极,提取其在单词中心周围100毫秒窗口内的平均高伽马波段包络响应,通过岭回归模型预测神经反应,以留存折叠的平均预测相关性作为大脑相似性得分。研究还验证了嵌入表示主成分数量和计算神经反应窗口大小对结果无显著影响,确保了数据处理方法的可靠性。

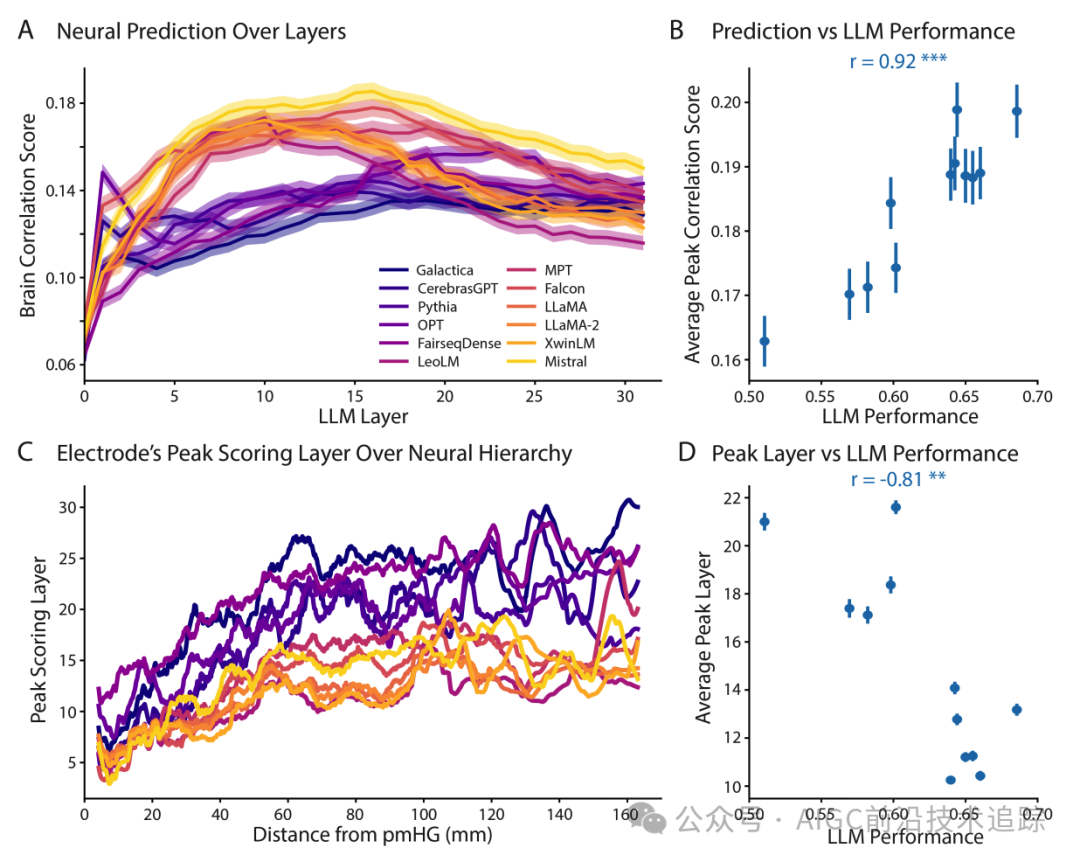

3. 模型性能与大脑相似性的关联机制

研究发现,LLMs的神经反应可从模型表示中预测,大脑相似性在层间呈上升趋势,在中间或后期层达峰值。性能出色的LLMs在预测大脑活动时更准确,提取的语言特征更类脑。通过皮尔逊相关系数计算,LLM性能与大脑相似性峰值呈显著正相关(Pearson (r = 0.92),(p = 2.24 × 10^{-5}))。这表明模型在基准任务上表现越好,其处理语言时与大脑的相似性越高,为理解LLMs的语言处理机制提供了重要依据。

4. 模型层与大脑处理区域的映射关系

大脑的听觉和语言处理通路呈层次化组织,初级听觉皮层位于后内侧颞横回(pmHG,或TE1.1)。研究人员以pmHG为参考点,计算电极与pmHG的距离来量化其在语言处理通路中的深度。此前研究已发现LLMs深层与大脑深层语言处理区域有对应关系,本研究进一步发现性能好的LLMs在较早层达到大脑相似性峰值,差的模型则需更深层。这表明LLMs在进化中,特征提取层次与大脑的对齐方式发生了变化,为探究LLMs语言处理机制提供了新视角。

三、LLM 与大脑语言层次对齐

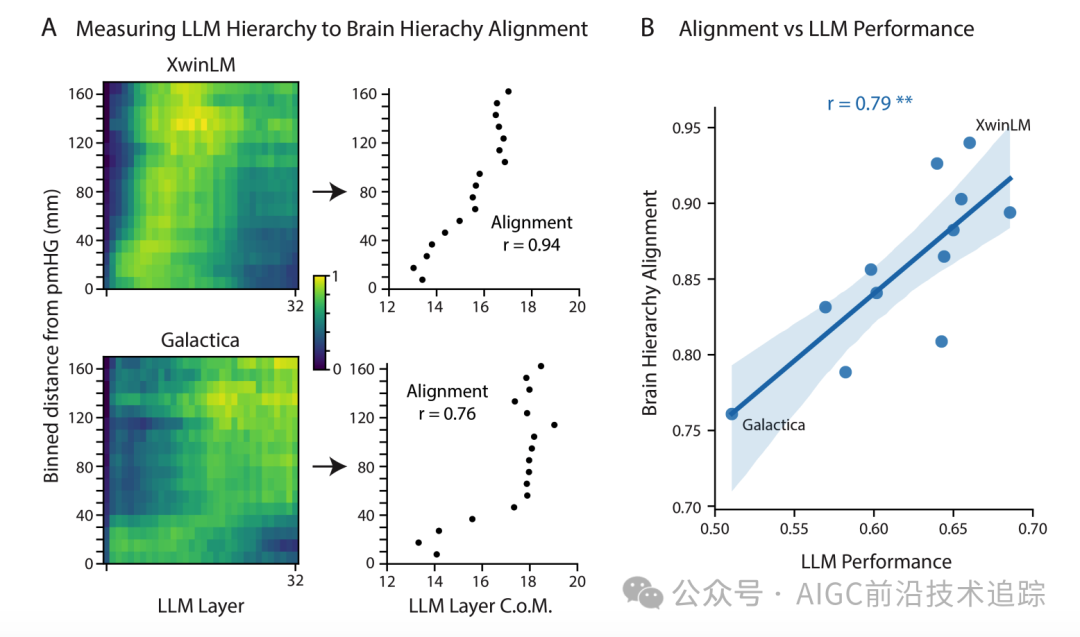

1. 层次对齐的计算策略

受视觉皮层研究启发,研究人员计算大脑与LLMs层次特征提取通路的对齐程度。由于大脑精确层次处理阶段不完全明确,仍以与pmHG的距离为量化指标。具体操作是将电极按距离pmHG分组,对每组电极各层的大脑相似性得分归一化并平均,得到层得分矩阵。通过计算质心确定与大脑层次最相似的LLM层,比较其与大脑层次结构的距离关系,发现部分模型在LLM层与大脑层次结构的对齐上呈更线性的增加趋势,为理解两者关系提供了线索。

2. 模型性能与层次对齐的相关性验证

以XwinLM(最高对齐得分)和Galactica(最低对齐得分)为例,两者基准性能差异显著。研究发现XwinLM在特征提取过程中从早期到晚期与大脑处理更一致。通过计算LLM层质心与距离pmHG的皮尔逊相关系数,发现大脑对齐程度与LLM性能呈显著正相关(Pearson (r = 0.79),(p = 0.0021))。用电极潜伏期替代距离pmHG进行分析,结果仍一致(Pearson (r = 0.89),(p = 0.0001)),且将受试者分组分析后,大脑层次对齐与LLM性能在两组中均显著相关。这充分证明了性能优的LLMs在特征提取时与大脑语言处理层次通路更线性对齐,为模型优化提供了方向。

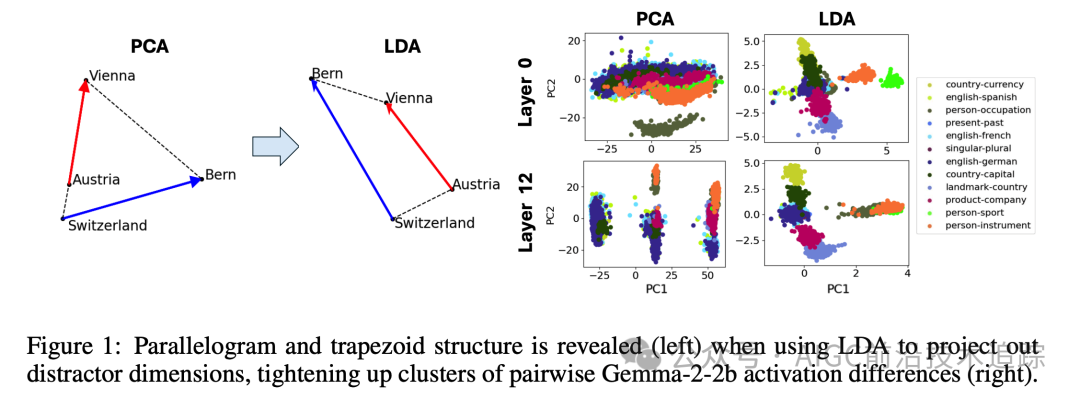

3. 模型间特征提取层次的比较方法

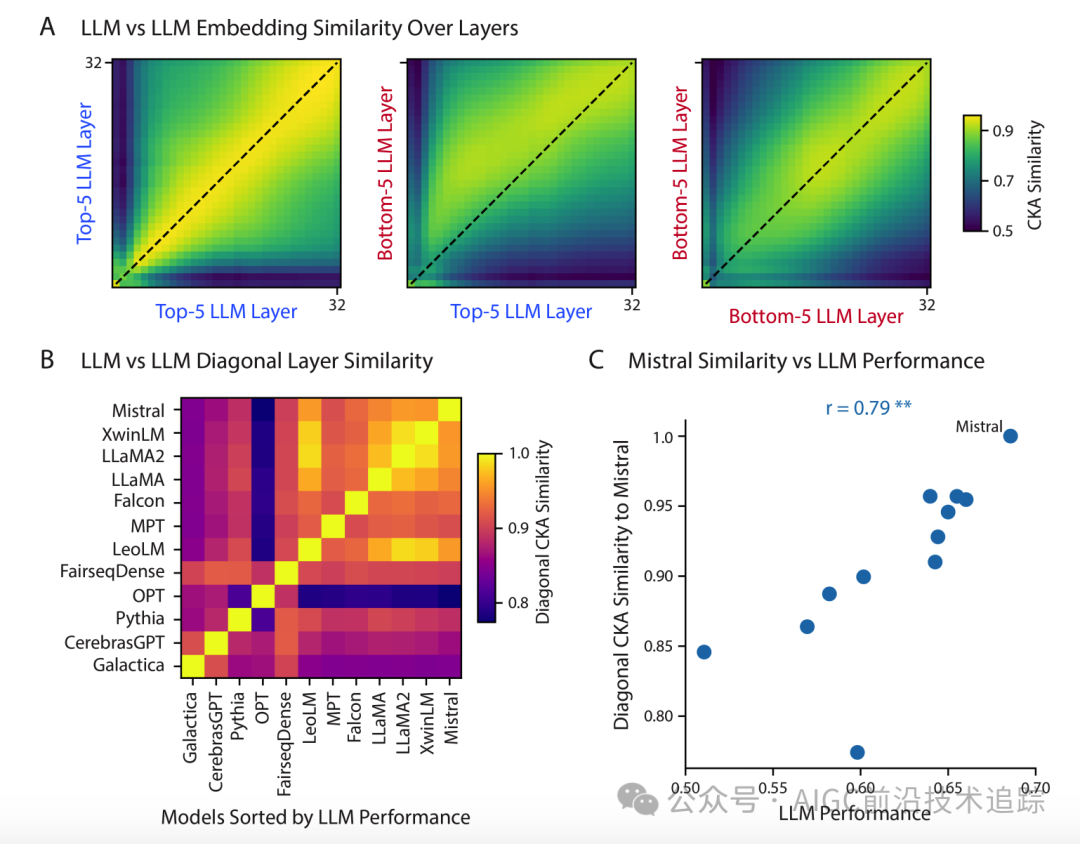

研究采用中心核对准(CKA)方法比较不同LLMs的特征提取层次。CKA类似于典型相关分析(CCA),但通过非线性核函数(如RBF)能更好测量高维数据相似性。对于两个模型,计算一个模型某层与另一个模型各层的CKA相似性,得到层间相似性矩阵,其元素反映模型在相应层的特征相似程度,为深入比较提供丰富信息。

4. 模型特征提取效率的差异剖析

按LLM基准性能将模型分前5名和后5名两组,分析其相似性矩阵。前5名模型在对角线方向高度相似,表明处理语言策略较一致;后5名模型早期层相似性低,后期一致性也不如前5名。对比前5名和后5名模型,最大相似性在对角线上有偏移,说明差的模型需更多层达与好模型相似的特征提取水平。计算各模型与最佳性能模型Mistral的对角线相似性,发现与LLM性能呈强烈正相关(Pearson (r = 0.79),(p = 0.0022)),揭示了LLMs特征提取层次的差异及低效特征提取或早期层学习不足对模型性能和大脑相似性的影响。

四、上下文信息

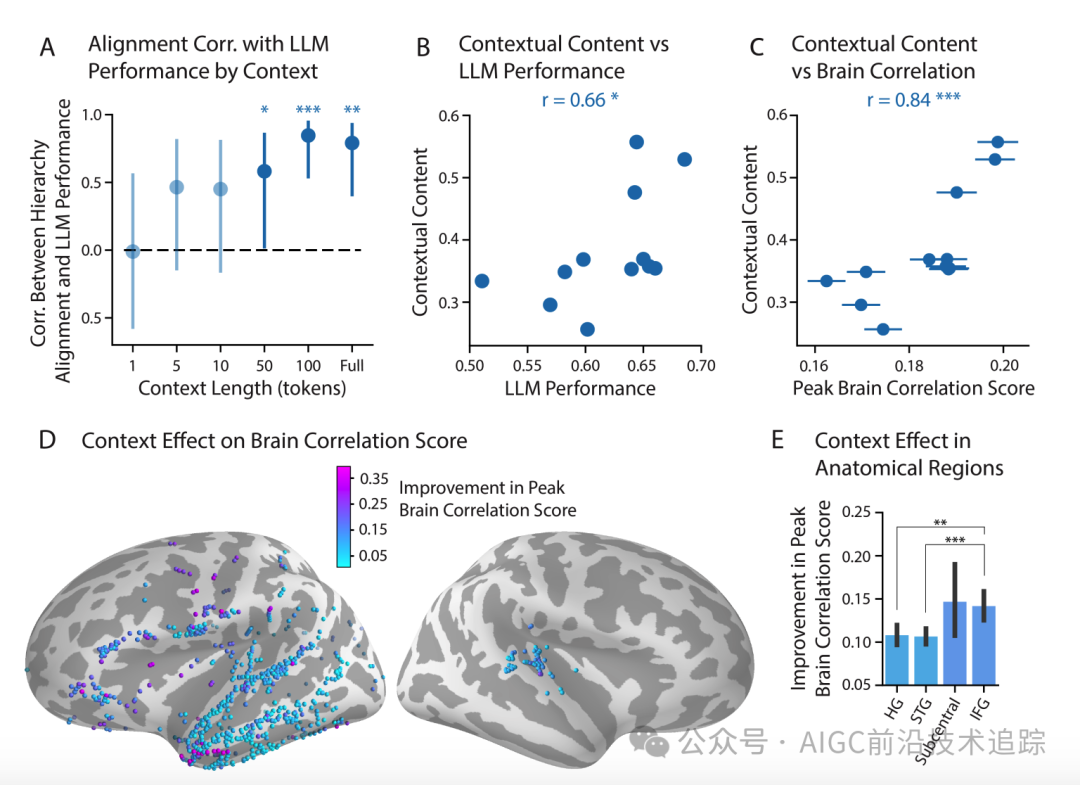

1. 上下文信息与层次对齐的关联分析

鉴于上下文信息对LLM大脑相似性的关键作用,研究推测其影响模型与大脑层次特征提取通路的对齐。通过限制LLMs的因果注意力机制,提供不同长度(1 - 100个词)的上下文窗口提取嵌入表示。实验发现,除1个词上下文情况外,上下文窗口长度与LLM性能和大脑层次对齐呈正相关,且在50个词及以上时显著。这表明上下文信息的丰富程度对模型的层次特征提取机制有重要影响,为优化模型提供了思考方向。

2. 上下文信息对模型性能和大脑相似性的影响

因长上下文长度下LLM性能与层次对齐正相关,研究预期好的模型能更好融入上下文信息。通过测量全上下文与1个词上下文情况下嵌入表示的CKA差异,定义为模型表示的上下文内容。研究发现上下文内容与LLM性能呈显著正相关(Spearman (r = 0.66),(p = 0.020)),与大脑相似性呈极强正相关(Spearman (r = 0.84),(p = 0.0006))。这表明上下文信息对自然和人工语言模型均至关重要,上下文特征提取能力是LLMs实现与大脑层次对齐的关键因素。研究还发现上下文信息对大脑相似性的影响在语言处理层次中越往后越关键,支持了大脑和LLMs均沿层次提取上下文的观点,也为模型改进提供了理论依据。

3. 研究结果总结与展望

本研究通过对12个LLMs的深入分析,揭示了LLMs与大脑语言处理机制在多个方面的趋同现象。在模型性能与大脑相似性方面,两者存在显著正相关,且模型层与大脑处理区域的对应关系随模型性能变化。在层次对齐上,性能好的模型与大脑的层次结构更线性对齐,模型间特征提取层次也存在明显差异。上下文信息对模型的影响研究表明,其对模型性能和大脑相似性至关重要,且在不同层次的语言处理中有不同作用。未来研究可进一步探索模型架构、训练策略等因素对这些趋同现象的影响,以推动LLMs向更类脑、高效的方向发展,同时也为神经科学研究提供更多启示。

论文地址:https://arxiv.org/pdf/2401.17671

Contextual Feature Extraction Hierarchies Converge in Large Language Models and the Brain

论文地址:https://arxiv.org/pdf/2410.19750

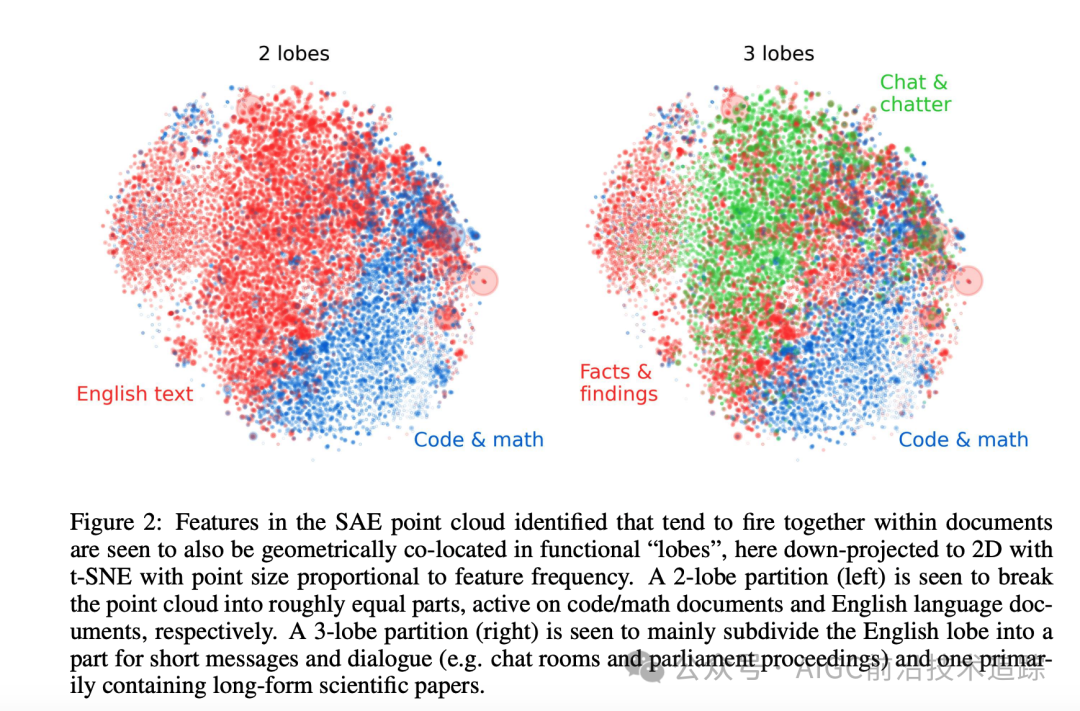

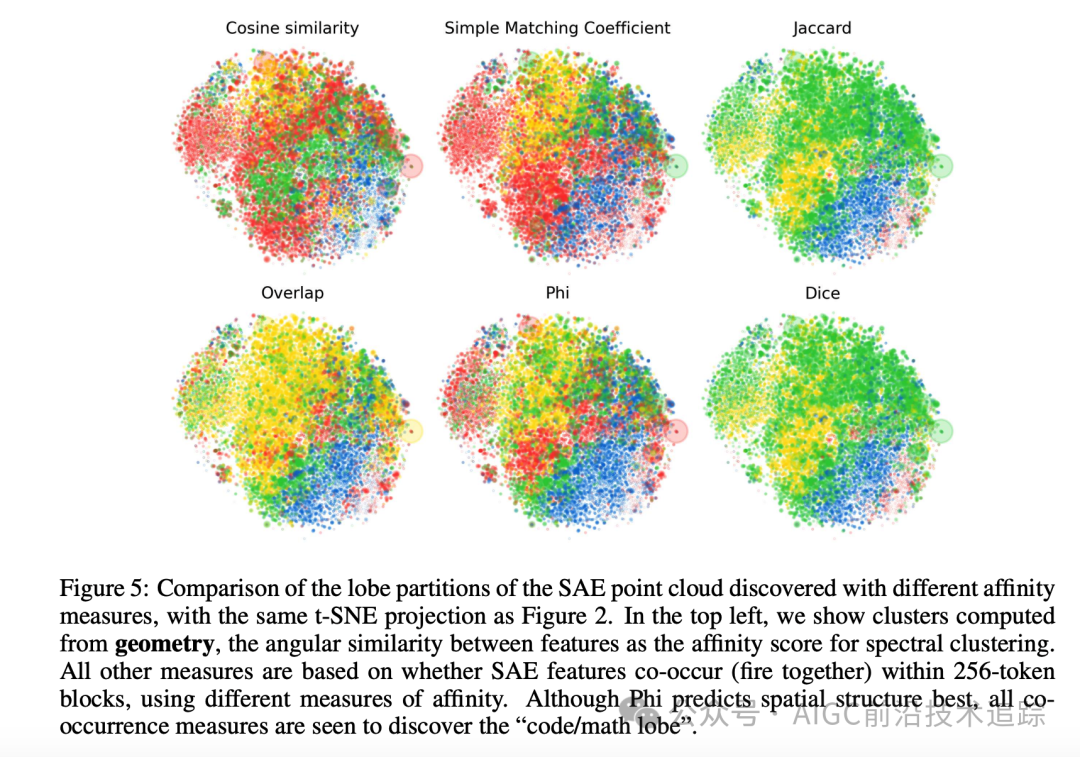

THE GEOMETRY OF CONCEPTS: SPARSE AUTOENCODER FEATURE

STRUCTURE

本文转载自AIGC前沿技术追踪,作者: 爱读论文的吴彦祖