微软推出MixLLM,全局混合精度量化方法助力模型效能飞跃

量化已成为压缩大语言模型(LLMs)的最有效方法之一。然而,现有的量化方案仍然存在不可忽视的准确性下降或系统效率低下的局限性。在本文中,我们全面分析了量化的一般原则对准确性、内存消耗和系统效率三角关系的影响。我们提出了MixLLM,这是一种基于输出特征之间的混合精度量化的方法。MixLLM从全局视角识别高显著性的输出特征,而非仅在单层内部,有效地为最需要的输出特征分配更大的位宽,从而在低内存消耗的情况下实现良好的准确性。我们提出了算法-系统协同设计的量化配置的最佳点,以实现高准确性和系统效率。

为应对系统挑战,我们设计了两步去量化方法:轻松利用int8 Tensor Core,并通过快速数据类型转换显著减少去量化开销,同时提出软件流水线以最大程度地重叠内存访问、去量化和矩阵乘法。广泛的实验表明,仅增加10%的比特数,对于Llama 3.1 70B模型,困惑度(PPL)增加可从约0.5降低到0.2以内,同时在三个流行模型上,MMLU-Pro平均提高了0.93。除了卓越的准确性,MixLLM还实现了最先进的系统效率。

论文: https://arxiv.org/pdf/2412.14590

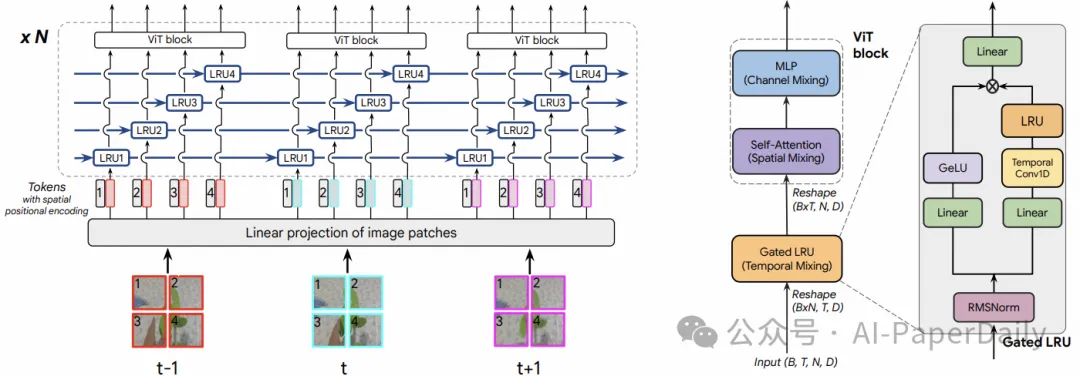

2. TRecViT: A Recurrent Video Transformer

我们提出了一种用于视频建模的新模块。该模块基于时间-空间-通道的分解方法,为每个维度设计了专门的块:门控线性循环单元(LRUs)在时间维度上执行信息混合、自注意力层在空间维度上进行混合、多层感知机(MLPs)处理通道维度。这个被称为TRecViT的架构在稀疏和密集任务上表现出色,无论是在监督学习还是自监督学习模式下都能良好运行。值得注意的是,我们的模型具有因果性,并且在大规模视频数据集(如SSv2、Kinetics400)上的性能优于或与纯注意力模型ViViT-L相当,同时具有以下显著优势:参数数量减少3倍、内存占用减少12倍、计算复杂度(FLOPs)降低5倍。

论文: https://arxiv.org/pdf/2412.14294

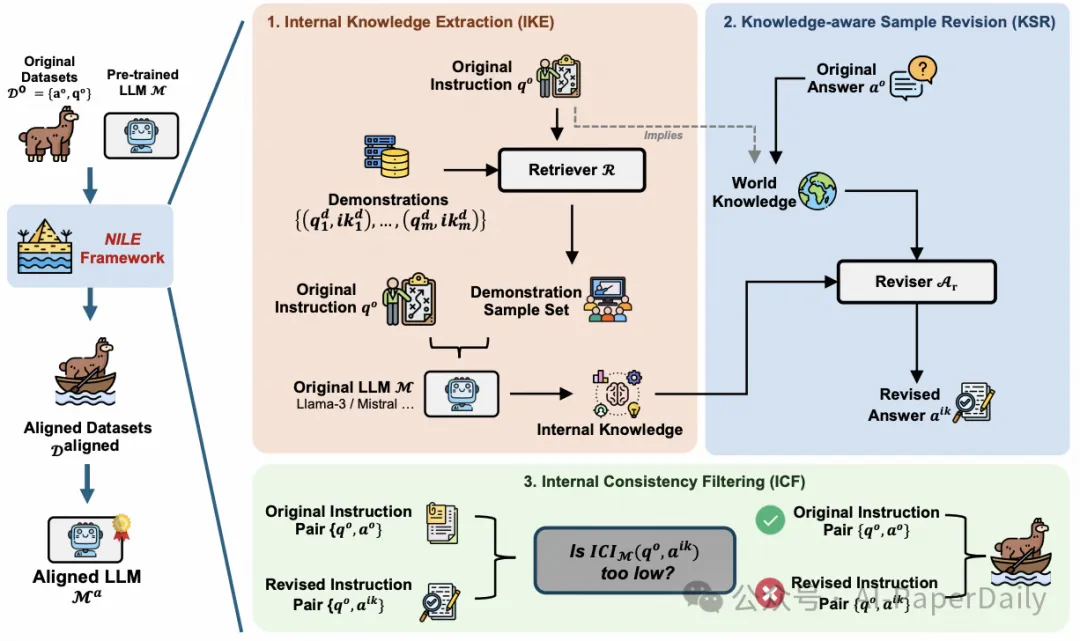

3. NILE: Internal Consistency Alignment in Large Language Models

作为增强大语言模型(LLM)与人类意图对齐的关键步骤,指令微调(Instruction Fine-Tuning,IFT)对数据集质量有着极高的要求。然而,现有的IFT数据集常常包含与模型预训练阶段学习的内部知识不一致的信息,这可能严重影响IFT的效果。

为解决这一问题,我们引入了NILE(内部一致性对齐)框架,旨在优化IFT数据集,进一步释放LLM的潜能。NILE的工作原理是:提取目标预训练LLM对指令数据相关的内部知识、利用这些内部知识修正IFT数据集中的答案、提出创新的内部一致性过滤(Internal Consistency Filtering,ICF)方法,筛选与模型内部知识高度一致的训练样本。

我们的实验证明,经NILE对齐的IFT数据集显著提升了LLM在多个能力评估数据集上的性能:Arena-Hard数据集性能提升高达66.6%、Alpaca-Eval V2数据集性能提升68.5%。进一步分析确认,NILE框架的每个组件都对这些显著的性能提升做出了贡献,并提供了有力证据:数据集与预训练内部知识的一致性对于最大化LLM潜力至关重要。

论文: https://arxiv.org/pdf/2412.16686

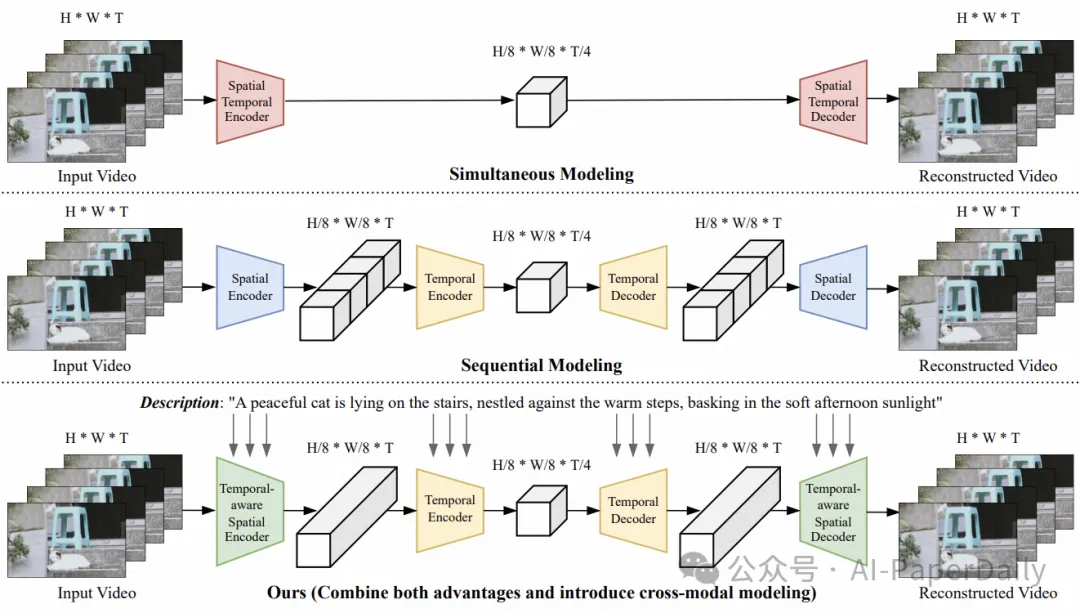

4. Large Motion Video Autoencoding with Cross-modal Video VAE

学习一个鲁棒的视频变分自编码器(VAE)对于减少视频冗余和促进高效视频生成至关重要。直接将图像VAE孤立地应用于单个帧可能导致时间不一致性和次优压缩率,这是由于缺乏时间维度的压缩。现有的视频VAE已开始解决时间压缩问题,但往往仍然存在重建性能不足的挑战。

在本文中,我们提出了一种新颖且强大的视自编码器,能够实现高保真视频编码。研究的主要创新点包括:空间-时间压缩策略、文本引导增强、模型多样性提升。

论文: https://arxiv.org/pdf/2412.17805

本文转载自 AI-PaperDaily,作者: AI-PaperDaily