牛津&Meta最新!PartGen:基于多视图扩散模型的多模态部件级3D生成和重建!

文章链接:https://arxiv.org/pdf/2412.18608

项目链接:https://silent-chen.github.io/PartGen/

总结速览

解决的问题

当前的3D生成与扫描技术能够生成具有高质量形状和纹理的3D资产,但这些资产通常是单一的、不具备结构的整体表示(如隐式神经场、高斯混合体或网格)。然而,专业应用与创意工作流中需要结构化的3D资产,这些资产由具有独立意义的部分组成,便于重用、编辑与动画制作。

提出的方案

本文提出了PartGen,能够将无结构的3D对象转化为具有语义意义的组成部分。方法分为两个关键阶段:

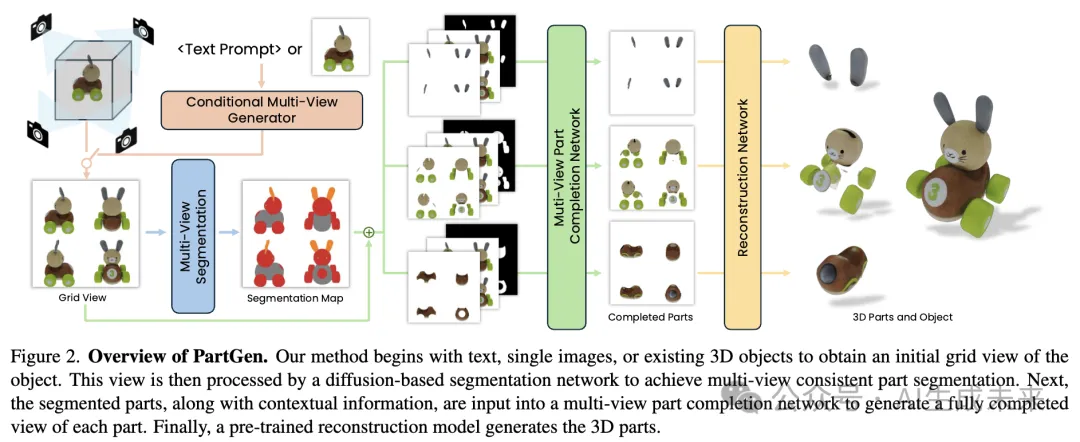

- 部分分割:通过多视图扩散模型生成多个视角的一致分割图,将3D对象分割为多个部分。

- 部分补全与重建:利用第二个多视图扩散模型补全各部分的遮挡区域,并通过3D重建网络生成完整的3D部件,确保部件间的无缝整合。

应用的技术

- 多视图扩散模型:用于生成视角一致的分割图,并捕捉多种可能的分割方案,符合艺术家分割对象的习惯。

- 生成式补全:通过上下文信息完成遮挡部件,甚至在信息缺失的情况下进行“合理幻觉”,生成完整的不可见部分。

- 3D重建网络:将补全的视图转换为高质量的3D部件,实现模型的整体性和一致性。

达到的效果

- 提升分割与重建质量:相比现有分割与部件提取baseline,PartGen在分割精度和部件完整性上表现出色。

- 多输入支持:支持从文本、图像或无结构3D对象生成具有部分结构的3D资产。

- 下游任务应用:支持3D部分编辑任务,例如部件替换、移除、独立编辑等,满足动画制作、游戏开发和机器人应用需求。

- 语义一致性:生成的部件语义清晰,整体结构完整,为3D理解和空间智能提供支持。

方法

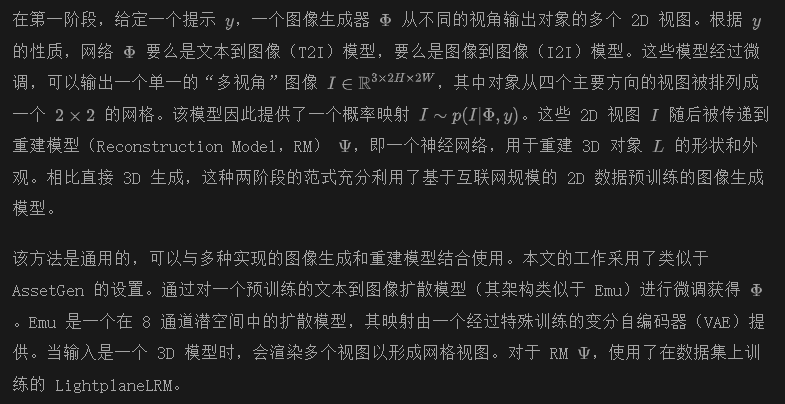

PartGen是一个能够将 3D 对象完全分解为完整 3D 部件的框架。每个部件都是独立的、可供人类理解的、自包含的元素,组成了 3D 对象的组合表示。PartGen 能够接受不同的输入模态(文本提示、图像提示或 3D 资产),并通过重新利用一个强大的多视角扩散模型来执行部件分割和补全任务。PartGen 的概述如下图 2 所示。

本节简要介绍了 3D 生成的多视角扩散模型背景,以及 PartGen 如何应用于文本、图像或 3D 模型输入。然后,描述了 PartGen 如何自动分割、补全和重建 3D 部件。

3D 生成的背景

多视角扩散模型方法通常采用两阶段的 3D 生成方法。

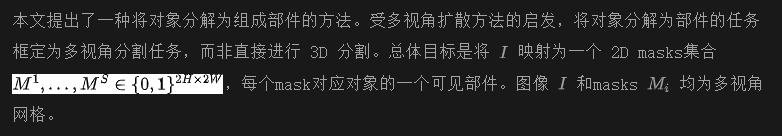

多视角部件分割

通过多视角扩散的视角处理 3D 对象分割有以下几个优势:

- 它能轻松集成到现有的多视角框架中。

- 将对象分解为部件本质上是一个非确定性、模糊的任务,因为它取决于所需的详细程度、个人偏好以及艺术意图。

实现细节

上下文部件补全

部件重建

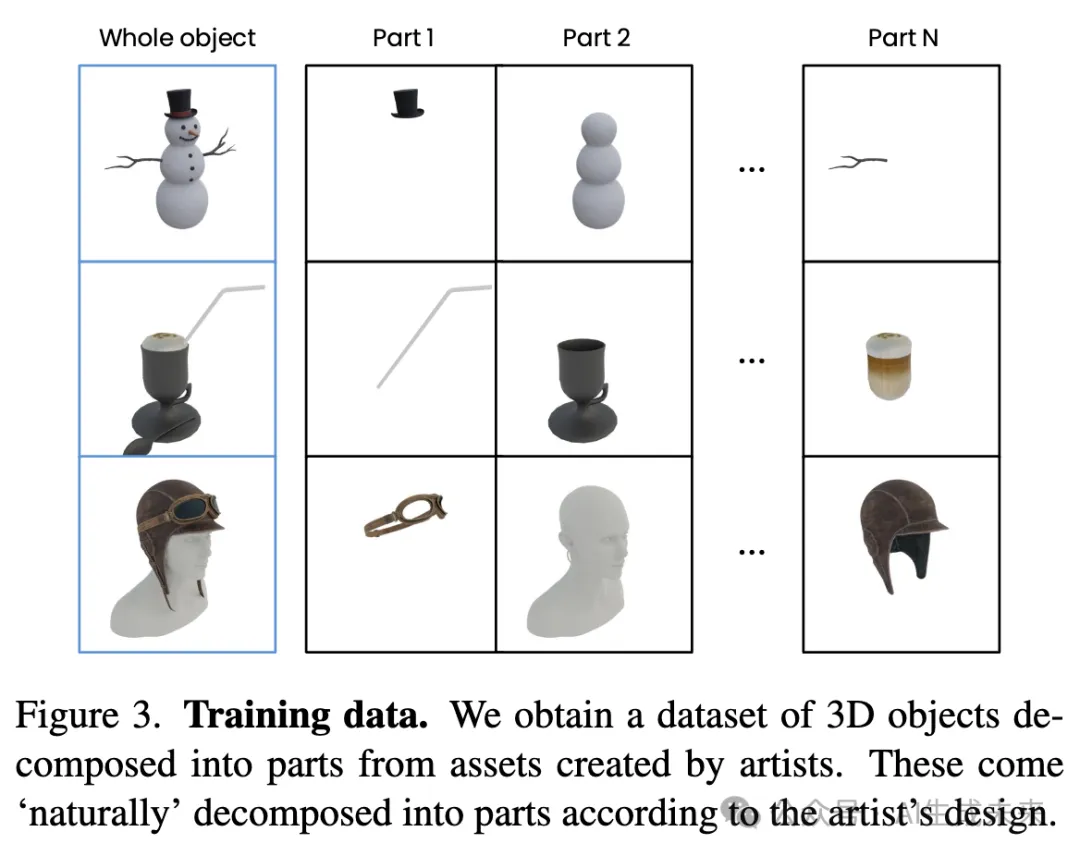

训练数据

根据三种需要微调的模型,对数据进行了不同的预处理:

多视角生成器数据

实验

评估协议

首先分别评估pipeline中的两个主要组件:部件分割和部件补全与重建。然后,评估分解后的重建结果与原始对象的匹配程度。所有实验均使用数据集中的 100 个保留对象。

部件分割

评估协议

为分割任务设置了以下两种场景:

排序列表通过对候选区域评分并移除冗余部分生成。随后,将这些分割与真实分割Mk进行匹配,并报告平均精度均值(mAP)。

由于问题本身的不确定性,该精度在实际应用中可能较低:算法预测的许多部件可能无法完全匹配特定艺术家的选择。

Baselines

采用原始的和微调后的 SAM2 作为多视角分割的基线方法,并使用以下两种方式对 SAM2 进行微调:

- mask解码器微调:在本文的数据集上使用真实mask和随机选择的种子点微调 SAM2 的mask解码器,针对不同视角进行训练。

- 多视角拼接微调:将四个正交视角拼接为多视角图像I,并微调 SAM2 以预测多视角mask M(此情况下,种子点随机落在某一视角中)。

对于每个输入图像和种子点,SAM2 生成三个区域:

- 自动分割:在对象上分布一组查询点作为种子点,获得每个种子点的三个不同区域。

- 种子分割:直接返回给定种子点的分割结果。

此外,与最新工作 Part123 进行了比较。

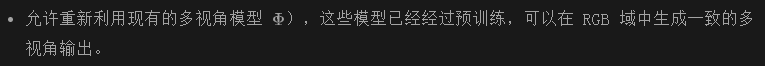

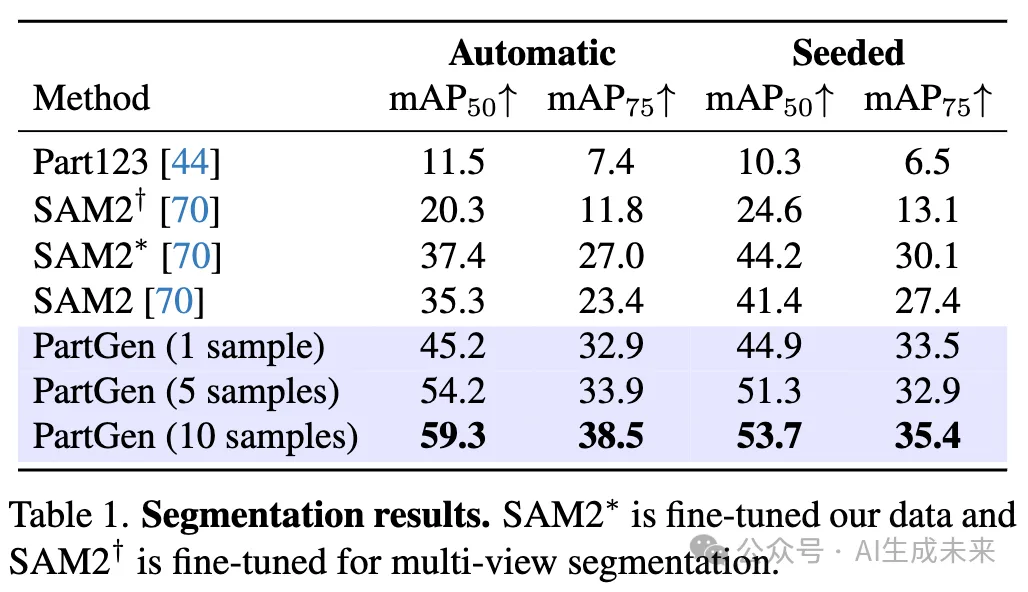

结果

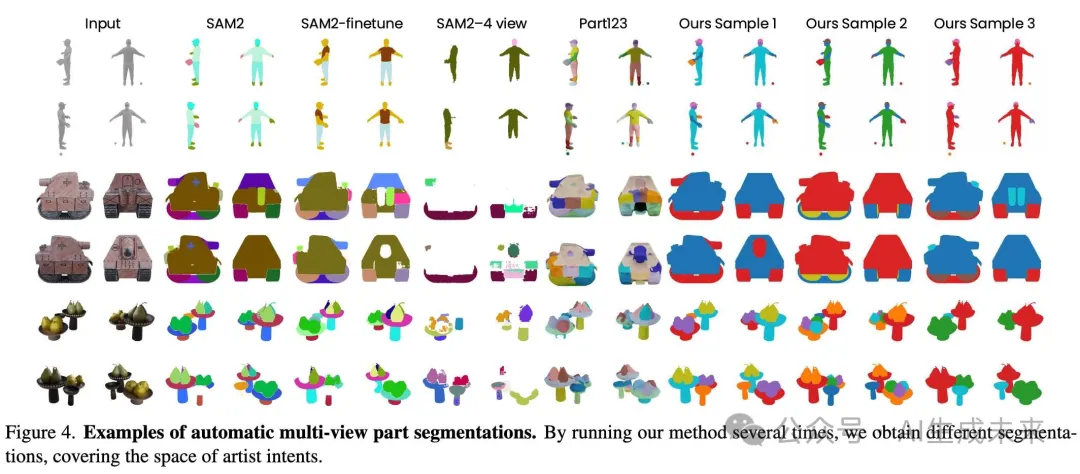

如下表 1 所示,本文的方法在 mAP 指标上的结果显著高于其他方法,包括微调后的 SAM2。这主要归因于分割任务的模糊性,基于生成器的方法能够更好地捕捉这种模糊性。定性结果如下图 4 所示。

部件补全与重建

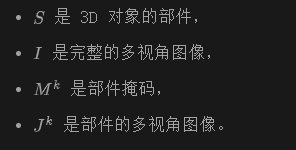

对于每个模型,随机选择一个部件索引k,以下表示中省略k以简化符号。

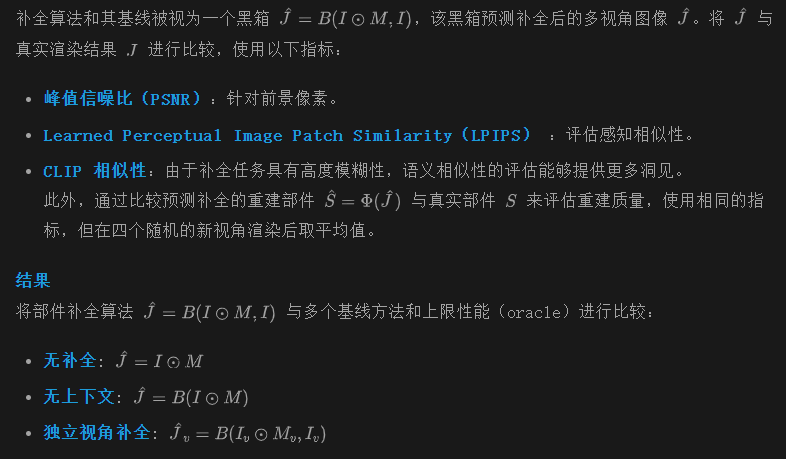

评估协议

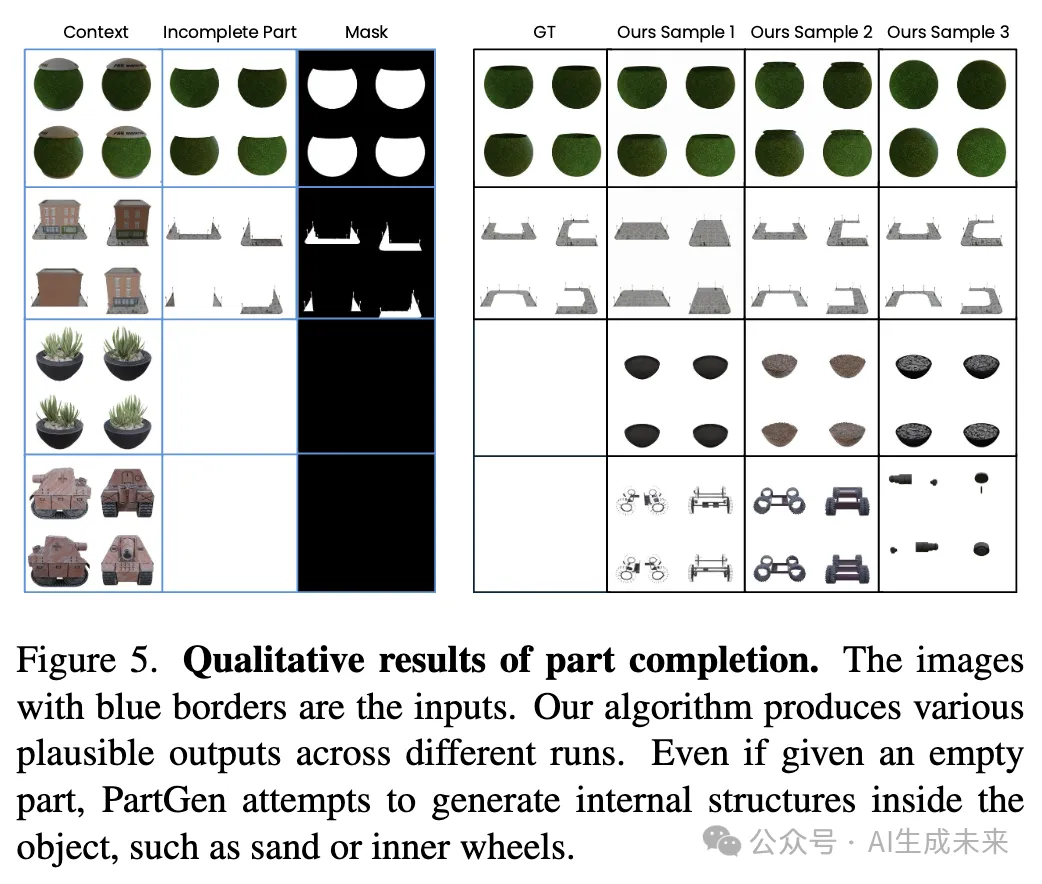

如下表 2 所示,本文的方法在性能上大幅超越基线方法。联合多视角推理和上下文部件补全对取得良好性能至关重要。定性结果见前面图 5。

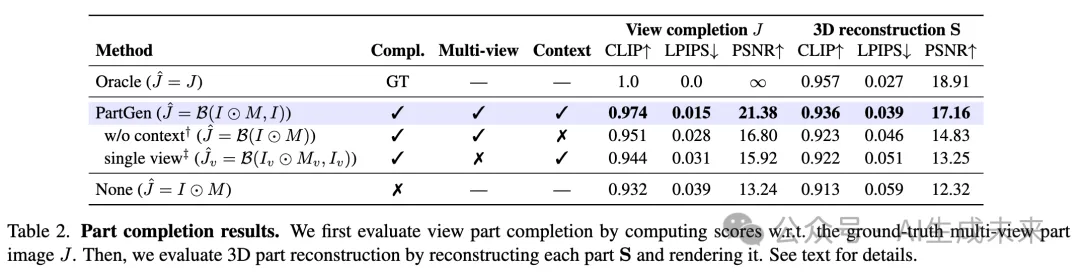

部件重组

应用

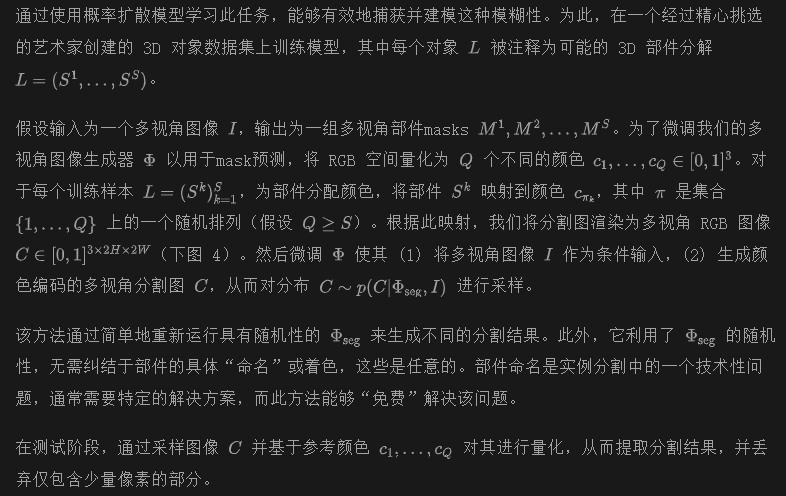

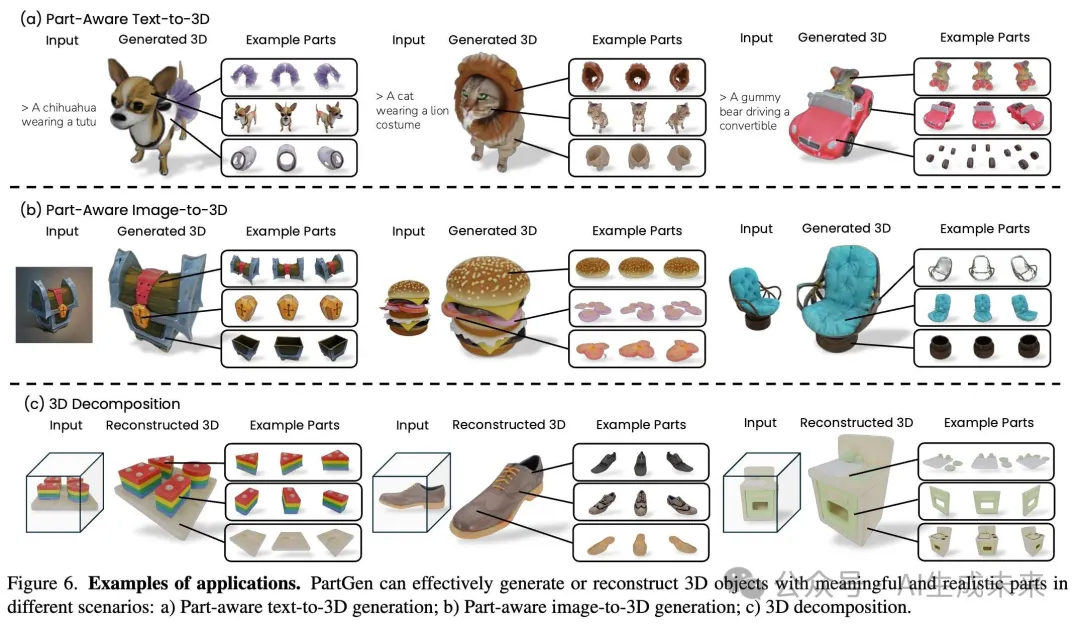

基于部件的文本到 3D 生成

将 PartGen 应用于基于部件的文本到 3D 生成。训练的文本到多视角生成器类似于 [76],接受文本提示作为输入,输出四视图网格。

- 示例中使用了DreamFusion的提示。

- 下图 6 表明,PartGen 即使在高度遮挡(如橡皮糖熊)等具有挑战性的情况下,也能有效生成具有清晰和完整部件的 3D 对象。

基于部件的图像到 3D 生成

进一步扩展 PartGen 到基于部件的图像到 3D 生成,在文本到多视角生成器的基础上,通过类似于 [95] 的策略微调生成器以接受图像作为输入。上图 6 的结果表明,PartGen 在这一任务中同样表现出色。

真实世界 3D 对象分解

PartGen 还可以分解真实世界的 3D 对象。使用 Google Scanned Objects (GSO) 的对象进行实验。

- 对于每个 GSO 3D 对象,渲染不同视角以获得图像网格,并按上述方式应用 PartGen。

- 上图 6 的最后一行展示了 PartGen 在分解真实世界 3D 对象方面的效果。

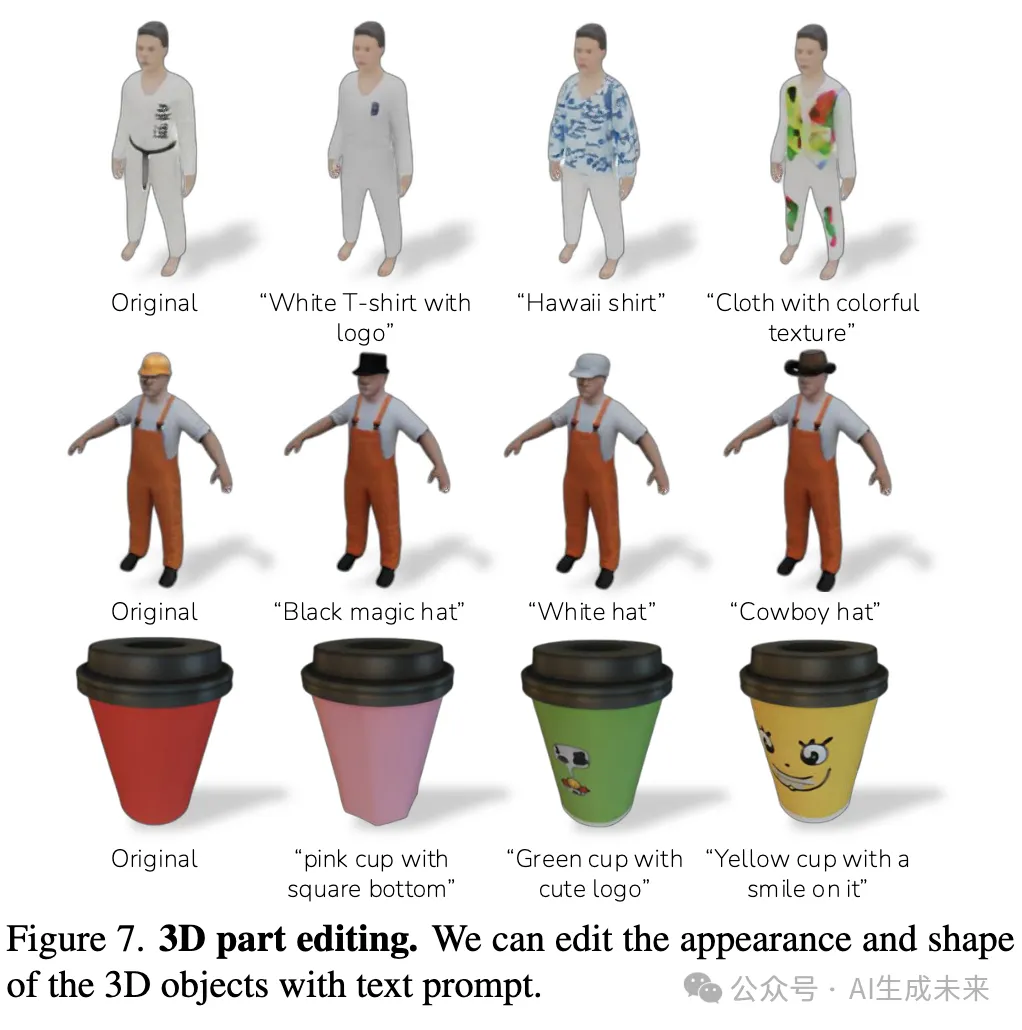

3D 部件编辑

展示了分解后的 3D 部件可以通过文本输入进一步修改。

- 如下图 7 所示,方法的变体使得能够基于文本提示有效编辑部件的形状和纹理。

- 3D 编辑模型的详细信息见补充材料。

结论

PartGen,一种从文本、图像或非结构化 3D 对象生成或重建组成性 3D 对象的新方法。PartGen 可以重建即使是仅部分可见或完全不可见的 3D 部件,利用特制的多视角扩散先验进行引导。还展示了 PartGen 的几个应用,包括基于文本的部件编辑。这是朝着生成更适用于专业工作流的 3D 资产迈出的重要一步。

本文转自AI生成未来 ,作者:AI生成未来