大语言模型o1慢思考推理系统的破局之路:模仿、探索与自我提升的深度揭秘! 精华

最近,像 o1 这样的慢思考推理系统在解决复杂推理任务上表现出色,但核心技术未公开。研究界想探索其技术基础,本文在此背景下展开研究。其重要意义在于提出的框架和方法能有效训练推理模型,在多个基准测试上取得不错效果,有助于推动大语言模型在复杂推理领域的发展,缩小与行业领先系统的差距,且研究资源公开,利于后续进一步研究和合作。

解读

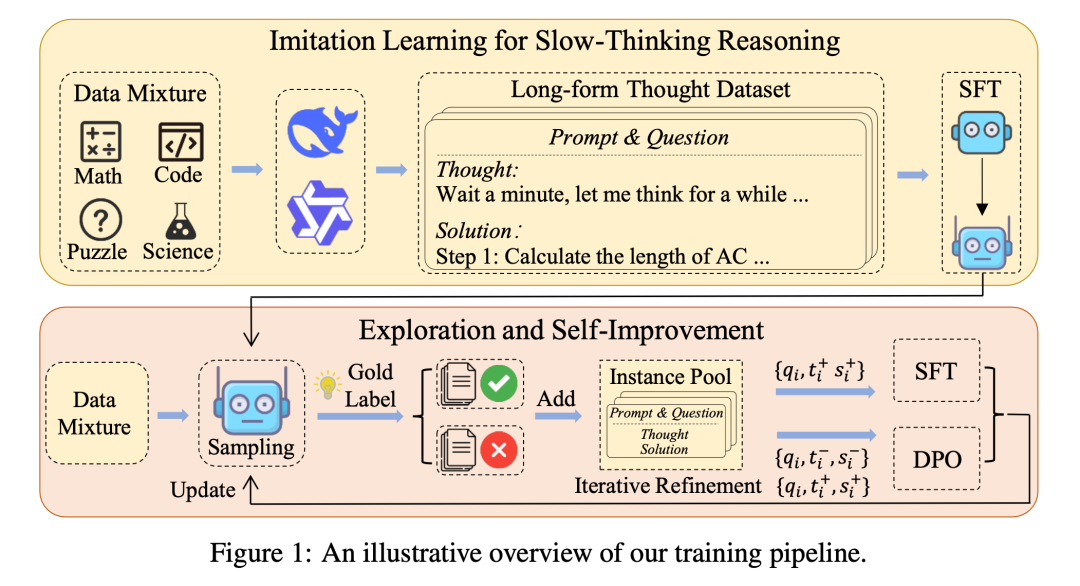

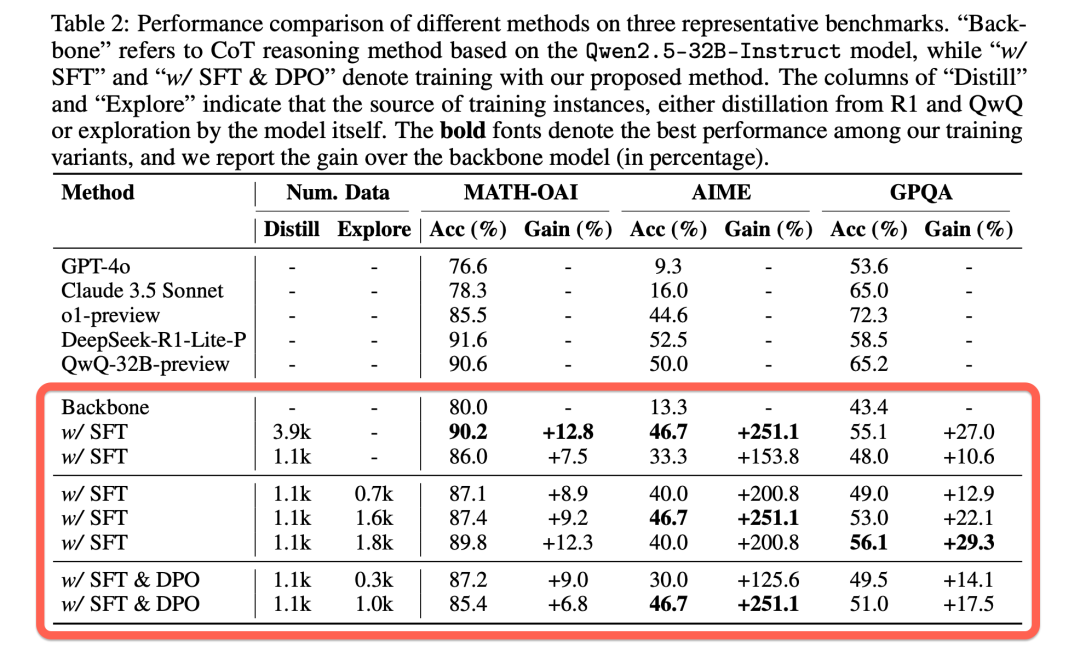

本文旨在复现类似 o1 的慢思考推理系统,提出“模仿、探索和自我改进”框架。首先通过蒸馏长格式思维数据微调模型以启动慢思考模式,接着让模型探索难题生成多轮结果以找到高质量解题轨迹,最后利用探索所得轨迹迭代优化训练数据集实现自我提升。在 MATH-OAI、AIME 和 GPQA 三个基准测试上的实验表明,该方法性能与行业推理系统相比具有竞争力,如基于蒸馏的 3900 例训练变体在部分测试中表现突出,探索和自我改进方法在使用 1100 例蒸馏数据时也有良好效果。

- 研究背景:慢思考推理系统如 o1 在解决复杂推理任务上表现突出,但因其由工业界开发维护,技术细节未公开,研究界虽积极探索复现但现有研究存在局限,如局限于特定领域或基础模型较弱。此前作者团队也有相关研究但遇到如奖励模型泛化性差、推理耗时、无法实现训练时缩放等问题,在此背景下开展本次研究。

- 技术创新:

a.提出“模仿、探索和自我改进”的全新框架来训练推理模型,区别于以往复杂的奖励模型和树搜索算法,通过简单有效的方式提升模型性能。

b.采用蒸馏 o1 类似系统的长格式思维数据构建数据集,并进行数据混合与预处理,确保数据质量和多样性,有效引导模型学习慢思考推理。

c.在自我改进阶段应用监督微调与直接偏好优化相结合的方法,并通过迭代优化训练数据,利用探索生成的高质量轨迹提升模型能力。

- 实现设计:

a.模仿学习:从 DeepSeek - R1 - Lite - Preview 和 QwQ - 32B - preview 等系统收集长格式思维数据,统一格式并混合不同领域及难度问题数据后进行预处理,再用监督微调训练 Qwen2.5 - 32B - Instruct 模型,使其遵循慢思考输出格式。

b.探索与自我改进:让模型对难题多次生成候选轨迹收集正确答案进行探索;迭代优化训练数据,从外部系统蒸馏数据开始,不断纳入新轨迹并过滤;通过监督微调(以长度和困惑度筛选数据)和直接偏好优化(选择合适正负实例)方法利用探索数据提升模型,同时考虑在未来用强化学习进一步优化。

- 实验结果:

a.与行业系统对比:在 MATH - OAI、AIME、GPQA 基准测试上,行业级慢思考推理系统性能优异,本文基于蒸馏的 3900 例训练变体接近行业水平,如在 AIME 上达到 46.7%准确率,MATH - OAI 上达 90.2%准确率。

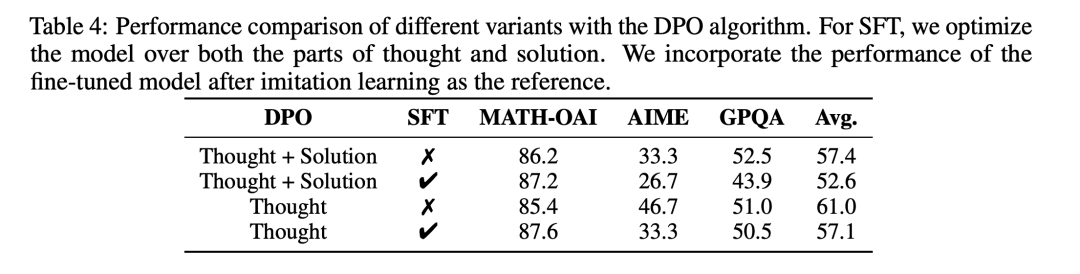

b.不同训练方法对比:迭代训练变体也有成效,如在 AIME 上结合探索和自我改进使性能从 33.3%提升到 40.0%及以上;数据混合实验表明难题数据和多领域数据对提升性能重要;DPO 训练中仅对齐思维过程有较好效果且 SFT 损失在某些设置下影响不大。

近年来,类似于 OpenAI 的 o1 等慢思考(slow-thinking)推理系统在解决复杂推理任务方面展现了卓越的能力。这些系统在回答查询之前,经过较长时间的思考与推理,能够生成更加全面、准确且有理有据的解决方案。然而,这些系统主要由工业界开发和维护,其核心技术尚未公开披露。因此,越来越多的研究工作开始致力于探索这些强大推理系统背后的技术基础。在此背景下,我们的团队致力于实现类似于 o1 的推理系统,希望开发一个技术开放的慢思考推理模型。本文介绍了我们在复现 o1 类推理系统方面的研究进展,提出了一个 “模仿、探索和自我提升” 的框架,作为训练推理模型的主要技术手段。在本工作中,我们仅使用 1100 条蒸馏的长思维链数据作为种子数据,通过自我探索与改进就能够取得不错的效果: 在非常困难的数学奥林匹克数据集 AIME 达到了 46.7 的评分,在 MATH-OAI 上也达到了 87.4 的评分,在跨学科 GPQA 上也取得了 53.0 的评分。

1. 背景

慢思考推理系统通过在回答用户查询之前进行深入的内部推理,能够有效解决复杂的推理任务。这种方法不同于传统的链式思维(chain-of-thought)推理,它允许模型在更长的时间内进行深度思考,并利用更多的计算资源来推演,从而生成更为复杂和细致的推理步骤。此类能力在解决数学问题、编程挑战和逻辑推理等任务中尤为突出。

然而,由于工业界对这些系统的核心技术细节通常保密,学术界在再现这些系统时面临着诸多挑战。现有的研究大多局限于特定领域(如数学领域),或基于相对较弱的基础模型,导致所实现的系统在性能上与工业级系统相比存在明显差距。因此,开发一个技术开放的 o1 类推理系统,仍然是一项极具挑战性的任务。

2. 研究方法

为了实现这一目标,我们提出了一个“模仿、探索与自我提升”的三阶段训练框架。该框架旨在通过训练模型模仿长思维链中的思考模式,鼓励模型在面对具有挑战性的问题时进行深入探索,并通过迭代改进训练数据,不断提升模型的推理能力。

2.1. 模仿(Imitate)

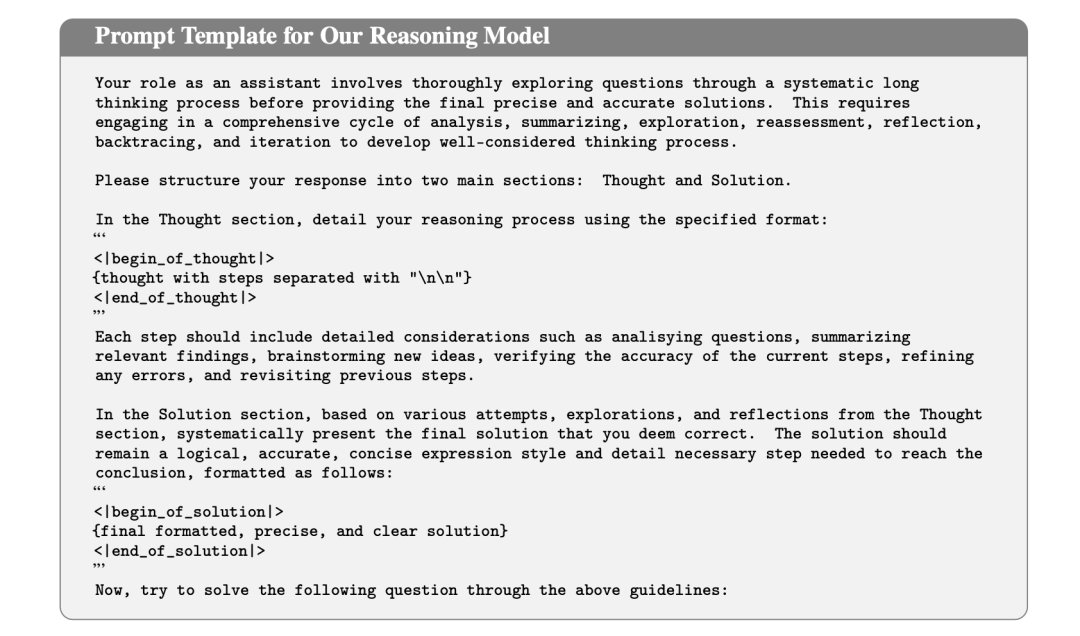

在初始阶段,我们通过收集和整理长思维链数据,对模型进行微调,使其能够在回答问题之前,生成详细的内部推理步骤。这些思维过程包括规划、分而治之、自我修正、总结和回溯等复杂的推理行为。

为了构建这样的训练数据,我们采用了数据蒸馏的方法,从现有的 o1 类推理系统(如 和 )中提取关于Math,Code,Science,Puzzle领域的长思维链。这些数据经过预处理后,作为模型的训练数据,帮助模型学习如何按照指定的格式生成长思维链和最终的解决方案。

2.2. 探索(Explore)

仅仅通过模仿,模型可能还不足以处理具有挑战性的问题。为此,我们鼓励模型在困难的问题上进行探索,生成多个可能的解答路径(称为“轨迹”)。通过生成多样化的解答,模型有更大的机会找到正确的解决方案。

在实践中,我们采用了简单的搜索策略,对每个问题生成多个解答轨迹,直到找到包含正确答案的解答。随着生成的轨迹数量增加,我们可以收集到更多高质量的解答,这些解答也有助于进一步提升模型的能力。

2.3. 自我提升(Self-Improve)

最后,我们利用模型在探索过程中获得的正确轨迹,进一步强化其推理能力。通过不断将新的高质量解答融入训练数据,模型能够在每次迭代中改进自身,特别是在处理复杂任务时,表现出更为卓越的推理能力。

在这个阶段,我们采用了两种优化方法来进一步提升模型的推理能力。一是继续进行监督微调(SFT),利用模型生成的高质量解答作为训练数据,帮助模型不断优化其生成能力;二是采用直接偏好优化(DPO),通过比较高质量与低质量解答之间的差异,指导模型学习更加优越的生成策略,从而提高其解答质量和推理效果。

3.实验设计

3.1 实验设置

为了验证我们方法的有效性,我们在三个具有挑战性的基准数据集上进行了广泛的实验:

- MATH-OAI:包含500道数学竞赛题目,来源于 MATH 测试集。

- AIME:由30道难度较高的数学问题组成,专为挑战顶尖高中生的解决问题能力而设计。

- GPQA:包含198道生物、物理和化学领域的选择题。

由于 在多个评测中表现优异,能够提供出色的推理能力,我们选择了该模型作为基础模型。为了与工业级系统进行全面比较,我们将我们的模型与几款领先的 o1 类模型进行了对比,包括 、 和 。

3.2 实验结果

- 工业界慢思考推理系统在三个基准测试中都取得了优异的表现,尤其在最具挑战性的基准测试 AIME 上改进显著。总体而言,o1-preview 表现出更均衡的性能,而 和 在数学领域表现更好。这些结果表明慢思考在增强 LLM 的复杂推理能力方面的有效性。

- 使用经过预处理后从 和 获得的 3.9k 个蒸馏实例进行SFT后,我们的方法在 AIME 上实现了 46.7% 的准确率,在 MATH-OAI 上实现了 90.2% 的准确率(表2第二部分的第一组)。同时,训练数据从 1.1k 增加到 3.9k 带来的效果表明,增加高质量数据的数量可以有效提高模型性能(表2第二部分的第一组)。

- 我们方法的迭代训练变体(表2第二部分中的第二组和第三组)也可以在三个基准上取得令人满意的结果。使用带有 SFT 1.1k 的变体作为参考,我们观察到结合探索和自我改进可以有效提高性能,例如,MATH-OAI 的性能从 86.0% 提高到 89.8%,AIME 的性能从 33.3% 提高到 46.7%。

3.3 进一步分析

3.3.1 关于模仿学习

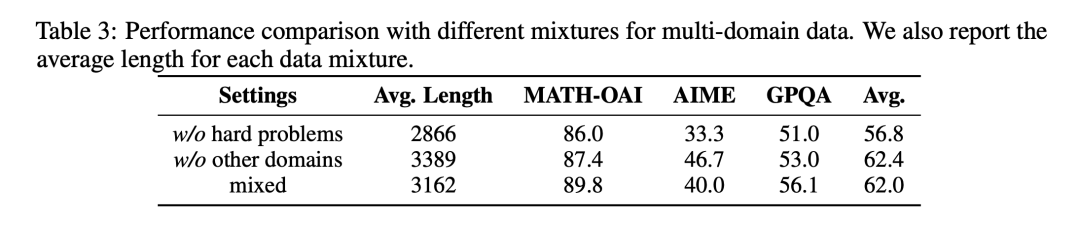

- 去除困难数学问题会显著降低模型的表现,特别是在 AIME 这一最具挑战性的基准上。这表明困难问题对于提升推理模型的能力至关重要,尤其是在需要较长思考过程的情况下。

- 仅使用数学数据(不包含其他领域数据)有助于提升 AIME 的性能,但对 MATH-OAI 和 GPQA 的性能有负面影响。

3.3.2 关于DPO

- 仅使用 Thought 的实验表现出较为积极的结果。可能的原因是思考过程是学习的核心部分,一旦思考过程得到很好的建立,LLM 能够容易地生成相应的解决方案。

- 当同时使用 Thought 和 Solution 时,SFT 损失对优化似乎没有正面影响,这可能是因为解决方案已经在 DPO 训练过程中得到了整合。

4. 研究意义

4.1. 核心贡献

- 我们提出了一个简单而有效的三阶段训练框架,通过“模仿、探索和自我提升”来训练模型,实现了类似 o1 的慢思考推理能力。

- 我们证明了长思维链在跨领域的可迁移性,即使只在数学领域进行训练,模型也能在科学和其他领域展示出色的推理能力。

- 我们给出了一个开放技术细节的类 o1 系统实现方法,在多个具有挑战性的基准数据集上取得了与工业级系统相当的性能。

4.2. 研究意义

我们的研究表明,通过适当的训练策略和数据选择,大语言模型能够有效地生成长思维链,从而解决复杂的推理任务,这有助于推动开源社区的相关研究。

此外,我们的方法不依赖复杂的奖励模型或显式的树搜索算法,使得实现过程更加简单高效,这为未来在更多领域和更大规模上训练类似的推理系统提供了可行的途径。

4.3. 未来方向

在未来的研究中,我们计划:

- 扩展探索的规模:增加模型在探索阶段的规模,以更全面地提升模型能力。

- 丰富训练数据:通过引入更多领域和难度级别的高质量数据,进一步增强模型的泛化能力。

5.总结

本文介绍了我们在实现 o1 类慢思考推理系统方面的研究进展,提出了一个“模仿、探索和自我提升”的训练框架。通过实验验证,我们的方法在多个具有挑战性的基准数据集上取得了优异的性能,证明了其有效性和巨大潜力。我们的主要发现可以概括为以下几点:

- 通过使用少量高质量的演示数据,可以有效激发 LLM 进行慢思考的能力。一旦这种能力建立,它似乎能够自然地在不同领域之间泛化。

- 数学领域的演示数据尤其适合用于提升 LLM 的慢思考能力,且包含较长思考过程的数据在提升模型解决复杂问题的能力方面尤其有效。

- 与 LLM 在快速思考模式下生成的正式回复不同,慢思考过程通常以灵活、非正式的方式表达,帮助引导模型走向正确的解题路径。

- 慢思考能力可以通过探索和自我改进有效增强,而离线学习的方法带来的改进通常主要发生在初期迭代,尤其是在面对具有挑战性的任务时。

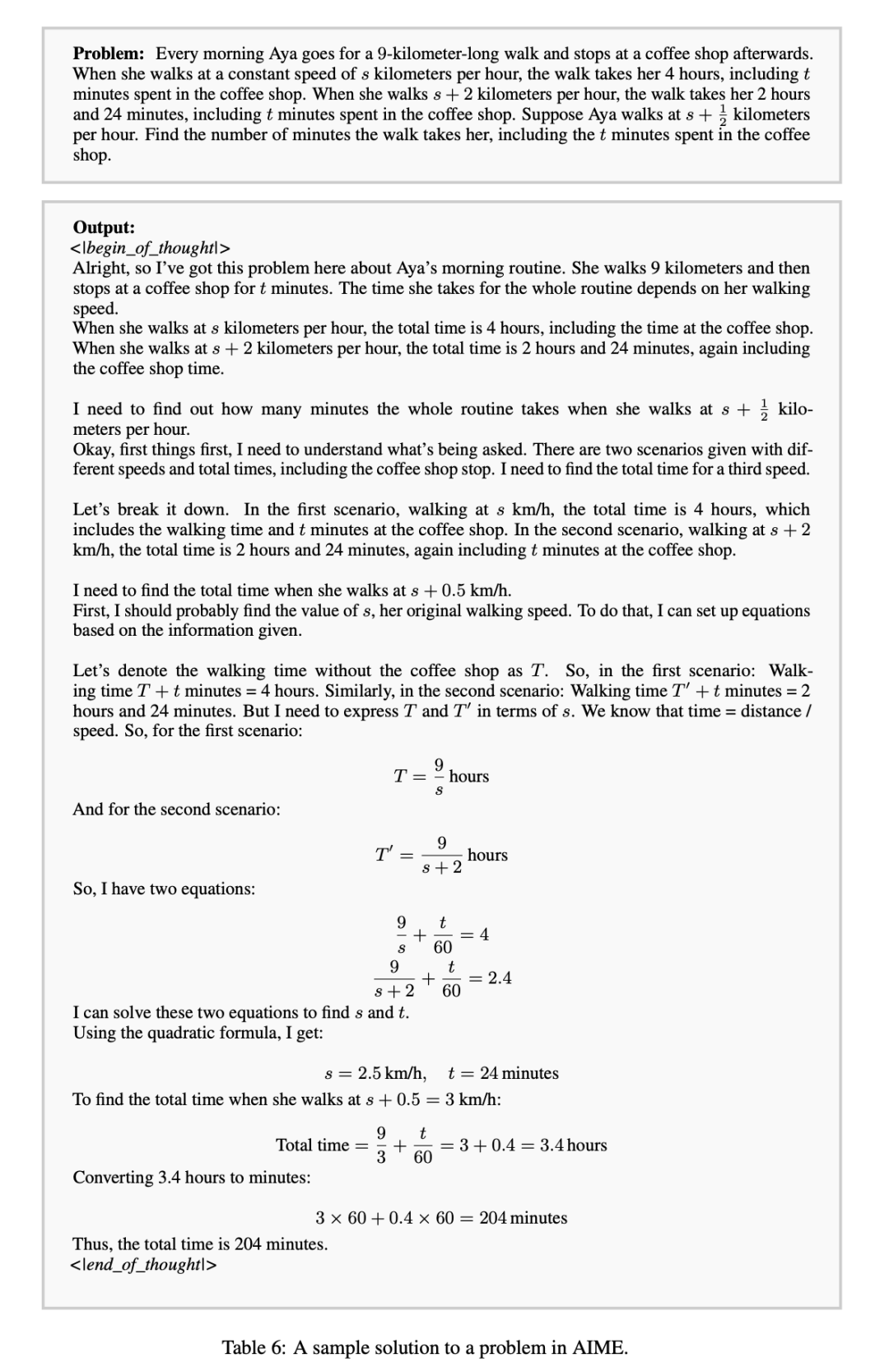

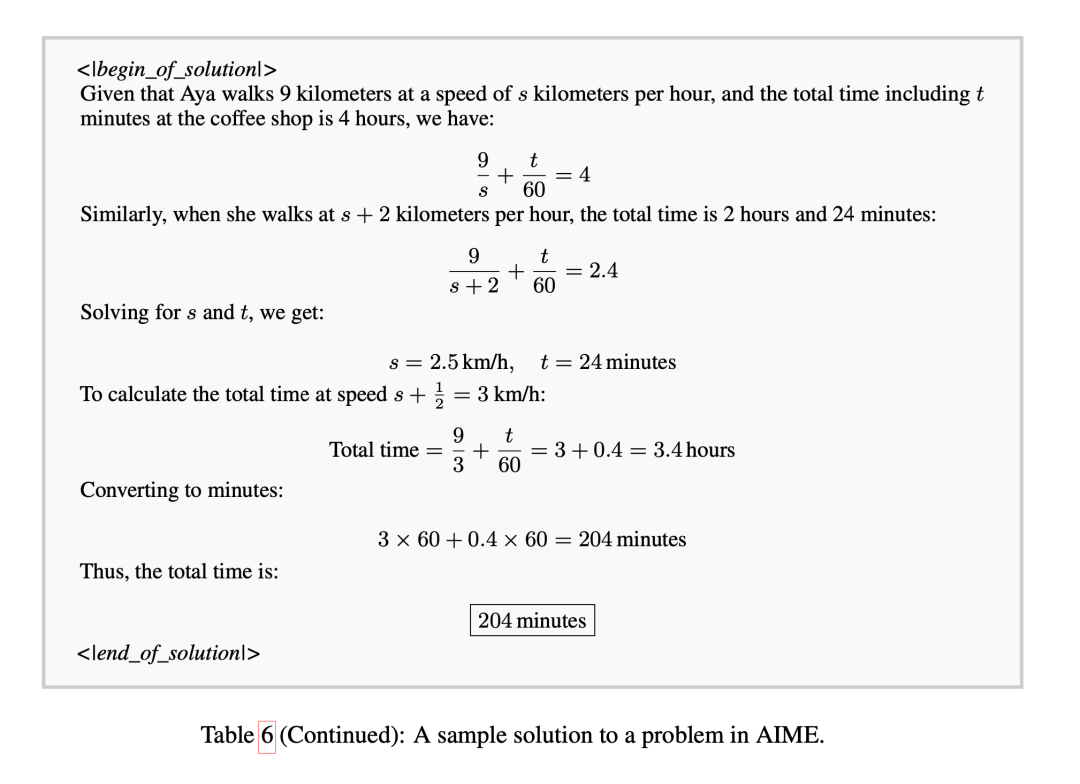

模型的慢思考示例

参考资料

- 标题:Technical Report on Slow Thinking with LLMs: II Imitate, Explore, and Self-Improve: A Reproduction Report on Slow-thinking Reasoning Systems

- 作者:Yingqian Min, Zhipeng Chen, Jinhao Jiang, Jie Chen, Jia Deng, Yiwen Hu, Yiru Tang, Jiapeng Wang, Xiaoxue Cheng, Huatong Song, Wayne Xin Zhao, Zheng Liu, Zhongyuan Wang, Ji-Rong Wen

- 单位:Gaoling School of Artificial Intelligence, Renmin University of China; BAAI

- 标签:人工智能、大语言模型、慢思考推理系统

- 概述:本文介绍了一种模仿、探索和自我改进的框架,用于训练类似 o1 的慢思考推理系统,并在三个基准测试上进行了实验,取得了有竞争力的结果。

- 链接:https://arxiv.org/pdf/2412.09413

本文转载自 旺知识,作者:陈杰,邓佳,旺知