回复

为什么有了大模型还需要用Embedding模型?

不知道大家有没有想过这个问题?

我这两天对这个问题还深入思考了一下,思考的初衷是来源于现在这么多的开源大模型,而且挺多是多模态场景,而Embedding模型相对单模且英文语料居多,如果能复用大模型的output layer,是不是会加速手头上的实验进展。

但思考后觉得效果应该是比不上原生的Embedding模型,有空再专门测试一下看看。

可能主要有以下几点原因:

- 像LLM模型都是预测next token,那么针对next token的预测,模型肯定更加关注在这个token附近的信息,那么对应这个Embedding也更多是这附近的局部信息。而我们需要的Embedding表征,是输入句子的全局表征,而不是“你好吗,我吃饭了,你可以出来了吗?”这句话里,对其中“你可以出来了吗”做的局部信息特征映射。

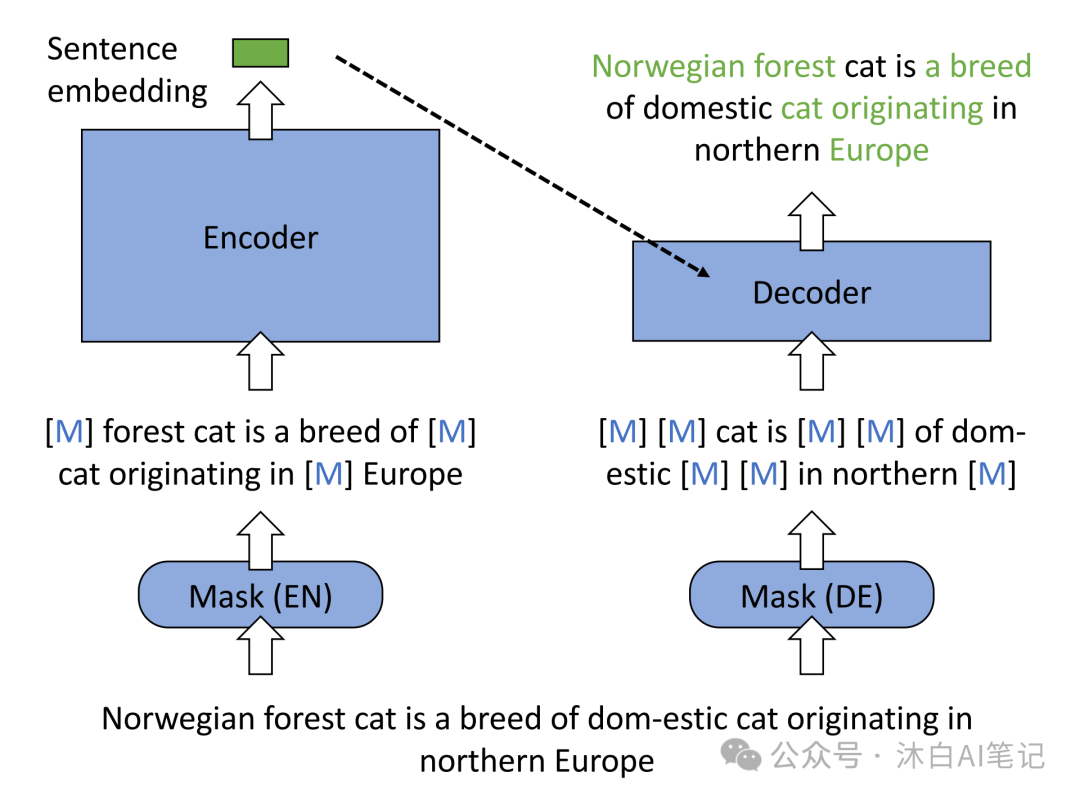

- 目前比较好的Embedding模型都用到了对比学习,这种学习方式能够更精确地学习的全局Eembedding特征,如果用LLM也可以在下游接一个自监督训练器,效果也会很不错,就是成本有点高。最近有一篇paper也可供参考:《Improving Text Embeddings with Large Language Models》

对比学习目标是,学习一个这样的特征提取器,在它提取的特征所构建的 embedding 空间中,同类样本的 embedding 互相靠近,而不同类样本的embedding相互远离。通常,同类样本对互称为正样本(positive sample),不同类样本对互称为负样本(negative sample)。

本文转载自 沐白AI笔记,作者: 杨沐白

赞

收藏

回复

相关推荐