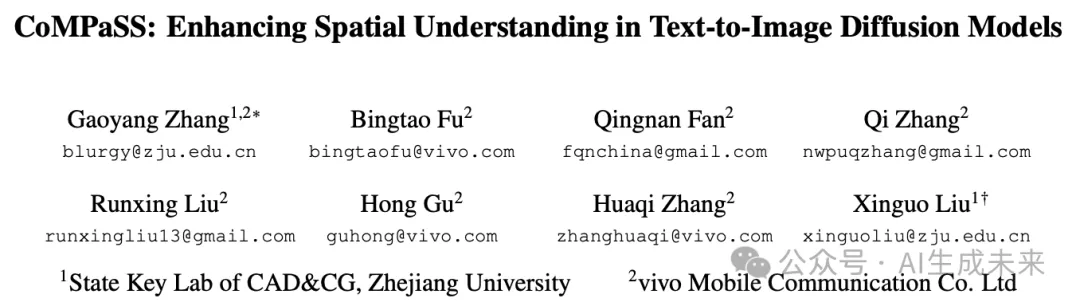

让SD系列和FLUX.1无痛升级!浙大&vivo提出CoMPaSS:文生图空间理解能力暴涨!

论文链接:https://arxiv.org/pdf/2412.13195

git链接:https://github.com/blurgyy/CoMPaSS

亮点直击

- 一个综合的训练框架CoMPaSS,显著增强了T2I扩散模型的空间理解能力。

- 一个系统化的数据引擎SCOP,通过施加原则性约束来识别和验证图像中对象对之间明确的空间关系,从而能够策划高质量的空间训练数据。

- 一个无参数模块TENOR,进一步提高了任何架构的T2I扩散模型的空间理解能力,同时增加的计算开销可以忽略不计。

总结速览

解决的问题

文本到图像(T2I)扩散模型在生成图像时,通常无法准确呈现文本提示中描述的空间关系。主要原因有两个:1)现有数据集中与空间相关的数据具有模糊性;2)当前文本编码器无法准确解析输入描述的空间语义。

提出的方案

引入CoMPaSS框架,该框架包括两个关键模块:空间约束导向配对(SCOP)数据引擎和token编码顺序(TENOR)模块。SCOP通过施加原则性空间约束来策划空间准确的训练数据,以解决数据模糊性问题。TENOR模块则改善文本编码器对空间语义的解析,充分利用高质量的空间先验。

应用的技术

- SCOP数据引擎:通过一组原则性空间约束识别和验证图像中对象之间的明确空间关系,从而策划高质量的空间训练数据。

- TENOR模块:一个无参数模块,优化文本编码器的空间理解能力,几乎不增加计算开销。

达到的效果

- CoMPaSS框架在四种流行的开源T2I扩散模型上展示了其有效性,显著提升了模型在空间关系生成上的表现。

- 在多个基准测试中取得了显著的相对增益,包括VISOR(+98%)、T2I-CompBench Spatial(+67%)和GenEval Position(+131%),刷新了SOTA。

方法

CoMPaSS,这是一种用于提高文本到图像扩散模型空间理解能力的综合解决方案。开发了空间约束导向配对(SCOP)数据引擎,该引擎从图像中提取具有明确空间关系的对象对,并提供其准确的文本描述。介绍了Token编码排序(TENOR)模块,这是一个即插即用的模块,通过引入显式的token排序信息来增强文本输入中空间语义的保留。

这些组件共同形成了一种提高文本到图像扩散模型空间理解能力的综合方法:SCOP通过精心策划的空间关系提供高质量的空间先验,而TENOR使模型能够在生成过程中有效地解释和利用这些空间先验。

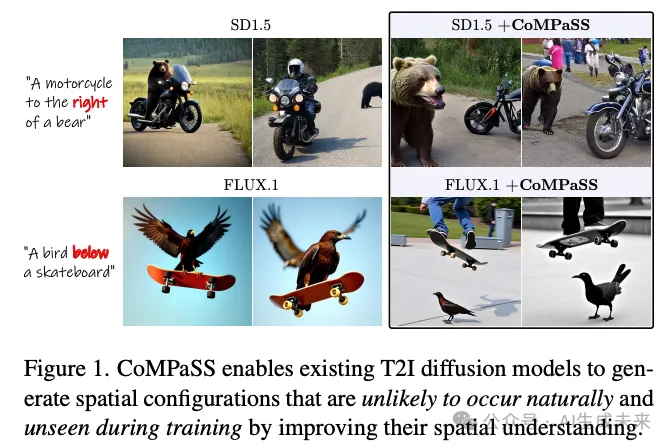

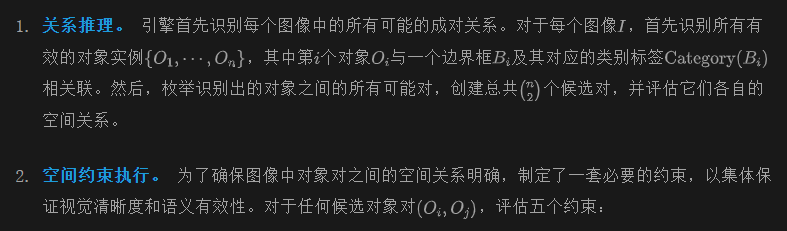

SCOP数据引擎

在生成模型中实现高质量的空间理解需要训练数据具有明确的空间关系。然而,现有的文本-图像数据集往往包含存在问题的空间描述。如下图2所示,1)“左”和“右”等术语由于视角模糊性而受到影响,可能不一致地指代观察者视角或对象本身的方向;2)方向性术语经常在非空间上下文中使用(例如,“正确的选择”);3)空间关系常常缺少或错误地描述参考对象,使得无法确定预期的空间配置。这些问题给试图从此类数据中学习可靠空间关系的模型带来了重大挑战。

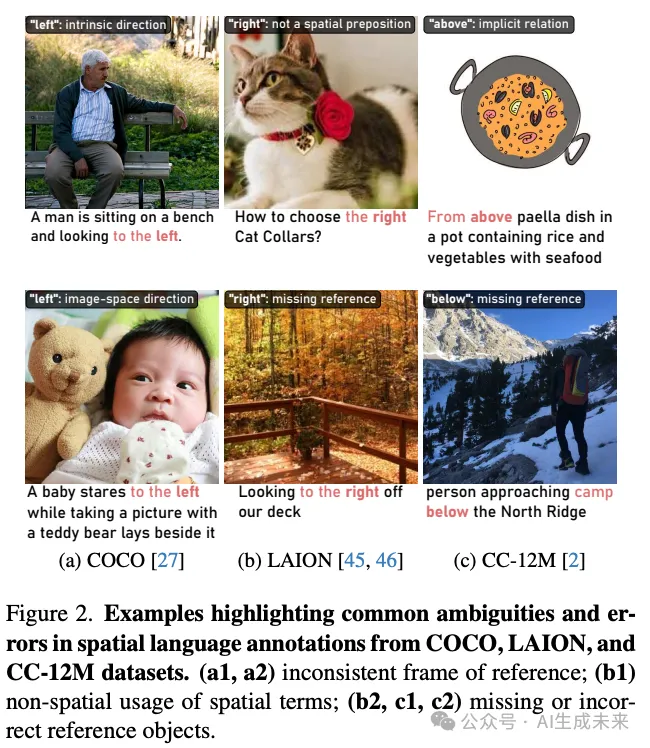

通过空间约束导向配对(SCOP)数据引擎来解决这一限制,该引擎通过精心设计的空间约束来识别和验证对象对之间的空间关系。如下图3所示,

SCOP通过三个关键阶段处理图像:

- 视觉重要性:对象必须占据图像的足够部分,以确保其空间关系具有意义:

一个相对较小的Tv值确保了上一阶段推理的空间关系成为图像的主要特征,而不是背景元素的偶然排列。

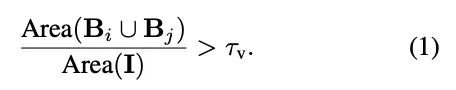

语义区分:对象必须属于不同的类别,例如:

该约束消除了在空间描述中,由于同一对象类别的多个实例而可能产生的参考混淆。

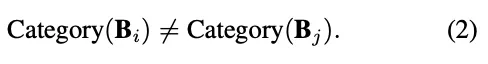

最小重叠:对象必须保持足够的视觉分离。

重叠阈值 保持了单个对象的可见性,同时允许诸如“杯子在桌子上”这类自然的空间配置,其中预期会有部分重叠。

尺寸平衡:成对的对象应具有相当的视觉显著性。

通过这一约束,两个对象应在空间关系中有类似的贡献,防止出现一个对象过小而无法作为可靠的空间参考的情况。这些约束有效地过滤掉了模糊的空间关系,同时保留了自然的对象交互,为清晰和一致的空间描述奠定了坚实的基础。

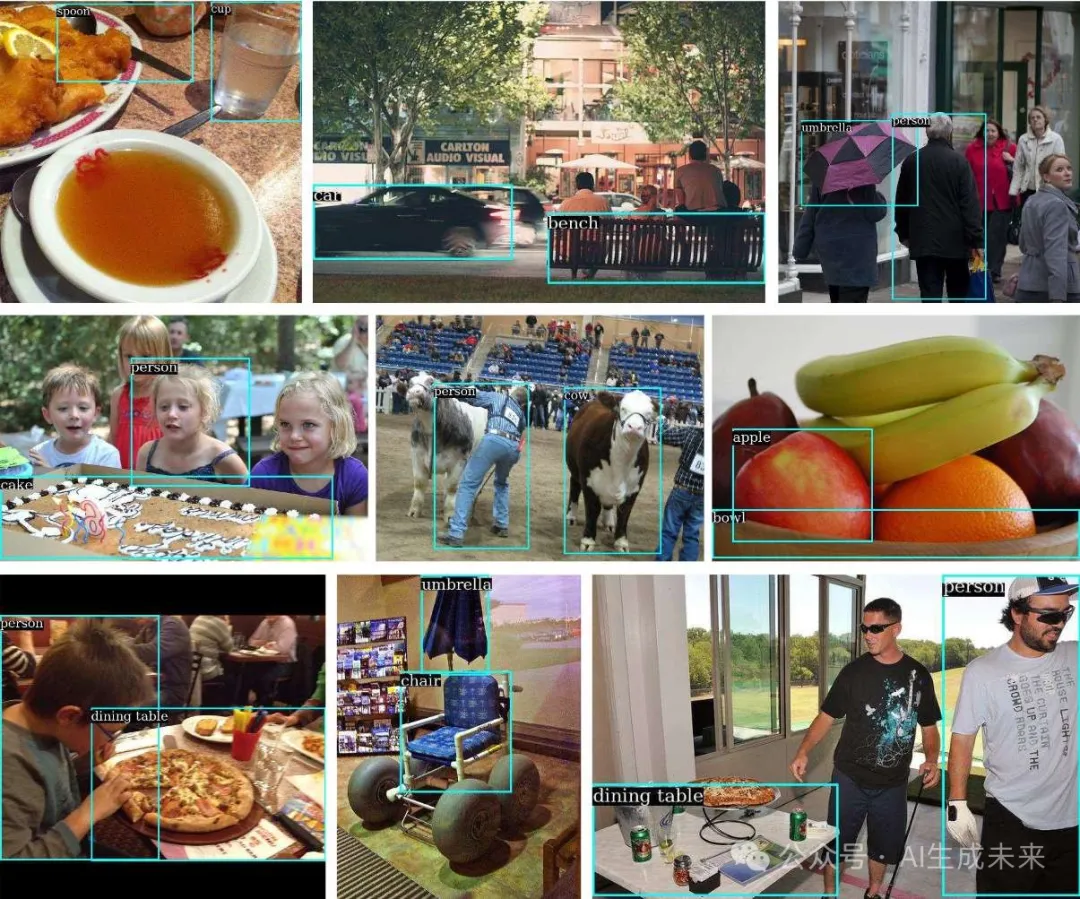

SCOP 数据集。 在 COCO 训练集上自动化 SCOP,以策划一个专门用于训练具有改进空间理解能力的 T2I 模型的数据集,涵盖超过 15,000 张图像中的 28,000 多个对象对,具有明确定义的空间关系和准确的空间描述符。该数据集显著提高了在其上训练的 T2I 扩散模型的空间理解能力,而其规模仅为网络规模数据集的一小部分(LAION-400M的 0.004% 或 CC-12M的 0.13%),展示了 SCOP 数据引擎的效率和效能。

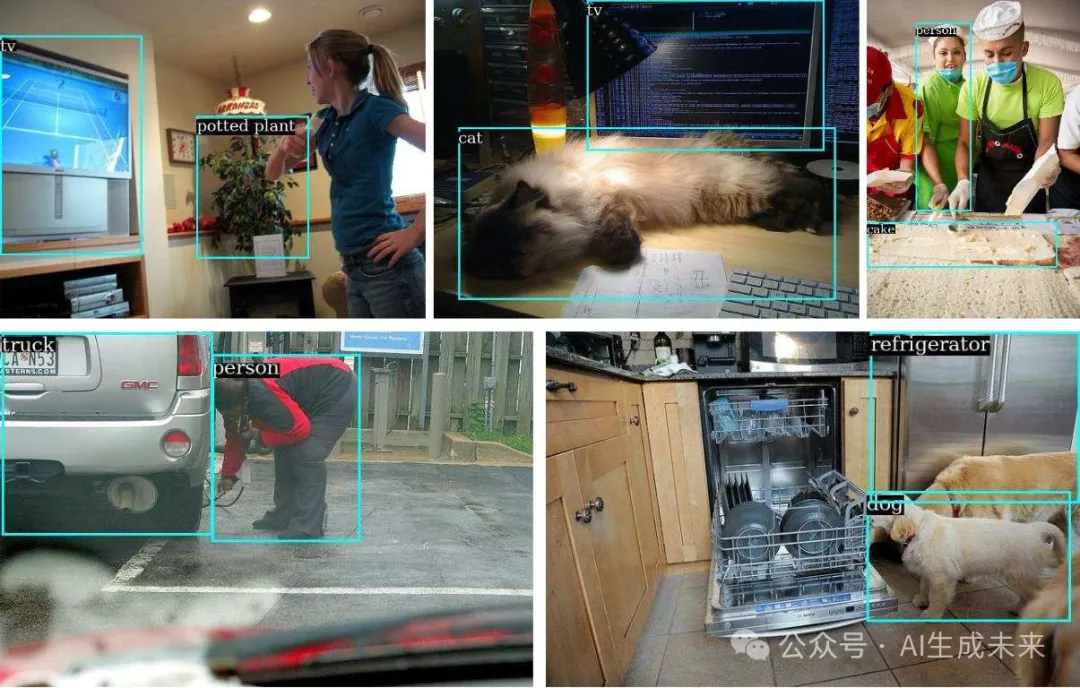

SCOP数据引擎提取的示例对象对及其相应的边界框:

Token 编码排序模块

文本到图像的扩散模型依赖于文本编码器,将自然语言描述转化为语义表示,以指导图像生成过程。为了生成准确的空间关系,这些语义表示必须保留输入文本中描述的准确空间关系。这是T2I(文本到图像)扩散模型有效空间理解的基础。

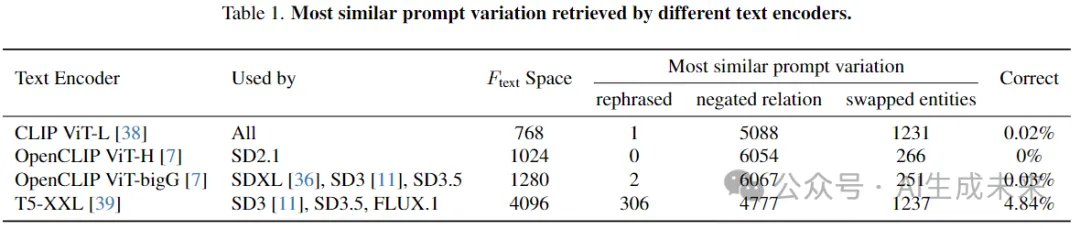

空间理解分析。 研究扩散模型是否能够正确表示空间信息。关键见解是,如果文本编码器能够正确保留空间关系,那么逻辑上等效的空间描述在其编码表示中应该具有高度相似性。设计了一个agent任务来量化这一特性:给定一个描述空间关系的基本提示(例如,“A在B的左边”),生成其三个变体:

- 重述:逻辑上等效但措辞不同(“B在A的右边”);

- 否定关系:将关系短语替换为其相反的短语(“A在B的右边”);

- 交换实体:交换对象位置(“B在A的左边”)。

理论上,只有重述的变体应该产生与基本提示相似的编码。

为了确保全面的评估,使用COCO中的所有80个对象类别进行分析,结合四种基本空间关系(“左”、“右”、“上”、“下”),生成了6,320个提示。根据编码表示之间的相似性,检索出最相似的提示变体,使用四个文本编码器进行评估。结果如表1所示:即使是拥有110亿参数的T5-XXL也在95%以上的情况下无法识别逻辑上等效的变体。较轻的编码器如CLIP在不同的模型尺寸上几乎完全失败,这表明当前的文本编码器在其编码表示中没有充分保留空间关系。

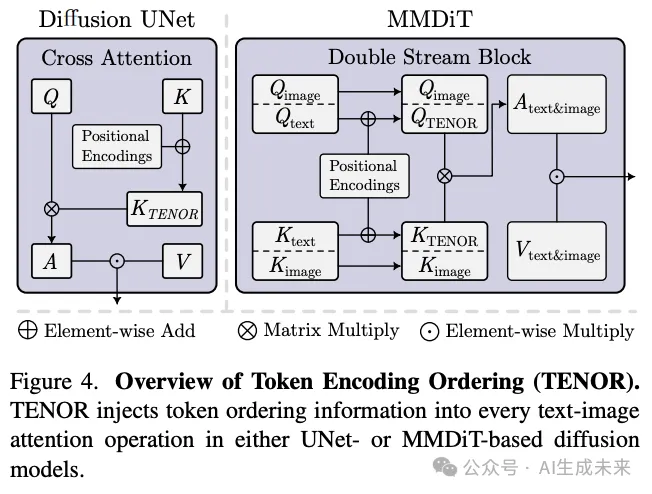

解决方案。 基于这一分析,提出了TENOR,这是一种即插即用的模块,旨在弥补当前文本编码器的局限性。TENOR通过在整个文本到图像生成过程中的注意力操作中增强条件文本信号的原始token顺序信息来运行。与transformer中的原始位置编码仅将位置编码添加到初始标记embedding不同,TENOR明确地将token顺序信息注入到扩散模型中的每一次文本-图像注意力操作中。这一设计确保了每次文本指导影响图像生成过程时,空间语义都能得到积极保留。

实现与效率。 下图 4 展示了 TENOR 的整体过程。具体来说,在扩散模型中的每一次文本-图像注意力操作中,TENOR 将绝对位置编码添加到 UNet 模型的 K 向量,以及 MMDiT 模型的 Ktext 和 Qtext。在现有方法中,有建议在训练期间微调文本编码器、在测试时进行优化或结合大语言模型,但这些方法在训练或推理时会增加显著的计算开销。相比之下,我们的解决方案不需要扩散模型以外的额外可训练参数,并且在推理时几乎没有计算负担。虽然适配 TENOR 需要对扩散模型进行简短的微调,但这一过程比训练新的空间感知文本编码器要高效得多。根据经验,发现这种方法显著提高了 UNet 模型和 MMDiT 模型 FLUX 的空间理解能力。

证明空间关系“左”的附加结果:

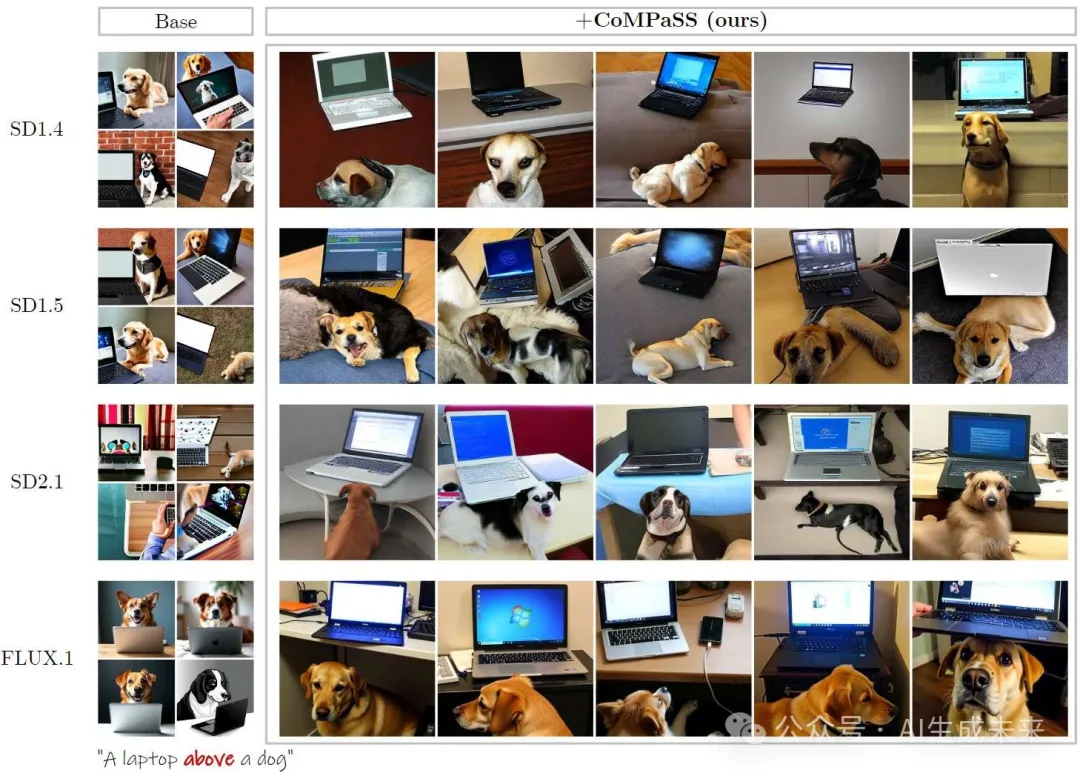

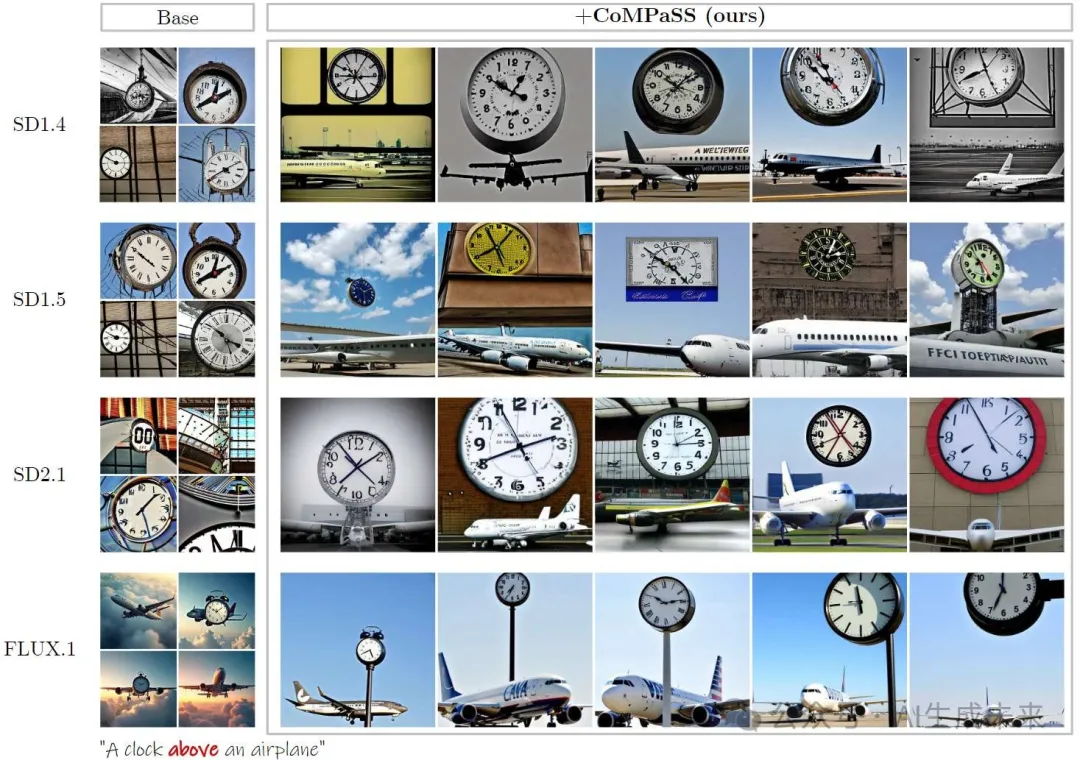

证明空间关系“上”的附加结果:

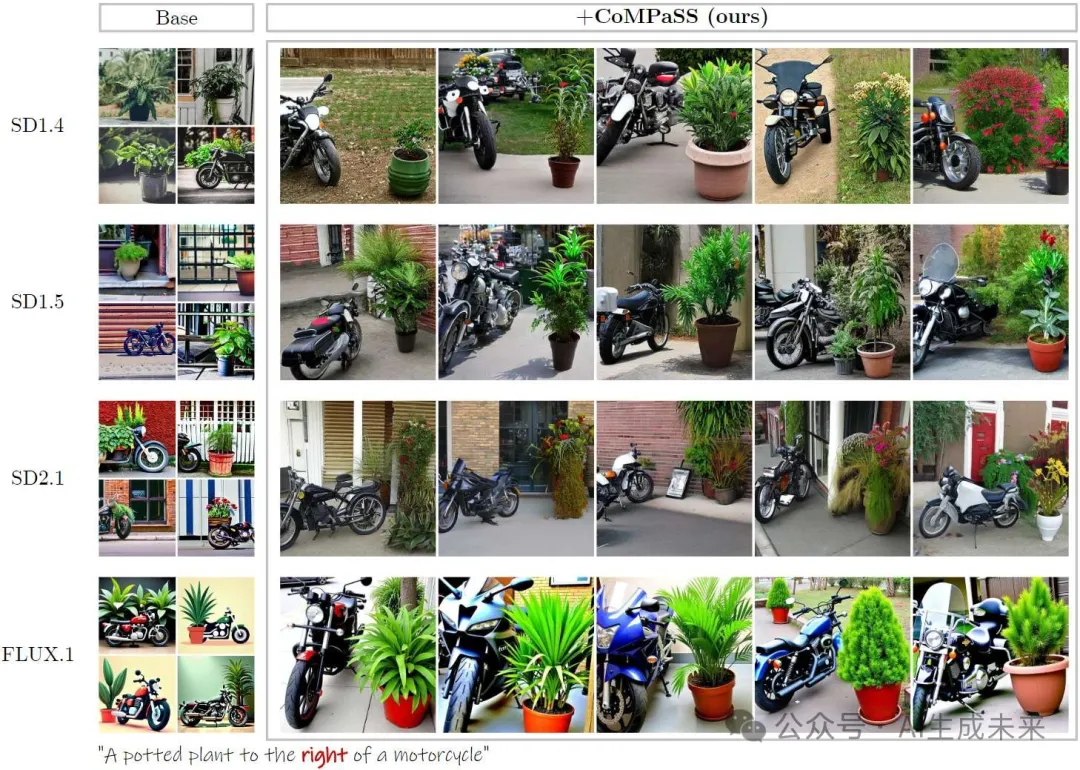

证明空间关系“右”的附加结果:

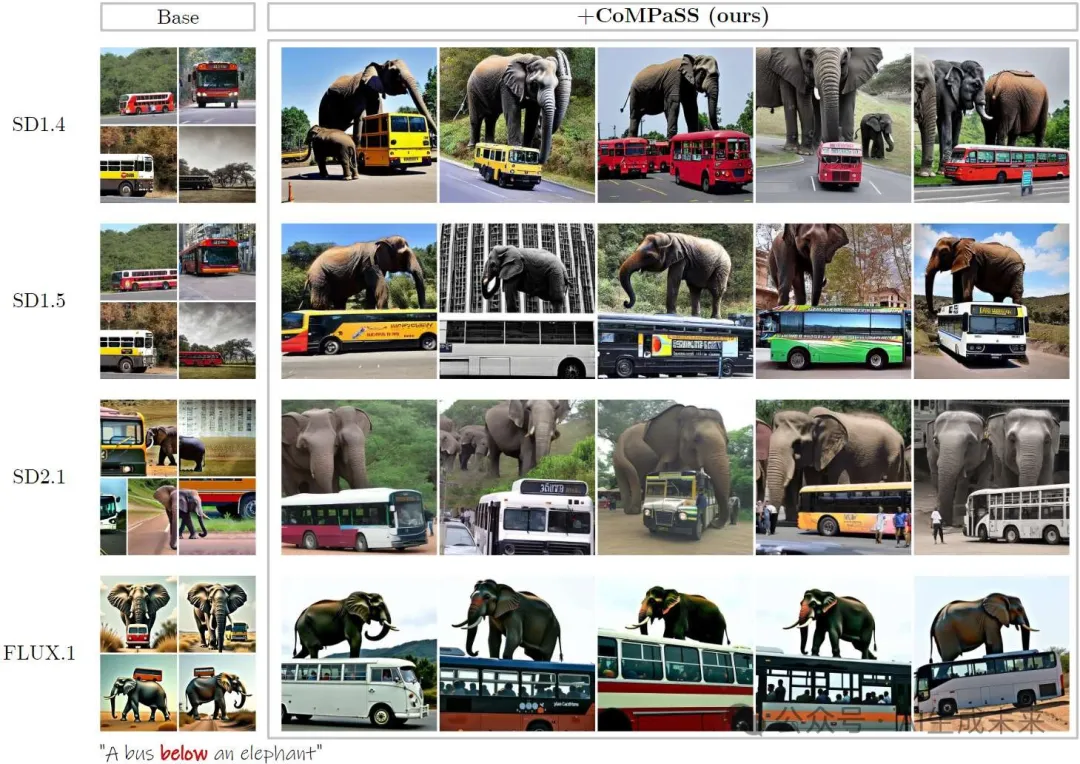

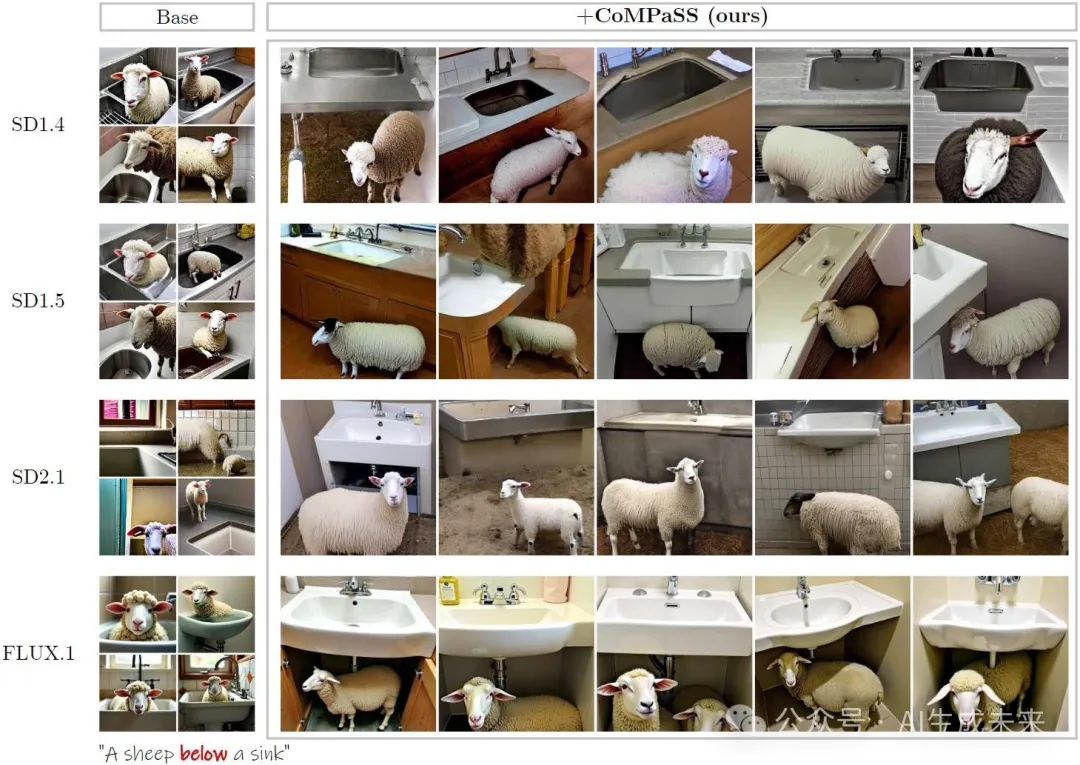

证明空间关系“下”的附加结果:

实验

训练细节

评估指标

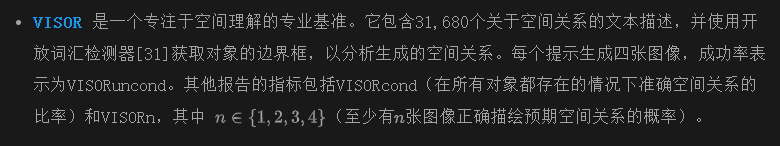

我们在几个著名的基准上对CoMPaSS进行了广泛评估,这些基准如下所述:

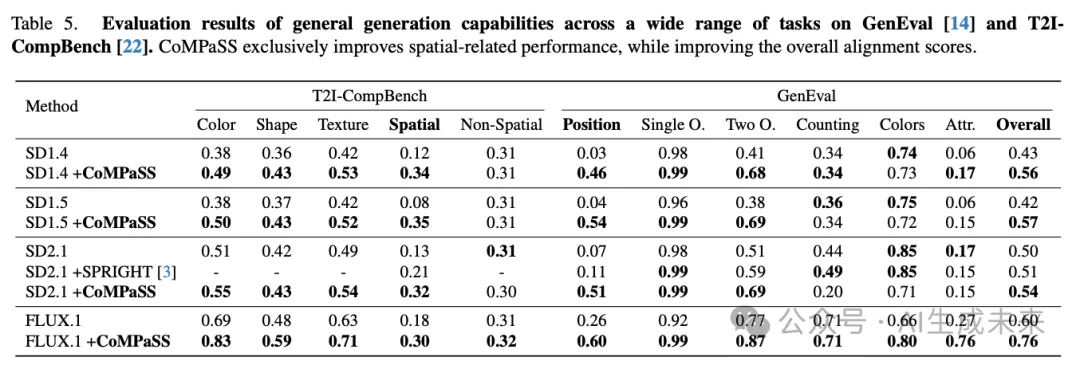

- T2I-CompBench和GenEval是两个用于全面评估文本-图像对齐能力的基准。除了空间相关评估外,它们还提供评估属性绑定正确性、非空间关系和计数的方法。我们使用它们来评估CoMPaSS在非空间理解任务上的性能影响。

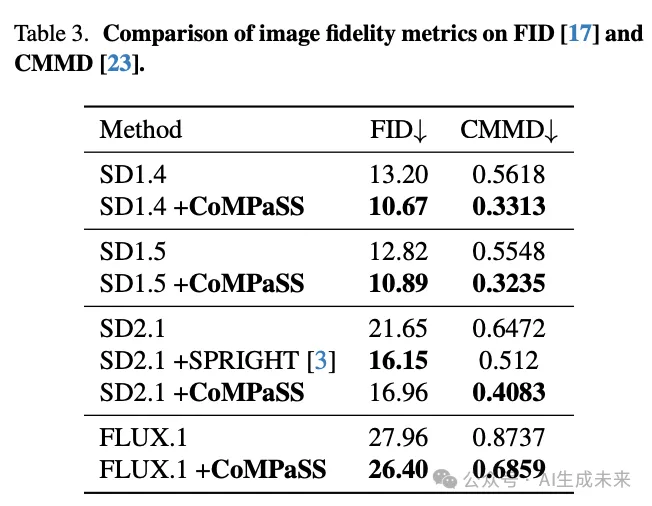

- Frechet Inception Distance (FID)和CLIP Maximum Mean Discrepancy (CMMD)用于估计从文本到图像模型生成的图像的保真度。FID估计生成图像的逼真度。CMMD是一种图像质量估计器,与人类偏好更好地对齐,旨在弥补FID的一些局限性。我们报告这两者的结果。

主要结果

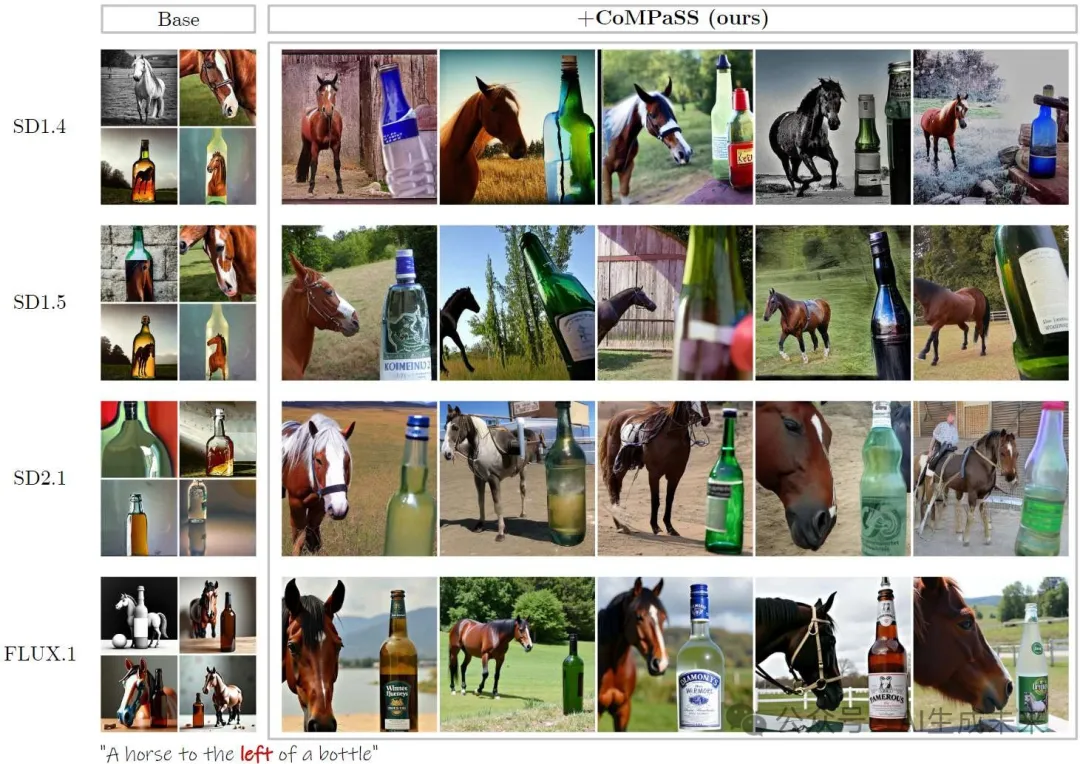

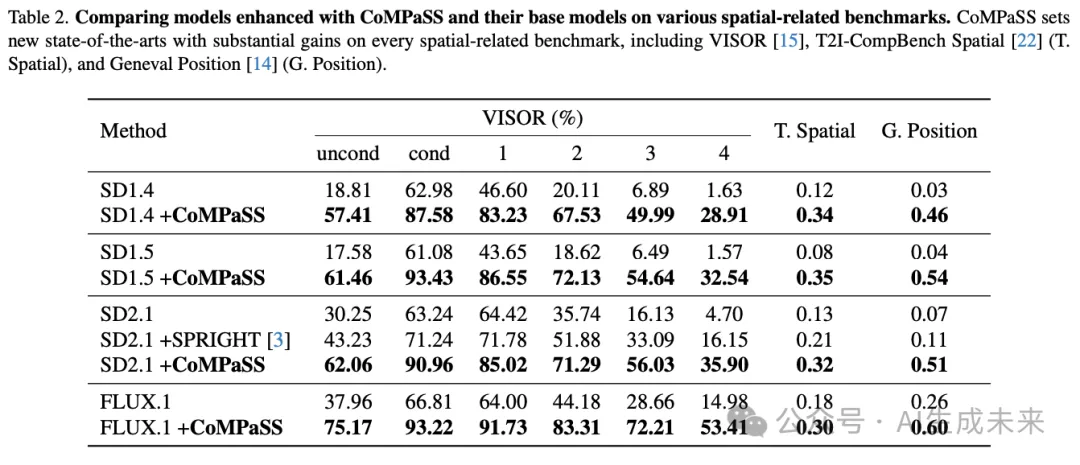

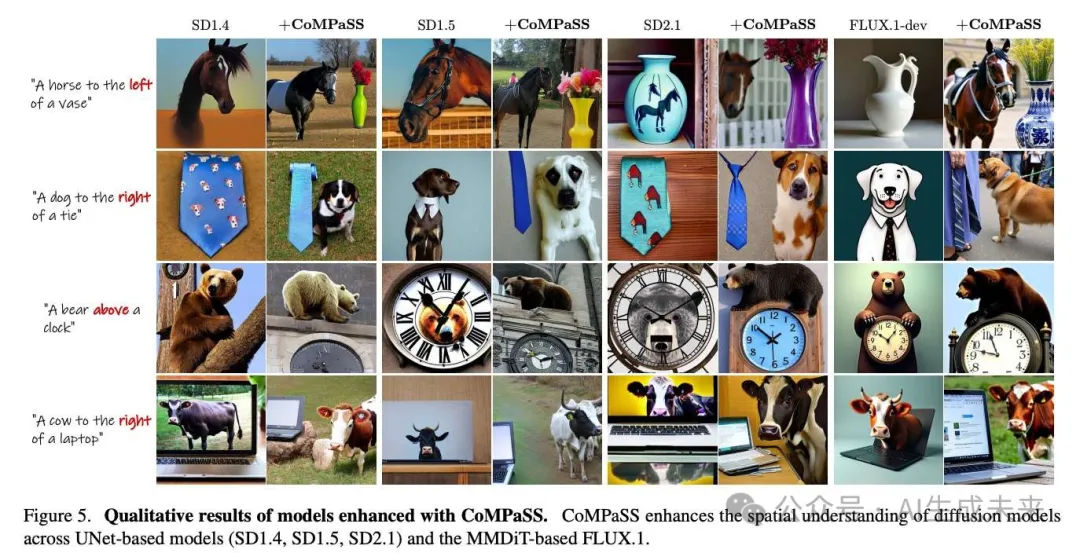

空间理解。 在多个基准测试中评估空间关系生成的准确性,并在下表2中报告结果。将CoMPaSS添加到现有扩散模型中,在所有与空间相关的指标上达到了新的SOTA水平。值得注意的是,在最佳开放权重扩散模型FLUX.1中,CoMPaSS在VISOR上获得了+98%的相对增益,在T2I-CompBench Spatial上获得了+67%的增益,在GenEval Position上获得了131%的增益。如下图5所示,现有模型通常在空间关系上表现不佳,而CoMPaSS有效地解决了这些局限性,即使是在训练期间未见过的新空间配置上,也表现出显著的空间理解提升。

通用生成能力和保真度。 除了与空间相关的指标外,还在GenEval和T2I-CompBench基准测试中评估其他任务,以及FID和CMMD的图像保真度评分。结果在下表3和下表5中报告。CoMPaSS专门提高了与空间相关的性能,同时提高了整体对齐分数和图像保真度。推测在基础模型中,空间术语与不相关的语义纠缠在一起,这是由于数据严重缺陷和表示不清晰造成的。通过专门解开空间术语的纠缠,模型也学会了更好地理解语言的其他方面,从而在其他任务上取得了改进。

消融研究

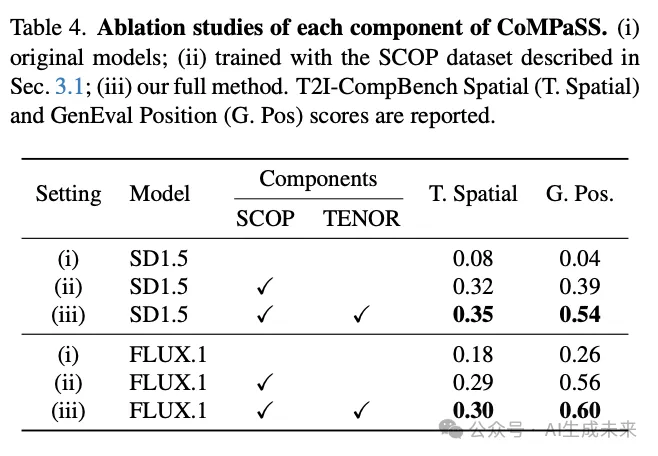

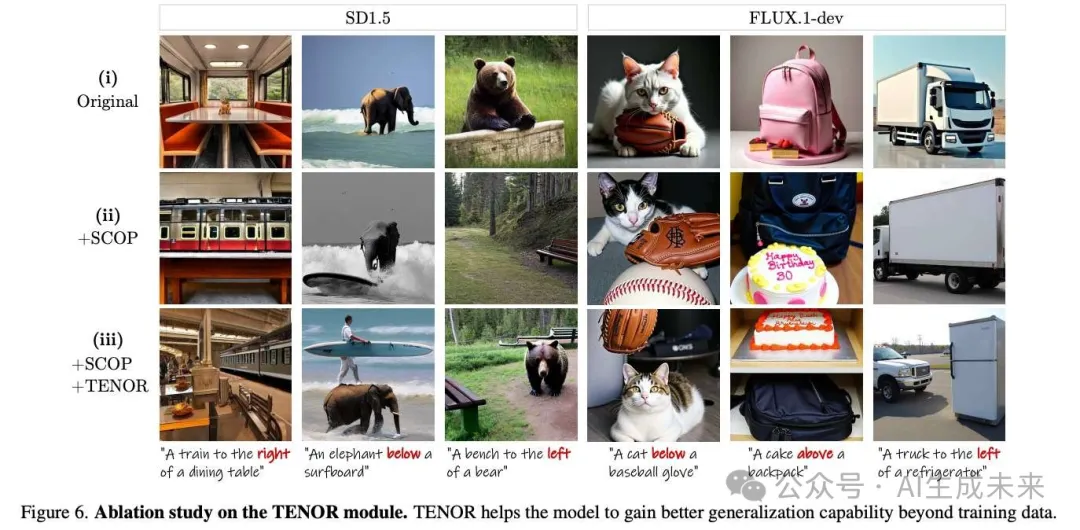

在接下来的实验中,对SD1.5(最流行且易于获取的基于UNet的扩散模型)和FLUX.1-dev(基于MMDiT架构的最先进扩散模型)进行对照实验,以更好地理解每个组件如何影响生成性能。在不同设置下的空间准确性指标在下表4中报告。

SCOP的效果。 在每个模型中比较设置(i)和(ii)显示,仅SCOP就对扩散模型的空间理解有显著贡献。这一发现与我们的初始动机一致,识别出当前模型在空间相关生成上失败的一个主要原因是,当前数据集产生了严重缺陷的空间相关图像-文本数据。这也证实了SCOP能够筛选出一组高质量的数据,直接促进了扩散模型的空间理解。

TENOR的效果。 上表4显示,方法完整(每个模型中的设置(iii))进一步提高了空间准确性。用训练期间未见过的文本描述提示模型,并将生成结果与设置(ii)进行比较。结果如下图6所示。虽然SCOP提供了丰富且准确的空间先验,但只有在结合TENOR后,模型才能更好地推广到未见过的复杂空间配置。这一现象与我们在上表1中关于流行文本编码器空间理解缺陷的初步发现紧密相关:当完全相反的文本描述的语义表示无法区分时,模型被训练去对齐来自看似相似文本条件的混合图像信号,导致超出训练数据的泛化能力差。

TENOR通过在整个扩散模型中主动将token顺序信息注入每次文本-图像注意操作,解决了这一问题,在输入层面解开不同的空间配置,减轻了模型区分不同空间术语的负担,从而在未见过的设置上实现更好的零样本生成。

结论

CoMPaSS,这是一种多功能训练框架,可增强任何文本到图像扩散模型的空间理解能力。CoMPaSS通过SCOP数据引擎解决了数据集中空间关系模糊的问题,SCOP通过原则性约束来策划空间准确的训练数据。CoMPaSS还使用了一个无参数模块TENOR,该模块在不增加计算开销的情况下,进一步提升了任何架构的文本到图像扩散模型的空间理解能力。对四种流行的开源扩散模型进行了广泛的实验,涵盖了基于UNet的模型(SD1.4、SD1.5、SD2.1)和基于MMDiT的FLUX.1,并在知名基准测试中设定了新的行业标准,取得了显著的相对增益,包括VISOR(+98%)、T2I-CompBench Spatial+67%)和GenEval Position =(+131%)。重要的是,空间理解能力的提升并没有以牺牲一般生成能力或图像质量为代价。通过解决当前文本到图像扩散模型的一个基本限制,相信CoMPaSS在可靠的空间精确图像生成方面迈出了重要一步,并为需要精确空间控制的应用打开了新的可能性。

本文转自AI生成未来 ,作者:AI生成未来