Meta推出开放世界具身问答数据集OpenEQA:视觉大模型在具身智能上还有很长的路要走! 原创

想象一个实体化的 AI 代理,充当家庭机器人的大脑或时尚的智能眼镜。这样的代理需要利用视觉等感知模态来理解周围环境,并能够用清晰、日常语言有效地与人交流。这类似于构建“世界模型”,即代理对外部世界的内部表示,可以通过语言查询。这是一个长期愿景和一个艰巨的研究挑战——Meta正在积极探索。

近日,Meta发布了开放词汇体验问答(OpenEQA)框架——一个衡量 AI 代理通过开放词汇问题来理解其环境的新基准。这类似于我们如何评估人类对概念的理解,即通过问问题并评估他们的答案。OpenEQA 包含两个任务:

- (1)叙事记忆EQA,其中实体化的 AI 代理根据其对过去经验的回忆来回答问题;

- (2)主动EQA,在其中代理必须在环境中采取行动以收集必要的信息并回答问题。

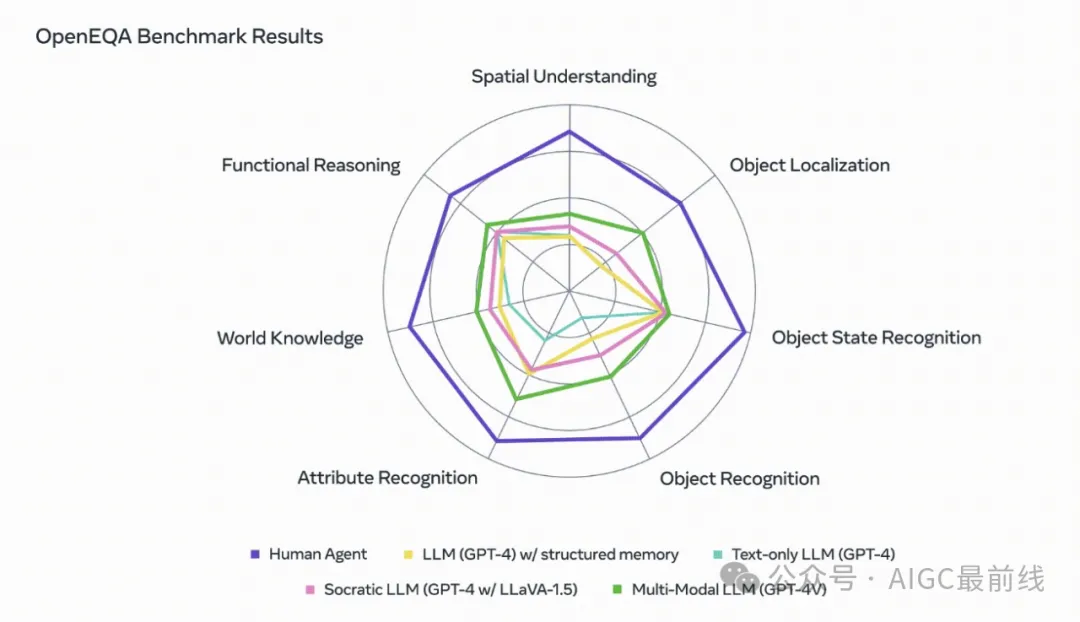

Meta使用OpenEQA对几个最先进的视觉+语言基础模型(VLMs)进行了基准测试,并发现即使是性能最好的模型(GPT-4V达到48.5%)与人类表现(85.9%)之间也存在显著差距。特别值得关注的是,对于需要空间理解的问题,即使是最好的VLMs几乎是“盲目”的——也就是说,它们的表现并不比仅文本模型好多少,这表明利用视觉信息的模型并没有从中获得实质性的好处,并且在回答视觉问题时依赖于在文本中捕获的有关世界的先验知识。举个例子,对于问题“I'm sitting on the living room couch watching TV. Which room is directly behind me?”,模型基本上是随机猜测不同的房间,而没有从视觉叙事记忆中获得明显的好处,这应该提供对空间的理解。这表明,在实体化AI代理准备好进入主流之前,需要在感知和推理方面进行额外的改进。

OpenEQA将具有挑战性的开放词汇问题与以自然语言回答的能力相结合。这产生了一个直观的基准测试,显示了对环境的强大理解,并对当前的基础模型构成了重大挑战。我们希望这项工作能激发更多的研究,帮助AI理解和沟通它所看到的世界。

论文:https://open-eqa.github.io/assets/pdfs/paper.pdf

数据集:https://github.com/facebookresearch/open-eqa

本文转载自公众号AIGC最前线