RARE:通过检索增强推理增强打造一个媲美GPT4的RAG系统 精华

1. 为什么要提出 RARE?

问答(QA,Question Answering)系统的目的以自然语言提出的问题生成答案,其涵盖的领域和类型极为广泛,从开放领域的 QA到更为专业的领域,比如医疗QA。

医疗 QA 要求模型能够掌握复杂的医学知识、解读临床场景,并选出正确且符合上下文的选项。

和多数专业领域的 QA 类似,医疗 QA 也需要结构化的多步骤推理,从一系列连续的步骤中推理出答案。比如,依据患者信息给出恰当的初始治疗方案,模型首先要识别患者的状况,接着分析相关因素并诊断疾病,最后确定合适的基于证据的干预措施。如果没有这种结构化的多步骤推理,面对如此复杂的医疗场景,很难得出准确且与上下文紧密相关的答案。

此外,医疗 QA 存在一些显著区别于其他领域 QA 的问题:

•高度依赖特定领域的知识,而这些知识并非总能在预训练模型中获取,因此需要从外部来源依据事实进行检索。比如涉及特定医学术语,像射血分数降低的心力衰竭(HFrEF)这类问题。而且,医学知识更新迅速,新的治疗方法或最新的指南可能未被纳入模型的预训练语料库。例如,较新的药物(如用于 HFrEF 的 SGLT2 抑制剂)可能在近期的指南中被推荐,却在较旧的预训练模型中缺失。

•包含各式各样的问题类型,不仅有前面提及的多步骤推理和基于事实的检索,还包括需要迭代证据检索的问题,在整个过程中都要求在每个推理步骤检索相关知识以确保准确性和相关性。

2. 什么是RARE框架?

2.1 RARE 框架概览

针对上述问题,作者提出了检索增强推理增强(RARE,Retrieval-Augmented Reasoning Enhancement)。

RARE基于现有的 rStar,其中语言模型生成推理步骤,另一个进行验证,在无需微调或使用高级模型的情况下提升准确性。为生成有效的多步骤推理路径,RARE 涵盖了五种类型的动作来提示语言模型生成下一个推理步骤。

图片

图片

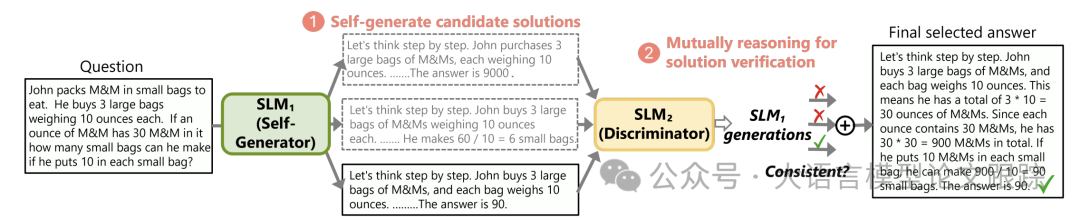

什么是rStar?

Self-play muTuAl Reasoning (rStar) 是一种自我博弈的相互推理方法,显著提高了小型语言模型(SLMs)的推理能力,而无需微调或依赖更高级的模型。rStar将推理过程分解为自我博弈的生成-鉴别过程(如上图)。

•自我生成(Self-play Mutual Generation):首先,目标SLM(小型语言模型)通过蒙特卡洛树搜索(Monte Carlo Tree Search,MCTS)增强,并引入一系列类似人类的推理行为来构建更高质量的推理轨迹。

•相互鉴别(Mutual Discrimination):然后,另一个能力与目标SLM相似的SLM作为鉴别器,对目标SLM生成的每个推理轨迹进行验证。相互同意的推理轨迹被认为是相互一致的,因此更有可能是正确的。

RARE的五种类型的动作包括提出一步思考、提出剩余的思考步骤、提问和回答子问题、重新回答子问题以及重新表述问题。

这些动作有助于模型探索不同的推理路径:

• 为回答基于事实的问题,RARE 还设计了新动作:根据问题生成多个搜索查询并检索相关文档。

• 为回答复合问题,添加了新动作,用于细化子问题、检索目标信息并更新下一步。

受 rStar 的生成器-判别器结构启发,引入了检索增强生成器和真实性评分器,提升大型语言模型的推理准确性与事实完整性。

图片

图片

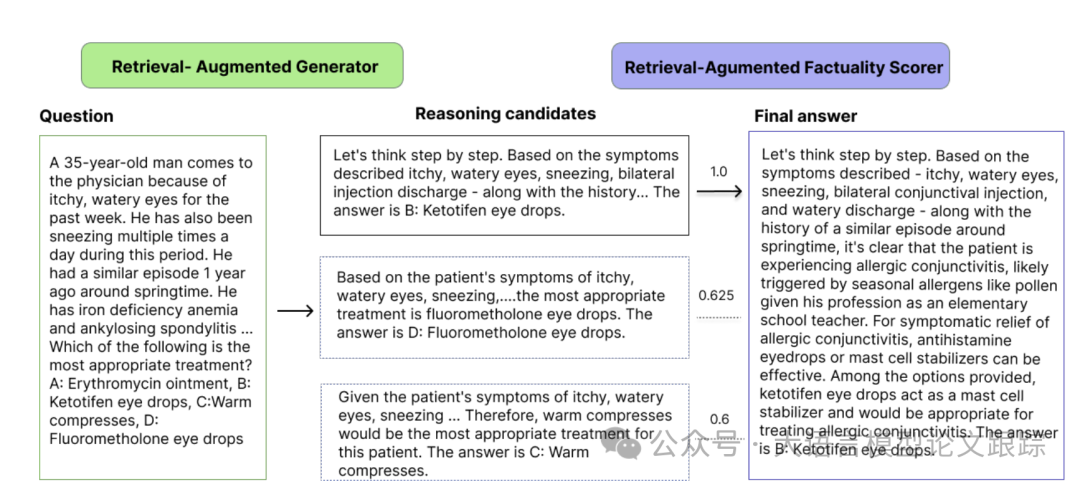

如上图所示,RARE 分两个主要阶段运作。

•检索增强生成器生成候选:检索增强生成器基于 rStar 自生成器,融入了两个新的检索增强动作,能动态获取相关外部信息。将丰富的上下文知识整合进中间推理步骤,尤其是对于复杂问题,提升了候选推理轨迹的相关性和准确性。

•检索增强评分器进行真实性评估:取代 rStar 中的判别器,检索增强真实性评分器会评估每个候选轨迹的事实可靠性。评分器会核实中间推理步骤与检索到的证据是否一致,并给出反映轨迹与外部知识一致性的真实性分数。具有最高真实性分数的轨迹会被选为最终答案,优先考虑最有事实依据的推理路径。这种选择确保了一致性和事实一致性,增强了响应的可靠性。

2.2 检索增强生成器(Retrieval-Augmented Generator)

为了借助外部知识优化推理流程,在原本的 rStar 生成器中引入了两个新动作,将其转化为检索增强型生成器,如上面两个图所示。

这些检索增强动作使得生成器能够动态融合外部信息,提升生成的推理轨迹的相关性与准确性:

图片

图片

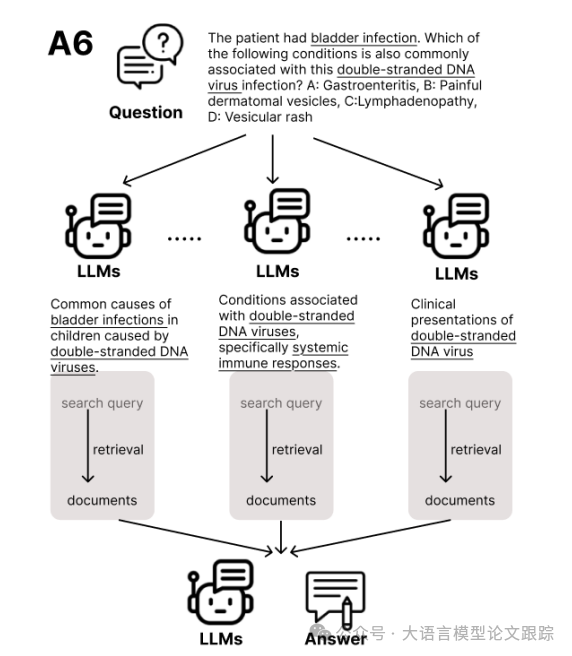

• A6:搜索查询生成与信息检索(Search Query Generation and Information Retrieval.)。使 LLM 依据初始问题构建搜索查询并进行信息检索。检索到的文档提供了额外的背景信息,丰富了推理轨迹,助力生成器形成更全面且与上下文相关的最终答案。

图片

图片

• A7:子问题检索与重新回答(Sub-question Retrieval and Reanswering)。对通过动作 A3 生成的子问题的答案进行细化。对于每个子问题,生成器检索特定的相关信息并用其重新回答子问题。这种方式提高了中间推理步骤的准确性,进而增强了整个推理轨迹的连贯性和事实可靠性。

凭借这些检索增强动作,生成器能够探索更广阔的解决方案空间,形成既逻辑连贯又富含外部知识的推理路径。这种向检索增强型生成器的转变使 RARE 能够更出色地处理复杂、知识密集型的推理任务。

2.3 检索增强评分器(RAFS,Retrieval-Augmented Factuality Scorer)

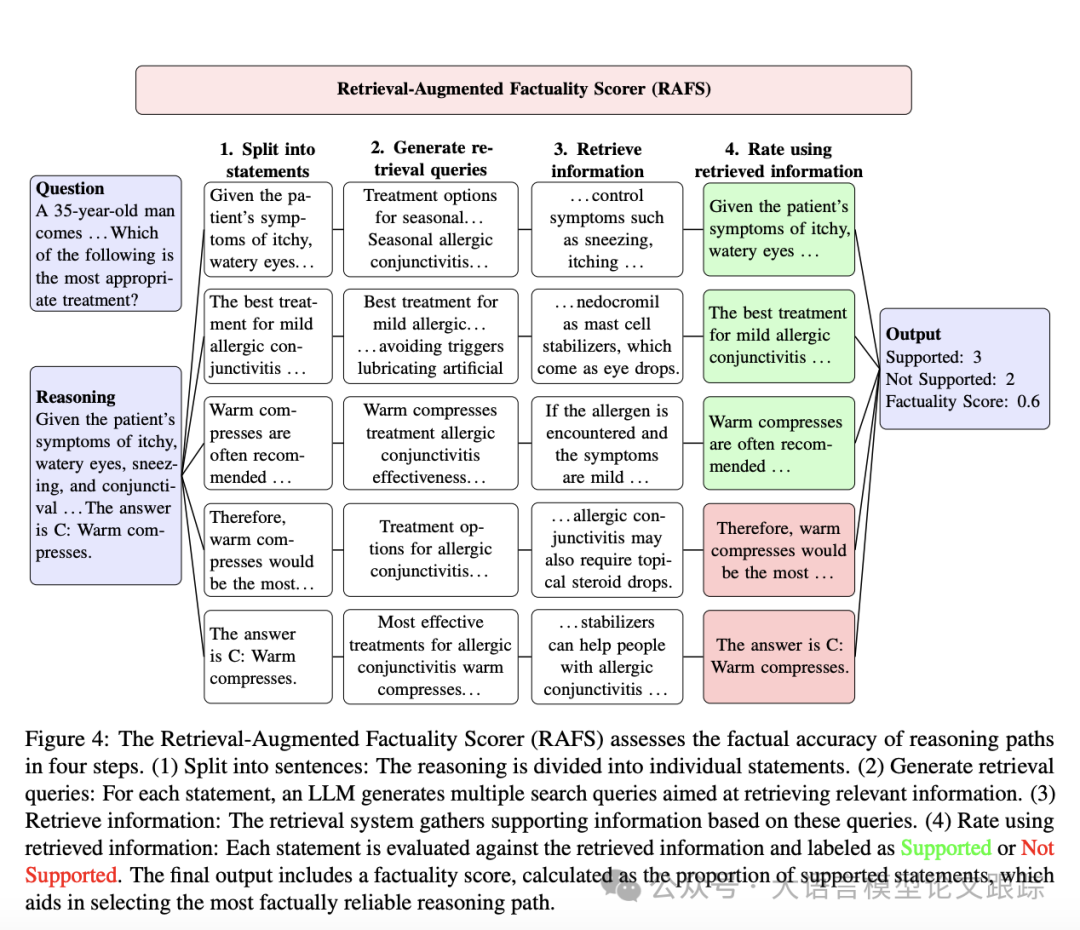

受搜索增强事实性评估器(SAFE)的启发:将 LLM(GPT-3.5-turbo)与谷歌搜索相结合来评估响应的事实性,RARE 推出了检索增强事实性评分器(RAFS)。

RAFS 对其方法进行了调整,用 LLaMA 3.1 70B 取代 GPT-3.5-turbo,用包含通用领域知识(维基百科)和医学领域资源(PubMed、StatPearls 及医学教科书)的语料库索引检索系统取代谷歌搜索。

图片

图片

为评估生成的推理路径的事实准确性,RAFS 按照上图所示的四个系统性步骤来评估每个候选轨迹。

• 拆分(Split into sentences):把每个推理轨迹分割为单独的语句,让 RAFS 能够独立核实离散推理步骤的事实准确性,增强整体评估的可靠性。

• 生成检索查询(Generate retrieval queries):针对每个语句,RAFS 运用 LLM 生成多个检索查询,旨在检索上下文相关的证据。

• 检索信息(Retrieve information):检索系统收集与每个生成的查询相对应的文档或信息。为评估每个推理步骤与外部来源的一致性提供了事实依据。

• 使用检索到的信息进行评分(Rate using retrieved information):将每个语句与检索到的证据进行对比,并标记为“支持”或“不支持”,依据与信息的一致性。推理路径的总体事实性得分计算为支持陈述的比例,表明轨迹的事实可靠性。

3. 效果如何?

3.1 推理任务的性能

图片

图片

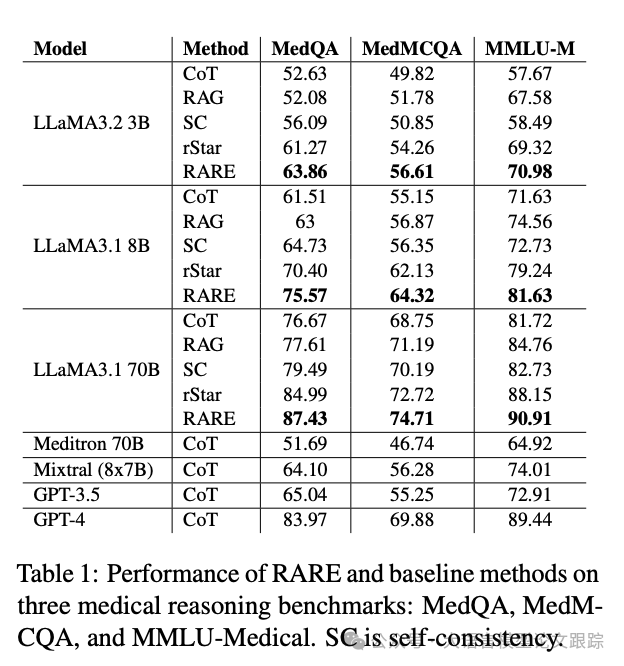

上图展示了 RARE 与其他方法在三个医疗推理基准(MedQA、MedMCQA 以及 MMLU-Medical)上的表现。这些数据集既要求复杂的推理,又需要高度的事实准确性,因而适合用来评估 RARE 的检索增强推理方法的成效。

结果表面,相较于基线方法(如思维链(CoT)、检索增强生成(RAG)、自一致性和 rStar),RARE 能有效提升 LLaMA 模型的推理能力。

在所有模型规模(LLaMA3.2 3B、LLaMA3.1 8B 以及 LLaMA3.1 70B)中,RARE 始终优于基线方法。

随着模型规模的增大,性能提升愈发显著,RARE 增强的 LLaMA3.1 70B 在多个数据集上的表现优于 GPT-4。

此外,RARE 在所有基准测试中均显著优于其他大型模型,如 GPT-3.5、Mixtral 和 Meditron。

3.2 常识推理的表现

图片

图片

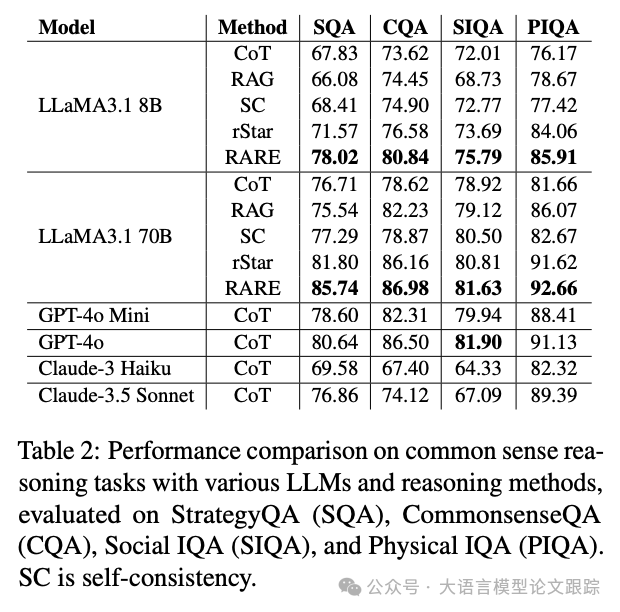

上图展示了 RARE 与其他推理方法以及更大的语言模型在常识推理基准测试中的性能,涵盖 StrategyQA、Commonsense QA、Social IQA 和 Physical IQA 等。

这些数据集对一系列常识推理技能进行了测试,其中 StrategyQA 所需的推理更为复杂和隐性,而其他数据集即便没有严格要求,也能从先进的推理方法中获益。

RARE 在 LLaMA3.1 8B 和 LLaMA3.1 70B 模型中始终优于基线方法,如思维链、检索增强生成、自我一致性和 rStar 等。

在 LLaMA3.1 70B 上,RARE 进一步缩小了与最先进专有模型的差距,在 StrategyQA 和 PIQA 上超越 GPT-4o Mini,表现与 GPT-4o 接近。

RARE 在所有基准测试中也一直优于 Claude-3 Haiku 和 Claude-3.5 Sonnet,展现出其竞争优势。结果彰显了 RARE 在增强常识推理方面的可扩展性和有效性,

3.3 消融研究

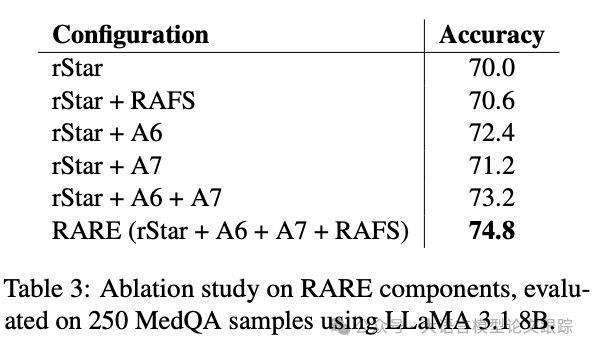

为评估 RARE 框架中各组件的贡献,运用 LLaMA 3.1 8B 模型,针对来自 MedQA 数据集的 250 个样本展开了消融研究。

图片

图片

上图展示了不同配置下的准确率结果,单独考量了检索增强的真实性评分器以及两个检索增强动作(A6 和 A7)所产生的影响。

以准确率为 70.0%的基线(rStar)为起点,发现仅添加检索增强的真实性评分器,准确率会适度提升至 70.6%,这表明真实性评分组件增强了推理的可靠性。

添加动作 A6(生成搜索查询并检索相关信息),准确率提升至 72.4%。

添加动作 A7(检索子问题的信息并重新作答),准确率提高到 71.2%。

将 A6 和 A7 相结合,准确率达到 73.2%,表明这两个检索增强动作协同运作,通过在多个阶段提供相关背景信息来强化推理过程。

最终,完整的 RARE 配置,涵盖 rStar、两个检索增强动作(A6 和 A7)以及真实性评分器,准确率达到最高的 74.8%。

3. 局限性

RARE 在推理准确性和事实可靠性方面有显著提升,但也存在一些局限,为后续研究指明了方向。

• RARE仅在诸如 LLaMA 3.1 这类开源模型上做了测试,尚未在 GPT-4 等大型专有模型上开展。原因在于 RARE 的迭代检索与推理过程需要大量 API 调用,导致在闭源模型上评估成本过高。不过,此框架与模型无关,若资源允许,可直接用于专有模型。

• RARE 旨在找出能得出正确答案的单一推理路径,却未必能优化出能使鲁棒性最大化的最佳或最短路径(比如实现最高的模型置信度)。未来的工作可以探索设计更优的奖励函数,以防奖励作弊,并改进最可靠推理路径的选取。

• 另外,尽管检索增强的事实性评分器是依据事实准确性来评估推理路径的,但RAFS 与人类评估之间的一致性尚未得到深入分析。而且,在医学问答中评估推理步骤目前还没有既定的评估指标,这对研究界来说仍是一个开放的挑战。

• 最后,RARE 当下仅限于使用蒙特卡罗树搜索来探索行动路径。虽然有效,但这种方式未利用经过训练的奖励模型来动态引导搜索过程。未来的拓展可以融入奖励模型或其他优化策略,进一步提升推理质量和效率。

本文转载自 大语言模型论文跟踪,作者:HuggingAGI