为什么Transformer难以学会搜索?一项新研究揭示关键原因 | 从优势到局限:大型语言模型的潜力与边界

大模型领域的发展日新月异,每天都有许多有趣的论文值得深入品读。下面是本期的论文:

1、为什么Transformer难以学会搜索?一项新研究揭示关键原因

图片

图片

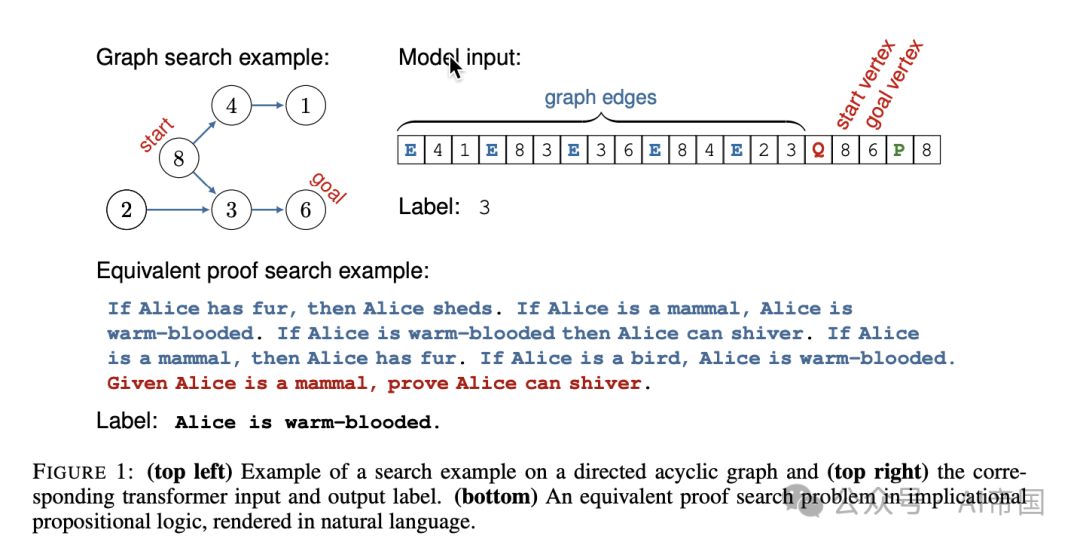

搜索是许多重要任务(如推理、规划和导航)的核心能力,但最新研究表明,Transformer架构的大模型在搜索任务上表现不佳。那么,这是数据不足、模型参数不够,还是Transformer架构本身的限制?为探究这一问题,研究者采用了一个基础的图连通性问题作为测试平台,深入分析Transformer的搜索能力。

图片

图片

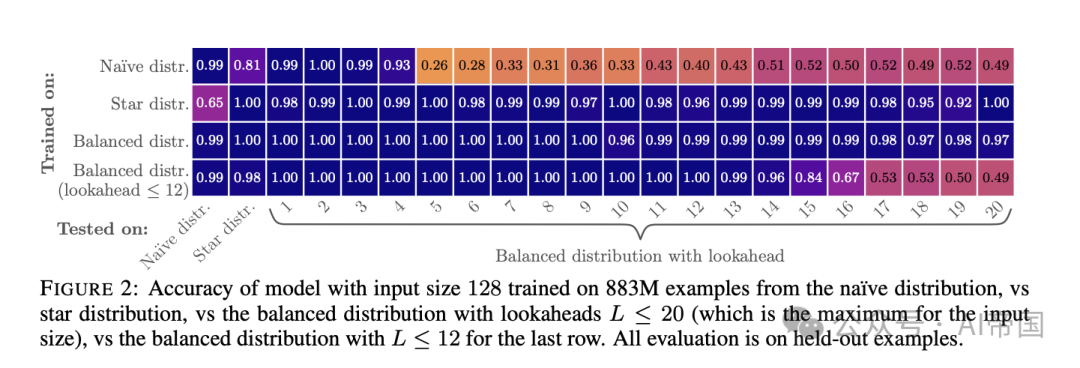

首先,这项研究设计了一个实验框架,通过生成无穷多高覆盖率的数据来训练小型Transformer模型,模拟搜索任务。这些任务基于有向无环图(DAG),要求模型从起点到目标点找到路径上的下一节点。研究发现,Transformer在特定的训练数据分布下能够学会搜索,并能通过层层递归扩展可达节点集,实现指数级的搜索能力。然而,当图的规模扩大时,Transformer的学习能力迅速下降,即便增加模型参数规模也无济于事。这表明,单纯依靠模型的扩展并不足以提升其搜索能力。

图片

图片

图片

图片

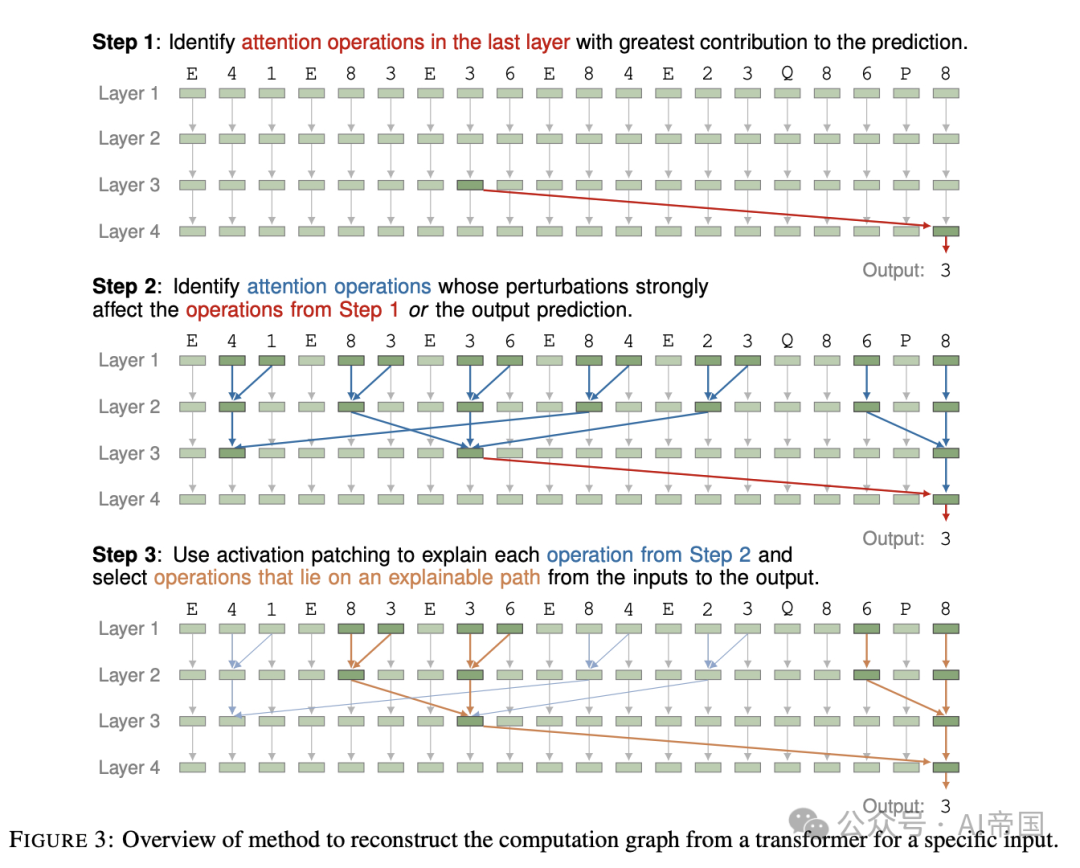

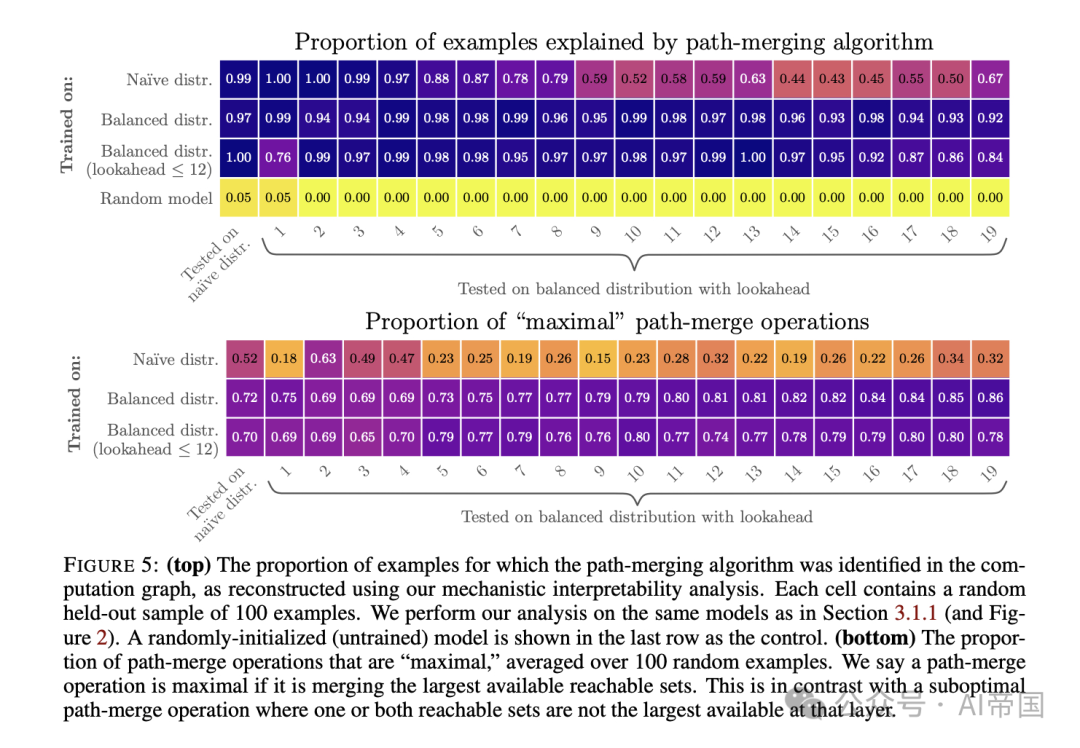

更进一步,研究开发了一种全新的可解释性分析方法,能够提取模型学习到的算法。分析发现,Transformer通过一种路径合并算法完成搜索,每个顶点的表示存储了从该顶点可达的顶点集。尽管这一方法适用于小规模图,但在面对更复杂的搜索任务时,模型依然表现出明显的局限性。即使使用链式思维提示(Chain-of-Thought)等技术,模型在大规模图上的表现仍然不尽如人意。

图片

图片

这项研究揭示了Transformer在搜索任务上的局限性,提出仅靠规模扩展无法解决问题,未来或许需要探索更有效的训练方法(如课程学习)或替代架构(如循环式Transformer)。此外,研究中开发的可解释性工具还有望应用于其他推理任务,帮助揭示Transformer在解决复杂任务时学到的底层算法。

这篇论文提醒我们,Transformer虽然强大,但在特定任务中可能需要更多创新性方法才能突破现有的性能瓶颈。

论文标题:Transformers Struggle to Learn to Search

论文链接:https://arxiv.org/abs/2412.04703

2、从优势到局限:大型语言模型的潜力与边界

图片

图片

大型语言模型能做什么?

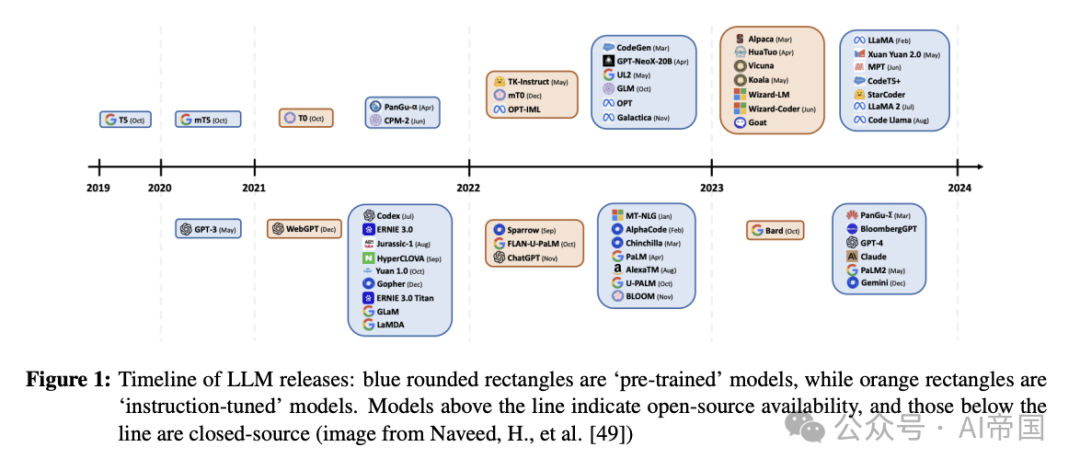

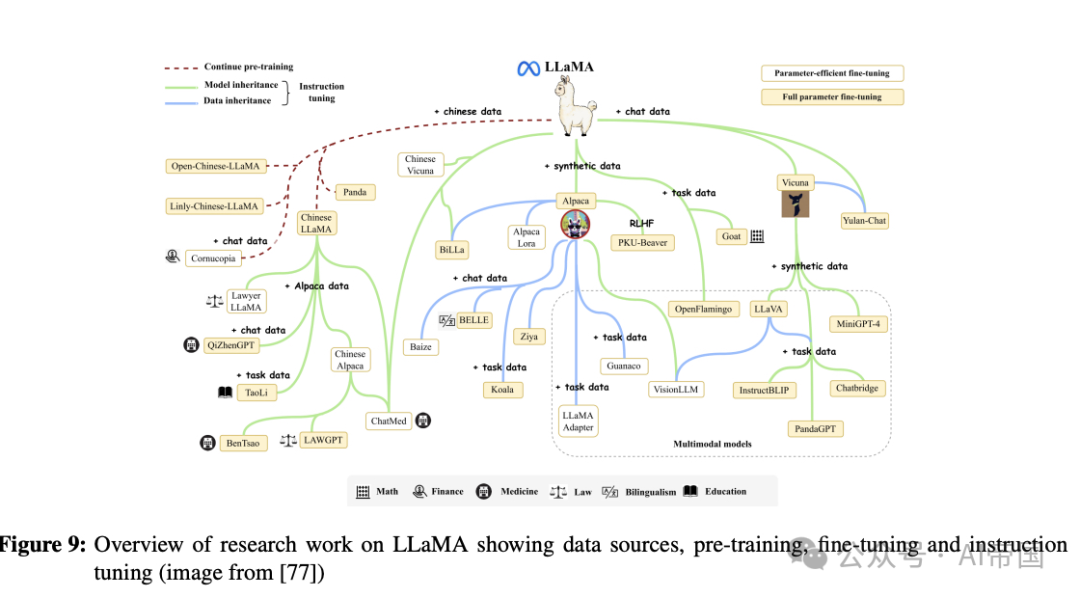

人工智能技术正全面融入我们的生活与工作,其中大型语言模型(LLMs)尤为引人注目。它们不仅能生成流畅自然的文本,还能在复杂场景中表现出令人印象深刻的推理能力。例如,通过理论测试(Theory of Mind)和图灵测试,LLMs展示了接近人类认知的能力。然而,它们的应用也伴随争议——既有对潜在创造力的期待,也有对错误和偏见的担忧。这些模型的独特之处在于,它们既可以“开箱即用”,也可以通过与传统技术结合,定制化解决实际问题。

图片

图片

局限与挑战:AI并非完美的答案

尽管LLMs在许多领域表现卓越,但它们并非万能。例如,这些模型缺乏真正的“自我意识”和对环境的实时更新能力,仅能模拟语言模式。此外,模型训练数据中可能包含偏见或不适当内容,这些问题可能在生成结果中被放大。论文还详细讨论了“越狱攻击”(Jailbreak Attacks),即通过巧妙提示绕过模型内置的安全限制,从而生成不当或违法内容的风险。

图片

图片

如何应对局限?

为了应对上述问题,研究者提出了多种方法:一方面通过构建挑战数据集(如CrowSPairs)评估模型中的偏见,另一方面开发新型技术,如液态神经网络(Liquid Neural Networks)和优化硬件(如Groq语言处理单元),以提升模型的效率、适应性和安全性。这些进展不仅让技术更加灵活,还将其推广到更广泛的日常场景中。

技术发展的未来:机遇与警示并存

LLMs的快速发展让人兴奋,也提醒我们要时刻关注其局限性与潜在风险。未来,持续评估模型表现、优化训练方法和硬件架构,是保障技术稳定性和适用性的关键。论文还预测,这些技术将逐步变得更加高效、经济,甚至可能在普通设备上普及,为社会带来更便捷的应用体验。

论文标题:A Primer on Large Language Models and their Limitations

论文链接:https://arxiv.org/abs/2412.04503

本文转载自 AI帝国,作者: 无影寺