图像生成与各种编辑任务大一统!贾佳亚团队提出DreamOmni:训练收敛速度快且性能强大

文章链接:https://arxiv.org/pdf/2412.17098

Github链接:https://zj-binxia.github.io/DreamOmni-ProjectPage/

亮点直击

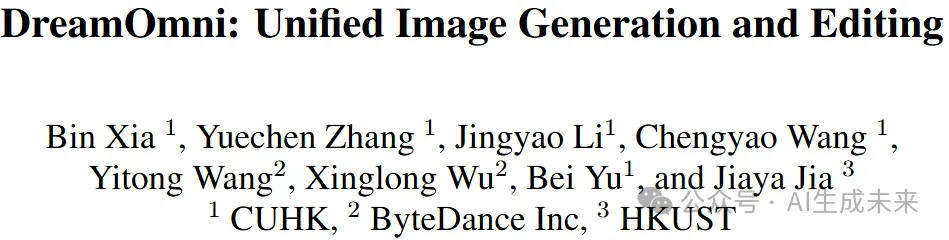

- 对现有的模型框架进行了分析,并基于不同任务的特点,提出了一种高效且强大的统一图像生成与编辑框架——DreamOmni。

- 引入了一种合成拼贴数据pipeline,用以解决当前创建和筛选高质量编辑数据的低效性和困难。此外,还利用该合成拼贴数据pipeline来提高T2I模型输出的准确性。实验结果表明,合成数据是一种高效、优质且具有成本效益的方法,能够扩展数据规模,进而实现统一的图像生成与编辑训练。

- 经过统一训练后,结合T2I数据和多种合成数据集,DreamOmni展示了具有竞争力的T2I生成能力,并在一系列编辑任务中表现出色。

总结速览

解决的问题

文生图遇到了一些挑战:

- 将这些模型适应到下游应用通常需要以不同的方式集成各种插件(如ControlNet和IP-adapter),或扩展输入通道(例如,SD-inpainting 、InstructP2P)。这种对专门化框架的依赖限制了多任务泛化能力,并增加了部署的复杂性。

- 高质量和准确的编辑数据难以获得,包括基于指令的编辑、拖拽编辑和主题驱动的生成数据。

提出的方案

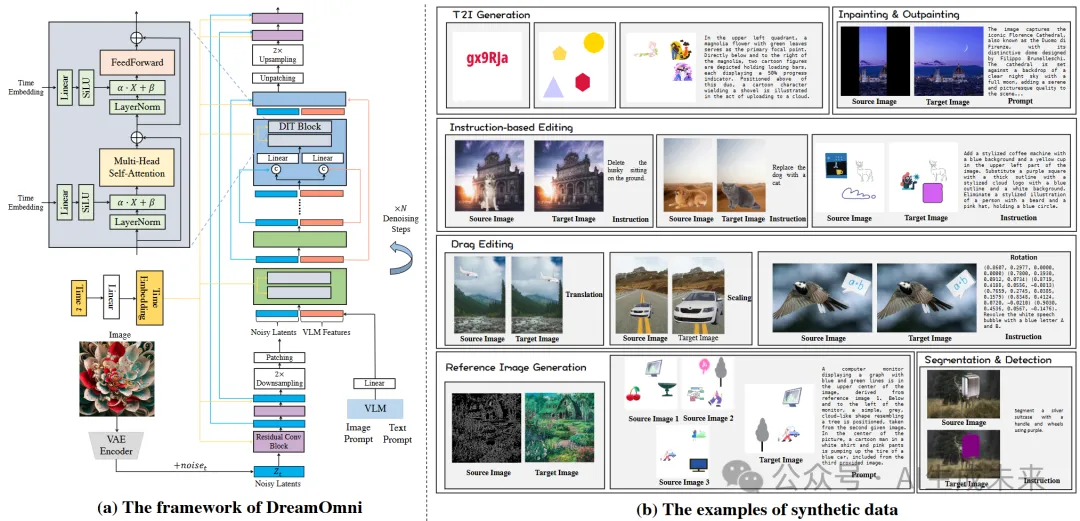

- 提出将T2I模型与多种编辑任务(如基于指令的编辑、图像修复与扩展、拖拽编辑以及参考图像生成)统一到一个框架中。

- 引入了一个高效的合成数据pipeline,用于高效且准确地构建编辑数据,促进原生统一生成与编辑模型的训练。

应用的技术

- DreamOmni:DreamOmni框架支持统一的图像生成与编辑,具有快速的训练收敛速度和强大的性能。

- 一种基于拼贴的合成数据生成流程。该流程可以高效地生成用于各种编辑任务的数据,例如在基于指令的编辑中进行添加、删除和替换操作,在拖拽编辑中进行平移、缩放和旋转操作。此外,它还支持参考图像生成以及分割与检测任务。此外,合成数据生成流程提高了T2I(文本到图像)生成的准确性,特别是对于与文本、几何形状、颜色、位置和数量相关的属性。

达到的效果

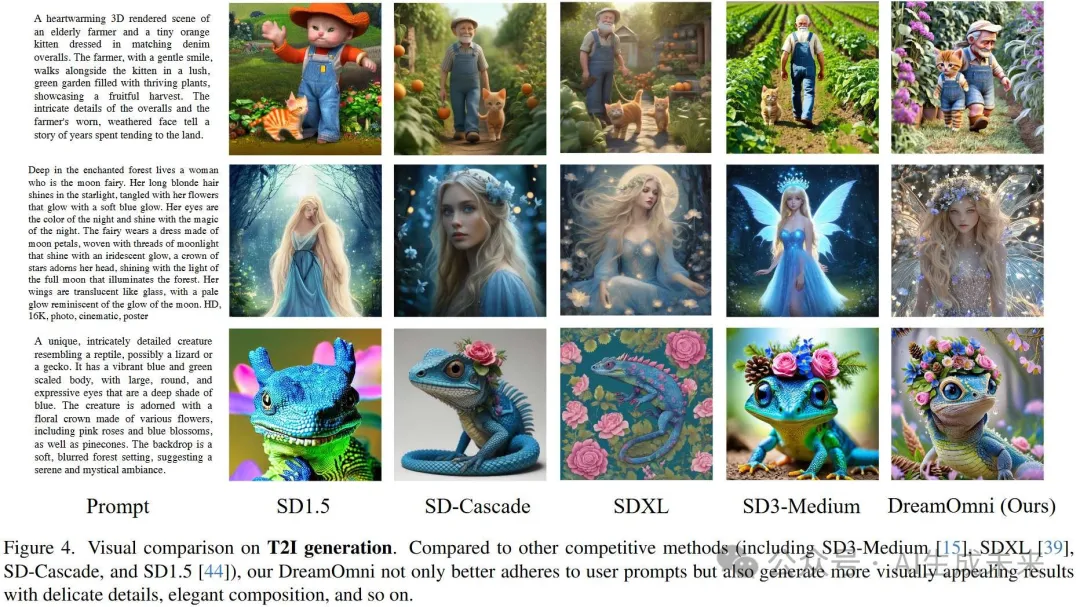

T2I视觉比较

图像修复比较

图像条件生成比较

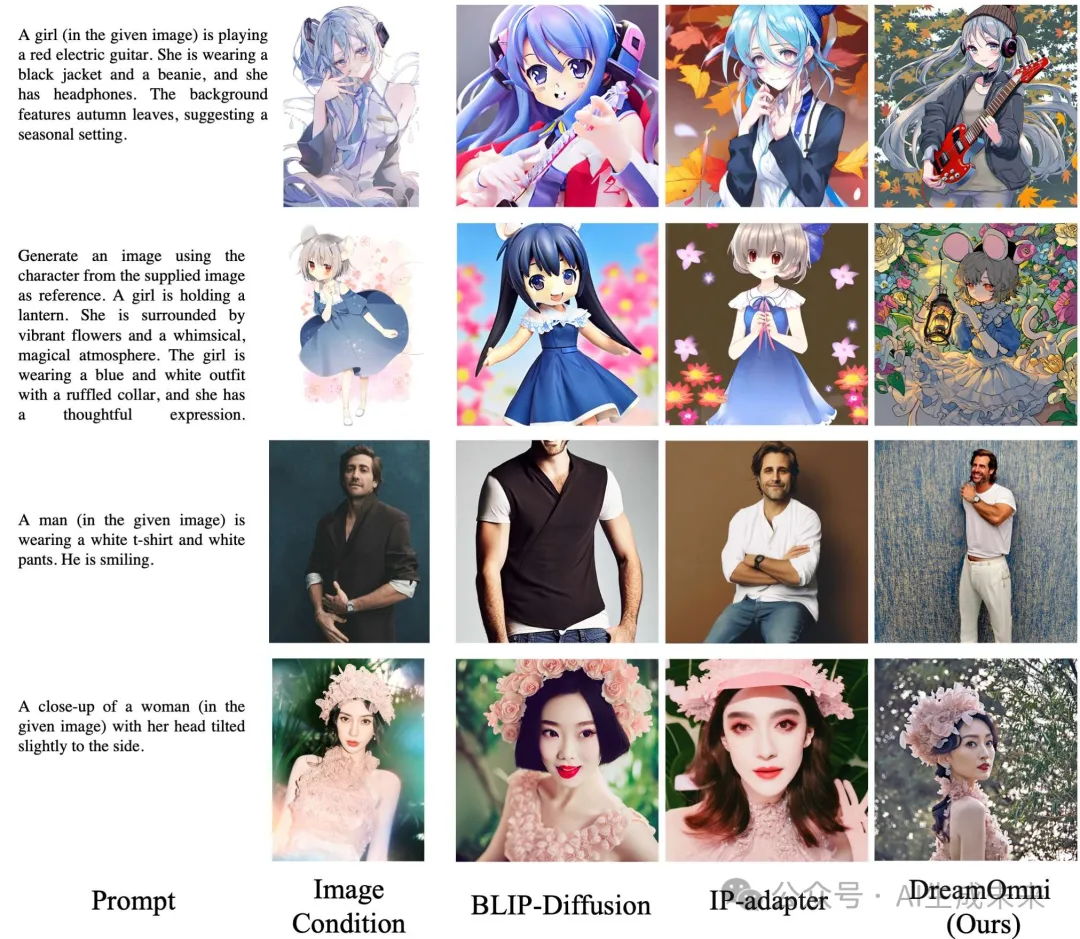

主题驱动生成的视觉比较

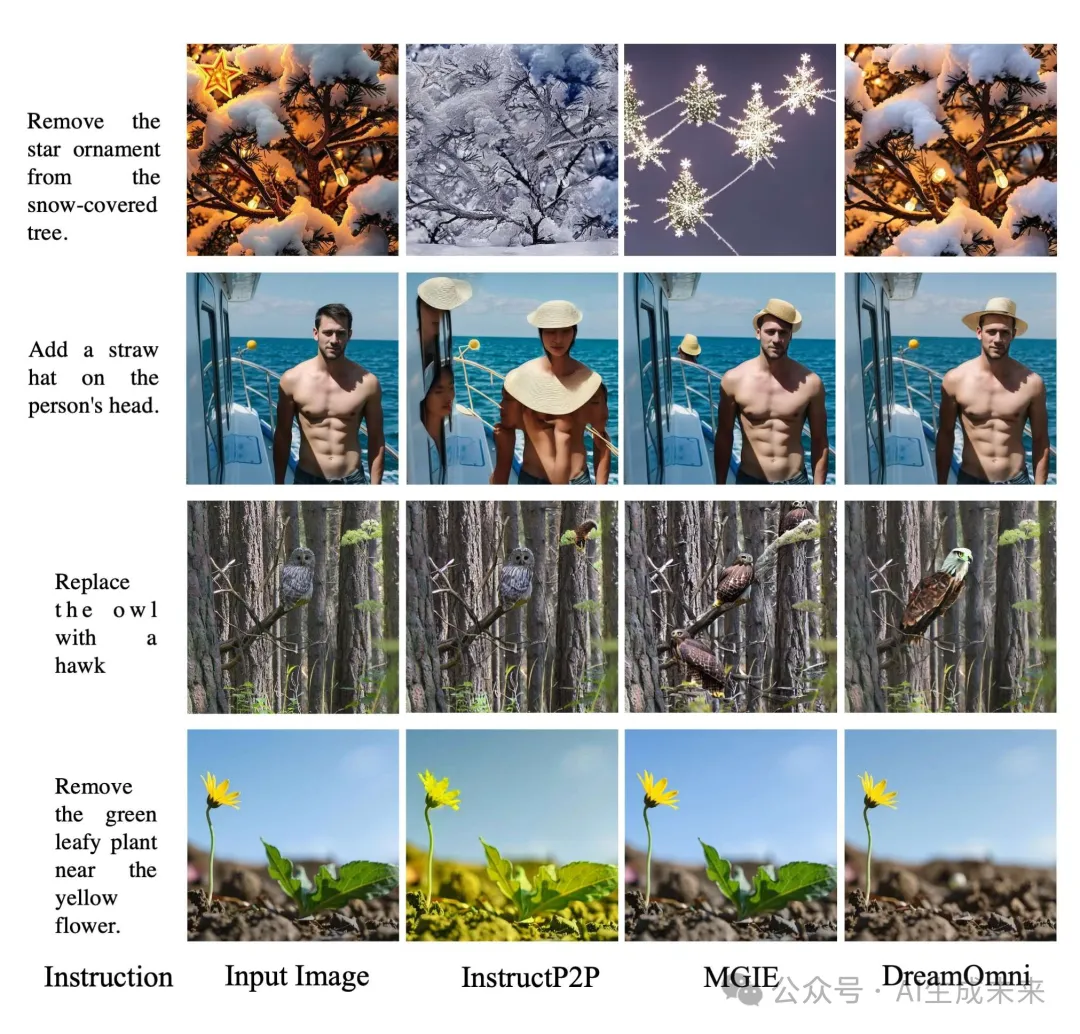

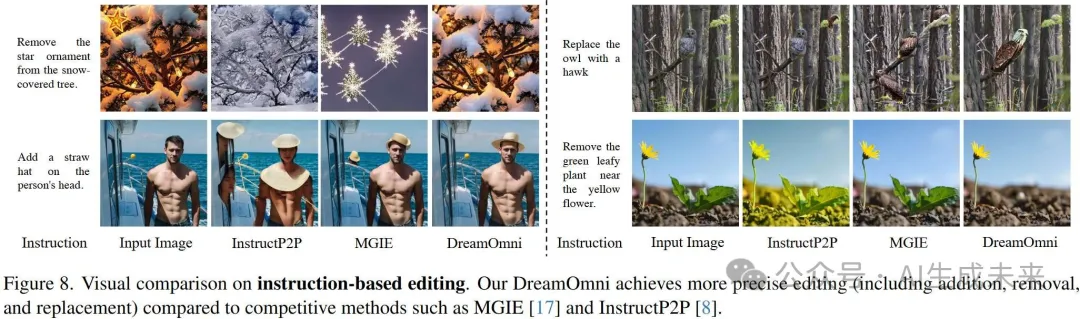

基于指令的编辑的视觉比较

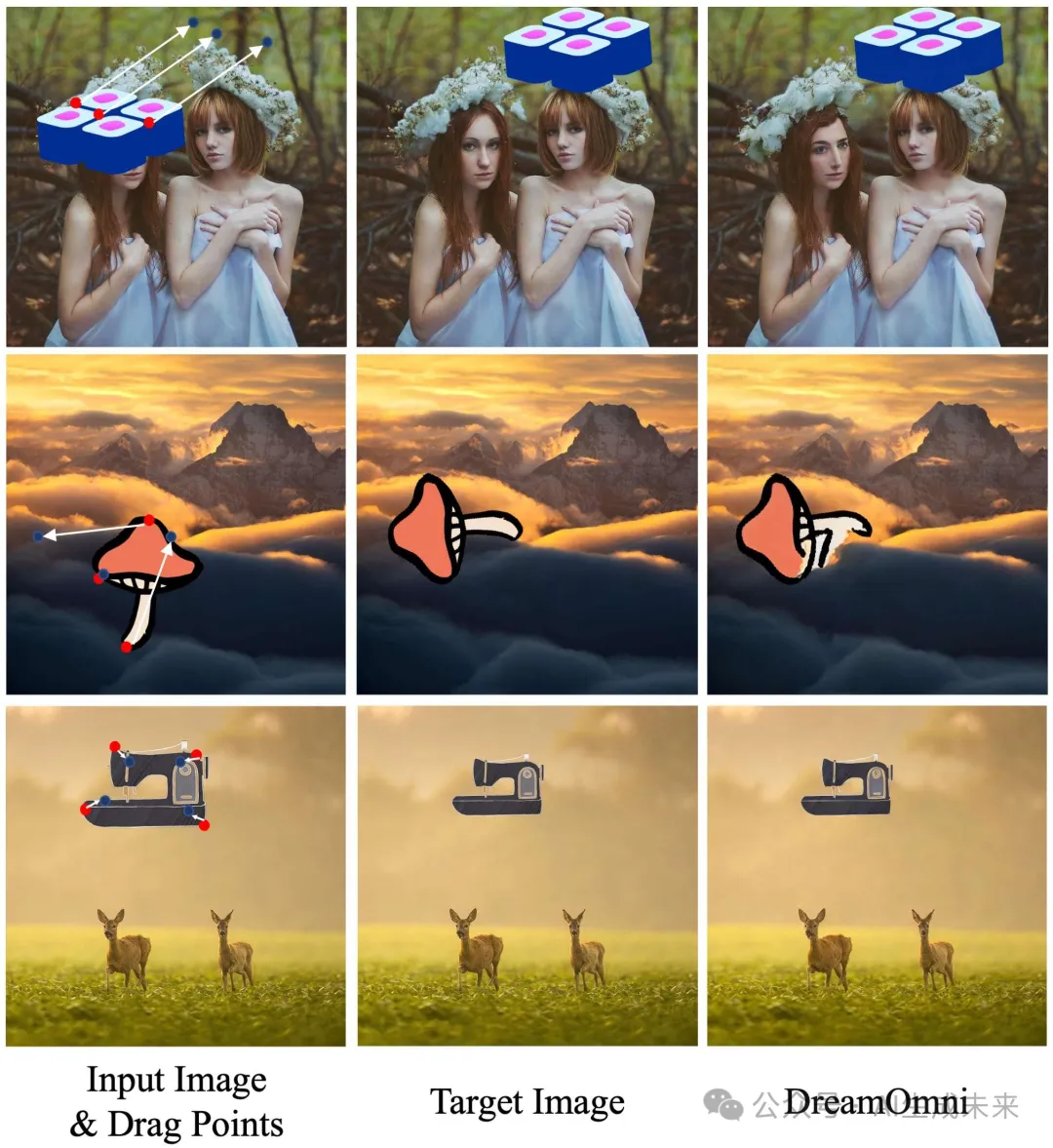

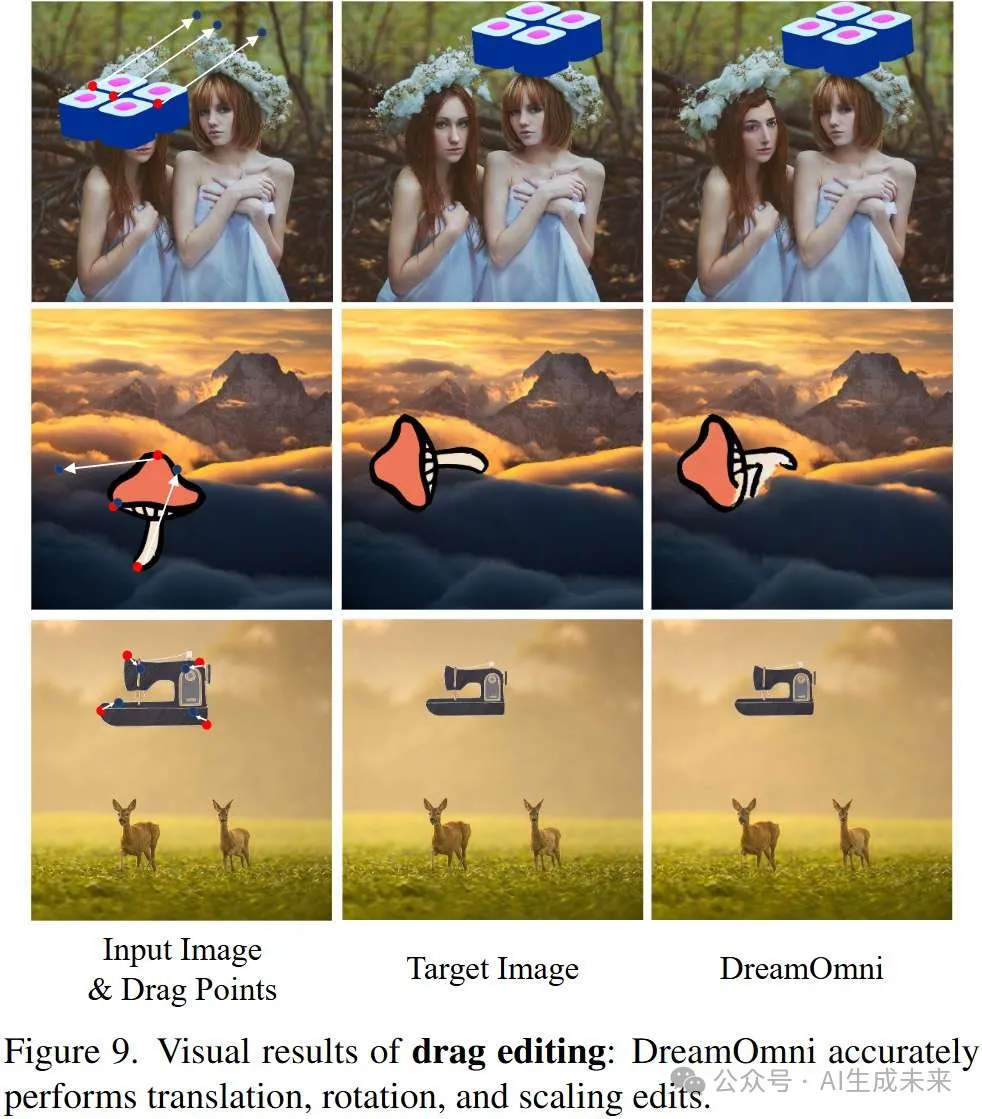

拖动编辑的视觉比较

方法论

多任务统一化是计算机视觉和人工智能领域的一个趋势和追求,它不仅增强了模型的可用性,减少了部署的复杂性,还能实现协同训练,从而促进任务之间的协同效应。然而,目前的T2I基础模型主要是专门为T2I设计的,通常忽视了与其他任务(如各种图像编辑任务)整合的潜力。为此,提出了DreamOmni,一个统一的图像生成与编辑模型。从三个方面设计并训练了DreamOmni:

- 在公平的环境下比较了各种框架,并基于不同任务的特性设计了一个强大且训练收敛速度快的框架,支持统一的多任务处理。

- 提出了一个便捷、高效且准确的合成数据流程,用于扩展数据规模,以促进多任务的统一训练并增强模型的指令跟随能力。

- 介绍DreamOmni的训练方案。

T2I和各种编辑任务的本地统一训练可以防止概念遗忘和生成质量下降,同时增强模型的编辑和提示跟随能力。

框架

旨在设计一个统一且强大的图像生成与编辑框架。目前,不同的编辑模型通常有不同的结构设计。例如,IP-adapter和 BLIP-Diffusion通过跨注意力注入信息以保持主体的一致性;而InstructP2P通过为模型添加不同数量的输入通道来实现编辑一致性。这些结构是针对特定任务量身定制的,缺乏通用性。因此,如下图2 (a) 所示,将VLM特征与噪声隐空间变量进行拼接,并将其输入到DIT块进行联合多头自注意力操作。

之后,VLM特征和噪声隐空间变量会通过FeedForward模块进行处理。这使得模型能够自主学习任何层次的特征(从整体一致性到主体一致性)进行编辑和生成。值得注意的是,对于FeedForward模块,将VLM特征和噪声隐空间变量分开,通过两个不同的FeedForward模块进行处理,且网络结构相同。此外,并没有使用CLIP或 T5作为文本编码器,而是引入了一个视觉-语言模型(VLM),使得图像和文本提示可以共同理解与编码。

在当前的框架设计中,一些工作,如DIT,是在标签条件生成下进行比较的,而不是T2I。然而,T2I本质上比基于标签的生成更为复杂,因为它需要集成和理解复杂的提示。此外,许多T2I模型,例如SDXL,使用了不同的模型大小、数据集和训练设置。这种差异使得评估不同模型组件对整体性能的影响变得具有挑战性。此外,SDXL在其UNet结构中融合了许多Transformer块。

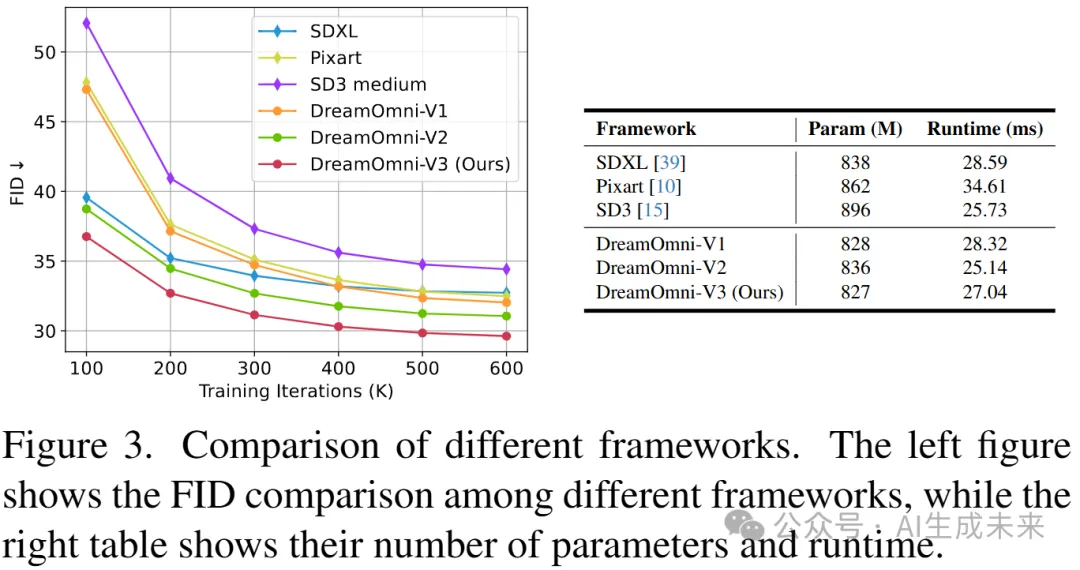

那么,为什么DIT能够超越SDXL呢? 为了解决这个问题,进行了大量的实验,如图3所示。观察到DIT优于Unet,因为DIT将大部分计算分配到2×下采样的隐空间变量,而Unet将更多计算分配到4×下采样的隐空间变量。由于在1×隐空间变量上的注意力操作会带来内存负担,进一步采用残差卷积块来细化1×隐空间变量的生成细节。此外,还观察到,在UNet框架中使用长连接可以显著加速模型的训练收敛速度,而不会影响性能。如图2 (a)所示,将早期和后期的特征沿通道维度进行拼接,并应用线性层将这两个特征合并。值得注意的是,VLM特征和噪声隐空间变量使用的线性层是不同的。

合成数据

除了统一框架外,还需要大量数据来支持联合训练。虽然T2I数据比较容易获取,但为像基于指令的编辑任务创建和筛选准确、高质量的数据要复杂得多。为了解决这一问题,引入了一个合成拼贴数据流程,能够高效且准确地生成所需的编辑数据。如图2 (b) 所示,流程涵盖了六个任务。值得注意的是,这并不是合成流程的全部能力;它还能够处理更复杂的任务组合。

- T2I生成:如图2 (b)所示,除了常规的T2I数据外,通过结合合成数据进一步增强模型在T2I任务中的表现,特别是在文本、形状、位置、数量和颜色生成方面。具体来说,对于文本,在空白画布上随机生成单词或短语,使用各种字体、颜色、厚度和大小。对于形状和数量,随机创建具有不同数量、颜色和大小的几何形状,并将它们排列在画布上。基于这些属性及其位置,我们生成准确的提示,并通过LLM进一步优化。此外,使用多种贴纸和分割数据进行合成,将它们放置在画布上并计算它们的精确空间关系。这些提示随后会由LLM生成并进一步优化,以产生更自然的描述。

- 修复与扩展:随机生成用于涂抹、块状物和图像边缘的mask。值得注意的是,在训练过程中,除了将被遮罩的图像及其相应的mask输入到VLM进行编码外,还以50%的概率包含图像描述。

- 基于指令的编辑:将任务分为三种操作:添加、删除和替换。对于删除和替换操作,随机选择一个背景图像和一个物体图像来创建源图像。在删除情况下,目标图像仅为背景图像;对于替换,目标图像通过将物体替换为不同的物体来生成。值得注意的是,对于添加,由于需要将添加的物体放置在与背景相对的合适位置,在本论文中使用了空白背景。

- 拖动编辑:将数据分为三种类型:平移、缩放和旋转。值得注意的是,Instadrag 将每一对拖动点视为一张独立的图像,这种方法较为稀疏且由于固定的拖动点数量要求,实用性较差。因此,使用格式 表示每个拖动点,作为提示输入,其中 和 表示源图像中拖动点的坐标,dx 和 dy 表示平移向量。此外,我们通过将这些坐标除以图像的宽度或高度来对其进行归一化。

- 参考图像生成:将数据分为两种类型:基于图像的生成,类似于ControlNet,和基于主体的生成。对于基于图像的生成,首先选择高质量的图像,并创建相应的Canny图、深度图和分割mask作为训练的源图像。对于基于主体的生成,合成源图像,并随机选择这些图像中的物体来创建目标图像。模型通过参考源图像中的特定属性生成新的内容,从而能够灵活地生成多样的场景和主体。

- 分割与检测:随机选择一个背景图像和一个物体图像,将它们合成成源图像。随后,应用颜色操作或在物体区域画一个边框,基于物体图像的Alpha通道来获得目标图像。

总体来说,合成拼贴数据流程既高效又精确,能够轻松生成数十亿种多样化的编辑图像。它非常适合用于DreamOmni的大规模预训练和微调。

模型训练

经过仔细考虑,为DreamOmni的DIT模型选择了2.5B参数的模型大小。这一大小在确保强大性能的同时,也能保证用户友好性。对于VLM编码器,直接采用了Qwen2-VL 7B模型,基于以下三个原因:

- 它支持任意分辨率的图像输入;

- 它提供强大的模型性能;

- 它是以宽松的开源许可证发布的。

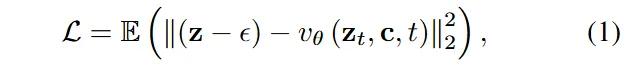

VLM特征来源于Qwen2-VL的倒数第二层。此外,使用FLUX-schnell的VAE作为DreamOmni的VAE,它保留了更多的隐空间通道,使模型能够捕捉更细致的图像细节。此外,我们使用Rectified Flow优化DreamOmni,该方法通过在噪声和数据之间沿直线插值执行前向过程。使用损失L对DreamOmni进行训练:

其中, 表示在时间步t的噪声特征图。真实图像通过VAE编码到隐空间空间以得到z。这里,表示高斯噪声,表示DIT模型,是条件信息。

T2I训练数据集包括1.25亿张图像,涵盖了LAION数据集(1.03亿)和收集的数据(2200万)。这些图像已通过InternVL2 进行了标注。对于合成数据,如T2I、指令编辑、修复与扩展、拖动编辑和参考图像生成,分别生成了1200万张图像,总数大约为6000万张。此外,对于分割与检测,生成了800万张图像。在训练之前,为了提高训练速度,首先将提示编码为VLM特征。

训练过程分为三个阶段。在第一阶段,使用256×256大小的图像,批次大小为2048,学习率为1×10⁻⁴,进行377K次迭代;在第二阶段,使用512×512大小的图像,批次大小为1024,学习率为5×10⁻⁵,进行189K次迭代;在最后阶段,从12M高质量T2I数据中随机抽取1M张高质量图像,并结合每种合成数据类型,训练1024×1024大小的图像,批次大小为256,学习率为2×10⁻⁵,进行140K次迭代。

所有实验均在64个A100 GPU上进行。此外,为了使模型能够生成不同分辨率的图像,在训练时,类似于SDXL的方法,依据图像的纵横比将图像分成31个buckets,纵横比从4:1到1:4不等。

实验

框架评估

在相似的设置下比较了几种T2I模型框架,以识别有效的组成部分。使用相同的VAE、CLIP文本编码器、参数、运行时间以及LAION训练/测试数据集,评估了基于Unet的SDXL、基于DIT的Pixart、SD3-Medium和DreamOmni变体。值得注意的是,如图3所示,为了便于比较,并没有使用DreamOmni的全部2.5B参数,而是将所有模型的参数调整为0.85B。DreamOmni-V1具有与SDXL相同的两个下采样层(2×和4×),但缺少Unet连接。

DreamOmni-V2在DreamOmni-V1的基础上增加了Unet连接,而DreamOmni-V3进一步集中所有DIT操作于2×下采样的隐空间空间。

- 有Unet连接的模型(如SDXL、DreamOmni-V2、DreamOmni-V3)显示出比没有Unet连接的模型(如SD3-Medium、DreamOmni-V1)更快的收敛速度。尤其是,DreamOmni-V3的收敛速度比SD3-Medium快四倍,显著提升了训练和微调效率。

- 比较DreamOmni-V3和DreamOmni-V2时,发现将DIT模块的计算集中在更高分辨率的隐空间空间(2×)上,更具成本效益。

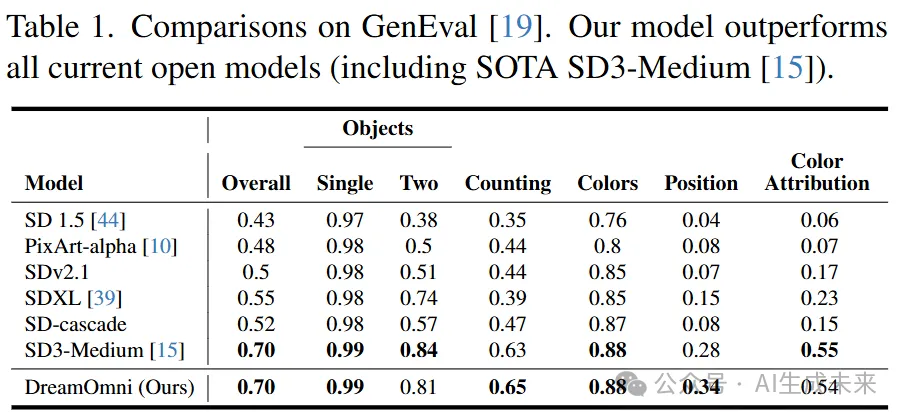

T2I生成评估

如表1所示,我们的合成数据显著提升了DreamOmni在T2I生成方面的能力,特别是在数量、颜色和位置方面,使得我们的模型在GenEval上取得了SOTA结果。值得注意的是,SD3-Medium 是一个2B的开源SOTA T2I模型,参数与我们的DreamOmni相似。此外,图4展示了定性结果。可以看到,DreamOmni的输出不仅视觉上更具吸引力,而且与给定的提示更为一致。

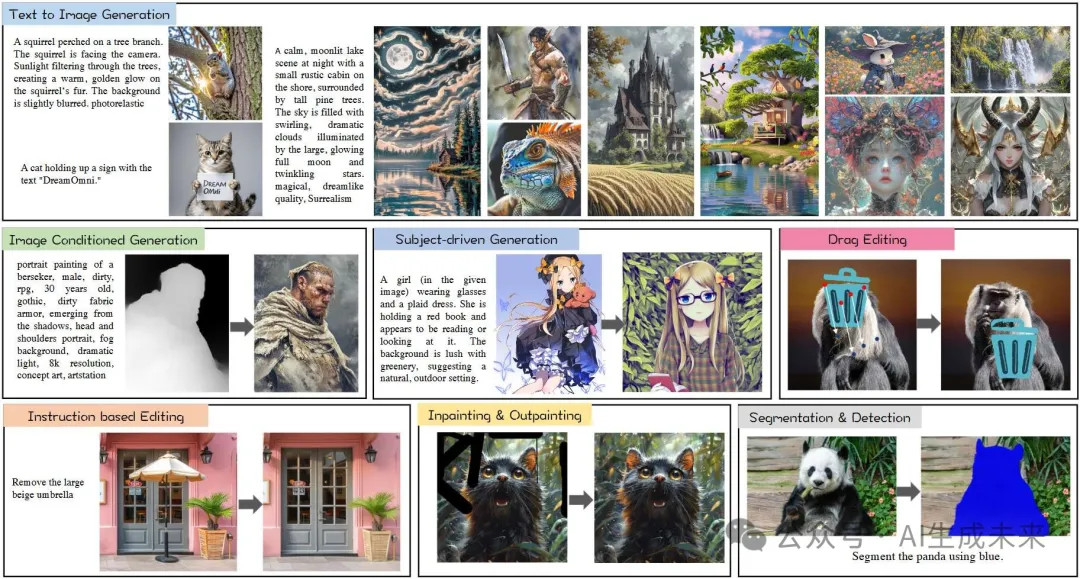

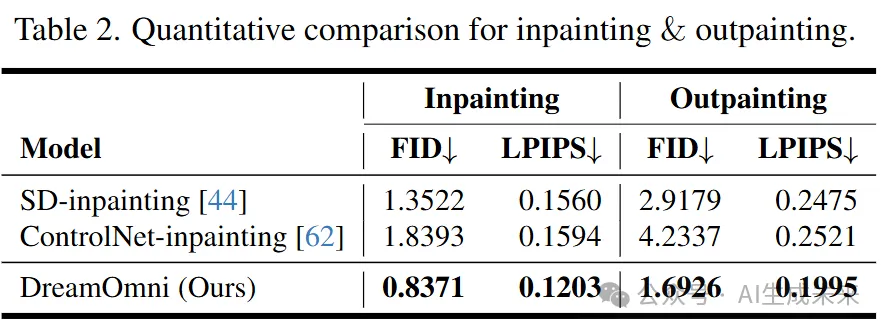

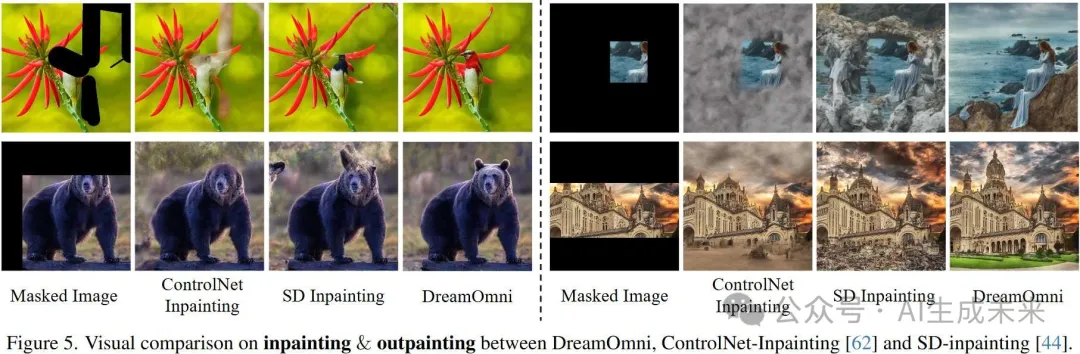

修复评估

将DreamOmni与ControlNet-Inpainting和SD-Inpainting 在我们的高质量评估数据集上进行了比较,以评估其性能。定量结果如表2所示,表明DreamOmni在生成质量和一致性方面显著优于ControlNet-Inpainting和SD-Inpainting。视觉结果(图5)进一步强调了DreamOmni在生成细节方面的优势,超越了ControlNet-Inpainting和SD-Inpainting。此外,DreamOmni在处理大面积掩码时非常有效,能够生成逼真的内容,而不是模糊和不一致的输出。

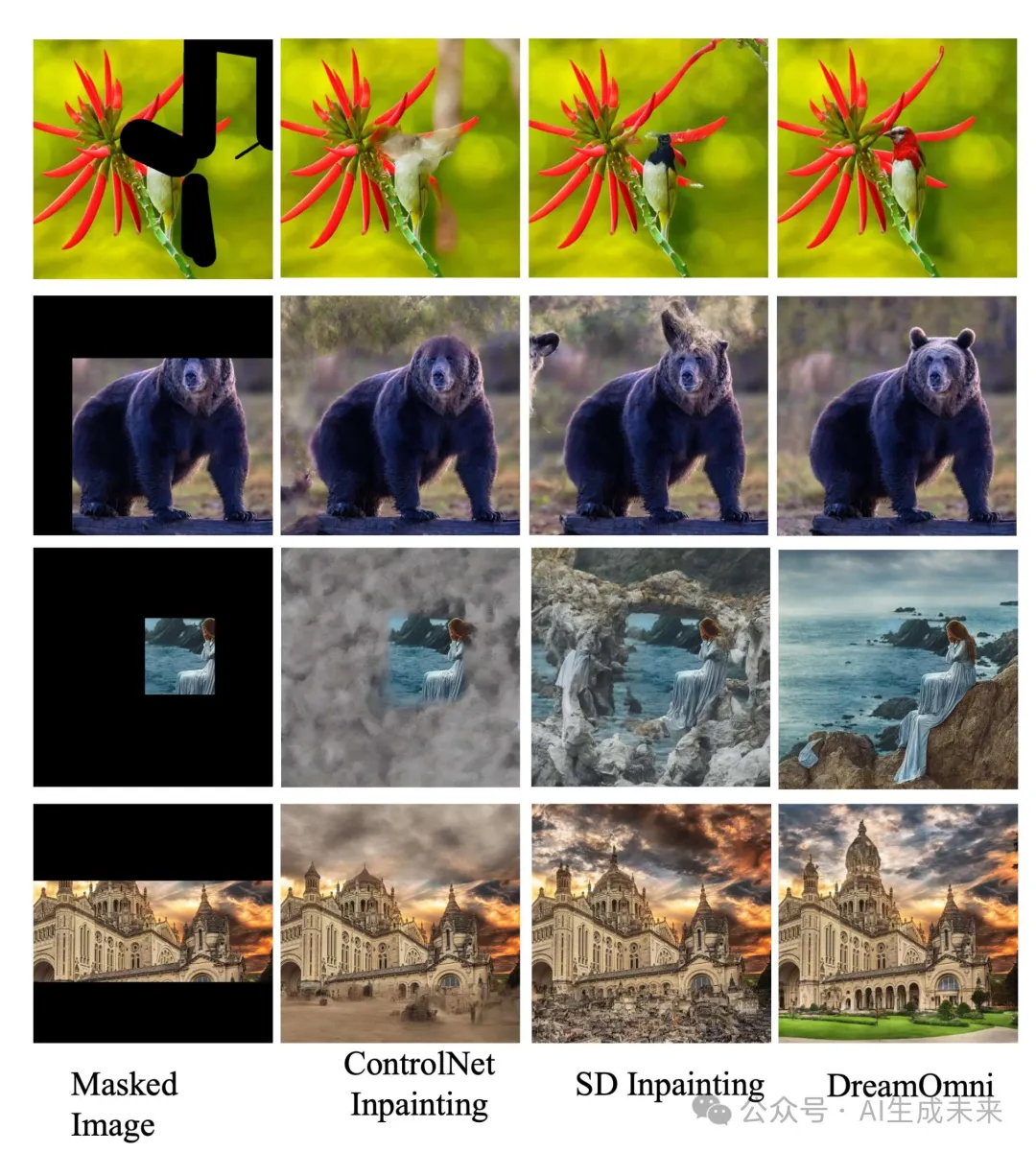

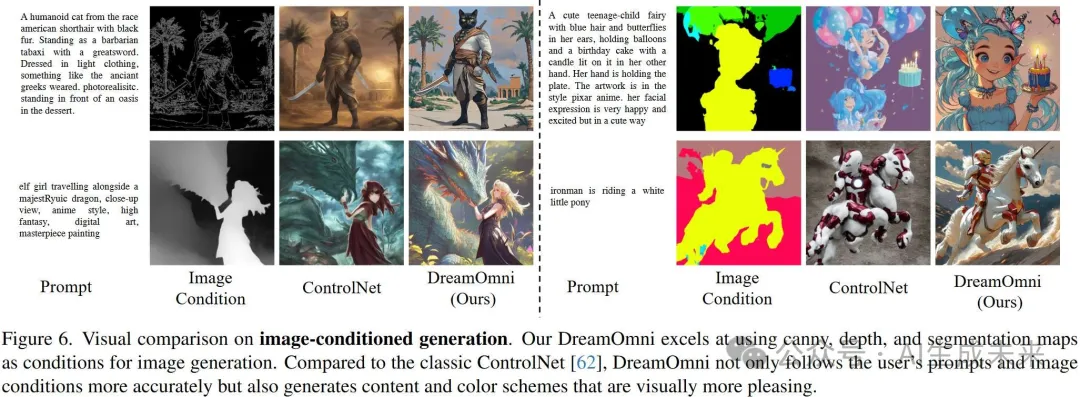

参考图像生成评估

对于基于图像的生成,与ControlNet 在Canny图、深度图和分割图像条件下进行了比较。图6展示了视觉结果。这些结果表明,在所有测试条件下,DreamOmni明显优于ControlNet。方法不仅能更忠实地遵循图像条件和提示,还表现出更好的视觉质量,具有更好的构图和更丰富的细节。

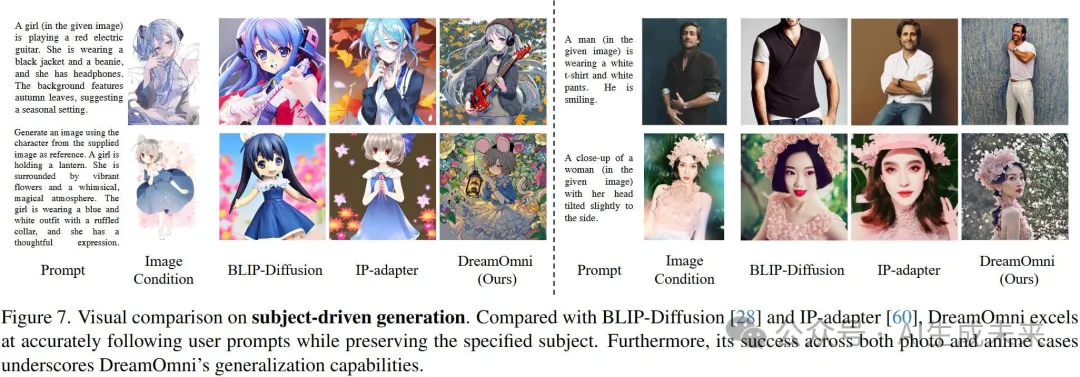

对于基于主体的图像生成,将我们的方法与竞争方法(如BLIP-Diffusion和IP-Adapter)进行了比较。为了展示DreamOmni强大的泛化能力,在动漫和摄影图像上验证了其性能。图7展示了视觉结果。与其他方法相比,我们的DreamOmni不仅能有效保留指定的主体,而且能较好地遵循提示。

指令编辑评估

将DreamOmni与MGIE 和InstructP2P 等竞争方法进行了比较。图8展示了视觉结果。可以看到,DreamOmni在添加、删除和替换操作上表现出更精确的编辑。具体来说,编辑结果展现出较高的一致性,对未编辑区域的变化最小,并且生成的编辑内容质量较高。这进一步验证了我们的合成数据pipeline是一种高效且有效的创建基于指令编辑数据集的方法,能够使模型学习精准的指令编辑。此外,合成数据pipeline的高效性使得模型能够轻松扩展多样化的训练数据。

拖动编辑评估

在合成评估数据集上对DreamOmni进行了评估。下图9展示了视觉结果。

- 与目标图像相比,DreamOmni能够准确执行平移、旋转和缩放的拖动编辑。

- 对于平移和缩放,DreamOmni能够保持拖动物体的完整性。然而,大范围的旋转操作对DreamOmni来说更具挑战性,因为它涉及物体自身的复杂变换,这可能导致编辑物体的变形。

- 这些结果展示了我们的合成数据pipeline在拖动编辑方面的有效性,通过将拖动点位置和位移信息编码为指令输入,使得模型能够学习精确的拖动编辑(如前面图2所示)。

结论

当前的T2I基础模型缺乏统一的框架和下游任务训练,如图像编辑。为了解决这个问题,介绍了DreamOmni,一种用于T2I生成和编辑的统一模型。在公平设置下评估了现有模型的框架,并考虑了不同编辑任务的具体需求。通过分析,开发了一个将T2I与各种编辑任务集成的框架。此外,训练编辑模型的挑战之一是创建高质量、大规模的编辑数据,这通常是低效的。为了解决这个问题,设计了一种合成拼贴数据pipeline,能够高效生成大量精准、高质量的编辑数据。此外,该pipeline增强了模型在文本、位置、数量、颜色和几何方面的生成准确性。通过联合训练T2I和多任务合成数据,开发了一个原生的、统一的图像生成与编辑模型。T2I训练强化了模型对特定概念的掌握,并提高了生成质量,而编辑训练使其能够处理编辑任务的需求。

本文转自AI生成未来 ,作者:AI生成未来