中国科学院软件研究所联合团队通过反事实推理解锁多智能体系统中的智能体行为

一年多以来,强化学习(RL)在许多重要的顺序决策问题上取得了惊人的进展,随着问题的复杂性不断增加,研究领域也逐渐从单智能体强化学习算法转向多智能体强化学习(MARL)算法,这些算法在各种领域中发挥着越来越重要的作用,如无人驾驶飞机、工业机器人、相机网络和自动驾驶等。但是深度RL策略通常缺乏可解释性,使得人类很难理解和信任这些策略。在多智能体系统(MAS)中,由于智能体之间的交互和依赖性,这一问题更为突出。

多智能体系统是一种由多个智能体组成的系统,这些智能体相互协作或竞争以实现特定目标。每个智能体在系统中都有其独特的角色,并与其他智能体进行交互,共同完成任务。随着MAS在各类应用中的普及,对其进行解释变得日益迫切。尽管此前的研究已经针对智能体的行为或状态提供了解释,但仍未能充分理解黑箱智能体在MAS中的重要性以及整体团队策略。

为了拓宽RL应用在关键领域的采用,有必要通过有效的解释来增强RL智能体的透明性。现有的一些训练中解释RL方法可以同时在完成任务时提供模型的内在解释,但它们不能在黑箱环境中工作。12 月 23 日,来自中国科学院软件研究所的研究团队提出了一种新颖的智能体级别解释方法——EMAI,用于评估单个智能体的重要性,弥补了这一研究空白。通过反事实推理,EMAI通过评估智能体随机行为引起的奖励变化来衡量其重要性,从而提供更高保真度的解释和更有效的实际应用指导,他们的论文《Understanding Individual Agent Importance in Multi-Agent System via Counterfactual Reasoning》同日发表于arXiv。

研究工作由多个机构的研究人员合作完成,主要团队成员包括中国科学院软件研究所(ISCAS)的Jianming Chen、Yawen Wang、Junjie Wang、Jun Hu、Qing Wang和Fanjiang Xu。研究团队隶属于综合信息系统实验室、国家智能游戏技术重点实验室以及中国科学院大学。新加坡管理大学的Xiaofei Xie。这些研究人员在人工智能、多智能体系统和反事实推理等领域具备深厚的学术背景和丰富的研究经验,致力于通过先进的技术提升系统的解释能力和应用效果。

相关工作

随着多智能体系统(MAS)在复杂任务中的应用逐渐普及,对智能体行为和决策的解释需求变得日益迫切。研究领域中已经有许多关于强化学习(RL)解释的工作,这些工作主要分为训练中解释和训练后解释。

在训练中解释方面,研究者们致力于设计能同时提供解释的RL训练算法。这些方法通常在任务执行过程中生成可解释的中间结果,从而让用户了解智能体如何进行决策和完成任务。举例来说,分层RL模型、模型近似方法以及信贷分配技术都是典型的训练中解释方法。然而,这些方法的主要目标是优化RL模型的性能,解释能力往往只是附带的,并且精度较低。此外,这类方法提供的解释是模型自身生成的,无法用于解释黑箱智能体。

相比之下,训练后解释方法则侧重于在智能体训练完成后解释其决策过程和策略。根据解释目标的不同,现有的训练后解释方法主要分为两类:观测级别的解释和步骤级别的解释。观测级别的解释方法通过构建显著图等手段,揭示观察中对智能体决策影响最大的特征区域。而步骤级别的解释方法则旨在找出整个过程中最关键的时间步,从而确定对最终奖励起关键作用的时间节点。然而这些方法通常无法评估每个时间步中智能体的重要性,这在MAS中尤为重要。

反事实推理作为一种广泛应用于监督学习模型解释的方法,通过扰动输入并观察对结果的影响,揭示模型特定预测背后的原因。在多智能体系统中,反事实推理也被引入来解释智能体的行为。例如,通过扰动智能体的行为并观察奖励变化,研究人员可以确定哪些行为对最终结果最为关键。尽管反事实推理在观测级别和状态级别的解释中已经取得了一定进展,但在每个时间步上进行智能体级别解释仍然是一个尚未充分探索的领域。

对于多智能体系统的现有解释方法来说,存在一些显著的局限性。许多方法在黑箱设置下无法有效工作,而只能在白箱设置中提供解释。这些方法在处理智能体间复杂交互和时间步之间的依赖关系时,往往显得力不从心。为了解决这些问题,研究团队提出了一种基于反事实推理的EMAI方法,通过学习屏蔽智能体策略,有效评估每个时间步上目标智能体的重要性,从而提供更高保真度的解释。

研究方法

目前的研究主要集中在智能体行为或状态的解释上,而对智能体在MAS中的重要性以及团队整体策略的理解却相对不足。研究团队提出了一种名为EMAI(Explanation of Multi-Agent Importance)的新方法,旨在通过反事实推理评估单个智能体的重要性,以弥补这一研究空白。具体来说,EMAI通过评估智能体随机行为引起的奖励变化,来衡量智能体的重要性,并提供相应的解释。

多智能体强化学习(MARL)问题涉及多个智能体在同一环境中相互协作或竞争,以最大化某一全局奖励函数。在这种情境下,每个智能体都具有独特的策略,并且其决策会影响整个系统的表现。在实际应用中,由于智能体之间存在复杂的交互关系和时间上的依赖性,导致MARL问题变得非常复杂。因此,为了能够有效评估每个智能体的重要性,研究人员需要一种能够捕捉这些复杂关系的方法。

目标智能体的重要性评估

在MAS中,评估单个智能体的重要性是理解其行为和系统整体表现的关键。具体而言,研究人员需要确定每个智能体在不同时间步上的重要性,以识别那些对系统表现至关重要的智能体。现有的方法主要集中在通过扰动输入来评估智能体的重要性,但这些方法往往无法有效处理多智能体系统中的复杂交互关系和依赖性。为了解决这一问题,研究团队提出了一种基于反事实推理的方法,通过随机化智能体的行为并观察其对系统奖励的影响,来评估智能体的重要性。

反事实推理在MAS中的应用

反事实推理是一种用于解释监督学习模型的常用方法,通过扰动输入并观察结果变化,揭示模型特定预测背后的原因。在MAS中,反事实推理也被引入来解释智能体的行为。具体而言,通过随机化智能体的行为,并观察其对系统奖励的影响,可以确定哪些智能体在当前时间步上对系统表现最为关键。这种方法不仅可以提供更高保真度的解释,还能帮助识别系统中的潜在问题和漏洞,为进一步优化系统提供有力支持。

EMAI(个体智能体重要性解释方法)的提出

为了解决现有方法在处理MAS时的局限性,研究团队提出了一种新颖的智能体级别解释方法——EMAI。EMAI通过反事实推理,评估单个智能体的重要性,以提供更高保真度的解释。具体来说,EMAI利用随机化智能体行为引起的奖励变化,衡量智能体的重要性,并采用多智能体强化学习(MARL)模型来捕捉智能体之间的复杂交互关系。

策略随机化与奖励变化

在EMAI方法中,研究人员通过随机化智能体的行为来评估其重要性。具体而言,如果某个智能体的随机行为导致系统奖励发生较大变化,则表明该智能体在当前时间步上非常重要。为了实现这一点,研究人员设计了一种优化函数,旨在最小化随机化行为前后奖励的差异。同时,研究人员引入了稀疏约束,以鼓励在训练过程中探索更多的智能体行为随机化。

屏蔽智能体的设计与训练

在EMAI方法中,研究人员引入了屏蔽智能体的概念,这些智能体通过学习来识别并屏蔽那些不重要的目标智能体的行为。具体而言,屏蔽智能体的策略学习被建模为一个多智能体强化学习(MARL)问题,通过反事实推理评估目标智能体的重要性,并在训练过程中最小化随机化行为引起的奖励差异。为了确保模型的有效性,研究人员采用了集中训练与去中心化执行(CTDE)范式,该范式允许在训练过程中使用全局信息指导个体智能体的学习,而每个智能体基于自身观察独立决策,从而有效分解联合动作空间。

通过上述方法,EMAI能够提供更高保真度的解释,并在理解策略、发动攻击和修补策略等实际应用中提供有效指导。后续章节将详细介绍EMAI的模型架构与训练过程,以及实验与评估结果。

模型架构与训练

在理解多智能体系统中个体智能体的重要性时,EMAI(Explanation of Multi-Agent Importance)方法的提出为研究人员提供了一种新颖而有效的解决方案。研究团队将详细探讨EMAI的模型架构与训练过程,包括其整体框架、屏蔽智能体和中央评论网络的设计、训练目标和优化函数,以及中心化训练与去中心化执行(CTDE)范式的应用。

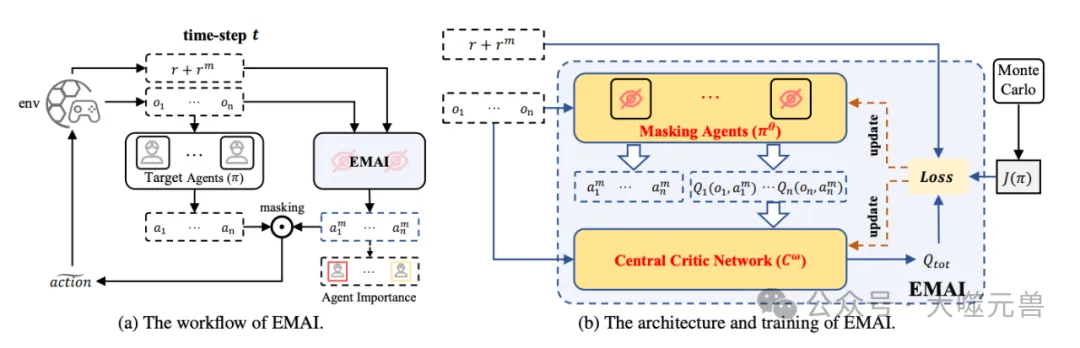

图1:研究团队提出的EMAI概述。(a) 在每个时间步,EMAI输出每个目标代理的动作随机化的掩蔽概率,概率越低,相应目标代理的重要性越高。(b) 在训练过程中,掩蔽代理的策略网络学习掩蔽动作和个体值,中央批评网络学习总值以估计预期奖励。引入损失函数以最小化动作随机化前后的奖励差异,并鼓励代理人进行更多的动作随机化。

EMAI的整体框架旨在通过反事实推理评估单个智能体的重要性,从而提供更高保真度的解释。该框架由两个主要部分组成:屏蔽智能体网络和中央评论网络。屏蔽智能体网络负责学习和识别那些在每个时间步上对系统表现不重要的智能体,并随机化这些智能体的行为。而中央评论网络则从全局角度评估屏蔽智能体的联合行为,确保模型能够捕捉智能体之间的复杂交互关系。

屏蔽智能体和中央评论网络

在EMAI方法中,屏蔽智能体的设计和训练是实现智能体级别解释的关键。屏蔽智能体通过学习来识别并屏蔽那些不重要的目标智能体的行为。具体而言,每个屏蔽智能体都会基于其观察到的信息,决定是否随机化目标智能体的行为。如果某个智能体的重要性较低,则屏蔽智能体会随机化其行为,从而评估其对系统表现的影响。

中央评论网络则负责从全局角度评估屏蔽智能体的联合行为。通过结合所有屏蔽智能体的决策,中央评论网络能够更好地理解智能体之间的相互依赖性,并为优化屏蔽智能体的策略提供指导。在训练过程中,中央评论网络会不断调整其权重,以确保屏蔽智能体能够准确识别并随机化那些不重要的目标智能体。

训练目标和优化函数

为了确保EMAI方法的有效性,研究人员设计了一种优化函数,旨在最小化随机化行为前后系统奖励的差异。具体来说,优化函数的目标是通过最小化目标智能体行为随机化前后的奖励差异,从而提高屏蔽智能体识别不重要智能体的精度。同时,研究人员还引入了稀疏约束,以鼓励屏蔽智能体在训练过程中探索更多的智能体行为随机化,从而提高模型的整体表现。

在训练过程中,屏蔽智能体和中央评论网络会基于当前的观察和系统状态,不断调整其决策和权重,以最小化优化函数的值。通过这种方式,EMAI方法能够逐步提高其识别和随机化目标智能体的精度,从而提供更高保真度的解释。

中心化训练与去中心化执行(CTDE)在EMAI中的应用

在EMAI方法中,研究人员采用了中心化训练与去中心化执行(CTDE)范式,以更好地处理多智能体系统中的复杂交互关系。CTDE范式允许在训练过程中使用全局信息指导个体智能体的学习,而每个智能体在执行过程中则基于自身的观察独立决策,从而有效分解联合动作空间。

CTDE范式的一个重要原则是个体-全局-最大(IGM)原则。该原则旨在确保智能体的个体行为和全局行为在优化过程中能够同时最大化。具体来说,个体智能体的策略应通过最小化其个体奖励与全局奖励之间的差异来进行优化,从而确保其行为在整体系统中的贡献。

为了实现这一原则,研究人员设计了总损失函数,结合个体损失和全局损失,通过最小化总损失函数的值,确保智能体的个体行为和全局行为在训练过程中能够协调一致。总损失函数的设计使得EMAI方法在处理多智能体系统中的复杂交互关系时,能够更加高效和精确地评估每个智能体的重要性。

通过上述方法,EMAI方法不仅能够提供更高保真度的解释,还能够在理解策略、发动攻击和修补策略等实际应用中提供有效指导。通过中心化训练与去中心化执行(CTDE)范式的应用,EMAI方法能够在复杂的多智能体系统中,实现对个体智能体重要性的高效评估和解释。

实验与评估

为了验证EMAI方法在评估多智能体系统中个体智能体重要性方面的有效性,研究人员进行了多项实验。这些实验旨在评估EMAI的解释保真度、实际应用效果以及在不同多智能体环境中的表现。以下是实验的详细设置、评估指标和结果分析。

实验设置

研究人员选择了三个不同特征的多智能体基准环境进行实验,包括StarCraft多智能体挑战(SMAC)、Google研究足球(GRF)和多智能体粒子环境(MPE)。这些环境覆盖了密集奖励、稀疏奖励、对抗任务和协作任务等不同类型的多智能体任务。每个基准环境中选取了两个至三个代表性的任务,以验证EMAI方法的广泛适用性。

在实验过程中,研究人员将EMAI方法与三种常用且先进的基线方法进行了比较。基线方法包括StateMask、基于值的方法(VB)和基于梯度的归因方法(GBA)。StateMask是一种训练后解释方法,旨在分析每个时间步状态对最终奖励的重要性;VB是一种常用的训练中解释方法,基于MARL中的信贷分配或值分解问题,将重要性与价值函数相关联;GBA则利用输出对数概率的梯度进行训练中解释。

保真度评估

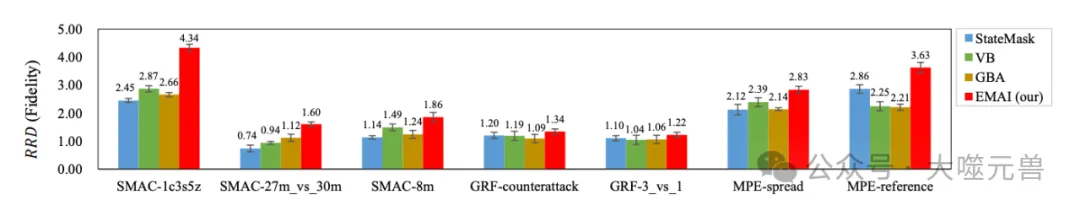

图2:保真度评估的结果。条形图表示平均值,条形图上的黑线表示标准偏差。

为了评估EMAI方法在识别重要智能体方面的精度,研究人员采用了保真度评估指标。具体来说,研究人员通过随机化选定智能体的行为,并测量奖励差异来评估解释的保真度。如果选定的智能体对最终奖励确实关键,那么随机化这些智能体的行为应该导致较大的奖励变化。研究人员使用相对奖励差异(RRD)来标准化不同环境中的奖励变化,RRD值越大,表示解释保真度越高。

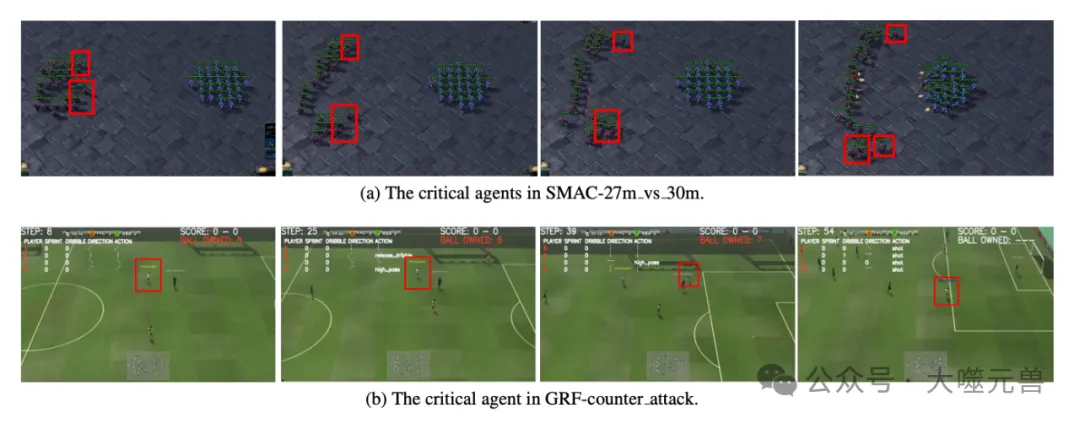

图3:EMAI识别的关键代理的图示,用红色框标记。

实验结果显示,EMAI方法在所有任务中均取得了最高的RRD值,相对于基线方法,保真度的相对改进在11%到118%之间。这表明,EMAI方法能够更准确地识别出多智能体系统中每个个体的重要性。

实用性评估

在实际应用中,研究人员评估并分析了EMAI方法在理解策略、发动攻击和修补策略方面的实用性。这些评估反映了EMAI方法在多智能体系统中的实际应用价值。

理解策略

研究人员通过可视化EMAI识别出的关键智能体,展示了EMAI方法如何帮助人类理解多智能体的策略。在SMAC和GRF任务中,EMAI成功识别出了在团队策略中具有重要作用的智能体。用户研究表明,大多数参与者认为EMAI提供的解释更符合人类直觉,并有助于识别策略缺陷。

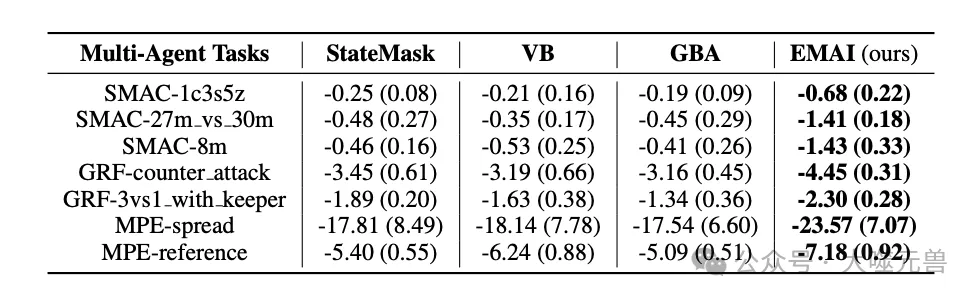

发动攻击

为了分析解释方法在发动攻击中的意义,研究人员设计了针对关键智能体的攻击实验。通过向关键智能体的观察值添加噪声,导致其做出次优决策。实验结果显示,EMAI指导的攻击最为有效,导致奖励减少最多,相对于基线方法的改进在14%到289%之间。

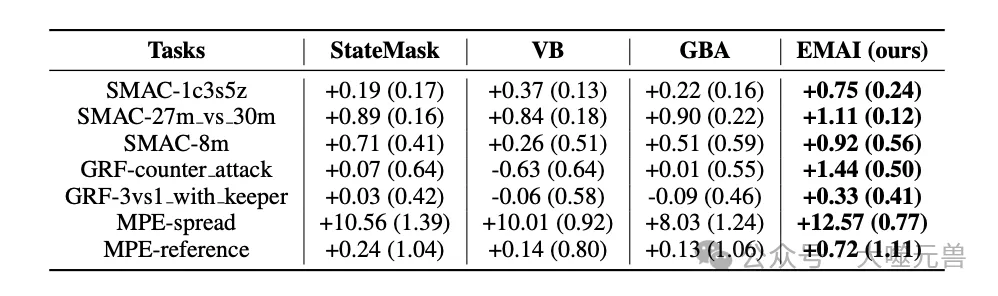

表1:攻击前后剧集团队奖励的变化。括号外和括号内的数字分别表示平均值和标准偏差。

表2:补丁前后剧集团队奖励的变化。括号外和括号内的数字分别表示平均值和标准偏差。

研究人员还设计了一种由EMAI指导的策略修补方法,通过记录高奖励片段中关键智能体的观察轨迹及其相应动作,构建补丁包。在需要修补的片段中,通过搜索与当前观察相似的观察并选择替代动作,提高系统表现。实验结果显示,EMAI指导的修补效果最佳,某些基线方法甚至导致奖励减少。

结论与未来工作

研究团队提出了一种新颖的智能体级别解释方法——EMAI,通过反事实推理来评估多智能体系统(MAS)中个体智能体的重要性。相比现有方法,EMAI通过随机化智能体行为引起的奖励变化,衡量智能体的重要性,并采用多智能体强化学习(MARL)模型来捕捉智能体之间的复杂交互关系。在实际应用中,EMAI不仅在理解策略方面表现出色,还在发动攻击和修补策略方面提供了有效的指导。

实验结果表明,EMAI在多个多智能体任务中均取得了显著优于基线方法的表现。尤其是在保真度评估中,EMAI的相对改进在11%到118%之间,证明了其在识别重要智能体方面的高效性和准确性。

EMAI的优势与应用前景

EMAI方法具备多种优势,使其在广泛的应用场景中具有巨大的潜力。EMAI通过反事实推理提供高保真度的智能体级别解释,解决了现有方法在处理复杂多智能体系统时的局限性。EMAI采用的多智能体强化学习模型,能够有效捕捉智能体之间的依赖关系,提高解释的精确度和适用性。

在实际应用方面,EMAI在理解策略、发动攻击和修补策略等方面表现出色。例如,通过可视化EMAI识别出的关键智能体,人类能够更好地理解多智能体系统的策略,并识别系统中的潜在问题和漏洞。此外,EMAI指导的攻击和修补策略实验表明,其在提升系统安全性和性能方面具有重要价值。

未来EMAI方法有望在无人驾驶、智能机器人、智能交通等领域得到广泛应用,帮助优化和解释复杂多智能体系统,提升其可靠性和透明性。

现有局限性与未来研究方向

尽管EMAI方法在多智能体系统的解释方面取得了显著进展,但仍存在一些局限性和挑战。首先,EMAI主要基于智能体行为的随机化来评估重要性,而在更加复杂的环境中,智能体的重要性可能还受其他因素(如视觉感知和规划能力)的影响。未来的研究可以进一步扩展EMAI方法,考虑更多因素对智能体重要性的影响,以提高解释的全面性和准确性。

在实际应用中,EMAI的方法需要大量的计算资源和时间,特别是在处理大规模多智能体系统时。为了解决这一问题,未来的研究可以探索更加高效的算法和优化技术,以提高EMAI方法的计算效率和实用性。

最后,EMAI在实际应用中还需要更多的验证和测试,以确保其在不同应用场景中的可靠性和适用性。未来的研究可以通过更多的实验和实地测试,进一步验证和完善EMAI方法,并探索其在不同领域中的具体应用和效果。(END)

参考资料:https://arxiv.org/abs/2412.15619