文生图击败所有扩散SOTA方案!智源研究院等提出NOVA:迈向统一的多任务大模型

文章链接:https://arxiv.org/pdf/2412.14169

Github链接:https://github.com/baaivision/NOVA

亮点直击:

- 高效的自回归建模:NOVA提出了不使用向量量化的自回归视频生成方法,通过时间步预测和空间集预测的分离,结合双向建模,在提高生成效率的同时保持较高的视觉保真度和流畅性。

- 显著降低训练成本:NOVA在文本到图像生成任务中超越了最先进的图像扩散模型,不仅在生成质量上表现出色,而且在训练成本上大幅降低,使得视频生成任务更具实用性。

- 良好的zero-shot泛化能力:NOVA能够处理不同的视频时长和应用场景,具有强大的zero-shot能力,使其成为一个统一的多功能模型,适应多种生成任务。

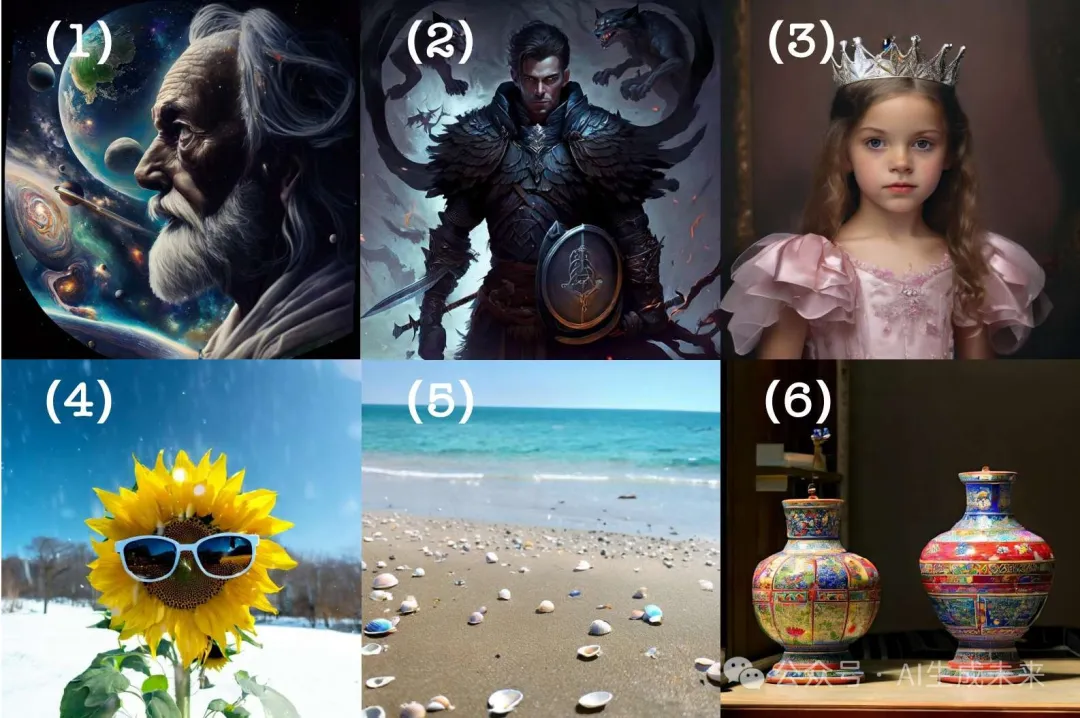

文生图效果一览

总结速览

解决的问题:

- 现有的自回归视频生成模型(如图像或视频片段通过向量量化转换为离散值标记空间后进行逐标记预测)面临着高保真度和高压缩率难以同时实现的问题。

- 向量量化的标记生成方法需要更多的标记来保证高质量,从而导致图像分辨率或视频序列较长时,计算成本显著增加。

- 在自回归(AR)视觉生成领域,现有方法通常采用栅格扫描预测,导致生成效率较低,且对于大规模视频数据的处理能力有限。

提出的方案:

- 提出了一种新的自回归视频生成方法,称为NOVA,通过不使用向量量化的方式进行视频生成建模。

- 该方法将视频生成问题重新表述为非量化的自回归建模,分为时间步预测和空间集预测两个部分。

- NOVA维持了GPT风格模型的因果特性(Causal Property),确保了灵活的上下文学习能力,同时在单帧内使用双向建模(Bidirectional Modeling)来提高效率。

应用的技术:

- 自回归建模(Autoregressive Modeling):通过不使用向量量化来实现帧对帧的时间预测和集对集的空间预测。

- 双向建模:在单帧内进行双向建模,以提高生成效率,减少计算资源需求。

- GPT风格因果建模:保持因果关系,使模型能够灵活地进行上下文学习。

达到的效果:

- NOVA模型比现有的自回归视频生成模型在数据效率、推理速度、视觉保真度和视频流畅性上具有显著优势,且模型容量较小,仅为0.6B参数。

- 较低的训练成本:在文本到图像生成任务中,NOVA超越了当前最先进的图像扩散模型,同时降低了训练成本。

- 广泛的zero-shot应用能力:NOVA模型在不同的视频时长和应用场景中具有良好的泛化能力。

方法

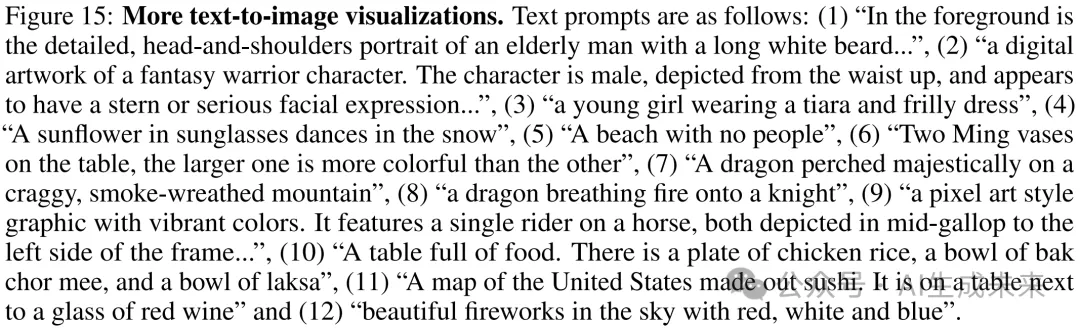

NOVA 框架的pipeline和实现细节,如下图 2 所示。

重新思考自回归模型在视频生成中的应用

本文将文本到视频生成视为基本任务,将自回归(AR)模型视为基本手段。自回归视频生成方法主要有两种类型:

(1) 通过栅格扫描顺序的逐token生成。这些研究在视频帧序列中执行因果逐token预测,并按照栅格扫描顺序依次解码视觉token:

(2) 随机顺序的mask集生成方法将每个视频帧内的所有标记视为平等,使用双向transformer解码器进行每组token的预测。然而,这种广义的自回归(AR)模型是在大型固定长度的视频帧上进行同步建模训练的,这可能导致在上下文上的可扩展性差,并且在较长的视频时长中存在一致性问题。因此,NOVA 提出了一个新解决方案,通过将单个视频帧内的每组生成与整个视频序列中的每帧预测解耦。这使得 NOVA 能够更好地处理时间因果性和空间关系,提供了一个更灵活、更具可扩展性的 AR 框架。

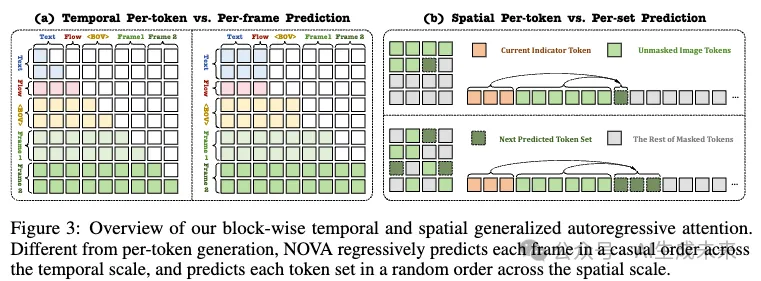

时间自回归建模通过逐帧预测

使用预训练的语言模型将文本提示编码为特征。为了更好地控制视频动态,使用 OpenCV (cv2)计算采样视频帧的光流。平均光流幅度作为运动评分,并与提示信息进行整合。此外,采用开源的 3D 变分自编码器(VAE),其时间步长为 4,空间步长为 8,将视频帧编码到隐空间。增加了一个额外的可学习的补丁嵌入层,空间步长为 4,用以对齐隐视频通道到后续的transformer。值得注意的是,早期 AR 模型中的下一个标记预测对于单个图像中的无向视觉补丁似乎是反直觉的,并且在推理过程中存在较高的延迟。相比之下,视频帧可以自然地看作一个因果序列,每个帧充当自回归生成的元单元。因此实现了如图 3(a) 所示的块级因果遮罩注意力,确保每个帧只能关注文本提示、视频光流以及其前面的帧,同时允许所有当前帧标记彼此可见:

空间自回归建模通过集对集预测

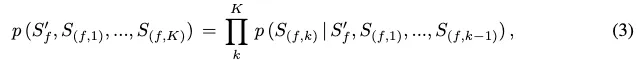

将每个token集定义为来自随机方向的多个标记作为元因果标记,如上图 3(b) 所示,从而促进了一个高效并行解码的广义 AR 过程。尝试利用时间层输出的目标帧指示特征来辅助空间层,逐渐解码对应图像中的所有随机masked token集。然而,这种方法导致了图像结构崩塌和随帧数增加而导致的视频流畅性不一致。我们假设这种情况的发生是因为来自相邻帧的指示特征相似,难以在没有显式建模的情况下准确学习连续和微小的运动变化。此外,训练期间从真实框架获得的指示特征对空间 AR 层的鲁棒性和稳定性贡献较弱,无法有效抵抗累积推理误差。

扩散过程去噪用于逐标记预测

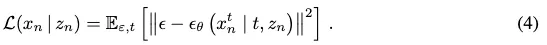

在训练过程中,引入了扩散损失来估算连续值空间中的per-token概率。例如,定义一个真实标记为 ,并且 NOVA 的输出为 。损失函数可以表述为去噪准则:

实验

实验设置

数据集:

我们采用多个多样化、精心挑选的高质量数据集来训练我们的 NOVA。对于文本到图像的训练,最初从 DataComp、COYO、Unsplash和 JourneyDB收集了 1600 万个图像-文本对。为了探索 NOVA 的扩展性,通过从 LAION、DataComp 和 COYO 中选择更多最低美学评分为 5.0 的图像,扩展了数据集,最终达到约 6 亿个图像-文本对。对于文本到视频的训练,从 Panda-70M的子集和内部视频-文本对中选择了 1900 万个视频-文本对。进一步从 Pexels收集了 100 万个高分辨率视频-文本对,以微调我们的最终视频生成模型。根据 (Diao et al. (2024)),训练了一个基于 Emu2-17B模型的字幕引擎,为我们的图像和视频数据集创建高质量的描述。最大文本长度设置为 256。

架构:

主要遵循 (Li et al. (2024c)) 构建 NOVA 的空间 AR 层和去噪 MLP 块,包括 LayerNorm、AdaLN、线性层、SiLU 激活 和另一个线性层。配置了 16 层的时间编码器、空间编码器和解码器,维度分别为 768(0.3B)、1024(0.6B)或 1536(1.4B)。去噪 MLP 由 3 个维度为 1280 的块组成。空间层采用 MAR的编码-解码架构,类似于 MAE。具体来说,编码器处理可见的图像块进行重建,而解码器进一步处理可见和被遮掩的块进行生成。为了捕捉图像的隐空间特征,使用了 (Lin et al. (2024)) 中的一个预训练并冻结的 VAE,它在时间维度上实现了 4 倍压缩,在空间维度上实现了 8×8 的压缩。采用了 (Li et al. (2024c); Nichol & Dhariwal (2021)) 的mask和扩散调度器,在训练过程中使用 0.7 到 1.0 之间的mask例,并在推理过程中根据余弦调度将其从 1.0 逐渐减少到 0。与常见做法一致 (Ho et al. (2020)),训练时使用 1000 步的噪声调度,但推理时默认为 100 步。

训练细节:

评估:

使用 T2I-CompBench、GenEval和 DPG-Bench来评估生成图像与文本条件之间的对齐度。对于每个原始或改写的文本提示 (Wang et al. (2024)),生成图像样本,每个图像样本的分辨率为 512×512 或 1024×1024。使用 VBench来评估文本到视频生成在 16 个维度上的能力。对于给定的文本提示,随机生成 5 个样本,每个样本的视频大小为 33×768×480。在所有评估实验中采用了 7.0 的无分类器引导,并结合 128 步自回归步骤来提高生成图像和视频的质量。

主要结果

NOVA 在文本到图像生成模型中超越了现有的模型,展现出卓越的性能和效率。

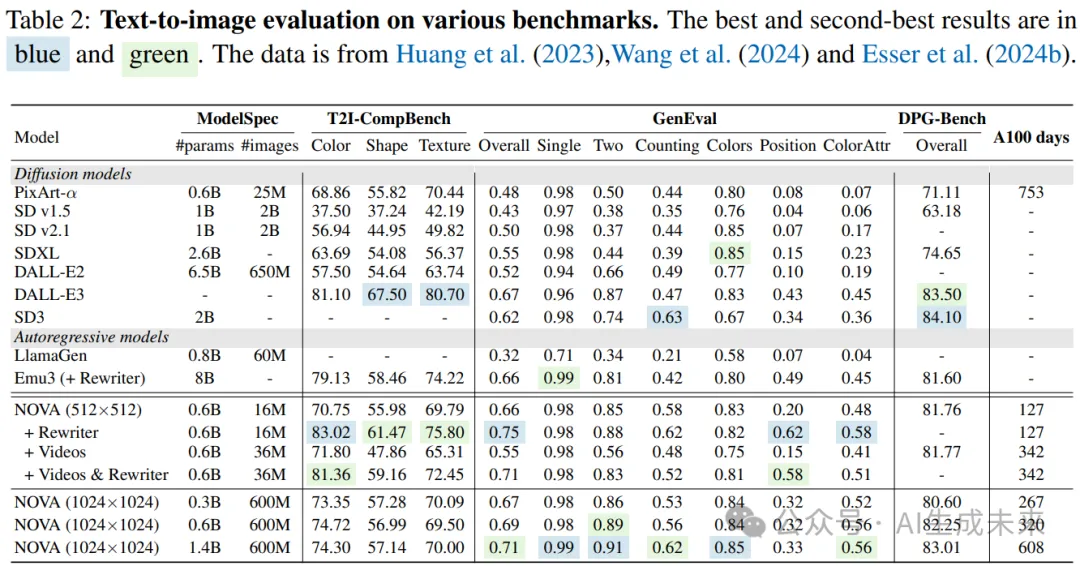

在 表 2 中,将 NOVA 与几种近期的文本到图像模型进行比较,包括 PixArt-α、SD v1/v2 、SDXL 、DALL-E2 、DALL-E3、SD3、LlamaGen和 Emu3。经过文本到图像的训练后,NOVA 在 GenEval 基准测试中取得了最先进的表现,尤其是在生成特定数量的目标时表现突出。

特别地,NOVA 在 T2I-CompBench 和 DPG-Bench 上也取得了领先的成绩,在小规模模型和大规模数据下表现优异(仅需 PixArt-α 最佳竞争者的 16% 训练开销)。最后,我们的文本到视频模型也超越了大多数专门的文本到图像模型,例如 SD v1/v2、SDXL 和 DALL-E2。这突显了我们模型在多上下文场景中的鲁棒性和多功能性,尤其是在文本到视频生成这一基本训练任务上表现尤为突出。

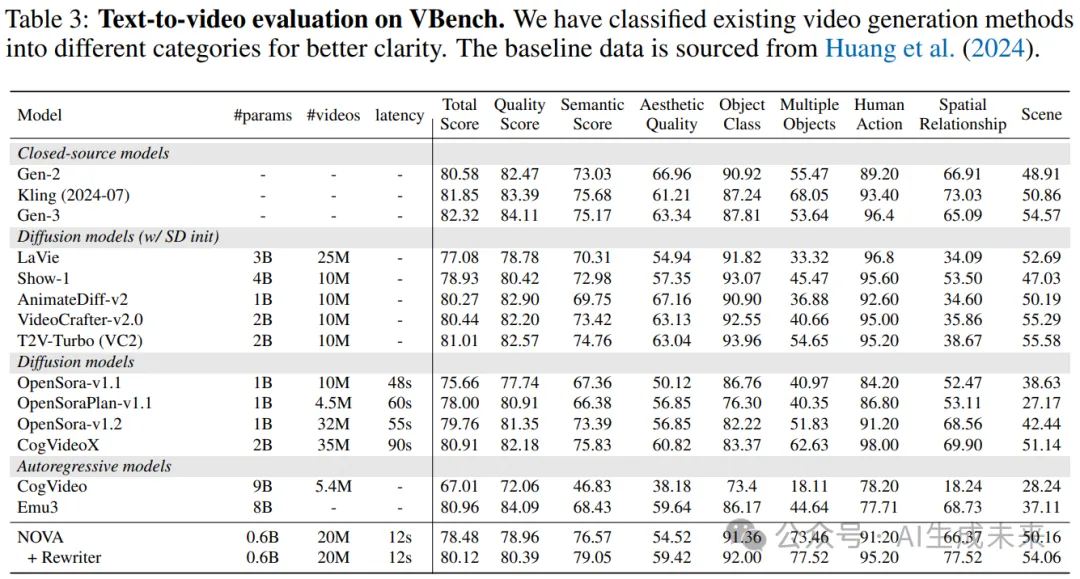

NOVA 在与扩散文本到视频模型的竞争中表现出色,并显著抑制了自回归(AR)对比模型。强调当前版本的 NOVA 设计用于生成 33 帧视频,并可以通过预填充最近生成的帧来扩展视频长度。进行了定量分析,将 NOVA 与开源和专有的文本到视频模型进行比较。如 表 3 所示,尽管其模型规模显著较小(0.6B 与 9B),NOVA 在多项文本到视频评估指标中明显超越了CogVideo。它的性能与最新的 SOTA 模型 Emu3相当(80.12 与 80.96),但其规模远小(0.6B 与 8B)。

此外,将 NOVA 与最先进的扩散模型进行了比较。包括 Gen-2、Kling、Gen-3等闭源模型,以及 LaVie、Show-1、AnimateDiff-v2、VideoCrafter-v2.0、T2V-Turbo、OpenSora-v1.1、OpenSoraPlan-v1.1/v1.2和 CogVideoX等开源替代方案。结果凸显了文本到图像预训练在我们广义因果过程中的有效性。值得注意的是,缩小了自回归与扩散方法在建模大规模视频文本对中的差距,提升了视频生成的质量和指令跟随能力。此外,NOVA 在推理延迟方面展示了相较于现有模型的显著速度优势。

定性结果

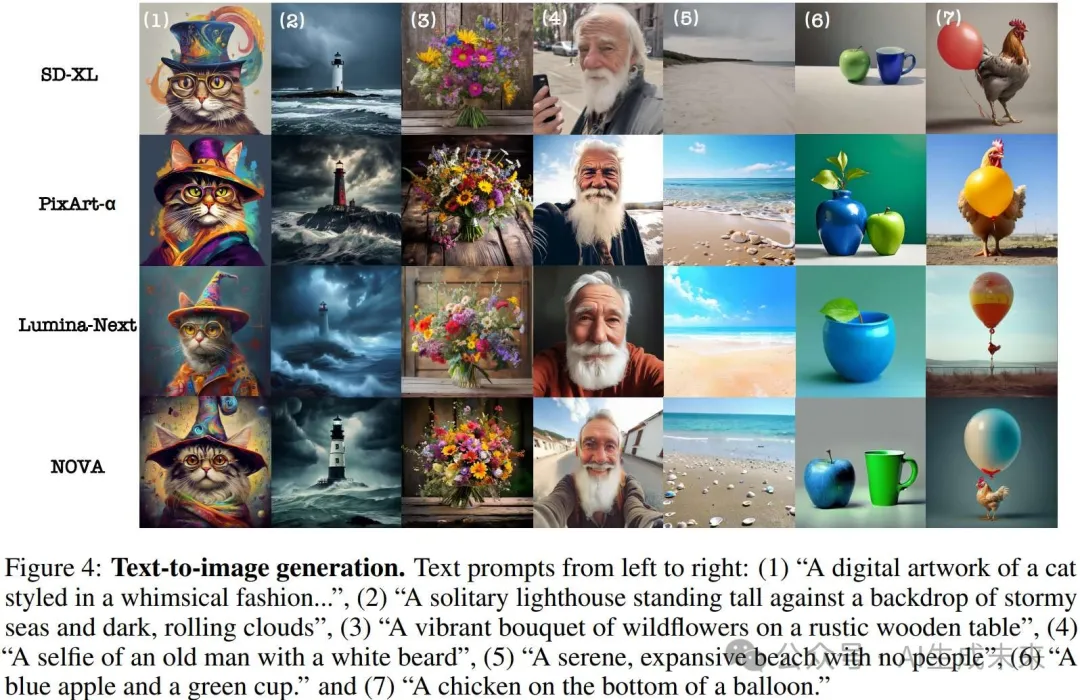

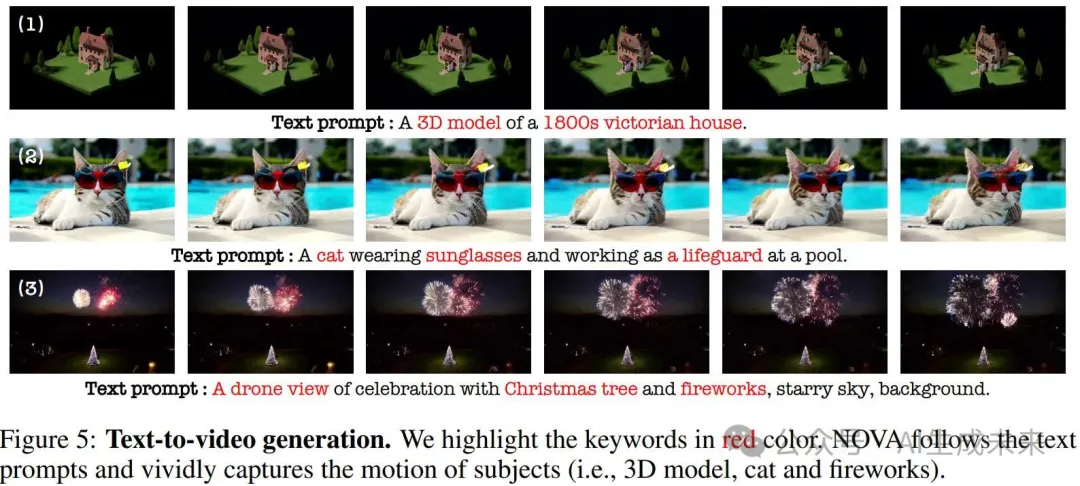

高保真图像和高流畅度视频

我们展示了当前领先图像生成方法的定性比较,如 图 4 所示。NOVA 在各种提示风格下表现出强大的视觉质量和保真度,尤其在颜色属性绑定和空间物体关系方面表现出色。在 图 5 中展示了文本到视频的可视化,突出展示了 NOVA 捕捉多视角、平滑物体运动以及稳定场景过渡的能力,这些都基于提供的文本提示。

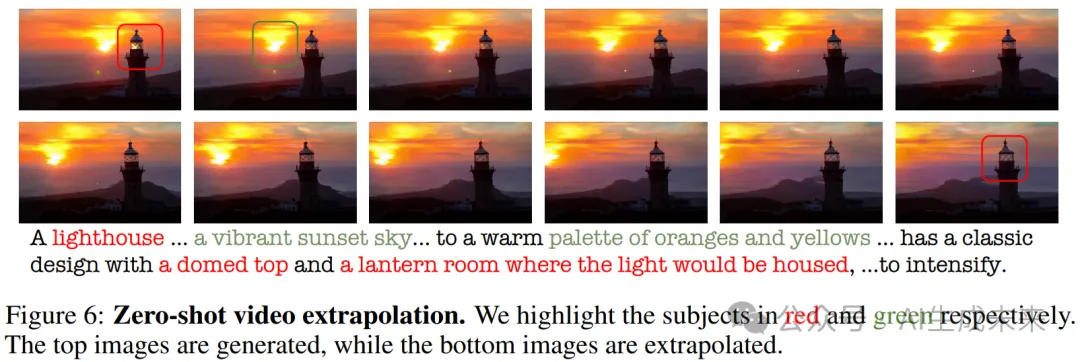

zero-shot 视频外推的泛化能力

通过预填充生成的帧,NOVA 能够生成超越训练长度的视频。例如,通过调整文本和 BOV 嵌入,我们生成了比原始视频长两倍的 5 秒视频,如 图 6 所示。在视频外推过程中,我们观察到 NOVA 始终保持帧间的时间一致性。例如,当提示描述一个穹顶和一个灯笼房间时,模型准确地展示了屋内的照明效果,并捕捉了日落过渡的细节。这进一步凸显了因果建模在长时间上下文视频生成任务中的优势。

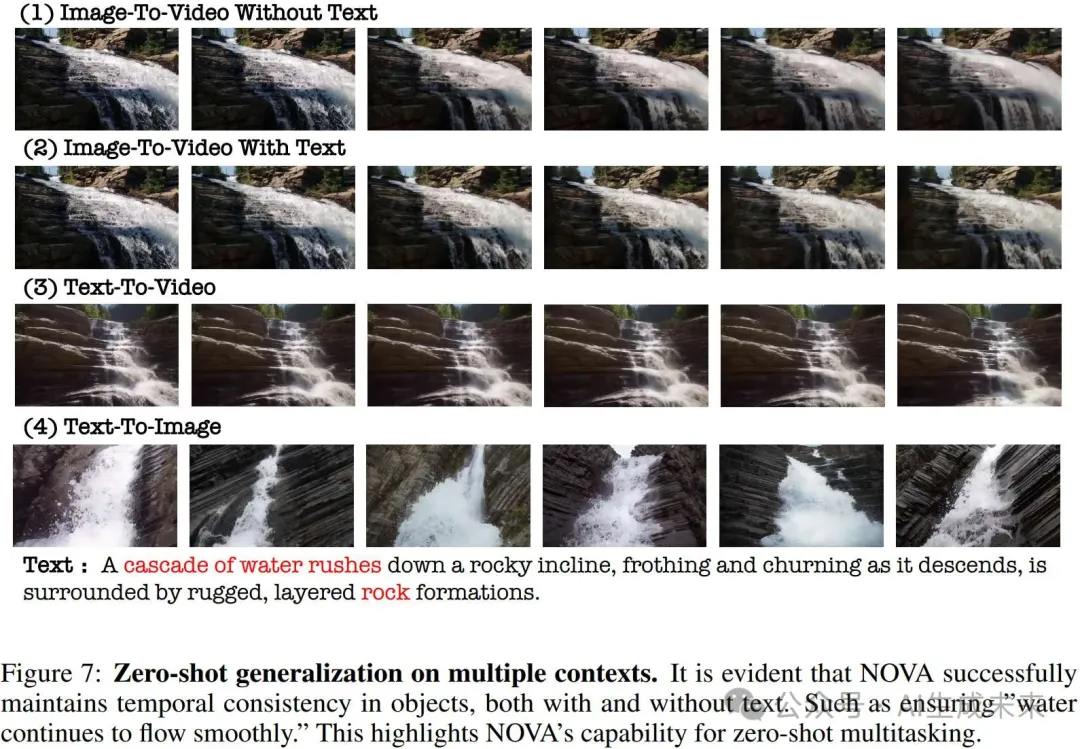

zero-shot 在多个上下文中的泛化能力

通过预填充参考图像,NOVA 能够生成图像到视频的转换,无论是否有文本提示。在 图 7 中,我们提供了一个定性示例,展示了 NOVA 在没有文本提示的情况下模拟现实运动的能力。此外,当文本提示被包含时,透视运动显得更加自然。这表明 NOVA 能够捕捉到基本的物理规律,如相互作用力和流体动力学。

消融实验

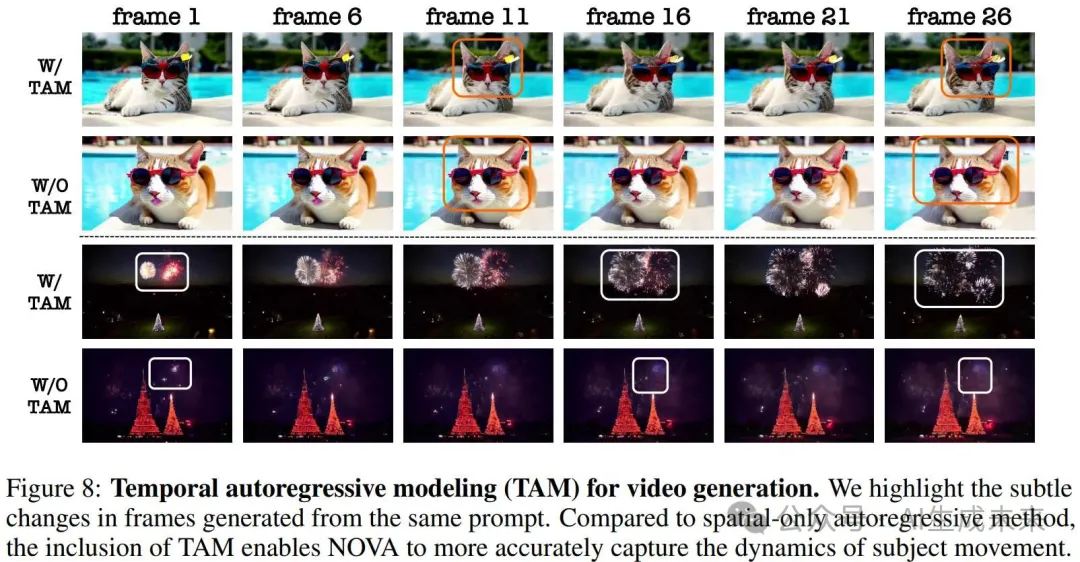

时序自回归建模的有效性

为了突出时序自回归建模的优势,我们让空间自回归来完成视频生成任务。具体来说,我们修改了时序层的注意力掩码,改为双向注意力,并使用按集合预测的方式随机预测整个视频序列。在相同的训练迭代下,我们观察到视频中的物体运动减少(如 图 8 所示)。此外,在跨多个上下文的zero-shot 泛化或视频外推中,网络输出出现了更多的伪影和时间一致性问题。此外,这种方法在推理时不兼容 kv-cache 加速,导致随着视频帧数的增加,延迟线性增长。这进一步证明了因果建模在视频生成中的优越性,优于多任务方法。

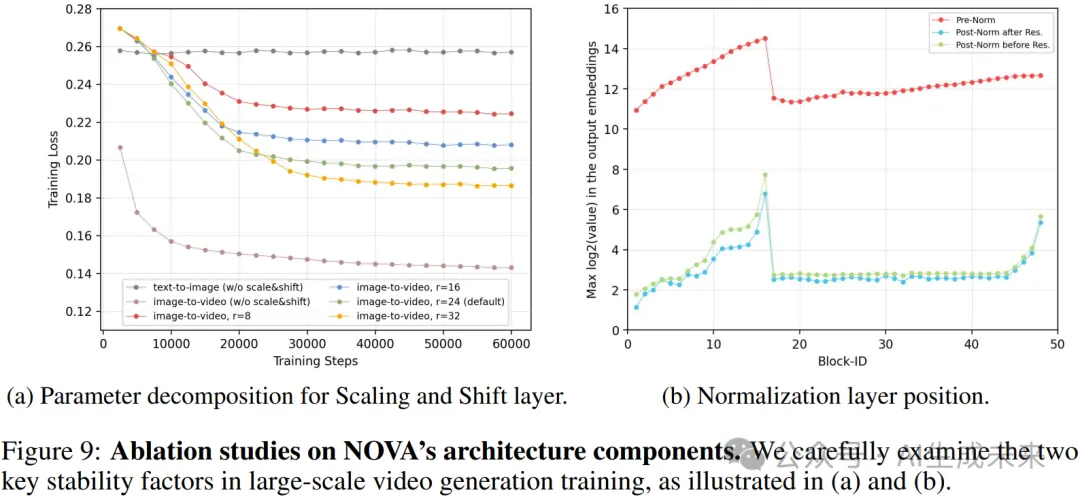

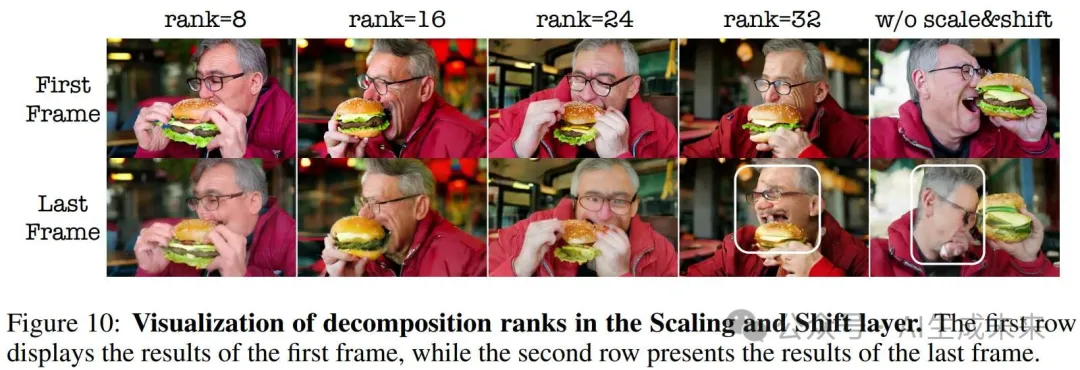

缩放和位移层的有效性

为了捕捉跨帧的运动变化,我们采用了一个简单但有效的缩放和位移层,显式地建模了来自 BOV 关注特征空间的相对分布。在 图 9(a) 中,我们展示了这种方法显著减少了文本到图像生成和图像到视频生成损失之间的漂移。当我们逐渐减小 MLP 的内部秩时,训练难度增加,导致网络进行更加全面和鲁棒的学习过程。然而,极低的秩值在运动建模方面会带来挑战,因为它们显著限制了该层的表示能力(如 图 10 所示)。在所有文本到视频的实验中,秩值默认为 24,从而实现了更准确的运动预测。

后归一化层的有效性

从零开始训练大规模的图像和视频生成模型通常面临着混合精度的重大挑战,这在其他视觉识别方法中也有类似表现。如 图 9(b) 所示,使用预归一化的训练过程会遭遇数值溢出和方差不稳定的问题。尝试了在残差分支上应用各种正则化技术,如随机深度和残差 dropout,但发现这些方法效果较差。受到 (Liu et al. (2022)) 的启发,引入了后归一化,并通过实验证明,后归一化能够有效地缓解输出嵌入的残差积累问题,相较于预归一化,它能带来更加稳定的训练过程。

结论

NOVA,一种新型的自回归模型,旨在同时实现文本到图像和文本到视频的生成。NOVA 在提供卓越的图像质量和视频流畅性的同时,显著减少了训练和推理的开销。关键设计包括时间帧逐帧预测、空间集逐集生成,以及跨各种上下文的连续空间自回归建模。大量实验证明,NOVA 在图像生成方面达到了接近商业质量,并在视频生成中展现出令人满意的保真度和流畅度。NOVA 为下一代视频生成和世界模型铺平了道路,提供了关于实时和无限视频生成的宝贵见解和可能性,超越了像 Sora 这样的扩散视频模型。作为第一步,我们将在未来的工作中继续进行更大规模的实验和数据扩展,探索 NOVA 的极限。

本文转自AI生成未来 ,作者:AI生成未来