字节跳动AI研究院发布FullStack Bench和SandboxFusion:用于评估真实编程场景中LLM的综合基准测试工具 原创

01、概述

近年来,随着大型语言模型(LLMs)的快速发展,代码智能化取得了前所未有的进步。从代码生成到调试再到测试,这些模型已经成为推动软件开发、数据科学和计算问题解决的重要工具。然而,尽管 LLMs 展现出了强大的能力,现有的评估体系却未能全面反映真实世界中的编程需求。今天,我们将聚焦字节跳动 Seed 和 M-A-P 团队推出的 FullStack Bench 和 SandboxFusion,探讨它们如何为代码智能的未来提供全新可能。

02、代码智能的瓶颈:评估体系的缺失

当前,主流的编程评估数据集(如 HumanEval、MBPP 和 DS-1000)多以特定领域为核心,关注点主要集中在高级算法或机器学习。这种“单一维度”的评估方式难以覆盖全栈编程所需的多样性。例如:

- 缺乏多语言支持:许多数据集对多语言能力的评估不到位,而现代编程环境往往涉及多种语言的混合使用。

- 缺乏全域覆盖:数据集多集中于某些“高端”领域,却忽视了桌面开发、数据分析和多媒体处理等日常需求。

- 问题规模有限:问题的多样性和数量不足以体现真实编程场景的复杂性。

这些缺陷直接限制了 LLM 的进一步发展,无法准确衡量其性能和潜力。

03、FullStack Bench:重新定义编程评估

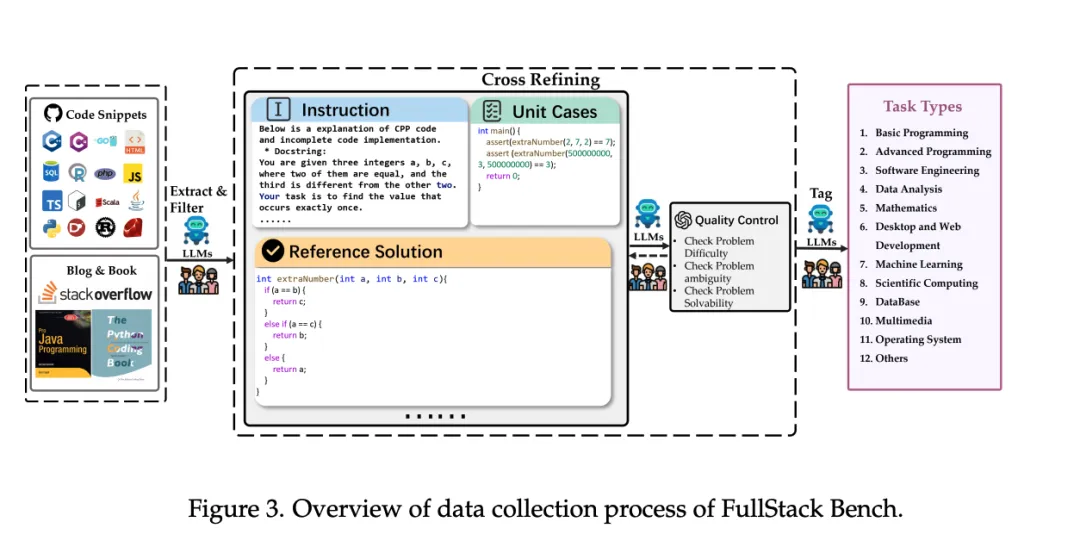

为了解决上述问题,ByteDance Seed 和 M-A-P 团队推出了 FullStack Bench,这是一个全新的编程评估基准,旨在全面衡量 LLM 的真实世界应用能力。

亮点一:多维覆盖,跨语言支持

FullStack Bench 涵盖了 11 个不同的应用领域,包括数据分析、桌面与网页开发、机器学习和多媒体等。它支持 16 种编程语言,真正实现了多语言和跨领域的全栈能力评估。

亮点二:丰富的问题库

数据集包含 3,374 个问题,每个问题均配有单元测试用例、参考解决方案以及难易程度分类(易、中、难)。

- 多样性设计:结合人类专家与 LLM 协作生成问题,确保了问题的广泛性和质量。

- 真实场景模拟:覆盖从基础编程到复杂算法的多种需求,适合不同类型的模型测试。

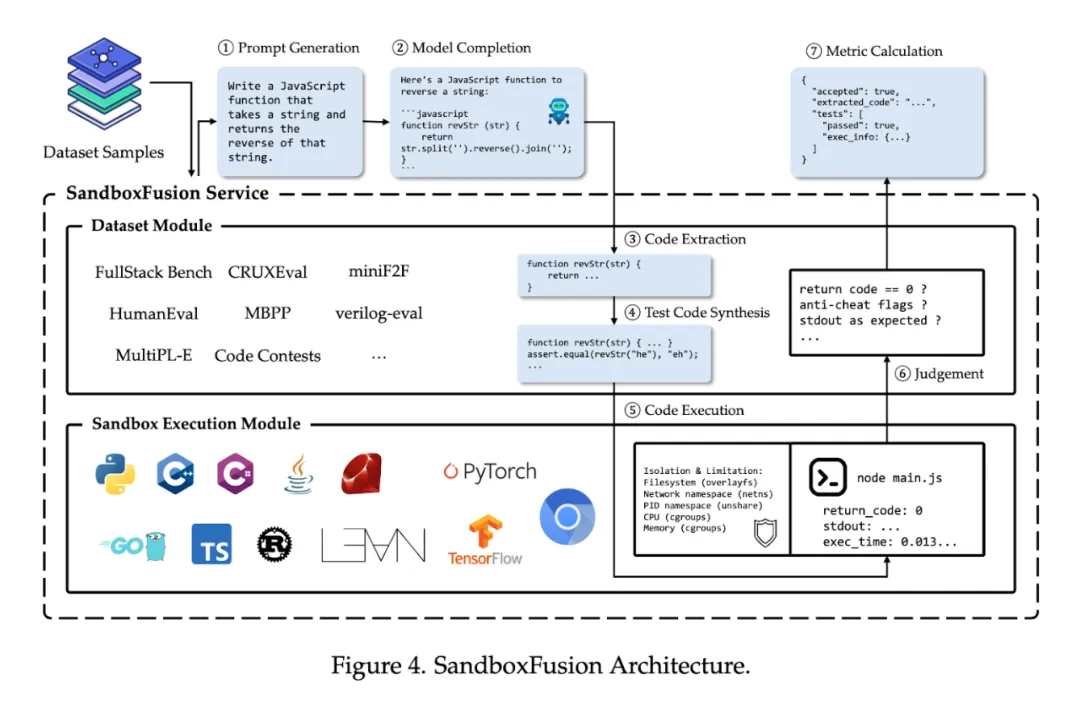

04、SandboxFusion:为多语言执行而生

FullStack Bench 的强大离不开其背后的执行环境 SandboxFusion。这是一个统一的代码执行平台,为多语言、多依赖场景提供了安全、隔离的运行环境。

关键特性:

- 广泛语言支持:SandboxFusion 支持 23 种编程语言,覆盖了主流开发语言的几乎所有需求。

- 扩展性与兼容性:除了 FullStack Bench,SandboxFusion 还可用于其他流行的基准测试(如 HumanEval 和 MBPP),显著提升了平台的通用性。

- 高效与稳定:在多语言依赖环境中,SandboxFusion 的运行效率远超现有执行环境,为复杂测试提供了更可靠的解决方案。

05、实验结果:揭示模型的潜力与挑战

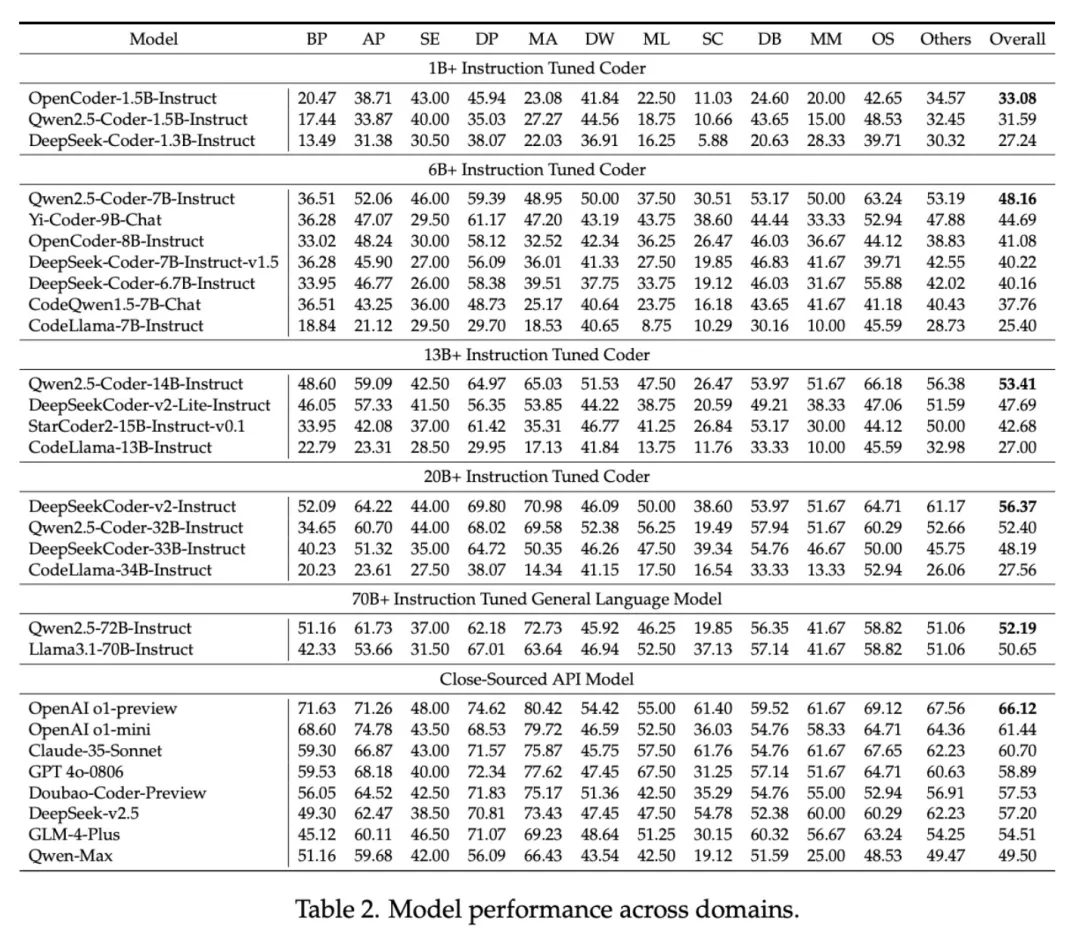

研究团队基于 FullStack Bench 对多种 LLM 进行了广泛测试,揭示了当前模型在性能上的多样性与局限性。

跨领域表现的差异

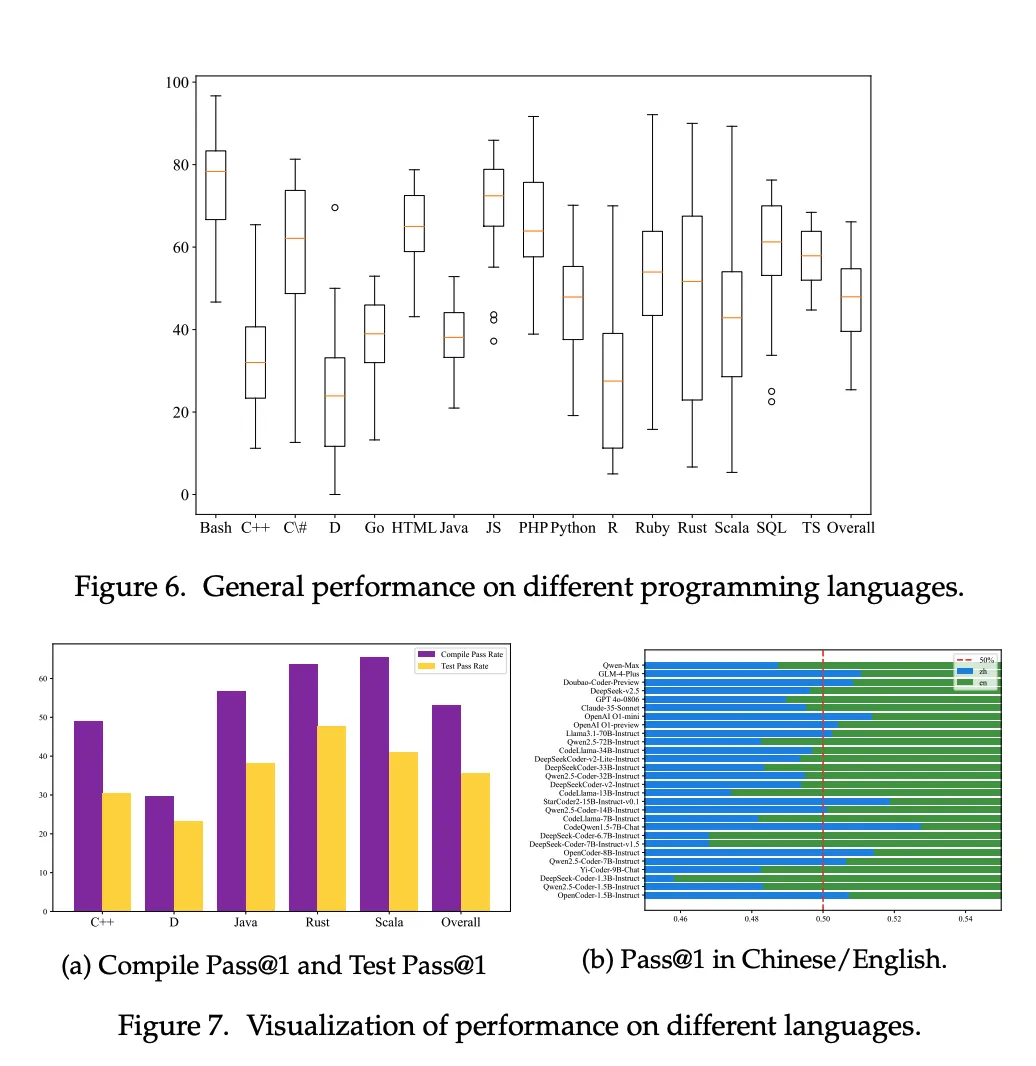

实验表明,不同模型在领域和语言上的表现差异显著:

- 强项:一些模型在基础编程和数据分析任务中表现优异。

- 弱项:但在多媒体处理和操作系统相关任务上表现乏力。

- 评估指标:主流的 Pass@1 指标(一次性通过率)显示了模型在处理复杂任务时的适应性挑战。

规模化的权衡:大小与性能的平衡

研究还分析了模型的扩展规律(Scaling Laws),发现:

- 参数规模与性能正相关:参数数量的增加通常能提升模型表现。

- 性能瓶颈:部分模型在超大规模(如 Qwen2.5-Coder 的 32B 和 72B 参数)下性能反而下降,这表明优化模型效率与规模之间的平衡至关重要。

06、实际意义:推动代码智能的未来

FullStack Bench 和 SandboxFusion 不仅填补了当前编程评估的空白,更为代码智能技术的发展提供了重要工具。

对开发者的启示

- 全栈评估的价值:FullStack Bench 帮助开发者识别模型在特定领域的强项与短板,为优化模型提供了数据支持。

- 多语言开发的支持:SandboxFusion 解决了多语言执行环境的技术难题,为开发复杂应用提供了便利。

对行业的推动

- 研究领域:提供了更全面的模型评估工具,推动代码智能技术的不断进步。

- 企业应用:在实际业务中,SandboxFusion 可支持复杂、多依赖的项目测试,提升生产效率。

07、结语

随着代码智能化的不断深入,准确评估 LLM 的能力已成为行业发展的关键。而 FullStack Bench 和 SandboxFusion 的推出,标志着这一领域迈向了一个全新的台阶。

它们不仅为模型的研究与开发提供了重要支持,也为未来复杂编程场景的智能化奠定了基础。无论你是开发者、研究者还是企业技术负责人,这一组合工具都将为你的工作带来深远影响。

参考:

- https://arxiv.org/abs/2412.00535

- https://huggingface.co/datasets/ByteDance/FullStackBench

- https://github.com/bytedance/SandboxFusion

本文转载自公众号Halo咯咯 作者:基咯咯