腾讯的混源视频模型HunyuanVideo:大视频生成模型训练的系统框架 原创

01、概述

随着人工智能技术的飞速发展,视频生成作为AI领域的重要突破,已经开始展现出令人惊艳的潜力。从图像到视频的生成,不仅要求算法具有强大的视觉理解能力,还要能准确捕捉动作和语义之间的微妙关系。而在这个领域,HunyuanVideo作为一款全新的开源视频生成大模型,以其卓越的表现和创新的技术架构,正逐步打破传统视频生成模型的局限,成为AI视频生成的领先者之一。

本文将深入探讨HunyuanVideo的核心技术、架构设计以及其如何在行业中掀起波澜。无论你是对AI技术感兴趣的开发者,还是热衷于视频创作的内容创作者,HunyuanVideo的创新性都值得你一探究竟。

02、什么是HunyuanVideo?

HunyuanVideo是一款由腾讯开发的、具有130亿参数的视频生成大模型。它的目标是通过强大的技术架构,提供与领先的闭源模型相媲美甚至超越的生成表现。

与大多数现有的视频生成模型不同,HunyuanVideo并不局限于单一的数据结构或技术。它采用了一个全面的框架,集成了数据整理、图像-视频联合训练和高效的基础设施,能够支持大规模模型训练和推理。这一创新设计使得HunyuanVideo在视频生成领域取得了显著突破,成为最大的开源视频生成模型之一。

03、HunyuanVideo的核心优势

1)高质量的视觉效果与运动表现

为了确保生成的视频拥有高质量的视觉效果、丰富的运动表现、精准的文本-视频对齐和生成稳定性,HunyuanVideo在架构设计上进行了大量的实验和优化。根据业内专业评估人员的反馈,HunyuanVideo在综合指标上超越了以往最先进的闭源视频生成模型,包括Runway Gen-3、Luma 1.6,以及三款中文社区表现最强的模型。

这种突破性的成果,正是HunyuanVideo通过深度优化架构和技术细节,努力消除生成视频过程中的噪声和不确定性所取得的。

2)打破数据壁垒,弥合开源与闭源模型的差距

传统的视频生成模型往往面临着闭源和开源之间的技术鸿沟。而HunyuanVideo的出现,正是希望通过开源的方式,将最前沿的视频生成技术带给更多开发者和研究人员。通过开源基础模型和应用模型的代码与权重,HunyuanVideo旨在弥合开源和闭源视频基础模型之间的差距,帮助社区中的每一位开发者都能自由探索并尝试自己的创意,推动视频生成生态的更加动态与活跃。

3) 强大的多模态信息融合能力

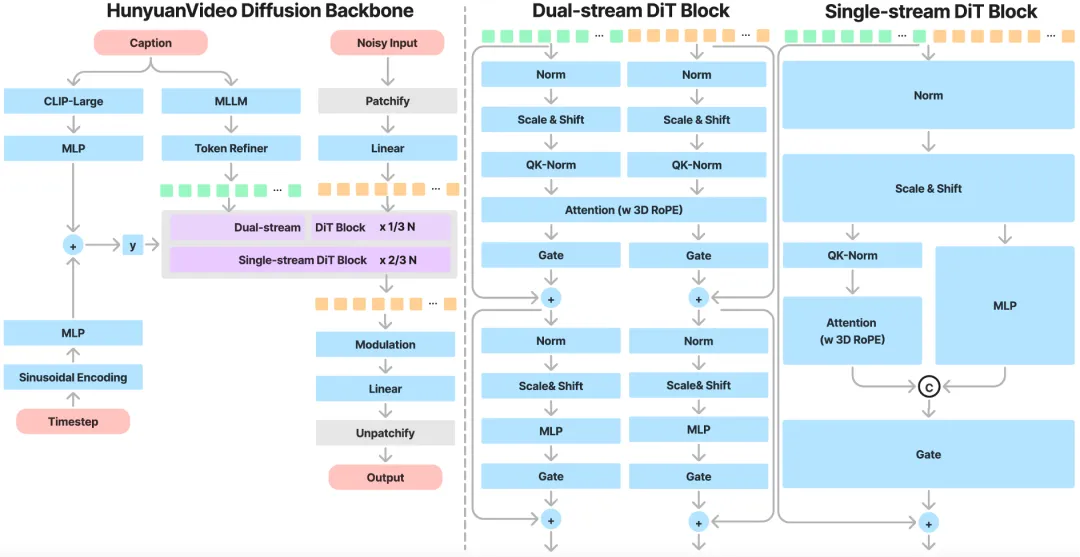

HunyuanVideo采用了一种独特的双流到单流混合模型设计。这种设计在视频生成过程中首先独立处理文本和视频的token(符号),避免了不同模态之间的干扰,让每个模态可以各自学习到最合适的调制机制;随后,它会将视频和文本的token连接在一起,通过后续的Transformer模块进行有效的信息融合,从而提升生成视频的质量。

这种架构能够有效捕捉视觉和语义信息之间的复杂交互,显著增强模型的整体性能,最终生成更符合用户需求的视频内容。

04、HunyuanVideo的架构设计

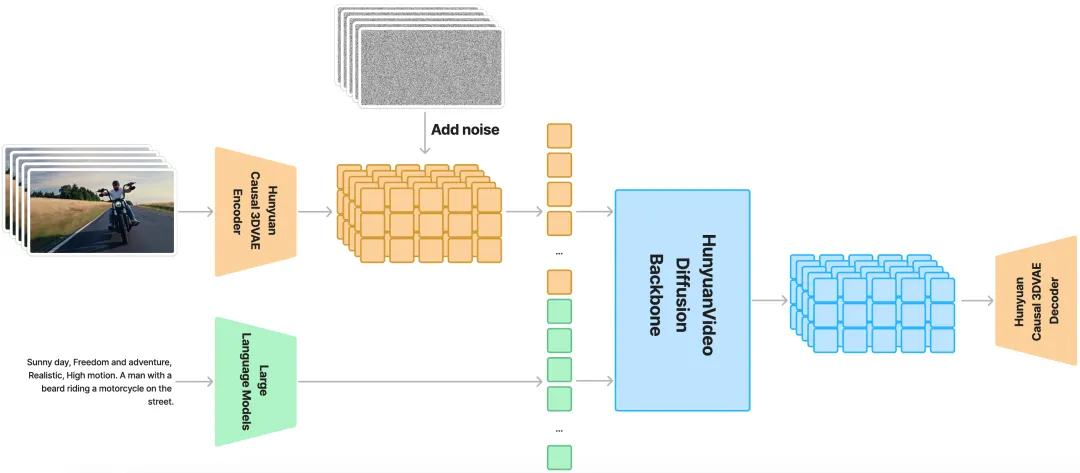

HunyuanVideo采用了一种基于隐空间模型的设计,其训练过程涉及到压缩视频的时间维度和空间维度。通过使用3D VAE(变分自编码器),HunyuanVideo能够有效地将时间和空间维度的特征压缩为更紧凑的表示。具体来说,时间维度压缩4倍,空间维度压缩8倍,最终将其转化为16个通道,从而显著减少了后续Transformer模型处理的token数量。

这种方法不仅提高了生成效率,还能够在不牺牲视频质量的情况下,保持较高的分辨率和帧率,使得视频生成变得更加灵活与高效。

MLLM文本编码器:更加精准的文本理解

在视频生成过程中,文本提示是至关重要的。为了确保HunyuanVideo能够准确理解文本指令并生成高质量的视频,HunyuanVideo采用了一个预训练的Multimodal Large Language Model(MLLM)作为文本编码器。

与传统的CLIP和T5-XXL相比,MLLM在图文对齐和复杂推理方面具有更强的优势。通过对大规模图文数据进行微调,MLLM能够在特征空间中实现更精准的图文对齐,从而使得生成的文本与视频内容更加契合。此外,MLLM还具备零样本生成能力,能够根据系统指令进行更为精准的文本特征提取,进而优化视频生成过程。

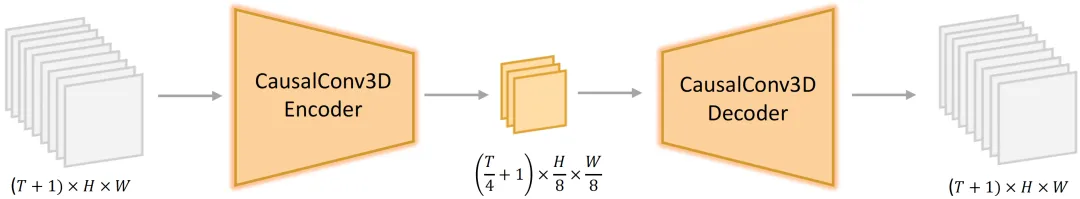

3D VAE:压缩空间,提升效率

HunyuanVideo采用的3D VAE不仅具备时间和空间压缩的优势,还在编码器和解码器中使用了CausalConv3D(因果卷积3D)技术,这一创新设计让视频的生成更加高效。通过4倍压缩时间维度和8倍压缩空间维度,HunyuanVideo在保持视频质量的同时,大大减少了计算量,为大规模视频生成提供了强有力的技术支持。

05、视频生成的创新:Prompt改写模型

为了帮助用户更好地与模型互动,HunyuanVideo还提供了一个独特的Prompt改写模型。该模型通过将用户输入的文本提示进行优化,确保模型能够更准确地理解用户的意图,生成更加符合要求的视频。

HunyuanVideo提供了正常模式和导演模式两种改写模式。正常模式旨在增强视频生成模型对用户指令的理解,而导演模式则专注于提升视频的视觉质量,包括构图、光照和摄像机的运动等方面。虽然导演模式能够生成更具视觉冲击力的视频,但有时也可能会牺牲一些语义细节,因此用户可以根据自己的需求进行选择。

06、HunyuanVideo的能力评估

为了验证HunyuanVideo的生成能力,我们与四个闭源视频生成模型进行了对比。在与其他模型的比较中,我们使用了1,533个文本提示,并通过单次推理生成了相同数量的视频样本。评估标准包括文本对齐、运动质量和视觉质量。结果表明,HunyuanVideo在综合指标上表现最为优秀,尤其在运动质量方面,表现优于其他所有对比模型。

07、结语

随着HunyuanVideo的开源发布,AI视频生成技术迎来了一个新的时代。它不仅为开发者提供了一个强大、灵活的创作平台,也为AI视频生成的未来奠定了基础。通过HunyuanVideo,我们有理由相信,在不久的将来,更多的创作者将能够借助AI技术,轻松生成高质量的视频内容,创造出更丰富、更生动的视觉世界。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯

原文链接:https://mp.weixin.qq.com/s/UaHVpYIuFyVC4cxvKHM21w