Nature: LLM变得越来越像大脑

哥伦比亚大学和范斯坦医学研究所学者最近研究了 LLM 与脑神经反应的相似性。

目的与发现

研究的目的是确定最新的 LLM 是否与人脑表现出相似之处,有可能提高对LLM和大脑的理解,尤其在理解和生成语言方面。

研究结果发表在《自然机器智能》上【文献1】,表明随着 LLM 越来越先进,不仅性能更高,也变得更像大脑。

研究方法

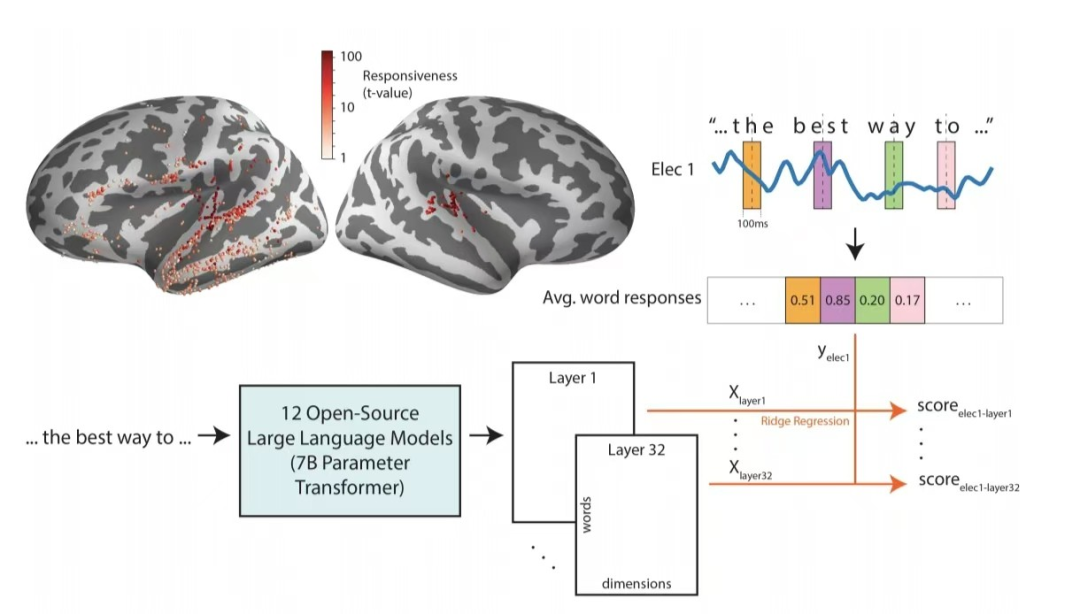

研究人员通过植入神经外科患者大脑的电极记录了他们在听语音时的脑神经反应。

并将同一语音的文本提供给 LLM 并提取其嵌入Embedding,嵌入本质上是 LLM 不同层编码和处理文本的内部表征。

随后,通过从单词嵌入来预测脑神经对单词的反应,这个词嵌入中预测大脑反应的能力,可用来估计LLM与大脑的相似性。

学者比较了具有几乎相同的架构和相似参数量的 12 种不同开源模型,探索每个 LLM 的哪些层与语言处理中涉及的大脑区域表现出最大的对应关系。

结论与含义

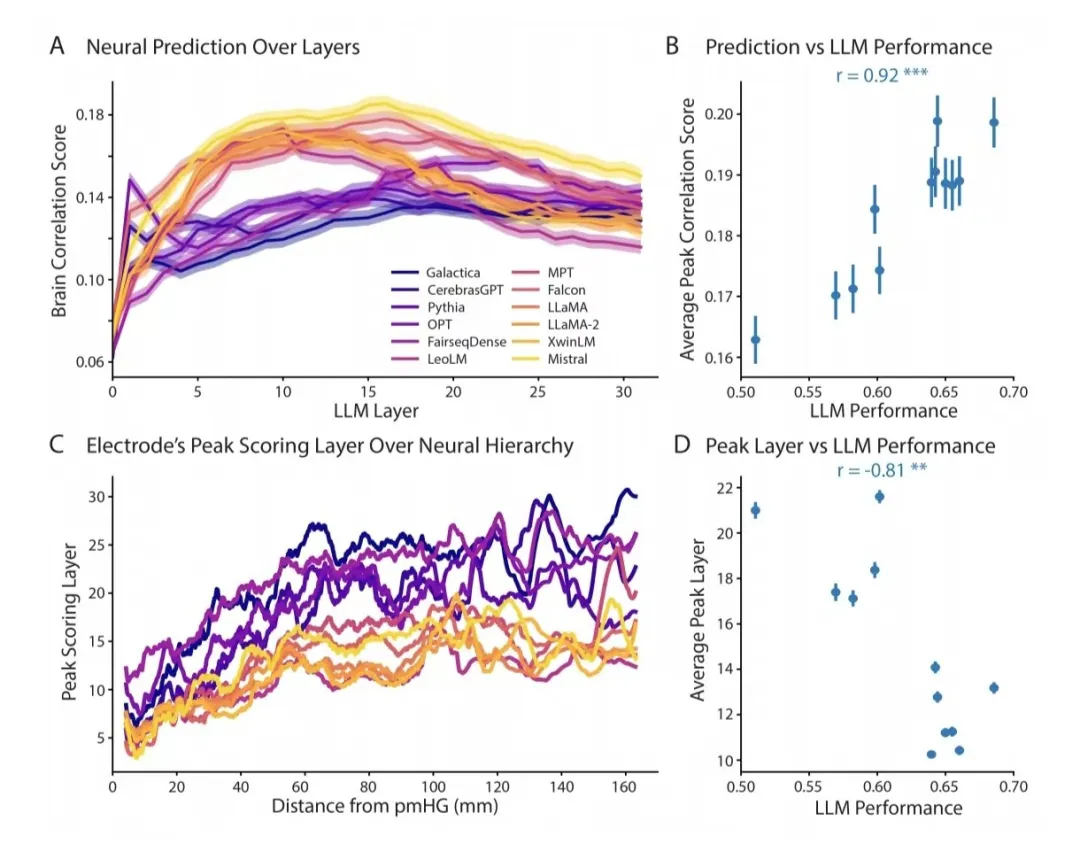

随着 LLM 变得越来越强大,其嵌入变得更加类似于大脑对语言的神经反应,与大脑层次结构的一致性也在增加。

意味着在语言处理过程中,在连续的大脑区域中提取的信息量和类型,与性能最高的 LLM 的连续层提取的信息比低性能的 LLM 更一致。

该发现具有多种含义,其一是 LLM 架构和训练的方法正引领LLM朝着与人脑相同的原则发展。

作者阐明“无论是因为一些基本原则是理解语言的最有效方法,还是仅仅出于偶然,似乎自然系统和人工系统在朝着相似的语言处理方法靠拢。”

大脑知觉原理

GPT4技术原理五:大模型的幻觉,解铃还须系铃人 笔者整理过 Friston的大脑知觉原理:

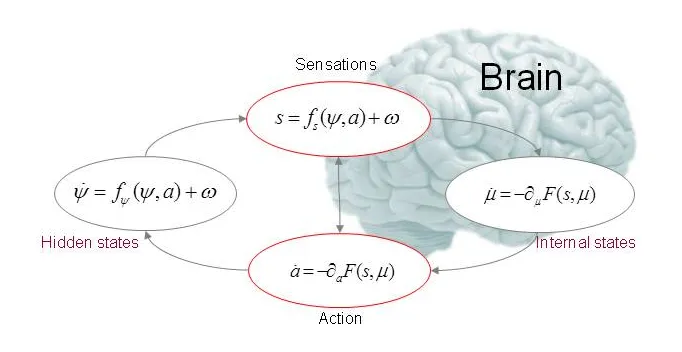

Friston假设大脑构建了一个世界模型,其中先验的“信念”用以指导概率推理:从大脑接收的感官输入中,推断出其外部原因。

将“先验”与新的感官输入相结合,产生感知,是大脑对内外部两个信息源的整合,并按其相对精度进行加权。其数学形式如下:

F(s,u) = - log(p(s|m)) + Dkl [ q(Φ|u) || p(Φ|s,m) ] ,式中,m 代表外部客观世界,u 是大脑内部建构的世界模型,s 是感官输入,Φ是m的参数,也是大脑需要推测的导致s 的原因,F 是这一感知过程的自由能。

这就是著名的贝叶斯大脑:

LLM认知框架

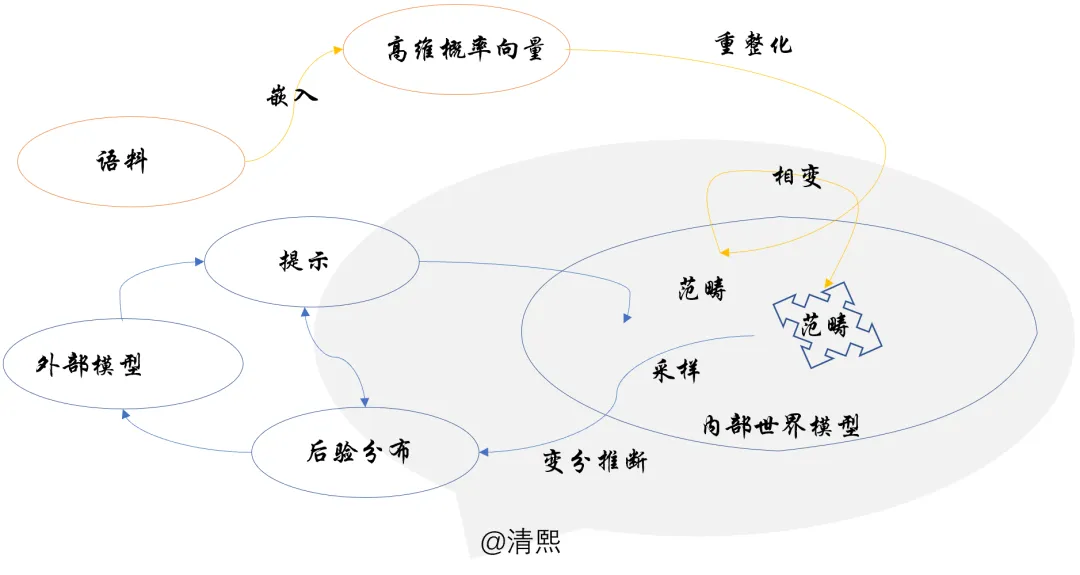

Friston的大脑知觉原理与笔者梳理出来LLM数理认知框架相辅相成:LLM通过重整化感知,范畴构成内部世界模型,变分推断做推理。

LLM认知框架十分接近Friston 的贝叶斯大脑,与学者们的研究结论“自然系统和人工系统在朝着相似的语言处理方法靠拢”亦吻合。

文献1:Contextual Feature Extraction Hierarchies Converge in Large Language Models and the Brain https://www.nature.com/articles/s42256-024-00925-4

预印本:https://arxiv.org/abs/2401.17671

代码:https://doi.org/10.24433/CO.0003780.v1

本文转载自 清熙,作者: 王庆法