模拟一切实现AGI?OpenAI Sora核心成员最新演讲+专访来了

通过什么方式够实现通用人工智能?

近期由AGI House组织的一场主题演讲给出了解答。

OpenAI Sora团队核心成员Tim Brooks和Bill Peebles对通用人工智能的实现分享了一些他们的看法,作为Sora研究负责人,他们表示:「视频生成技术将通过模拟一切来实现AGI」。

这不禁引发了网友们的惊叹:模拟一切!兄弟,我好怕……

也有网友对其所称的「模拟一切」进行调侃,认为AGI是不可能实现的。

从Sora发布以来,就吸引了众多人的关注,其功能的强大也让人叹为观止,同时对其所存在的问题也成为人们热议的焦点。

两位负责人以一分钟的高清视频作为开场,从宏观角度对Sora的功能、如何开辟内容创作的新机遇、背后的技术原理进行介绍,以及它为实现真正的通用人工智能(AGI)目标迈出的重要一步。

Sora的功能

Tim表示,这段视频对他们来说意义非凡,因为它实现了他们的一个重要目标:创造出1080p高清、时长一分钟的视频内容。

Sora研究团队一直在探寻,怎样才能在视频生成方面实现真正的飞跃?

这个视频做到了这一点!它展示了极高的复杂度,比如精细的反射和阴影效果。

一个特别值得一提的细节是视频中蓝色的标志牌,当视频中的人物经过它时,标志牌仍旧清晰可见。

这在视频生成中是一个极大的挑战,因为涉及到如何在较长时间内保持物体的持久性和一致性。

此外,他们还能创造出多种不同风格的视频内容,比如充满想象力的纸艺世界。

Sora能够深入学习并理解整个三维空间。比如,当摄像机在三维空间中移动并捕捉人物动作时,能够精确把握世界的几何结构和物理复杂性。

由此可见,Sora不仅能够生成各种内容,它还从视频训练中学习到了大量关于物理世界的知识。

开辟内容创作的新机遇

正如Tim所提到的,我们对Sora为对象创造带来革命性的机遇充满期待。

不仅因为它是实现通用人工智能(AGI)的关键一步,也因为它在短期内将为内容创作带来突破。

Bill Peebles以一个宇航员冒险的电影预告片为例,表示视频制作中最困难的部分是让素材与视频整体协调。

这个例子的特别之处在于,视频中的宇航员在Sora生成的多个镜头中都能够出现。

也就是说,我们不必拍摄大量的花絮片段,最后创建一个合成镜头。

Sora决定了它想要将镜头转向何处,同时,它会把同一个宇航员放在许多不同的环境中。

因此,他们认为这项技术在之后特效制作上或许将带来巨大的变革。

另一个示例展示了一个外星人自然融入纽约市的情景,采用35mm胶片效果,展示了充满派拉蒙惊悚片风格。

这项技术已经展示出Sora能够创造出令人惊叹的奇幻效果,而这些效果如果使用传统的CGI技术,成本将会非常高昂。

因此,在短期内这项技术所带来的影响是深远的。

当然,还可以利用Sora制作其他类型的效果。

比如充满科幻氛围的场景:一位潜水员发现了一个隐藏的、充满机械化海洋生物和高级外星技术的未来式船舶残骸。

此外,互联网上有很多创意无限的人们,他们可能没有Sora这样的工具来实现他们的创意。

想象一下,如果这些人能将他们的创意通过Sora进行实现,他们将创造出多么绚烂的作品!

Sora的酷炫之处在于,可以实现传统好莱坞设施难以实现的拍摄场景,比如同时充当珠宝店和动物园的店铺,展示了带有亮丽的珠宝装饰的剑齿虎和乌龟等动物。

这种镜头十分逼真,但现实中的动物很难出现在这样的场景中,因此就不得不利用CGI。

Sora让这些场景的制作变得非常简单,只需一小时就能完成。

Sora与艺术家的合作

Tim Brooks表示,他们近期新推出了一个用于研究的平台,该平台目前仅向少数艺术家开放使用权限,处于早期阶段,不是面向大众的产品。

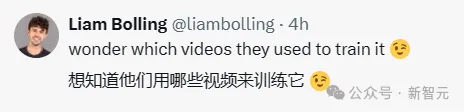

该平台致力于生成逼真和超现实的内容,并与小规模的红队、艺术家和潜在用户合作,以确保技术的安全性。

其中,艺术家Shy Kids表达了对该技术的兴奋之情,认为其不仅能生成逼真的内容,还能创造全新的超现实作品。

他们期待人们对全新媒体和娱乐形式的兴趣,这些将由Sora和未来版本的视频生成技术实现。

同时Tim Brooks也提到了一些艺术家使用Sora创作的作品,以及他们在博客文章中分享的相关内容和思考。

他们希望这项技术能推动内容创作的大众化,让更多有创意的人能够实现他们的想法并分享给大家。

Sora背后的技术原理

Tim Brooks对Sora背后的技术原理进行了简要介绍,讨了语言模型和视觉模型的相似之处以及其在不断发展中的潜力。

他认为语言模型之所以如此成功,是因为它们具有扩展的能力,并引用了《苦涩的教训》中的观点,

长远来看,那些随着规模增长而性能提升的方法,随着计算能力的增加将最终胜出。

语言模型之所以能够如此成功,部分原因在于它们采取了所有形式的文本,包括数学、代码等,并将其转化为通用的 Token 范围,然后利用 Transformer 模型对其进行训练,从而形成了通用模型。

他们想对视觉数据做同样的事,这也正是他们使用Sora做的事情。

他们将不同类型的视觉数据转化为小块,类似于空间时间中的小立方体,并通过Transformer模型进行训练,以实现模型的可扩展性。

通过在多种纵横比上训练,他们实现了多样化的创作方式,并展示了模型在生成视频、实现零样本学习、实现视频之间过渡等方面的能力。

他们认为,类似于语言模型,这些视频模型也将为人们带来许多令人惊叹的创意效果,并且对于这些可能性的探索才刚刚开始。

Sora实现真正AGI意义重大

文本生成视频模型,如Sora所展示的复杂场景生成能力,逐渐显现出对人类互动和身体接触的详细理解,这是通用人工智能的重要一步。

Bill Peebles指出,要生成真实逼真的视频,需要一个内部模型理解所有物体、人类等环境如何运作。

因此,他们认为Sora将为通用人工智能的发展做出贡献。

此外,他们特别强调了模型的扩展性。

通过创建基于Transformer的框架,并对不同的Sora模型进行比较,他们展示了模型训练中计算量增加对性能提升的影响。

从基础模型到增加了32倍计算量的模型,可以看到对场景和物体的理解逐步提升。

接着,他们分享了Sora在动物模拟、3D一致性以及视频中物体持久性方面的成功之处。

他们认为,Sora不仅能处理短期内的互动,还能实现永久性的改变。

虽然目前Sora在这方面的能力还相对较弱,它并不能每次都实现,但还是有许多的成功例子。

Bill Peebles还强调,Sora模型对于物理规律的自我理解,使其能够模拟多种世界,如Minecraft等,这表明Sora在模拟现实世界的同时,也具备模拟其他虚拟世界的潜力。

最后,他们认为Sora能够涵盖所有世界的知识,实现通用人工智能的目标。

他们憧憬着有朝一日,能够在文本生成视频模型上运行像ChatGPT这样的语言模型,为人工智能的发展开辟更广阔的前景。

失败案例

但Sora在一些案例中的失败也表明其在处理物理互动方面仍存在挑战。

举例来说,Sora在处理我们认为非常相似的物理互动方面仍然有很大的困难,比如被附身的椅子不被认为是一个物体。甚至更简单的物理行为,比如打破一个玻璃杯。

未来,在理解基础事物方面它还有很长的路要走。

尽管存在挑战,可以看出他们对这个技术的未来充满期待。

他们将其视为视频版的GPT-1,并相信这项技术将在短期内取得巨大进步。

尽管有一些失败案例,但已经出现了一些积极迹象和吸引人的特性。

他们对此感到非常兴奋,并期待看到人们在这一技术基础上所创造的惊人作品,以及全球对其的反应。

不知大家对此有怎样的看法?

最后问答环节

在演讲的最后,Sora两位研究负责人也对大家所关注的问题进行了回应并主要回答了以下问题。

Q1:在关于理解AI智能体或让其在场景中相互作用的问题上,是否已经确切地定义了这一部分信息呢?或者说,这只涉及像素级的处理,然后需要进一步操作?现在,是否可以将这部分信息复制到这里了呢?

Tim Brooks:

在Sora内部,所有这些都是隐式进行的。当我们看到Minecraft的样本时,并没有明确的概念来描述它模拟了玩家的何种行为,或者如何在环境中展现出动作。

如果要精确描述正在发生的事情,或以某种方式解读它,就需要建立一些额外的系统来从Sora当前的基础上提取那些信息。

现在,一切都是隐含的。比如说,3D的概念是隐含的,你所见到的所有内容都是隐含的。在其中没有任何明确的参与者。

Q2:你能谈谈微调的可能性吗?你如何看待将这些插件或功能整合到整个过程中?

Tim Brooks:

艺术家们希望在创作过程中拥有更多的控制权,包括能够使用他们自己设计的角色。

我们正在积极考虑如何实现这一点。可以通过对模型进行微调,使其适应特定的数据集或内容。

目前,我们正在收集反馈并探索实现这个目标的可能性。

Q3:在语言Transformer中,预测是按顺序进行的。而在视觉Transformer中,我们按照扫描线的顺序或者其他方式进行预测,可能会像蛇一样或者以空间结构的方式。这是否是视觉Transformer的基本限制?预测的顺序是否影响了对空间结构的关注?

Tim Brooks:

在这种情况下,我们使用的是扩散模型,而不是像语言模型那样的自回归Transformer。

我们对生成的视频进行降噪,从一个完全充斥噪声的视频开始,通过迭代运行模型逐步去除噪声。

通常情况下,我们是同时对整个视频进行去噪处理,而不是按照扫描线的顺序。我们也提到了另一种方法,即先生成一个较短的视频,然后根据需要进行延长。

Q4:你们生成视频的帧率是每秒30帧吗?或者,你们更倾向于对帧持续时间进行插值处理?我知道,所有核心处理的速度都远不及动画渲染的速度。

Tim Brooks:

我们是以30帧每秒的速度生成的。

Q5:你们尝试过进行汽车碰撞或旋转等动作,来测试图像生成是否能够符合物理模型或基础动作类型吗?

Bill Peebles:

我们尝试了几个例子,旋转效果基本还算合理,但并不完美。

关于汽车照明的样本,我认为Sora还没能完全掌握牛顿的三个运动定律。

Q6:你们现在正试图解决哪些用户反馈的Sora存在的问题?

Tim Brooks:

我们目前主要关注与外部艺术家和红队成员的互动反馈。

艺术家希望有更多控制权,包括相机和路径控制。

对安全问题的关注主要涉及负责任和安全性,以防止滥用和假信息传播,这些都是我们需要考虑的。

Q7:是否可能制作用户可以互动的视频,例如通过VR设备?如果我在播放视频时中途停止并进行编辑,视频是否能够响应这些更改?

Bill Peebles:

目前,Sora的运行速度还比较慢,主要是因为存在一些延迟。

通常情况下,生成视频所需的时间取决于参数设置,比如持续时间和分辨率。但要制作出你描述的那种互动体验,至少需要几分钟。

所以,我们离这个目标还有一段路要走,但我认为这个想法很棒。

Q8:在构建这个第一版时有什么明确的目标吗?你在过程中遇到了哪些问题,从中学到了什么经验?

Tim Brooks:

我们的主要目标始终是在至少30秒内生成1080p的高质量视频,这是我们从项目早期就确定的。

我们意识到视频生成一直被限制在短暂的几秒,因此这一点成为整个项目的重中之重。

在这一过程中,我们发现处理视频数据的挑战之大。这需要进行大量详细而枯燥的工程工作,以确保系统能够正常运行。

尽管我们预料到了这一点,但确实花费了相当多的时间和精力。

Q9:还有其他的发现吗?

Tim Brooks:

我们一直致力于保持方法的简单性,尽管有时候实际情况比说起来更具挑战性。

我们的主要关注点是做出尽可能简单的事情,然后在此基础上进行大规模的扩展。

Q10:发布视频时,你会优化提示词并评估视频效果吗?

Tim Brooks:

评估视频确实有挑战,我们采用多种方式。

首先是模型的损失值,低损失值与模型的优良性能相关。

另一种方法是使用图像指标评估单帧质量。我们也花费大量的时间生成样本并自行检查,尽管这需要处理大量样本以避免噪声。

Q11:关于训练数据,你认为我们需要多少才能实现通用人工智能?你觉得互联网上的数据是否足够?

Bill Peebles:

我认为我们有充足的数据来实现通用人工智能。

我也相信人们会找到新的方法来改进事物。

当我们遇到困难时,我们总会找到新的方法来提高效果。

所以,不论我们手头有什么数据,都足以实现通用人工智能。

本文转自 新智元 ,作者:新智元