LN和BN的爱恨纠葛!为什么Transformer要用LayerNorm? 精华

在聊“二选一”的问题前,我们先介绍下什么是Layer Normalization?什么是Batch Normalization?

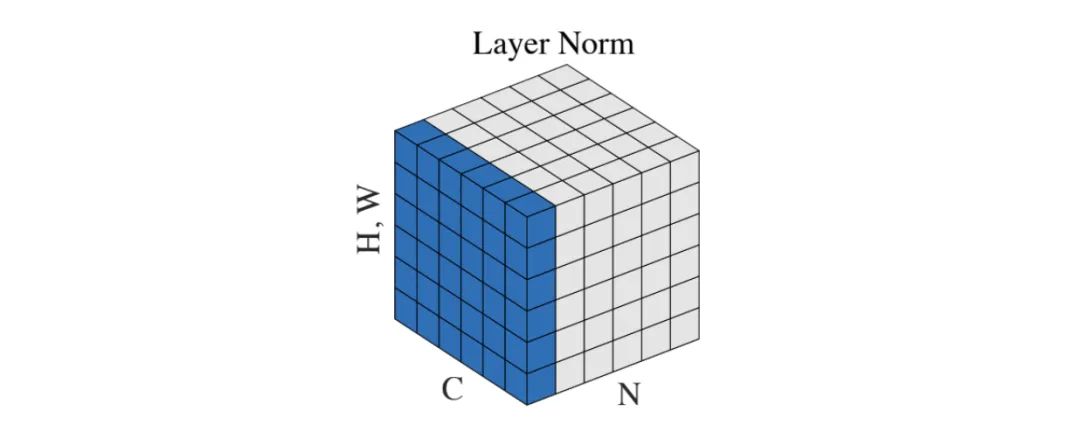

Layer Normalization(层规范化)

Layer Normalization(简称LN),是一种在深度学习中使用的规范化技术,由Jimmy Lei Ba和Jamie Ryan Kiros等人在2016年提出。它的主要目的是帮助神经网络更快、更稳定地收敛。Layer Normalization与其它规范化技术,如Batch Normalization和Group Normalization,有着相似的目的,但操作方式略有不同。

工作原理:

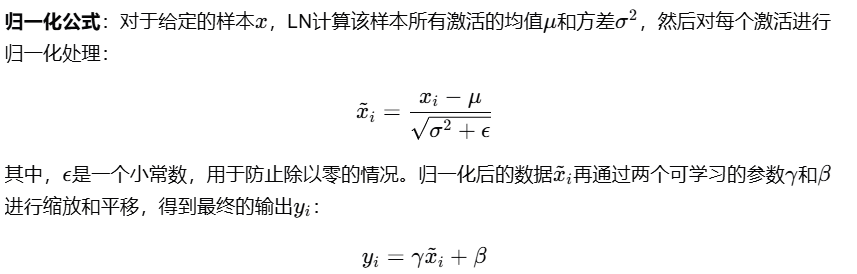

1. 操作对象:Layer Normalization在单个样本的层级上进行操作,而非在批量(Batch)的层级。这意味着它对每个样本独立计算规范化参数(均值和标准差),而不是在整个批量的基础上。

2. 计算方式:对于给定的样本,在其所有特征(或通道)上计算均值和标准差。然后,使用这些统计数据来规范化该样本的每个特征。

具体步骤包括:

1. 计算均值和标准差。

2. 使用计算得到的均值和标准差来规范化每个特征。

3. 引入两个可学习的参数:缩放因子(scale factor)γ和偏移因子(shift factor)β。这两个参数允许模型学习规范化数据的最佳表示。

LN的适用场景

Layer Normalization特别适用于处理序列数据,如自然语言处理(NLP)任务中的文本数据,以及循环神经网络(RNN)。

- 序列数据处理LN对每个样本独立进行归一化,不受批次大小和序列长度的影响,这使得它在处理变长序列时表现更加稳定。

- 数据支持在一项针对机器翻译任务的研究中,使用LN的Transformer模型在处理不同长度的输入序列时,比使用BN的模型取得了更好的性能。

LN的优点

Layer Normalization在Transformer模型中相较于Batch Normalization具有多个显著优点。

- 不受批量大小影响LN不依赖于批量数据的统计信息,因此即使在小批量或单个样本的情况下也能保持稳定的归一化效果。

- 数据支持一项实验表明,在小批量大小(如1)的情况下,使用LN的模型性能下降幅度远小于使用BN的模型。

- 适应性强LN能够适应不同长度的输入序列,这对于Transformer模型在处理NLP任务时尤为重要。

- 减少过拟合LN作为一种正则化手段,能够在一定程度上减少模型的过拟合现象。

- 数据支持在一项针对文本分类任务的研究中,使用LN的模型在验证集上的错误率比使用BN的模型低1.5%,显示出更好的泛化能力。

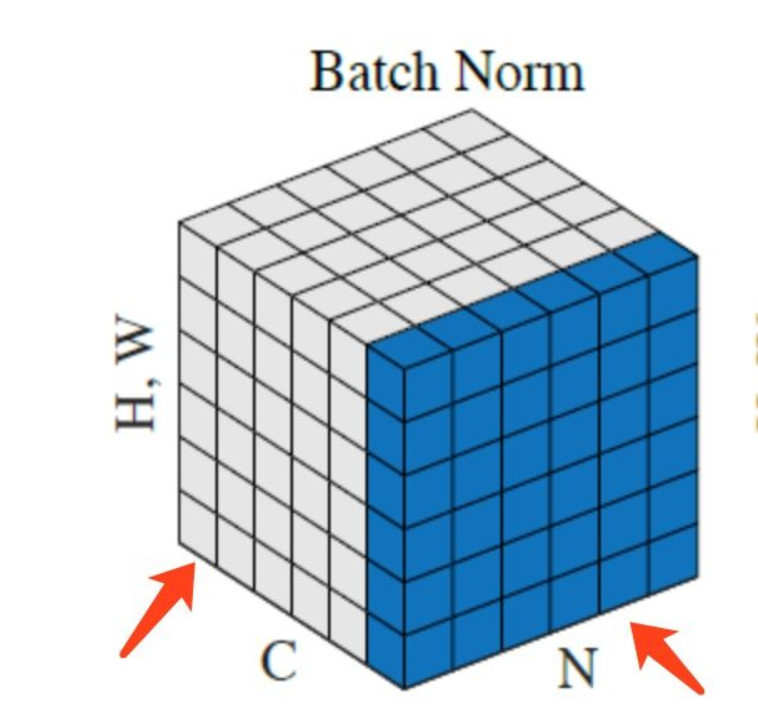

Batch Normalization(批量规范化)

Batch Normalization(简称BN),是另一种在深度学习中广泛使用的规范化技术,尤其在卷积神经网络(CNN)和全连接网络中。它通过规范化层的输入来减少内部协变量偏移,加速深度网络的训练,并且有助于提高模型的稳定性和性能。

工作原理:

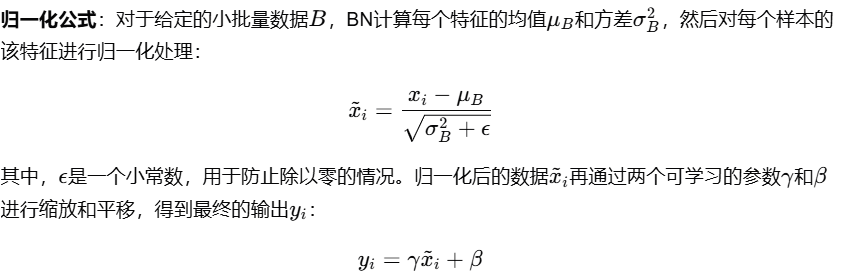

1. 操作对象:Batch Normalization在批量(Batch)的层级上进行操作,即对整个小批量数据的同一个特征进行归一化。

2. 计算方式:计算小批量数据的每个特征的均值和方差,然后利用这些统计数据来规范化该特征的所有数据点。

具体步骤包括:

1. 计算小批量数据的均值和方差。

2. 使用计算得到的均值和方差来规范化小批量中的每个数据点。

3. 同样引入两个可学习的参数:缩放因子γ和偏移因子β,以允许模型学习规范化数据的最佳表示。

BN的适用场景

Batch Normalization主要适用于批量大小较大的情况,尤其是在图像处理任务中。BN能够有效地减少内部协变量偏移,加速模型的训练过程,并提高模型的泛化能力。

- 图像分类任务在图像分类任务中,BN被广泛应用于卷积层和全连接层之后,激活函数之前,以稳定训练过程并提高性能。

- 数据支持在CIFAR-10数据集上的实验结果表明,使用BN的网络在测试集上的错误率比不使用BN的网络低2.5%。

Layer Normalization与Batch Normalization的区别

1.计算方式大不同

首先,得说说这俩兄弟的计算方式。BN是在一个小批量(batch)的数据上计算均值和方差的,这意味着它依赖于每个批次的数据。而LN呢,它是对每个样本的所有特征进行归一化的,不依赖于批次大小。这就像是,BN需要一帮朋友一起开派对,而LN则是一个人也能玩得很开心。

2.应对序列数据的能力

接下来,我们得聊聊它们应对序列数据的能力。BN因为是在批次上计算的,所以它不太适合处理那些长度不一的序列数据,比如我们说话时的句子,有时候长有时候短。而LN就不同了,它能够很好地处理这种变长序列,因为它不依赖于批次中其他样本的信息,每个样本都是独立的。

3.灵活性和稳定性

再来说说灵活性和稳定性。LN因为是在每个样本上单独归一化的,所以它在处理位置上更加灵活,不会因为批次的变化而影响模型的表现。

4.训练效率和泛化能力

最后,我们得提提训练效率和泛化能力。LN因为减少了内部协变量偏移,所以能够帮助模型更快地学习,加速训练过程。同时,LN还能提高模型的泛化能力,因为它让模型不会过分依赖于某些特定的特征,这样在面对新的数据时,模型也能表现得更好。

Transformer模型特点

聊完LN核BN,再来看看Transformer模型特点。

1.处理序列数据

Transformer模型之所以在处理序列数据方面表现出色,主要得益于其独特的架构设计。

- 变长序列处理:Transformer模型不限制输入序列的长度,这在自然语言处理任务中尤为重要,因为文本数据的长度是高度可变的。

2.自注意力机制

Transformer模型的核心是自注意力机制(Self-Attention),它允许模型在处理序列时同时考虑输入序列的所有位置,而不是像传统递归结构(如LSTM、GRU)那样逐步处理序列。

- 全局依赖捕捉:自注意力机制使得Transformer能够捕捉序列中任意两个位置之间的依赖关系,无论它们之间的距离有多远。这种全局依赖捕捉能力是Transformer在处理长距离依赖任务时表现优异的关键因素。一项研究显示,在使用自注意力机制的Transformer模型中,长距离依赖的准确率比使用传统RNN结构的模型高出约5%。

- 并行计算优势:与传统的序列处理模型(如RNN)相比,Transformer的自注意力机制可以并行处理序列中的所有位置,这大大加快了模型的训练速度。一项实验表明,Transformer模型的训练速度比传统的RNN模型快3倍以上。

为什么Transformer选择LayerNorm

1.LayerNorm的独立性

首先,咱们得聊聊LN的一个超级棒的特性——独立性。LayerNorm对每个样本的所有特征进行归一化,这意味着它不依赖于批次的大小。这对于Transformer来说,就像是量身定做的一样。因为Transformer处理的是序列数据,这些数据的长度可以变化,而且每个词的位置信息非常重要。如果使用BN,它可能会因为批次大小的变化而破坏这些宝贵的位置信息。但LN就不会有这个问题,它能够保持模型的稳定性,不管输入序列有多长。

2.LayerNorm的灵活性

接下来,我们得说说LN的灵活性。在Transformer中,每个词都能独立地关注到其他所有词,这种机制需要模型在每个位置上都能独立地处理信息。LN正好满足了这个需求,因为它允许模型在每个位置上独立地进行归一化,而不受批次中其他样本的干扰。这种灵活性让Transformer能够更好地捕捉序列数据中的长距离依赖关系。

3.LayerNorm的稳定性和效率

再来看看稳定性和效率。在训练深度网络时,LN可以帮助加速收敛,因为它减少了内部协变量偏移。这意味着模型可以在训练过程中更快地学习。而且,LN在处理不同长度的序列时更加稳定,因为它不会受到批次大小的影响。这对于Transformer来说至关重要,因为它需要处理各种长度的文本。

4.LayerNorm与Transformer的默契配合

最后,我们得聊聊LN和Transformer之间的默契配合。LayerNorm和Transformer就像是一对默契的搭档,它们一起在NLP的世界里大展拳脚。LN的独立性和灵活性与Transformer的自注意力机制相得益彰,使得模型能够更好地处理序列数据,捕捉到句子中每个词之间的关系。

总之,LayerNorm之所以成为Transformer的首选,是因为它的独特优势和Transformer的需求完美匹配。虽然BatchNorm在其他领域也有出色的表现,但在Transformer的世界里,LayerNorm才是那个最佳拍档。

本文转载自 智驻未来,作者: 小智