LLM合集:微软开源新一代视频token化方法VidTok,打造高性能视频Token化解决方案

1. VidTok: A Versatile and Open-Source Video Tokenizer

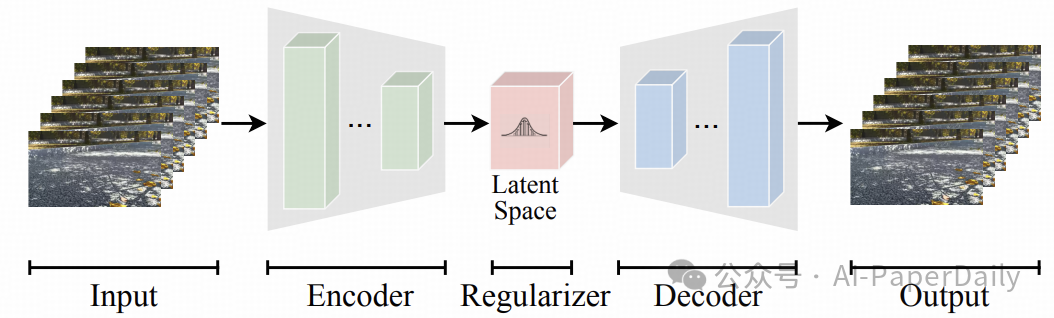

将视频内容编码为紧凑的潜在token已经成为视频生成和理解中的一个基本步骤,这是为了应对像素级表示中固有的冗余问题。因此,随着以视频为中心的研究日益重要,对高性能、开源视频token化工具的需求也在不断增长。我们推出了 VidTok,这是一种多功能的视频Tokenizer,在连续和离散token化方面都提供了最先进的性能。

VidTok 相较于现有方法引入了几个关键改进:模型架构方面采用了卷积层和上/下采样模块;为了解决传统向量量化(VQ)常见的训练不稳定性和码本崩溃问题,我们将有限标量量化(FSQ)整合到离散视频token化中;改进了训练策略,包括两阶段训练过程和使用较低帧率等措施。

通过集成这些改进,VidTok 在多个评估指标上实现了显著的进步,如峰值信噪比(PSNR)、结构相似性(SSIM)、感知路径长度(LPIPS)以及弗雷歇视频距离(FVD),在标准化的评估设置下表现出色,超越了现有方法。

VidTok 的推出不仅提升了视频token化的效率和质量,还为视频内容的理解与生成提供了一种强大的工具,有助于推动视频技术的发展。

论文:https://arxiv.org/pdf/2412.13061

2. Mix-LN: Unleashing the Power of Deeper Layers by Combining Pre-LN and Post-LN

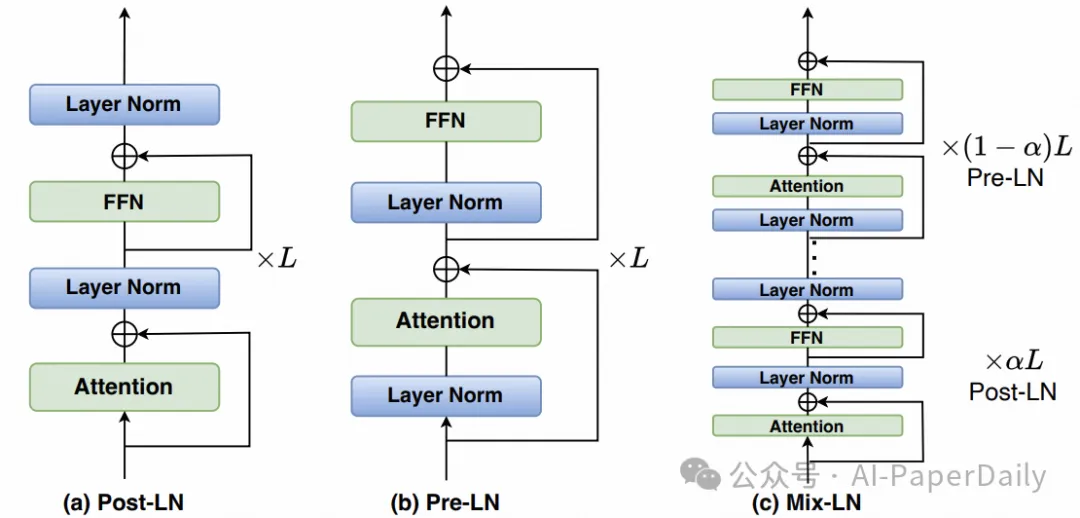

大语言模型(LLMs)取得了显著的成功,但最新的研究发现,这些模型的深层往往贡献较小,并且可以在不影响整体性能的情况下被剪枝。虽然一些人将此视为模型压缩的机会,我们认为这是一个由于广泛使用Pre-LN而导致的训练不足问题。我们证明了在像 GPT 和 LLaMA 这样的模型中常用的 Pre-LN 会导致其深层的梯度范数减弱,从而降低了这些层的有效性。相反,后层归一化(Post-LN)在深层保持较大的梯度范数,但在早期层则遭遇梯度消失的问题。

为了解决这个问题,我们引入了一种新的归一化技术——混合层归一化(Mix-LN),它在同一模型内结合了 Pre-LN 和 Post-LN 的优势。Mix-LN 在早期层应用 Post-LN,在深层应用 Pre-LN,确保整个网络各层之间有更均匀的梯度分布。这使得网络的所有部分——无论是浅层还是深层——都能有效地参与到训练中。通过对从70M到7B参数规模的各种模型进行大量实验,我们证明 Mix-LN 一贯优于单独使用 Pre-LN 或 Post-LN,促进了更加平衡和健康的全网梯度范数,提高了 LLM 预训练的整体质量。

此外,我们还展示了使用 Mix-LN 预训练的模型在监督微调(SFT)和人类反馈强化学习(RLHF)期间比使用 Pre-LN 或 Post-LN 的模型学得更好,强调了高质量深层的重要性。通过有效解决当前 LLM 深层效率低下的问题,Mix-LN 解锁了它们的潜力,增强了模型能力而无需增加模型尺寸。我们的代码可在 https://github.com/pixeli99/MixLN 获取。

论文:https://arxiv.org/pdf/2412.13795

3. FastVLM: Efficient Vision Encoding for Vision Language Models

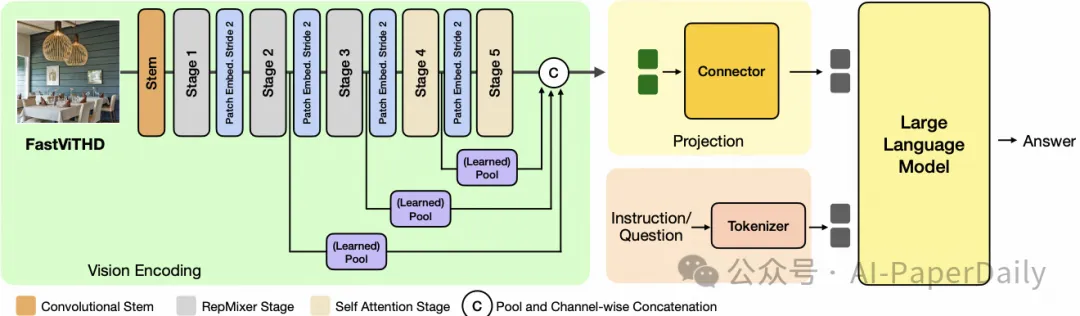

提升输入图像分辨率对于增强视觉语言模型(VLMs)的性能至关重要,尤其是在涉及丰富文本图像理解的任务中。然而,像 ViTs 这样的流行视觉编码器在高分辨率下变得效率低下,因为大量的token和堆叠的自注意力层导致了高的编码延迟。在不同的操作分辨率下,VLM 的视觉编码器可以在两个方面进行优化:减少编码延迟和最小化传递给语言模型(LLM)的视觉token数量,从而降低整体延迟。

基于对图像分辨率、视觉延迟、token数量和 LLM 尺寸之间相互作用的全面效率分析,我们推出了 FastVLM,这是一种在延迟、模型尺寸和准确性之间实现了优化权衡的模型。FastVLM 包含 FastViTHD,这是一种新型的混合视觉编码器,旨在输出更少的token并大幅减少高分辨率图像的编码时间。与先前的方法不同,FastVLM 仅通过缩放输入图像就实现了视觉token数量和图像分辨率之间的最佳平衡,无需额外的token修剪,并简化了模型设计。

在 LLaVA-1.5 设置中,FastVLM 在保持与先前工作相似的 VLM 基准性能的同时,首次token生成时间(TTFT)提升了3.2倍。相比最高分辨率(1152x1152)下的 LLaVa-OneVision,FastVLM 使用相同的0.5B参数量的语言模型,在如 SeedBench 和 MMMU 等关键基准测试中达到了可比的性能,但 TTFT 快了85倍,且视觉编码器体积小了3.4倍。

论文:https://arxiv.org/pdf/2412.13303

4. AniDoc: Animation Creation Made Easier

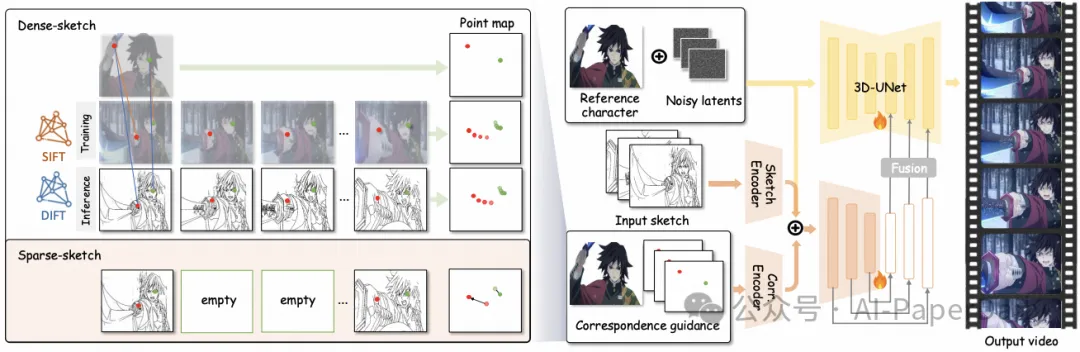

二维动画的制作遵循一个行业标准的工作流程,包括四个基本阶段:角色设计、关键帧动画、中间帧绘制(in-betweening)和上色。我们的研究旨在通过利用日益强大的生成式人工智能来降低上述过程中的劳动力成本。基于视频扩散模型,我们开发了 AniDoc 这一视频线稿上色工具,它可以自动将草图序列转换为符合参考角色规范的彩色动画。

我们的模型采用对应匹配作为显式指导,这使得它对参考角色与每一帧线稿之间的变化(例如姿势变化)具有很强的鲁棒性。此外,我们的模型甚至可以自动化中间帧绘制的过程,用户只需提供一个角色图像以及起始和结束的草图,就可以轻松创建时间上连贯的动画。

这项技术不仅大大减少了动画制作过程中的人力投入,也提高了创作效率和灵活性。我们的代码可以在以下网址获取:https://yihao-meng.github.io/AniDoc_demo。

论文:https://arxiv.org/pdf/2412.14173

本文转载自 AI-PaperDaily,作者: AI-PaperDaily