12个真实世界机器人任务成功率超OpenVLA 24.17% | EMMA-X:7B具身多模态动作模型 精华

文章链接:https://arxiv.org/pdf/2412.11974

代码链接:https://github.com/declare-lab/Emma-X

Huggingface链接:https://huggingface.co/declare-lab/Emma-X

亮点直击

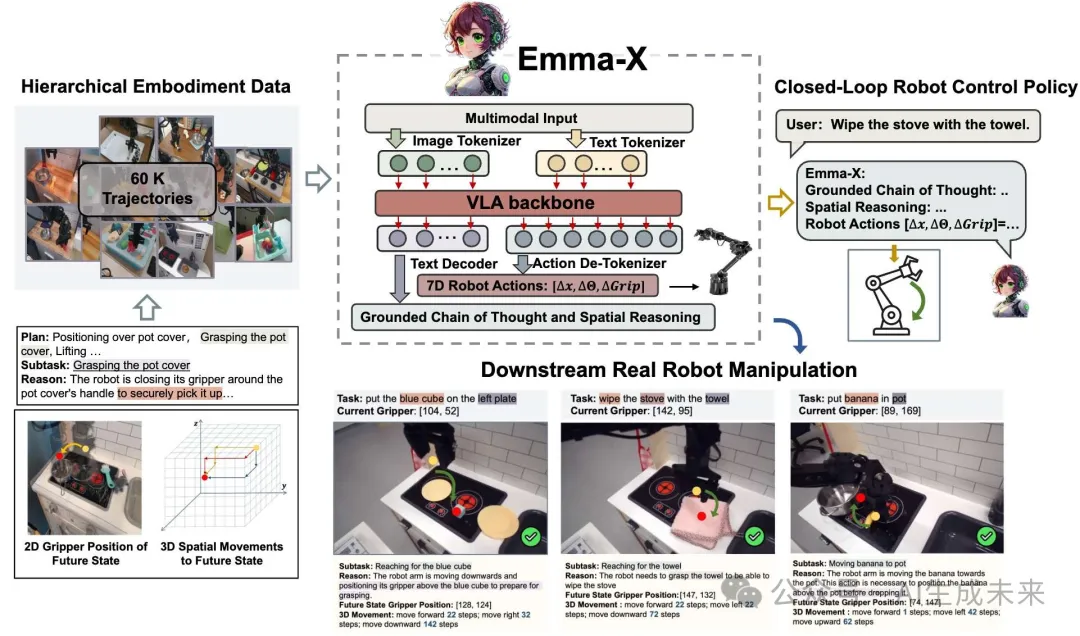

- 提出了一个具有70亿参数的具身多模态动作模型 EMMA-X,通过在有根据的链式思维(CoT)推理数据上微调 OpenVLA 创建而成。

- 通过合成构建了一个层次化的具身数据集,该数据集来自现有的机器人操作数据集,包含了3D空间运动、2D夹爪位置和有根据的推理。

- 提出了一种新颖的轨迹分割策略,利用夹爪的开合状态和机器人手臂的运动轨迹,促进了有根据的任务推理和前瞻性空间推理。

- 提出的 EMMA-X 在各种实际机器人任务中,特别是在需要空间推理的任务中,相比现有的竞争基准,取得了显著的性能提升。

总结速览

解决的问题

传统的基于强化学习的机器人控制方法通常是任务特定的,无法在不同环境或未见过的物体和指令中进行有效推广。尽管视觉语言模型(VLMs)在场景理解和任务规划上表现出色,但它们缺乏生成适用于特定机器人形态的可操作策略的能力。此外,现有的视觉语言行动(VLA)模型在长时间跨度的空间推理和基于实际任务的规划中存在挑战,尤其是在处理复杂任务和模糊指令时。

提出的方案

本文提出了EMMA-X(Embodied Multimodal Action Model with Grounded Chain of Thought and Look-ahead Spatial Reasoning) 模型。该模型通过引入基于层次化具身数据集(BridgeV2)来增强机器人任务推理和空间引导,生成更加精准的多任务通用机器人动作。EMMA-X结合了基于视觉和任务推理的链式思维,并且引入了前瞻性空间推理能力,以确保机器人能够生成高效且适应环境的长期任务规划。

应用的技术

- 层次化具身数据集(BridgeV2):EMMA-X基于此数据集,包含了60,000条机器人操作轨迹,每条轨迹都附有详细的空间推理和任务推理。

- 前瞻性空间推理(Look-ahead Spatial Reasoning):通过预测夹爪未来位置(2D位置)和三维运动计划,优化机器人行动的长期规划。

- 轨迹分割策略:基于夹爪的开合状态和机器人手臂的运动轨迹,动态地将状态序列分割成独立段,从而减轻了因不充分的视觉理解所导致的任务推理中的幻觉问题。

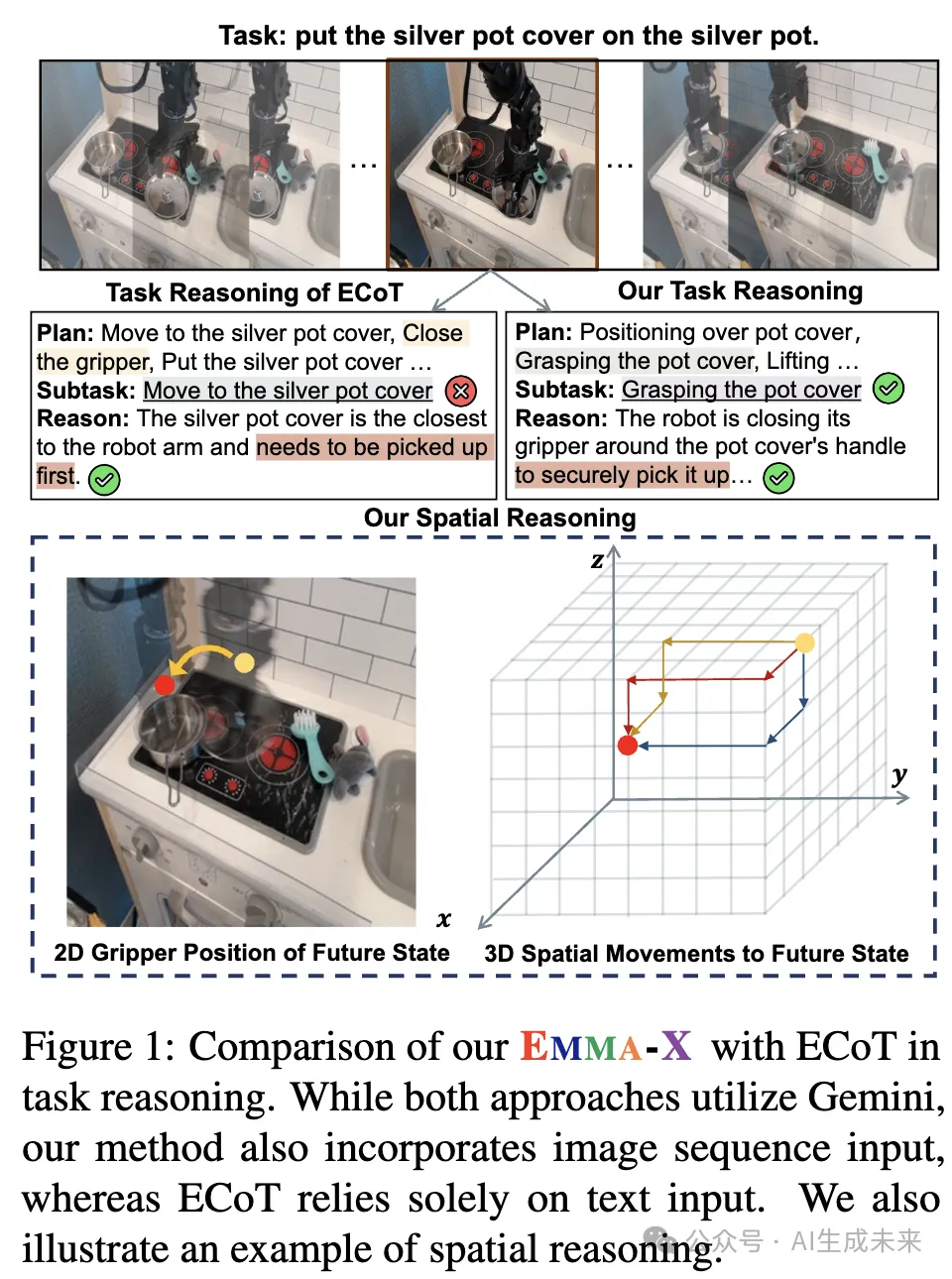

- Gemini生成任务推理:与ECoT方法不同,EMMA-X结合了视觉输入和任务推理,避免了仅依赖文本描述所产生的推理冲突。

达到的效果

- 减少幻觉现象:通过结合视觉图像和任务推理,EMMA-X显著减少了任务推理过程中的幻觉问题,提供了更为准确的子任务定义。

- 提高机器人任务执行效果:实验结果表明,EMMA-X在实际的机器人任务中,尤其是需要长时间跨度空间推理的任务中,表现优于现有的竞争基准。

- 增强的任务规划能力:通过长时间跨度的空间推理,EMMA-X能够生成更精确的高层次运动规划,帮助机器人在复杂和动态环境中执行任务。

方法

EMMA-X 包括三个关键设计:

- 基于夹爪状态和机器人手臂运动轨迹对轨迹进行分割。

- 生成层次化的规划,包括有根据的任务推理、2D夹爪位置和3D空间运动。

- 基于我们构建的数据集,基于OpenVLA训练EMMA-X。

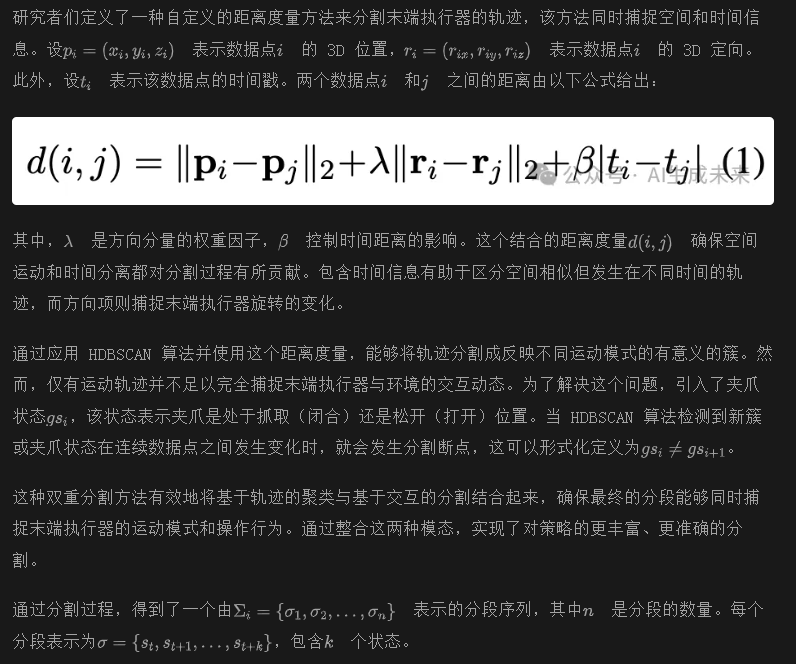

轨迹分割

为什么要分割轨迹? 本文的总体目标是通过有根据的链式思维(CoT)推理,增强视觉语言行动(VLA)模型。现有 VLA 模型存在两个主要的局限性:

- 虽然现有的 VLA 通过将任务分解为子任务并使用 CoT 解决每个子任务来改善任务分解(Zawalski et al., 2024),但它们的 CoT 推理完全依赖于文本场景描述。这限制了它们在现实场景中的推理能力。

- 它们缺乏强大的空间推理能力,而空间推理对有效的任务规划和执行至关重要。

为了解决这些局限性,本文提出了两个关键的解决方案:

- 结合视觉场景信息:除了文本提示外,将视觉输入集成到Gemini中,使任务分解可以同时基于视觉和文本上下文生成高层次的规划。

- 细粒度的运动规划:训练机器人确定去哪里以及如何到达完成子任务所需的潜在未来状态。

为了实现这些解决方案,每个状态都必须标记机器人正在执行的子任务。然而,实验表明,通过Gemini 直接标注每个帧会导致标签噪声,可能是因为上下文信息不足。为了克服这个问题,将轨迹分割成连续的状态序列,其中机器人执行语义上相似的动作。通过这种分割,提供了更丰富的上下文,使Gemini 更有效地为子任务分配标签。

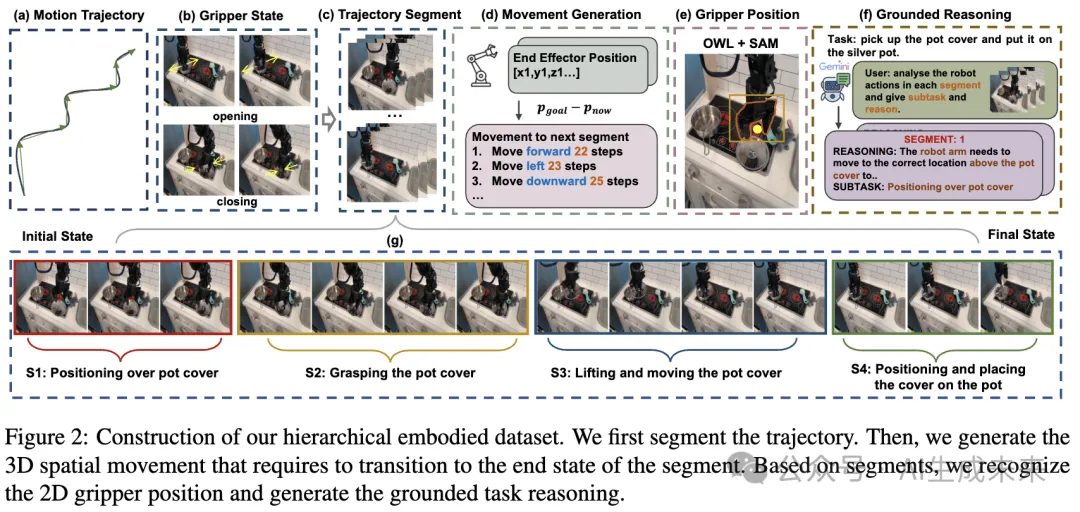

分割方法

如下图 2(a) 和2(b) 所示,通过结合末端执行器的运动轨迹和夹爪状态对观察序列进行分割。为了实现这一目标,使用了基于密度的空间聚类算法(HDBSCAN),该算法能够有效处理由于人类示范中的不完美性引起的小波动所带来的噪声。HDBSCAN 的灵活性使得它能够发现数据中多样的轨迹模式。

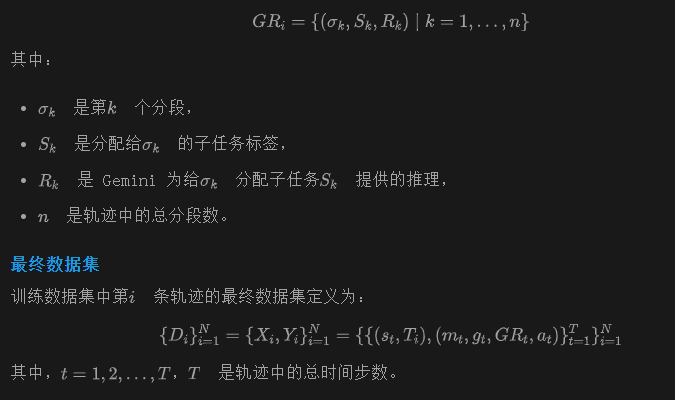

数据生成

在获得分段后,为每个示范生成层次化的具身规划数据,如前图 2 所示。对于每个示范的分段,生成当前分段完成状态的 2D 末端执行器位置和 3D 运动。此外,为相应的子任务生成有根据的推理。

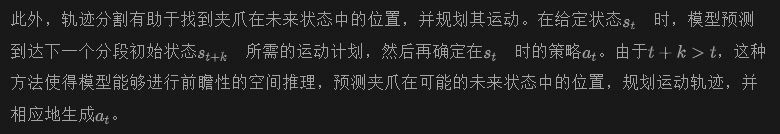

为什么进行前瞻空间推理?

如果没有能力基于未来状态设立地标或检查点并根据它们规划路线,配送员只能依赖于反应性决策,这会导致低效或错误的路径选择。通过整合高层计划和即时反馈,配送员能够确保有目的且自适应地朝目标前进。

类比,计算出前瞻夹爪位置和运动计划,预测如何到达未来的状态。

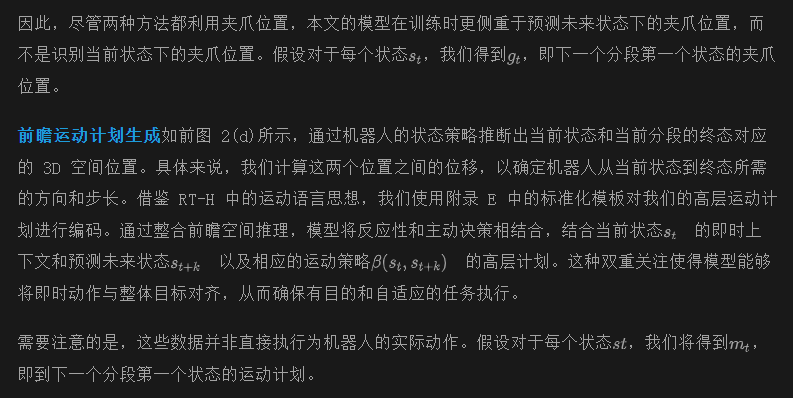

前瞻夹爪位置生成参考(Zawalski 等,2024),同样使用 OWLv2和 SAM来检测 2D 夹爪位置,如前图 2(e)所示。不同之处在于,训练模型仅输出当前输入状态的夹爪位置,而在数据构建过程中,使用当前夹爪位置作为输入,预测下一个分段第一个状态的夹爪位置。

基于推理的链式思维

如前图 2(f) 和 (g) 所示,利用 Gemini 3 来推导出每个分段对应的子任务,以及执行该子任务所需的场景理解和推理。具体来说,我们将分段图像序列和任务描述作为输入,指导 Gemini 生成每个分段的子任务和有根据的推理。与(Zawalski 等,2024)仅从文本信息推导子任务及其状态映射不同,本文的方法首先根据机器人运动轨迹和夹爪状态对序列进行分割。然后,基于给定的多模态信息,我们生成相应的子任务和每个子任务的推理。需要注意的是,每个子任务可以包含多个分段。对于第i条轨迹,从 Gemini 获得有根据的推理,定义为:

EMMA-X

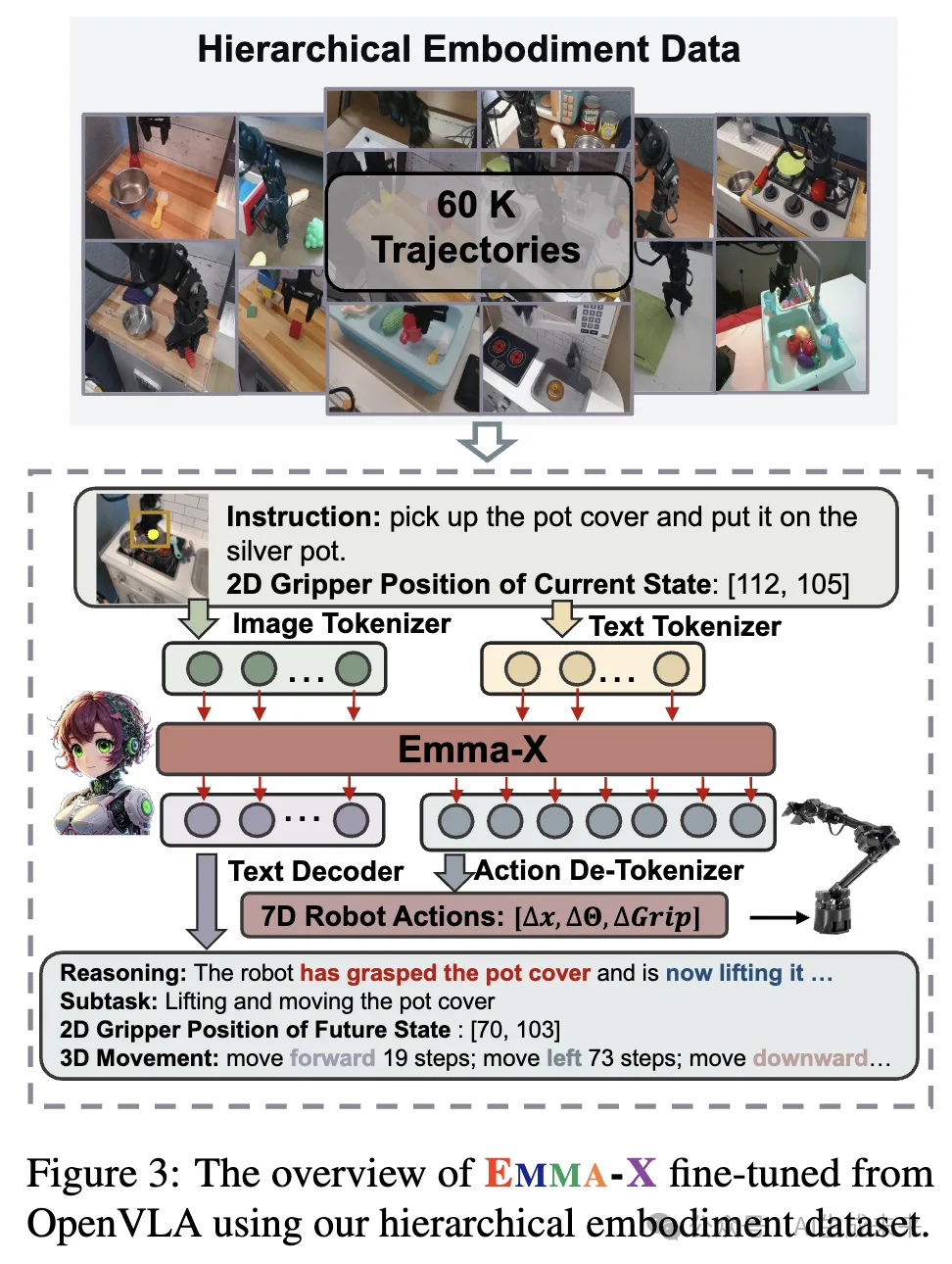

本节介绍EMMA-X 的架构,这是一种基于 7B 参数的视觉语言行动(VLA)模型,经过在分层具身数据上微调OpenVLA得到。如下图 3 所示,调整了文本提示,加入了当前夹持器位置,并通过链式思维(CoT)训练来增强空间推理和场景理解能力,以预测下一步机器人的行动策略。

在实际机器人测试过程中,EMMA-X 接收以下几种输入:

- 任务描述:描述机器人需要执行的任务的文本。

- 当前观察图像:来自机器人视角的当前场景图像。

- 2D 夹持器位置:夹持器的当前位置信息,由OWLv2和SAM实时检测。

EMMA-X 接下来会经历以下几个步骤:

- 子任务和场景描述生成:

- 基于任务描述和实时观察,模型首先预测要执行的子任务。

- 它还会生成当前场景的描述,详细描述图像中目标物体与机器人臂之间的空间关系。这包括夹持器如何移动以实现当前子任务的操作指令。

- 目标位置预测:

- 图像中的2D 位置(视觉平面中的位置)。

- 机器人物理环境中的3D 空间移动(所需的实际空间运动)。

- EMMA-X 预测完成子任务后夹持器需要到达的目标位置,包括:

- 下一步机器人动作预测:

- 最终,模型输出7维机器人动作策略,指导机器人执行后续的操作任务。

实验

实现细节

为了创建分层推理数据集,使用了我们的数据创建管道对BridgeData-v2 进行处理,该数据集包含约60,000 条轨迹,每条轨迹都配有任务指令。这个数据集为训练 VLA 模型提供了基础。

在训练VLA 模型 时,使用了OpenVLA,这是一个基于Prismatic 视觉语言框架 的 7B 视觉语言行动模型。OpenVLA 在Open X-Embodiment 数据集 上进行了预训练,数据集包含了一系列多模态任务演示及其关联指令。

对于自回归训练,将 7 维度的动作策略标记化为离散的策略标记,符合 OpenVLA 的既定方法。训练过程遵循 OpenVLA 的标准协议,我们在我们的增强数据集上对基础模型进行了3 个周期 的微调,直到收敛。

机器人设置和评估指标

使用6自由度的WidowX机器人臂来评估我们的方法,该机器人臂在Bridge V2论文中被介绍,是评估通用机器人策略的标准基准。该策略以单个第三人称摄像头的输入图像和自然语言指令为输入,预测末端执行器的速度动作以控制机器人。

为了严格测试策略的泛化能力,开发了一套具有挑战性的评估任务,涵盖多个方面:域内场景、域外(OOD)物体、空间关系和域外指令。所有策略在相同的现实世界设置上进行评估,以确保摄像头角度、照明条件和背景的一致性。每个任务执行10次,遵循OpenVLA建立的方法。如果机器人成功完成任务,得分为1(成功),否则得分为0(失败)。根据OpenVLA的方法,我们还引入了一个“半成功”(h-succ)指标,考虑任务目标和难度,并且仅当满足半成功标准时才给出0.5分。

基准对比

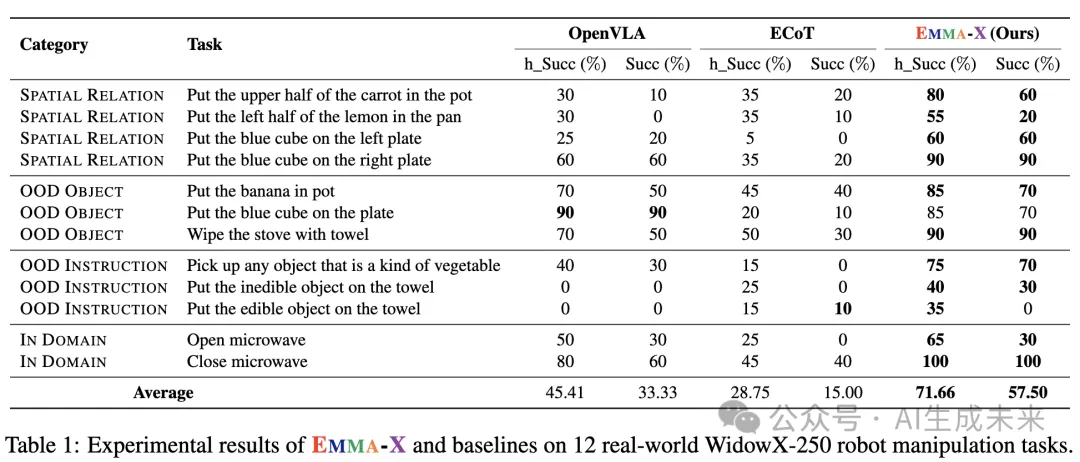

为了全面评估EMMA-X的性能,在12个不同的任务上进行了广泛的实验,并与几种竞争方法进行了比较。

OpenVLA:基于大规模VLM Prismatic-7b的VLA模型,且在Open-X-Embodiment数据集上进行了预训练。OpenVLA w/ FT:为了进行公平比较,在BridgeV2数据集上对OpenVLA模型进行了微调,并遵循本文方法中相同的训练设置,训练了相同的轮次。ECoT:基于BridgeV2数据集微调的OpenVLA VLA模型,使用他们生成的链式思维(CoT)推理数据进行训练。

EMMA-X提升策略的泛化能力

本节将EMMA-X与几种基准方法进行了比较,评估了其在12个真实世界机器人任务中的表现。如下表1所示,EMMA-X在任务成功率上比强基准OpenVLA提高了24.17%,在半成功率上提高了26.25%。这证明了我们构建的分层具身数据集的有效性。

此外,与ECoT相比,EMMA-X表现出显著的提升,可能由以下原因造成:

- ECoT在训练数据上存在噪声,这在面对域外指令或不熟悉的物体时会引发幻觉,导致任务失败。有趣的是,即使在域内任务中,它也比其他模型表现较差,突显了其有限的推理能力。基于任务推理的方法通过结合分段的视觉图像来解决这一问题,从而确保任务理解更加准确。

- EMMA-X通过预测当前段落的结束状态的2D夹持器位置和3D空间运动,再预测下一步机器人动作策略,增强了空间推理能力。

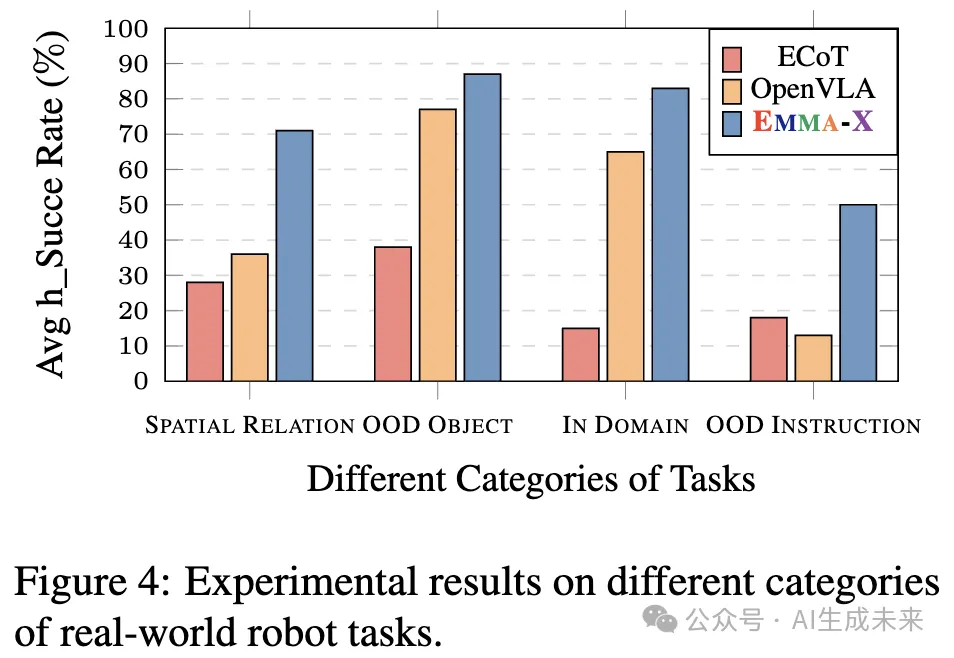

如下图4所示,对各种类别的机器人任务进行了平均表现比较。值得注意的是,在空间关系任务中,方法取得了最显著的性能提升,成功率相比OpenVLA提高了35%,相比ECoT提高了29%。这些结果有力地验证了本文预测的3D空间运动的有效性。此外,本文的方法在域外指令任务中也表现出了显著的性能提升,突出显示了基于任务推理的有效性。

分析

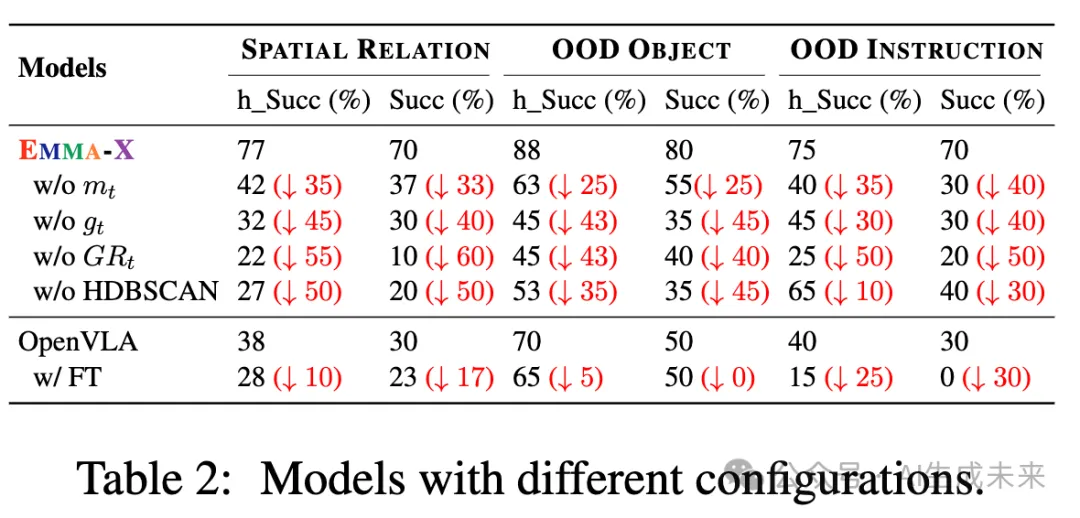

训练了多个EMMA-X的变体,以评估分段、提前空间推理和基于任务的思维链(CoT)推理的作用,它们共同构成了EMMA-X的核心。为了进行评估,从空间关系(SPATIAL RELATION)、域外物体(OOD OBJECT)和域外指令(OOD INSTRUCTION)中选择了6个提示(提示在C节中以品红色标出)。对于每个提示,我们在与主要实验相同的实验设置下进行了10次实验。

分段对策略的巨大帮助为了评估本文的分段技术的有效性,进行了一项实验,其中序列仅根据夹持器(末端效应器)的开合位置进行分段。结果,如下表2所示,在“w/o HDBSCAN”条件下,一般性能下降了10%到50%。特别是空间推理性能下降最为显著,下降幅度为50%。这些发现表明,公式1中引入的距离度量对分段过程至关重要。

提前空间推理的影响

为了评估提前空间推理的重要性,进行了两个实验:

- EMMA-X在没有显式预测下一个段落夹持器位置的情况下进行训练,仅依赖预测的运动计划来达到该段落的未来夹持器位置(在上表2中表示为“w/o gt”)。这假设EMMA-X隐式推断未来的夹持器位置。

- 训练了EMMA-X来预测未来末端效应器的位置,但没有进行运动计划的滚动来达到该位置(在表2中表示为“w/o mt”)。结果显示,这两种情况下的性能都有显著下降(“w/o mt”下降了25%-40%,而“w/o gt”下降了30%到45%),空间推理任务的下降尤为显著(“w/o mt”下降了35%,而“w/o gt”下降了45%)。

此外,结果表明,预测未来末端效应器的位置更为关键,因为在没有3D空间运动到下一个段落的情况下,性能下降较轻。推测这可能是由于OpenVLA固有的空间推理能力,使其更容易在位置之间过渡。

基于任务的思维链(CoT)推理的重要性基于任务的思维链(CoT)推理是EMMA-X的基础元素。为了评估其影响,训练了一个没有基于任务的推理的EMMA-X变体,同时保留了数据中的提前空间推理。结果显示,性能下降了43%-55%,突显了仅靠空间推理不足以完成任务。有趣的是,缺乏基于任务的CoT推理导致空间推理性能下降更为严重,相比于那些明确去除空间推理能力的模型。这凸显了基于任务的CoT在处理复杂推理任务中的关键作用,包括空间推理。因此推测,为了增强视觉-语言-动作(VLA)模型的泛化策略,改善其广泛的推理能力是必要的,涵盖物体识别、颜色理解、抽象、常识知识等。

微调不会改善OpenVLA本文试图找出是否可以通过在BridgeV2上微调OpenVLA来与EMMA-X的表现相匹配。结果(见上表2)显示,OpenVLA经过微调后,性能下降了5%-30%,最差的表现出现在域外指令任务上。推测这一下降是由于过拟合,因为BridgeV2本身已经是OpenVLA预训练数据集的一部分。

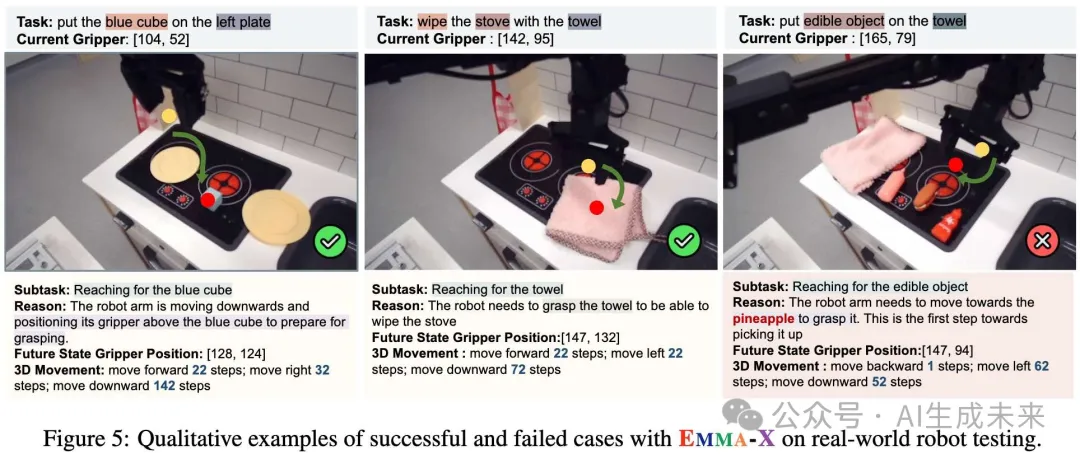

真实世界机器人任务的定性分析为了定性地评估本文的空间和任务推理在引导机器人动作中的有效性,展示了两个成功的轨迹和一个失败的轨迹(见下图5)。从左侧的案例中,发现预测的夹持器位置对应于子任务“抓取蓝色立方体”的结束状态。3D运动提供了详细的路径,清晰地指向“蓝色立方体”。还包括了一个失败的轨迹,其中“热狗”错误地被识别为“菠萝”。这一错误传播开来,影响了夹持器未来位置的预测,导致它无法准确抓取“热狗”。

结论

EMMA-X,一个7B参数的具身多模态动作模型,旨在增强空间推理和任务规划,以生成机器人策略。构建了一个包含基于任务推理的层次化具身数据集,包括2D夹持器位置和3D空间运动。此外,提出的轨迹分段策略通过将推理与视觉图像结合,减少了任务推理中的幻觉现象。实验结果证明了EMMA-X的有效性,在需要长时间跨度空间推理的任务中,相比现有基线模型表现出显著的改进。

局限性

尽管EMMA-X表现出有前景的性能,但与OpenVLA相比,其延迟仍然较高。这种推理时间增加主要来源于推理过程中新生成的额外tokens。具体来说,EMMA-X生成的tokens数量大约是OpenVLA的10倍。为了解决这个问题,一种潜在的策略是预测一个段落内的所有策略,并仅在预测的策略与预期的运动计划有显著偏差时重新生成策略。

另一个局限性是EMMA-X的泛化能力。通过将训练过程扩展到包含更大子集的OXE数据集,可能会增强模型处理更广泛任务和机器人系统的能力。最后,使用SAM检测夹持器位置可能会导致不准确的情况。当夹持器部分被物体遮挡或位于图像框架外时,可能会发生这些错误。使用更强大的模型来检测和分割机器人手部可能会解决这些挑战并提高可靠性。

本文转自AI生成未来 ,作者:AI生成未来